Model Context Provider CLI: инструмент командной строки для использования сервисов MCP в любой крупной модели, не зависит от Claude.

Общее введение

Model Context Provider CLI (mcp-cli) - это инструмент командной строки на уровне протокола для взаимодействия с серверами провайдеров контекста модели. Инструмент позволяет пользователям отправлять команды, запрашивать данные и взаимодействовать с различными ресурсами, предоставляемыми сервером. mcp-cli поддерживает несколько провайдеров и моделей, включая OpenAI и Ollama, при этом по умолчанию используются модели gpt-4o-mini и qwen2.5-coder, соответственно. Для работы инструмента требуется Python 3.8 или выше, а также соответствующие зависимости. Вы можете использовать инструмент, клонировав репозиторий GitHub и установив необходимые зависимости.

Список функций

- Поддержка взаимодействия на уровне протокола с серверами предоставления контекста модели

- Динамические инструменты и ресурсы для изучения

- Поддержка нескольких провайдеров и моделей (OpenAI и Ollama)

- Обеспечивает интерактивный режим, позволяющий пользователям динамически выполнять команды

- Поддерживаемые команды: ping, list-tools, list-resources, list-prompts, chat, clear, help, quit/exit

- Поддерживаемые параметры командной строки включают: --server, --config-file, --provider, --model

Использование помощи

Процесс установки

- Хранилище клонирования:

git clone https://github.com/chrishayuk/mcp-cli

cd mcp-cli

- Установите ультрафиолет:

pip install uv

- Синхронизация зависимостей:

uv sync --reinstall

Использование

- Запустите клиент и взаимодействуйте с сервером SQLite:

uv run main.py --server sqlite

- Запустите клиент с провайдером и моделью OpenAI по умолчанию:

uv run main.py --server sqlite

- Использование специальных конфигураций и Оллама Провайдер управляет клиентом:

uv run main.py --server sqlite --provider ollama --model llama3.2

интерактивный режим

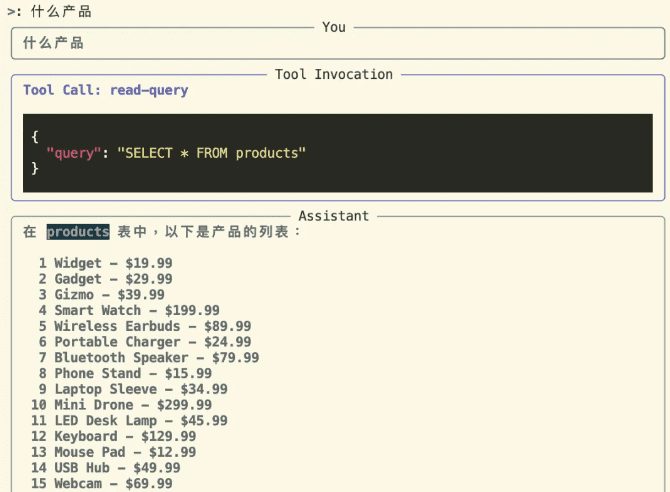

Войдите в интерактивный режим и взаимодействуйте с сервером:

uv run main.py --server sqlite

В интерактивном режиме вы можете использовать инструмент и взаимодействовать с сервером. Провайдер и модель, указанные при запуске, будут отображаться следующим образом:

Entering chat mode using provider 'ollama' and model 'llama3.2'...

Поддерживаемые команды

ping: Проверьте, отвечает ли сервер.list-tools: Показать доступные инструментыlist-resources: Показать доступные ресурсыlist-prompts: Показать доступные советыchat: Войти в режим интерактивного чатаclear: Очистить экран терминалаhelp: Отображает список поддерживаемых команд.quit/exit: Выход из клиента

Использование провайдеров OpenAI

Если вы хотите использовать модель OpenAI, вам следует задать OPENAI_API_KEY переменная окружения, которую можно найти в .env файле или задается в качестве переменной окружения.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...