Модель генерации видео Mochi 1: SOTA в моделях генерации видео с открытым исходным кодом

Genmo AI - это передовая лаборатория искусственного интеллекта, занимающаяся разработкой современных моделей генерации видео с открытым исходным кодом. Ее флагманский продукт, Mochi 1, - это модель генерации видео с открытым исходным кодом, способная генерировать высококачественное видео на основе текстовых подсказок. Цель Genmo - стимулировать инновации в области искусственного интеллекта с помощью технологии генерации видео, предлагая неограниченные возможности для виртуального исследования и творчества.

Models - это библиотека моделей генерации видео с открытым исходным кодом, включающая последние модели Mochi 1. Mochi 1 основана на асимметричной диффузии. Трансформатор (Архитектура AsymmDiT с 1 миллиардом параметров является самой большой из публично опубликованных моделей генерации видео. Модель способна генерировать высококачественные, плавные видеоролики с действиями и очень чутко реагирует на текстовые подсказки.

Mochi 1 Preview - это открытая передовая модель генерации видео с высокой точностью движения и сильным следованием подсказкам. Наша новая модель значительно сокращает разрыв между закрытыми и открытыми системами генерации видео. Мы выпустим модель под свободной лицензией Apache 2.0.

Адрес предварительного просмотра Mochi 1

Обнимающееся лицо (модель весов)

Игровая площадка (онлайн демо)

[bilibili]https://www.bilibili.com/video/BV1FRy6YeEui/[/bilibili]

Список функций

- Поколение видео: Создавайте высококачественный видеоконтент, вводя текстовые подсказки.

- модель с открытым исходным кодом: Mochi 1 доступен в виде модели с открытым исходным кодом, что позволяет пользователю самостоятельно адаптировать и дорабатывать его.

- Высокое качество движения: Создавайте видео с плавными движениями и высокоточной физикой.

- Мощное выравнивание кия: Возможность генерировать видео, точно соответствующее потребностям пользователя, на основе текстовых подсказок.

- Поддержка общества: Предоставление платформы сообщества, где пользователи могут делиться и обсуждать созданный видеоконтент.

- Поддержка нескольких платформ: Поддержка использования на различных платформах, включая веб и мобильные устройства.

Архитектура модели Mochi 1

Mochi 1 представляет собой значительное достижение в области генерации видео с открытым исходным кодом и моделью диффузии с 10 миллиардами параметров, основанной на нашей новой архитектуре Asymmetric Diffusion Transformer (AsymmDiT). Обученная полностью с нуля, она является самой большой моделью генерации видео из когда-либо публично выпущенных. Самое главное - это простая и легко взламываемая архитектура.

Эффективность очень важна для того, чтобы сообщество могло запускать наши модели. В дополнение к Mochi мы также открыли доступ к нашему видео VAE, который сжимает видео до небольшого размера 128x, используя пространство 8x8 и 6-кратное сжатие времени до 12 каналов потенциального пространства.

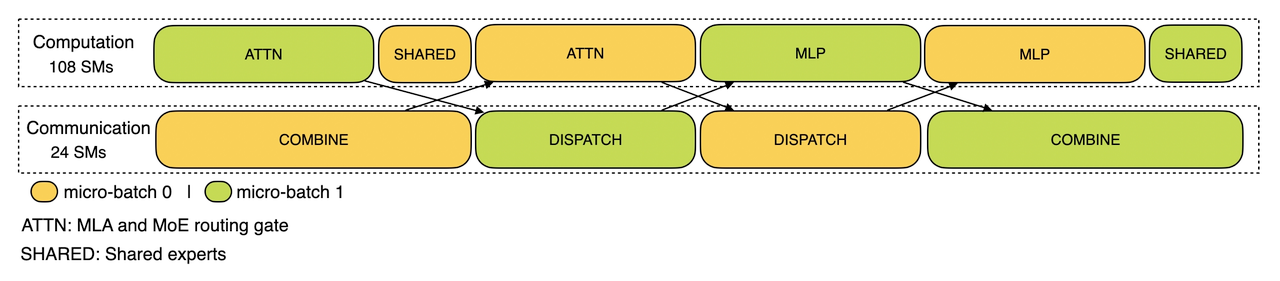

AsymmDiT эффективно обрабатывает подсказки пользователя и маркеры сжатого видео, упрощая обработку текста и концентрируя возможности нейронной сети на визуальных выводах.AsymmDiT использует механизм мультимодального самовнимания для совместной фокусировки на тексте и визуальных маркерах и обучает отдельный MLP-слой для каждой модальности, подобно Stable Diffusion.3 Однако из-за больших скрытых размерностей, наши для визуального потока почти в четыре раза больше параметров, чем для текстового. Чтобы объединить модальности в механизме самовнимания, мы используем асимметричный УГ и выходной проекционный слой. Такая асимметричная конструкция снижает требования к памяти для выводов.

Многие современные модели распространения информации используют несколько предварительно обученных языковых моделей для представления подсказок пользователя. В отличие от них, Mochi 1 кодирует подсказки, используя только одну языковую модель T5-XXL.

Mochi 1 использует полный трехмерный механизм внимания для совместного анализа контекстного окна из 44 520 видеомаркеров. Чтобы локализовать каждый маркер, мы расширяем обучаемое вращательное позиционное вложение (RoPE) до трех измерений. Сеть обучается смеси частот пространственных и временных осей из конца в конец.

Mochi использует некоторые из последних улучшений в расширениях языковой модели, включая слой SwiGLU feed-forward, нормализацию ключей запросов для повышения стабильности и мезонинную нормализацию для контроля внутренней активации.

После этого будет подготовлен технический документ, в котором будут приведены более подробные сведения, способствующие развитию видеогенерации.

Процесс установки Mochi 1

- склад клонов ::

git clone https://github.com/genmoai/models

cd models

- Установка зависимостей ::

pip install uv

uv venv .venv

source .venv/bin/activate

uv pip install -e .

- Скачать модельные веса : Скачайте файл с весами с сайта Hugging Face или по magnet-ссылке и сохраните его в локальной папке.

Процесс использования

- Запуск пользовательского интерфейса ::

python3 -m mochi_preview.gradio_ui --model_dir "<path_to_downloaded_directory>"

взаимозаменяемость<path_to_downloaded_directory>это каталог, в котором находятся веса модели.

- Генерация видео в командной строке ::

python3 -m mochi_preview.infer --prompt "A hand with delicate fingers picks up a bright yellow lemon from a wooden bowl filled with lemons and sprigs of mint against a peach-colored background. The hand gently tosses the lemon up and catches it, showcasing its smooth texture. A beige string bag sits beside the bowl, adding a rustic touch to the scene. Additional lemons, one halved, are scattered around the base of the bowl. The even lighting enhances the vibrant colors and creates a fresh, inviting atmosphere." --seed 1710977262 --cfg_scale 4.5 --model_dir "<path_to_downloaded_directory>"

взаимозаменяемость<path_to_downloaded_directory>это каталог, в котором находятся веса модели.

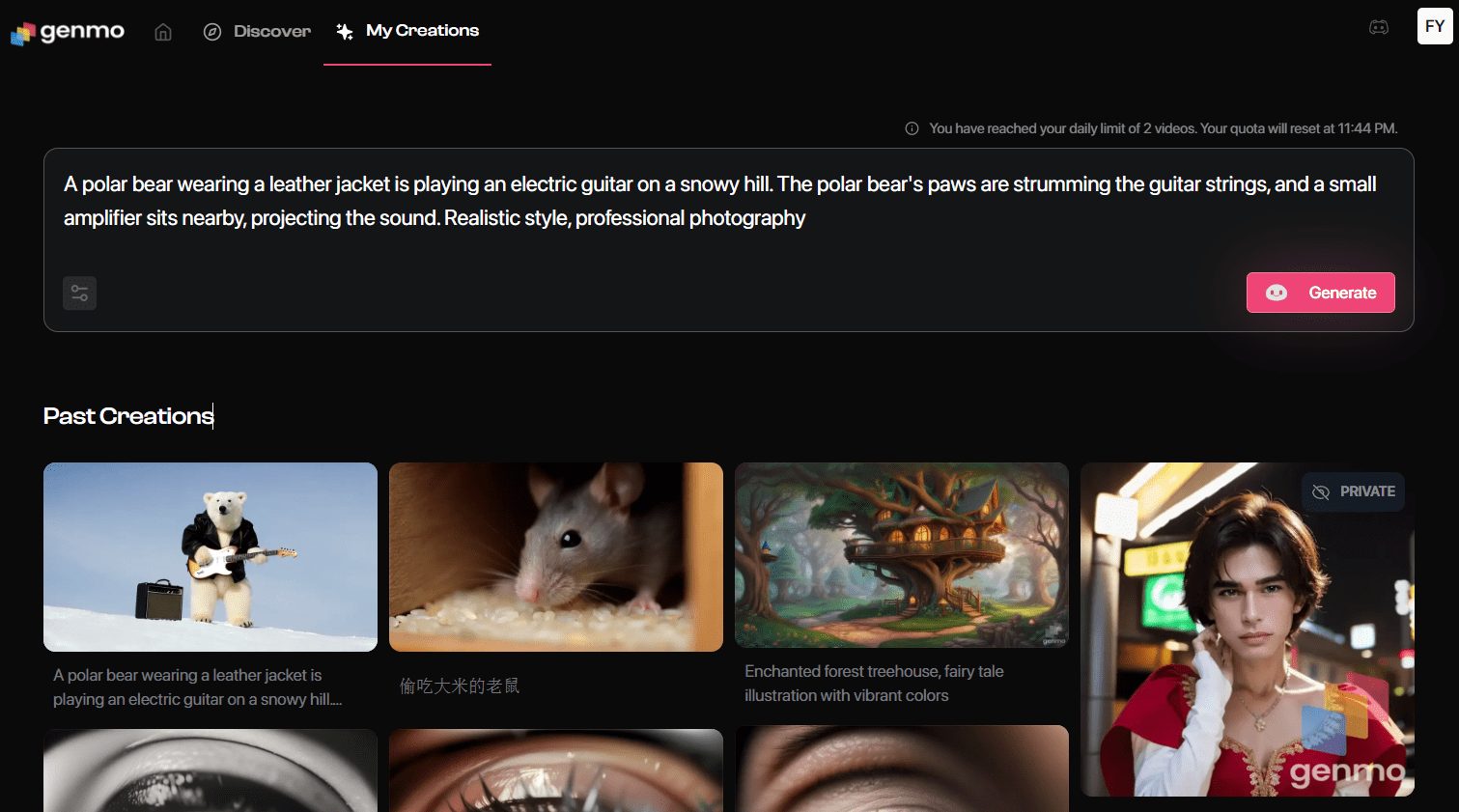

Испытайте Mochi 1 онлайн

- Перейдите на страницу генерации: После входа в систему нажмите "Playground", чтобы перейти на страницу создания видео.

- подсказка ввода: Введите описание видео, которое вы хотите создать, в поле запроса. Например: "Трейлер фильма о приключениях 30-летнего астронавта в красном шерстяном мотоциклетном шлеме".

- Выбор настроек: Выберите стиль видео, разрешение и другие настройки по мере необходимости.

- Создать видео: Нажмите кнопку "Генерировать", и система создаст видео в соответствии с вашими подсказками.

- Скачать и поделиться: После создания видео можно просмотреть и загрузить его локально или поделиться им непосредственно на платформах социальных сетей.

Дополнительные возможности

- Пользовательские модели: Пользователи могут загрузить веса модели для Mochi 1, тренировать и настраивать их локально для персонализации.

- Взаимодействие с обществом: Присоединяйтесь к сообществу Genmo's Discord, чтобы обмениваться опытом и делиться созданными видеороликами с другими пользователями.

- Интерфейс API: Разработчики могут использовать API-интерфейс, предоставляемый Genmo, для интеграции функций генерации видео в свои приложения.

общие проблемы

- Сбой генерации видеоУбедитесь, что вводимые подсказки ясны и конкретны, избегая расплывчатых или сложных описаний.

- Проблемы с входом в систему: Если вы не можете войти в систему, проверьте подключение к Интернету или попробуйте использовать другой браузер.

- Скачать модель: Посетите страницу Genmo на GitHub, чтобы загрузить последнюю версию весов модели Mochi 1.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...