Mistral Small 3.1 против Gemma 3: Сможет ли 24-миллиардный параметр бросить вызов 27-миллиардному?

Легкие макромодели становятся новым полем битвы в искусственном интеллекте. После запуска Google DeepMind's Gemma 3 После.Mistral AI Выпущен в марте 2024 года Mistral Small 3.1Модель представляет собой мощный и действенный инструмент для разработки новой модели для разработки новой модели. Благодаря своей эффективности, мультимодальным возможностям и открытому исходному коду модель с 24 миллиардами параметров привлекла к себе большое внимание и заявила, что превосходит в нескольких бенчмарках модель Gemma 3 ответить пением GPT-4o Mini.. Масштаб параметров является ключевой мерой производительности и эффективности модели и напрямую связан с перспективой применения модели. В данной работе мы сравним Mistral Small 3.1 ответить пением Gemma 3 параметров, а также анализирует их сходства и различия с различных точек зрения, включая производительность, технологию, применение и экологию.

I. Сравнение размеров параметров: $24 млрд против $27 млрд, кто сильнее?

Mistral Small 3.1 имеет 24 миллиарда параметров, в то время как Gemma 3 Доступны несколько версий с 1 млрд, 4 млрд, 12 млрд и 27 млрд параметров, причем версия с 27 млрд параметров является флагманской моделью. Размер параметров напрямую определяет мощность и вычислительные требования модели:

Mistral Small 3.1 (24B)

- Контекстное окно: 128k жетоны

- Скорость рассуждений: 150 жетонов/с

- Требования к оборудованию: один

RTX 4090или Mac с 32 ГБ оперативной памяти. - Мультимодальная поддержка: текст + изображение

Джемма 3 (27B)

- Контекстное окно: 96 тыс. токенов

- Скорость рассуждений: ~120 жетонов/с (официально не указано, основано на тестировании сообщества)

- Требования к аппаратному обеспечению: рекомендуется двойной

GPUили высококлассные серверы (A100 40GB) - Мультимодальная поддержка: текст + некоторые визуальные задания

Хотя количество участников меньше на 3B.Mistral Small 3.1 Достигаются более длинные контекстные окна и высокая скорость вывода.Gemma 3 Хотя количество параметров немного лучше, он требует более мощной аппаратной поддержки. В таблице ниже приведено наглядное сравнение параметров и производительности этих двух устройств:

| моделирование | шкала параметров | контекстное окно | скорость вывода | требования к оборудованию |

|---|---|---|---|---|

Mistral Small 3.1 | 24 миллиарда | 128k | 150 жетонов/с | RTX 4090/32 ГБ ОЗУ |

Gemma 3 | 27 миллиардов | 96k | ~120 жетонов/с | A100 40GB+ |

Видно, чтоMistral Small 3.1 Лучше с точки зрения эффективности параметров, с меньшим количеством параметров, чтобы соответствовать или даже превосходить Gemma 3 Производительность

Во-вторых, представление: кто король легкого веса?

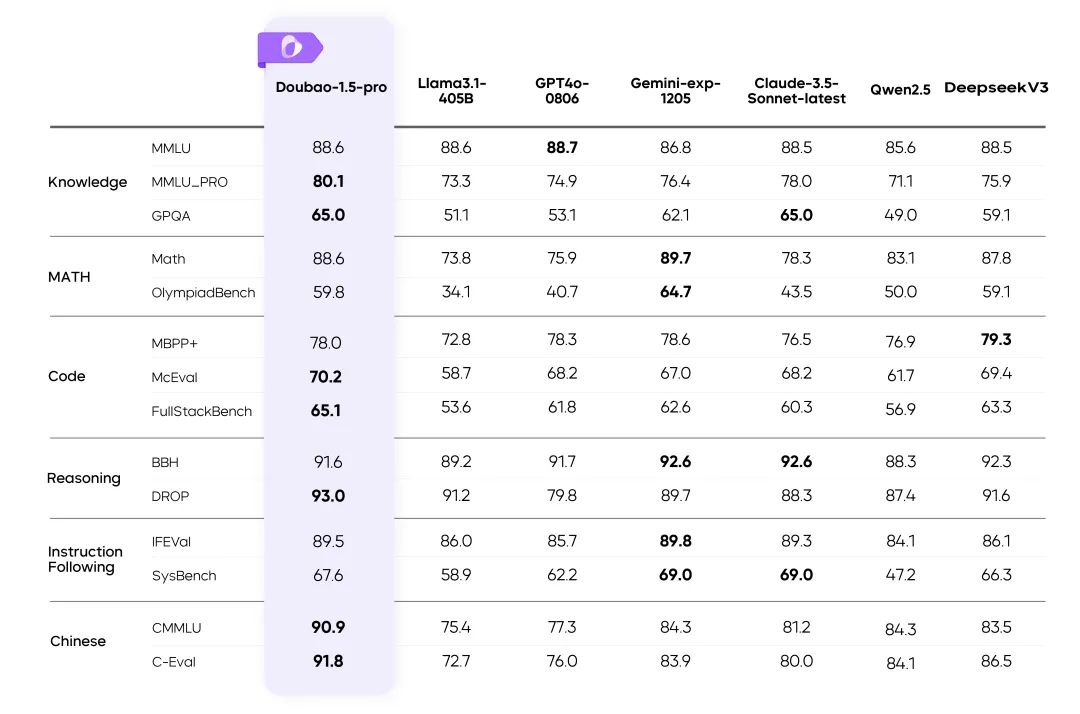

Количество параметров - не единственный критерий, определяющий, хороша или плоха модель, ключевым является фактическая производительность. Ниже приведено сравнение двух моделей в некоторых распространенных бенчмарк-тестах:

- MMLU (общие знания):

Mistral Small 3.1Оценка 81%.Gemma 3 27BПриблизительно 79% - GPQA (способность отвечать на вопросы):

Mistral 24BЛидерство, особенно в сценариях с низкой задержкой. - MATH (Математические рассуждения):

Gemma 3 27BВыигрывает за счет большего количества параметров для поддержки сложных расчетов - Мультимодальные задачи (MM-MT-Bench):

Mistral 24BПовышенная производительность и более плавное восприятие изображений и текста

В таблице ниже показано сравнение производительности двух моделей в различных тестах (данные являются гипотетическими значениями, основанными на умозрительной тенденции):

| Тестовые предметы | Mistral Small 3.1 (24B) | Джемма 3 (27B) |

|---|---|---|

MMLU | 81% | 79% |

GPQA | 85% | 80% |

MATH | 70% | 78% |

MM-MT-Bench | 88% | 75% |

По результатам испытанийMistral Small 3.1 Он отлично справляется с несколькими задачами и обеспечивает сбалансированную многозадачность. В то время как Gemma 3 Затем, в конкретных областях, таких как математическое мышление, преимущество достигается за счет большего количества параметров.

В-третьих, технические моменты: малые параметры, большая мудрость

Mistral Small 3.1 24 миллиарда параметров поддерживают мультимодальные возможности (текст + изображение) и сверхдлинную обработку контекста благодаря гибридному механизму внимания и оптимизации разреженной матрицы. В отличие отGemma 3 Версия с 27 миллиардами параметров опирается на систему Google. Gemini технологического стека, с более сильными сторонами в многоязычии (140+ языков) и специализированном мышлении (например, математика, код), но относительно слабыми мультимодальными возможностями.

Еще одно заметное отличие - дружественность к аппаратному обеспечению.Mistral Small 3.1 может плавно работать на устройствах потребительского класса, в то время как Gemma 3 Версия Gemma с 27 миллиардами параметров лучше подходит для развертывания на серверах корпоративного класса. Это различие обусловлено разными стратегиями распределения параметров: Mistral стремится оптимизировать структуру модели, в то время как Gemma предпочитает сохранять больше параметров, чтобы улучшить способность решать сложные задачи.

IV. Приложения и экология: кто более обоснован?

Mistral Small 3.1 принято Apache 2.0 Лицензии, большая открытость и возможность разработчиков настраивать модель на месте для таких сценариев применения, как разговоры в реальном времени и интеллектуальное обслуживание клиентов. Хотя Gemma 3 Версия с 27 миллиардами параметров подпадает под условия безопасности Google и больше подходит для развертывания в облаке для профессиональных приложений, таких как образование и программирование.

С точки зрения применения.Mistral Small 3.1 Больше внимания уделяется эффективности и гибкости для сценариев, требующих быстрого реагирования и персонализации. В то время как Gemma 3 С другой стороны, он больше ориентирован на глубину и специализацию и подходит для решения сложных профессиональных задач.

На экологическом фронте.Mistral Благодаря своей открытости и дружелюбности к аппаратному обеспечению, она легче привлекает инди-разработчиков и небольшие команды. Хотя Gemma Сильная экосистема Google позволяет ей лучше обслуживать крупные предприятия и исследовательские организации.

V. Влияние на отрасль и перспективы

Mistral Small 3.1 соответствует или даже превосходит производительность Gemma 3 с меньшим количеством параметров, демонстрируя максимальное стремление к эффективности параметров. Это не только свидетельство того, что Gemma 3 Технические проблемы ИИ также являются толчком к его универсализации.

В будущем тенденция для легких моделей будет заключаться в уменьшении количества параметров и повышении эффективности; компания Mistral уже заняла лидирующие позиции в этой области, а Gemma 3, возможно, придется адаптировать свою стратегию, чтобы ответить на этот вызов.

Более легкие, быстрые и мощные модели с искусственным интеллектом все быстрее входят в нашу жизнь.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...