MiniMax Первый открытый MiniMax-01, 4M сверхдлинный контекст, новая архитектура, вызов трансформеру

"MoE" плюс "беспрецедентное масштабное внедрение в производственную среду". молния Внимание", плюс "рефакторинг программного и инженерного обеспечения от фреймворка до уровня CUDA" - и что вы получаете?

Ответ - новая модель, которая объединяет возможности лучших моделей и увеличивает длину контекста до уровня 4 миллионов токенов.

15 января компания по макромоделированию MiniMax официально представила давно ожидаемую новую серию моделей: MiniMax-01, состоящую из базовой языковой макромодели MiniMax-Text-01 и визуальной мультимодальной макромодели MiniMax-VL-01, разработанной путем интеграции поверх нее облегченной модели ViT.

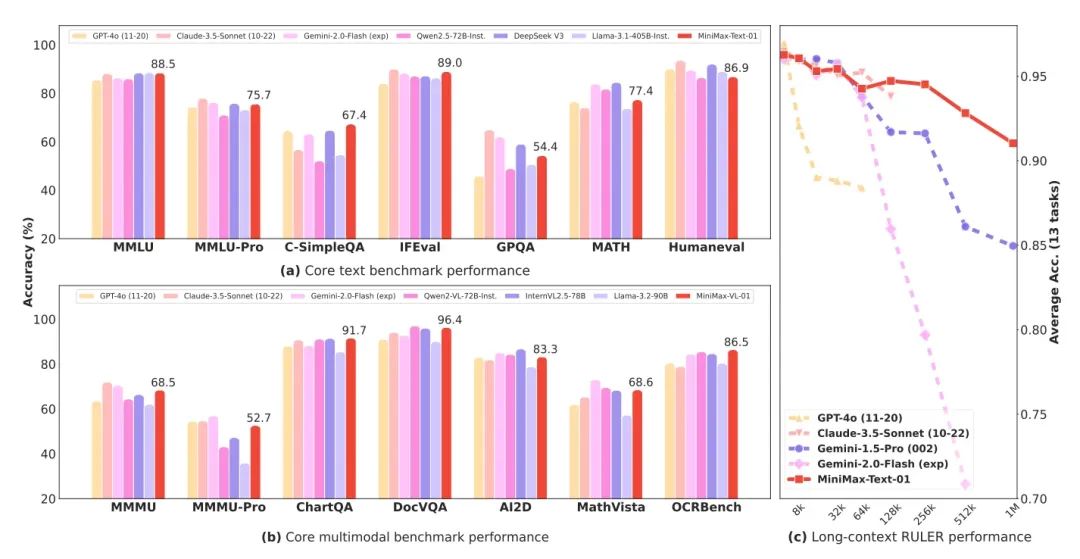

MiniMax-01 - это модель MoE (Mixed Expert) с 456 миллиардами общих параметров и 32 экспертами, которая по совокупной мощности в нескольких основных наборах обзоров находится на одном уровне с GPT-4o и Claude 3.5 sonnet, но в то же время имеет в 20-32 раза большую длину контекста, чем современные топовые модели, а при большей длине входных данных она также является моделью с самым долгим спадом производительности. это модель с самым медленным падением производительности. То есть это настоящий контекст с 4 миллионами токенов.

- Базовая языковая макромодель MiniMax-Text-01, визуальная мультимодальная макромодель MiniMax-VL-01

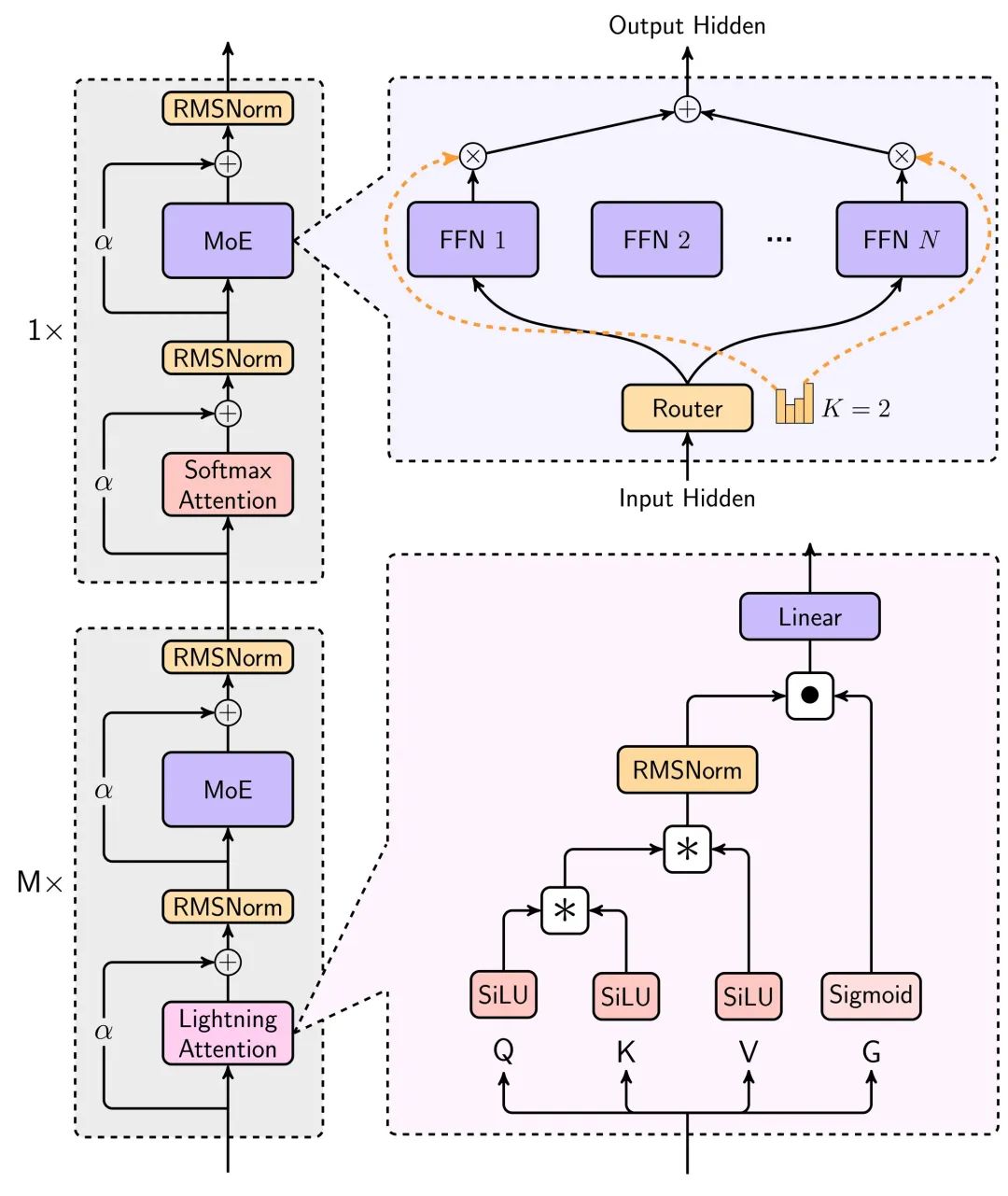

- Новая архитектура молниеносного внимания, квадратичная к линейной, значительно снижает затраты на умозаключения

- Тяжелый открытый исходный код, параметры текстовой модели до 456 миллиардов, 32 эксперта

- Сверхдлинный контекст длиной в 4 миллиона слов и производительность, соответствующая лучшим зарубежным моделям

- Модель, код и технический отчет были выпущены, очень искренне!

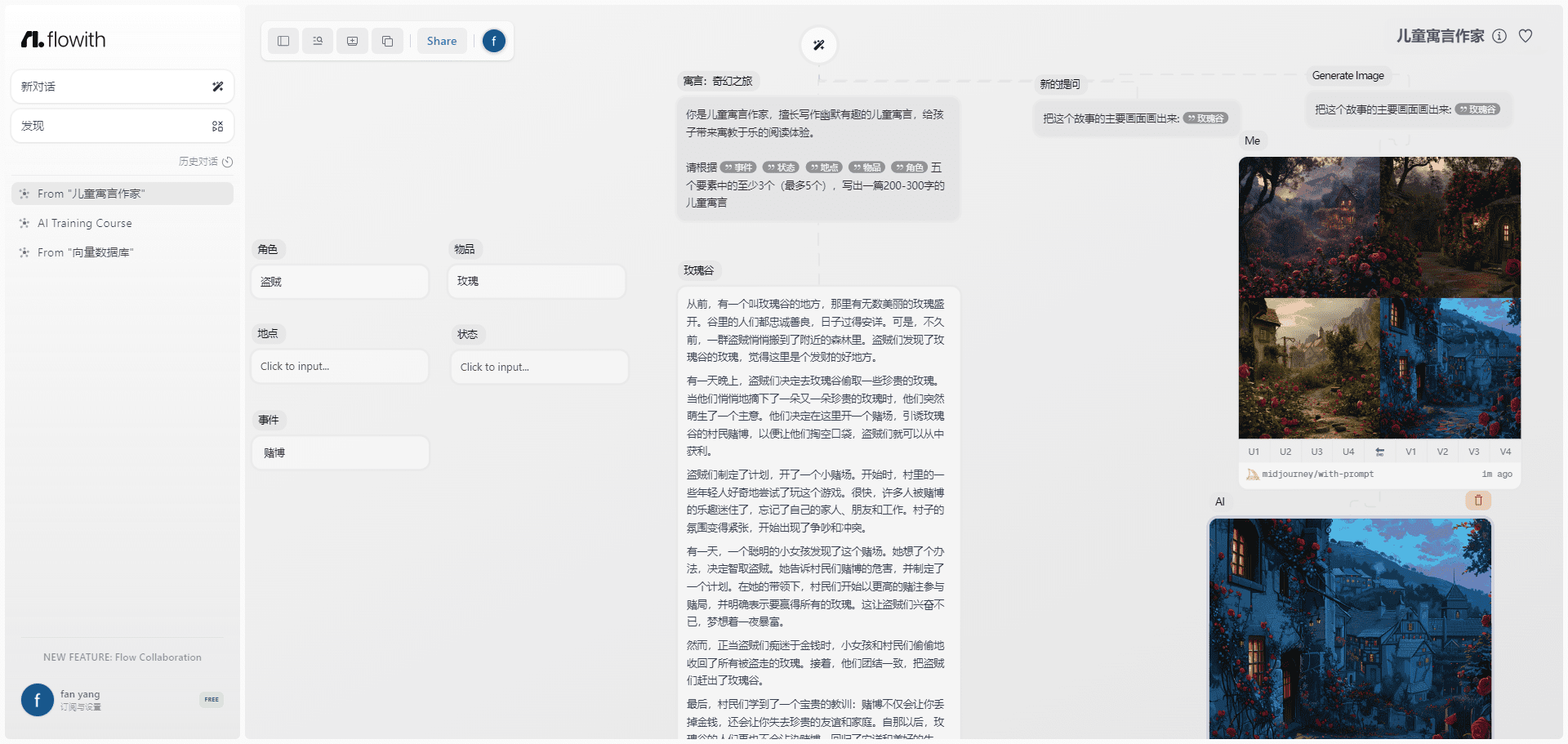

Как веб-интерфейс, так и API уже работают и доступны в режиме онлайн и коммерчески по адресу, указанному в конце статьи.

Новая технология: молниеносное внимание

Самое удивительное в этой модели - новая архитектура линейного внимания.

Мы все знаем, что в реальном использовании ИИ длинный текст имеет решающее значение, длинная память на символы чата, кодирование ИИ для написания кода, агент для выполнения различных задач, сценарий которых неотделим от длинного текста.

Большие модели падают в цене, но чем дольше они используются, тем медленнее и дороже становятся.

Корень этой проблемы заключается в следующем Трансформатор Архитектура имеет квадратичную вычислительную сложность. Арифметическое потребление рассуждений экспоненциально возрастает по мере увеличения контекста.

На этот раз новая модель MiniMax использует механизм линейного внимания Lightning, который позволяет значительно сократить время вычислений и выводов для длинных текстов.

Основные архитектурные схемы для этого моделирования можно увидеть в техническом отчете.

Сокращение потребления ресурсов для вывода модели этой архитектурой огромно, как видно из следующего графика, сравнивающего время вывода для длинного текста, где линейное внимание используется для того, чтобы время вывода медленно увеличивалось почти линейно, а не экспоненциально, по мере роста контекста.

Более подробное описание можно найти в техническом отчете в конце статьи.

Вычисления уменьшаются, цена снижается, а производительность не может быть потеряна надолго для того, чтобы ее можно было использовать по-настоящему.

На графике ниже показана производительность Text-1 на оценочном наборе очень длинных текстов, где он удивительным образом превосходит интервал длиной более 512 Кбайт. Близнецы 2.0 Flash.

Еще один очень интересный момент в техническом отчете - способность модели к контекстному обучению (In-Context Learning), которая постепенно увеличивается по мере улучшения контекста, может стать огромным подспорьем для написания ИИ, а также для задач, требующих долгого запоминания.

В целом, применение механизма Lightning attention позволяет значительно повысить удобство использования длинных текстов для больших моделей, а цена имеет шанс упасть еще на порядок, в будущем ее стоит ждать с большим нетерпением.

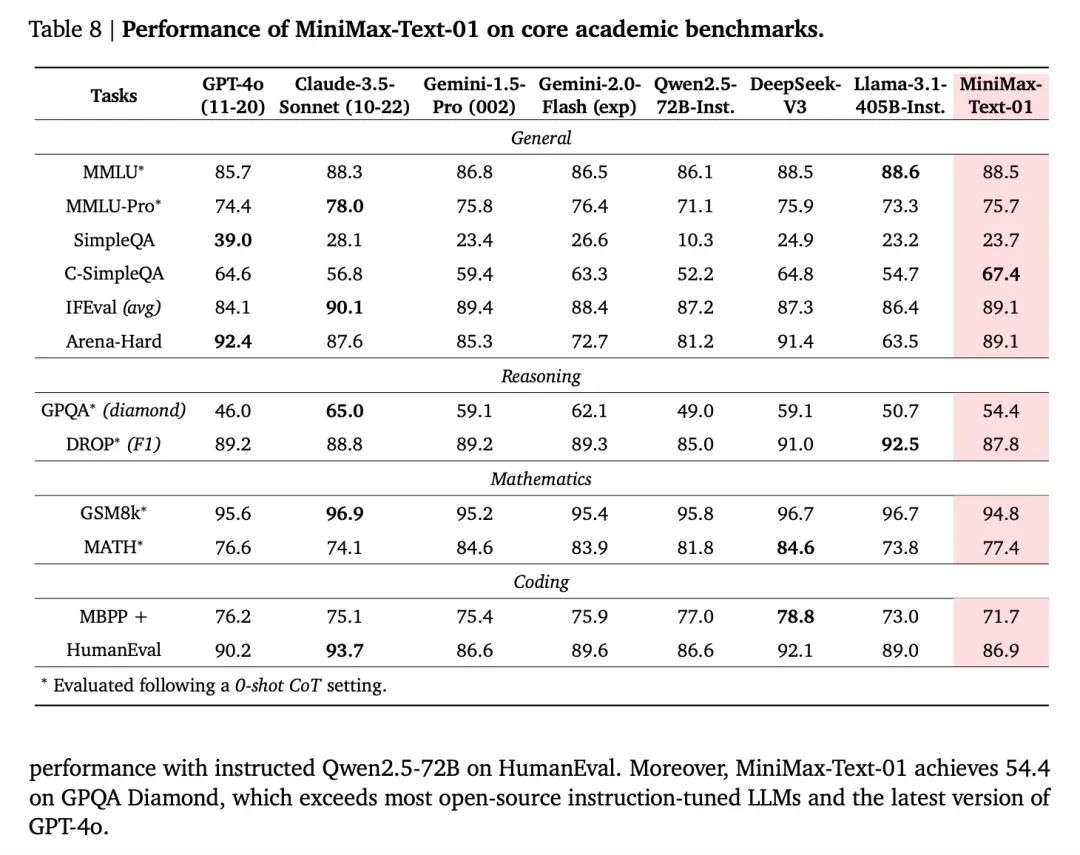

Производительность модели, выравнивание первой линии

Что касается показателей производительности модели, то, будучи моделью с открытым исходным кодом, она по многим показателям догоняет лучшие зарубежные модели с закрытым исходным кодом.

А поскольку модель имеет обратную связь с платформой Conch для оптимизации и итераций, пользовательский опыт в реальных сценариях также гарантирован.

Официальное использование реальных пользовательских сценариев для создания тестового набора, вы можете видеть, что производительность в реальных сценариях также очень яркая, особенно заметны три сценария: творческое письмо, викторины знаний, длинный текст.

Кроме того, модель визуального понимания MiniMax-VL-01 по производительности, в основном, по всем показателям равна или превосходит зарубежные топовые модели, особенно практичные сцены OCR и графики.

Следующий момент трансформера

Когда итерации поколений моделей перестают быть свирепыми, длина контекста и логические рассуждения становятся двумя наиболее приоритетными направлениями.

Что касается контекста, то Gemini когда-то была самой длинной. Более того, генеральный директор DeepMind Демси Хассабис рассказал, что в Google модель Gemini уже достигла длины 10 миллионов токенов в экспериментах и, как полагают, в конечном итоге "достигнет бесконечной длины", но что мешает Gemini сделать это сейчас, так это соответствующая стоимость. Но что мешает Gemini сделать это сейчас, так это соответствующая стоимость. В недавнем интервью он сказал, что у Deepmind теперь есть новый подход к решению этой проблемы стоимости.

Так что тот, кто первым сможет увеличить длину контекста и при этом снизить стоимость, наверняка получит преимущество. Судя по результатам, продемонстрированным MiniMax-01, он действительно добился качественного повышения эффективности.

В этом исчерпывающем техническом отчете об эффективности использования аппаратного обеспечения можно судить по одной статистике - при выводе MiniMax достигает 75% MFU на графических процессорах H20.

MFU (Machine FLOPs Utilization) - это фактическое использование аппаратной вычислительной мощности (FLOPs, т.е. операций с плавающей запятой в секунду) моделью во время работы. Короче говоря, MFU описывает, полностью ли модель использует производительность оборудования. Высокий коэффициент использования определенно приведет к преимуществу в стоимости.

MiniMax 01 - это, безусловно, один из редких сюрпризов в недавних дебатах о мертвых стенах.Как уже говорилось выше, два важных направления, одно из которых в области вывода, а другое - в более длинных контекстах, представлены Deepseek V3 и MiniMax-01.

Интересно, что с точки зрения технического маршрута, оба в определенной степени оптимизируют основной механизм внимания в Transformer, который заложил основу для сегодняшнего бума, и это смелый рефакторинг, аппаратное и программное обеспечение в одном. deepSeek V3 был описан как "доящий" карты Nvidia, и для способности MiniMax достичь такого высокого уровня умозаключений MFU очень важно, что они также Они оптимизируют фреймворк для обучения и непосредственно аппаратное обеспечение.

Согласно отчету MiniMax, они разработали ядро CUDA для линейной концентрации внимания непосредственно с нуля, шаг за шагом, и создали различные сопутствующие фреймворки для этой цели, чтобы оптимизировать эффективное использование ресурсов GPU. Обе компании достигли своих целей благодаря более тесной интеграции аппаратных и программных возможностей.

Еще одно интересное наблюдение: обе эти выдающиеся компании уже инвестировали в исследования и разработку технологии больших моделей до появления ChatGPT, и удивительно, что эти две модели не работают в режиме "догнать GPT4", который мы привыкли видеть в прошлом, а, скорее, в соответствии с их собственной оценкой развития технологии, они сделали большие инвестиции и даже некоторые ставки на инновации, и получили ответ после серии продолжительных солидных работ. Вместо этого, основываясь на собственном мнении о развитии технологий, они сделали большие инвестиции и даже некоторые ставки на инновации, и получили ответ после серии продолжительных и серьезных работ.

И ни один из этих ответов не предназначен только для себя - все они пытаются доказать, что некая концепция, которая когда-то была засунута в лабораторию, может дать тот эффект, который она обещает, будучи развернутой в масштабах реального мира, и тем самым позволить большему числу людей продолжить ее оптимизацию.

Это напоминает времена появления трансформеров.

Когда механизм "Внимание" был запущен еще в лаборатории, но споры не утихали, именно Google, поверив в его потенциал, приложила немало усилий и ресурсов, чтобы превратить его из теоретического эксперимента в реальную вещь, реализованную в масштабном развертывании. Далее люди потянулись к проверенному пути к сегодняшнему процветанию.

Трансформер накладывает друг на друга все больше слоев и потребляет все больше энергии, а MiniMax-01 пытается переделать старый механизм внимания, и это снова и снова напоминает дежавю. -Внимание - это все, что вам нужно.

"В настоящее время модель все еще сохраняет 1/8 часть обычного внимания softmax. Мы работаем над более эффективными архитектурами, которые в конечном итоге полностью устранят softmax-внимание, что позволит достичь неограниченных контекстных окон без перегрузки вычислений".

Цена модели

Вход: $1/миллион жетон

Выход: $8/миллион токенов

В основном используйте его с закрытыми глазами.

Ресурсы для моделирования

Код:https://github.com/MiniMax-AI/MiniMax-01

Модели:https://huggingface.co/MiniMaxAI/MiniMax-Text-01, https://huggingface.co/MiniMaxAI/MiniMax-VL-01

Технический отчет:https://filecdn.minimax.chat/_Arxiv_MiniMax_01_Report.pdf

Веб-сторона:https://hailuo.ai

API. https://www.minimaxi.com/

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие посты

Нет комментариев...