Mini LLM Flow: построение мини-интеллектов LLM с "структурой направленного графа" за 100 строк кода

Общее введение

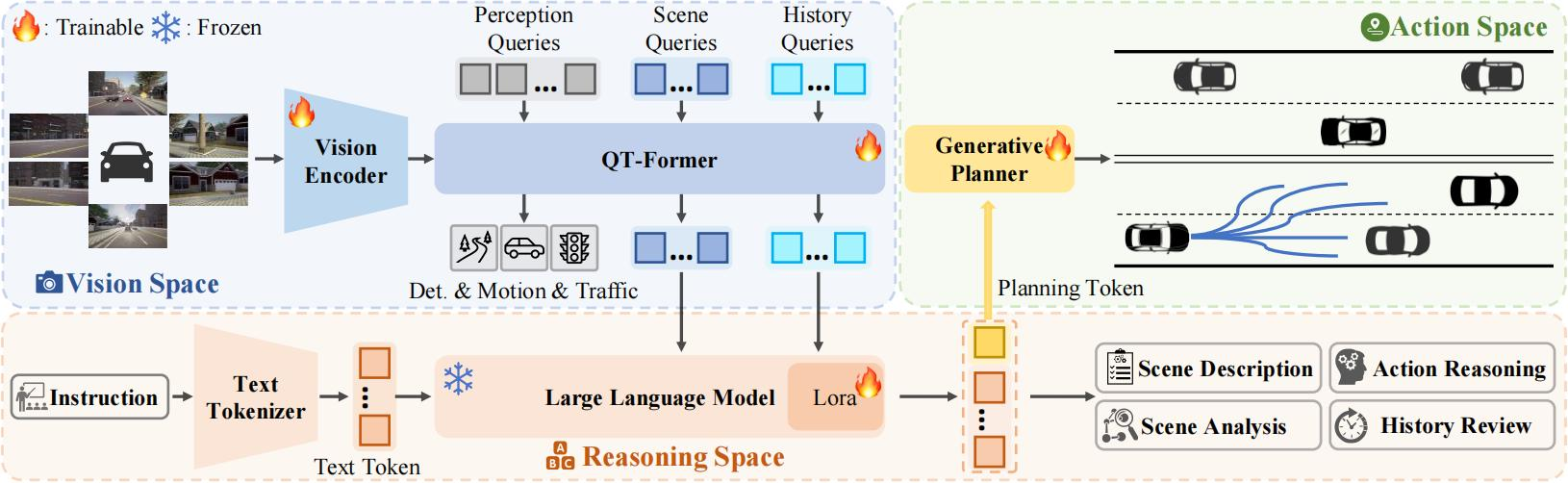

miniLLMFlow - это минималистичный фреймворк для разработки больших языковых моделей (LLM), содержащий всего 100 строк основного кода и демонстрирующий философию дизайна "Путь прост". Фреймворк специально разработан для того, чтобы ИИ-помощники (например, ChatGPT, Claude и т. д.) могли программировать автономно, поддерживая такие продвинутые функции, как мультиинтеллектуальность, декомпозиция задач и улучшение поиска RAG. Проект использует протокол MIT с открытым исходным кодом и постоянно обновляется и поддерживается на платформе GitHub. Его лучшими особенностями являютсяМоделирование рабочих процессов LLM в виде вложенных структур направленных графовОбработка простых задач через узлы, соединение агентов через действия (маркировка ребер), декомпозиция задач через узлы оркестровки процессов, поддержка вложенности процессов и пакетной обработки, что делает разработку сложных приложений ИИ простой и интуитивно понятной.

Список функций

- Поддержка систем совместных разработок с участием нескольких разведчиков

- Обеспечение функций декомпозиции задач и планирования процессов

- Реализация разработки приложения RAG (Retrieval Augmented Generation)

- Поддержка функции пакетной обработки узлов для задач, требующих большого объема данных

- Обеспечьте управление рабочими процессами с помощью вложенной структуры направленного графа

- Интеграция основных ассистентов LLM (например, ChatGPT, Claude)

- Поддержка пользовательских инструментов и упаковки API

- Полная документация и учебная поддержка

Использование помощи

1. конфигурация установки

Способ 1: Установка с помощью pip

pip install minillmflow

Подход 2: Прямое использование исходного кода

Быстро интегрируйте в свой проект, скопировав файл исходного кода (всего 100 строк) прямо из проекта.

2. Описание инфраструктуры

miniLLMFlow использует структуру вложенного направленного графа и содержит следующие основные понятия:

- Узлы: Базовый блок для обработки отдельных задач LLM

- Действия: маркированные ребра связанных узлов для взаимодействия между интеллектами

- ПотокиНаправленные графы, образованные хореографическими узлами, для декомпозиции задач

- МатрешкаПроцессы можно повторно использовать в качестве узлов для поддержки создания сложных приложений.

- Партия: Поддержка параллельной обработки задач, требующих больших объемов данных

3. Руководство по процессу разработки

- этап проектирования

- Определение высокоуровневых процессов и структур узлов

- Проектирование структур общей памяти

- Определение полей данных и методов обновления

- Этап реализации

- Начните с простой реализации

- Поэтапное добавление сложной функциональности

- Разработано с помощью ассистента LLM

- Разработано с помощью LLM Assistant

- Разработка проекта с Клодом::

- Создайте новый проект и загрузите документы

- Установка инструкций по настройке проекта

- Пусть Клод поможет с разработкой и реализацией

- Разработка с помощью ChatGPT::

- Используйте специализированный помощник GPT

- Возможность использования более новых моделей для разработки кода

- Разработка проекта с Клодом::

4. Пример начала работы

Проект содержит полное вводное руководство, показывающее, как реализовать систему Paul Graham Article Abstract и QA Proxy, которую можно быстро освоить, начав работать с Google Colab.

5. лучшие практики

- Начните с простой функциональности и постепенно расширяйте ее

- Полностью используйте ассистента LLM для развития

- Обратитесь к примеру кода в документации

- Используйте встроенные средства отладки и тестирования

- Следите за обновлениями проекта и обсуждениями в сообществе

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...