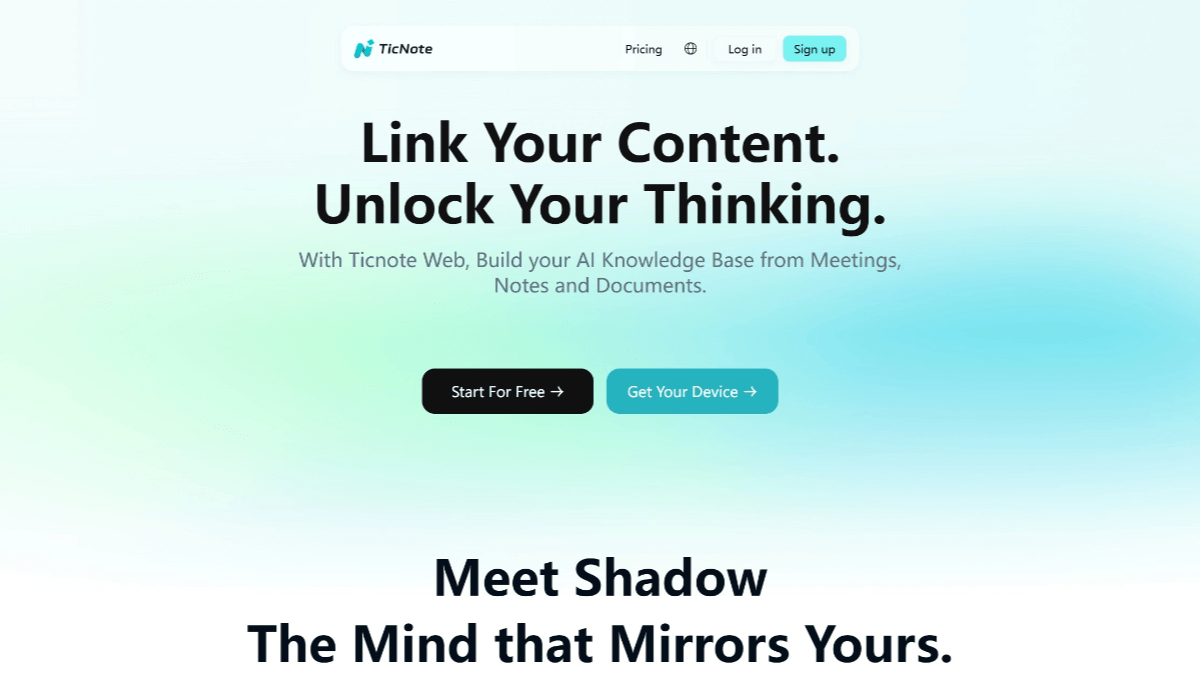

Ming-flash-omni-Preview - макромодель Ant Group с открытым исходным кодом и полной модальностью

Что такое Ming-flash-omni-Preview?

Ming-flash-omni-Preview - полномодальная макромодель с открытым исходным кодом, выпущенная компанией Ant Group's inclusionAI, с масштабом параметров в сотни миллиардов, основанная на разреженной MoE-архитектуре Ling 2.0, с общими параметрами 103B и активациями 9B. Она превосходит все остальные в полномодальном понимании и генерации, особенно в управляемой генерации изображений, понимании потокового видео, речи и диалекта. В частности, он имеет значительные преимущества в генерации управляемых изображений, понимании потокового видео, распознавании речи и диалектов, а также в тембровом клонировании. Первая "генеративная парадигма сегментации" позволяет добиться тонкого пространственного семантического контроля и высокой управляемости генерацией изображений; модель может понимать потоковое видео на тонком уровне и давать пояснения в реальном времени; в области речи она поддерживает контекстно-ориентированное понимание речи и распознавание диалектов, причем ее способность понимать 15 китайских диалектов была значительно улучшена, а способность тембрового клонирования также была значительно улучшена. Архитектура обучения модели эффективна, а пропускная способность обучения улучшена за счет нескольких оптимизаций.

Особенности Ming-flash-omni-Preview

- Полная модальная способность: Поддерживает множество модальных входов и выходов, включая изображения, текст, видео и аудио, с мощными возможностями мультимодального понимания и генерации.

- Контролируемое формирование изображенийПервая "Парадигма генеративной сегментации", реализующая тонкий пространственный семантический контроль и значительно повышающая управляемость процесса создания и редактирования изображений.

- Понимание потокового видео: обеспечивает тонкое понимание потокового видео, предоставляет в реальном времени описания соответствующих объектов и взаимодействий, а также поддерживает непрерывный диалог на основе реалистичных сценариев.

- Фонетика и понимание диалектов: Поддерживает распознавание речи с учетом контекста (Context-Aware Speech Recognition, ContextASR) и распознавание диалектов, значительно улучшая понимание 15 китайских диалектов.

- клонирование тона: Модернизированная функция генерации речи, способная эффективно клонировать тембр оригинального диалога во вновь созданный диалог, со стабильным смешанным китайским и английским произношением.

- Эффективная система обученияОсновываясь на разреженной архитектуре MoE, пропускная способность обучения улучшается за счет нескольких оптимизаций для достижения "большой емкости и малой активации" для каждого режима.

- Открытый исходный код и поддержка сообщества: Модель и код являются открытым исходным кодом, и ресурсы можно найти на GitHub, HuggingFace и ModelScope, чтобы разработчики могли опробовать их и оставить отзыв.

Основные преимущества Ming-flash-omni-Preview

- Размер параметра 100 миллиардов: Являясь первой полномодальной макромоделью с открытым исходным кодом и масштабом параметров в сотни миллиардов, она обладает мощными вычислительными возможностями и богатым семантическим пониманием.

- Разреженная архитектура MoEРазреженная архитектура MoE, основанная на Ling 2.0, позволяет достичь "большой емкости, малой активации", что повышает производительность и гибкость модели при сохранении высокой вычислительной эффективности.

- Мультимодальное лидерство: Достижение ведущего уровня полномодальных моделей с открытым исходным кодом в таких модальных задачах, как генерация изображений, понимание видео и распознавание речи, и особенно в генерации управляемых изображений и распознавании диалектов.

- Инновационная парадигма генеративной сегментацииПредложена парадигма совместного обучения "генеративная сегментация как редактирование", позволяющая реконструировать сегментацию изображений в задачу редактирования с сохранением семантики, что значительно улучшает управляемость процессом генерации изображений и качество редактирования.

- Эффективное обучение и оптимизация: Проблема неоднородности данных и неоднородности моделей при мультимодальном обучении решается с помощью таких методов, как упаковка последовательностей и эластичная нарезка кодеров, которые значительно повышают пропускную способность обучения.

Какой официальный сайт у Ming-flash-omni-Preview?

- Репозиторий GitHub: https://github.com/inclusionAI/Ming

- Библиотека моделей HuggingFace: https://huggingface.co/inclusionAI/Ming-flash-omni-Preview

Ming-flash-omni-Preview's Applicable Crowd

- Исследователи искусственного интеллекта: Предназначенная для мультимодальных исследований, модель может быть использована для изучения новых методов и сценариев применения мультимодального слияния изображений, видео и речи.

- инженер-разработчик: Те, кто хочет интегрировать мультимодальные функции в свои проекты, например, разработать приложения для интеллектуального анализа видео, голосового взаимодействия, создания изображений и т.д., смогут быстро добиться этого благодаря мощным мультимодальным возможностям.

- специалист по анализу данных: Мультимодальные данные нуждаются в обработке и анализе, которые могут быть использованы для предварительной обработки данных, извлечения признаков и т. д., чтобы повысить эффективность и качество обработки данных.

- Дизайнер продукции: Сосредоточившись на пользовательском опыте и инновациях, мультимодальные возможности генерации могут быть использованы для разработки более креативных и интерактивных продуктов.

- педагог: Он может применяться в сфере образования, например, при разработке интеллектуального образовательного программного обеспечения для повышения эффективности обучения и интерактивности с помощью распознавания голоса, создания изображений и других функций.

- создатель контентаТакие как видеопродюсеры, дизайнеры, писатели и т.д., могут использовать его генеративные возможности для быстрого создания креативного контента и повышения эффективности творческой деятельности.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...