MegaTTS3: легкая модель для синтеза китайской и английской речи

Общее введение

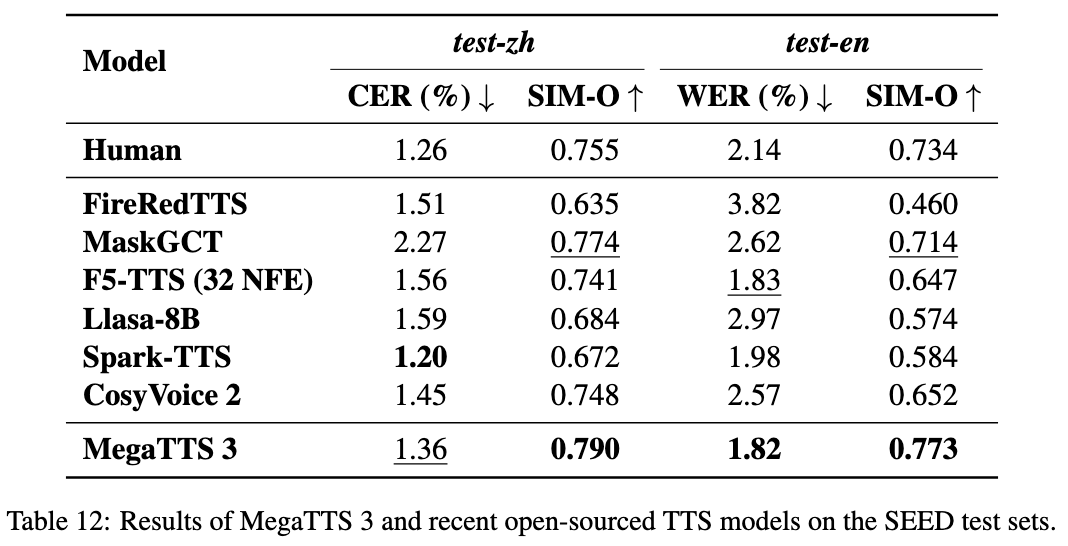

MegaTTS3 - это инструмент синтеза речи с открытым исходным кодом, разработанный компанией ByteDance в сотрудничестве с Чжэцзянским университетом и предназначенный для генерации высококачественной китайской и английской речи. Его основная модель имеет всего 0,45 ББ параметров, легка и эффективна, поддерживает генерацию смешанной китайской и английской речи и клонирование речи. Проект размещен на GitHub и предоставляет код и предварительно обученные модели для бесплатного скачивания.MegaTTS3 может имитировать целевой голос с помощью нескольких секунд аудиообразцов, а также поддерживает настройку интенсивности акцента. Он подходит для академических исследований, создания контента и разработки речевых приложений, а функции контроля произношения и длительности будут добавлены в будущем.

Список функций

- Генерируйте китайскую, английскую и смешанную речь с естественным и плавным выходом.

- Высококачественное клонирование речи достигается с помощью небольшого количества звука, имитирующего определенный тембр.

- Поддерживает настройку силы акцента, может генерировать речь с акцентом или стандартным произношением.

- Используйте акустические латенты для повышения эффективности обучения модели.

- Встроенный высококачественный вокодер WaveVAE для повышения разборчивости и реалистичности речи.

- Для поддержки анализа речи предусмотрены подмодули Aligner и Graphme-to-Phoneme.

- Открытый исходный код и предварительно обученные модели для пользовательской разработки.

Использование помощи

MegaTTS3 требует некоторого базового опыта программирования, особенно на Python и в средах глубокого обучения. Ниже приведены подробные инструкции по установке и использованию.

Процесс установки

- Построенная среда

MegaTTS3 РекомендуетсяPython 3.9. Это можно сделать с помощьюCondaСоздайте виртуальную среду:conda create -n megatts3-env python=3.9 conda activate megatts3-envПосле активации все операции выполняются в этой среде.

- Код загрузки

Выполните следующую команду в терминале для клонированияGitHubСклад:git clone https://github.com/bytedance/MegaTTS3.git cd MegaTTS3 - Установка зависимостей

Проектные предложенияrequirements.txtЕсли вы хотите установить необходимые библиотеки, выполните следующую команду:pip install -r requirements.txtВремя установки зависит от сети и устройства и обычно завершается за несколько минут.

- Получение модели

Предварительно обученные модели можно загрузить с Google Drive или Hugging Face (см. официальные ссылки).README). Скачайте его и распакуйте в./checkpoints/Папка. Пример:- главнокомандующий (военный)

model.pthвводить./checkpoints/model.pth. - предварительно экстрагированный

latentsФайлы должны быть загружены по указанной ссылке в ту же директорию.

- главнокомандующий (военный)

- тестовая установка

Запустите простую тестовую команду для проверки среды:python tts/infer_cli.py --input_wav 'assets/Chinese_prompt.wav' --input_text "测试" --output_dir ./genЕсли сообщений об ошибках нет, значит, установка прошла успешно.

Основные функции

синтез речи

Генерация речи - основная функция MegaTTS3. Она требует ввода текста и эталонного аудио:

- Подготовьте документ

существоватьassets/в папку с эталонным аудио (например.Chinese_prompt.wavиlatentsФайлы (например.Chinese_prompt.npy). Если нетlatentsТребуются официальные предварительно извлеченные файлы. - Выполнить команду

Вход:CUDA_VISIBLE_DEVICES=0 python tts/infer_cli.py --input_wav 'assets/Chinese_prompt.wav' --input_text "你好,这是一段测试语音" --output_dir ./gen--input_wavопорный аудиотракт.--input_textэто текст, который необходимо синтезировать.--output_dirвыходная папка.

- Посмотреть результаты

Созданная речь сохраняется в./gen/output.wavФильм доступен для прямого воспроизведения.

клонирование речи

Для имитации определенного звука требуется всего несколько секунд аудиосэмплов:

- Подготовьте четкий опорный звук (рекомендуется 5-10 секунд).

- Используйте приведенную выше команду синтеза, чтобы указать

--input_wav. - Выходной голос будет максимально приближен к эталонному тону.

регулировка акцента

Настройка силы акцента с помощью параметров p_w ответить пением t_w::

- Введите английский звук с акцентом:

CUDA_VISIBLE_DEVICES=0 python tts/infer_cli.py --input_wav 'assets/English_prompt.wav' --input_text "这是一条有口音的音频" --output_dir ./gen --p_w 1.0 --t_w 3.0 p_wподход1.0Временами сохраняется оригинальный акцент, но при этом нарастает тенденция к стандартному произношению.t_wКонтролирует сходство тембров, обычно более чемp_wваш (почетный)0-3.- Создайте стандартное произношение:

CUDA_VISIBLE_DEVICES=0 python tts/infer_cli.py --input_wav 'assets/English_prompt.wav' --input_text "这条音频发音标准一些" --output_dir ./gen --p_w 2.5 --t_w 2.5

Операции с веб-интерфейсом

Поддерживает работу через веб-интерфейс:

- Бег:

CUDA_VISIBLE_DEVICES=0 python tts/gradio_api.py - Откройте браузер и введите адрес (по умолчанию)

localhost:7860), загружайте аудио и текст для создания речи.CPUПриблизительно 30 секунд в условиях окружающей среды.

Использование субмодуля

Алигномер

- функциональность: Выравнивание речи и текста.

- использование: Беги

tts/frontend_function.pyПример кода для сегментации речи или распознавания фонем в

Графема к фонеме

- функциональность: Преобразование текста в фонемы.

- использование: Справочник

tts/infer_cli.py, который можно использовать для анализа произношения.

WaveVAE

- функциональность: Сжатый звук

latentsи восстановлен. - ограничение: параметры кодировщика не раскрываются и могут использоваться только с предварительно извлеченными

latents.

предостережение

- Параметры кодировщика WaveVAE недоступны по соображениям безопасности и могут использоваться только с официальными

latentsДокументация. - Проект был выпущен 22 марта 2025 года и до сих пор находится в стадии разработки, планируются новые варианты произношения и корректировки продолжительности.

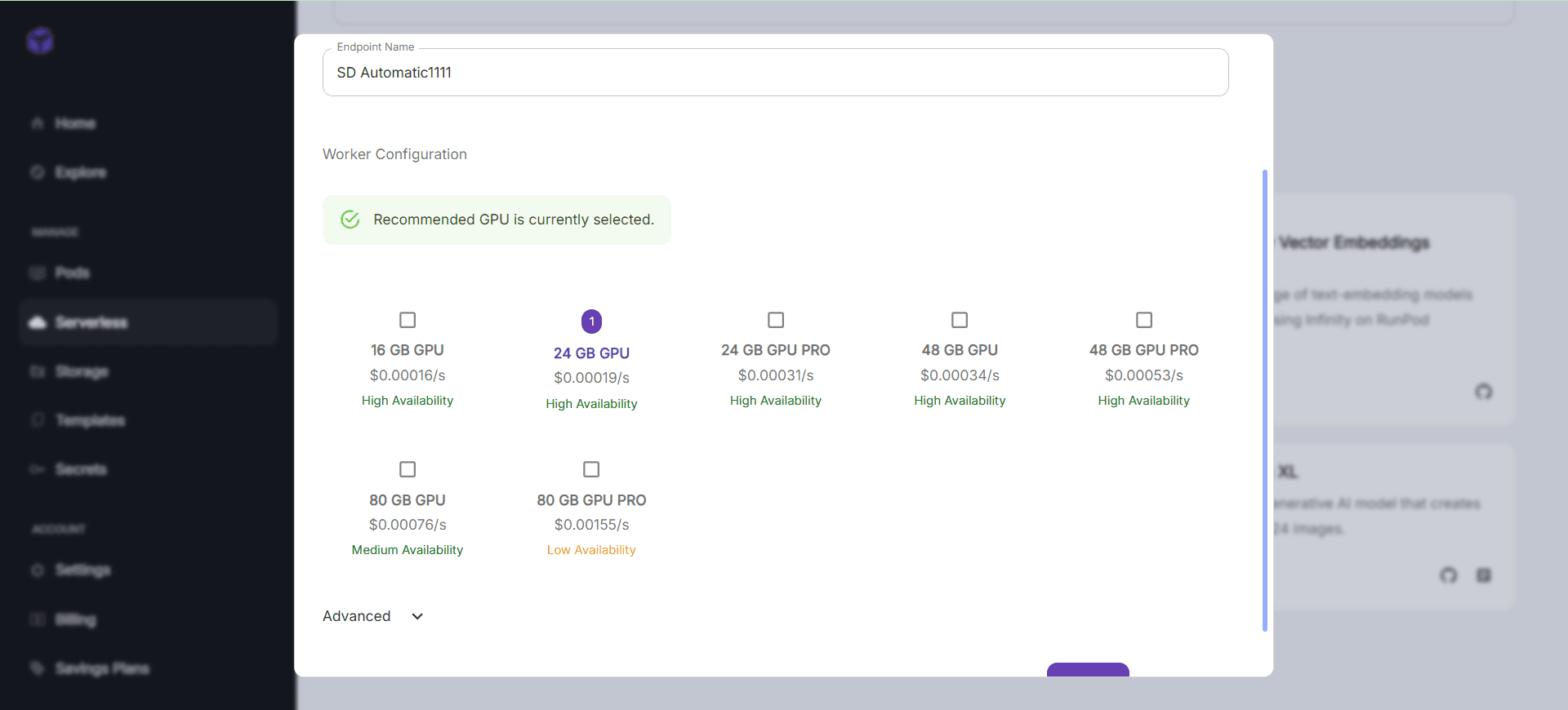

GPUУскоренные рекомендации.CPUРаботает, но медленно.

сценарий применения

- научные исследования

Исследователи могут тестировать методы синтеза речи с помощью MegaTTS3, анализируяlatentsЭффект - Учебные пособия

Преобразование учебников в речь и создание аудиокниг для повышения эффективности обучения. - создание контента

Создавайте дикторский текст для видео или подкастов и экономьте на затратах на ручную запись. - голосовое взаимодействие

Разработчики могут интегрировать его в свои устройства, чтобы обеспечить голосовой диалог на английском и китайском языках.

QA

- Какие языки поддерживаются?

Поддерживает китайский, английский и смешанную речь, с возможностью расширения на другие языки в будущем. - обязательно

GPUЧто? Я не знаю.

Не обязательно.CPUЕго можно запустить, но он работает медленно, поэтому рекомендуется использоватьGPU. - Как справиться со сбоями в установке?

обновлениеpip(pip install --upgrade pip), проверить сеть или вGitHubОтправить выпуск. - Почему отсутствуют кодировщики WaveVAE?

Не разглашается по соображениям безопасности, требуется официальное предварительное извлечениеlatents.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...