Marco-o1: версия модели OpenAI o1 с открытым исходным кодом, основанная на Qwen2-7B-Инструкции по тонкой настройке для изучения открытых моделей вывода для решения сложных проблем

Общее введение

Marco-o1 - это открытая модель рассуждений, разработанная Alibaba International Digital Commerce Group (AIDC-AI) для решения сложных задач реального мира. Модель сочетает в себе тонкую настройку цепочки мышления (CoT), поиск по дереву Монте-Карло (MCTS) и инновационные стратегии рассуждений для оптимизации решения сложных задач. Marco-o1 не только фокусируется на дисциплинах со стандартными ответами, таких как математика, физика и программирование, но и стремится обобщить их на области, где нет четких критериев и где трудно определить количественную оценку вознаграждения. Цель проекта - изучить потенциал крупномасштабных моделей вывода для многоязычных приложений и, путем постоянной оптимизации и совершенствования, расширить возможности моделей в плане рассуждений и область их применения.

Список функций

- Тонкая настройка цепочки мыслей (CoT): Повышение способности модели к выводу путем точной настройки базовой модели с полными параметрами, сочетая открытые наборы данных CoT и синтетические данные собственных исследований.

- Поиск по дереву Монте-Карло (MCTS): Использование достоверности результатов моделирования для управления поиском, расширения пространства решений и оптимизации пути вывода.

- Стратегия разумных действий: Внедрение инновационных стратегий рассуждающих действий и рефлексивных механизмов для изучения действий на разных уровнях детализации и улучшения способности моделей решать сложные проблемы.

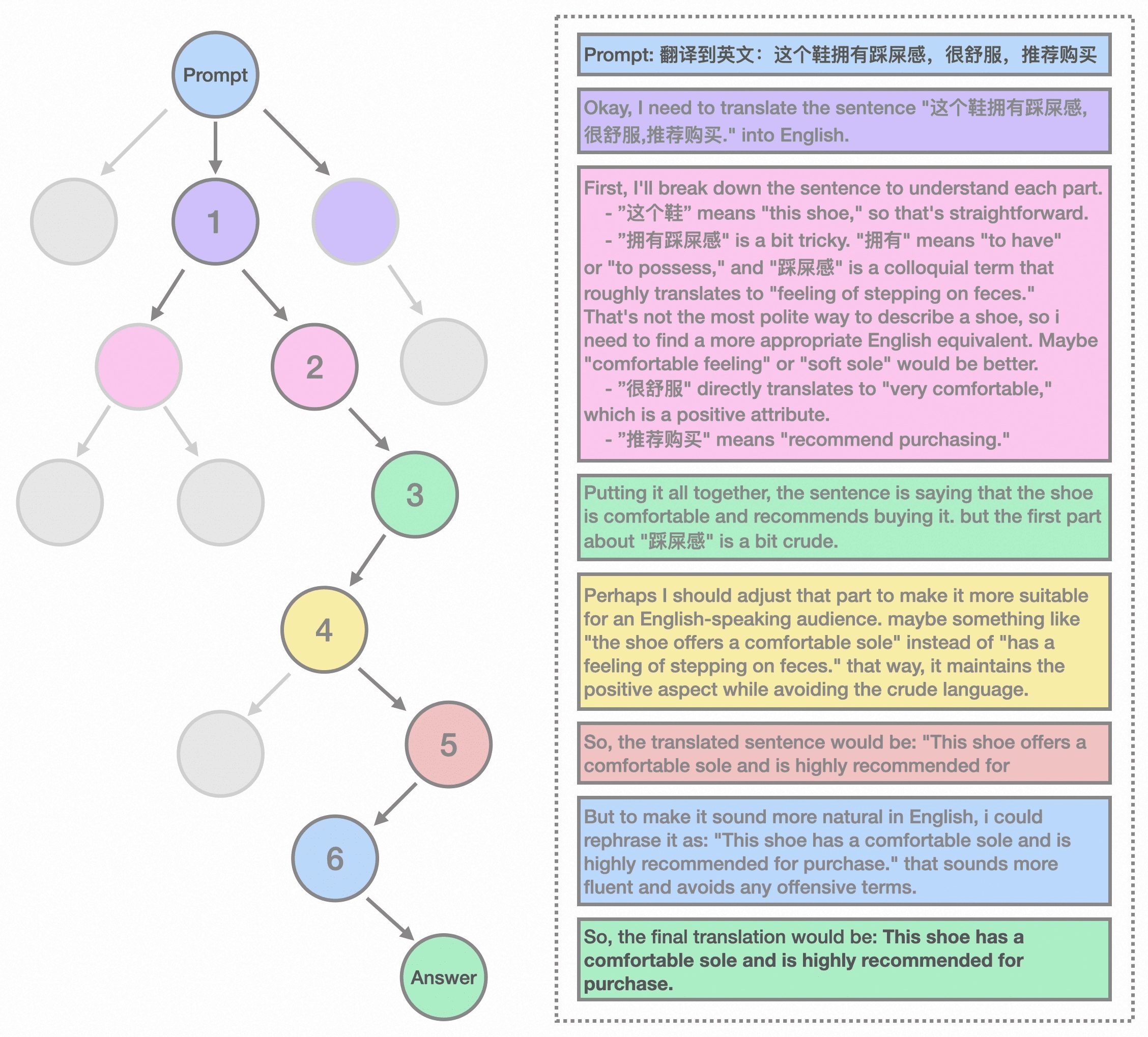

- Задания по многоязычному переводу: Первое применение крупномасштабной модели вывода к задаче машинного перевода, исследование законов масштабирования времени вывода в многоязычных и переводческих доменах.

- Обучение модели вознагражденияРазработка моделирования вознаграждения за результат (ORM) и моделирования вознаграждения за процесс (PRM) для обеспечения более точных сигналов вознаграждения и уменьшения случайности результатов поиска по дереву.

- Интенсивное обучениеОптимизация процесса принятия решений моделью с помощью методов обучения с усилением для дальнейшего расширения ее возможностей по решению задач.

Использование помощи

Процесс установки

- Посетите страницу GitHub: Перейти кСтраница Marco-o1 на GitHub.

- склад клонов: Используйте команду

git clone https://github.com/AIDC-AI/Marco-o1.gitКлонируйте репозиторий в локальный. - Установка зависимостей: Перейдите в каталог проекта и выполните команду

pip install -r requirements.txtУстановите необходимые зависимости.

Руководство по использованию

- Модели для погрузки: В среде Python используйте следующий код для загрузки модели:

from transformers import AutoModelForCausalLM, AutoTokenizer model_name = "AIDC-AI/Marco-o1" model = AutoModelForCausalLM.from_pretrained(model_name) tokenizer = AutoTokenizer.from_pretrained(model_name) - Пример рассуждений: Рассуждения с моделями, вот простой пример:

python

input_text = "How many 'r' are in strawberry?"

inputs = tokenizer(input_text, return_tensors="pt")

outputs = model.generate(**inputs)

print(tokenizer.decode(outputs[0], skip_special_tokens=True)) - многоязычный переводMarco-o1 отлично справляется с задачами перевода на несколько языков, пример перевода показан ниже:

python

input_text = "这个鞋拥有踩屎感"

inputs = tokenizer(input_text, return_tensors="pt")

outputs = model.generate(**inputs)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))

Подробный порядок работы функций

- Тонкая настройка цепочки мыслей (CoT)::

- Подготовка данных: Сбор и сопоставление открытых наборов данных CoT и синтетических данных для самостоятельных исследований.

- Тонкая настройка моделирования: Используйте полученные данные для точной настройки базовой модели с полными параметрами, чтобы улучшить ее вывод.

- Поиск по дереву Монте-Карло (MCTS)::

- узловое представление: В системе MCTS каждый узел представляет собой состояние рассуждения в процессе решения проблемы.

- Выход движения: Возможные действия узла генерируются LLM и представляют собой потенциальные шаги в цепочке умозаключений.

- Откат и расчет бонусов: Во время фазы отката LLM продолжает процесс рассуждений до состояния завершения.

- Поиск в Bootstrap: Используйте баллы вознаграждения для оценки и выбора перспективных путей, чтобы направить поиск в сторону более надежных цепочек умозаключений.

- Стратегия разумных действий::

- Гранулярность действий: Изучение действий на различных уровнях в рамках MCTS для повышения эффективности и точности поиска.

- Механизмы отражения: Побуждение моделей к самоанализу значительно повышает их способность решать сложные проблемы.

- Задания по многоязычному переводу::

- применение миссии: Применение больших моделей вывода к задачам машинного перевода для изучения законов масштабирования времени вывода в многоязычных и переводческих доменах.

- Пример перевода: Продемонстрируйте превосходные характеристики модели при переводе сленговых выражений.

- Обучение модели вознаграждения::

- Моделирование вознаграждения за результат (ORM): Обучение моделей для получения более точных сигналов вознаграждения и уменьшения случайности результатов поиска по дереву.

- Моделирование вознаграждения за процесс (PRM): Дальнейшая оптимизация путей вывода модели с помощью моделирования вознаграждения за процесс.

- Интенсивное обучение::

- Оптимизация решенийОптимизация процесса принятия решений моделью и улучшение ее возможностей по решению задач с помощью методов обучения с подкреплением.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...