LocalAI: решения для развертывания локального ИИ с открытым исходным кодом, поддержка нескольких архитектур моделей, унифицированное управление моделями и API с помощью WebUI.

Общее введение

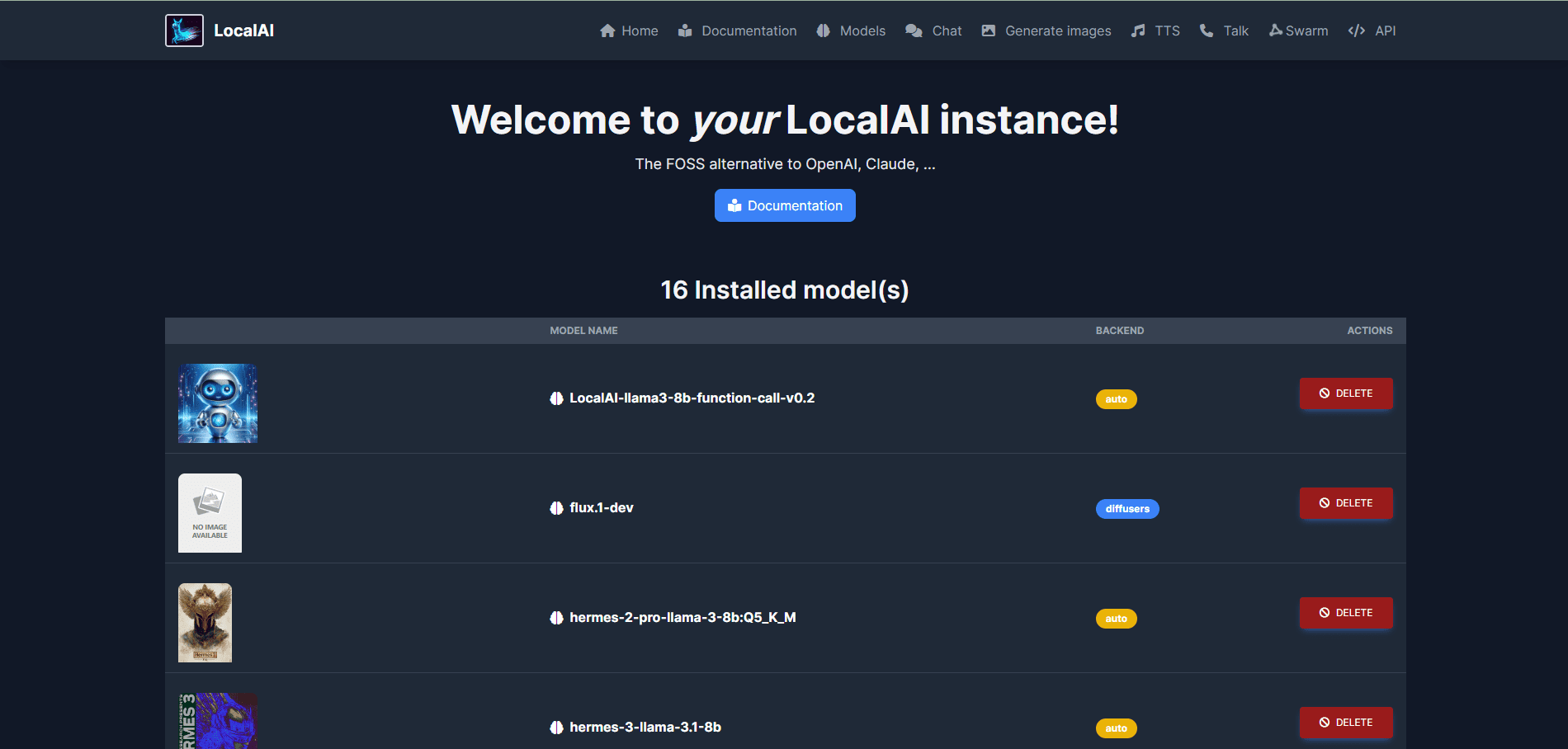

LocalAI - это альтернативный локальный ИИ с открытым исходным кодом, который стремится предоставить API-интерфейсы, совместимые с OpenAI, Claude и другими. LocalAI был создан и поддерживается Этторе Ди Джачинто и поддерживает широкий спектр архитектур моделей, включая gguf, transformers, diffusers и другие, для локального или локального развертывания.

Список функций

- Генерация текста: поддерживает серию моделей GPT, способных генерировать высококачественный текстовый контент.

- Генерация звука: генерируйте естественный и плавный голос с помощью функции преобразования текста в звук.

- Формирование изображений: высококачественные изображения создаются с помощью стабильной диффузионной модели.

- Клонирование речи: генерируйте речь, похожую на оригинальный голос, с помощью технологии клонирования речи.

- Distributed Reasoning: поддерживает P2P-рассуждения для повышения эффективности обоснования моделей.

- Загрузка моделей: загружайте и запускайте модели непосредственно с таких платформ, как Huggingface.

- Интегрированный веб-интерфейс: обеспечивает интегрированный веб-интерфейс для удобного управления.

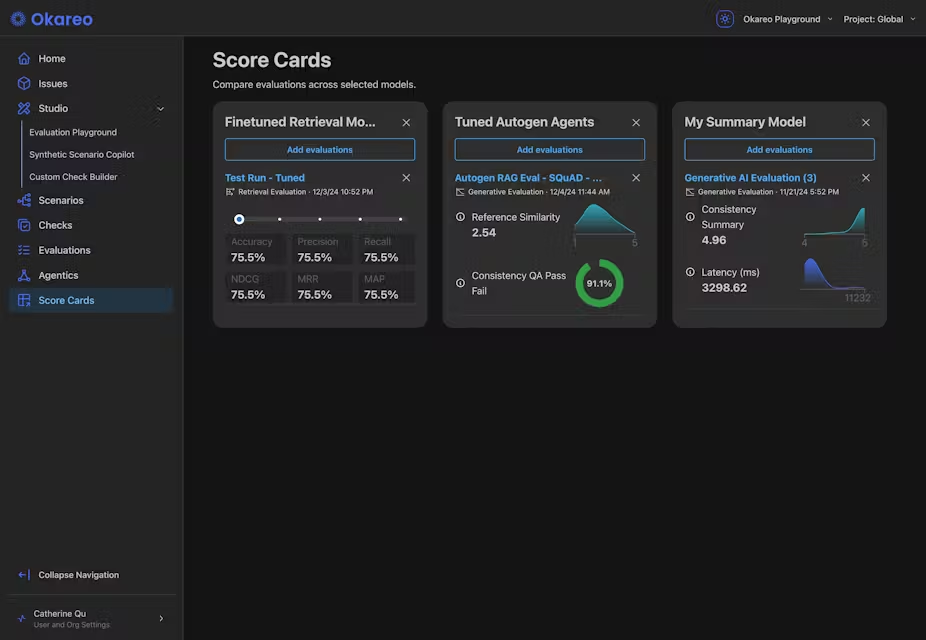

- Vector Database Embedding Generation: поддержка создания векторной базы данных для встраивания.

- Ограниченный синтаксис: поддержка генерации текстового содержимого с ограниченным синтаксисом.

- Vision API: предоставляет функции обработки и анализа изображений.

- Reordering API: поддерживает переупорядочивание и оптимизацию текстового контента.

Процесс установки

- Использование сценариев установки::

- Выполните следующую команду, чтобы загрузить и установить LocalAI:

curl -s https://localai.io/install.sh | sh

- Выполните следующую команду, чтобы загрузить и установить LocalAI:

- Использование Docker::

- Если GPU отсутствует, выполните следующую команду для запуска LocalAI:

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-aio-cpu - Если у вас графический процессор Nvidia, выполните следующую команду:

docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-aio-gpu-nvidia-cuda-12

- Если GPU отсутствует, выполните следующую команду для запуска LocalAI:

Процесс использования

- Запуск LocalAI::

- После запуска LocalAI через процесс установки, описанный выше, зайдите в

http://localhost:8080Перейдите в веб-интерфейс.

- После запуска LocalAI через процесс установки, описанный выше, зайдите в

- Модели для погрузки::

- В WebUI перейдите на вкладку Models, выберите и загрузите нужную модель.

- В качестве альтернативы можно загрузить модель с помощью командной строки, например:

local-ai run llama-3.2-1b-instruct:q4_k_m

- Создавайте контент::

- В WebUI выберите соответствующий функциональный блок (например, генерация текста, генерация изображений и т. д.), введите необходимые параметры и нажмите кнопку Generate.

- Например, чтобы сгенерировать текст, введите запрос, выберите модель и нажмите кнопку "Сгенерировать текст".

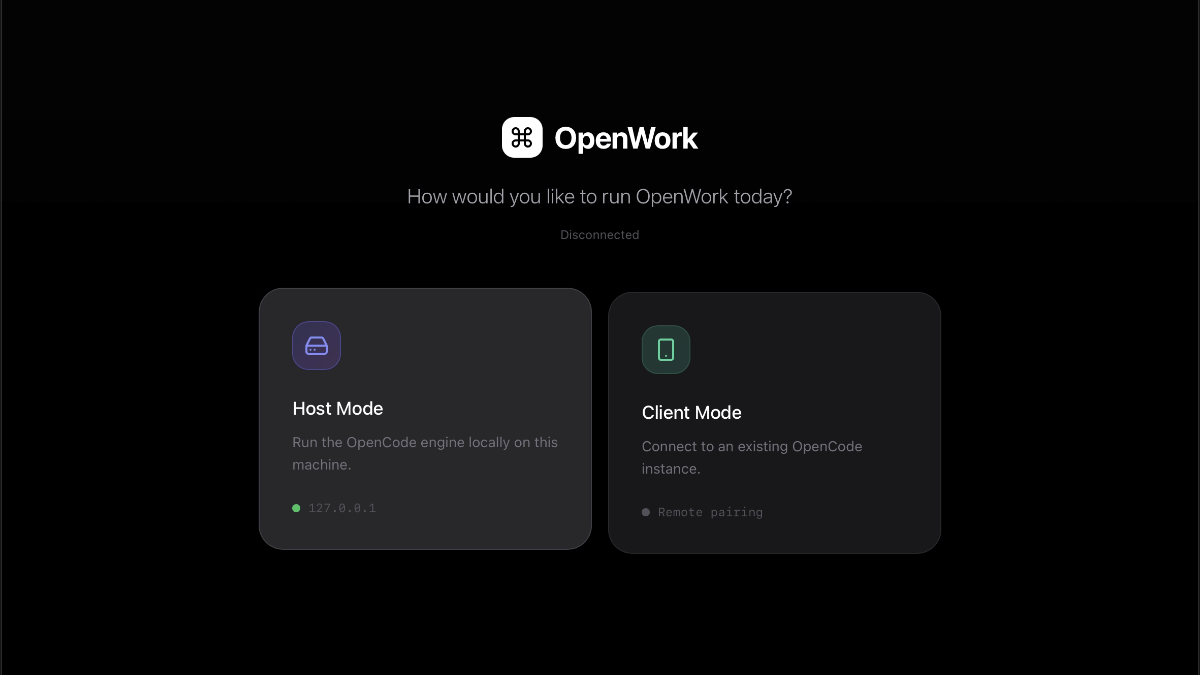

- распределённый вывод::

- Настройте несколько экземпляров LocalAI для проведения распределенных P2P-выводов и повышения эффективности вычислений.

- Обратитесь к руководству по настройке распределенного вывода в официальной документации.

Дополнительные возможности

- Пользовательские модели::

- Пользователи могут загружать и скачивать пользовательские модели из Huggingface или реестра OCI для удовлетворения конкретных потребностей.

- Интеграция API::

- LocalAI предоставляет REST API, совместимый с OpenAI API, чтобы разработчики могли легко интегрировать его в существующие приложения.

- Подробные сведения об использовании API см. в официальной документации по API.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...