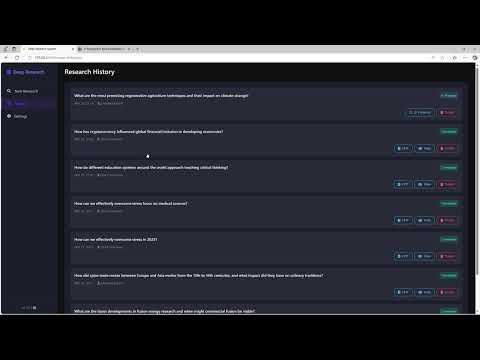

Местные глубокие исследования: локальный инструмент для создания отчетов о глубоких исследованиях

Общее введение

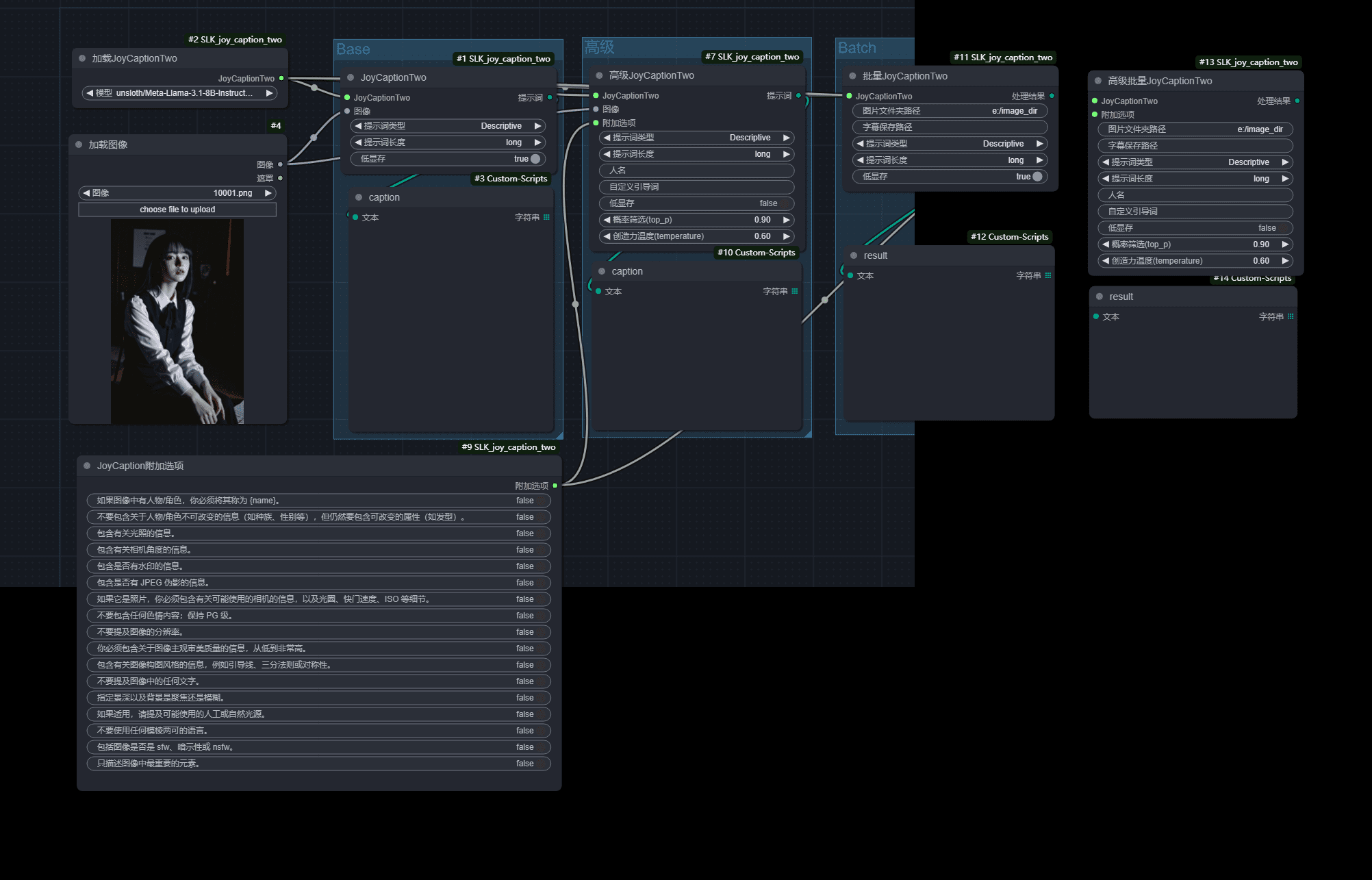

Local Deep Research - это исследовательский помощник ИИ с открытым исходным кодом, призванный помочь пользователям проводить глубокие исследования и создавать подробные отчеты по сложным проблемам. Он поддерживает локальную работу, позволяя пользователям выполнять исследовательские задачи, не полагаясь на облачные сервисы. Инструмент сочетает локальное моделирование больших языков (LLM) с разнообразными функциями поиска по таким источникам, как академические базы данных, Википедия, веб-контент и другие. Пользователи могут быстро создавать комплексные отчеты с цитатами благодаря простой установке и настройке. Проект делает акцент на защите конфиденциальности и гибкости и подходит для академических исследований, изучения технологий и управления личными знаниями.

Список функций

- Поддержка локальных больших языковых моделей для защиты конфиденциальности данных.

- Автоматически выбирайте подходящие инструменты поиска, такие как Wikipedia, arXiv, PubMed и т. д.

- Создавайте подробные отчеты со структурированными разделами и ссылками.

- Функция быстрых резюме, позволяющая получить краткие ответы за считанные секунды.

- Поддерживает локальный поиск документов в сочетании с веб-поиском для всестороннего анализа.

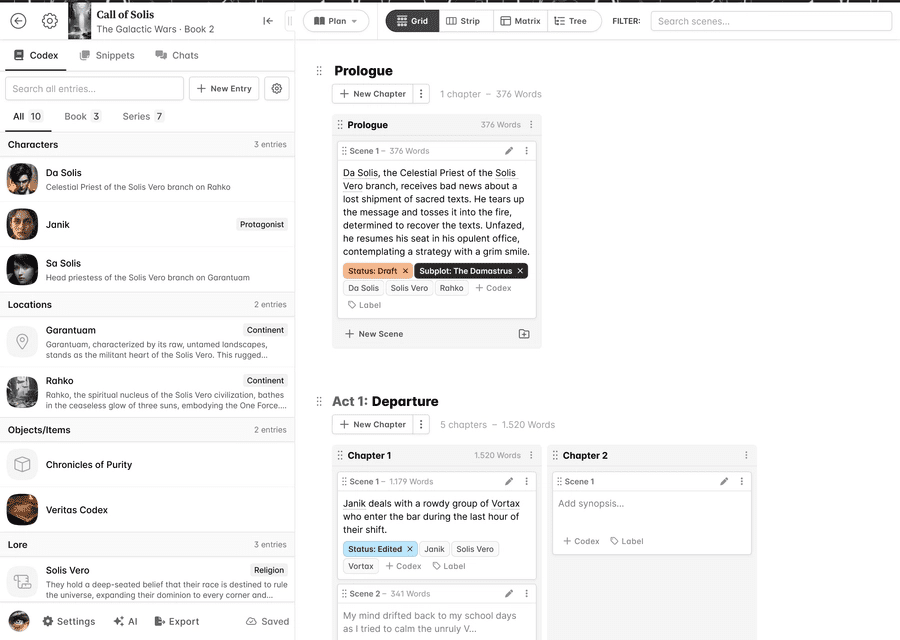

- Для гибкого управления предусмотрены веб-интерфейс и интерфейс командной строки.

- Поддержка многоязычного поиска для пользователей со всего мира.

Использование помощи

Процесс установки

Для работы Local Deep Research требуется установка среды Python и сопутствующих зависимостей. Ниже приведены подробные шаги по установке:

- склад клонов

Выполните следующую команду в терминале, чтобы клонировать проект локально:git clone https://github.com/LearningCircuit/local-deep-research.git cd local-deep-research

- Установка зависимостей

Используйте средства управления пакетами Python для установки необходимых библиотек:pip install -e .Если вам нужны функции автоматизации браузера, установите Playwright:

playwright install - Установка местных моделей (Оллама)

Local Deep Research поддерживает принятие Оллама Запустите локальную большую языковую модель. Посетите сайт https://ollama.ai, чтобы загрузить и установить Ollama, а затем запустить рекомендательную модель:ollama pull gemma3:12bУбедитесь, что служба Ollama запущена в фоновом режиме.

- Настройка SearXNG (необязательно)

Для достижения наилучших результатов поиска рекомендуется самостоятельно размещать поисковую службу SearXNG. Выполните следующую команду, чтобы запустить SearXNG:docker pull searxng/searxng docker run -d -p 8080:8080 --name searxng searxng/searxngВ корневом каталоге проекта

.envфайл для настройки адреса SearXNG:SEARXNG_INSTANCE=http://localhost:8080 SEARXNG_DELAY=2.0 - стартовый набор

- веб-интерфейс: Выполните следующую команду, чтобы запустить веб-версию, посетите сайт http://127.0.0.1:5000:

ldr-web - интерфейс командной строки: Выполните следующую команду, чтобы запустить версию командной строки:

ldr

- веб-интерфейс: Выполните следующую команду, чтобы запустить веб-версию, посетите сайт http://127.0.0.1:5000:

Работа основных функций

1. Создание краткого резюме

Функция Quick Summary предназначена для пользователей, которым нужен быстрый ответ. Откройте веб-интерфейс и введите исследовательский вопрос, например "Последние достижения в области термоядерной энергетики". Нажмите на кнопку "Quick Summary", и инструмент в течение нескольких секунд выдаст краткий ответ с ключевой информацией и источниками. Если вы используете командную строку, запустите ее:

from local_deep_research import quick_summary

results = quick_summary(query="核聚变能源的最新进展", search_tool="auto", iterations=1, questions_per_iteration=2, max_results=30)

print(results["summary"])

Результаты будут выведены в виде текста с кратким резюме и ссылками.

2. создание подробных отчетов

Функция подробного отчета подходит для пользователей, которым нужен всесторонний анализ. После ввода вопроса в веб-интерфейсе выберите опцию "Сгенерировать отчет". Инструмент выполняет несколько раундов поиска и анализа и генерирует отчет в формате Markdown с оглавлением, главами и ссылками. Время создания отчета зависит от сложности проблемы и количества раундов поиска (по умолчанию 2). Пример работы с командной строкой:

from local_deep_research import generate_report

report = generate_report(query="核聚变能源的最新进展", search_tool="auto", iterations=2)

print(report)

Сгенерированный отчет сохраняется локально, обычно в корневом каталоге проекта по пути examples Папка.

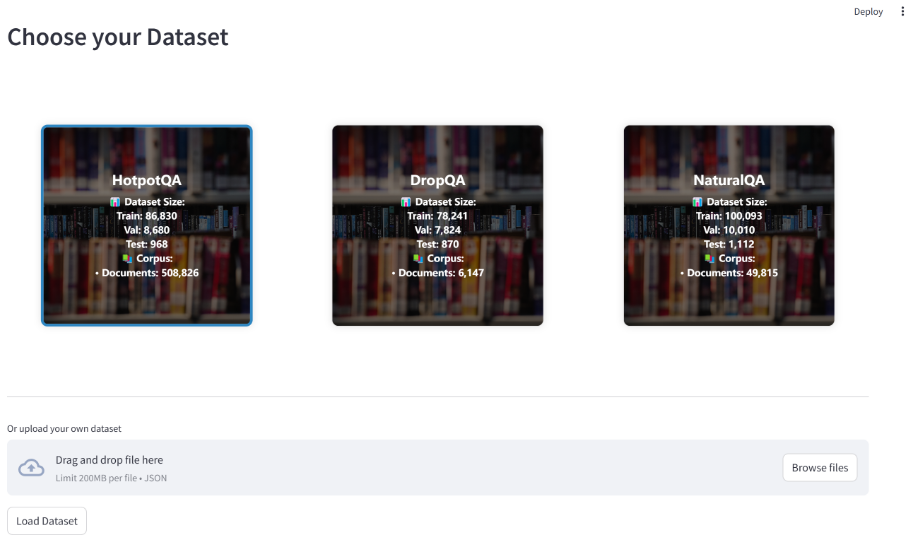

3. локальный поиск документов

Пользователи могут загружать частные документы (например, PDF, TXT) в указанную папку для анализа с помощью функции Retrieval Augmented Generation (RAG). Настройте путь к документу:

DOC_PATH=/path/to/your/documents

Выберите "Локальные документы" в качестве источника отчета в веб-интерфейсе, и инструмент сгенерирует отчет, объединяющий локальные документы и веб-поиск. Работа в командной строке:

results = quick_summary(query="分析我的文档中的AI趋势", report_source="local")

4. Многоязычный поиск

Инструмент поддерживает мультиязычный поиск вопросов на неанглийском языке. Введите в веб-интерфейс вопрос на китайском или другом языке, и инструмент автоматически адаптирует поисковый инструмент, чтобы вернуть соответствующие результаты. Например, если вы введете "последние достижения в области квантовых вычислений", инструмент будет искать как в китайских, так и в английских источниках.

Параметры конфигурации

Пользователи могут изменять config.py возможно .env Файл настраивает параметры:

search_tool: Выберите инструмент поиска (по умолчанию)auto).iterations: Установите количество раундов исследования (по умолчанию 2).max_results: Максимальное количество результатов за один раунд поиска (по умолчанию 50).max_filtered_results: Количество отфильтрованных результатов (по умолчанию 5).

предостережение

- Обеспечьте стабильное интернет-соединение для поиска внешних ресурсов.

- Производительность локальной модели зависит от аппаратного обеспечения, поэтому рекомендуется использовать GPU-ускорение.

- Регулярно обновляйте Ollama и код проекта, добавляя новейшие функции.

сценарий применения

- научные исследования

Студенты и исследователи могут использовать Local Deep Research для быстрого сбора информации из научных статей и веб-страниц и создания цитируемых отчетов. Например, при исследовании темы "Прорывы в квантовых вычислениях" инструмент извлекает последние статьи из arXiv и PubMed и генерирует структурированный отчет. - Исследование технологий

Любители технологий могут изучить новые технологические тенденции, такие как "Блокчейн в цепочке поставок". Инструмент сочетает в себе локальную документацию и поиск в Интернете, обеспечивая всесторонний анализ. - Управление персональными знаниями

Пользователи могут загружать личные заметки или документы, чтобы организовать свою базу знаний с помощью внешней информации. Например, личный доклад на тему "Прогнозы развития ИИ на 2025 год".

QA

- Требует ли локальное исследование глубины сети?

Локальная модель работает без подключения к Интернету, но функции поиска (например, Wikipedia, arXiv) требуют подключения к Интернету. Пользователи могут выбрать использование только локальных документов. - Какие большие языковые модели поддерживаются?

По умолчанию поддерживаются модели, размещенные в Ollama, такие какgemma3:12b. Пользователи могут получить доступ к этой информации черезconfig.pyНастройте другие модели, такие как vLLM или LMStudio. - Как можно повысить качество отчетности?

Увеличить количество раундов поиска (iterations) и количество результатов (max_results), или использовать более мощную модель. Четкое описание проблемы также поможет повысить точность. - Поддерживаются ли системы Windows?

Да, проект предоставляет программу установки Windows в один клик для упрощения процесса настройки. Посетите репозиторий GitHub для загрузки.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...