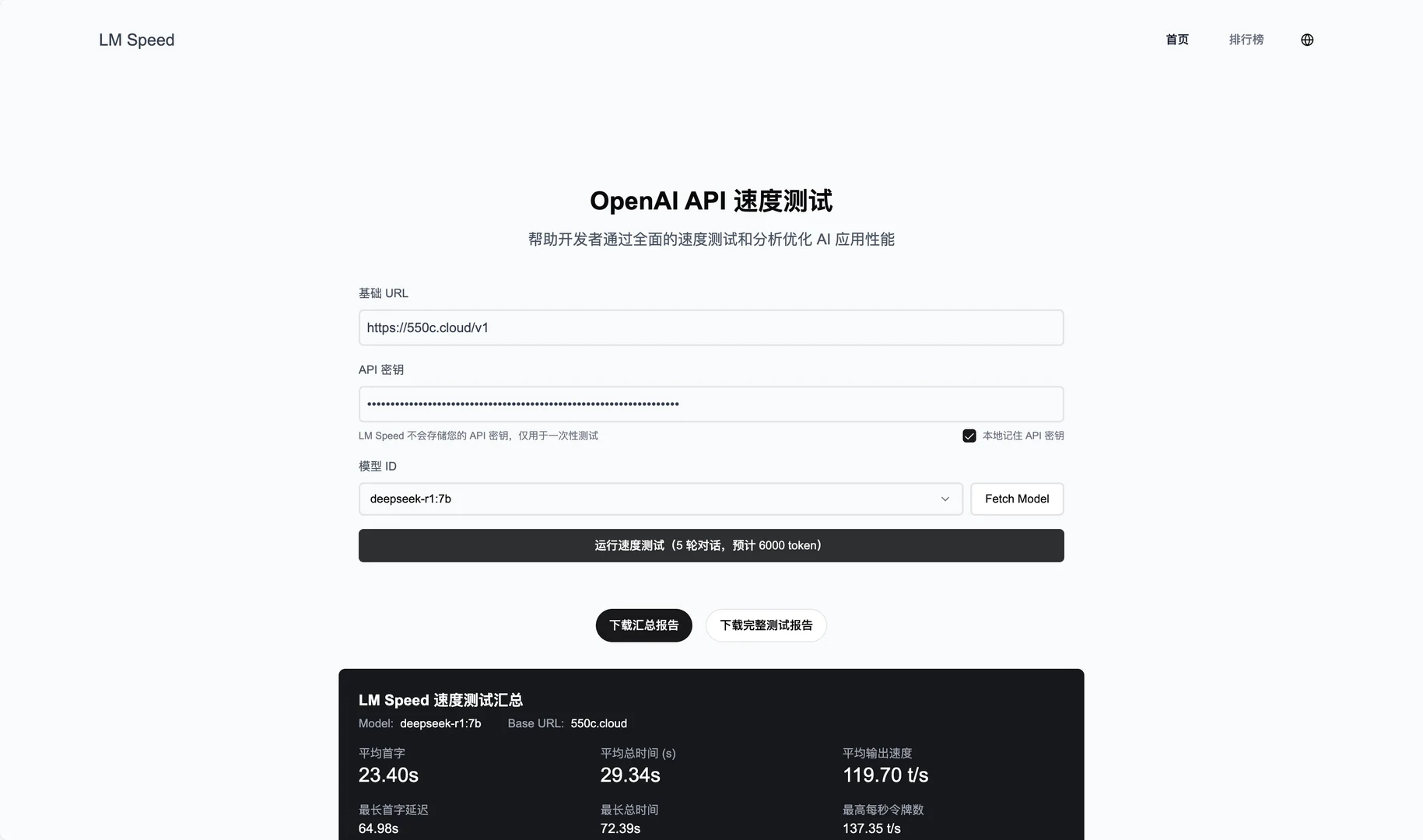

LM Speed: быстрое тестирование производительности API большой модели

Общее введение

LM Speed - это инструмент, созданный специально для разработчиков ИИ и доступный в виде онлайн-сервиса на сайте lmspeed.net. Его основная функция - тестирование и анализ производительности API языковых моделей, что помогает пользователям быстро выявлять узкие места в скорости и оптимизировать стратегии вызова. Инструмент поддерживает множество интерфейсов, включая OpenAI API, и обеспечивает мониторинг данных в реальном времени и подробные отчеты о производительности. Независимо от того, являетесь ли вы индивидуальным разработчиком или командой, LM Speed позволяет легко сравнивать производительность различных моделей и производителей с помощью интуитивно понятных графиков данных и автоматизированных тестов.

Список функций

- Мониторинг производительности в реальном времени: отображение многомерных данных, таких как обработка в секунду жетон номер (TPoS).

- Комплексная оценка производительности: измерьте основные показатели, такие как задержка первого маркера, время отклика и другие.

- Визуализация данных: создавайте насыщенные графики для визуализации тенденций производительности.

- Автоматизированные стресс-тесты: пять последовательных раундов тестирования для обеспечения надежности данных.

- Формирование отчетов одним щелчком мыши: автоматическое создание профессиональных отчетов о тестировании, поддержка экспорта и обмена.

- Быстрый тест на параметры URL: запуск теста непосредственно по ссылке без ручного ввода.

- Сохранение исторических данных: запись результатов испытаний и поддержка анализа тенденций.

Использование помощи

Использование онлайн-сервисов

- Доступ к веб-сайту

Откройте браузер и перейдите на сайт https://lmspeed.net. - Входные параметры испытаний

Заполните форму страницы следующей информацией:baseUrl: адрес службы API, например.https://api.deepseek.com/v1.apiKey: Ваш ключ API.modelId: идентификатор тестируемой модели, например.free:QwQ-32B.

- стартовый тест

Нажмите кнопку "Начать тест", и система автоматически проведет пять раундов стресс-тестов. Во время тестирования вы увидите обновления данных в режиме реального времени, включая TPoS и время отклика. - Посмотреть результаты

После завершения тестирования на странице отображаются подробные графики и показатели, такие как задержка первого токена и средняя производительность. Вы можете нажать кнопку "Создать отчет", чтобы загрузить PDF-файл или поделиться им со своей командой. - Быстрый тест параметров URL

Если вы не хотите вводить его вручную, вы можете запустить тест прямо по ссылке. Пример:

https://lmspeed.net/?baseUrl=https://api.suanli.cn/v1&apiKey=sk-你的密钥&modelId=free:QwQ-32B

После открытия ссылки тест начнется автоматически. Примечание: В целях безопасности не рекомендуется передавать ключ API непосредственно в URL.

Процесс установки локального развертывания

- Подготовка среды

Убедитесь, что на вашем компьютере установлены Git, Node.js (рекомендуется версия 16 или выше), Docker и Docker Compose; если нет, сначала загрузите и установите их. - склад клонов

Откройте терминал и введите следующую команду, чтобы загрузить код:

git clone https://github.com/nexmoe/lm-speed.git

cd lm-speed

- Развертывание Docker

- создать

docker-compose.ymlскопируйте официально предоставленный код:version: '3.8' services: app: image: nexmoe/lmspeed:latest ports: - "8650:3000" environment: - DATABASE_URL=postgresql://postgres:postgres@db:5432/nexmoe - NODE_ENV=production depends_on: - db restart: always db: image: postgres:16 restart: always environment: POSTGRES_USER: postgres POSTGRES_PASSWORD: postgres POSTGRES_DB: nexmoe volumes: - postgres_data:/var/lib/postgresql/data volumes: postgres_data: - Запускается в терминале:

docker-compose up -d - После успешного развертывания получите доступ к

http://localhost:8650Услуги по просмотру.

- Ручное развертывание

- Установите зависимость:

npm install - Копирование и настройка переменных окружения:

cp .env.example .envкомпилятор

.envзаполните адрес базы данных и конфигурацию API. - Начните обслуживание:

npm run dev - интервью

http://localhost:3000.

Функциональное управление

- мониторинг в реальном времени

При тестировании в режиме онлайн на странице динамически отображаются изменения TPoS и времени отклика. Вы можете навести курсор мыши на графики, чтобы увидеть точные значения. - автоматизированное тестирование

После нажатия кнопки "Начать тест" система автоматически проведет пять раундов тестирования. Результаты каждого раунда записываются, и в конце генерируются среднее значение и диапазон колебаний, которые помогут вам оценить стабильность API. - Экспорт отчетов

По завершении тестирования нажмите "Экспорт отчета" и выберите формат PDF. Отчет содержит тестовую среду, показатели производительности и графики и подходит для совместного использования или архивирования. - Анализ исторических данных

Онлайн-сервис ведет учет результатов ваших тестов. После входа в систему перейдите на страницу "История", чтобы просмотреть результаты предыдущих тестов и динамику показателей.

предостережение

- Убедитесь, что ключ API действителен, иначе тест будет провален.

- При локальном развертывании убедитесь, что брандмауэр имеет открытые порты (по умолчанию 3000 или 8650).

- Если график загружается медленно, возможно, возникли проблемы с сетью, и мы рекомендуем обновить страницу и повторить попытку.

С помощью этих шагов вы можете протестировать работу API языкового моделирования онлайн или локально с помощью LM Speed. Операция проста, результаты наглядны и очень полезны.

сценарий применения

- Разработчики выбирают API-сервисы

Тестирование разработчиков с помощью LM Speed DeepSeek и API, таких как Silicon Flow, чтобы выбрать поставщика, наиболее подходящего для проекта. - Вызов модели оптимизации команды

Команды, работающие с искусственным интеллектом, используют его для мониторинга производительности API при высокой нагрузке, корректируя стратегии вызовов для повышения эффективности приложений. - Исследователи анализируют колебания производительности

- Для написания научного отчета исследователи изучили изменения в работе модели в различных условиях с помощью пяти раундов тестирования и исторических данных.

QA

- Какие API поддерживает LM Speed?

В основном он поддерживает API в формате OpenAI, такие как DeepSeek, Suanli и так далее. Если API совместим с OpenAI SDK, его можно тестировать. - Что делать с нестабильными результатами тестов?

Убедитесь в стабильности сетевого соединения или увеличьте количество тестовых раундов (код может быть изменен для локального развертывания). Сильные колебания результатов могут быть связаны с проблемой поставщика API. - Нужно ли мне платить?

Онлайн-сервисы в настоящее время бесплатны, но их функциональность может быть ограничена. Локальное развертывание полностью бесплатно, а код является открытым.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...