LLM API Engine: быстрая генерация и развертывание API с помощью естественного языка

Общее введение

LLM API Engine - это проект с открытым исходным кодом, призванный помочь разработчикам быстро создавать и внедрять API на базе искусственного интеллекта. Проект использует Large Language Model (LLM) и технологии интеллектуального веб-ползания, чтобы позволить пользователям создавать пользовательские API с помощью описаний на естественном языке. Основные возможности включают автоматическое создание структуры данных, обновление данных в реальном времени, вывод структурированных данных и гибкие варианты развертывания. LLM API Engine имеет модульную архитектуру, которая поддерживает развертывание конечных точек API на различных платформах, таких как Cloudflare Workers, Vercel Edge Functions и AWS Lambda.

Список функций

- Преобразование текста в API: Генерируйте API с простыми описаниями на естественном языке.

- Автоматическое создание структур данных: Автоматическая генерация структур данных с использованием технологии OpenAI.

- Интеллектуальный просмотр веб-страниц: Поиск данных на веб-страницах с помощью технологии Firecrawl.

- Обновление данных в режиме реального времени: Поддержка ползания по таймеру и обновления данных в реальном времени.

- Мгновенное развертывание API: Быстрое развертывание конечных точек API.

- Вывод структурированных данных: Проверяет выходные данные по схеме JSON.

- Архитектура кэширования и хранения данных: Используйте Redis для кэширования и хранения данных.

Использование помощи

Процесс установки

- склад клонов::

git clone https://github.com/developersdigest/llm-api-engine.git

cd llm-api-engine

- Установка зависимостей::

npm install

- Создание файла переменной среды: Создать в корневом каталоге проекта

.envи добавьте следующие переменные:

OPENAI_API_KEY=your_openai_key

FIRECRAWL_API_KEY=your_firecrawl_key

UPSTASH_REDIS_REST_URL=your_redis_url

UPSTASH_REDIS_REST_TOKEN=your_redis_token

NEXT_PUBLIC_API_ROUTE=http://localhost:3000

- Запуск сервера разработки::

npm run dev

Откройте браузер, чтобы получить доступ кhttp://localhost:3000Посмотреть приложение.

Функции Поток операций

- Создание конечных точек API::

- Зайдите на главную страницу приложения и нажмите кнопку "Создать новый API".

- Введите название и описание API, а также выберите тип источника данных (например, веб-ползание).

- Используйте естественный язык для описания требуемых структур данных и правил сбора информации.

- Нажмите кнопку "Generate API", и система автоматически сгенерирует конечные точки API и структуры данных.

- Настройка и управление API::

- Просмотрите список созданных API на экране API Management.

- Щелкните на API, чтобы перейти на страницу с подробной информацией, где можно редактировать конфигурацию API, просматривать журналы и тестировать конечные точки API.

- Настраивается с помощью Redis Storage API, с поддержкой изменений и обновлений в любое время.

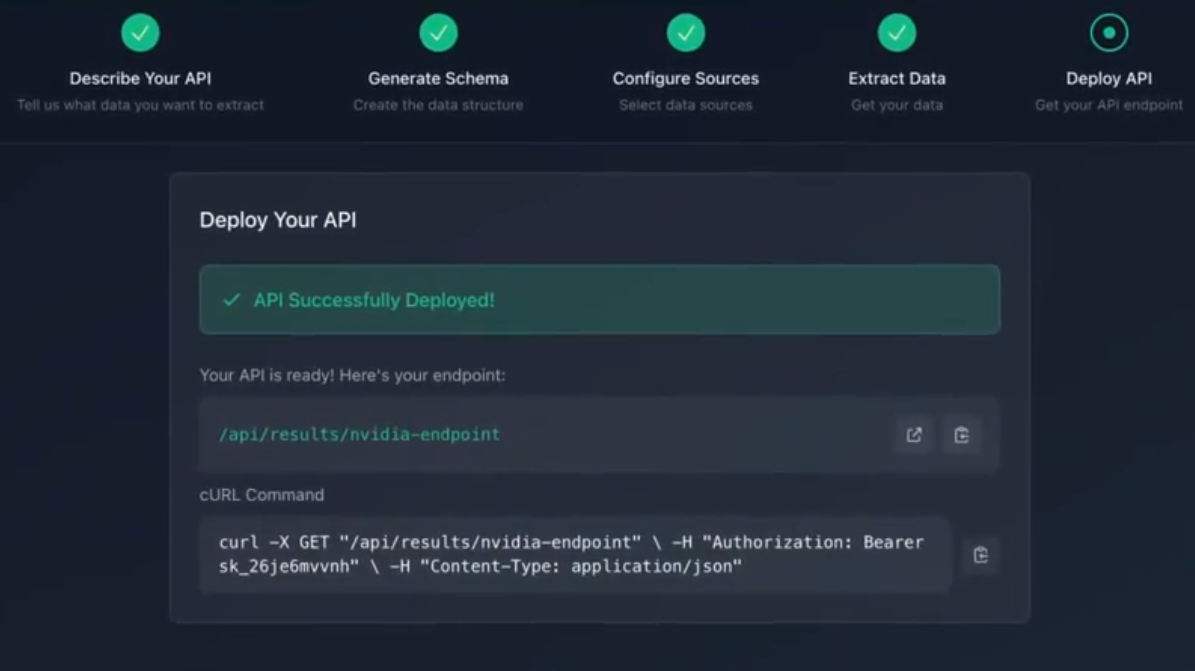

- Развертывание конечных точек API::

- Выберите платформу развертывания (например, Vercel, AWS Lambda и т. д.).

- Настройте параметры развертывания в соответствии с требованиями платформы и нажмите кнопку "Развернуть".

- После завершения развертывания вы можете просмотреть URL и статус конечных точек API на экране "Управление API".

- Использование конечных точек API::

- Вызывайте конечные точки API в своем приложении для получения структурированных данных.

- Поддерживает доступ к конечным точкам API с помощью HTTP-запросов, возвращающих данные в формате JSON.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...