llama.cpp: эффективный инструмент для вывода, поддерживает множество аппаратных средств, легко реализует вывод LLM

Общее введение

llama.cpp - это библиотека, реализованная на чистом языке C/C++ и предназначенная для упрощения процесса вывода для больших языковых моделей (LLM). Она поддерживает широкий спектр аппаратных платформ, включая Apple Silicon, NVIDIA GPU и AMD GPU, и предоставляет несколько вариантов квантования для увеличения скорости вычислений и уменьшения использования памяти. Целью проекта является достижение высокопроизводительного вывода LLM с минимальными настройками как для локальных, так и для облачных сред.

Список функций

- Поддержка различных аппаратных платформ, включая Apple Silicon, GPU NVIDIA и AMD GPU.

- Обеспечивает возможность квантования от 1,5 до 8 бит целых чисел

- Поддерживает множество моделей LLM, таких как LLaMA, Mistral, Falcon и др.

- Предоставьте интерфейс REST API для легкой интеграции

- Поддержка смешанных рассуждений на основе CPU+GPU

- Обеспечьте привязку к нескольким языкам программирования, таким как Python, Go, Node.js и др.

- Обеспечение поддержки различных инструментов и инфраструктуры, таких как инструменты преобразования моделей, балансировщики нагрузки и т. д.

Использование помощи

Процесс установки

- Хранилище клонирования:

git clone https://github.com/ggerganov/llama.cpp.git

cd llama.cpp

- Скомпилируйте проект:

make

Руководство по использованию

преобразование модели

llama.cpp предоставляет множество инструментов для преобразования и квантования моделей для эффективной работы на различном оборудовании. Например, модель Hugging Face можно преобразовать в формат GGML с помощью следующей команды:

python3 convert_hf_to_gguf.py --model <model_name>

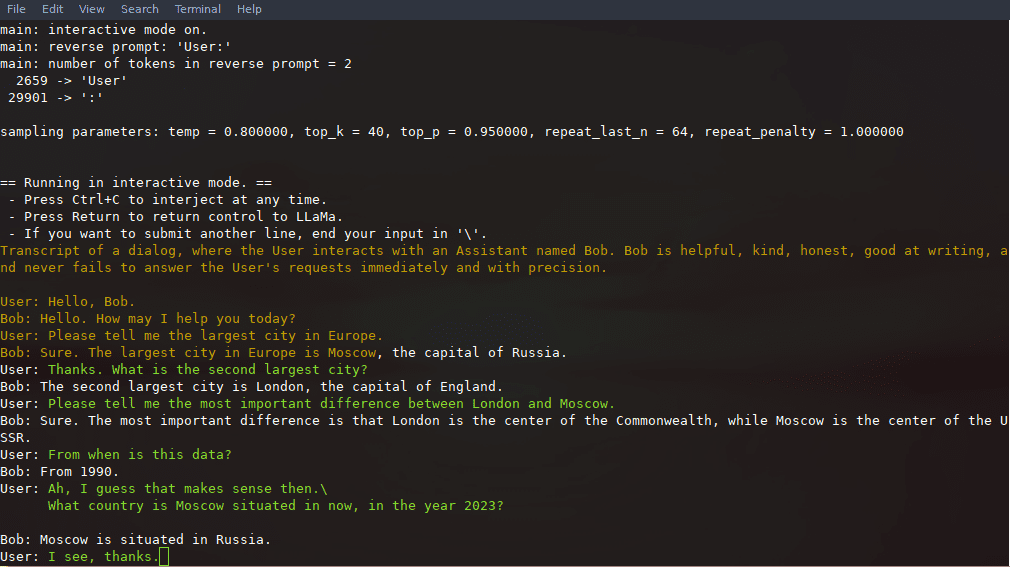

Пример рассуждений

После компиляции вы можете использовать следующие команды для выводов:

./llama-cli -m models/llama-13b-v2/ggml-model-q4_0.gguf -p "你好,世界!"

Использование REST API

llama.cpp также предоставляет совместимый с OpenAI API HTTP-сервер, который можно использовать для локальных сервисов вывода моделей. Запустите сервер:

./llama-server -m models/llama-13b-v2/ggml-model-q4_0.gguf --port 8080

Доступ к базовому веб-интерфейсу можно получить через браузер или с помощью API для запросов выводов:

curl -X POST http://localhost:8080/v1/chat -d '{"prompt": "你好,世界!"}'

Подробный порядок работы функций

- Загрузка модели: Сначала необходимо загрузить файл модели и поместить его в указанную директорию, а затем загрузить модель с помощью инструмента командной строки.

- Конфигурация рассуждений: Соответствующие параметры для вывода, такие как длина контекста, размер партии и т.д., могут быть установлены через конфигурационные файлы или параметры командной строки.

- Интеграция API: Через интерфейс REST API llama.cpp может быть интегрирован в существующие приложения для создания автоматизированных сервисов рассуждений.

- оптимизация производительности: Использование возможностей квантования и аппаратного ускорения позволяет значительно повысить скорость и эффективность вычислений.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...