LLaMA Factory: эффективная тонкая настройка более сотни макромоделей с открытым исходным кодом, легкая настройка моделей

Общее введение

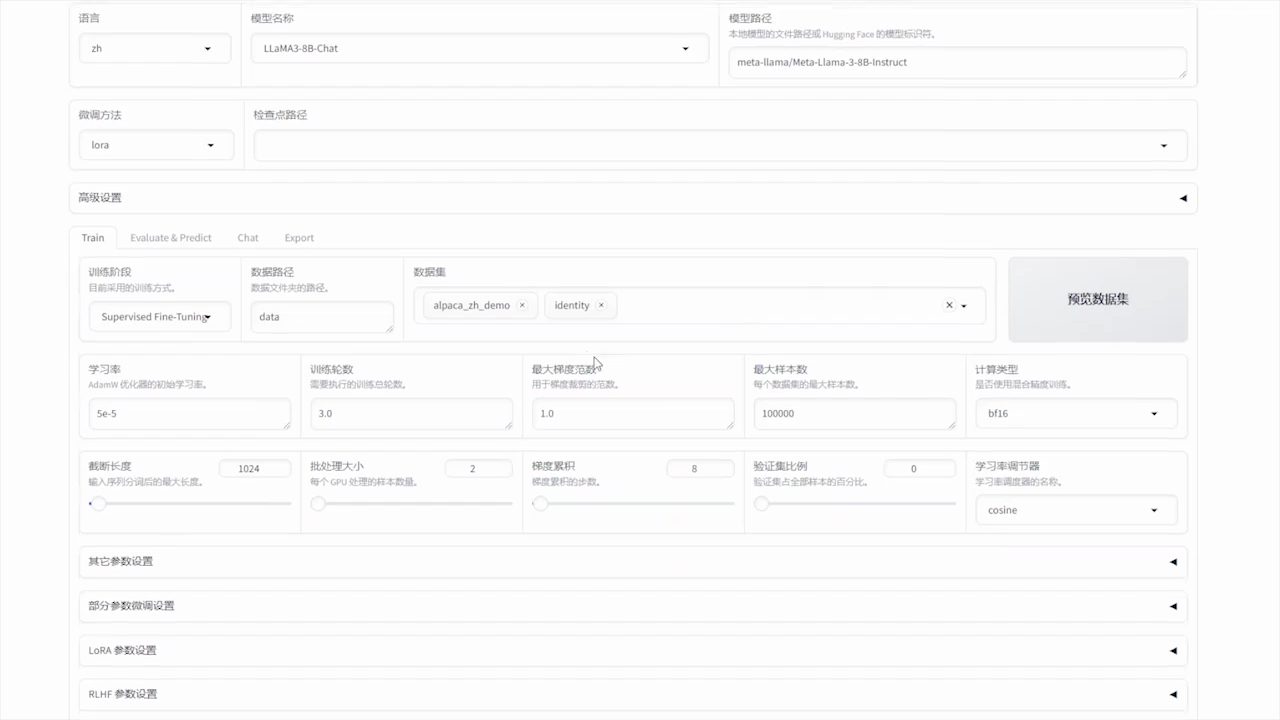

LLaMA-Factory - это унифицированный и эффективный фреймворк для тонкой настройки, который поддерживает гибкую настройку и эффективное обучение более 100 больших языковых моделей (LLM). Встроенный веб-интерфейс LLaMA Board позволяет пользователям настраивать модели без написания кода. В фреймворк интегрированы различные передовые методы обучения и практические советы, позволяющие значительно повысить скорость обучения и эффективность использования памяти GPU.

Список функций

- Поддержка нескольких моделей: Поддержка LLaMA, LLaVA, Mistral, Qwen и других многоязычных моделей.

- Несколько методов обучения: Включает обрезку по всему объему, обрезку по заморозке, LoRA, QLoRA и т.д.

- эффективный алгоритм: Интеграция GaLore, BAdam, Adam-mini, DoRA и других передовых алгоритмов.

- практический навык: Поддержка FlashAttention-2, Unsloth, Liger Kernel и др.

- Экспериментальный мониторинг: Предоставляет инструменты мониторинга, такие как LlamaBoard, TensorBoard, Wandb, MLflow и другие.

- быстрый вывод: Предоставляет OpenAI-подобные API, Gradio UI и CLI-интерфейсы.

- Поддержка наборов данных: Поддержка загрузки предварительно обученных моделей и наборов данных с HuggingFace, ModelScope и других платформ.

Использование помощи

Процесс установки

- Клонируйте код проекта:

git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git

cd LLaMA-Factory

- Установите зависимость:

pip install -e ".[torch,metrics]"

Дополнительные зависимости включают: torch, torch-npu, metrics, deepspeed, liger-kernel, bitsandbytes и другие.

Подготовка данных

пожалуйста, обратитесь к data/README.md Узнайте больше о формате файлов наборов данных. Вы можете использовать наборы данных на узле HuggingFace / ModelScope / Modelers или загрузить наборы данных на локальный диск.

Быстрый старт

Используйте следующие команды, чтобы запустить LoRA для точной настройки, рассуждений и объединения моделей Llama3-8B-Instruct:

llamafactory-cli train examples/train_lora/llama3_lora_sft.yaml

llamafactory-cli chat examples/inference/llama3_lora_sft.yaml

llamafactory-cli export examples/merge_lora/llama3_lora_sft.yaml

Более подробную информацию об использовании см. examples/README.md.

Использование графического интерфейса платы LLaMA

Тонкая настройка осуществляется через графический интерфейс LLaMA Board, предоставляемый Gradio:

llamafactory-cli webui

Развертывание Docker

Для пользователей CUDA:

cd docker/docker-cuda/

docker compose up -d

docker compose exec llamafactory bash

Для пользователей Ascend NPU:

cd docker/docker-npu/

docker compose up -d

docker compose exec llamafactory bash

Для пользователей AMD ROCm:

cd docker/docker-rocm/

docker compose up -d

docker compose exec llamafactory bash

Развертывание API

Используйте API в стиле OpenAI и vLLM Рассуждения:

API_PORT=8000 llamafactory-cli api examples/inference/llama3_vllm.yaml

Посетите эту страницу, чтобы ознакомиться с документацией по API.

Скачать модели и наборы данных

Если у вас возникли проблемы с загрузкой моделей и наборов данных из Hugging Face, вы можете использовать ModelScope:

export USE_MODELSCOPE_HUB=1

Обучите модель, указав идентификатор модели в ModelScope Hub, например. LLM-Research/Meta-Llama-3-8B-Instruct.

Запись результатов экспериментов с W&B

Чтобы использовать Вес & Biases записывает результаты своих экспериментов с помощью следующих параметров в yaml-файле:

wandb:

project: "your_project_name"

entity: "your_entity_name"

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...