LiveTalking: интерактивная цифровая система "живой человек" с открытым исходным кодом для синхронного аудио- и видеодиалога в реальном времени

Общее введение

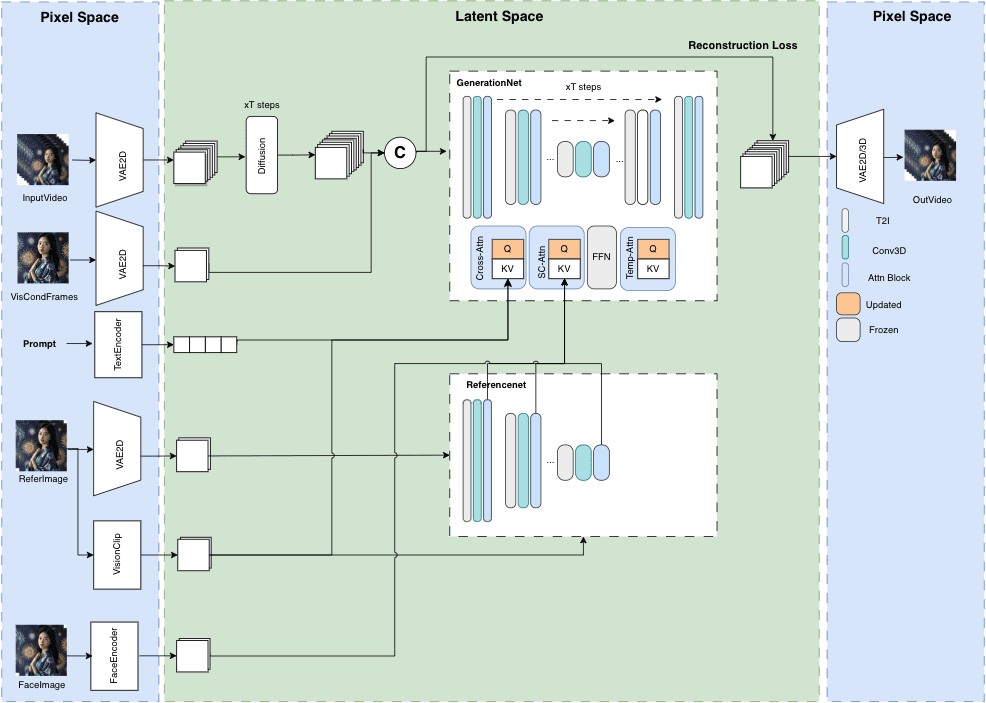

LiveTalking - это интерактивная система цифрового человека с открытым исходным кодом, предназначенная для создания высококачественного цифрового человека в реальном времени. Проект использует протокол Apache 2.0 с открытым исходным кодом и объединяет ряд передовых технологий, включая рендеринг ER-NeRF, обработку аудио- и видеопотоков в реальном времени, синхронизацию губ и так далее. Система поддерживает цифровой рендеринг и взаимодействие с человеком в реальном времени и может быть использована для прямых трансляций, онлайн-образования, обслуживания клиентов и многих других сценариев. Проект набрал более 4300 звезд и 600 веток на GitHub, что свидетельствует о сильном влиянии сообщества. LiveTalking уделяет особое внимание производительности в реальном времени и интерактивному опыту, и предоставляет пользователям полную систему развития цифрового человека, интегрируя технологию AIGC. Проект постоянно обновляется и поддерживается, а также сопровождается исчерпывающей документацией, что делает его идеальным выбором для создания приложений для цифровых людей.

Список функций

- Поддерживаются несколько цифровых моделей человека:ernerf, иmusetalk, иwav2lip, иСверхлегкий цифровой человек

- Обеспечьте одновременный аудио- и видеодиалог

- Поддержка клонирования звуков

- Люди, выступающие за цифровые технологии, говорят и их перебивают

- Поддержка сращивания видео по всему телу

- Поддержка RTMP и WebRTC push-потоков

- Поддержка планирования видео: воспроизводите пользовательские видео, когда не разговариваете

- Поддержка множественного параллелизма

Использование помощи

1.Процесс установки

- Экологические требования : Ubuntu 20.04, Python 3.10, Pytorch 1.12, CUDA 11.3

- Установка зависимостей ::

conda create -n nerfstream python=3.10

conda activate nerfstream

conda install pytorch==1.12.1 torchvision==0.13.1 cudatoolkit=11.3 -c pytorch

pip install -r requirements.txt

Если вы не будете тренироваться. ernerf модель, следующие библиотеки устанавливать не нужно:

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

pip install tensorflow-gpu==2.8.0

pip install --upgrade "protobuf<=3.20.1"

2. Быстрый старт

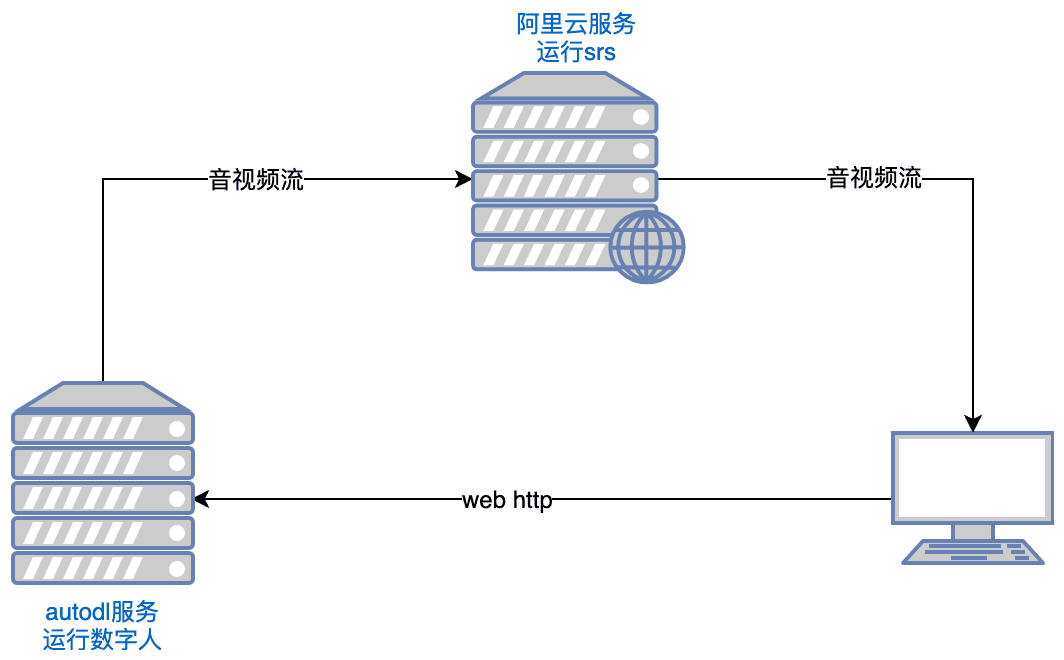

- Работающая система SRS ::

export CANDIDATE='<服务器外网ip>'

docker run --rm --env CANDIDATE=$CANDIDATE -p 1935:1935 -p 8080:8080 -p 1985:1985 -p 8000:8000/udp registry.cn-hangzhou.aliyuncs.com/ossrs/srs:5 objs/srs -c conf/rtc.conf

Замечания: Серверу необходимо открыть порты tcp:8000,8010,1985; udp:8000

- Запуск проекта Digital People ::

python app.py

Если вы не можете получить доступ к Huggingface, выполните его перед запуском:

export HF_ENDPOINT=https://hf-mirror.com

Открыть с помощью браузера http://serverip:8010/rtcpushapi.htmlЕсли вы введете какой-либо текст в текстовое поле, отправьте его, и цифровое лицо будет транслировать отрывок.

Дополнительные инструкции по применению

- Запуск Docker : Нет необходимости в предыдущей установке, просто запустите его:

docker run --gpus all -it --network=host --rm registry.cn-beijing.aliyuncs.com/codewithgpu2/lipku-metahuman-stream:vjo1Y6NJ3N

Код находится в /root/metahuman-streamпредыдущий git pull Извлеките последний код, затем выполните команду, как в шагах 2 и 3.

- Зеркальное отображение ::

- изображение автодла:самоучитель по автодлу

- Зеркала ucloud:Учебник по ucloud

- общие проблемы : Вы можете обратиться к этой статье для настройки среды Linux CUDA:справочная статья

3. Инструкции по конфигурированию

- Конфигурация системы

- Отредактируйте файл config.yaml, чтобы задать основные параметры

- Настройка камер и аудиоустройств

- Настройка параметров и путей модели ИИ

- Настройка параметров потоковой передачи в режиме реального времени

- Подготовка цифровой модели человека

- Поддержка импорта пользовательских 3D-моделей

- Можно использовать готовые примеры моделей

- Поддержка импорта моделей MetaHuman

Основные функции

- Синхронный аудио- и видеодиалог в реальном времени::

- Выберите модель дигитайзера: на странице конфигурации выберите соответствующую модель дигитайзера (например, ernerf, musetalk и т. д.).

- Выбор метода передачи аудио/видео: выберите подходящий метод передачи аудио/видео (например, WebRTC, RTMP и т. д.) в соответствии с требованиями.

- Начать диалог: запуск передачи аудио/видео для синхронного аудио/видео диалога в реальном времени.

- Переключение цифровой модели человека::

- Вход на страницу настроек: На странице Project Run нажмите кнопку Setup, чтобы перейти на страницу настроек.

- Выбрать новую модель: выберите новую модель Дигимона на странице настроек и сохраните настройки.

- Restart Project: перезапуск проекта для применения новой конфигурации модели.

- Настройка параметров аудио и видео::

- Вход на страницу настройки параметров: На странице выполнения проекта нажмите кнопку настройки параметров, чтобы перейти на страницу настройки параметров.

- Параметры настройки: Настройте параметры аудио и видео (например, разрешение, частоту кадров и т.д.) в соответствии с требованиями.

- Сохранить и применить: сохранение настроек и применение новой конфигурации параметров.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...