LHM: генерация 3D-моделей человека с учетом движения на основе одного изображения

Общее введение

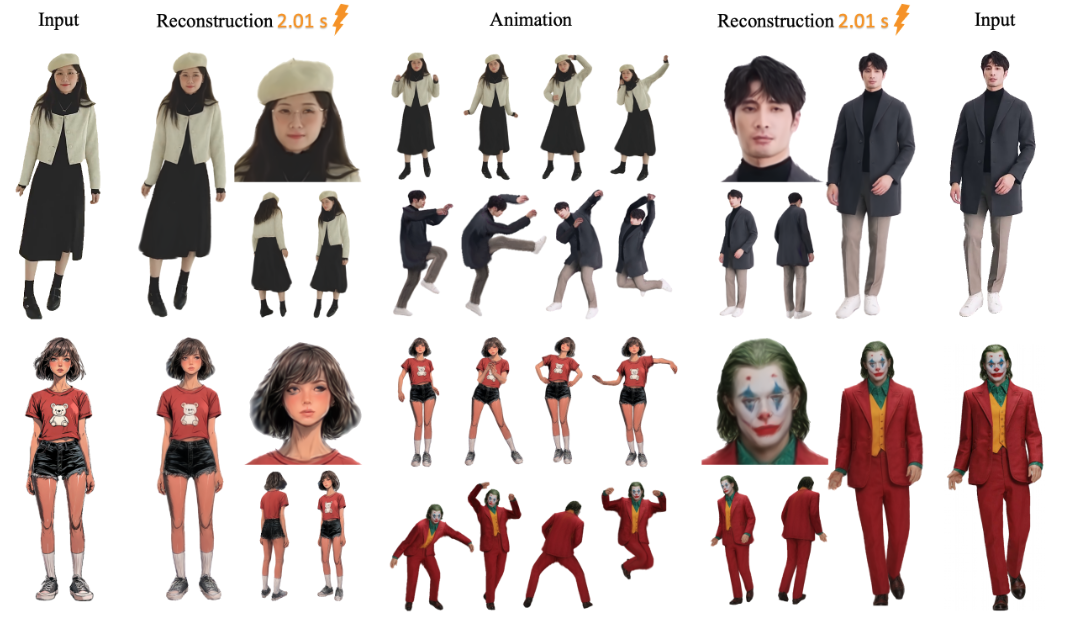

LHM (Large Animatable Human Reconstruction Model) - это проект с открытым исходным кодом, разработанный командой aigc3d, который позволяет быстро генерировать поддерживающие действия 3D-модели человека из одного изображения. Основной особенностью проекта является использование технологии искусственного интеллекта для превращения 2D-изображения в 3D-модель за считанные секунды, с поддержкой предварительного просмотра в реальном времени и корректировки позы. LHM использует технологию 3D Gaussian Splatting для представления человеческого тела, в сочетании с мультимодальной архитектурой трансформации, которая сохраняет текстуру одежды и геометрические детали. Проект, впервые выпущенный 13 марта 2025 года, предоставляет предварительно обученные модели и код, подходящий для исследований и разработки приложений, связанных с 3D-цифровыми людьми.

Список функций

- Создайте 3D-манекен из одного изображения за считанные секунды.

- Поддерживается рендеринг в реальном времени, и сгенерированную модель можно просматривать напрямую.

- Функция корректировки позы человеческого тела для создания динамического видео.

- Вывод файлов 3D-сетки (например, в формате OBJ) для последующего редактирования.

- В комплект входят предварительно обученные модели (например, LHM-0.5B и LHM-1B), которые не нужно обучать самостоятельно.

- Интегрированный интерфейс Gradio с поддержкой локальной визуализации.

- Предоставляет конвейер обработки видео, который может извлекать действия из видео для применения к моделям.

Использование помощи

Использование LHM делится на две части: установка и эксплуатация. Ниже приведены подробные шаги, которые помогут вам быстро приступить к работе.

Процесс установки

- Подготовка среды

Для системы требуется Python 3.10 и CUDA (поддерживается версия 11.8 или 12.1). Рекомендуется видеокарта NVIDIA, например A100 или 4090, с не менее чем 16 ГБ видеопамяти.- Проверьте версию Python:

python --version - Проверьте версию CUDA:

nvcc --version

- Проверьте версию Python:

- склад клонов

Введите следующую команду в терминале, чтобы загрузить код LHM:git clone https://github.com/aigc3d/LHM.git cd LHM

- Установка зависимостей

Запустите соответствующий скрипт в соответствии с версией CUDA:- CUDA 11.8:

sh ./install_cu118.sh - CUDA 12.1:

sh ./install_cu121.sh

Если сценарий не сработал, установите зависимости вручную:

pip install -r requirements.txt - CUDA 11.8:

- Скачать модели

Модель будет загружена автоматически. Если вы хотите загрузить ее вручную, воспользуйтесь следующей командой:- Модель LHM-0.5B:

wget https://virutalbuy-public.oss-cn-hangzhou.aliyuncs.com/share/aigc3d/data/for_lingteng/LHM/LHM-0.5B.tar tar -xvf LHM-0.5B.tar - Модель LHM-1B:

wget https://virutalbuy-public.oss-cn-hangzhou.aliyuncs.com/share/aigc3d/data/for_lingteng/LHM/LHM-1B.tar tar -xvf LHM-1B.tar

Скачайте его и распакуйте в корневой каталог проекта.

- Модель LHM-0.5B:

- Проверка установки

Выполните тестовые команды, чтобы убедиться, что с окружением все в порядке:python app.pyВ случае успеха будет запущен интерфейс Gradio.

рабочий процесс

Создание 3D-моделей

- Подготовьте фотографию

Подготовьте четкое изображение всего человеческого тела и сохраните его в локальной сети, например<path_to_image>/person.jpg. - Запуск сценариев вывода

Введите его в терминал:bash ./inference.sh ./configs/inference/human-lrm-1B.yaml LHM-1B <path_to_image>/ ./output/<path_to_image>это путь к вашему изображению../output/выходная папка, в которую сохраняются сгенерированные результаты.

- Посмотреть результаты

После создания<output>В папке будет находиться файл 3D-модели и видеоролик с рендерингом. Вы можете открыть файл сетки с помощью 3D-программ (например, Blender) или воспроизвести видео напрямую.

Добавить действие

- Подготовительная последовательность движений

Проект содержит примеры файлов действий, расположенных в папке<LHM根目录>/train_data/motion_video/mimo1/smplx_params. Вы также можете использовать собственный файл параметров SMPL-X. - Запуск сценариев действий

Введите следующую команду:bash ./inference.sh ./configs/inference/human-lrm-1B.yaml LHM-1B <path_to_image>/ <path_to_motion>/smplx_params<path_to_motion>путь к файлу действия.

- Предварительный просмотр видеоролика действия

В выходной папке создается экшн-видео, которое можно воспроизводить напрямую.

Использование интерфейса Gradio

- Интерфейс запуска

Запускается в терминале:python app.pyОткроется браузер

http://0.0.0.0:7860. - Загрузить фотографию

Загрузите фотографию своего тела в интерфейс и нажмите "Отправить". - Получение результатов

Через несколько секунд в интерфейсе появится отрендеренное изображение и видеоролик, который можно загрузить и просмотреть.

Экспорт 3D-сетки

- Запустите скрипт экспорта

Вход:bash ./inference_mesh.sh ./configs/inference/human-lrm-1B.yaml LHM-1B - Найдите файл.

В выходной папке будут файлы сетки в формате OBJ, которые можно редактировать в 3D-программах.

предостережение

- Изображения должны быть четкими, лучше использовать простые фоны.

- Эффект действия зависит от качества входного воздействия.

- Если у вас недостаточно видеопамяти, попробуйте модель LHM-0.5B.

сценарий применения

- разработка игр

Разработчики могут использовать LHM для быстрого создания 3D-моделей персонажей из фотографий, корректировки поз и импорта их в игровой движок, экономя время моделирования. - производство фильмов и телепередач

Команды кино и телевидения могут использовать LHM для создания цифровых моделей и видеороликов для использования в сценах со спецэффектами, что позволяет сократить расходы на ручное моделирование. - виртуальный ведущий (ТВ)

Хозяева могут загружать собственные фотографии для создания 3D-изображения, а затем добавлять действия для создания индивидуального виртуального образа. - Образовательные исследования

Исследователи смогли протестировать алгоритмы 3D-реконструкции с помощью LHM или продемонстрировать процесс преобразования изображений в модели в учебном классе.

QA

- Какие форматы изображений поддерживает LHM?

Поддерживаются такие распространенные форматы, как JPG, PNG, рекомендуется JPG, а размер файла не должен превышать 10 МБ. - Сколько времени требуется для создания модели?

Около 0,2 секунды на картах A100, 1-2 секунды на картах 4090, незначительно зависит от аппаратного обеспечения. - Могу ли я сам обучить модель?

Это возможно, но обучающие скрипты официально не предоставляются. Требуется подготовка набора данных и настройка кода, подходит для опытных пользователей. - Можно ли редактировать полученную 3D-модель?

Можно. После экспорта OBJ-файла отредактируйте геометрию и текстуры в Blender или Maya.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...