LatentSync: инструмент с открытым исходным кодом для создания видео с синхронизацией губ непосредственно из аудио.

Общее введение

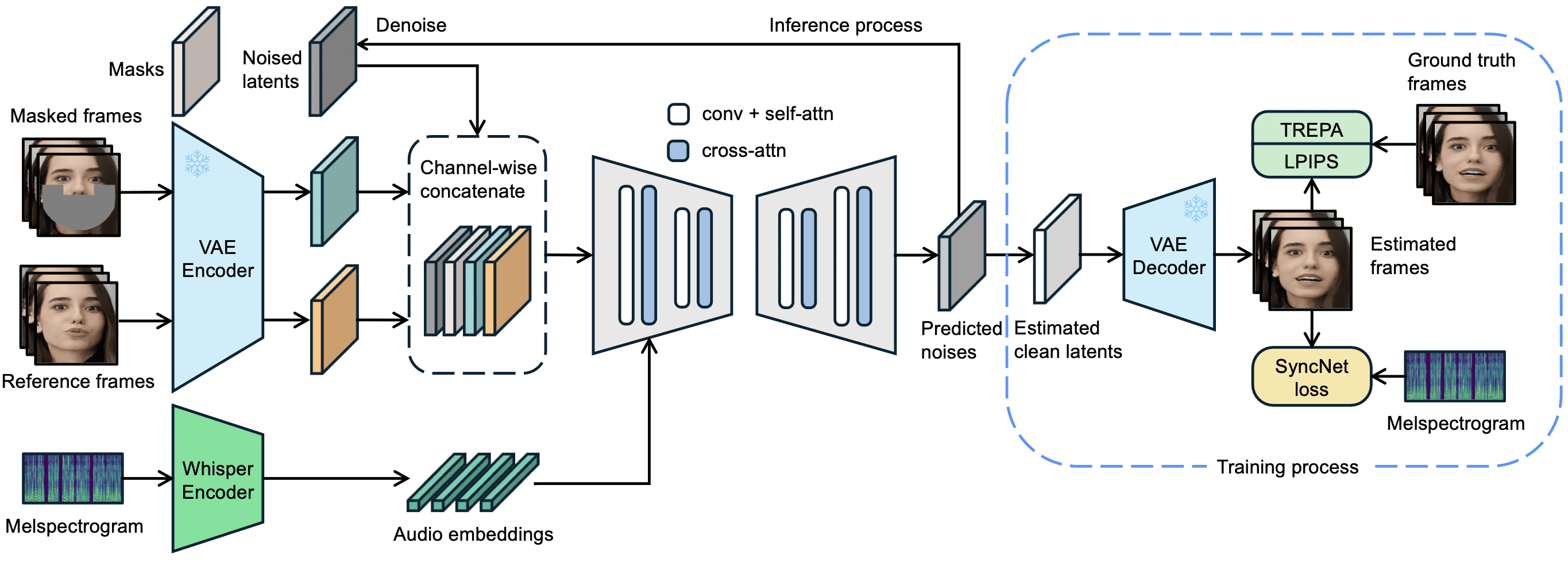

LatentSync - это инструмент с открытым исходным кодом, разработанный компанией ByteDance и размещенный на GitHub. Он управляет движениями губ персонажей в видео непосредственно через аудио, так что форма рта точно соответствует голосу. Проект основан на модели скрытой диффузии Stable Diffusion в сочетании с Шепот Звуковые признаки извлекаются для создания видеокадров по сети U-Net. В версии latentSync 1.5, выпущенной 14 марта 2025 года, оптимизирована временная согласованность, добавлена поддержка видео на китайском языке и снижено требование к памяти обучающего видео до 20 Гб. Пользователи могут запускать код вывода для создания синхронизированного по губам видео с разрешением 256x256, имея лишь видеокарту, поддерживающую 6,8 Гб видеопамяти. видео в разрешении 256x256. Инструмент полностью бесплатный, с кодом и предварительно обученными моделями, и подходит как для энтузиастов, так и для разработчиков.

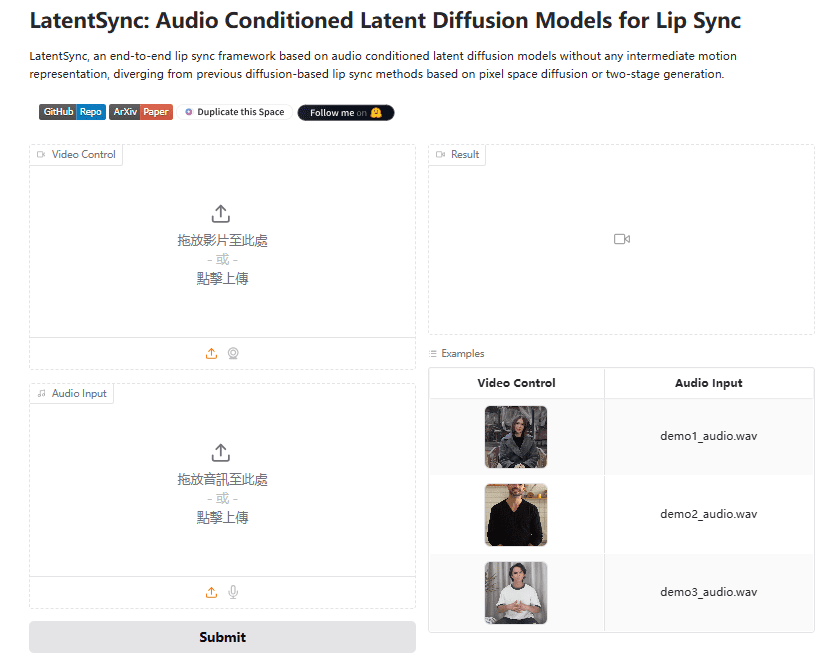

Опыт работы: https://huggingface.co/spaces/fffiloni/LatentSync

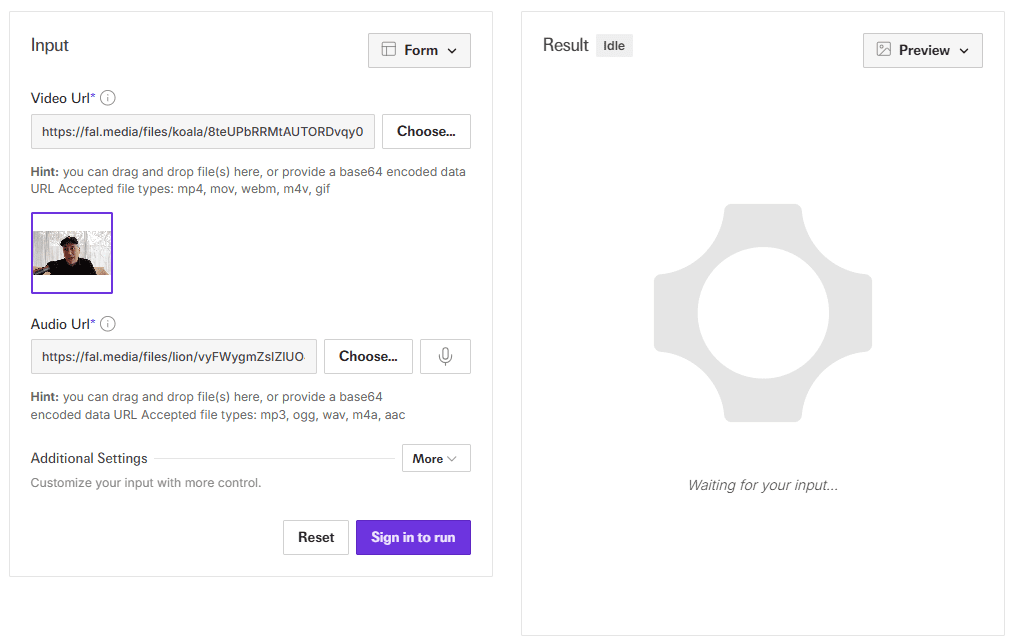

Демо-адрес API: https://fal.ai/models/fal-ai/latentsync

Список функций

- Аудиопривод Lip Sync: Ввод аудио и видео для автоматической генерации движений губ, соответствующих звуку.

- Сплошная генерация видео: Нет необходимости в промежуточном представлении, прямой вывод четкого синхронизированного по губам видео.

- Оптимизация согласованности во времени: Уменьшает скачки изображения благодаря технологии TREPA и временным слоям.

- Поддержка китайского видео: В версии 1.5 улучшена работа с китайским аудио и видео.

- Эффективная поддержка при обученииU-Net доступен в различных конфигурациях с объемом памяти до 20 ГБ.

- Конвейер обработки данных: Встроенные инструменты для очистки видеоданных и обеспечения качества генерации.

- параметризация: Поддержка настройки шагов вывода и шкалы наведения для оптимизации генерации.

Использование помощи

LatentSync - это локально запускаемый инструмент для пользователей с технической базой. Процесс установки, настройки и обучения подробно описан ниже.

Процесс установки

- Требования к аппаратному и программному обеспечению

- Требуется видеокарта NVIDIA с объемом видеопамяти не менее 6,8 ГБ (для выводов), для обучения рекомендуется 20 ГБ и более (например, RTX 3090).

- Поддерживает Linux или Windows (для Windows требуется ручная настройка сценария).

- Установите Python 3.10, Git и PyTorch с поддержкой CUDA.

- Код загрузки

Запускается в терминале:

git clone https://github.com/bytedance/LatentSync.git

cd LatentSync

- Установка зависимостей

Выполните следующую команду для установки необходимых библиотек:

pip install -r requirements.txt

Дополнительная установка ffmpeg для обработки аудио и видео:

sudo apt-get install ffmpeg # Linux

- Скачать модели

- через (щель) Обнимающееся лицо загрузка

latentsync_unet.ptответить пениемtiny.pt. - Поместите файл в

checkpoints/каталог со следующей структурой:checkpoints/ ├── latentsync_unet.pt ├── whisper/ │ └── tiny.pt - Если вы обучаете SyncNet, вам также необходимо загрузить

stable_syncnet.ptи другие вспомогательные модели.

- Среда верификации

Выполните команду тестирования:

python gradio_app.py --help

Если ошибок нет, среда создана успешно.

процесс вывода

LatentSync предлагает два метода вывода, оба требуют 6,8 ГБ видеопамяти.

Метод 1: Интерфейс Gradio

- Запустите приложение Gradio:

python gradio_app.py

- Откройте браузер и перейдите по предложенному локальному адресу.

- Загрузите видео- и аудиофайлы, нажмите кнопку Run и дождитесь появления результатов.

Метод 2: Командная строка

- Подготовьте входной файл:

- Видео (например.

input.mp4), должны содержать четкие лица. - Аудио (например.

audio.wav), рекомендуется 16000 Гц.

- Запустите сценарий рассуждений:

python -m scripts.inference

--unet_config_path "configs/unet/stage2_efficient.yaml"

--inference_ckpt_path "checkpoints/latentsync_unet.pt"

--inference_steps 25

--guidance_scale 2.0

--video_path "input.mp4"

--audio_path "audio.wav"

--video_out_path "output.mp4"

inference_steps: 20-50, чем выше значение, тем выше качество и ниже скорость.guidance_scale: 1,0-3,0, чем выше значение, тем точнее форма губ, возможны небольшие искажения.

- зонд

output.mp4Эффект синхронизации губ подтвержден.

Предварительная обработка входных данных

- Частоту кадров видео рекомендуется установить на 25 кадров в секунду:

ffmpeg -i input.mp4 -r 25 resized.mp4

- Частота дискретизации звука должна составлять 16000 Гц:

ffmpeg -i audio.mp3 -ar 16000 audio.wav

Поток обработки данных

Если модель необходимо обучить, то сначала нужно обработать данные:

- Запустите скрипт:

./data_processing_pipeline.sh

- модификации

input_dirдля вашего видеокаталога. - Процесс включает в себя:

- Удалите поврежденное видео.

- Настройте видео на 25 кадров в секунду, а звук - на 16000 Гц.

- Разделите сцену с помощью PySceneDetect.

- Разрежьте видео на отрезки по 5-10 секунд.

- Определите лица с помощью выравнивания и измените размер до 256x256.

- Фильтрует видео с оценкой синхронизации менее 3.

- Рассчитайте показатель hyperIQA и удалите видеоролики с рейтингом ниже 40.

- Обработанное видео сохраняется в

high_visual_quality/Каталог.

Обучение U-Net

- Подготовьте данные и все контрольные точки.

- Выберите профиль (например.

stage2_efficient.yaml). - Беговая тренировка:

./train_unet.sh

- Измените путь к данным и путь сохранения в файле конфигурации.

- Требования к графической памяти:

stage1.yaml: 23 ГБ.stage2.yaml: 30 ГБ.stage2_efficient.yaml: 20 ГБ для обычных видеокарт.

предостережение

- Пользователям Windows необходимо установить

.shПерейдите к запуску команды Python. - Если экран прыгает, увеличьте

inference_stepsили настроить частоту кадров видео. - Поддержка китайского аудио была оптимизирована в версии 1.5, чтобы обеспечить использование последних моделей.

Выполнив эти действия, пользователи смогут легко установить и использовать LatentSync для создания видео с синхронизацией губ или дальнейшего обучения модели.

сценарий применения

- пост-продакшн

Замените звук для существующих видео, чтобы создать новые губы, подходящие для дубляжа. - виртуальное изображение

Ввод звука для создания видеороликов с говорящими аватарами для живых или коротких видео. - производство игр

Добавьте динамические диалоговые анимации персонажам, чтобы улучшить игровой процесс. - многоязычие

Создание обучающих видеороликов со звуком на разных языках, адаптированных для пользователей из разных стран.

QA

- Поддерживает ли он генерацию в режиме реального времени?

Не поддерживается. Текущая версия требует полного аудио и видео и требует от нескольких секунд до нескольких минут для генерации. - Каков минимальный объем видеопамяти?

Для рассуждений требуется 6,8 ГБ, а для обучения рекомендуется 20 ГБ (после оптимизации в версии 1.5). - Можете ли вы справиться с аниме?

Можно. В качестве официальных примеров можно привести аниме-ролики, которые отлично работают. - Как улучшить поддержку китайского языка?

Используйте LatentSync версии 1.5, которая была оптимизирована для обработки китайского звука.

Установщик LatentSync одним щелчком мыши

Кварк: https://pan.quark.cn/s/c3b482dcca83

Автономный установщик для WIN/MAC

Кварк: https://pan.quark.cn/s/90d2784bc502

Baidu: https://pan.baidu.com/s/1HwN1k6v-975uLfI0d8N_zQ?pwd=gewd

LatentSync Enhanced:https://pan.quark.cn/s/f8d3d9872abb

Локальное развертывание LatentSync 1.5 1: https://pan.baidu.com/s/1QLqoXHxGbAXV3dWOC5M5zg?pwd=ijtt

Локальное развертывание LatentSync 1.5 2: https://pan.baidu.com/share/init?surl=zIUPiJc0qZaMp2NMYNoAug&pwd=8520

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...