JetBrains Open Source Mellum: специализированная модель, предназначенная для завершения кода

Компания JetBrains, поставщик инструментов для разработки программного обеспечения, недавно объявила об открытии базовой версии Mellum, языковой модели, разработанной специально для завершения кода, и ее доступности на платформе Hugging Face. Этот шаг призван способствовать прозрачности и сотрудничеству в области ИИ при разработке программного обеспечения.

Вместо того чтобы стремиться к вездесущности, философия дизайна Меллума сосредоточена на одной основной задаче: завершении кода. Компания JetBrains называет этот тип модели Специализированные модели (специализированная модель), подчеркивая, что цель ее разработки - глубокие возможности в конкретных областях, а не слепое стремление к широкой универсальности. Модель поддерживает завершение кода на различных языках программирования, включая Java, Kotlin, Python, Go, PHP, C, C++, C#, JavaScript, TypeScript, CSS, HTML, Rust и Ruby.

открытый исходный код Mellum-4b-base это первая модель в семействе Mellum. В будущем JetBrains планирует расширить это семейство за счет более специализированных моделей для различных задач кодирования, таких как предсказание диспаратности.

Соображения, лежащие в основе открытого исходного кода

Решение сделать Mellum открытым исходным кодом не было принято легкомысленно. Вместо того чтобы быть доработанной версией существующей модели с открытым исходным кодом, Mellum был создан с нуля компанией JetBrains для обеспечения облачных функций завершения кода для своих продуктов IDE и был выпущен в открытый доступ в прошлом году.

Компания JetBrains заявляет, что Open Source Mellum основана на вере в силу прозрачности, сотрудничества и совместного прогресса. От Linux и Git до Node.js и Docker - парадигма открытого исходного кода стала ключевой движущей силой значительного скачка в развитии технологий. Учитывая, что уже есть LLM с открытым исходным кодом, превосходящие некоторых лидеров отрасли, не исключено, что общее развитие ИИ пойдет по аналогичной траектории.

Этот шаг также означает, что JetBrains открывает одну из своих основных технологий для сообщества. Выпуская Mellum на Hugging Face, компания предлагает исследователям, преподавателям и старшим техническим специалистам возможность получить представление о внутреннем устройстве специализированной модели. Это больше, чем просто предоставление инструмента, это инвестиции в открытые исследования и сотрудничество.

Что такое специализированная модель?

В области машинного обучения специализация - это не новая концепция, а основной подход, который на протяжении десятилетий определял дизайн моделей - построение моделей для эффективного и результативного решения конкретных задач. Однако в последние годы дискуссия в области ИИ постепенно смещается в сторону попыток охватить все задачи с помощью обобщенных моделей, но это часто связано со значительными вычислительными и экологическими затратами.

Специализированные моделиВместо этого он возвращается к первоначальной цели специализации: построению моделей, которые хорошо работают в определенной области.

Это можно сравнить с "Т-образным навыком": человек обладает широкими знаниями по многим темам (широта знаний, горизонтальный столбик буквы "Т"), но глубокими знаниями в определенной области (глубина знаний, вертикальный столбик буквы "Т"). Специализированные модели следуют той же философии: они не создаются для того, чтобы справляться со всем, а специализируются и преуспевают в выполнении одной задачи, чтобы быть действительно ценными в определенной области.

Mellum - воплощение этой философии. Это относительно небольшая, эффективная модель, предназначенная для решения задач, связанных с кодом, начиная с завершения кода.

Причина такого подхода заключается в том, что не все проблемы требуют универсальных решений, и не у всех команд есть ресурсы или необходимость запускать большие, всеохватывающие модели. Специализированные модели (такие как Mellum) имеют явные преимущества:

- Обеспечивают точность при решении специфических задач.

- Экономичность с точки зрения эксплуатации и развертывания.

- Необходимость расчетов и углеродный след невелики.

- Обеспечивает большую доступность для исследователей, преподавателей и небольших коллективов.

Это не технологический шаг назад, а применение проверенных принципов специализации к современным проблемам ИИ. В JetBrains считают, что это более разумный путь вперед.

Как работает Меллум?

Mellum - это многоязычная параметрическая модель 4B (Mellum-4b-base), оптимизированный специально для завершения кода. Компания JetBrains провела бенчмарки для нескольких языков на различных наборах данных и выполнила обширную ручную оценку в своей IDE.

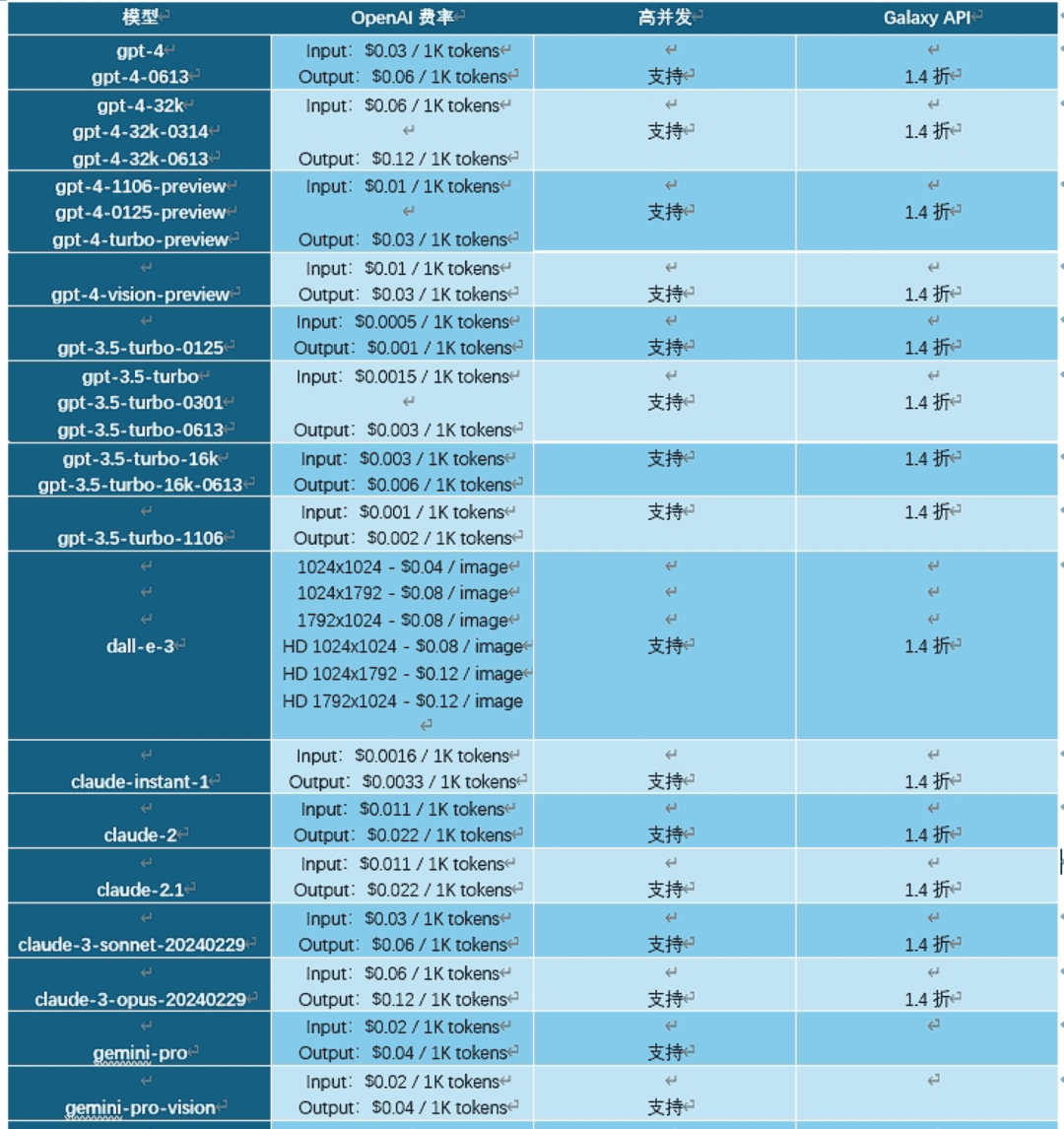

Ниже приведены данные, сравнивающие производительность Mellum с рядом моделей с большим количеством параметров (все подробности, результаты и сравнения можно найти в карточке модели Hugging Face):

| моделирование | Наполнение HumanEval (одна линия) | Наполнение HumanEval (несколько линий) | RepoBench 1.1 (2K контекст, py) | САФИМ (средний) |

|---|---|---|---|---|

| Mellum-4B-base | 66.2 | 38.5 | 28.2 | 38.1 |

| InCoder-6B | 69.0 | 38.6 | - | 33.8 |

| CodeLlama-7B-base | 83.0 | 50.8 | 34.1 | 45.0 |

| CodeLlama-13B-base | 85.6 | 56.1 | 36.2 | 52.8 |

| DeepSeek-Coder-6.7B | 80.7 | - | - | 63.4 |

Примечание: HumanEval Infilling тестирует возможности заполнения кода, RepoBench оценивает производительность в контексте реальной базы кода, а SAFIM - это другой эталонный тест на завершение кода. Сравнительные модели включают семейство CodeLlama от Meta и DeepSeek модели Coder.

Данные показывают, что Mellum демонстрирует конкурентоспособные результаты в конкретных бенчмарках (особенно если учесть его размер), несмотря на небольшое количество участников. Это еще раз подтверждает тезис о том, что специализированные модели могут достигать эффективной производительности на конкретных задачах. Количество параметров - не единственная мера возможностей модели, оптимизация под конкретную задачу также имеет решающее значение.

Для кого предназначен Меллум?

Важно понимать, что текущая версия Mellum, выпущенная на Hugging Face, в первую очередь не ориентирована на обычного конечного разработчика, который, возможно, не будет непосредственно настраивать или внедрять модель.

Модель открыта для следующих групп:

- Исследователи ИИ/МЛ: В частности, ученые, которые изучают роль ИИ в разработке программного обеспечения, проводят бенчмаркинг или исследуют интерпретируемость моделей.

- Инженеры и преподаватели в области ИИ/МЛ: Его можно использовать в качестве основы для обучения построению, тонкой настройке и адаптации языковых моделей, специфичных для конкретной области, или для поддержки образовательных проектов, посвященных архитектуре и специализации LLM.

Испытайте Меллум прямо сейчас

Базовая модель Mellum теперь доступна в следующих вариантах Обнимающееся лицо Выход в свет. JetBrains подчеркивает, что это только начало и что их цель - не стремиться к всеобщности, а создавать целенаправленные, эффективные инструменты. Для тех, кто хочет исследовать, экспериментировать или строить на основе Mellum, модель уже доступна и опробована.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...