Xinference: простое развертывание и обслуживание распределенных моделей ИИ

Общее введение

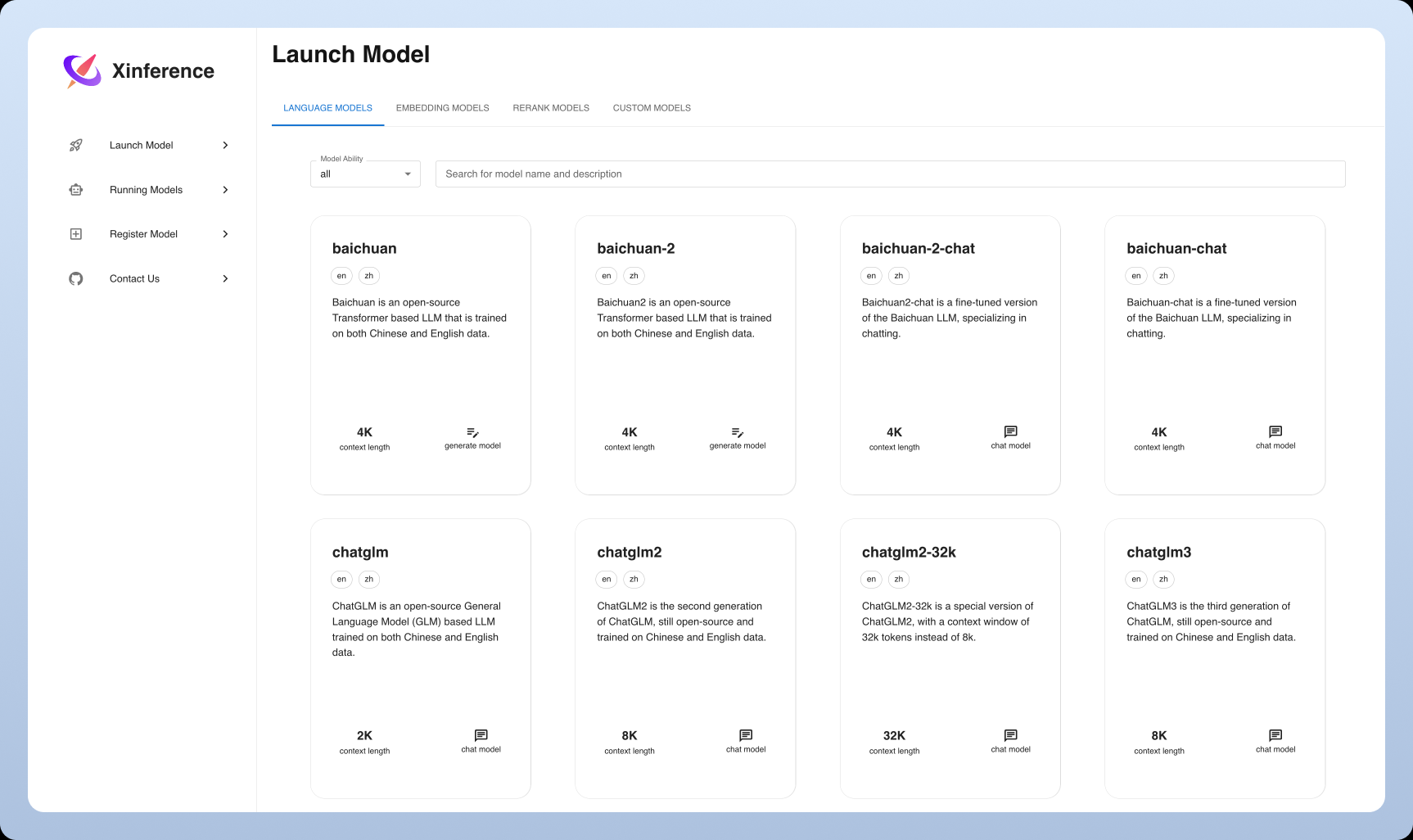

Xorbits Inference (или сокращенно Xinference) - это мощная и универсальная библиотека, ориентированная на распределенное развертывание и обслуживание языковых моделей, моделей распознавания речи и мультимодальных моделей. С помощью Xorbits Inference пользователи могут легко развернуть и обслуживать свои собственные модели или встроенные расширенные модели с помощью одной команды. В облаке, на локальном сервере или на персональном компьютере Xorbits Inference работает эффективно. Библиотека особенно подходит для исследователей, разработчиков и специалистов по обработке данных, помогая им реализовать весь потенциал передовых моделей ИИ.

Список функций

- распределенное развертывание: Поддерживает сценарии распределенного развертывания, позволяя беспрепятственно распределять задачи вывода модели между несколькими устройствами или машинами.

- услуга моделирования: Упорядочивание процесса обслуживания больших языковых моделей, моделей распознавания речи и мультимодальных моделей.

- Развертывание под одной командойРазвертывание и обслуживание моделей с помощью одной команды, как для экспериментальных, так и для производственных сред.

- Использование гетерогенного оборудованияВ системе : Intelligence используется гетерогенное оборудование, включая графические и центральные процессоры, для ускорения задач вывода моделей.

- Гибкие API и интерфейсы: Предоставление различных интерфейсов для взаимодействия с моделью, поддерживающих RPC, RESTful API (совместимый с OpenAI API), CLI и WebUI.

- Встроенные усовершенствованные модели: Встроенная поддержка широкого спектра передовых моделей с открытым исходным кодом, которые пользователи могут напрямую использовать для экспериментов.

Использование помощи

Процесс установки

- Подготовка к защите окружающей среды: Убедитесь, что установлена версия Python 3.7 или более поздняя.

- Установка Xorbits Inference::

pip install xorbits-inference

- Проверка установки: После завершения установки вы можете убедиться в том, что установка прошла успешно, с помощью следующей команды:

xinference --version

Руководство по использованию

модель развертывания

- Модели для погрузки: Используйте следующую команду для загрузки предварительно обученной модели:

xinference load-model --model-name <模型名称>

Пример:

xinference load-model --model-name gpt-3

- Начальные услуги: После загрузки модели запустите сервис:

xinference serve --model-name <模型名称>

Пример:

xinference serve --model-name gpt-3

- Вызов API: После запуска службы ее можно вызывать через RESTful API:

curl -X POST http://localhost:8000/predict -d '{"input": "你好"}'

Использование встроенной модели

В Xorbits Inference встроена поддержка широкого спектра продвинутых моделей, которые могут быть использованы непосредственно пользователем для проведения экспериментов. Пример:

- языковая модель: например, GPT-3, BERT и т.д.

- модель распознавания речи: например, DeepSpeech и др.

- мультимодальная модель: например, CLIP и т.д.

распределенное развертывание

Xorbits Inference поддерживает распределенное развертывание, позволяя пользователям легко распределять задачи по выводу моделей между несколькими устройствами или машинами. Шаги описаны ниже:

- Настройка распределенной среды: Установите Xorbits Inference на каждом узле и настройте сетевое соединение.

- Запуск распределенных служб: Запуск распределенных служб на главном узле:

xinference serve --distributed --nodes <节点列表>

Пример:

xinference serve --distributed --nodes "node1,node2,node3"

- Вызов распределенного API: Как и при развертывании одного узла, вызывается через RESTful API:

curl -X POST http://<主节点IP>:8000/predict -d '{"input": "你好"}'

общие проблемы

- Как обновить модель? Используйте следующую команду для обновления модели:

xinference update-model --model-name <模型名称>

- Как я могу просмотреть журналы? Чтобы просмотреть журнал обслуживания, выполните следующую команду:

xinference logs --model-name <模型名称>© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...