Inception Labs выпускает первую коммерческую модель диффузии большого языка

Inception Labs представляет семейство диффузных больших языковых моделей (dLLM) Mercury, которые в 10 раз быстрее и дешевле существующих LLM, что позволяет вывести моделирование языка на новые рубежи интеллекта и скорости.

центр

- Компания Inception Labs официально выпустила семейство диффузных больших языковых моделей (dLLM) Mercury, ознаменовав рождение нового поколения LLM и возвестив о новом уровне технологии быстрого и качественного создания текстов.

- Mercury в 10 раз быстрее текущих LLM, оптимизированных по скорости. На графических процессорах NVIDIA H100 модели Mercury работают со скоростью более 1 000 токенов в секунду, что ранее было возможно только на специализированных чипах.

- модель генерации кода Кодировщик ртути Теперь в Детская площадка Платформа Open Beta.Inception Labs предоставляет доступ к моделям кода и общим моделям для корпоративных клиентов через API и собственные развертывания.

Видение Inception Labs - диффузия, расширяющая возможности следующего поколения LLM

Современные модели больших языков (LLM) обычно используют авторегрессионную модель, что означает, что они пишутся как человек, слева направо, один за другим. жетон Генерация текста. Такая генерация по своей сути является последовательной - предыдущие лексемы должны быть сгенерированы, прежде чем могут быть сгенерированы последующие, и каждая сгенерированная лексема требует оценки нейронной сети с миллиардами параметров. Ведущие в отрасли LLM-компании делают ставку на увеличение времени вычислений при выводе, чтобы улучшить возможности своих моделей по выводу и исправлению ошибок, но создание длительных процессов вывода приводит к резкому росту стоимости вывода и увеличению задержек, что в конечном итоге делает продукты сложными в использовании. Для того чтобы высококачественные решения в области ИИ стали действительно повсеместными, необходимо изменить парадигму.

Диффузионные модели предлагают возможность такого изменения парадигмы. В таких моделях используется процесс генерации "от грубого к тонкому". Как показано на видео, выход модели начинается с чистого шума и постепенно оптимизируется в несколько этапов "денуазинга".

В отличие от авторегрессионных моделей, диффузионные модели не ограничены рассмотрением только того, что было выведено ранее. Это позволяет им лучше делать выводы и структурировать ответы. Кроме того, поскольку диффузионные модели способны постоянно оптимизировать свой вывод, они могут эффективно исправлять ошибки и уменьшать иллюзии. Именно благодаря этим преимуществам диффузионные модели лежат в основе многих современных выдающихся ИИ-решений в области создания видео, изображений и аудио, таких как Sora, Midjourney, Riffusion и др. Однако попытки применить диффузионные модели к дискретным данным, таким как текст и код, до сих пор не увенчались успехом. До Mercury эта ситуация была полностью нарушена.

Mercury Coder - 1000+ токенов/секунду, передовой интеллект на кончиках ваших пальцев!

Компания Inception Labs с радостью объявляет о выпуске Mercury Coder, первого общедоступного dLLM.

Mercury Coder расширяет границы возможностей ИИ: он в 5-10 раз быстрее, чем LLM текущего поколения, и обеспечивает высококачественные ответы при гораздо меньших затратах. Mercury Coder - это результат революционных исследований команды основателей Inception Labs, которые не только стали пионерами в области моделирования диффузии изображений, но и стали соавторами многих основных технологий генеративного ИИ, включая прямую оптимизацию предпочтений (DPO) и трансформаторы решений. Mercury Coder - результат новаторских исследований команды основателей Inception Labs, которые не только стали пионерами в области диффузионного моделирования изображений, но и стали соавторами ряда ключевых технологий генеративного ИИ, включая прямую оптимизацию предпочтений (DPO), Flash Attention и Decision Transformers.

dLLM может быть использован в качестве прямой замены существующих авторегрессионных LLM и поддерживает все сценарии применения, включая RAG (Retrieval Augmentation Generation), использование инструментов и рабочие процессы агентов. dLLM не генерирует ответы токен за токеном при получении пользовательского запроса. При получении запроса пользователя dLLM не генерирует ответ токен за токеном, а генерирует ответ по принципу "от грубого к тонкому", как показано в анимации выше. Модель трансформатора (используемая в Mercury Coder) была обучена на большом количестве данных и способна глобально оптимизировать качество ответа, изменяя несколько токенов параллельно для постоянного улучшения результатов. Результаты постоянно улучшаются за счет параллельного изменения нескольких лексем.

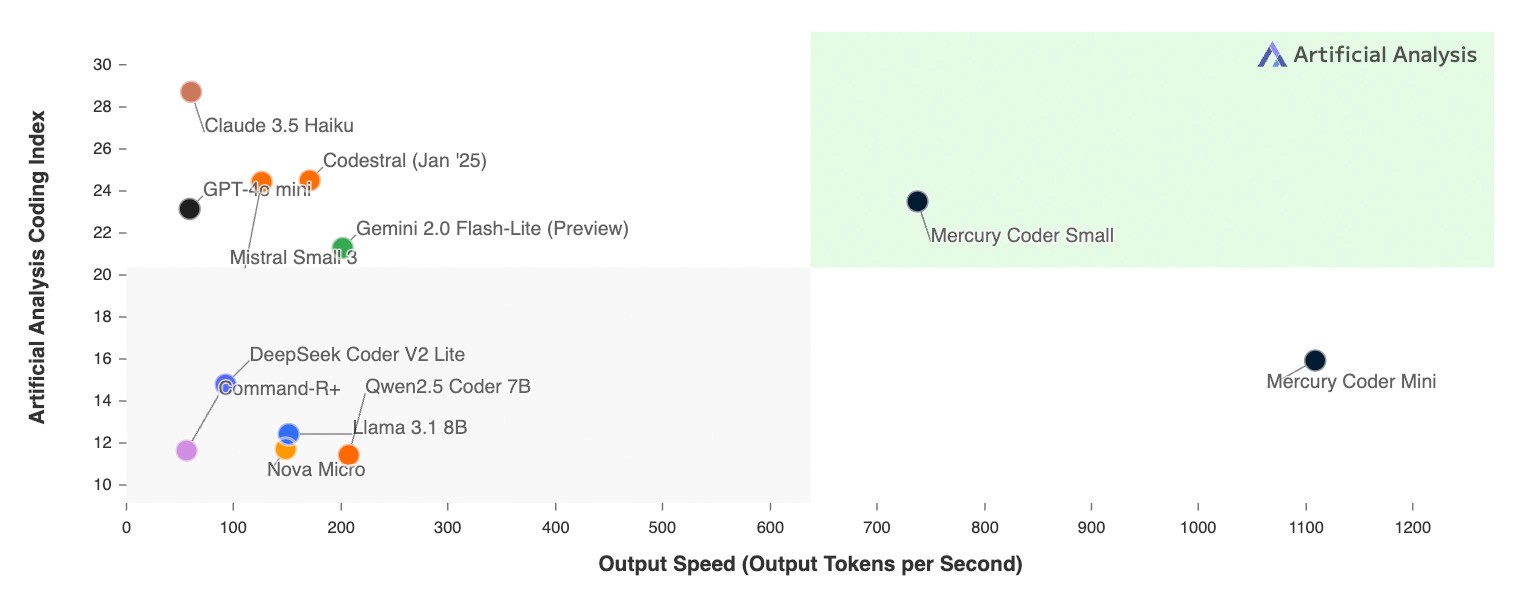

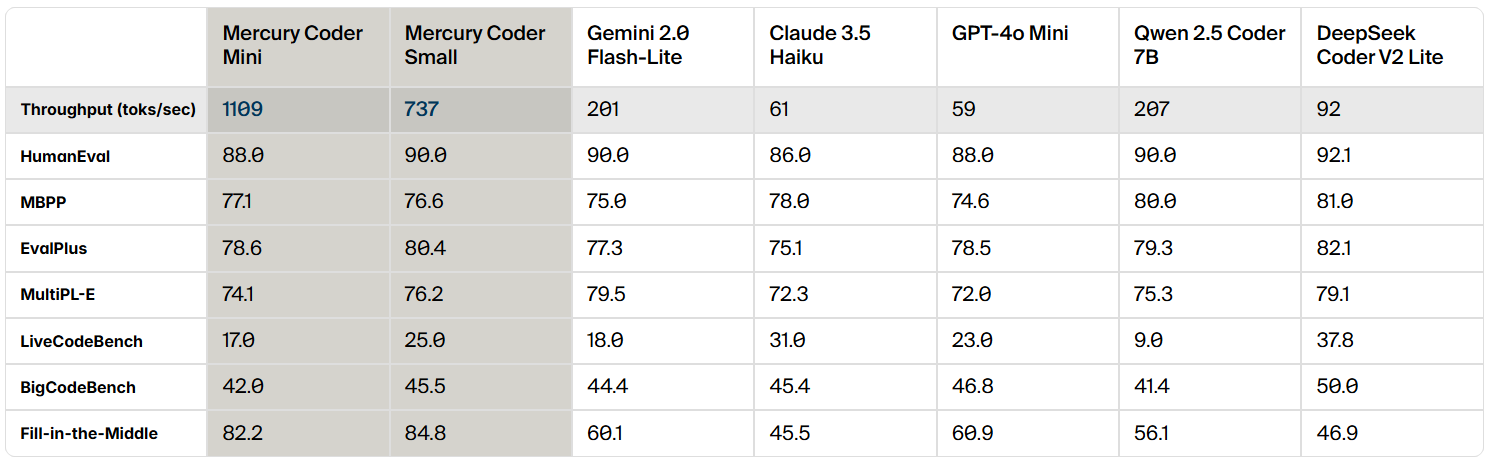

Mercury Coder - это dLLM, оптимизированный для генерации кода, и в стандартных бенчмарках Mercury Coder демонстрирует превосходство в широком спектре бенчмарков, часто превосходя GPT-4o Mini и Клод 3.5 Оптимизированные по скорости авторегрессионные модели, такие как Haiku, также работают в 10 раз быстрее.

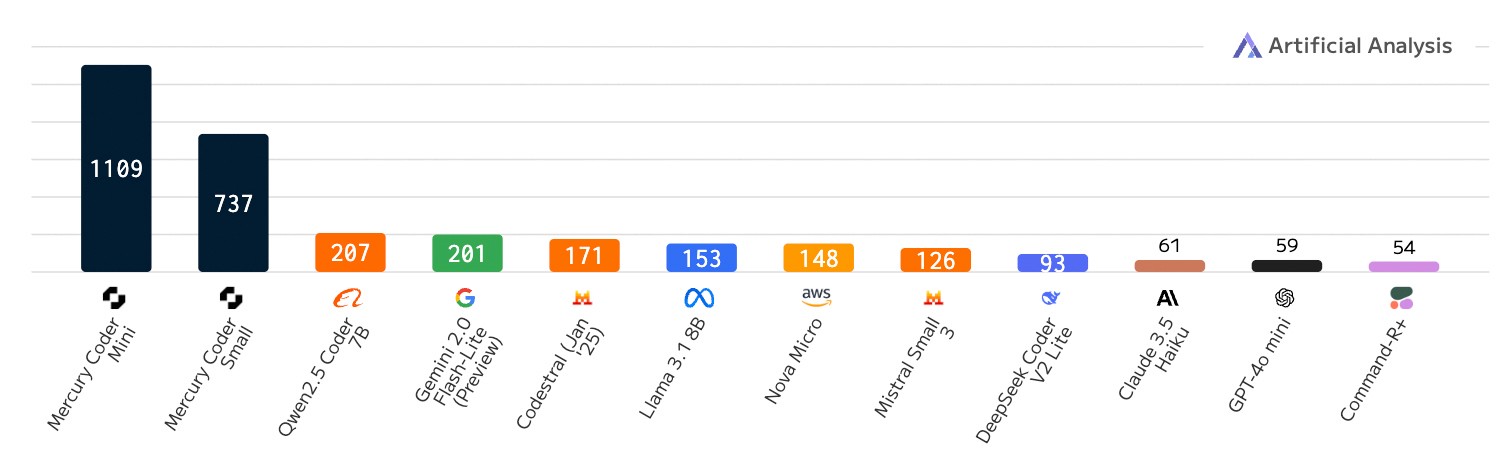

Уникальной особенностью dLLM является его невероятная скорость. В то время как даже оптимизированные по скорости авторегрессионные модели работают со скоростью не более 200 токенов/с, Mercury Coder работает со скоростью более 1000 токенов/с на графическом процессоре общего назначения NVIDIA H100, что в 5 раз быстрее. Mercury Coder даже более чем в 20 раз быстрее некоторых пограничных моделей, которые могут работать со скоростью менее 50 токенов/сек.

Ранее только специализированное оборудование, такое как Groq, Cerebras и SambaNova, могло достичь производительности, подобной dLLM. Алгоритмические улучшения Mercury Coder и аппаратное ускорение идут рука об руку, а на более быстрых чипах ускорение еще больше возрастает.

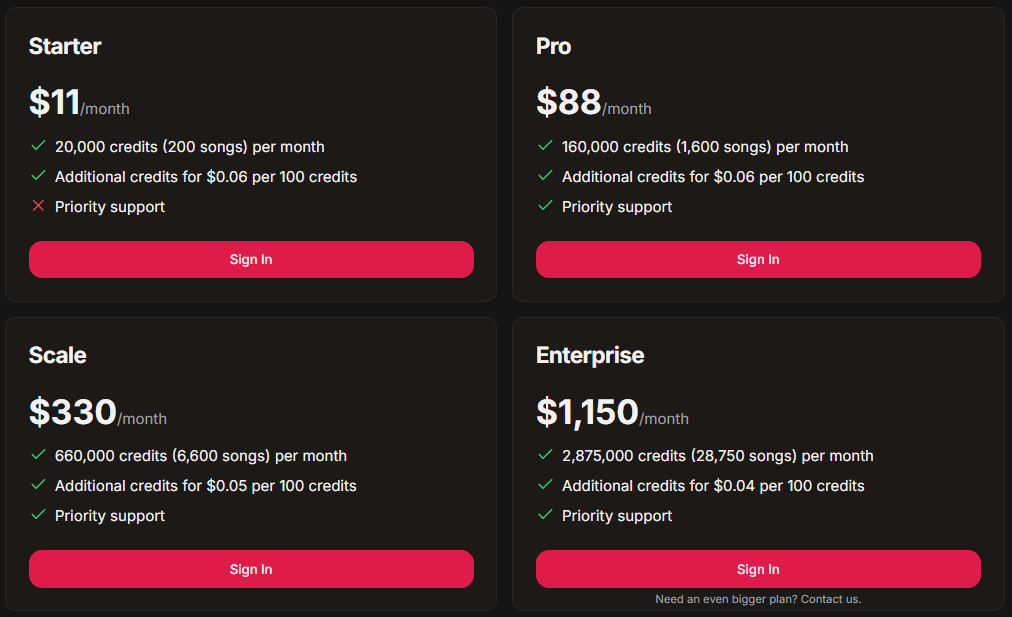

Сравнение скорости: количество выводимых токенов в секунду; рабочие нагрузки при написании кода

Еще интереснее то, что разработчики предпочитают функцию завершения кода Mercury Coder. В Второй пилот В бенчмарках Arena Mercury Coder Mini занял второе место, опередив по скорости такие оптимизированные модели, как GPT-4o Mini и Gemini-1.5-Flash, и даже сравнявшись по производительности с более крупными моделями, такими как GPT-4o. В то же время Mercury Coder является и самой быстрой моделью, примерно в четыре раза быстрее GPT-4o Mini.

Inception Labs приглашает вас испытать возможности Mercury Coder на себе. Inception Labs сотрудничает с Lambda Labs в Детская площадка Платформа предоставляет вам пробный доступ к Mercury Coder. Оцените, как Mercury Coder генерирует высококачественный код за долю времени, как показано на видео ниже.

Что это означает для приложений ИИ?

Первые последователи Mercury dLLM, включая лидеров рынка в области поддержки клиентов, генерации кода и автоматизации предприятий, успешно переходят от стандартной базовой модели с авторегрессией к Mercury dLLM в качестве прямой замены. Этот переход напрямую приводит к улучшению пользовательского опыта и снижению затрат. В сценариях приложений, чувствительных к задержкам, партнерам часто приходилось выбирать менее мощные модели, чтобы соответствовать строгим требованиям к задержкам. Теперь, благодаря превосходной производительности dLLM, эти партнеры могут использовать более крупные и мощные модели, сохраняя при этом свои первоначальные требования к стоимости и скорости.

Inception Labs предоставляет доступ к семейству моделей Mercury как через API, так и через локальное развертывание. Модели Mercury полностью совместимы с существующим оборудованием, наборами данных и процессами контролируемой тонкой настройки (SFT) и выравнивания (RLHF).

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...