Hybrid-T1 перевыпущен: с поддержкой Mamba, определяющей скорость вывода.

В последнее время область крупномасштабного моделирования языка привлекает все большее внимание со стороны индустрии к новым парадигмам обучения с подкреплением на поздних этапах обучения. После появления моделей серии O, таких как GPT-4o от OpenAI и DeepSeek-R1 В результате, отличная работа модели демонстрирует ключевую роль обучения с подкреплением в процессе оптимизации.

Команда Tencent Mixed Meta Model также добилась значительного прогресса в последнее время. В середине февраля этого года команда запустила модель умозаключений Mixed Yuan T1-Preview, основанную на базе Mixed Yuan среднего размера в Tencent Yuanbao APP. Теперь модель Deep Thinking серии Mixed Meta Model была обновлена до официальной версии Mixed Meta-T1.

Опыт работы Адрес:

https://llm.hunyuan.tencent.com/#/chat/hy-t1

https://huggingface.co/spaces/tencent/Hunyuan-T1

Hybrid-T1 основан на выпущенном в начале марта TurboS База быстрого мышления.TurboS - это первая в мире гипермасштабная смешанная модель экспертизы (MoE), включающая в себя Трансформатор и архитектуры Mamba. Благодаря масштабному посттренинговому обучению возможности Mamba-T1 в области умозаключений значительно расширяются и лучше согласуются с предпочтениями человека.

Гибрид-T1 обладает уникальными преимуществами в области глубоких рассуждений. Во-первых, способность TurboS захватывать длинные тексты помогает эффективно решать общие проблемы потери контекста и зависимости от удаленной информации при умозаключениях по длинным текстам. Во-вторых, архитектура Mamba специально оптимизирована для длинных последовательностей и значительно снижает потребление вычислительных ресурсов за счет эффективных вычислительных методов, обеспечивая при этом возможность захвата длинной текстовой информации. При одинаковых условиях развертывания скорость декодирования увеличивается в 2 раза.

На последующем этапе обучения модели 96,7% вычислительных ресурсов инвестируется в обучение с применением подкрепления, сосредоточенное на улучшении чистого умозаключения и оптимизации соответствия предпочтениям человека.

Для достижения этой цели команда исследователей собрала научные задачи и задачи на рассуждение мирового уровня, охватывающие области математики, логических рассуждений, науки и кода. Эти наборы данных охватывают широкий спектр задач - от базовых математических рассуждений до решения сложных научных проблем. Это, в сочетании с реальной обратной связью (ground-truth), гарантирует, что модель хорошо справляется с широким спектром задач на рассуждение.

Обучение проводилось с использованием подхода, основанного на обучении по учебной программе (CLE), при котором постепенно увеличивается сложность данных при постепенном расширении объема контекста модели, так что модель учится эффективно использовать их, улучшая свои способности к рассуждению. жетон Рассуждения.

Что касается стратегий обучения, то классические стратегии обучения с подкреплением, такие как воспроизведение данных и периодический сброс политики, заимствованы для повышения долгосрочной стабильности обучения модели более чем на 50%. На этапе согласования с предпочтениями человека используется единая схема обратной связи системы вознаграждения, включающая самовознаграждение (комплексную оценку и балльную оценку результатов работы модели на основе ранней версии T1-Preview) и шаблоны вознаграждения, которые направляют модель на самосовершенствование. Модели демонстрируют в своих ответах более богатую детализацию содержания и более эффективную информацию.

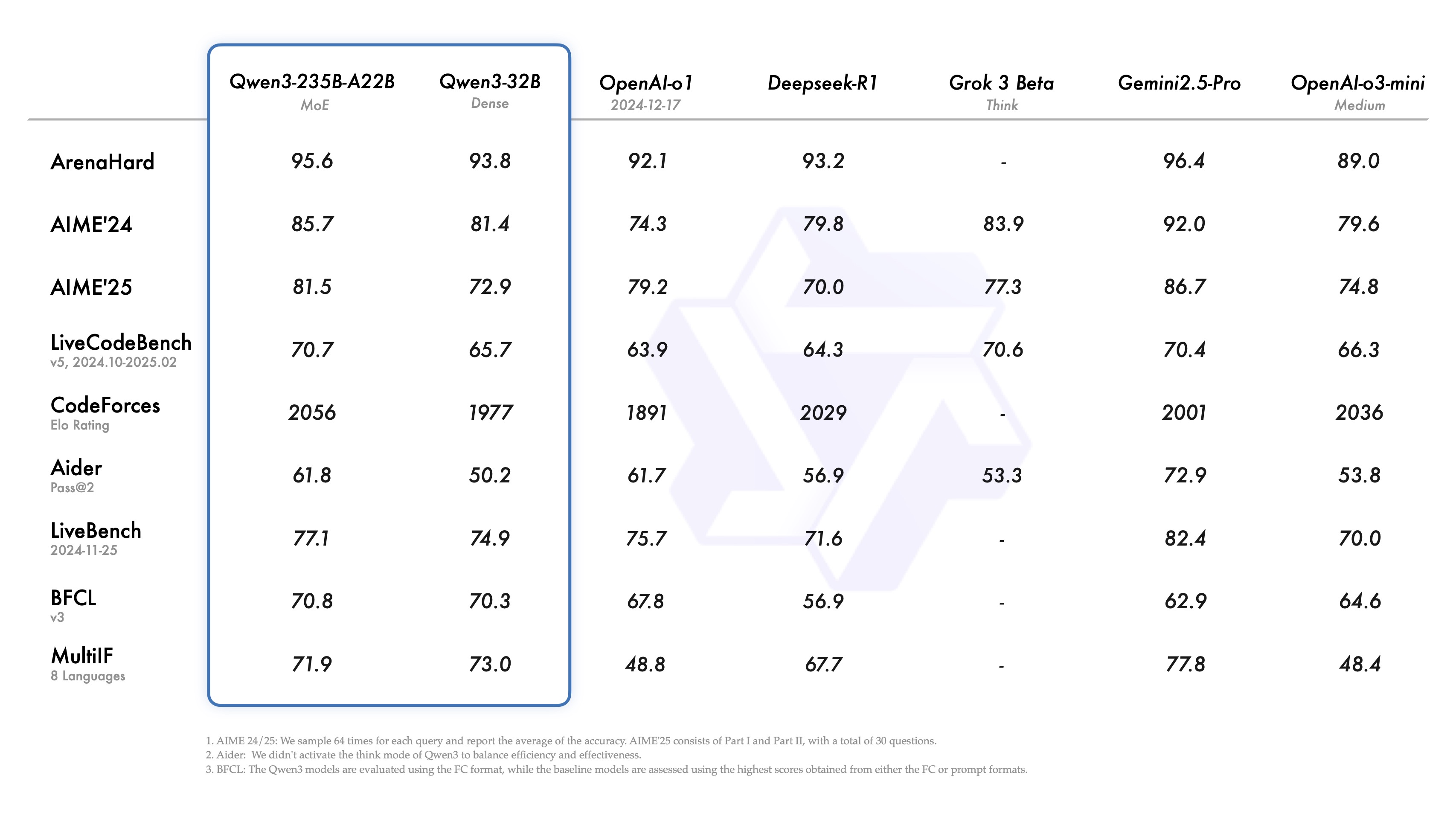

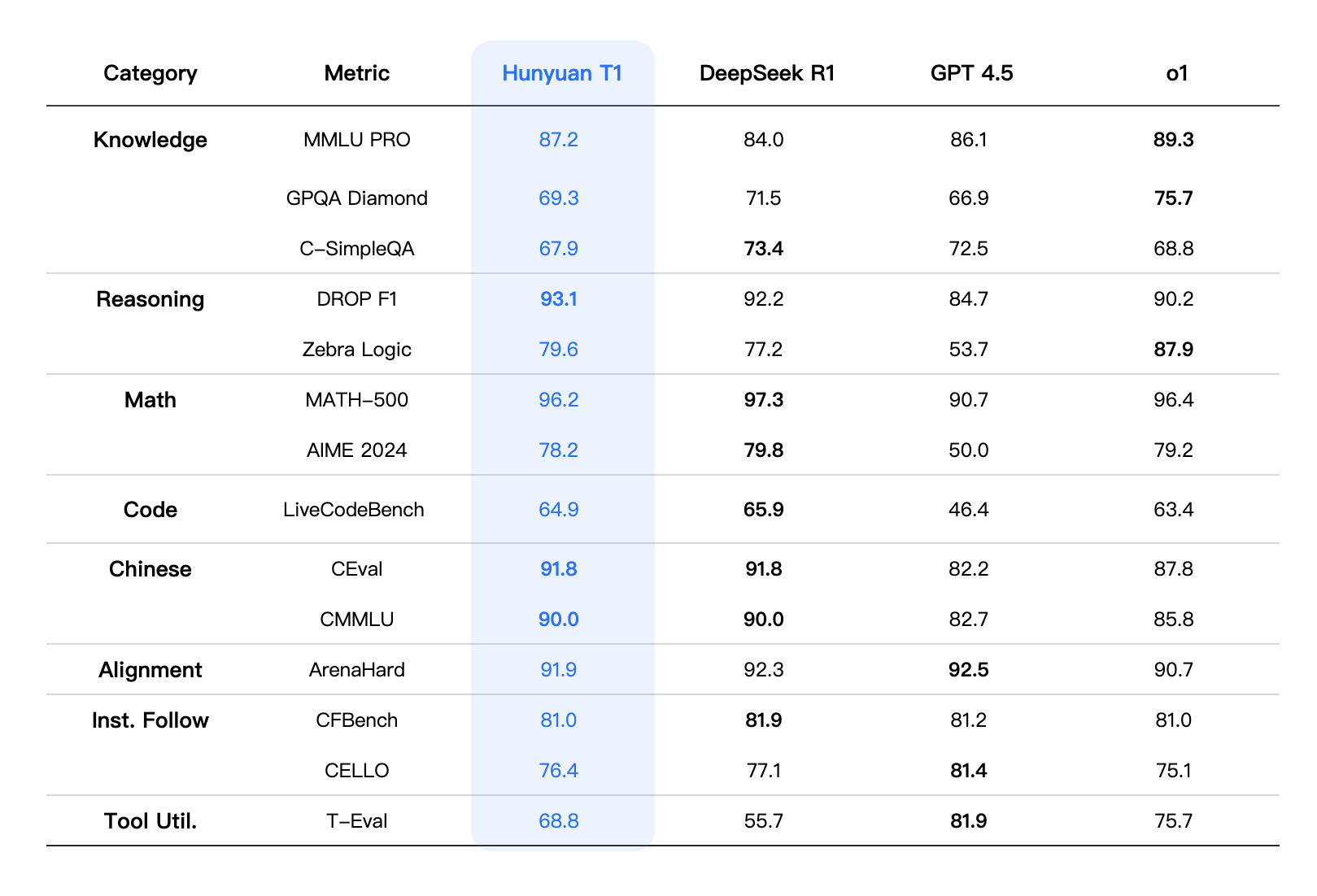

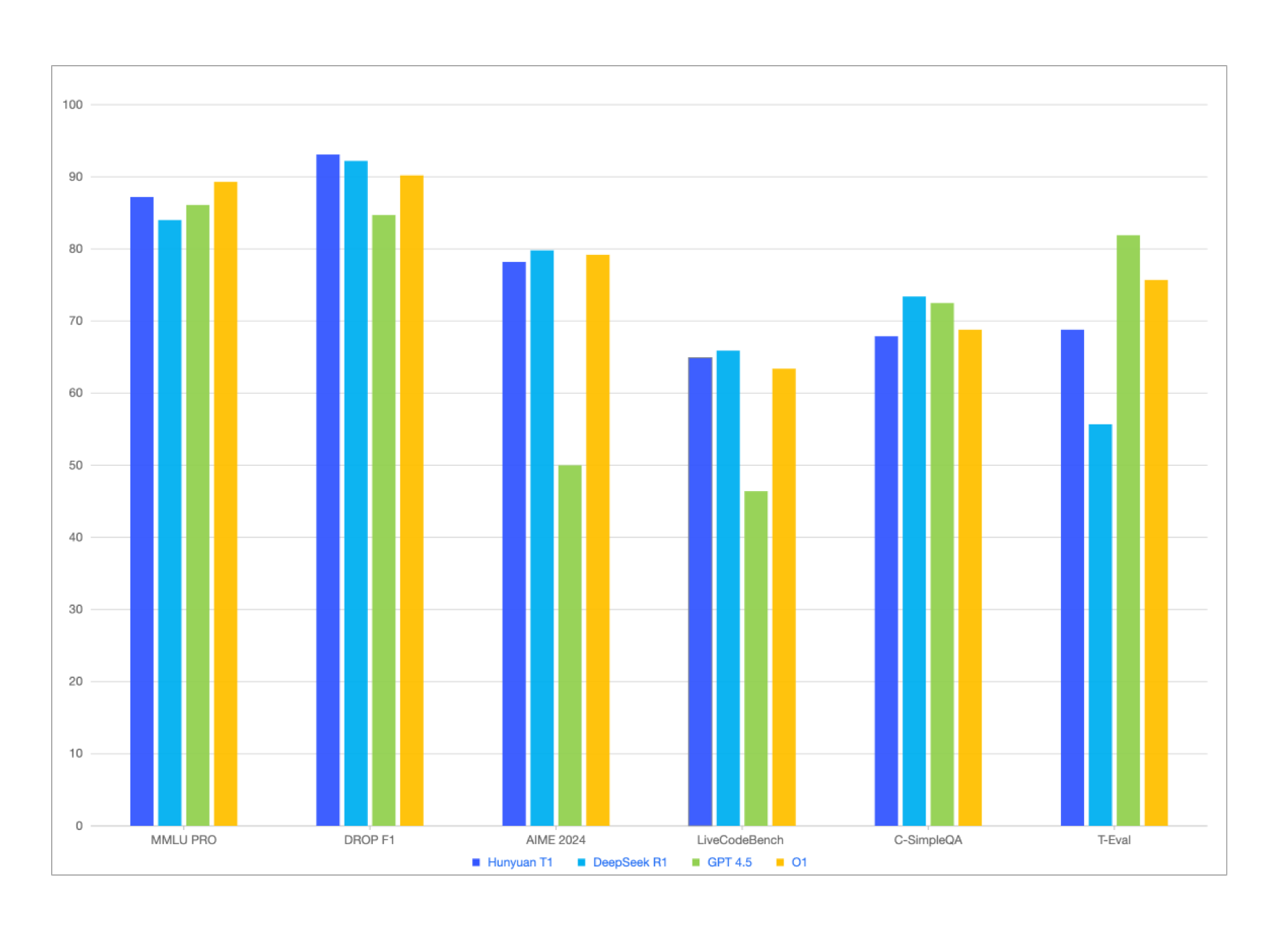

Помимо сопоставимых или чуть более высоких результатов, чем у DeepSeek-R1, в публичных эталонных тестах на знание китайского и английского языков, математики и логического мышления соревновательного уровня, таких как MMLU-pro, CEval, AIME, Zebra Logic и других, Mixed Elements-T1 также демонстрирует хорошие результаты на внутренних наборах данных, полученных от людей, с небольшими преимуществами в следовании культурным и творческим инструкциям, обобщении текста и компетенции "умного тела". .

По показателям комплексной оценки общая производительность Hybrid-T1 сопоставима с производительностью первоклассной пограничной модели вывода. По комплексной оценке возможностей T1 находится на уровне MMLU-PRO Занимая второе место в списке после O1, набирает 87.2 высоких результатов. Тест включает в себя вопросы из 14 областей гуманитарных, социальных, естественных и технических наук и направлен на проверку памяти и понимания широкого спектра знаний. Кроме того, особое внимание уделяется специализированным знаниям и сложным научным рассуждениям. GPQA-алмаз(T1 добился следующих результатов (в основном это проблемы докторского уровня в области физики, химии и биологии) 69.3 Счет.

Сценарии, требующие сильных навыков мышления, таких как кодирование, математика и логическое мышление, были протестированы в области естественных и инженерных наук. В LiveCodeBench При оценке кода T1 достиг 64.9 Баллы. В то же время Т1 преуспел в математике. Особенно в MATH-500 Вдобавок ко всему, это сделало 96.2 Отличные результаты, полученные после DeepSeek-R1, продемонстрировали всесторонние способности Т1 в решении математических задач. Кроме того, Т1 продемонстрировал высокую адаптивность при выполнении множества заданий на выравнивание, выполнение команд и использование инструментов. Например, Т1 хорошо справился с заданием ArenaHard Миссия была удостоена награды 91.9 Счет.

эффект моделирования

Примечание: Показатели оценки для других моделей в таблице взяты из официальных результатов оценки. Для деталей, не включенных в официальные результаты оценки, данные взяты из внутренней платформы оценки Hybrid.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...