От нейронных сетей до обнимающихся лиц - краткая история нейронных сетей и глубокого обучения

TL;DR Эта статья состоит из 8200+ слов и займет около 15 минут, чтобы прочитать ее полностью. В этой статье кратко рассматриваются новейшие приложения больших моделей - от машин восприятия до глубокого обучения ChatGPT История

Оригинал: https://hutusi.com/articles/the-history-of-neural-networks

В жизни нет ничего страшного, нужно только понять.

-- Мадам Кюри

I Глубокие сети убеждений

В 2006 году Джеффри Хинтон, профессор Университета Торонто (Канада), изучал способы обучения многослойных нейронных сетей, и вот уже более трех десятилетий он спокойно работает в области нейронных сетей. Хотя он считается титанической фигурой в этой области, результаты его исследований были недооценены промышленностью, поскольку нейронные сети были недооценены в индустрии искусственного интеллекта.

Семья Хинтона родилась в Лондоне, Англия, и в ее роду было немало выдающихся ученых, а Джордж Буль, логик, основавший булеву алгебру, был его прапрадедом. Его дед был научным писателем, а отец - энтомологом. Хинтон был умнее всех окружающих, но его путь в школе был нелегким: сначала он изучал архитектуру в университете, затем физику, потом философию и, наконец, закончил его со степенью бакалавра психологии. В 1972 году Хинтон поступил в Эдинбургский университет, чтобы получить степень доктора философии в области нейронных сетей, которая в то время считалась самой популярной в отрасли. В то время нейронные сети презирались промышленностью, и даже руководители Хинтона считали, что они не имеют практической пользы и будущего. Однако Хинтон не пал духом и верил в исследования нейронных сетей, настаивая на том, что сможет доказать их ценность, на чем он настаивал более 30 лет.

Хинтон вывихнул диск в поясничном отделе позвоночника, когда в молодости перевозил обогреватель, и с тех пор страдает от проблем с поясницей. В последние годы проблема усугубилась, и большую часть времени ему приходится лежать на спине, чтобы облегчить боль, а это значит, что он не может ни водить машину, ни летать, ни даже лежать на раскладной кровати в своем кабинете, когда встречается со студентами в лаборатории. Физическая боль от этого испытания не так сильно задела Хинтона, как безразличие к академическим исследованиям. Еще в 1969 году Минский в своей книге "Машины восприятия" установил закон для многослойных машин восприятия, поставив печать одобрения на последующие исследования нейронных сетей: "У многослойных машин восприятия не будет будущего, потому что никто в мире не сможет обучить многослойную машину восприятия достаточно хорошо, даже для того, чтобы она смогла научиться простейшим методам функционирования". Ограниченные возможности однослойных перцептронов, которые не могут решить даже базовые проблемы классификации, такие как "гетероскедастичность", и отсутствие доступных методов обучения для многослойных перцептронов равносильно тому, чтобы сказать, что направление исследований нейронных сетей является тупиковым. В отрасли нейронные сети считались академической ересью, и никто не верил, что они могут быть успешными, поэтому студенты старались обходить нейронные сети стороной при выборе научного руководителя, а Синтон некоторое время даже не мог набрать достаточное количество аспирантов.

В 1983 году Хинтон изобрел машину Больцмана, а позже упрощенная ограниченная машина Больцмана была применена в машинном обучении и стала основой иерархической структуры глубоких нейронных сетей. В 1986 году Хинтон предложил алгоритм обратного распространения ошибки (BP) для многослойных перцептивных машин - алгоритм, заложивший основу того, что впоследствии стало глубоким обучением. Хинтон изобретал что-то новое время от времени, и он продолжал писать более двухсот работ, связанных с нейронными сетями, даже несмотря на то, что они не были хорошо приняты. К 2006 году Хинтон накопил богатую теоретическую и практическую базу, и на этот раз он опубликовал работу, которая изменила всю систему машинного обучения и, по сути, весь мир.

Синтон обнаружил, что нейронные сети с несколькими скрытыми слоями способны автоматически извлекать признаки для обучения, что более эффективно, чем традиционное машинное обучение с ручным извлечением признаков. Кроме того, сложность обучения многослойных нейронных сетей может быть снижена благодаря послойному предварительному обучению, что решает давнюю проблему обучения многослойных нейронных сетей. Хинтон опубликовал свои результаты в двух работах в то время, когда термин "нейронная сеть" отвергался многими редакторами научных журналов, а названия некоторых рукописей даже возвращались из-за того, что в них содержалось слово "нейронная сеть". Чтобы не раздражать чувствительность этих людей, Хинтон взял новое имя и назвал модель "Глубокая сеть убеждений" (Deep Belief Network).

II. Датчики

На самом деле, исследования нейронных сетей можно отнести к 1940-м годам. В 1940 году 17-летний Уолтер Питтс встретил 42-летнего профессора Уоррена Маккаллоха в Иллинойском университете в Чикаго и присоединился к исследовательскому проекту последнего: попытка использовать нейронные сети для построения механической модели мозга на основе логических операций. Они использовали логические операции для абстрагирования мыслительной модели человеческого мозга и выдвинули концепцию "нейронной сети" (Neural Network), а нейроны - это наименьшая единица обработки информации в нейронной сети; они абстрагировали и упростили рабочий процесс нейронов в очень простую модель логических операций, которая позже была названа "M Модель была названа "M-P Neuron Model" по инициалам их двух имен.

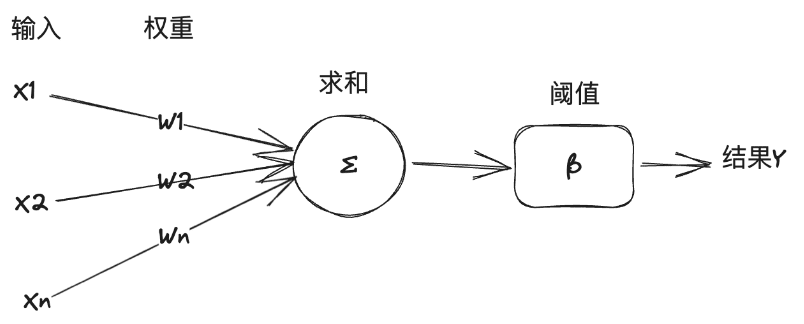

В этой модели нейрон получает несколько входных сигналов от других нейронов, причем значимость входных сигналов варьируется от одного нейрона к другому, что представлено "весом" связи, и нейрон суммирует все входы в соответствии с весом и сравнивает результат с "порогом" нейрона, чтобы решить, выводить сигнал или нет. Нейрон суммирует все входы в соответствии с весами и сравнивает результат с "порогом" нейрона, чтобы решить, выводить сигнал во внешний мир или нет.

Модель M-P" достаточно проста и понятна, чтобы быть смоделированной с помощью символической логики, и специалисты по ИИ использовали ее в качестве основы для построения нейросетевых моделей для решения задач машинного обучения. Вот краткое объяснение взаимосвязи между искусственным интеллектом, машинным обучением и глубоким обучением: Искусственный интеллект - это использование компьютерных технологий для достижения человеческого интеллекта, в общем учебнике определяется как изучение и конструирование интеллектуальных агентов. Интеллектуальный агент - это интеллектуальный агент, или просто агент, который решает специфические задачи или задачи общего назначения, имитируя человеческое мышление и познание. Интеллектуальный агент, решающий характерные задачи, известен как слабый искусственный интеллект, или узкий искусственный интеллект (ANI), а интеллектуальный агент, решающий задачи общего назначения, известен как сильный искусственный интеллект, или искусственный интеллект общего назначения (AGI). Машинное обучение - это направление ИИ, которое учится на данных и совершенствует системы. Глубокое обучение, с другой стороны, является еще одним направлением машинного обучения, которое использует методы нейронных сетей для машинного обучения.

В 1957 году Розенблатт, профессор психологии Корнельского университета, смоделировал и реализовал на компьютере IBM модель нейронной сети, которую он назвал перцептроном. Его подход заключался в том, чтобы собрать набор нейронов модели M-P, которые можно было бы использовать для обучения и выполнения некоторых задач машинного распознавания образов. В общем случае машинное обучение включает в себя два вида задач: классификацию и регрессию. Классификация - это проблема определения класса данных, например, определение того, является ли изображение кошкой или собакой, а регрессия - это проблема предсказания одних данных по другим, например, предсказание веса человека на основе его изображения. Перцептроны решают задачи линейной классификации. Объясните это на примере работы перцептронов из книги "Грани интеллекта":

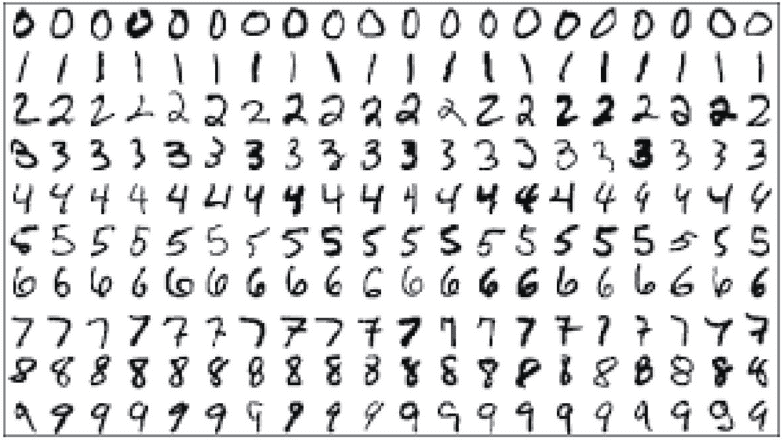

Предположим, что целью задачи является автоматическое распознавание арабских цифр; распознаваемые цифры будут написаны от руки или напечатаны в различных формах; цифры будут сохранены путем их сканирования в файл изображения размером 14*14 пикселей. Для машинного обучения сначала подготавливается обучающий набор, похожий на следующий рисунок. Обучающий набор - это набор данных, специально предназначенный для машинного обучения, это не только набор картинок и других данных, но и предварительная ручная маркировка, чтобы указать машине, что представляют собой числа, изображенные на картинках.

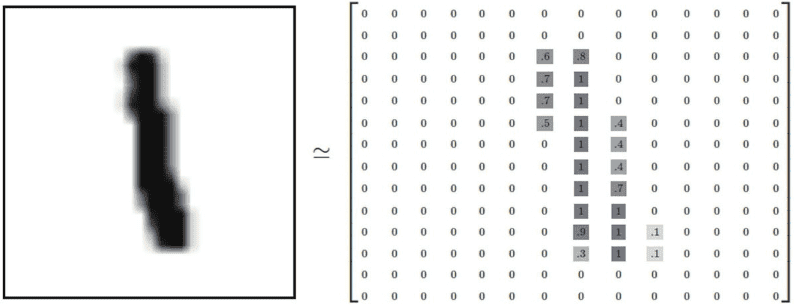

Затем нужно разработать структуру данных, чтобы машина могла хранить и обрабатывать эти изображения. Для цифрового изображения 14*14 в серой шкале черные пиксели могут быть представлены 1, белые - 0, а пиксели между черным и белым представлены числом с плавающей запятой в диапазоне 0-1 в зависимости от интенсивности серой шкалы. Как показано на рисунке ниже, эта картинка может быть преобразована в двумерный тензорный массив:

И машина способна распознать, что это за цифры на картинке, в основном путем нахождения особенностей этой картинки, которые представляют конкретное число. Человеку легко распознать эти рукописные цифры, но нам трудно объяснить, что это за особенности. Целью машинного обучения является извлечение из обучающего набора признаков картинок, представляющих числа, и, согласно модели M-P, способ извлечения признаков заключается в выборе веса и суммировании значений отдельных пикселей картинки и вычислении веса каждого пикселя, соответствующего каждому числу, на основе результатов соответствия между образцами картинок в обучающем наборе и аннотированными данными: если конкретный пиксель имеет очень отрицательное свидетельство того, что картинка не принадлежит числу Если пиксель имеет очень отрицательное свидетельство того, что изображение не принадлежит определенному числу, вес этого пикселя устанавливается на отрицательное значение для этого числа, и наоборот, если пиксель имеет очень положительное свидетельство того, что изображение принадлежит определенному числу, вес этого пикселя устанавливается на положительное значение для этого числа. Например, для числа "0" пиксель в средней точке изображения не должен иметь черного (1) пикселя, если он появляется, то изображение принадлежит числу 0, как отрицательное свидетельство, это уменьшает вероятность того, что на изображении именно число 0. Таким образом, после обучения и калибровки набора данных распределение веса каждого пикселя, соответствующего каждому числу 0-9, может быть получено как 14*14 (=196).

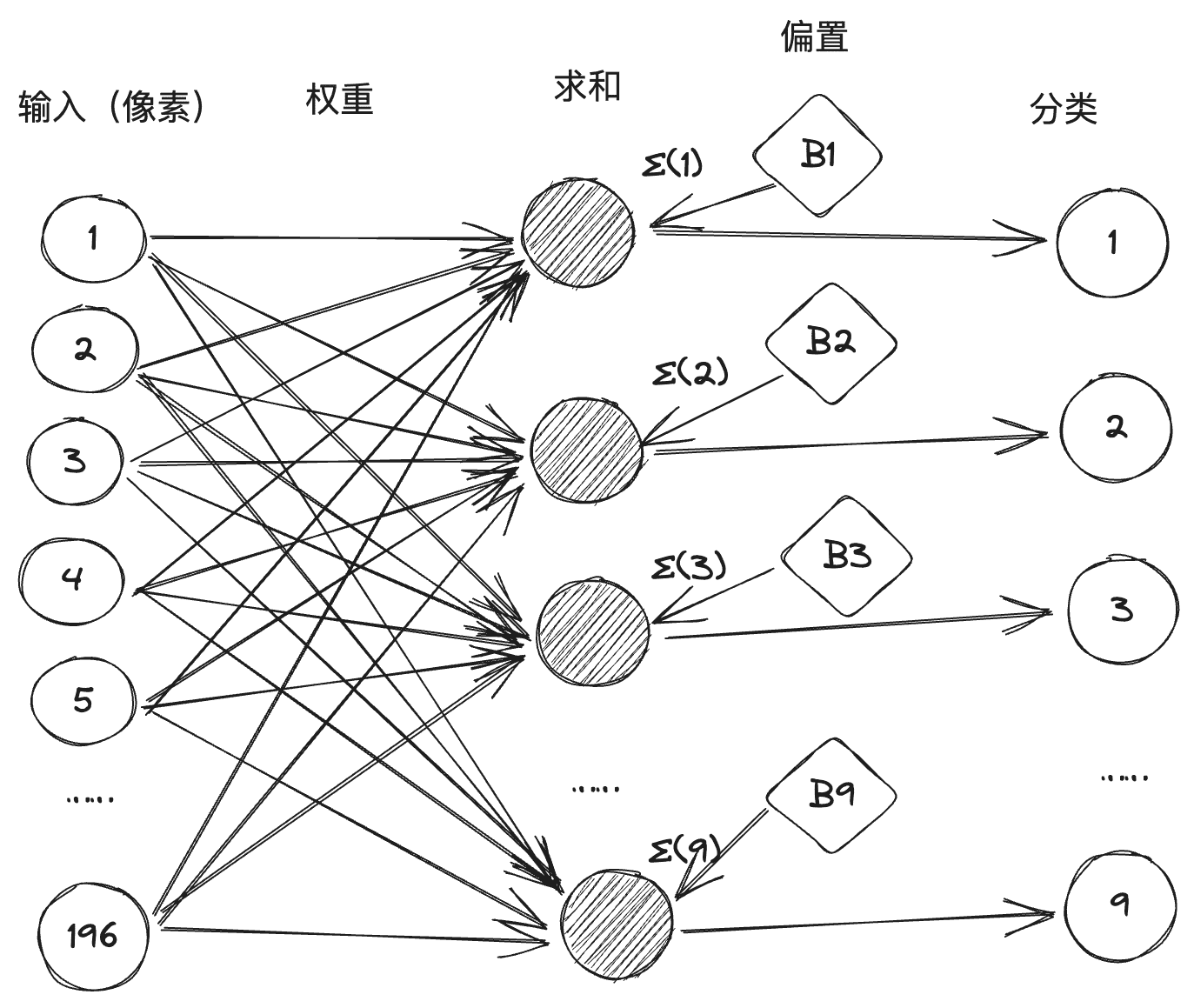

Затем мы преобразуем процесс классификации каждого числа в M-P нейрон, каждый нейрон имеет 196 пиксельных входов, а значение веса между каждым входом и нейроном получено путем обучения, так что это составляет нейронную сеть, состоящую из 10 нейронов, 196 входов и 1 960 соединительных линий с весами перед ними, как показано ниже: (Как правило, в нейронной сети пороговое значение будет преобразуется в смещение, называемое одним из членов суммирования, для упрощения арифметического процесса).

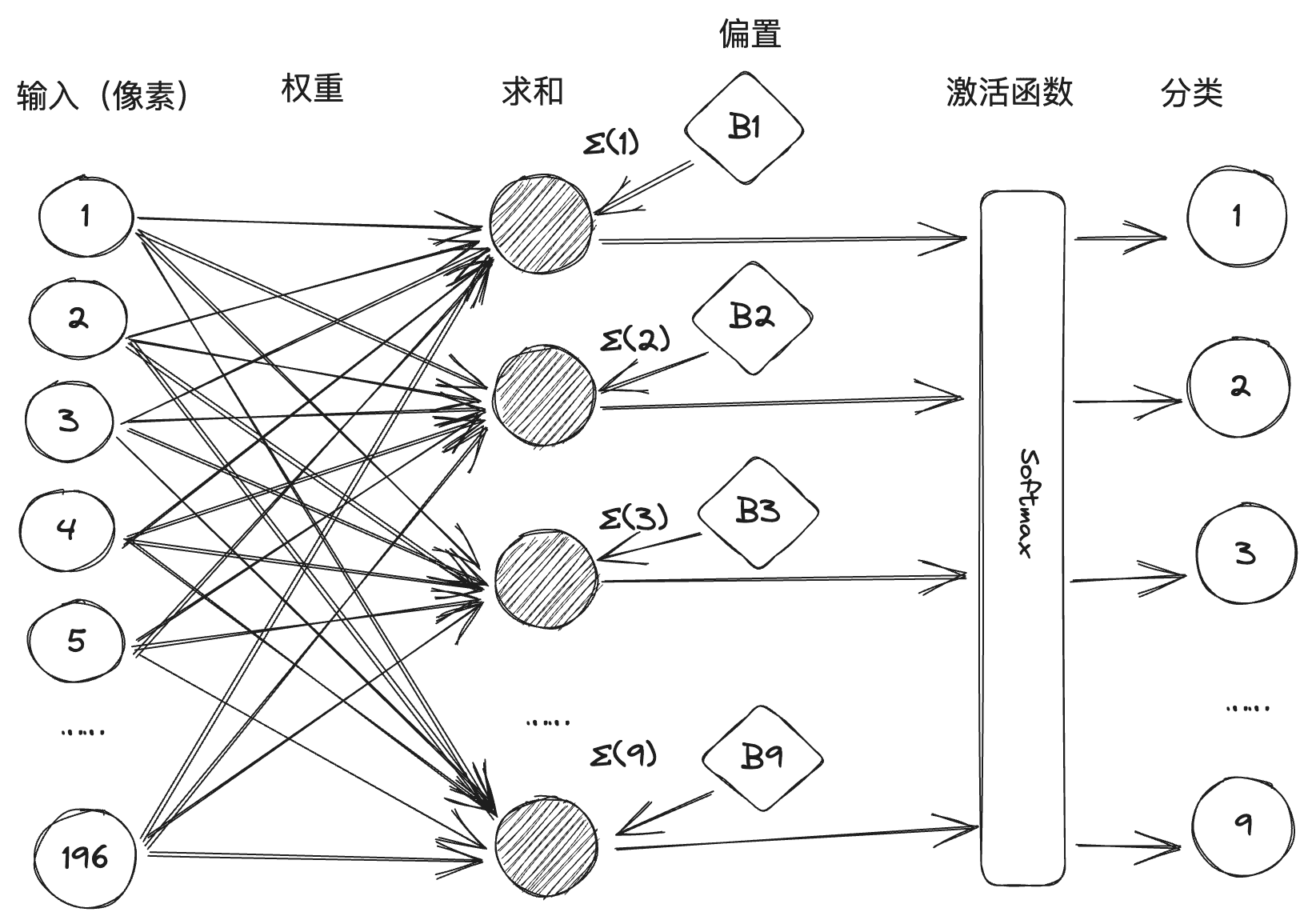

Однако на практике в некоторых рукописных шрифтах встречаются неоднозначности, которые могут привести к тому, что после взвешенного суммирования активируются два или более нейронов. Поэтому перцептивная машина реализуется путем введения функции активации, как показано на рисунке ниже, Softmax - это функция активации, которая будет обрабатывать значение суммирования для подавления числовой классификации с малой вероятностью и усиления числовой классификации с большой вероятностью.

Розенблатт сделал первый в мире аппаратный перцептрон "Марк-1" два года спустя, перцептрон мог распознавать английский алфавит, но в то время он вызвал огромную сенсацию. Министерство обороны США и военно-морской флот также заметили, и оказали большую финансовую поддержку, Розенблатт на восприятие машины доверие достигло своего пика, и даже репортер спросил "нет ли восприятия машины не может сделать вещи", ответ Розенблатта "любовь, надежда, отчаяние!". Ответ Розенблатта был "любовь, надежда, отчаяние". Слава Розенблатта росла, а его эпатажная личность привела к тому, что он повсюду нажил себе врагов, самым известным из которых был другой гигант искусственного интеллекта, Марвин Мински. Минский был организатором Дартмутской конференции и одним из основателей ИИ. В 1969 году он опубликовал свою книгу "Перцептивные машины", в которой четко указал на недостатки, существующие в перцептивных машинах. Первый недостаток заключался в математической демонстрации того, что перцептивные машины не могут справиться с нелинейными проблемами классификации, такими как гетероскедастичность, а второй - в демонстрации того, что сложность многослойных перцептивных машин приводит к резкому увеличению объема связанных данных без подходящего метода обучения. Минский получил четвертую премию Тьюринга в год выхода книги, и огромный престиж его суждения о перцептивных машинах вынес смертный приговор исследованиям нейронных сетей. Коннекционизм потерпел поражение, и символистские исследования стали мейнстримом в ИИ.

В области искусственного интеллекта существуют две основные школы мысли: коннекционизм и символизм - примерно как секта меча и секта ци в романах о боевых искусствах, которые долгое время соперничали друг с другом. Коннекционизм развивает ИИ, моделируя человеческий мозг для построения нейронных сетей, хранящих знания в большом количестве связей и обучающихся на основе данных. Символизм, напротив, считает, что знания и рассуждения должны быть представлены символами и правилами, то есть большим количеством определений правил "если - то" для генерации решений и рассуждений, и разрабатывает ИИ на основе правил и логики. Первый вариант представлен нейронными сетями, а второй - экспертными системами.

III Глубокое обучение

После неудачи с машиной восприятия государственные инвестиции в сферу ИИ сократились, и ИИ вступил в свой первый зимний период. А к 1980-м годам символизм, представленный экспертными системами, стал мейнстримом ИИ, вызвав вторую волну ИИ, в то время как исследования нейронных сетей остались в стороне. Как уже говорилось, есть только один человек, который до сих пор не опускает руки, и это Джеффри Хинтон.

Основываясь на своих предшественниках, Синтон последовательно изобрел машину Больцмана и алгоритм обратного распространения ошибки. Пионерский вклад Синтона в область нейронных сетей вдохнул жизнь в эту область, хотя основным направлением в области искусственного интеллекта с 1980-х годов до начала века оставались базы знаний и статистический анализ, различные техники нейронных сетей начали пробивать себе дорогу, с такими показательными примерами, как конволюционные нейронные сети (CNN), сети долговременной памяти (LSTM) и др. сети (LSTM) и т. д. В 2006 году Хинтон предложил глубокие сети убеждений, которые открыли эру глубокого обучения.

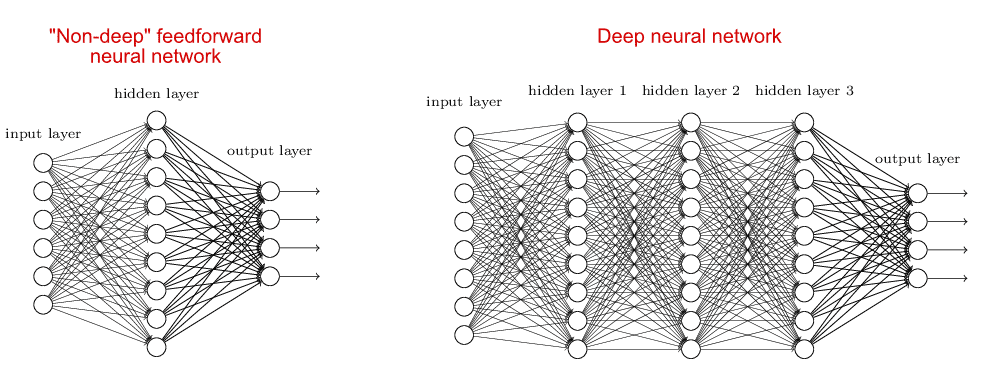

Модель нейронной сети, соответствующая глубокому обучению, называется глубокой нейронной сетью, которая является родственницей неглубоких нейронных сетей. В неглубоких нейронных сетях, как правило, имеется только один скрытый слой (или средний слой), а также входной и выходной слои, в общей сложности три слоя. Глубокие нейронные сети, с другой стороны, имеют более одного скрытого слоя, что позволяет сравнить эти два типа нейронных сетей:

Причина, по которой люди сосредоточились на неглубоких нейронных сетях до глубокого обучения, заключается в том, что увеличение количества слоев нейронной сети приводит к увеличению сложности обучения, с одной стороны, не хватает достаточной арифметической поддержки, а с другой стороны, нет хорошего алгоритма. Глубокая сеть убеждений, предложенная Хинтоном, решает эту проблему обучения с помощью алгоритма обратного распространения ошибки и предварительного обучения слоя за слоем. После глубокой сети убеждений глубокая нейронная сеть становится основной моделью машинного обучения, популярные в настоящее время GPT, Llama и другие крупные модели построены на основе одной или нескольких глубоких нейронных сетей.

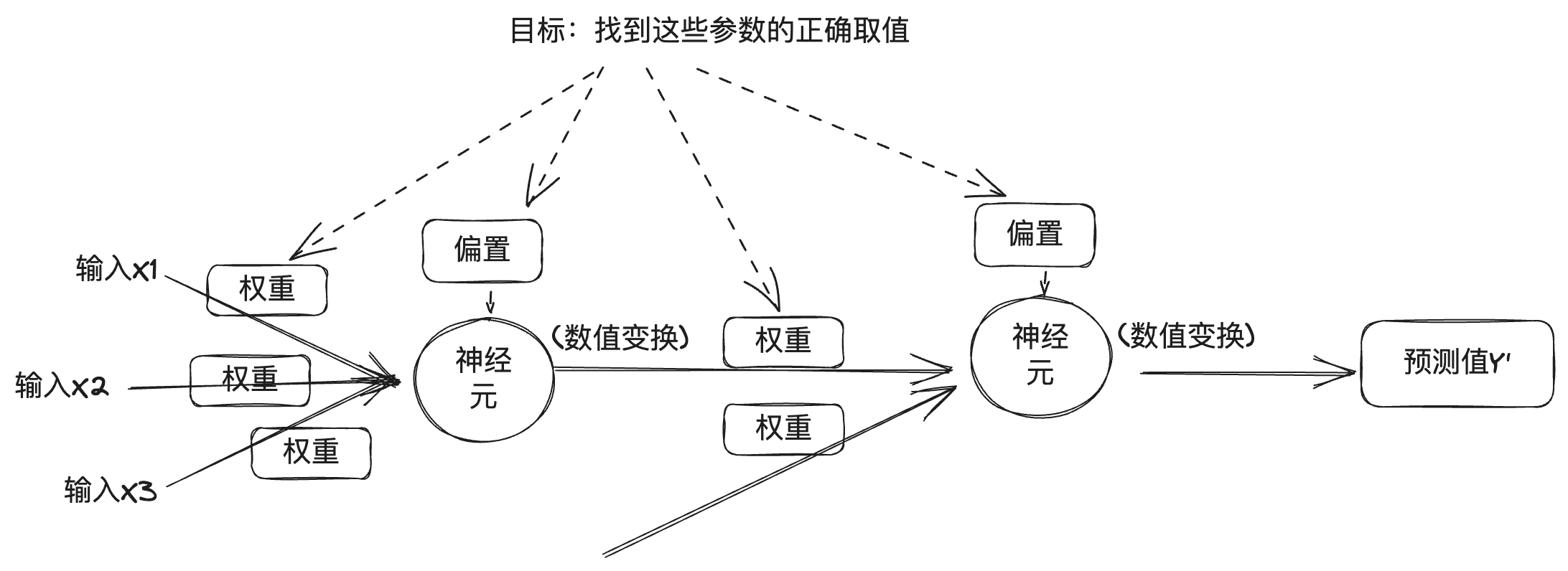

Для понимания глубоких нейронных сетей, вы можете обратиться к введению принципа перцептивной машины выше, глубокая нейронная сеть рассматривается как комбинация нескольких нейронов в нескольких слоях, из предыдущего раздела можно понять, каждый слой выход связан с весом, смещением и функцией активации, а для глубокой нейронной сети выход также связан с количеством слоев и другими числовыми значениями. В глубоких нейронных сетях эти значения можно разделить на две категории, одна из которых - количество слоев, функция активации, оптимизатор и т. д., известная как гиперпараметр, который задается инженером; другая - вес и смещение, известные как параметр, который автоматически получается в процессе обучения глубоких нейронных сетей, и поиск правильного параметра является целью глубокого обучения.

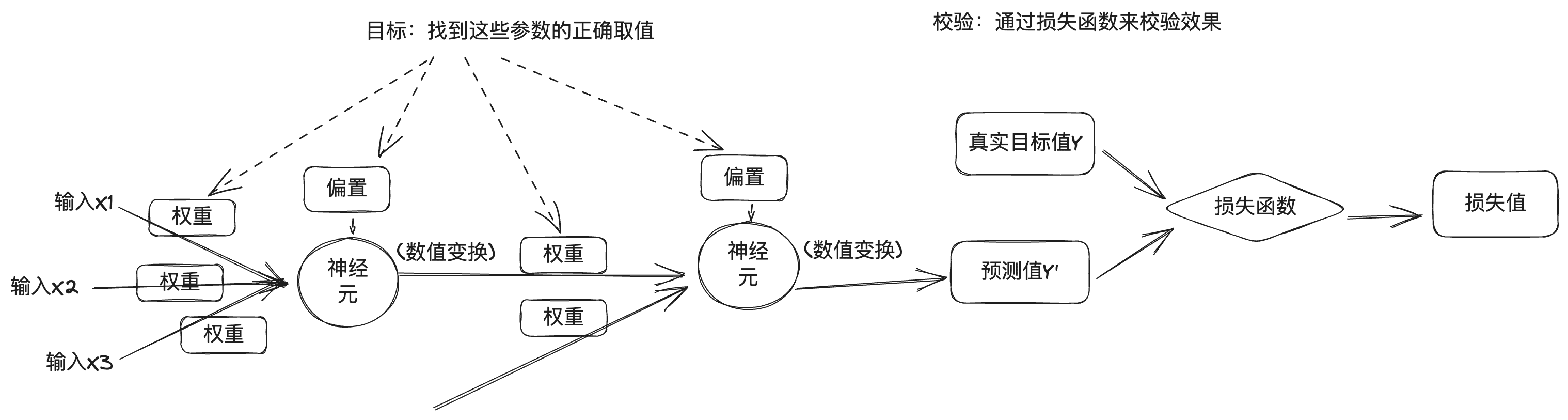

Но проблема в том, что глубокая нейронная сеть содержит огромное количество параметров, и изменение одного параметра влияет на поведение остальных, поэтому найти правильные значения для этих параметров - сложная задача. Чтобы найти правильные значения параметров и сделать вывод модели точным, нам нужен способ измерить разрыв между выводом модели и желаемым результатом. Поэтому при обучении глубокому обучению используется функция потерь, которая также известна как функция цели или функция затрат. Функция потерь показывает, насколько хороша или плоха модель нейронной сети на данной обучающей выборке, сравнивая предсказанное значение глубокой нейронной сети с истинным целевым значением, чтобы получить значение потерь.

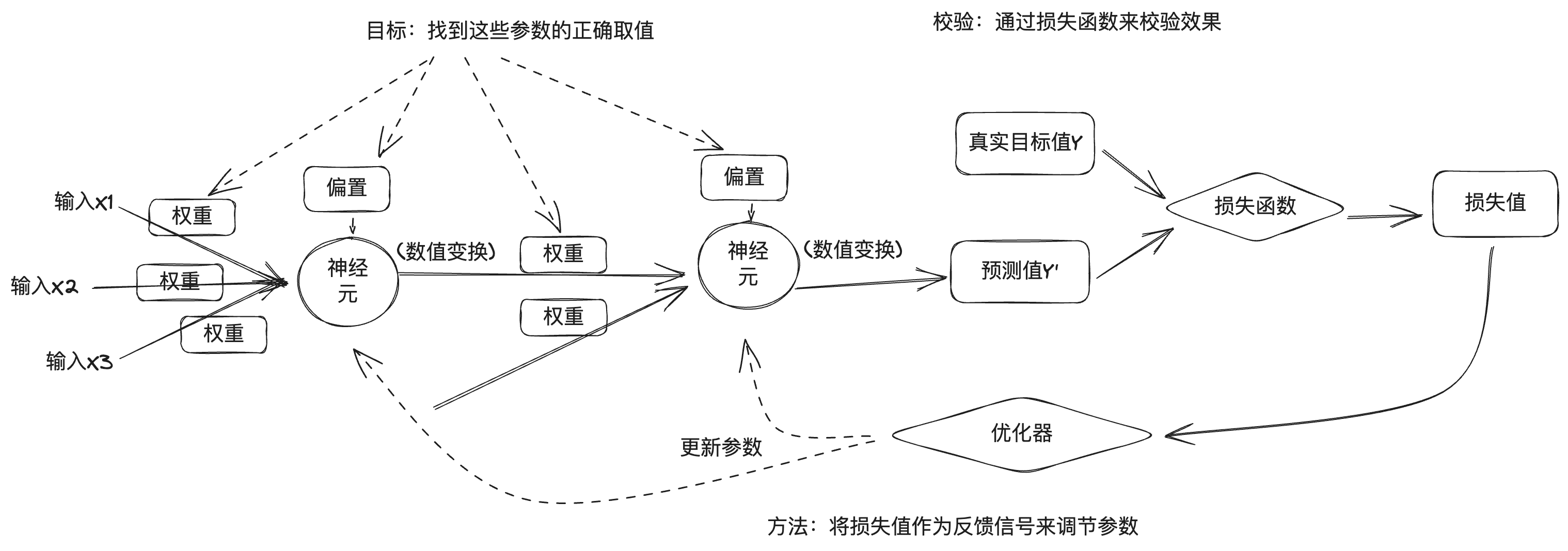

Подход глубокого обучения использует значения потерь в качестве сигналов обратной связи для точной настройки параметров, чтобы уменьшить значения потерь для текущей выборки обучения. Эта настройка осуществляется с помощью оптимизатора, который реализует алгоритмы оптимизации, такие как градиентный спуск, для обновления параметров узлов нейронов в каждом слое методом обратного распространения.

Вначале параметры нейронной сети назначаются случайным образом, вводится партия обучающих данных, и после получения прогнозируемого выхода сети через входной слой и скрытый слой к выходному слою вычисляется значение потерь в соответствии с функцией потерь, что представляет собой процесс прямого распространения; затем, начиная с выходного слоя, вычисляется градиент параметров в обратном направлении вдоль каждого слоя вплоть до входного слоя, и параметры сети обновляются с помощью алгоритма оптимизации на основе градиента, что представляет собой процесс обратного распространения. . При каждой партии обучающих образцов, обрабатываемых нейронной сетью, параметры подстраиваются в нужном направлении, а значения потерь уменьшаются, что и является циклом обучения. Достаточное количество циклов обучения позволяет получить параметры, минимизирующие функцию потерь, что приводит к созданию хорошей нейросетевой модели.

Конечно, на самом деле процесс глубокого обучения намного сложнее, чем это, поэтому здесь мы приведем лишь краткий обзор общего процесса.

В 2012 году Хинтон под руководством двух своих студентов, Алекса Крижевского и Ильи Суцкевера, разработал нейронную сеть AlexNet, которая участвовала в конкурсе по распознаванию изображений ImageNet и выиграла первенство, показав гораздо более высокую точность, чем занявший второе место. Затем Хинтон и его студенты основали компанию DNNResearch, Inc. для того, чтобы сосредоточиться на глубоких нейронных сетях. У компании не было ни продуктов, ни активов, но успех AlexNet привлек внимание нескольких интернет-гигантов. Зимой 2012 года на озере Тахо на границе США и Канады состоялся тайный аукцион: объектом торгов стала недавно основанная DNNResearch, а покупателями - Google, Microsoft, DeepMind и Baidu. В итоге, когда Google и Baidu еще только поднимали цену, Хинтон отменил аукцион и решил продать компанию Google за 44 миллиона долларов.В 2014 году Google прикарманила DeepMind.В 2016 году AlphaGo, использующая комбинацию классического поиска по дереву Монте-Карло и глубоких нейронных сетей, победила Ли Седоля, а в следующем году - игрока №1 в мировом рейтинге го Ке Цзе, и AlphaGo раздвинула границы искусственного интеллекта и глубокого обучения до нового уровня. искусственного интеллекта и глубокого обучения на новую высоту.

IV. Большие модели

В 2015 году Маск, технический директор Stripe Грег Брокман, руководители YC Ventures Сэм Альтман и Илья Суцкевер и другие встретились в отеле Resewood в Калифорнии, чтобы обсудить создание лаборатории искусственного интеллекта для противодействия контролю над технологиями искусственного интеллекта со стороны крупных интернет-компаний. Затем Грег Брокман привлек группу исследователей из Google, Microsoft и других компаний для создания новой лаборатории под названием OpenAI, где Грег Брокман, Сэм Альтман и Илья Суцкевер заняли должности председателя, генерального директора и главного ученого OpenAI соответственно.

Маск и Сэм Альтман изначально задумывали OpenAI как некоммерческую организацию, которая открыла бы технологии ИИ для всех желающих, чтобы противостоять опасности, которую представляет собой контроль над технологиями ИИ со стороны крупных интернет-компаний. Поскольку технология глубокого обучения ИИ переживала взрывной рост, никто не мог предсказать, будет ли она представлять угрозу для человечества в будущем, и открытость могла бы стать лучшим способом противостоять этому. И вот в 2019 году OpenAI решила создать прибыльную дочернюю компанию, чтобы финансировать развитие своих технологий, и закрыла исходный код своей основной технологии, которая была уже потом.

В 2017 году инженеры Google опубликовали работу под названием "Внимание - это все, что вам нужно", в которой предлагалось, что Трансформатор Архитектура нейронных сетей, для которой характерно внедрение в нейронные сети механизмов человеческого внимания. Упомянутое ранее распознавание изображений является одним из сценариев глубокого обучения, когда данные изображения представляют собой дискретные данные без корреляции между ними. В реальной жизни существует другой сценарий, который заключается в работе с временными данными, например с текстом, контекст которого связан, также как и голос, видео и т. д., являются временными данными. Эти упорядоченные во времени данные называются последовательностью (sequence), а реальная задача часто представляет собой преобразование последовательности в другую последовательность, например, перевод абзаца китайского языка в абзац английского, а также робот Q&A, превращающий абзац вопроса в абзац интеллектуально сгенерированных ответов, и поэтому используется преобразователь (Transformer), откуда и пошло название Transformer. Вот откуда происходит название Transformer. Как уже говорилось, возбуждение нейрона определяется взвешенной суммой входных данных, с которыми он связан, а вес представляет собой силу связи. В случае с данными временных рядов вес каждого элемента разный, что соответствует нашему повседневному опыту, например, посмотрите на следующий отрывок:

Исследования показали, что порядок китайских иероглифов не всегда влияет на чтение, например, когда вы заканчиваете читать это предложение, вы обнаруживаете, что все иероглифы в нем перепутаны.

Это справедливо не только для китайских иероглифов, но и для других человеческих языков, таких как английский. Это происходит потому, что наш мозг автоматически оценивает вес слов в предложении, в избыточной информации, чтобы поймать фокус, это и есть внимание.Инженеры Google внедрили механизм внимания в нейросетевую модель, используемую в обработке естественного языка, чтобы машина могла "понимать" намерения человеческого языка. Впоследствии, в 2018 году, OpenAI выпустила GPT-1 на базе архитектуры Transformer, GPT-2 в 2019 году, GPT-3 в 2020 году, а в конце 2022 года - программу ChatGPT AI Q&A на базе GPT-3.5, которая шокирует своими диалоговыми способностями, а ИИ сделал большой шаг вперед в направлении AGI.

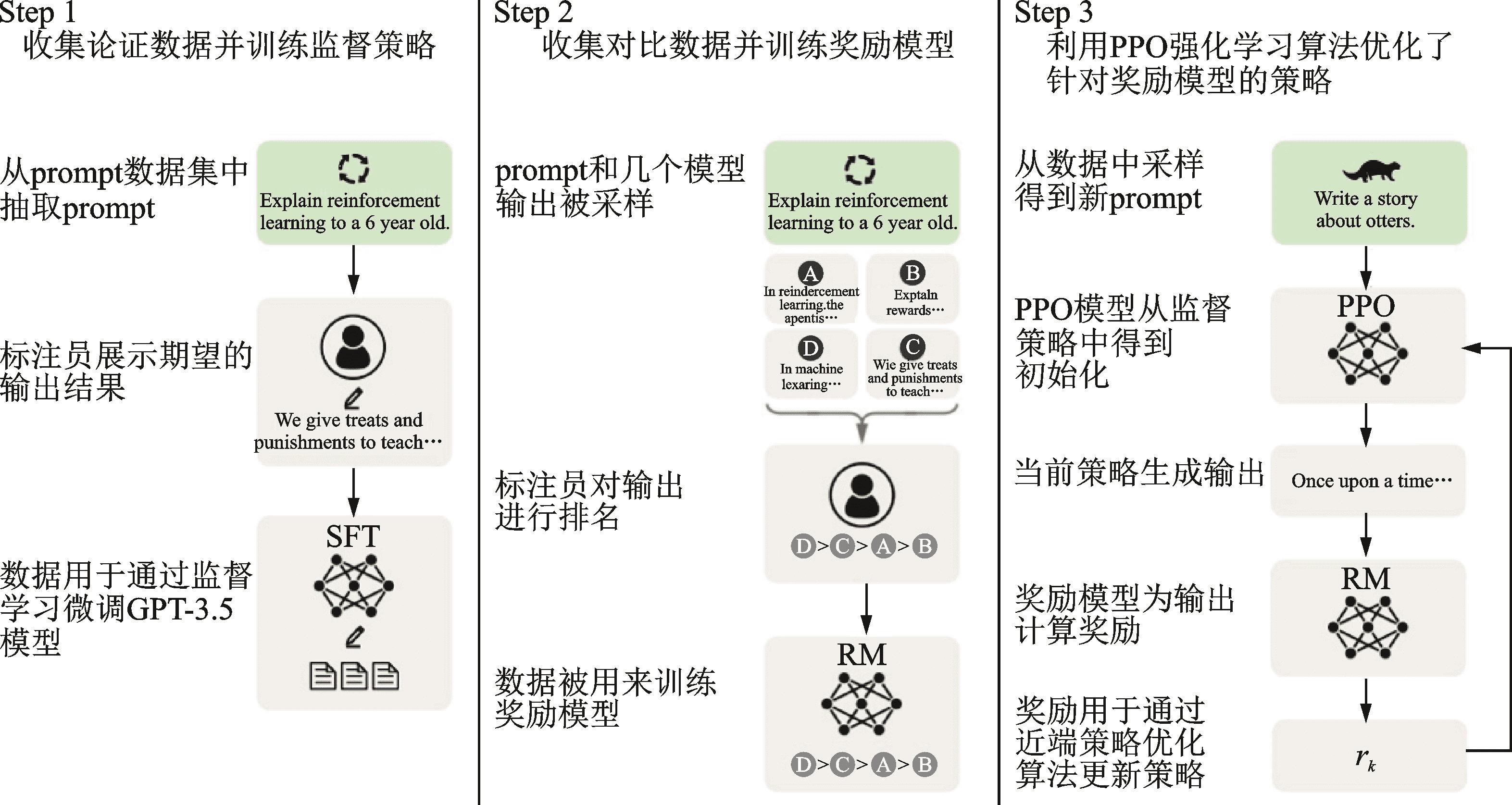

Полное название GPT - Generative Pre-trained Transformer, Generative означает способность генерировать новый контент, Transformer - инфраструктуру, а Pre-trained в середине указывает на то, что метод обучения - предварительное обучение. Почему он называется предварительно обученным? Потому что, начиная с AlexNet, люди стали использовать больше данных и больше параметров в обучении нейронных сетей, чтобы достичь лучших результатов, а это означает, что обучение становится более ресурсоемким и трудоемким. Такие затраты немного высоки для обучения специфическим задачам, и они немного расточительны, поскольку не могут быть использованы совместно с другими нейронными сетями. Поэтому в индустрии стали применять подход "предварительное обучение + тонкая настройка" для обучения нейросетевых моделей, то есть сначала завершить обучение общей большой модели на большом наборе данных, а затем завершить тонкую настройку модели на меньшем наборе данных для конкретных сценариев задач. В ChatGPT используется обучение с подкреплением на основе человеческой обратной связи (RLHF), которое является методом обучения нейросетевых моделей. ChatGPT использует обучение с подкреплением на основе обратной связи с человеком (RLHF) для предварительного обучения и тонкой настройки, которая делится на три этапа: первый этап - предварительное обучение языковой модели (LM); второй этап - сбор данных Q&A и обучение модели вознаграждения (RM); и третий этап - тонкая настройка языковой модели (LM) с помощью обучения с подкреплением (RL). Эта модель вознаграждения содержит обратную связь от человека, поэтому процесс обучения называется RLHF.

Пользователей впечатляет возможность многократного диалога, а также его точность при использовании ChatGPT. В соответствии с основами нейронных сетей, мы видим, что каждый процесс вывода происходит от входа через взвешивание и активацию каждого нейрона к выходу, и нет никакой способности к запоминанию. Причина, по которой ChatGPT хорошо работает с многораундовым диалогом, заключается в том, что он использует технологию Prompt Engineering в управлении диалогом.

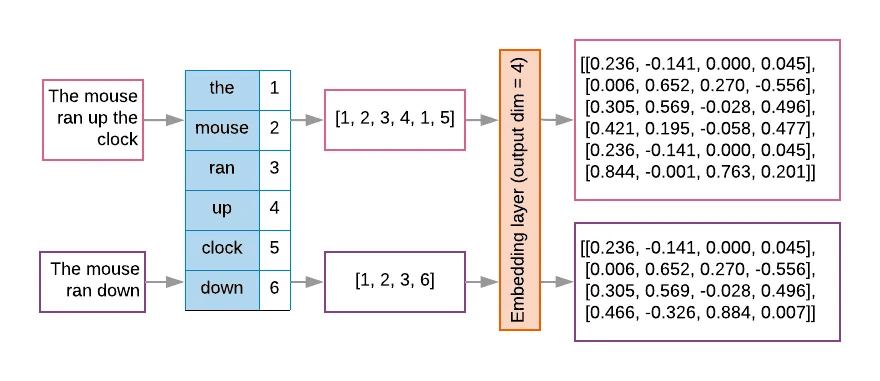

Для больших языковых моделей, таких как ChatGPT, на вход подается токен после преобразования строки текста, и большие модели обычно проектируют фиксированное контекстное окно, чтобы ограничить количество входных токенов из-за вычислительной эффективности и ограничений памяти. Текст сначала подразделяется токенизатором и нумеруется таблицей поиска, а затем встраивается в матрицу в вектор в пространстве высокой размерности, что представляет собой процесс векторизации текста, как показано на следующем рисунке.

Из-за ограничений по количеству лексем приходится использовать технику Prompt Engineering, чтобы сообщить крупной модели более полную информацию в ограниченном контекстном окне. Инженерия подсказок использует ряд стратегий для оптимизации входных данных модели, чтобы она выдавала результаты, которые лучше соответствуют ожиданиям.

За успехом ChatGPT стоит техническая эволюция большой модели, представленной GPT. OpenAI верит, что энергичные усилия приводят к чудесам, и постоянно расширяет параметры GPT: параметры модели GPT-1 составляют 117 миллионов, GPT-2 - 1,5 миллиарда, GPT-3 - 175 миллиардов, а GPT-4 - якобы 1,8 триллиона. Больше параметров модели означает больше вычислительных мощностей для поддержки обучения, поэтому OpenAI обобщила "Закон масштабирования", который гласит, что производительность модели зависит от размера модели, объема данных и вычислительных ресурсов, проще говоря, чем больше модель, чем больше объем данных и чем больше вычислительных ресурсов, тем выше производительность модели. Рич Саттон, отец обучения с подкреплением, выразил аналогичную точку зрения в своей статье "Горький урок" (the Bitter Lesson), рассматривая развитие искусственного интеллекта в последние десятилетия, он пришел к выводу, что в краткосрочной перспективе люди всегда пытаются улучшить производительность интеллектуального тела путем построения знаний, но в долгосрочной перспективе мощная арифметическая сила является королем.

Способность больших моделей также перешла от количественных к качественным изменениям, главный ученый Google Джефф Дин назвал это "эмерджентными способностями" (Emergent abilities) больших моделей. Рынок видит эту возможность, с одной стороны, основные поставщики больших моделей инвестируют в гонку вооружений, с другой стороны, большие модели с открытым исходным кодом также находятся в полном разгаре.

V Обнимающееся лицо

В 2016 году французы Клеман Деланж, Жюльен Шомон и Томас Вольф основали компанию Hugging Face, логотипом которой стал значок эмодзи. Hugging Face начала с разработки интеллектуальных чат-ботов для молодежи, затем разработала несколько инструментов для обучения моделей и выложила их в открытый доступ в процессе обучения моделей. Позже они разработали несколько инструментов для обучения моделей и выложили их в открытый доступ, а позже даже сместили акцент на последнее - такой, казалось бы, "непрофессиональный" подход привел их на новый путь и к незаменимой роли в области глубокого обучения.

В Кремниевой долине есть множество компаний, которые занимаются побочным бизнесом, чтобы добиваться успехов, например Slack изначально разрабатывал игры, команда компании распределена по многим местам, в процессе работы разрабатывается средство коммуникации, в результате чего происходит случайный пожар, то есть Slack. и очередь Hugging Face тоже похожа, но также для того, чтобы решить свои собственные болевые точки, в 2018 году Google выпустила большую модель BERT, и Hugging Face Face использовали знакомый фреймворк Pytorch для реализации BERT, назвали модель pytorch-pretrained-bert и выложили ее в открытый доступ на GitHub. позже с помощью сообщества была представлена группа моделей, таких как GPT, GPT-2, Transformer-XL и так далее, а проект был переименован в В области глубокого обучения идет конкуренция между двумя фреймворками Pytorch и TensorFlow, и исследователи часто переключаются между ними, чтобы сравнить преимущества и недостатки двух фреймворков, поэтому в проект с открытым исходным кодом была добавлена функция переключения между двумя фреймворками, и название проекта также было изменено на Transformers. Transformers также стал самым быстрорастущим проектом на GitHub.

Hugging Face продолжает разрабатывать и выкладывать в открытый доступ ряд других инструментов машинного обучения: Datasets, Tokenizer, Diffusers ...... Эти инструменты также стандартизируют процесс разработки ИИ. До появления Hugging Face можно сказать, что в разработке ИИ доминировали исследователи. До появления Hugging Face можно сказать, что в разработке ИИ доминировали исследователи без стандартизированного инженерного подхода. Hugging Face предоставляет всеобъемлющий набор инструментов ИИ и устанавливает набор стандартов де-факто, что также позволяет большему числу разработчиков ИИ и даже практиков, не связанных с ИИ, быстро приступить к работе и обучать модели.

Затем компания Hugging Face запустила Hugging Face Hub для размещения моделей, наборов данных и приложений ИИ на основе технологий Git и Git LFS, и на данный момент на платформе размещено 350 000 моделей, 75 000 наборов данных и 150 000 примеров приложений ИИ. Работа по размещению и открытому доступу к моделям и наборам данных, а также по созданию глобального центра репозиториев с открытым исходным кодом является инновационной и далеко идущей. В то время как упомянутый выше подход "предварительное обучение + тонкая настройка" облегчает обмен ресурсами для обучения нейронных сетей, Hugging Face Hub идет на шаг дальше, позволяя разработчикам ИИ легко использовать самые современные мировые результаты и дополнять их, делая демократизацию ИИ возможной для всех, кто может использовать ИИ и развивать его. GitHub, или, как гласит их слоган: создание сообщества ИИ будущего. Ранее я уже писал две статьи, одна изФиксация кода, изменившая мирЗнакомство с Git'ом, статья вПуть от нуля до 10 миллиардов долларовПредставляя GitHub и Git, GitHub, Hugging Face, я думаю, что между ними есть некое наследие, наследие хакинга, который меняет мир, чтобы построить будущее, и это одна из вещей, которая побудила меня написать этот пост.

VI. Послесловие

Когда я уже подходил к концу работы над этой статьей, я посмотрел доклад, который Хинтон недавно прочитал в Оксфордском университете. В ней Хинтон представил две основные школы мысли в области искусственного интеллекта: одну он назвал логическим подходом, или символизмом, а другую - биологическим подходом, или нейросетевым коннекционизмом, который моделирует работу человеческого мозга. И биологический подход оказался явным победителем над логическим. Нейронные сети - это модели, созданные для имитации понимания человеческого мозга, и большие модели работают и понимают, как мозг. Хинтон считает, что искусственный интеллект, превосходящий человеческий мозг, появится в будущем, причем гораздо раньше, чем мы прогнозируем.

Приложение 1 Хронология событий

В 1943 году Маккаллох и Питтс опубликовали "Модель нейронов М-П", которая использовала математическую логику для объяснения и моделирования вычислительных единиц человеческого мозга, и ввели понятие нейронных сетей.

Термин "искусственный интеллект" был впервые предложен на Дартмутской конференции в 1956 году.

В 1957 году Розенблатт предложил модель "перцептрона", а два года спустя ему удалось создать Mark-1, аппаратный перцептрон, способный распознавать английский алфавит.

В 1969 году Минский опубликовал книгу "Перцептивные машины", и указанные в ней недостатки перцептивных машин нанесли сильный удар по исследованиям перцептивных машин и даже нейронных сетей.

В 1983 году Хинтон изобрел машину Больцмана.

В 1986 году Хинтон изобрел алгоритм обратного распространения ошибки.

В 1989 году Ян ЛеКун изобрел конволюционную нейронную сеть (CNN).

В 2006 году Хинтон предложил сеть глубокого убеждения, положив начало эре глубокого обучения.

Глубокое обучение было серьезно воспринято индустрией в 2012 году, когда Хинтон и два его студента разработали AlexNet, который одержал убедительную победу в конкурсе ImageNet.

В 2015 году компания DeepMind, приобретенная Google, запустила AlphaGo, который победил Ли Седоля в 2016 году и Ке Цзе в 2017-м. Была основана компания OpenAI.

Компания Hugging Face была основана в 2016 году.

В 2017 году компания Google опубликовала документ о модели трансформера.

В 2018 году OpenAI выпустила GPT-1, основанный на архитектуре Transformer. Hugging Face выпустила проект Transformers.

В 2019 году OpenAI выпускает GPT-2.

В 2020 году OpenAI выпускает GPT-3. Hugging Face запускает Hugging Face Hub.

В 2022 году OpenAI выпускает ChatGPT.

Приложение 2 Ссылки

Книги:

Границы интеллекта: от машин Тьюринга до искусственного интеллекта Чжоу Чжимин (Автор) Издательство Механическая промышленность Октябрь 2018 г.

Революция в глубоком обучении Кейд Метц Шугуан Ду CITIC Press Январь 2023 г.

Deep Learning in Python (2nd Edition) Francois Chollet (Author) Liang Zhang (Translator) People's Posts and Telecommunications Publishing House August 2022

Введение в глубокое обучение: теория и реализация на основе Python Ясуи Сайто (Автор) Юйцзе Лу (Переводчик) Издательство "Народная почта и телекоммуникации" 2018 г.

Deep Learning Advanced: Natural Language Processing by Yasuyoshi Saito (Author) Yujie Lu (Translator) People's Posts and Telecommunications Publishing House October 2020

Это ChatGPT Стивен Вольфрам (Автор) WOLFRAM Media Chinese Group (Переводчик) Издательство "Народная почта и телекоммуникации" Июль 2023 г.

Генеративный искусственный интеллект Дин Лэй (Автор) CITIC Press Май 2023 г.

Huggingface Natural Language Processing Explained by Li Fulin (Author) Tsinghua University Press April 2023

Статья:

Введение в нейронные сети Ифенг Нгуен

2012 год, 180 дней, которые изменили судьбу человечества" Исследовательский институт Энкава

Эволюция семейства GPT MetaPost

Трансформер - внимание - это все, что вам нужно".

Разработка предварительно обученных языковых моделей.

Руководство по оперативному проектированию

ChatGPT за "кредитом" - технология RLHF подробное объяснение.

Разработка и применение методов моделирования крупных объектов ChatGPT.

Горький урок", Рич Саттон.

Интервью с техническим директором HuggingFace: подъем открытого кода, истории стартапов и демократизация ИИ".

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...