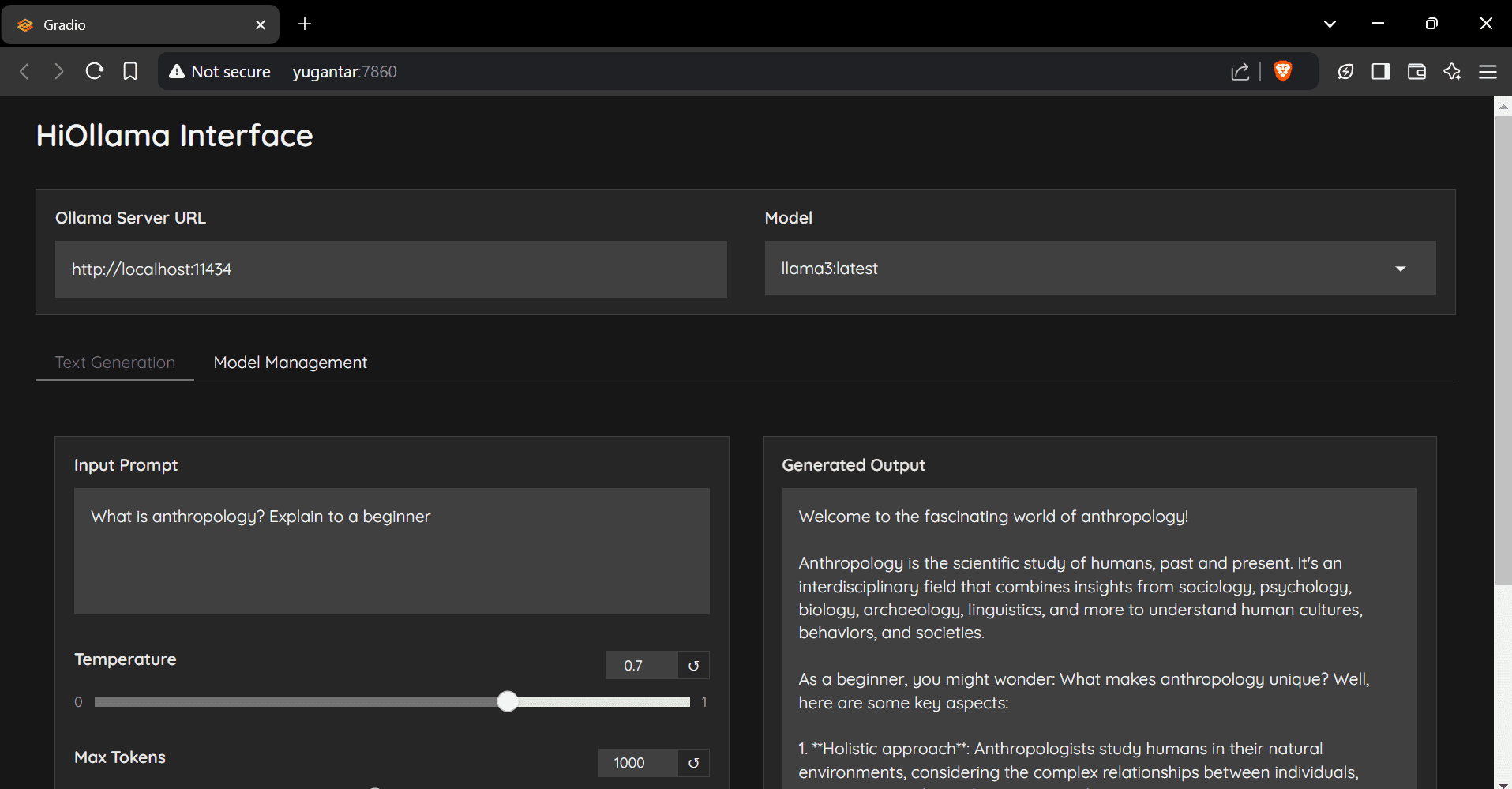

HiOllama: чистый чат-интерфейс для взаимодействия с нативными моделями Ollama

Общее введение

HiOllama - это удобный интерфейс, построенный на Python и Gradio и предназначенный для взаимодействия с моделями Ollama. Он предоставляет простой и интуитивно понятный веб-интерфейс, поддерживающий функции генерации текста в реальном времени и управления моделями. Пользователи могут настраивать такие параметры, как температура и максимальное количество маркеров, а также управлять несколькими моделями Ollama и настраивать URL-адреса сервера.

РЕКОМЕНДАЦИЯ: Оллама против Откройте WebUI Интеграция более дружественна, но затраты на развертывание несколько выше.

Список функций

- Простой и интуитивно понятный веб-интерфейс

- Генерация текста в режиме реального времени

- Настраиваемые параметры (температура, максимальное количество жетонов)

- Функции управления моделями

- Поддержка нескольких моделей Ollama

- Пользовательская настройка URL-адреса сервера

Использование помощи

Этапы установки

- Хранилище клонирования:

git clone https://github.com/smaranjitghose/HiOllama.git cd HiOllama - Создайте и активируйте виртуальную среду:

- Окна.

python -m venv env .\env\Scripts\activate - Linux/Mac.

python3 -m venv env source env/bin/activate

- Окна.

- Установите необходимые пакеты:

pip install -r requirements.txt - Установите Ollama (если она еще не установлена):

- Linux/Mac.

curl -fsSL https://ollama.ai/install.sh | sh - Окна.

Сначала установите WSL2, а затем выполните приведенную выше команду.

- Linux/Mac.

Этапы использования

- Запустите службу Ollama:

ollama serve - Беги, ХиОллама:

python main.py - Откройте браузер и перейдите на сайт:

http://localhost:7860

Краткое руководство пользователя

- Выберите модель из выпадающего меню.

- Введите подсказку в текстовой области.

- При необходимости отрегулируйте температуру и максимальное количество жетонов.

- Нажмите "Сгенерировать", чтобы получить ответ.

- Используйте опцию "Управление моделями", чтобы добавлять новые модели.

настроить

Настройки по умолчанию можно задать вmain.pyИзменено в:

DEFAULT_OLLAMA_URL = "http://localhost:11434"

DEFAULT_MODEL_NAME = "llama3"

общие проблемы

- ошибка подключения: Убедитесь, что Ollama запущена (

ollama serve), проверьте правильность URL-адреса сервера и убедитесь, что порт 11434 доступен. - Модель не найдена: Сначала вытащите модель:

ollama pull model_nameПроверьте доступные модели:ollama list. - портовый конфликт: в

main.pyИзмените порт вapp.launch(server_port=7860) # 更改为其他端口

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...