Как GRPO превосходит o1, o3-mini и R1 в игре "Загадка времени".

В последние годы искусственный интеллект добился значительного прогресса в развитии своих способностей к рассуждениям. После того как в прошлом году OpenAI продемонстрировал мощный потенциал больших языковых моделей (LLM) в области умозаключений, Google DeepMind, Alibaba, DeepSeek и Антропология Такие организации, как Калифорнийский университет в Беркли, быстро последовали этому примеру, используя методы обучения с подкреплением (RL) для обучения продвинутых моделей с возможностями "цепочки мыслей" (CoT). Эти модели достигли результатов, близких к насыщению, во многих эталонных тестах в таких областях, как математика и программирование.

Однако нельзя игнорировать тот факт, что даже самые лучшие из существующих на сегодняшний день моделей сталкиваются с непреодолимыми препятствиями при решении задач логического мышления. Большие языковые модели часто не в состоянии поддерживать последовательную цепочку логических рассуждений с постоянным вниманием ко всем важным деталям или надежно соединять несколько шагов рассуждения. Даже самые современные модели, которые генерируют контент, в 10-100 раз превышающий объем обычных моделей, часто допускают низкоуровневые ошибки, которые легко обнаруживаются человеком, решающим задачу.

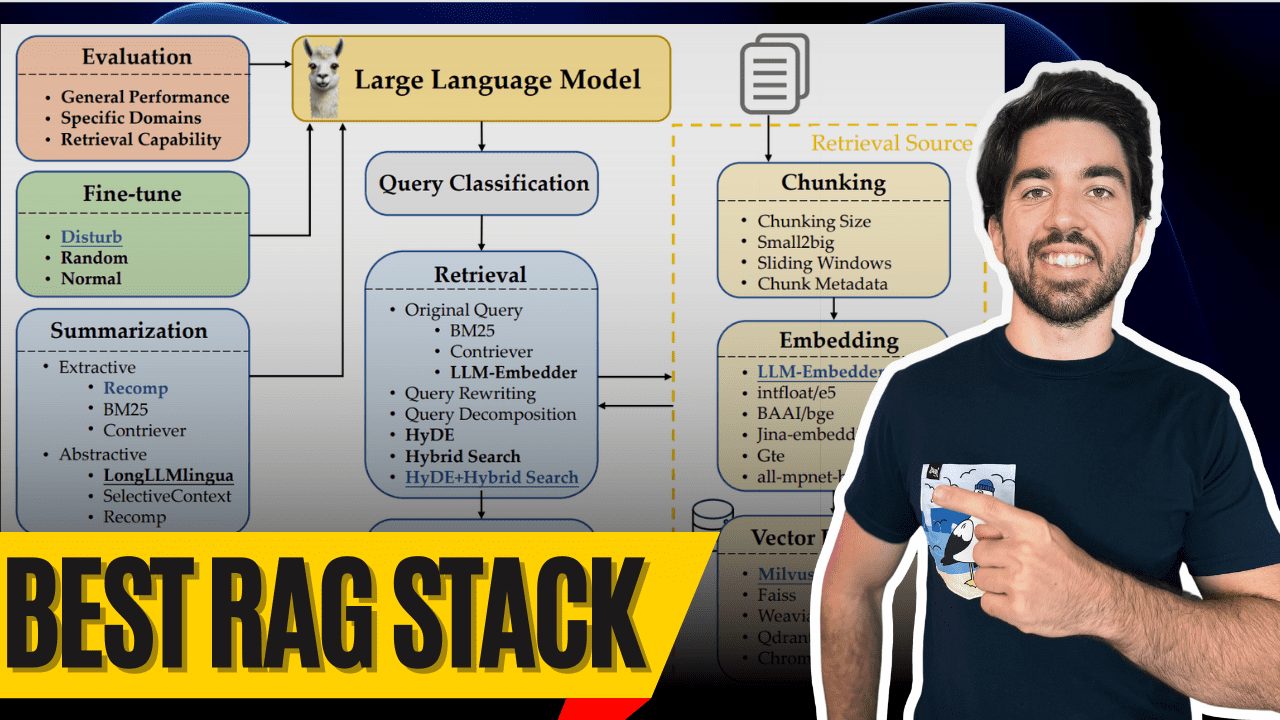

Чтобы изучить этот вопрос, Брэд Хилтон и Кайл Корбитт, авторы этой статьи, задумались: можно ли использовать новейшие методы обучения с подкреплением, чтобы вывести небольшие модели с открытым исходным кодом на передовые позиции по производительности вычислений? Чтобы ответить на этот вопрос, они выбрали технику под названием Оптимизация групповой относительной политики (GRPO) алгоритмов обучения с подкреплением.

Что такое GRPO?

Проще говоря, GRPO - это метод оптимизации градиентов стратегии. Градиентные методы улучшают производительность модели, корректируя ее политику (т. е. вероятностное распределение действий модели в данной ситуации). GRPO обновляет политику более эффективно, сравнивая относительные достоинства набора ответов модели. По сравнению с традиционными методами, такими как оптимизация проксимальной политики (PPO), GRPO упрощает процесс обучения, гарантируя при этом отличную производительность.

Чтобы убедиться в действенности GRPO, они выбрали программу под названием "Временная подсказка"Разумные игры как экспериментальные платформы".

Что такое Time Clue?

"Time Clue" - это головоломка, созданная по мотивам классической настольной игры "Clue (Cluedo)". В этой игре игроку предстоит найти серию подсказок, чтобы выяснить убийцу, орудие убийства, место, время убийства и мотив. В отличие от оригинальной игры, в "Time Clue" задача расширяется до пяти измерений, что повышает сложность и трудность игры.

Авторы начали с относительно слабых моделей и итеративно обучали их на игре "Time Clue" с помощью алгоритма GRPO. Со временем они наблюдали значительное улучшение способности этих моделей к рассуждениям, в итоге они сравнялись или даже превзошли некоторые из самых мощных собственных моделей.

Теперь они будут делиться информацией, которая включает в себятест, иПрограммы обучения, инабор данных ответить пениемвес модели исследования, все из которых свободно доступны под лицензией MIT.

бенчмаркинг

Для того чтобы провести эксперимент, сначала необходимо определить сложную задачу на рассуждение, которая имеет четко проверяемое решение и масштабируемую сложность. По совпадению, один из авторов, Брэд Хилтон, ранее создал проект под названием Временная подсказка набор головоломок, который полностью отвечает этим требованиям. Помимо соответствия критериям базовой фактологической ясности, при необходимости можно создавать новые головоломки.

Temporal Clue вдохновлена популярной настольной игрой Разгадка (Cluedo)Temporal Clue В этой игре игроки пытаются выяснить, кто убил мистера Бодди в особняке Тюдоров. Temporal Clue превращает эту игру в самостоятельную логическую головоломку, которая выходит за рамки стандартногокто, ис чем?, игде, и добавили два дополнительных измерения:Когда?(время) ипо какой причине?(Мотивация). Головоломки генерируются случайным образом, а минимальные, но достаточные подсказки используются для того, чтобы OR-Tools (используется в форме номинального выражения) Решатель CP-SAT Избранные.

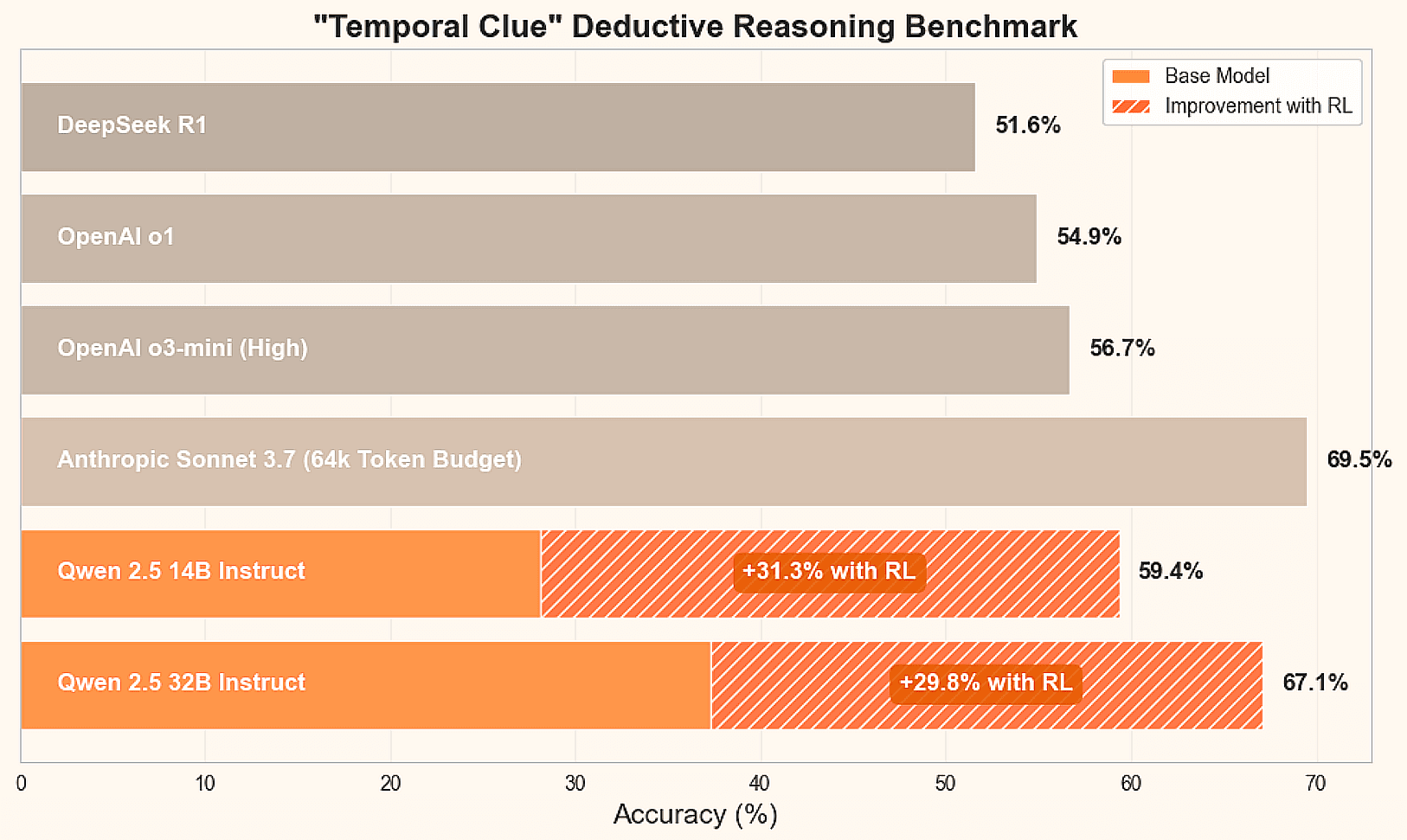

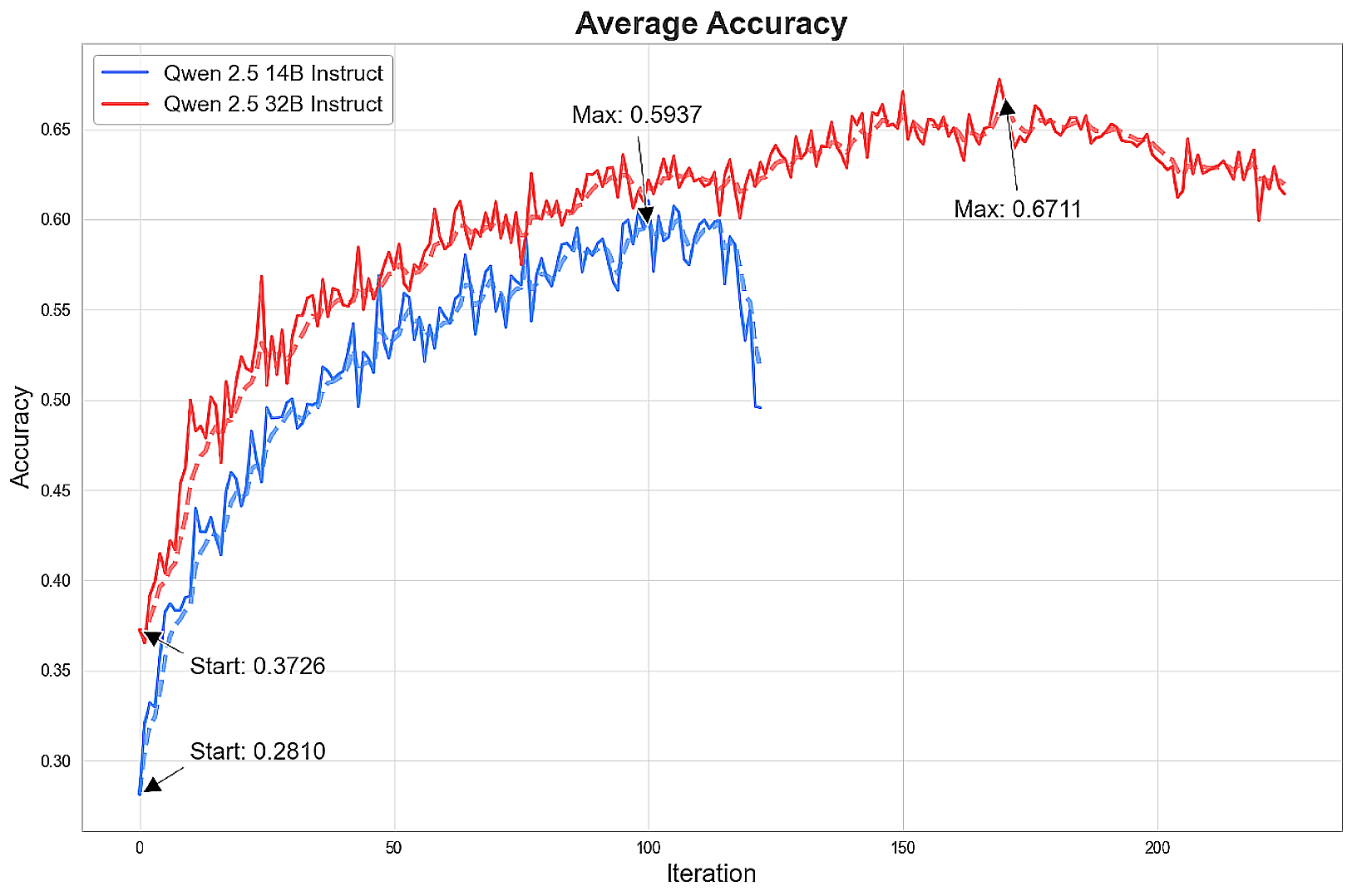

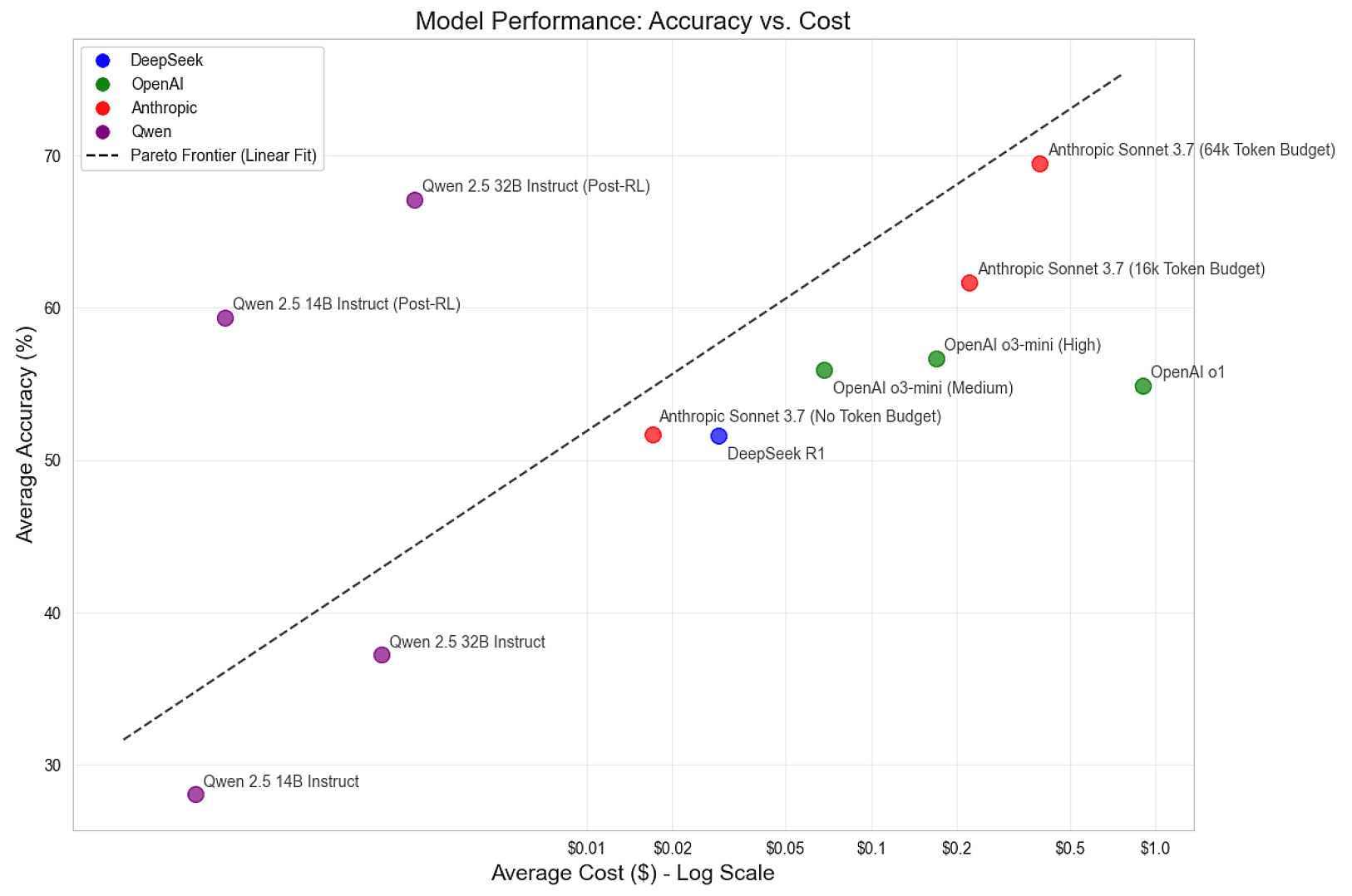

Чтобы определить текущее состояние дел в решении этой задачи вывода, они провели сравнительный анализ ведущих моделей вывода, включая DeepSeek R1, Антропный Клод Sonnet 3.7, а также модели Qwen 2.5 14B и 32B Instruct от Alibaba. Кроме того, они предоставляют предварительный обзор окончательных результатов:

| механизм | моделирование | способность к рассуждению | Средняя точность | средняя стоимость |

|---|---|---|---|---|

| DeepSeek | R1 | по умолчанию (настройка) | 51.6% | $0.029 |

| Антропология | Сонет 3.7 | не иметь | 51.7% | $0.017 |

| Антропология | Сонет 3.7 | 16k | 61.7% | $0.222 |

| Антропология | Сонет 3.7 | 64k | 69.5% | $0.392 |

| Али-Баба, персонаж из "Арабских ночей | Qwen 2.5 14B Инструкция | не иметь | 28.1% | $0.001 |

| Али-Баба, персонаж из "Арабских ночей | Qwen 2.5 32B Инструкция | не иметь | 37.3% | $0.002 |

Из этих бенчмарков видно, что наличие 64k жетон Модель Claude Sonnet 3.7 от Anthropic оказалась лучшей в этой задаче, но всем ведущим моделям есть куда расти. DeepSeek R1, популярная модель с открытым исходным кодом, показала точность, близкую к средней точности модели Claude Sonnet 3.7 от Anthropic - 51,7%. Однако производительность ненастроенной модели Qwen 2.5 Instruct относительно низка. Возникает вопрос: можно ли обучить эти небольшие модели с открытым исходным кодом до передовых уровней?

поезд

Для обучения передовой модели вывода они использовали обучение с подкреплением - метод, который позволяет интеллектам учиться на собственном опыте в контролируемой среде. В данном случае LLM - это интеллект, а головоломки - среда. Они направляли обучение LLM, заставляя их генерировать несколько ответов на каждую головоломку, чтобы изучить ландшафт проблемы. Они подкрепляют рассуждения, которые приводят к правильному решению, и наказывают рассуждения, которые сбивают модель с пути.

Среди различных методов RL они выбрали популярный алгоритм Group Relative Policy Optimisation (GRPO), разработанный компанией DeepSeek. По сравнению с более традиционными методами, такими как оптимизация проксимальной политики (PPO), GRPO упрощает процесс обучения и при этом обеспечивает высокую производительность. Чтобы ускорить эксперименты, они опустили Дисперсия Куллбэка-Лейблера (KL) наказание, несмотря на то, что программа их обучения поддерживает это.

В целом, цикл обучения состоит из следующих основных этапов:

- Генерирование модельных ответов на задачи-головоломки.

- Оцените ответы и оцените преимущество завершения чата для каждой группы (это "Групповая относительная" часть GRPO).

- Модель настраивается с помощью градиента стратегий адаптации, руководствуясь этими оценками доминирования.

- Повторяйте эти шаги с новыми пазлами и последней версией модели до тех пор, пока не будет достигнута оптимальная производительность.

Чтобы сгенерировать ответ, они используют популярный vLLM Механизм вывода. Они настроили выбор параметров так, чтобы максимизировать пропускную способность и минимизировать время запуска. Кэширование префиксов особенно важно, поскольку для каждой задачи выбирается множество ответов, а кэширование подсказок помогает избежать лишних вычислений.

Они заметили, что слишком большое количество запросов может привести к тому, что vLLM перегружены, что приводит к преобладанию или замене текущих запросов. Чтобы решить эту проблему, они ограничивают запросы с помощью семафора, который настроен на поддержание высокого уровня использования кэша ключевых значений (KV) при минимизации замены. Более совершенные механизмы планирования могут обеспечить более высокий уровень использования, поддерживая при этом гибкую длину генерации.

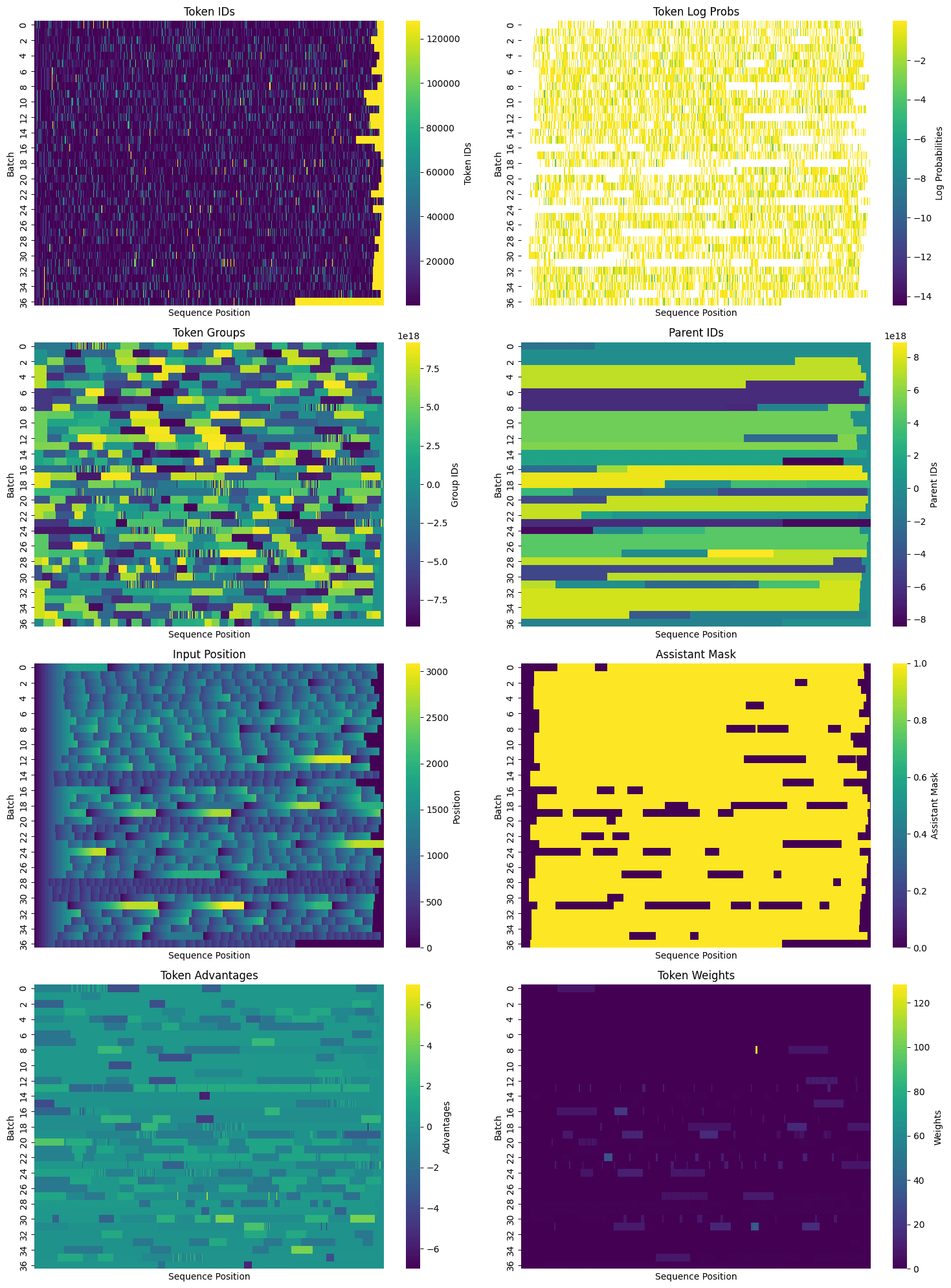

После отбора проб стандартный Трансформеры с обнимающимися лицами AutoTokenizer Обработка завершена. Шаблон чата представляет объект сообщения в виде строки подсказки, которая включает вспомогательную маску для определения того, какие маркеры были сгенерированы LLM. в них нет того, что необходимо в шаблоне по умолчанию. %generation% метки, поэтому они изменяются на этапе маркировки. Сгенерированные вспомогательные маски включаются в словарь тензоров, используемый для настройки, и используются для определения позиций, необходимых для вычисления потерь.

После сортировки ответов и получения масок помощников они упаковали данные для настройки. Помимо включения нескольких пар подсказка/ответ в каждую упакованную последовательность, они определили общие маркеры-подсказки и присвоили каждому маркеру идентификатор родителя, а также стандартный идентификатор группы. Особенно для таких задач, как Temporal Clue (в среднем более 1 000 маркеров на головоломку), создание большого количества ответов для каждой задачи и эффективная упаковка тензора может значительно уменьшить избыточность. После того как вся необходимая информация собрана, обучающий набор данных можно представить в двухмерном виде, где каждая строка представляет собой последовательность жетонов, которые могут содержать несколько подсказок и завершений:

Когда данные плотно упакованы, наступает время настройки. Модели были предварительно обучены, настроены по инструкции, достаточно интеллектуальны и хорошо выполняют инструкции. Однако они пока не могут надежно решить головоломку Temporal Clue. Однако иногда им это удается, и этого достаточно. Постепенно модель переводится в состояние "ищейки" путем увеличения вероятности хороших рассуждений и уменьшения вероятности плохих рассуждений. Это достигается с помощью стандартных методов машинного обучения, использующих градиентный подход для подсчета потерь и благоприятного смещения весов.

Для обучения команда PyTorch предоставила торхтун Torchtune имеет высокоэффективный декодер только трансформатор Реализации популярных моделей, включая Llama, Gemma, Phi и другие. Хотя в этом проекте в основном использовалась модель Qwen, они также экспериментировали с моделями Llama 8B и 70B от Meta.Torchtune также предоставляет утилиты для экономии памяти и повышения производительности, включая:

- Активировать контрольные точки

- Активировать деинсталляцию

- количественная оценка

- Эффективная точная настройка параметров (PEFT)Например Адаптивный низкий ранг (LoRA)

Полный список поддерживаемых оптимизаций см. в разделеДокумент с пояснениями здесь.

Кроме того, Torchtune поддерживает работу с несколькими устройствами (и теперьмногоузловой) обучения, что делает его идеальным для больших моделей. Он поддерживает параллельное обучение с полным срезом данных (FSDP) и параллельное тензорное обучение (TP), которые можно использовать в комбинации. Они также обеспечиваютДюжина программи поощрять пользователей копировать и настраивать ее под свои нужды. Они создали модифицированную версию полной программы тонкой настройки, которая поддерживает:

- Обучение с использованием нескольких и одного оборудования

- Загрузка эталонной модели и обмен весами для расчета дисперсии KL

- Расширенный расчет причинно-следственных масок с использованием идентификаторов групп и родительских идентификаторов

- Интеграция потерь GRPO и регистрация компонентов

Программа доступна вздесьСм. В будущем они надеются добавить поддержку тензорного параллелизма и изучить PEFT и квантование.

Процесс обучения RL включает в себя выбор большого количества гиперпараметров. В процессе обучения модели были протестированы различные конфигурации, и в основном были определены следующие конфигурации:

- Модели: Qwen 2.5 Instruct 14B и 32B

- Количество задач на итерацию: 32

- Количество образцов для каждой задачи за итерацию: 50

- Общее количество образцов за итерацию: 32 * 50 = 1600

- Скорость обучения: 6e-6

- Размер микропакета: 4 последовательности для модели 14B, 8 последовательностей для модели 32B

- Размер партии: переменный, в зависимости от количества последовательностей

Размер партии может быть разным, поскольку длина ответа может меняться в процессе обучения, эффективность упаковки последовательности колеблется на каждой итерации, а ответы с нулевым доминированием (т. е. ответы, для которых модель не дает ни положительной, ни отрицательной обратной связи) отбрасываются. В одном из запусков была предпринята попытка динамически регулировать скорость обучения в зависимости от размера партии, но это привело к тому, что скорость обучения оказалась слишком высокой для малых партий, и ее пришлось ограничить. Версия с установленным ограничением существенно не отличалась от версии с постоянной скоростью обучения, но регулировка размера партии и скорости обучения остается интересной областью для будущих экспериментов.

Они также провели короткие эксперименты, увеличивая количество задач на итерацию и уменьшая количество образцов на задачу, и наоборот, сохраняя общее количество образцов на итерацию примерно одинаковым. Эти изменения не показали значимых различий за короткий период обучения, что говорит о том, что схема устойчива к различным компромиссам между количеством задач и количеством образцов на задачу.

в конце концов

После обучения модели в течение более чем 100 итераций был достигнут передовой уровень умозаключений.

Модель быстро улучшает свои показатели, а затем улучшение точности начинает снижаться и в конечном итоге падает, иногда очень сильно. В лучшем случае модель 14B приближается к производительности Claude Sonnet 3.7 при 16 тыс. лексем, а модель 32B почти соответствует результатам Sonnet при 64 тыс. лексем.

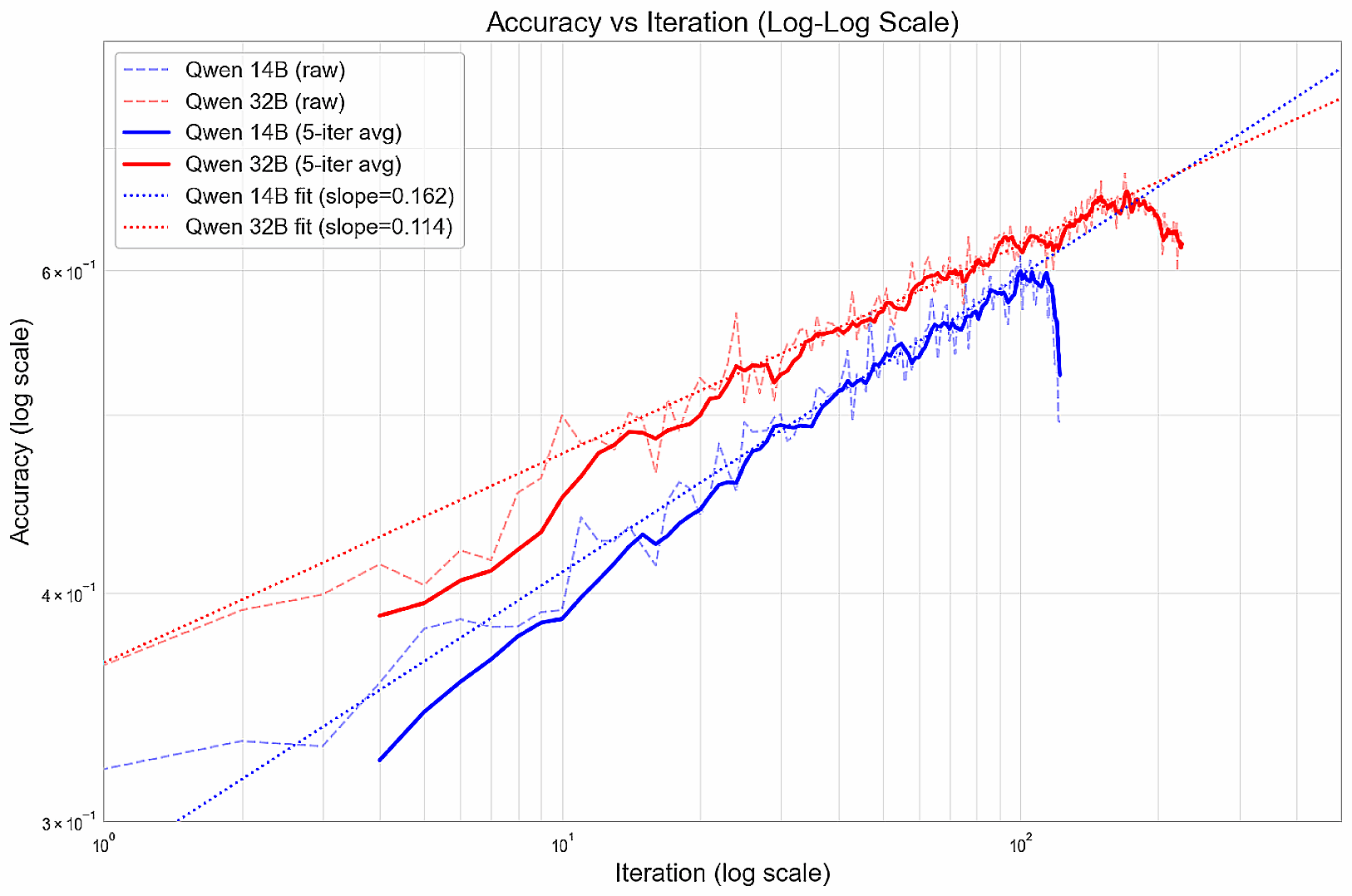

Во время тренировки улучшение показателей происходит по степенному закону, образуя линейную зависимость на логарифмической линейке (до ухудшения).

Они подозревают, что эти модели могут преждевременно сходиться на жадных стратегиях, которые работают на начальном этапе, но могут ограничить их долгосрочные перспективы. Следующим шагом может стать изучение способов поощрения разнообразия ответов, или способов постепенного наращивания компетенции (например, курсовое обучение), или назначение большего вознаграждения за особенно удачные решения, чтобы стимулировать тщательное изучение.

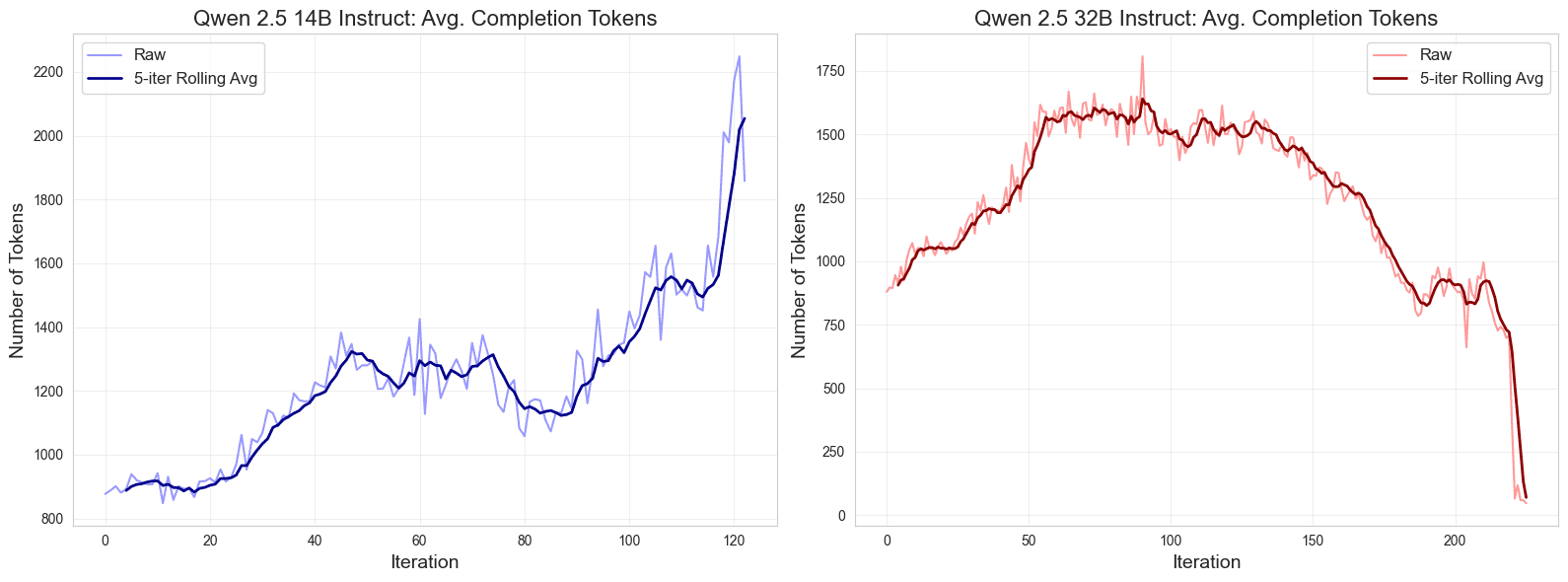

Кроме того, они заметили интересную закономерность в длине отклика во время обучения. Вначале отклик становится длиннее, затем стабилизируется, а к концу обучения расходится: отклик модели 14B становится длиннее, а отклик модели 32B - короче, особенно после достижения пика производительности.

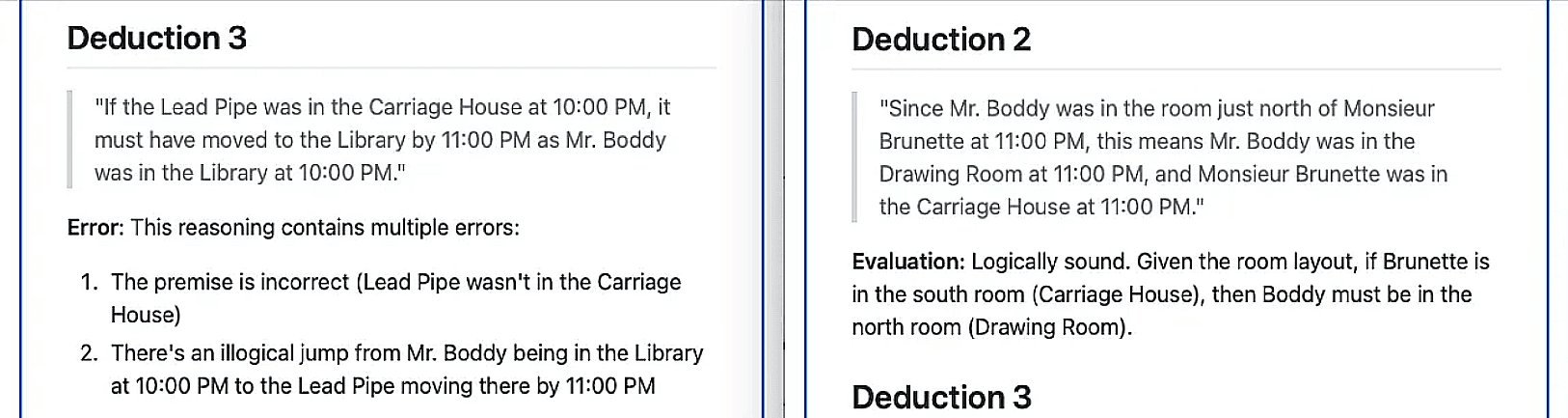

Чтобы качественно оценить улучшение логического мышления, они попросили свою самую сильную передовую модель Claude Sonnet 3.7 определить и оценить правдоподобность рассуждений, выполненных моделью Qwen 32B на аналогичных головоломках - до и после более чем 100 итераций обучения.Сонет определил 6 выводов из базовой модели, из которых все, кроме одного, были признаны ложными;Вместо этого он определил семь выводов из обученной модели, все из которых, кроме одного, были признаны логически обоснованными.

Наконец, предположение о том, чторазвертывание по требованиюестьДостаточная пропускная способностьОни основаны на Фейерверк AI (используется в форме номинального выражения)Уровни цен на бессерверные системыоценили стоимость модели Qwen. Они сравнили точность с натуральным логарифмом средней стоимости умозаключения на один ответ и увидели четкую линейную границу Парето в нескорректированной модели. Компромисс между стоимостью и точностью был значительно улучшен благодаря успешному обучению модели с открытым исходным кодом до уровня точности, соответствующего границе.

резюме

В этом исследовании они попытались выяснить, могут ли небольшие языковые модели с открытым исходным кодом достичь передовых возможностей рассуждения с помощью обучения с подкреплением. После обучения моделей Qwen 14B и 32B на сложных головоломках Temporal Clue с использованием тщательно подобранных гиперпараметров и метода GRPO они добились впечатляющего прироста производительности. Эти улучшения позволили вывести модели с открытым исходным кодом на передовые позиции по производительности вывода при значительном снижении стоимости. Полученные результаты подчеркивают потенциал обучения с подкреплением для эффективного обучения открытых моделей сложным задачам рассуждения.

Как уже говорилось ранее.набор данных, итест, иПрограммы обучения и веса моделей (14B, 32B) доступны бесплатно под лицензией MIT.

Кроме того, они обнаружили, что только 16 учебных примеров Достигается значительный прирост производительности до 10-15%.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...