GPT-Crawler: автоматический просмотр содержимого веб-сайта для создания документов базы знаний

Общее введение

GPT-Crawler - это инструмент с открытым исходным кодом, разработанный командой BuilderIO и размещенный на GitHub. Он просматривает содержимое страниц, вводя один или несколько URL-адресов веб-сайтов, генерируя структурированные документы знаний (output.json) для создания пользовательских GPT или AI-помощников. Пользователи могут настроить правила поиска, например, указать начальный URL-адрес и селектор контента, а инструмент автоматически извлекает текст и организует его в файлы. Инструмент прост в использовании и поддерживает локальные запуски, развертывание контейнеров Docker и вызовы API, что делает его идеальным для разработчиков, которые могут быстро создать собственных ИИ-помощников на основе контента веб-сайтов. Пока что он набирает обороты в технологическом сообществе, пользуясь популярностью благодаря своей эффективности и открытому исходному коду.

Список функций

- Изучает содержимое веб-сайта по одному или нескольким URL-адресам, генерируя

output.jsonДокументация. - Поддержка пользовательских правил наполнения, включая начальные URL, шаблоны сопоставления ссылок и селекторы CSS.

- Способность работать с динамическими веб-страницами и просматривать содержимое на стороне клиента с помощью безголового браузера.

- Предоставляет API-интерфейс для запуска задач краулинга с помощью POST-запросов.

- Поддерживает установку максимального количества страниц (

maxPagesToCrawl), размер документа (maxFileSize) и количество жетонов (maxTokens). - Сгенерированные файлы могут быть загружены непосредственно в OpenAI для создания пользовательских GPT или ИИ-ассистентов.

- Поддерживает работу с контейнерами Docker, что упрощает развертывание в различных средах.

- Конкретные типы ресурсов (например, изображения, видео и т. д.) могут быть исключены для оптимизации эффективности поиска.

Использование помощи

Установка и эксплуатация (локальный режим)

GPT-Crawler разработан на базе Node.js, и для его запуска требуется установка. Ниже приведены подробные шаги:

- Проверка окружения

Убедитесь, что на вашем компьютере установлены Node.js (версия 16 или выше) и npm. Для подтверждения выполните следующую команду:

node -v

npm -v

Если у вас его нет, загрузите и установите его с сайта Node.js.

- проект клонирования

Загрузите проект локально, введя команду в терминале:

git clone https://github.com/BuilderIO/gpt-crawler.git

- Доступ к каталогу

После завершения загрузки перейдите в папку с проектом:

cd gpt-crawler

- Установка зависимостей

Выполните следующую команду, чтобы установить необходимые пакеты:

npm install

- Настройка кроулера

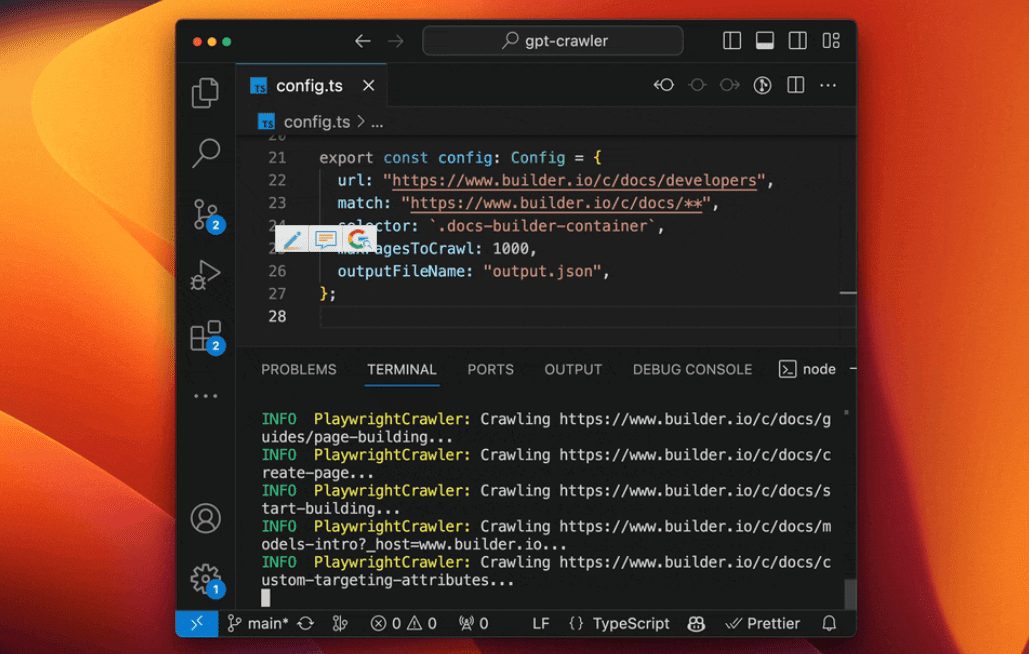

показать (билет)config.tsфайла, измените параметры переползания. Например, чтобы просмотреть документ Builder.io:

export const defaultConfig: Config = {

url: "https://www.builder.io/c/docs/developers",

match: "https://www.builder.io/c/docs/**",

selector: ".docs-builder-container",

maxPagesToCrawl: 50,

outputFileName: "output.json"

};

url: Начальный адрес ползунка.match: Шаблон сопоставления ссылок с поддержкой подстановочных знаков.selector: CSS-селектор для извлечения содержимого.maxPagesToCrawl: Максимальное количество страниц для просмотра.outputFileName: Имя выходного файла.

- Запуск краулера

После завершения настройки выполните следующую команду, чтобы запустить ползание:

npm start

По завершении.output.json файл создается в корневом каталоге проекта.

Альтернативные режимы работы

Использование контейнеров Docker

- Убедитесь, что Docker установлен (загружен с сайта Docker).

- входить

containerappПапка, Редактироватьconfig.ts. - Выполните следующую команду, чтобы собрать и запустить контейнер:

docker build -t gpt-crawler .

docker run -v $(pwd)/data:/app/data gpt-crawler

- Выходной файл создается в

dataпапка.

Работа с API

- После установки зависимостей запустите службу API:

npm run start:server

- По умолчанию служба запускается на

http://localhost:3000. - Отправьте POST-запрос на

/crawl, пример:

curl -X POST http://localhost:3000/crawl -H "Content-Type: application/json" -d '{"url":"https://example.com","match":"https://example.com/**","selector":"body","maxPagesToCrawl":10,"outputFileName":"output.json"}'

- доступный

/api-docsПросмотрите документацию по API (основанную на Swagger).

Загрузка в OpenAI

- Создание пользовательского GPT

- Открытый чатGPT.

- Нажмите на свое имя в левом нижнем углу и выберите "Мои GPT".

- Нажмите "Создать GPT" > "Настроить" > "Знания".

- загрузить

output.jsonДокументация. - Если файл слишком велик, то

config.tsустанавливатьmaxFileSizeвозможноmaxTokensРаздельный файл.

- Создание пользовательских помощников

- Откройте платформу OpenAI.

- Нажмите "+ Создать" > "Загрузить".

- загрузить

output.jsonДокументация.

Функции

- Просмотр содержимого

четко и определенно указыватьurlответить пениемselectorПосле этого инструмент извлекает текст страницы. Например..docs-builder-containerЗахватите только содержимое региона. - Создание файлов

Формат выходного файла:

[{"title": "页面标题", "url": "https://example.com/page", "html": "提取的文本"}, ...]

- Оптимизированная производительность

пользоватьсяresourceExclusionsИсключите посторонние ресурсы (например.png, иjpg), уменьшая размер файла.

предостережение

- Для создания пользовательских GPT требуется платный аккаунт OpenAI.

- Динамический веб-ползание полагается на безголовые браузеры для обеспечения целостности зависимостей.

- Конфигурация может быть настроена на разделение загрузки, если файл слишком велик.

сценарий применения

- Ассистент технической поддержки

Просматривайте веб-сайты с документацией по продуктам, чтобы генерировать помощников с искусственным интеллектом, которые помогают пользователям отвечать на технические вопросы. - Инструменты для организации контента

Берите статьи из блогов или новостных сайтов, чтобы создать базу знаний или помощника по вопросам и ответам. - Помощник по образованию и обучению

Просматривайте страницы онлайн-курсов, чтобы генерировать учебные помощники, предоставляющие ответы на вопросы, связанные с курсом.

QA

- Можно ли просматривать несколько веб-сайтов?

Можно. Вconfig.tsПросто задайте несколько URL-адресов и правила соответствия в - Что делать, если файл слишком велик для загрузки?

устанавливатьmaxFileSizeвозможноmaxTokensРазбивает файл на несколько файлов меньшего размера. - Поддерживаете ли вы китайские сайты?

Поддержка. Если содержимое сайта может быть разобрано безголовыми браузерами, оно может быть просмотрено правильно.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...