Google выпускает модель Gemma 3 QAT: лучшие модели ИИ для потребительских GPU

После того как в прошлом месяце было представлено новое поколение открытых моделей Джемма 3 Недавно компания Google расширила экосистему своих моделей новой версией, оптимизированной для обучения с учетом квантования (Quantization-Aware Training, QAT). Gemma 3 ранее использовалась в BF16 Точность ниже, чем у одного графического процессора высокого класса (например. NVIDIA H100Версия QAT предназначена для значительного снижения требований к памяти моделей при сохранении максимально возможного качества выходных данных, что позволяет запускать мощные модели искусственного интеллекта на оборудовании более потребительского класса. Версия QAT предназначена для значительного снижения требований к памяти моделей при сохранении высочайшего качества выходных данных, что позволяет запускать мощные модели ИИ на аппаратном обеспечении более потребительского класса.

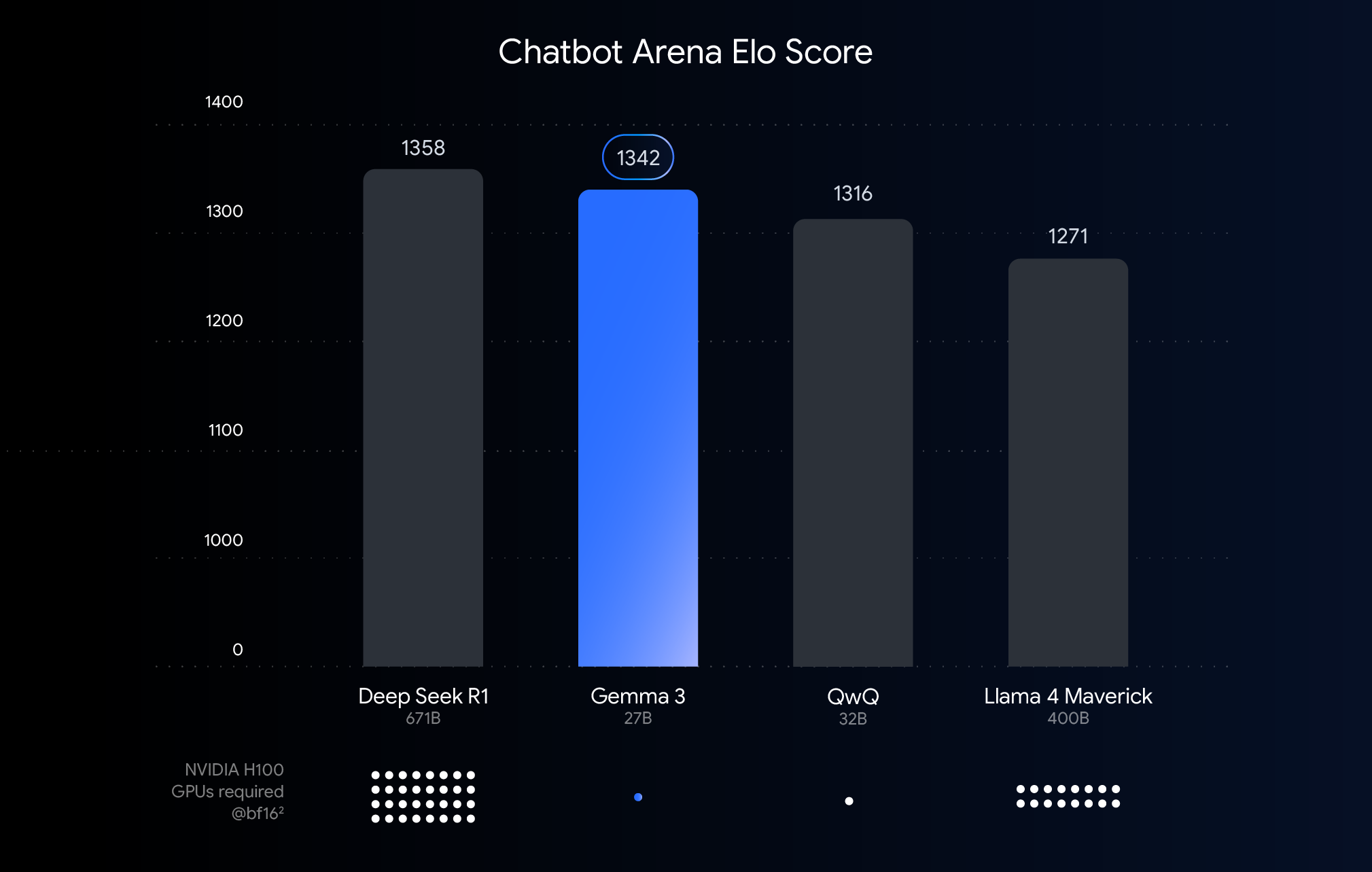

На этой диаграмме модели ИИ ранжируются на основе оценки Chatbot Arena Elo, причем более высокие оценки означают более высокие предпочтения пользователей. Точки указывают на то, что необходимо модели для работы NVIDIA H100 Предполагаемое количество графических процессоров.

Понимание порогов производительности, точности и квантификации

На графике выше показано сравнение производительности (оценки Elo) недавно выпущенных больших языковых моделей. Более высокие столбики означают, что модели показывают лучшие результаты при анонимном сравнении бок о бок, проведенном человеческими экспертами. В нижней части графика отмечена производительность на BF16 необходимые для запуска каждой модели в соответствии с типом данных NVIDIA H100 Расчетное количество GPU.

опция BF16 Сравнение проводится потому, что это широко используемый числовой формат для многих крупномасштабных модельных выводов, представляющий параметры модели, хранящиеся с 16-битной точностью. В случае унифицированного BF16 Сравнение в рамках этой установки помогает оценить возможности самой модели в одной и той же конфигурации вывода, исключая переменные, вносимые различным оборудованием или методами оптимизации, такими как квантование.

Стоит отметить, что на графике используется BF16 но при реальном развертывании очень больших моделей, чтобы снизить огромные требования к аппаратному обеспечению (например, к количеству графических процессоров), часто приходится использовать систему, подобную FP8 и другие форматы с более низкой точностью, что может потребовать компромисса между производительностью и целесообразностью.

Преодоление аппаратных барьеров: делаем ИИ более доступным

Хотя Gemma 3 отлично работает на высокопроизводительном оборудовании для облачных вычислений и исследовательских сценариев, отзывы пользователей ясно показывают, что рынок ожидает возможности использования возможностей Gemma 3 на существующем оборудовании. Внедрение мощных технологий ИИ означает, что модели должны эффективно работать на графических процессорах потребительского класса, которые обычно используются на настольных компьютерах, ноутбуках и даже мобильных устройствах. Локальный запуск больших моделей не только повышает конфиденциальность данных, снижает сетевые задержки и поддерживает автономные приложения, но и предоставляет больше возможностей для пользовательской настройки.

Технология QAT: ключ к балансу между производительностью и доступностью

Методы квантизации являются ключевыми для достижения этой цели. В моделях ИИ квантификация направлена на снижение точности чисел (т. е. параметров модели), используемых при хранении и вычислении модели. Это похоже на сжатие изображения путем уменьшения количества используемых в нем цветов. По сравнению с использованием 16 бит на число (BF16), квантование может использовать меньшее количество бит, например, 8 бит (int8) или даже 4-битные (int4).

усыновление int4 Это означает, что каждая цифра представлена всего 4 битами, а размер данных меньше, чем BF16 Уменьшение в 4 раза. Традиционные методы квантования (например, посттренинговое квантование PTQ) обычно выполняются после обучения модели, что легко реализовать, но может привести к значительному снижению производительности. Техника QAT, используемая Google, отличается.

QAT вводит этап квантования в процессе обучения модели для имитации операций с низкой точностью. Такой подход позволяет модели адаптироваться к среде с низкой точностью еще в процессе обучения, что позволяет ей лучше сохранять точность при последующем квантовании, обеспечивая более компактные и быстрые модели. В частности, Google применила примерно 5 000 шагов QAT к модели Gemma 3, ориентируясь на вероятность неквантованной контрольной точки. Таким образом, утверждается, что после квантования до Q4_0 Недоумение, мера предсказательной силы модели, уменьшается на 54%, когда формат (с использованием llama.cpp (Оценка).

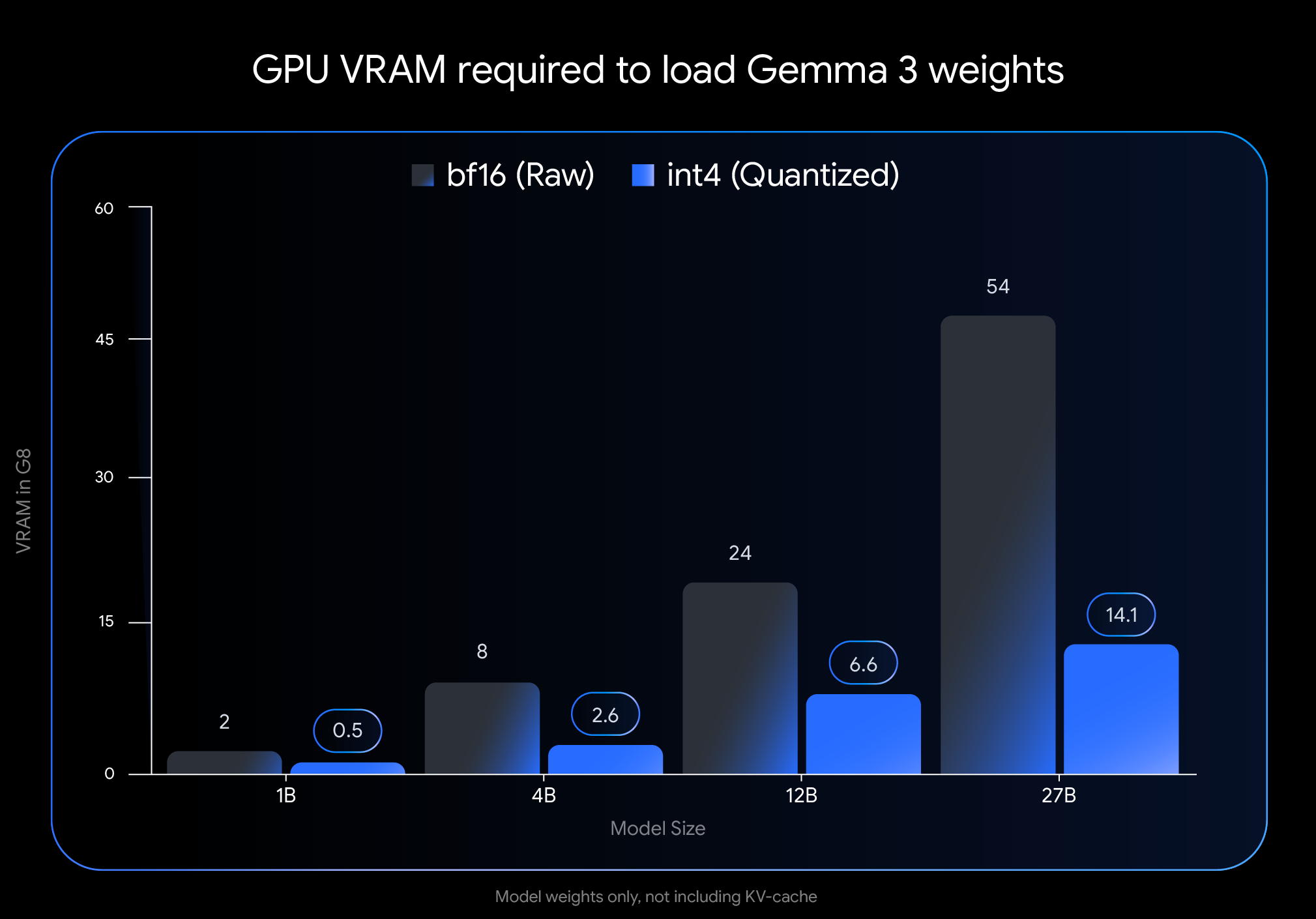

Значительный эффект: значительно снижается потребление VRAM

int4 Влияние квантования значительно, особенно с точки зрения объема видеопамяти (VRAM), необходимой для загрузки весов модели:

- Джемма 3 27B. От 54 ГБ (

BF16) до 14,1 ГБ (int4) - Джемма 3 12B. От 24 ГБ (

BF16) Сокращение до 6,6 ГБ (int4) - Джемма 3 4В. От 8 ГБ (

BF16) Уменьшено до 2,6 ГБ (int4) - Джемма 3 1B. От 2 ГБ (

BF16) до 0,5 ГБ (int4)

Осторожно. Эти данные представляют собой только VRAM, необходимую для загрузки весов модели. Запуск модели также требует дополнительной VRAM для кэша KV, в котором хранится информация о диалоговом контексте, размер которого зависит от длины контекста.

Запустите Gemma 3 на своем устройстве!

Значительное снижение требований к графической памяти позволяет запускать более крупные и мощные модели на широкодоступном оборудовании потребительского класса:

- Джемма 3 27B (

int4): Теперь его можно легко запустить на одном настольном компьютере с 24 ГБ VRAM.NVIDIA RTX 3090или аналогичных видеокарт, пользователи смогли запустить самый большой вариант Gemma 3 от Google локально. - Джемма 3 12B (

int4): Возможность работы на графических процессорах ноутбуков с 8 ГБ VRAM (таких какNVIDIA RTX 4060 Laptop GPUКомпания также предлагает мощные возможности искусственного интеллекта для портативных устройств. - Маленькие модели (4B, 1B). Обеспечивает большую доступность для систем с ограниченными ресурсами, включая некоторые мобильные устройства.

Простая интеграция с основными инструментами

Чтобы пользователям было проще использовать эти модели в своих рабочих процессах, Google сделала Hugging Face ответить пением Kaggle Официальный int4 ответить пением Q4_0 Неквантифицированные модели QAT. В то же время Google сотрудничает с несколькими популярными инструментами для разработчиков, чтобы пользователи могли беспрепятственно опробовать количественные контрольные точки на основе QAT:

- Оллама. Быстро запускается с помощью простой команды, поддерживаются все модели Gemma 3 QAT.

- Студия LM. Предоставляет удобный интерфейс для простой загрузки и запуска моделей Gemma 3 QAT на вашем рабочем столе.

- MLX. использовать

MLXРамка находится вApple SiliconЭффективный и оптимальный вывод моделей Gemma 3 QAT на - Gemma.cpp. Специальная реализация на C++ от Google для эффективного вывода на центральном процессоре.

- llama.cpp. Встроенная поддержка моделей QAT в формате GGUF для легкой интеграции в существующие рабочие процессы.

Больше количественных опций в экологии Геммаверс

В дополнение к официально опубликованной модели QAT, активные Gemmaverse Сообщество также предлагает множество альтернатив. В этих схемах обычно используются методы квантификации после обучения (PTQ), которые используются Bartowski, Unsloth, GGML и другие взносы членов сообщества, а также в Hugging Face Доступно на. Изучение этих возможностей сообщества дает пользователям более широкий выбор компромиссов между размером, скоростью и качеством модели для удовлетворения конкретных потребностей.

Начните прямо сейчас!

Внедрение передовых технологий ИИ в легкодоступное оборудование - важнейший шаг в демократизации разработки ИИ. Благодаря моделям Gemma 3, оптимизированным с помощью QAT, пользователи теперь могут использовать передовые возможности ИИ на своем настольном компьютере или ноутбуке. Это не только снижает барьер для разработчиков и исследователей при изучении крупномасштабных языковых моделей, но и открывает потенциал для более мощных приложений ИИ на границе.

Изучите количественные модели и начните их строить:

- Использование на ПК

OllamaБег:https://ollama.com/library/gemma3 - существовать

Hugging Faceответить пениемKaggleПосмотрите модель на: - Работает на мобильных устройствах (через

Google AI Edge):https://developers.googleblog.com/en/gemma-3-on-mobile-and-web-with-google-ai-edge/

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...