Gaze-LLE: инструмент предсказания цели для взгляда человека в видео

Общее введение

Gaze-LLE - это инструмент для предсказания цели взгляда, основанный на крупномасштабном обучаемом кодере. Проект, разработанный Фионой Райан, Аджаем Бати, Сангмином Ли, Даниэлем Болья, Джуди Хоффман и Джеймсом М. Регом, направлен на эффективное предсказание цели взгляда с помощью предварительно обученных визуальных базовых моделей, таких как DINOv2. Архитектура Gaze-LLE чиста и проста, и только замораживает предварительно обученный Архитектура Gaze-LLE чиста и проста, она только замораживает предварительно обученный визуальный кодер для обучения легкого декодера взгляда, что уменьшает количество параметров на 1-2 порядка по сравнению с предыдущими работами и не требует дополнительных входных модальностей, таких как глубина и информация о позе.

Список функций

- Сосредоточьтесь на прогнозировании целейЭффективное предсказание целей взгляда на основе предварительно обученных визуальных кодеров.

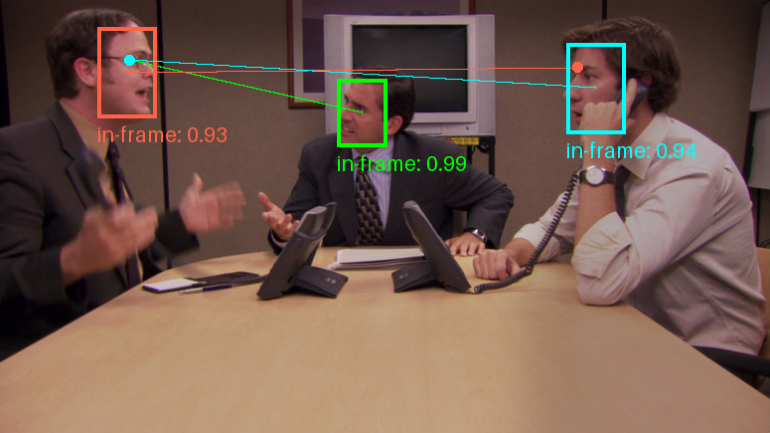

- Прогнозирование с помощью нескольких взглядов: поддерживает предсказание взгляда для нескольких человек на одном изображении.

- Модель предварительного обучения: Предоставляет множество предварительно обученных моделей для поддержки различных магистральных сетей и обучающих данных.

- Легкая архитектура: Обучение легких декодеров взгляда только на замороженных предварительно обученных визуальных кодерах.

- Никаких дополнительных режимов ввода: Дополнительные данные о глубине и ориентации не требуются.

Использование помощи

Процесс установки

- Хранилище клонирования:

git clone https://github.com/fkryan/gazelle.git

cd gazelle

- Создайте виртуальную среду и установите зависимости:

conda env create -f environment.yml

conda activate gazelle

pip install -e .

- Дополнительно: установите xformers для ускорения расчетов внимания (если это поддерживается системой):

pip3 install -U xformers --index-url https://download.pytorch.org/whl/cu118

Использование предварительно обученных моделей

Gaze-LLE предоставляет множество предварительно обученных моделей, которые пользователи могут загрузить и использовать по мере необходимости:

- газельдинов2vitb14: Модель на основе DINOv2 ViT-B с обучающими данными из GazeFollow.

- газельдинов2витл14: Модель на основе DINOv2 ViT-L с обучающими данными из GazeFollow.

- газельдинов2vitb14_inout: Модель на основе DINOv2 ViT-B с обучающими данными для GazeFollow и VideoAttentionTarget.

- газельбольшойvitl14_inout: Модель на основе DINOv2 ViT-L с обучающими данными для GazeFollow и VideoAttentionTarget.

Пример использования

- Загрузите модель в PyTorch Hub:

import torch

model, transform = torch.hub.load('fkryan/gazelle', 'gazelle_dinov2_vitb14')

- Просмотрите демонстрационный блокнот в Google Colab, чтобы узнать, как определить цель взгляда на изображении.

следите за прогнозами

Gaze-LLE поддерживает предсказание взгляда для нескольких людей, т.е. одно изображение кодируется один раз, а затем характеристики используются для предсказания целей взгляда для нескольких людей на изображении. Модель выдает пространственную тепловую карту, представляющую вероятность расположения цели взгляда в сцене со значениями в диапазоне [0,1], где 1 означает наибольшую вероятность расположения цели взгляда.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...