FunASR: Инструментарий для распознавания речи с открытым исходным кодом, разделение дикторов / распознавание диалоговой речи нескольких человек

Общее введение

FunASR - это набор инструментов для распознавания речи с открытым исходным кодом, разработанный Институтом Дарма компании Alibaba для объединения академических исследований и промышленных приложений. Он поддерживает широкий спектр функций распознавания речи, включая распознавание речи (ASR), обнаружение голосовых точек (VAD), восстановление пунктуации, языковое моделирование, верификацию диктора, разделение дикторов и распознавание речи в многоместном диалоге. FunASR предоставляет удобные скрипты и учебники для поддержки вывода и тонкой настройки предварительно обученных моделей, помогая пользователям быстро создавать эффективные сервисы распознавания речи.

Поддерживает различные форматы аудио и видео, может распознать десятки часов длинного аудио и видео в текст с пунктуацией, поддерживает сотни запросов для одновременной транскрипции Поддерживает китайский, английский, японский, кантонский и корейский языки.

Опыт работы в Интернете: https://www.funasr.com/

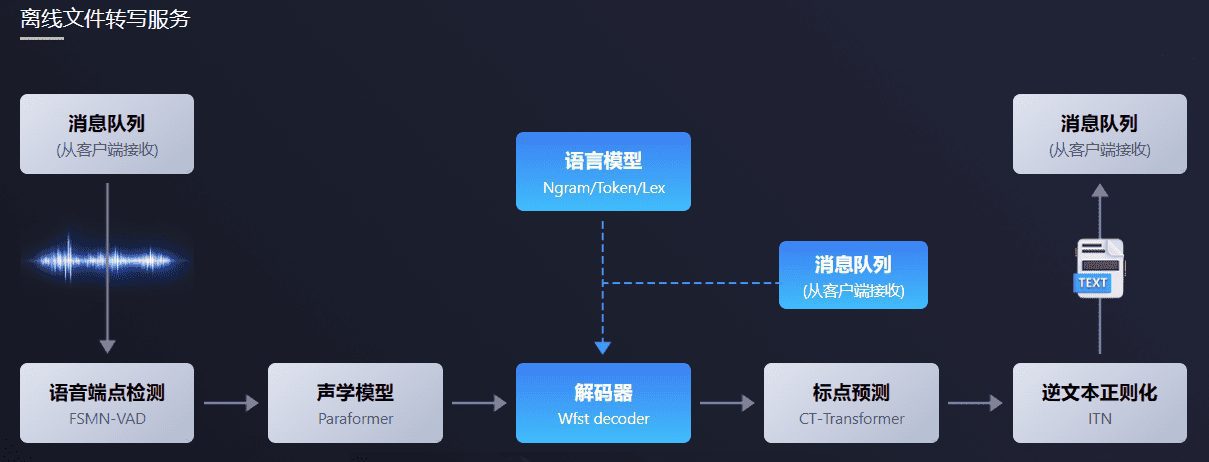

Программный пакет FunASR для транскрипции файлов в автономном режиме предоставляет мощный сервис транскрипции речевых файлов в автономном режиме. Благодаря полной системе распознавания речи, сочетающей в себе функции обнаружения конечных точек речи, распознавания речи, пунктуации и другие модели, он может распознавать десятки часов длинных аудио- и видеозаписей в виде пунктуационного текста и поддерживает сотни запросов на одновременную транскрипцию. На выходе получается пунктуационный текст с временными метками на уровне слов и поддержкой ITN и заданных пользователем "горячих слов". Интеграция с ffmpeg на стороне сервера, поддержка различных входных аудио- и видеоформатов. Пакет предоставляет html, python, c++, java и c# и другие языки программирования клиента, пользователь может непосредственно использовать и дальнейшее развитие.

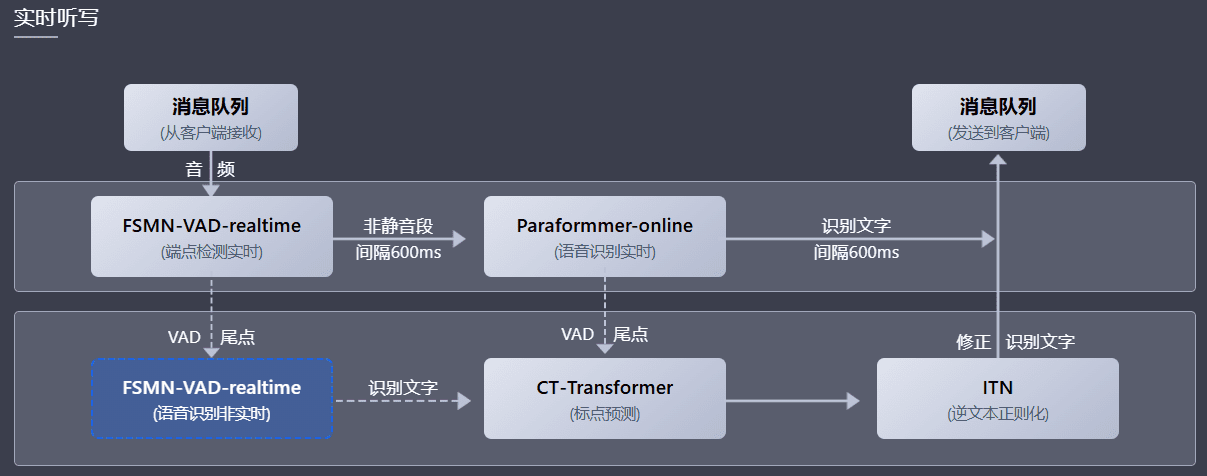

Программный пакет FunASR для диктовки речи в реальном времени объединяет в себе версии моделей обнаружения конечных точек речи, распознавания речи, распознавания голоса и моделей предсказания пунктуации в реальном времени. Используя синергию нескольких моделей, он может не только передавать речь в текст в реальном времени, но и корректировать выходной текст с высокой точностью транскрипции в конце предложения, выводить текст с пунктуацией, а также поддерживать несколько запросов. В соответствии с различными пользовательскими сценариями поддерживаются три режима обслуживания: диктовка речи в реальном времени (онлайн), транскрипция предложений в нереальном времени (офлайн) и интегрированная совместная работа в реальном и нереальном времени (2pass). Программный пакет предоставляет различные языки программирования, такие как html, python, c++, java и c# клиент, пользователи могут непосредственно использовать и развивать.

Список функций

- Распознавание речи (ASR): поддерживает распознавание речи в автономном режиме и в режиме реального времени.

- Обнаружение конечной точки голоса (VAD): определяет начало и конец голосового сигнала.

- Восстановление пунктуации: автоматическое добавление знаков препинания для улучшения читабельности текста.

- Языковые модели: поддерживает интеграцию нескольких языковых моделей.

- Верификация говорящего: проверка личности говорящего.

- Разделение дикторов: различение речи разных дикторов.

- Распознавание речи для нескольких разговоров: поддержка распознавания речи для нескольких одновременных разговоров.

- Вывод и тонкая настройка модели: предоставляет функции вывода и тонкой настройки для предварительно обученных моделей.

Использование помощи

Процесс установки

- Подготовка к защите окружающей среды::

- Убедитесь, что установлен Python 3.7 или выше.

- Установите необходимые библиотеки зависимостей:

pip install -r requirements.txt

- Скачать модели::

- Загрузите предварительно обученные модели из ModelScope или HuggingFace:

git clone https://github.com/modelscope/FunASR.git cd FunASR

- Загрузите предварительно обученные модели из ModelScope или HuggingFace:

- Конфигурационная среда::

- Настройте переменные окружения:

export MODEL_DIR=/path/to/your/model

- Настройте переменные окружения:

Процесс использования

- распознавание речи::

- Используйте командную строку для распознавания речи:

python recognize.py --model paraformer --input your_audio.wav - Распознавание речи с помощью кода Python:

from funasr import AutoModel model = AutoModel.from_pretrained("paraformer") result = model.recognize("your_audio.wav") print(result)

- Используйте командную строку для распознавания речи:

- обнаружение голосовых конечных точек::

- Используйте командную строку для обнаружения голосовых конечных точек:

python vad.py --model fsmn-vad --input your_audio.wav - Обнаружение конечных точек речи с помощью кода Python:

from funasr import AutoModel vad_model = AutoModel.from_pretrained("fsmn-vad") vad_result = vad_model.detect("your_audio.wav") print(vad_result)

- Используйте командную строку для обнаружения голосовых конечных точек:

- Восстановление знаков препинания::

- Используйте командную строку для восстановления пунктуации:

python punctuate.py --model ct-punc --input your_text.txt - Восстановление пунктуации с помощью кода Python:

from funasr import AutoModel punc_model = AutoModel.from_pretrained("ct-punc") punc_result = punc_model.punctuate("your_text.txt") print(punc_result)

- Используйте командную строку для восстановления пунктуации:

- Проверка спикера::

- Для проверки динамика используйте командную строку:

python verify.py --model speaker-verification --input your_audio.wav - Проверка диктора с помощью кода на Python:

from funasr import AutoModel verify_model = AutoModel.from_pretrained("speaker-verification") verify_result = verify_model.verify("your_audio.wav") print(verify_result)

- Для проверки динамика используйте командную строку:

- Распознавание речи при многократном разговоре::

- Распознавание речи для многопользовательских диалогов с помощью командной строки:

python multi_asr.py --model multi-talker-asr --input your_audio.wav - Распознавание речи при разговоре нескольких человек с помощью кода на Python:

from funasr import AutoModel multi_asr_model = AutoModel.from_pretrained("multi-talker-asr") multi_asr_result = multi_asr_model.recognize("your_audio.wav") print(multi_asr_result)

- Распознавание речи для многопользовательских диалогов с помощью командной строки:

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...