FireRedASR: модель с открытым исходным кодом для многоязычного высокоточного распознавания речи

Общее введение

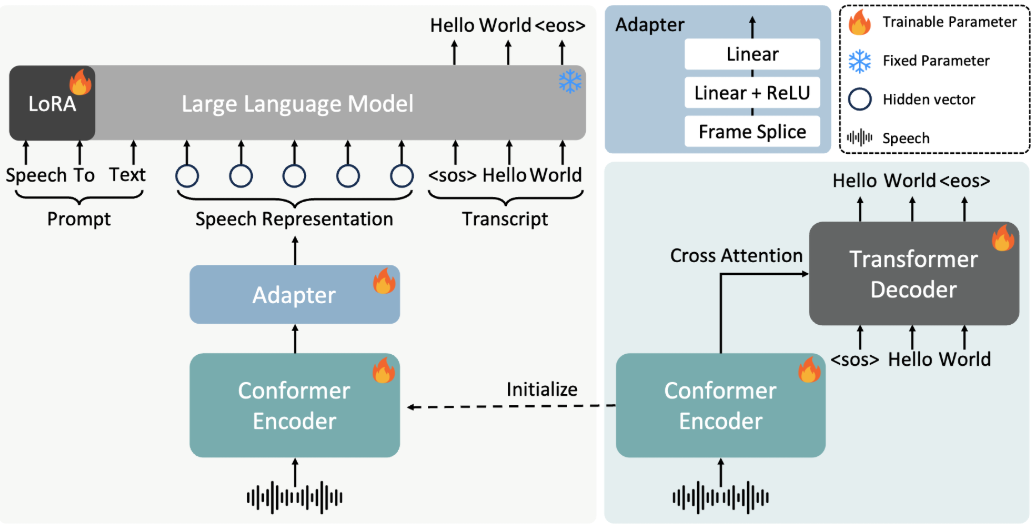

FireRedASR - это модель распознавания речи, разработанная и выложенная в открытый доступ командой Little Red Book FireRed и направленная на обеспечение высокоточной, многоязычной поддержки для решений автоматического распознавания речи (ASR). Проект, размещенный на GitHub, ориентирован на разработчиков и исследователей, обеспечивает промышленный уровень дизайна и поддерживает такие сценарии, как распознавание мандарина, китайских диалектов, английского языка и текстов песен. FireRedASR делится на две основные версии: FireRedASR-LLM стремится к предельной точности и подходит для профессиональных нужд; FireRedASR-AED балансирует между эффективностью и производительностью и подходит для приложений реального времени. По состоянию на 2025 год эта модель установила оптимальный рекорд в тесте китайского мандарина (CER 3.05%) и показала хорошие результаты в многосценарных тестах, что широко применимо в интеллектуальных помощниках, создании видео субтитров и других областях.

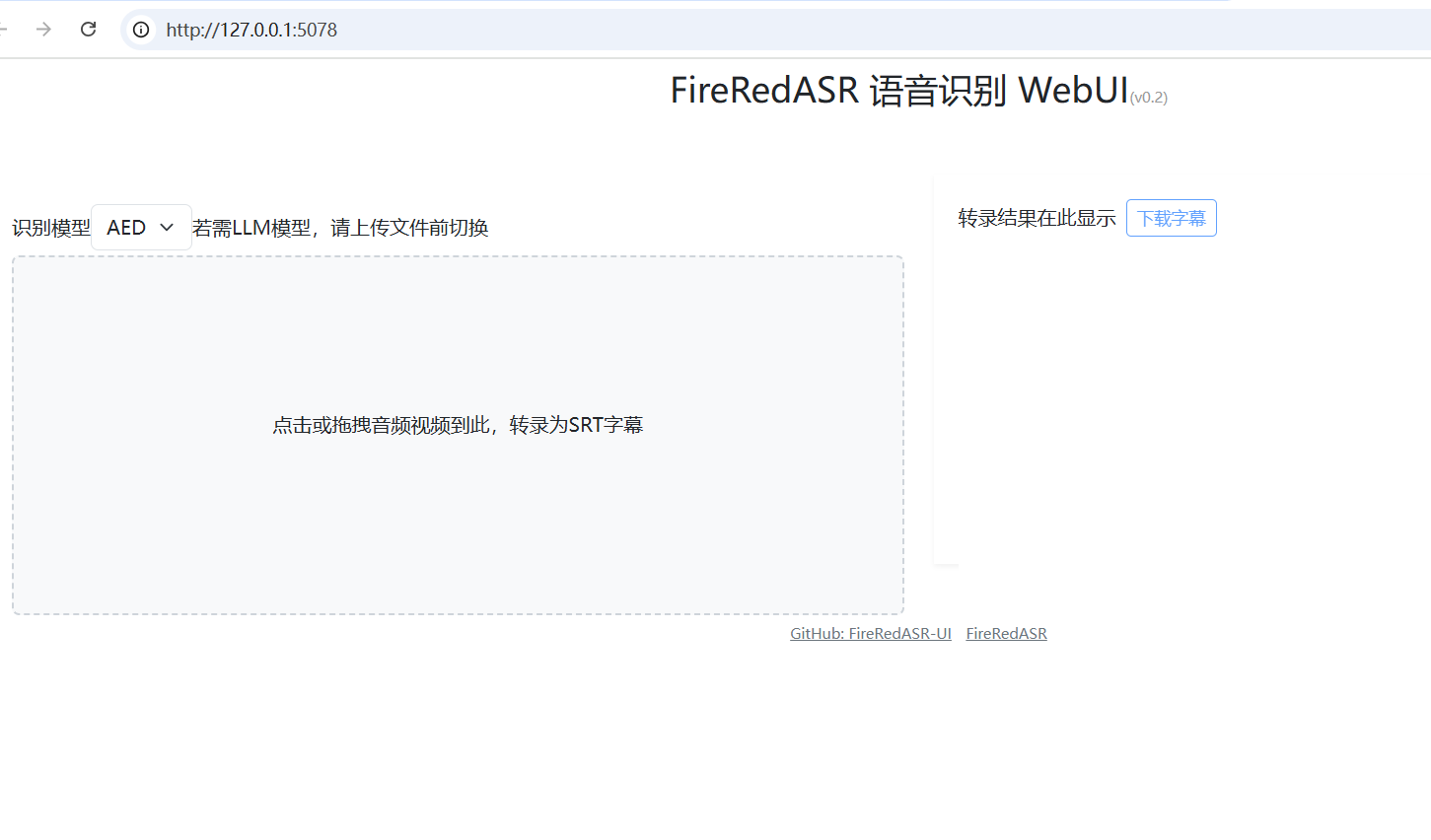

FireRedASR: WebUI-установщик в один клик: https://github.com/jianchang512/fireredasr-ui

Список функций

- Поддержка преобразования речи в текст на мандаринском языке, китайских диалектах и английском языке с лучшей в отрасли точностью распознавания.

- Обеспечивает функцию распознавания текстов песен, особенно подходит для обработки мультимедийного контента.

- Две версии, FireRedASR-LLM и FireRedASR-AED, предназначены для удовлетворения потребностей в высокоточных и высокоэффективных выводах, соответственно.

- Модели с открытым исходным кодом и код рассуждений для поддержки вторичных разработок сообщества и специализированных приложений.

- Он может работать с различными сценариями ввода звука, такими как короткие видеоролики, прямые трансляции, голосовой ввод и т. д.

- Поддерживает пакетную обработку аудио, подходит для решения масштабных задач по расшифровке данных.

Использование помощи

Процесс установки

Для работы FireRedASR требуются определенные конфигурации среды разработки, поэтому ниже приведены подробные шаги по установке:

1.Клонирование хранилища проектов

Откройте терминал и введите следующую команду, чтобы клонировать проект FireRedASR локально:

git clone https://github.com/FireRedTeam/FireRedASR.git

После завершения перейдите в каталог проектов:

cd FireRedASR

- Создание среды Python

Рекомендуется создать отдельное окружение Python с помощью Conda, чтобы обеспечить изоляцию зависимостей. Выполните следующую команду:

conda create --name fireredasr python=3.10

Активируйте окружающую среду:

conda activate fireredasr

- Установка зависимостей

Проект предусматриваетrequirements.txtфайл, содержащий все необходимые зависимости. Команда установки выглядит следующим образом:

pip install -r requirements.txt

Дождитесь завершения установки, убедитесь, что сеть работает без помех, для ускорения загрузки вам может понадобиться научный инструмент для работы в Интернете.

- Загрузите предварительно обученную модель

- FireRedASR-AED-L: Загрузите предварительно обученную модель прямо с GitHub или Hugging Face, поместите ее в

pretrained_models/FireRedASR-AED-LПапка. - FireRedASR-LLM-L: Помимо загрузки модели, необходимо также загрузить модель Qwen2-7B-Instruct в

pretrained_modelsпапку, а вFireRedASR-LLM-Lкаталог для создания мягких ссылок:

ln -s ../Qwen2-7B-Instruct

- Проверка установки

Выполните следующую команду, чтобы проверить, успешно ли прошла установка:

python speech2text.py --help

Если отображается справочное сообщение, значит, среда настроена правильно.

Как использовать

FireRedASR предоставляет два способа использования командной строки и Python API, ниже приводится подробное описание основных функций процесса работы.

работа в командной строке

- Однофайловая транскрипция (модель AED)

Используйте FireRedASR-AED-L для обработки аудиофайлов (до 60 секунд):

python speech2text.py --wav_path examples/wav/BAC009S0764W0121.wav --asr_type "aed" --model_dir pretrained_models/FireRedASR-AED-L

--wav_path: Указывает путь к аудиофайлу.--asr_type: Выберите тип модели, в данном случае "aed".--model_dir: Указывает папку модели.

Выходные данные отображаются в терминале, например, расшифрованный текстовый контент.

- Однофайловая транскрипция (модель LLM)

Используйте FireRedASR-LLM-L для обработки аудио (до 30 секунд):

python speech2text.py --wav_path examples/wav/BAC009S0764W0121.wav --asr_type "llm" --model_dir pretrained_models/FireRedASR-LLM-L

Значение параметра такое же, как и выше, а на выходе получается транскрибированный текст.

Операции с API на языке Python

- Загрузите модель и расшифруйте

Вызовите модель FireRedASR в сценарии Python:

from fireredasr.models.fireredasr import FireRedAsr

# 初始化 AED 模型

model = FireRedAsr.from_pretrained("aed", "pretrained_models/FireRedASR-AED-L")

batch_uttid = ["BAC009S0764W0121"]

batch_wav_path = ["examples/wav/BAC009S0764W0121.wav"]

results = model.transcribe(

batch_uttid, batch_wav_path,

{"use_gpu": 1, "beam_size": 3, "nbest": 1, "decode_max_len": 0}

)

print(results)

- от_пристрастия: Загрузите указанную модель.

- транскрибировать: Выполняет задачу транскрибирования и возвращает результат в виде списка текстов.

- Настройка параметров для оптимизации результатов

- использование_gpu: Установите значение 1, чтобы использовать ускорение GPU, 0, чтобы использовать ускорение CPU.

- размер пучка: Ширина пучка поиска, чем больше, тем выше точность, но тем больше времени это занимает, по умолчанию 3.

- nbest: Возвращает оптимальное количество результатов, по умолчанию 1.

Функциональное управление

- распознавание лирики

FireRedASR-LLM отлично справляется с распознаванием текстов песен. Вставьте аудиозапись песни (убедитесь, что она не занимает более 30 секунд), запустите:python speech2text.py --wav_path your_song.wav --asr_type "llm" --model_dir pretrained_models/FireRedASR-LLM-L**Вывод в виде текста песни с лучшими в отрасли показателями распознавания. **

- Поддержка нескольких языков

Для обработки диалектного или английского аудио используйте указанные выше команды или API напрямую, и модель будет адаптирована автоматически. Например, обработка английского аудио:model = FireRedAsr.from_pretrained("llm","pretrained_models/FireRedASR-LLM-L") results = model.transcribe(["english_audio"],["path/to/english.wav"],{"use_gpu":1}) print(results)

предостережение

- Ограничение длины аудиозаписи: AED поддерживается в течение 60 секунд, после чего могут возникнуть галлюцинации; LLM поддерживается в течение 30 секунд, при этом продолжительность поведения не определена.

- пакетный файл: Убедитесь, что длина входного аудиосигнала одинакова, чтобы избежать снижения производительности.

- требования к оборудованию: Для запуска больших моделей рекомендуется использовать GPU, так как CPU может работать медленнее.

С помощью описанных выше шагов пользователи могут легко начать работу с FireRedASR и пройти весь процесс от установки до использования, что применимо к различным сценариям распознавания речи.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие посты

Нет комментариев...