Аналитик Альберто Ромеро рассуждает: на самом деле OpenAI's GPT-5 уже давно готов.

Давайте начнем новый год с новыми силами!

- Может быть сгенерирован GPT-5

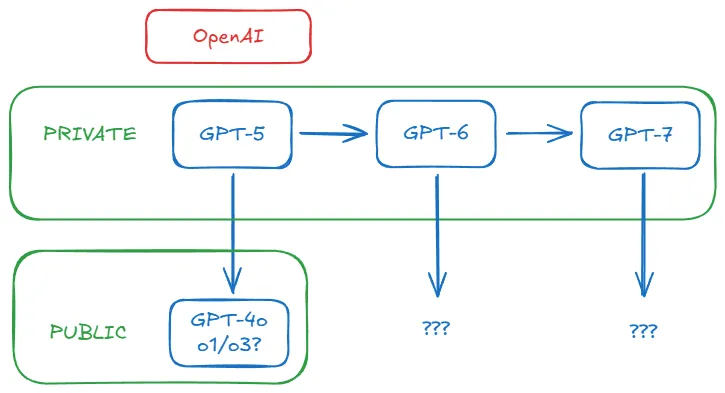

Что, если я скажу вам, что GPT-5 - это реальность. И не только реален, но и уже формирует мир так, как вы не видите. Вот гипотеза: OpenAI разработала GPT-5, но держит его у себя, потому что рентабельность инвестиций гораздо выше, чем если бы его открыли миллионам людей. ChatGPT пользователей. Более того, окупаемость инвестиций, которую они получают от Не деньги. Скорее, это что-то другое. Как видите, идея достаточно проста; проблема заключается в том, чтобы собрать воедино улики, которые указывают на нее. В этой статье мы рассмотрим, почему я считаю, что эти улики в конечном итоге соединяются.

Заранее предупреждаю: это чистая спекуляция. Все доказательства находятся в открытом доступе, но нет никаких утечек или внутренних слухов, подтверждающих мою правоту. Фактически, я строю эту теорию в этой статье, а не просто делюсь ею. У меня нет никакой конфиденциальной информации - а даже если бы и была, я связан соглашением о неразглашении. Эта гипотеза убедительна, потому что она логический . Честно говоря, что еще нужно, чтобы запустить эту машину слухов?

Верить в это или нет - решать вам. Даже если я ошибаюсь - а в конце концов мы узнаем ответ, - я думаю, что это забавная детективная игра. Я приглашаю вас высказать свои предположения в разделе комментариев, но, пожалуйста, оставайтесь конструктивными и вдумчивыми. Пожалуйста, не забудьте сначала прочитать всю статью. В остальном все дискуссии приветствуются.

I. Таинственное исчезновение Opus 3.5

Прежде чем исследовать GPT-5, мы должны упомянуть его столь же пропавшего дальнего кузена: Anthropic's Клод Опус 3.5.

Как вы знаете, три крупнейшие лаборатории искусственного интеллекта - OpenAI, Google DeepMind и Anthropic - предлагают портфели моделей, охватывающие спектр соотношения цены и производительности: openAI предлагает GPT-4o, GPT-4o mini, а также o1 и o1-mini; Google DeepMind предлагает Близнецы Ultra, Pro и Flash; у Anthropic есть Claude Opus, Sonnet и Haiku, и цель ясна: охватить как можно больше профилей покупателей. Одни ищут высочайшую производительность независимо от стоимости, другим нужны доступные и адекватные решения. Все это имеет смысл.

Но в октябре 2024 года произошло странное событие. В то время как все ожидали Антропология Когда они выпустили Claude Opus 3.5 в качестве ответа на GPT-4o (который вышел в мае 2024 года), 22 октября они выпустили обновленную версию Claude Sonnet 3.5 (которая стала известна как Sonnet 3.6), которая исчезла, оставив Anthropic без продукта, напрямую конкурирующего с GPT-4o. GPT-4o. Странно, не правда ли? Вот краткий обзор хронологии Opus 3.5:

- 28 октября в своей еженедельной обзорной статье я написал: "[Ходят] слухи, что Sonnet 3.6 - это... . промежуточная контрольная точка, созданная во время долгожданного провала обучения Opus 3.5". В тот же день в подфоруме r/ClaudeAI появилось сообщение "Claude 3.5 Opus was deprecated" со ссылкой на страницу Anthropic models - там до сих пор нет никаких признаков Opus 3.5. Есть предположение, что этот шаг был сделан для поддержания доверия инвесторов в преддверии нового раунда финансирования.

- 11 ноября генеральный директор Anthropic Дарио Амодей в подкасте Лекса Фридмана сообщил о Opus 3.5: "Хотя мы не можем назвать точную дату, мы все еще планируем выпустить Claude 3.5 Opus". Формулировка осторожно двусмысленная, но эффективная.

- 13 ноября Bloomberg подтвердил ранние слухи о том, что "после завершения обучения Anthropic обнаружила, что 3.5 Opus превзошла старую версию в оценках, но прирост не оправдал ожиданий, учитывая размер модели и стоимость построения прогона". Дарио не назвал дату, по-видимому, потому, что результаты оказались неудовлетворительными, несмотря на то, что обучение Opus 3.5 не было провалено. Обратите внимание на Соотношение затрат и производительности Не только производительность.

- 11 декабря эксперт по полупроводникам Дилан Патель и его команда из Semianalysis внесли окончательный поворот, предложив объяснение: "Anthropic завершает обучение Claude 3.5 Opus и демонстрирует хорошие результаты... ...но не выпустила его. Потому что они перешли на Генерация данных синтеза с помощью Claude 3.5 Opus которая значительно улучшает Сонет Claude 3.5 за счет бонусного моделирования".

Короче говоря, Anthropic действительно обучала Клода Опусу 3.5, но отказалась от этого названия, потому что результаты оказались недостаточно хорошими. Дарио считает, что результаты можно было бы улучшить с помощью другого процесса обучения, и избегает этой даты. Bloomberg подтверждает, что она превосходит существующие модели, но стоимость вывода (стоимость использования модели для пользователя) недоступна, а команда Дилана раскрывает связь между Sonnet 3.6 и пропавшим Opus 3.5: последний был использован для внутренней генерации синтетических данных, чтобы улучшить производительность первого.

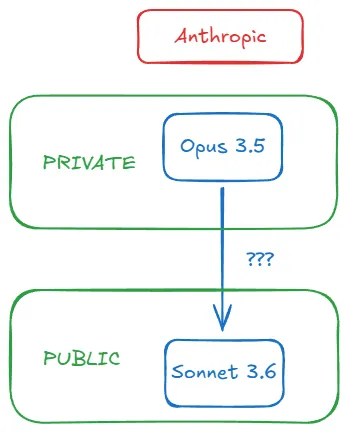

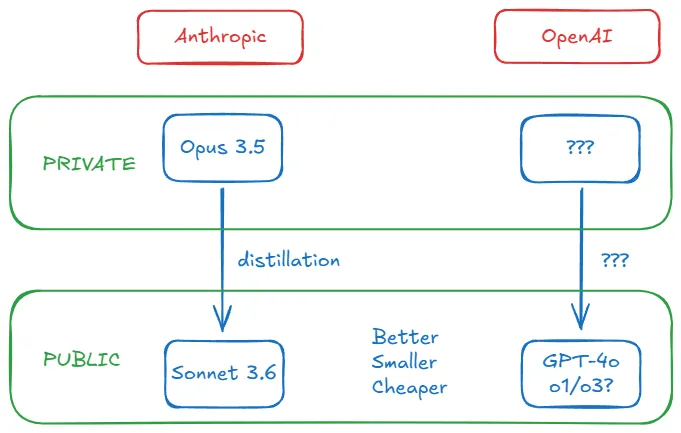

Весь процесс можно представить в виде следующей схемы:

II. Лучше, меньше и дешевле?

Процесс использования сильной и дорогой модели для получения данных, дополняющих немного более слабую, но более экономичную модель, называется дистилляцией. Это распространенная практика. Эта техника позволяет лабораториям искусственного интеллекта преодолеть ограничения, связанные только с предварительным обучением, и повысить производительность небольших моделей.

Существуют различные методы дистилляции, но мы не будем углубляться в эту тему. Главное помнить, что сильная модель в качестве "учителя" может сдвинуть модель "ученика" с позиции [маленький, дешевый и быстрый] + (после десятичной или дробной дроби) немного меньше, чем Превращается в [маленький, дешевый, быстрый] + грозный . Дистилляция превращает сильные модели в золотые рудники. Дилан объясняет, почему это имеет смысл для комбинации Opus 3.5-Sonnet 3.6 от Anthropic:

(Стоимость вывода (нового Sonnet по сравнению со старым) существенно не изменилась, но производительность модели улучшилась. Зачем выпускать 3.5 Opus с точки зрения стоимости, если можно получить 3.5 Sonnet путем посттренинга с 3.5 Opus?

Вернемся к вопросу стоимости: дистилляция контролирует расходы на вывод, повышая при этом производительность. Это напрямую решает основную проблему, о которой сообщал Bloomberg, и Anthropic решила не выпускать Opus 3.5 не только из-за его неудовлетворительных результатов, но и из-за его более высокой внутренней стоимости. (Дилан отмечает, что именно поэтому сообщество разработчиков с открытым исходным кодом быстро догоняет GPT-4 - они берут золото прямо из золотой жилы OpenAI).

Самое удивительное откровение? Сонет 3.6 не просто превосходен - он достигает верхний уровень . За пределами GPT-4o. Средняя модель Anthropic выигрывает у флагмана OpenAI, перегоняя Opus 3.5 (и, вероятно, по другим причинам; пять месяцев - достаточно долгий срок в искусственном интеллекте). Внезапно восприятие высокой стоимости как синонима высокой производительности начало рушиться.

Что случилось с эпохой "больше - значит лучше", которая, как предупреждает генеральный директор OpenAI Сэм Альтман, закончилась? Я писал об этом. Когда ведущие лаборатории стали скрытными, они перестали делиться цифрами параметров. Размеры параметров перестали быть надежными, и мы разумно переключились на эталонную производительность. Последний публично доступный размер параметров от OpenAI составлял 175 миллиардов для GPT-3 в 2020 году. В июне 2023 года появились слухи, что GPT-4 - это гибридная экспертная модель с ~1,8 триллиона параметров. Последующая детальная оценка Semianalysis подтвердила, что GPT-4 имеет 1,76 триллиона параметров, в июле 2023 года. Последующая детальная оценка Semianalysis подтвердила, что GPT-4 имеет 1,76 триллиона параметров, в июле 2023 года.

До декабря 2024 года - полтора года спустя - Эге Эрдил, исследователь из EpochAI, организации, занимающейся изучением будущего влияния ИИ, оценивает, что шкалы параметров пограничных моделей, включая GPT-4o и Sonnet 3.6, значительно меньше, чем у GPT-4 (хотя оба эталона превосходят GPT-4):

... Современные пограничные модели, такие как GPT-4o первого поколения и Claude 3.5 Sonnet, могут быть на порядок меньше, чем GPT-4: у 4o около 200 миллиардов параметров, а у 3.5 Sonnet - около 400 миллиардов... Хотя грубость оценки может привести к ошибкам до двух раз.

Он подробно объясняет, как он пришел к этому числу, не раскрывая архитектурных деталей, но для нас это не важно. Главное, что туман рассеивается: Anthropic и OpenAI, похоже, движутся по схожим траекториям. Их последние модели не только лучше, но и меньше и дешевле своих предшественников. Мы знаем, что Anthropic добилась этого, перегнав Opus 3.5. Но что сделала OpenAI?

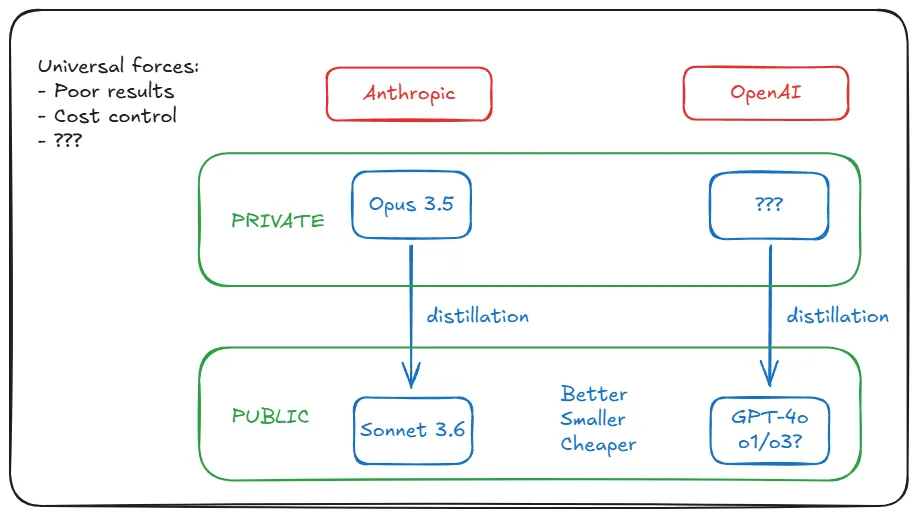

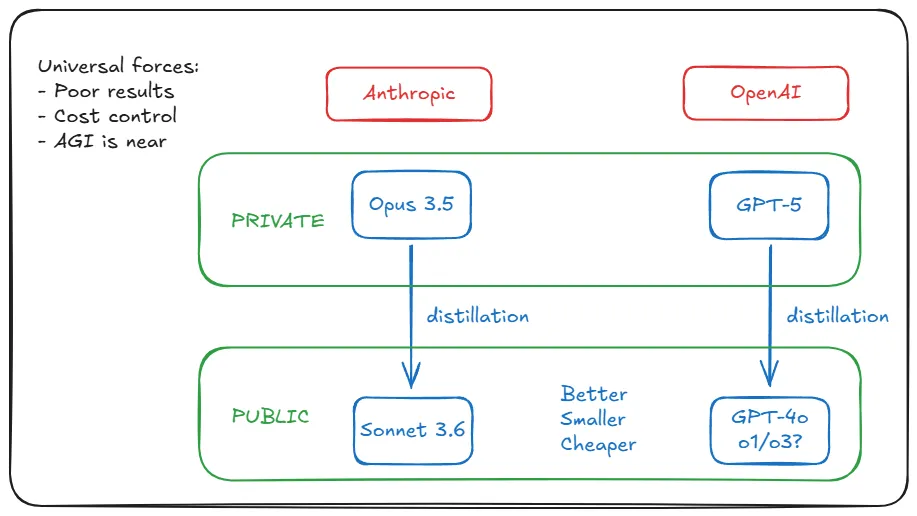

III. Лаборатории ИИ движимы универсализмом

Можно подумать, что стратегия дистилляции Anthropic обусловлена уникальной ситуацией, а именно плохими результатами обучения Opus 3.5. Но на самом деле ситуация Anthropic не уникальна, и последние результаты обучения Google DeepMind и OpenAI столь же неудовлетворительны. (Обратите внимание, что плохие результаты - это не то же самое, что Модель еще хуже. ) Причины нам не важны: уменьшение отдачи из-за недостатка данных, присущие архитектуре трансформера ограничения, плато закона масштабирования перед обучением и т.д. В любом случае, конкретный контекст Антропика на самом деле универсален.

Но помните, что по данным Bloomberg: показатели эффективности хороши лишь настолько, насколько велики затраты. Является ли это еще одним общим фактором? Да, и Эге объясняет, почему: всплеск спроса после бума ChatGPT/GPT-4. Генеративный ИИ распространяется с такой скоростью, что лабораториям трудно выдерживать потери от постоянного расширения. Это вынудило их снизить затраты на вывод (обучение проводится только один раз, затраты на вывод растут с ростом количества пользователей и их использования). Если каждую неделю продуктом пользуются 300 миллионов пользователей, операционные расходы могут внезапно стать фатальными.

Факторы, побудившие Anthropic усовершенствовать Sonnet 3.6 с помощью дистилляции, влияют на OpenAI с экспоненциальной интенсивностью. Дистилляция эффективна, потому что превращает эти две повсеместные проблемы в сильные стороны: решение проблемы стоимости выводов путем предоставления небольших моделей, при этом не выпуская больших моделей, чтобы избежать реакции общественности на посредственную производительность.

Эге считает, что OpenAI может выбрать альтернативу: переобучение. То есть обучение большего количества данных с использованием меньших моделей в не оптимальном с вычислительной точки зрения состоянии: "Когда выводы составляют большую часть расходов модели, лучше... обучать больше токенов с меньшими моделями". Но переобучение уже нецелесообразно. Когда выводы составляют большую часть расходов модели, лучше обучать больше токенов на меньших моделях". Но переобучение больше невозможно; у AI Labs закончились высококачественные данные для предварительного обучения, что недавно признали и Элон Маск, и Илья Суцкевер.

Возвращаясь к дистилляции, Эге заключает: "Я думаю, что, скорее всего, и GPT-4o, и Claude 3.5 Sonnet были переработаны из более крупных моделей".

Все подсказки до этого момента указывают на то, что OpenAI делает то же самое, что и Anthropic с Opus 3.5 (обучать и прятать), тем же способом (дистилляция) и по тем же причинам (плохие результаты/контроль затрат). Это открытие. Но вот в чем дело: Opus 3.5 но Где спрятаны аналоги OpenAI? Может быть, они спрятаны в подвале компании? Осмелитесь ли вы угадать его название...

IV. Пионеры должны расчистить путь

Я начинаю анализ с рассмотрения события Opus 3.5 компании Anthropic, которое более прозрачно в своей информации. Затем я переношу концепцию дистилляции на OpenAI, объясняя, что те же основополагающие силы, которые движут Anthropic, действуют и на OpenAI, но наша теория наталкивается на новое препятствие: будучи первопроходцем, OpenAI может столкнуться с препятствиями, с которыми Anthropic еще не сталкивалась.

Например, аппаратные требования для обучения GPT-5. Sonnet 3.6 сопоставим с GPT-4o, но он вышел на пять месяцев позже. Следует предположить, что GPT-5 находится на более высоком уровне: мощнее и крупнее. Выше не только стоимость обоснования, но и стоимость обучения. Затраты на обучение могут составить полмиллиарда долларов. Возможно ли достичь этого с помощью существующего оборудования?

Эге в очередной раз разгадывает: это возможно. Предложить такую громадину 300 миллионам пользователей нереально, но обучение - не проблема:

В принципе, существующего оборудования достаточно для поддержки моделей гораздо большего размера, чем GPT-4: например, модели с 100 триллионами параметров, которая в 50 раз больше GPT-4, со стоимостью вывода около $3000/миллион выходных жетонов и скоростью вывода 10-20 жетонов/секунду. Но для того, чтобы это было осуществимо, большие модели должны создавать значительную экономическую ценность для клиентов.

Но даже Microsoft, Google или Amazon (владельцы OpenAI, DeepMind и Anthropic соответственно) не могут позволить себе подобные умозаключения. Решение простое: если они планируют выложить в открытый доступ триллионы параметрических моделей, им придется "создать значительную экономическую ценность". Поэтому они этого не делают.

Они обучили модель. Обнаружили "лучшую производительность по сравнению с существующими продуктами". Но вынуждены признать, что "она недостаточно улучшена, чтобы оправдать огромные затраты на ее поддержание в рабочем состоянии". (Звучит знакомо? Месяц назад Wall Street Journal сообщил о GPT-5 в выражениях, поразительно похожих на отчет Bloomberg об Opus 3.5).

Они сообщают о посредственных результатах (с возможностью корректировки изложения). Сохраните их внутри компании в качестве моделей преподавателей, чтобы отсеять модели студентов. Затем выпустить последних. Мы получаем Sonnet 3.6 и GPT-4o, o1 и т. д. и радуемся их дешевому качеству. Ожидания от Opus 3.5 и GPT-5 остаются неизменными, даже когда мы становимся все более нетерпеливыми. Их золотая жила продолжает сиять.

В. Конечно, у вас есть еще причины, мистер Альтман!

В. Конечно, у вас есть еще причины, мистер Альтман!

Когда я зашел так далеко в своем расследовании, я все еще не был полностью убежден. Действительно, все факты говорят о том, что это вполне правдоподобно для OpenAI, но между "правдоподобно" или даже "правдоподобно" и "реально" все еще есть пропасть. Я не собираюсь заполнять этот пробел за вас - в конце концов, это всего лишь предположение. Но я могу еще больше усилить аргументацию.

Есть ли еще доказательства того, что OpenAI действует подобным образом? Есть ли у них другие причины задерживать выпуск GPT-5, кроме низкой производительности и растущих убытков, и какую информацию мы можем извлечь из публичных заявлений руководителей OpenAI о GPT-5? Не рискуют ли они нанести репутационный ущерб, постоянно откладывая выпуск модели? В конце концов, OpenAI - это лицо революции ИИ, а Anthropic работает в ее тени. Anthropic может позволить себе действовать подобным образом, но как насчет OpenAI? Возможно, не без цены.

Раз уж речь зашла о деньгах, давайте разберемся в некоторых важных деталях партнерства OpenAI с Microsoft. Во-первых, общеизвестный факт: статьи AGI. В блоге OpenAI, посвященном их структуре, говорится о пяти положениях об управлении, которые определяют их деятельность, отношения с некоммерческими организациями, отношения с советом директоров и отношения с Microsoft. Пятый пункт определяет AGI как "высокоавтономную систему, способную превзойти человека в большинстве экономически ценных начинаний" и устанавливает, что как только совет директоров OpenAI объявит, что AGI реализована, "система будет исключена из лицензирования интеллектуальной собственности и других коммерческих условий с Microsoft, которые подчиняются только условиям лицензии Microsoft и другим коммерческим условиям". другие коммерческие условия с Microsoft, которые применяются только к технологиям до AGI".

Нет необходимости говорить о том, что ни одна из компаний не хочет разрыва партнерства. openAI устанавливает условия, но делает все возможное, чтобы избежать необходимости их выполнять. Один из способов сделать это - отложить выпуск систем, которые могут быть названы AGI. "Но ведь GPT-5 - это точно не AGI", - скажете вы. И вот второй факт, о котором почти никто не знает: у OpenAI и Microsoft есть секретное определение AGI, которое, хотя и не имеет значения для научных целей, юридически определяет их партнерство: AGI - это "система ИИ, способная генерировать не менее 100 миллиардов долларов прибыли". AGI - это система ИИ, "способная генерировать не менее 100 миллиардов долларов прибыли".

Если OpenAI гипотетически отложит релиз под предлогом того, что GPT-5 не готов, они добьются еще кое-чего, кроме контроля над расходами и предотвращения реакции общественности: они избегут объявления о том, соответствует ли система порогу классификации AGI или нет. Хотя 100 миллиардов долларов - это ошеломляющая цифра, ничто не мешает амбициозным заказчикам получить такую прибыль. С другой стороны, давайте проясним: если OpenAI предскажет, что GPT-5 будет приносить 100 миллиардов долларов повторяющегося дохода в год, они не будут возражать против включения положения об AGI и расставания с Microsoft.

Большая часть реакции общественности на то, что OpenAI не выпустила GPT-5, основывалась на предположении, что они не выпускают его, потому что он недостаточно хорош. Даже если бы это было правдой, ни один скептик не перестает думать о том, что у OpenAI может быть лучше внутреннее применение, чем внешнее. Существует огромная разница между созданием отличной модели и созданием отличной модели, которая может дешево обслужить 300 миллионов человек. Если вы не можете этого сделать, вы не будете этого делать. Но опять же, если вы ненужное Сделайте это, и вы не будете делать этого. Раньше они предоставляли нам свои лучшие модели, потому что им нужны были наши данные. Теперь это уже не так необходимо. И они больше не гонятся за нашими деньгами. Это дело Microsoft, а не их. Они хотят AGI, потом ASI. Они хотят оставить после себя наследие.

VI. Почему это все меняет

Мы подходим к концу. Я считаю, что привел достаточно аргументов, чтобы выстроить твердый тезис: очень вероятно, что OpenAI уже имеет GPT-5 в своем распоряжении, так же как Anthropic имеет Opus 3.5. Возможно даже, что OpenAI никогда не выпустит GPT-5. Общественность теперь измеряет производительность в терминах o1/o3, а не только в GPT-4o или Claude Sonnet 3.6. Поскольку OpenAI исследует закон масштабирования в тестировании, планка, которую нужно преодолеть для GPT-5, продолжает расти. Как они смогут выпустить GPT-5, который действительно превзойдет o1, o3 и грядущие модели серии o, особенно если они будут выпускать их в таком быстром темпе? Кроме того, им больше не нужны ни наши деньги, ни данные.

Обучение новым базовым моделям - GPT-5, GPT-6 и более поздним - всегда имеет смысл внутри OpenAI, но не обязательно в качестве продукта. С этим, вероятно, покончено. Единственная важная цель для них сейчас - продолжать генерировать лучшие данные для следующего поколения моделей. Отныне базовая модель может работать в фоновом режиме, давая возможность другим моделям совершать подвиги, которых они не могли бы достичь самостоятельно, - как старик-затворник, передающий мудрость из тайной пещеры, только эта пещера - гигантский центр обработки данных. Независимо от того, видим мы его или нет, мы испытаем на себе последствия его мудрости.

Даже если GPT-5 в конце концов будет выпущен, этот факт вдруг покажется почти неважным. Если OpenAI и Anthropic действительно выйдут на рынок Рекурсивное самосовершенствование (хотя все еще с участием человека), тогда уже не будет иметь значения, что они сообщают нам публично. Они будут уходить все дальше и дальше вперед - точно так же, как Вселенная расширяется так быстро, что свет от далеких галактик уже не может достичь нас.

Может быть, именно поэтому OpenAI всего за три месяца перескочила с o1 на o3. И именно поэтому они переходят к o4 и o5. Возможно, именно поэтому они так радуются в социальных сетях в последнее время. Потому что они внедрили новый и улучшенный режим работы.

Вы действительно думаете, что близость к AGI означает, что вы сможете использовать все более мощный ИИ? Что они будут выпускать все новые разработки, чтобы мы могли ими пользоваться? Конечно, вы в это не поверите. Они имели в виду это, когда впервые заявили, что их модели продвинут их так далеко, что никто другой не сможет их догнать. Каждое новое поколение моделей - это двигатель, развивающий скорость бегства. Из стратосферы они помахали на прощание.

Пока неясно, вернутся ли они.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...