EmotiVoice: механизм преобразования текста в речь с управлением несколькими голосами и эмоциональными подсказками

Общее введение

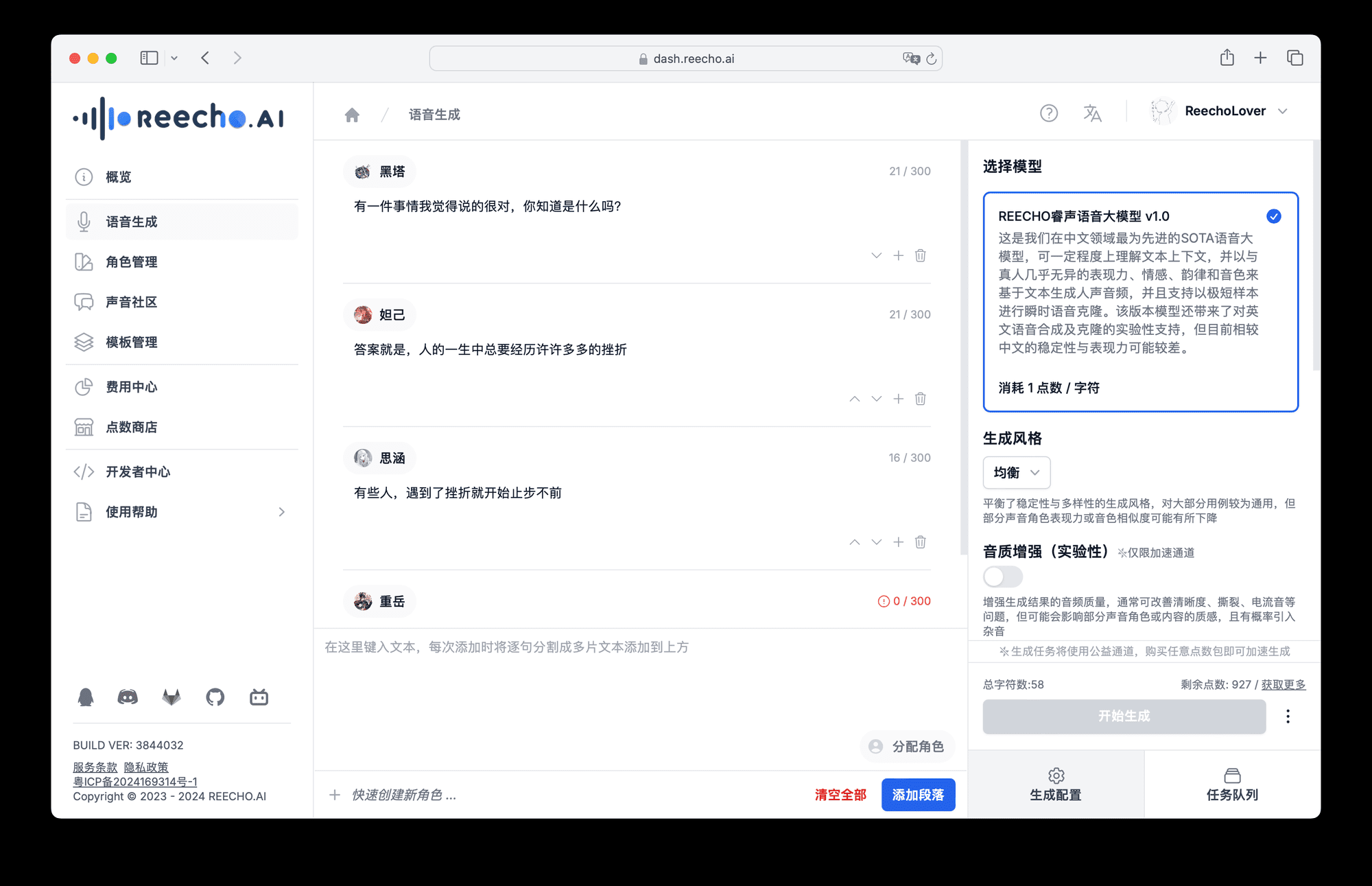

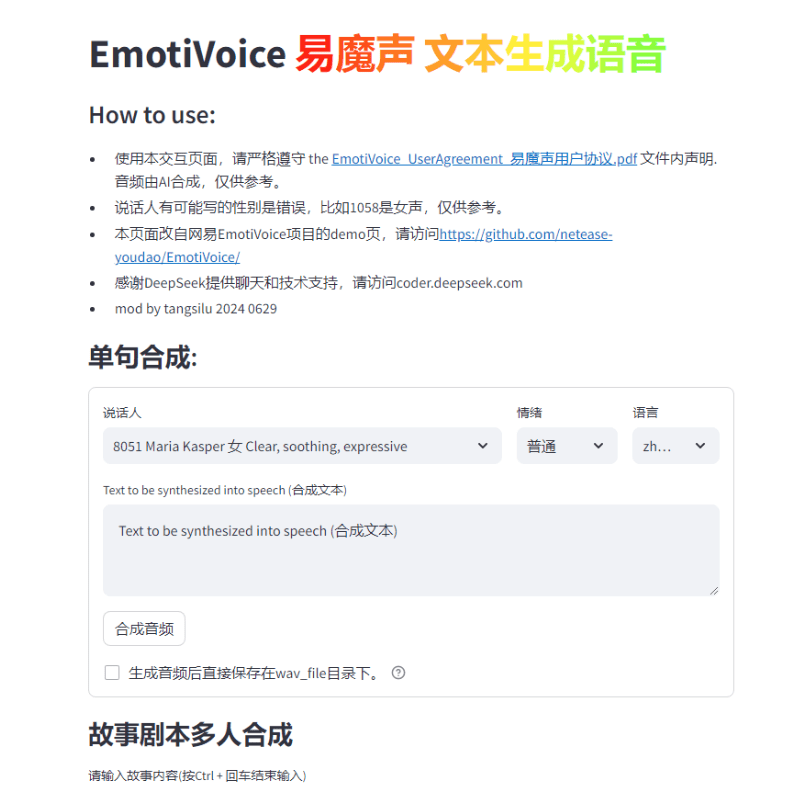

EmotiVoice - это движок преобразования текста в речь (TTS) с несколькими голосами и управлением эмоциональными подсказками, разработанный компанией NetEaseYoudao. Этот TTS-движок с открытым исходным кодом поддерживает английский и китайский языки, имеет более 2000 различных голосов и обладает возможностями синтеза эмоций для создания голосов с различными эмоциями, такими как счастье, возбуждение, грусть и гнев. Он предоставляет простой в использовании WEB-интерфейс и результаты пакетной генерации скриптового интерфейса.

Проводится по демонстрационному адресу Replicate

Список функций

Обеспечение WEB-интерфейса и интерфейса пакетной обработки сценариев

Поддержка синтеза эмоций

Несколько вариантов звучания

Поддержка китайского и английского синтеза

Использование помощи

Ознакомьтесь с репозиторием GitHub для получения инструкций по установке и использованию.

Запуск образа Docker для опробования EmotiVoice

Обратитесь к странице Wiki, чтобы загрузить дополнительную информацию, например, предварительно обученные модели.

Присоединяйтесь к группе WeChat для обмена отзывами

По многочисленным просьбам пользователей мы рады выпуститьФункция клонирования звукаи содержит два примера учебников!

Примечания.

- Для этой функции требуется как минимум один Графические процессоры Nvidia .

- звук целиДанные имеют решающее значение! Подробные требования будут приведены в следующем разделе.

- В настоящее время эта функция поддерживается только на китайском и английском языках, что означает, что вы можете тренироваться как на китайских, так и на английских данных.Приобретите модель тембра, которая может говорить на двух языках.

- Хотя EmotiVoice поддерживает эмоциональный контроль, данные для обучения также должны быть эмоциональными, если вы хотите, чтобы ваш голос передавал эмоции.

- После обучения с использованием только ваших данных, EmotiVoice изОригинальный звук будет изменен. Это означает, что новая модель будет полностью адаптирована к вашим данным. Если вы хотите использовать 2000 с лишним оригинальных голосов EmotiVoice, рекомендуется использовать оригинальную предварительно обученную модель.

Подробные требования к данным для обучения

- Аудиоданные должны быть высокого качества и должны быть четкими и без искажений для голоса одного человека. Продолжительность или количество предложений пока не обязательны, несколько предложений вполне подойдут, но рекомендуется более 100 предложений.

- Текст, соответствующий каждой аудиозаписи, должен строго соответствовать содержанию речи. Перед обучением исходный текст преобразуется в фонемы с помощью программы G2P. Необходимо обратить внимание на паузы (sp*) и результаты полифонического преобразования, они оказывают значительное влияние на качество обучения.

- Если вы хотите, чтобы ваш голос передавал эмоции, учебные данные тоже должны быть эмоциональными. Кроме того, содержание **tag 'prompt'** должно быть изменено для каждого аудио. Содержание подсказки может включать в себя любое текстовое описание эмоций, темпа речи и стиля речи.

- Затем вы получите файл под названием

data directoryкаталог, который содержит два подкаталога, thetrainответить пениемvalid. Каждый подкаталог имеетdatalist.jsonlфайл, и каждая строка отформатирована:{"key": "LJ002-0020", "wav_path": "data/LJspeech/wavs/LJ002-0020.wav", "speaker": "LJ", "text": ["<sos/eos>", "[IH0]", "[N]", "engsp1", "[EY0]", "[T]", "[IY1]", "[N]", "engsp1", "[TH]", "[ER1]", "[T]", "[IY1]", "[N]", ".", "<sos/eos>"], "original_text": "In 1813", "prompt": "common"}.

Распределение шагов обучения.

Для китайцев, пожалуйста, обратитесь к Рецепт DataBakerПожалуйста, обратитесь к английской версии:Рецепт LJSpeech. Ниже приводится краткое описание:

- Подготовьте учебную среду - ее нужно настроить только один раз.

# create conda enviroment conda create -n EmotiVoice python=3.8 -y conda activate EmotiVoice # then run: pip install EmotiVoice[train] # or git clone https://github.com/netease-youdao/EmotiVoice pip install -e .[train]

- консультация Подробные требования к учебным данным Выполните подготовку данных, рекомендуемые справочные примерыРецепт DataBaker ответить пением Рецепт LJSpeechметоды и сценарии в

- Затем выполните следующую команду, чтобы создать каталог для обучения:

python prepare_for_training.py --data_dir <data directory> --exp_dir <experiment directory>. Замена<data directory>для фактического пути к каталогу подготовленных данных.<experiment directory>это желаемый путь к экспериментальному каталогу. - Может быть изменен в зависимости от конфигурации сервера и данных

<experiment directory>/config/config.py. После завершения модификаций запустите процесс обучения, выполнив следующую командуtorchrun --nproc_per_node=1 --master_port 8018 train_am_vocoder_joint.py --config_folder <experiment directory>/config --load_pretrained_model True. (Эта команда запустит процесс обучения с использованием указанной папки конфигурации и загрузит все указанные предварительно обученные модели). Этот метод в настоящее время доступен для Linux, в Windows могут возникнуть проблемы! - После завершения некоторых этапов обучения выберите контрольную точку и выполните следующую команду, чтобы убедиться, что результаты соответствуют ожиданиям:

python inference_am_vocoder_exp.py --config_folder exp/DataBaker/config --checkpoint g_00010000 --test_file data/inference/text. Не забудьте изменитьdata/inference/textСодержимое поля динамика в Если вы довольны результатом, смело используйте его! Мы предоставляем модифицированную версию демонстрационной страницы.demo_page_databaker.pyПриходите и оцените эффект тона после клонирования с помощью DataBaker. - Если результаты неудовлетворительны, вы можете продолжить обучение или проверить свои данные и окружение. Конечно, не стесняйтесь обсуждать это в сообществе или подавать заявки!

Справочная информация о времени выполнения.

Для справки мы приводим следующую информацию о времени работы и конфигурации оборудования:

- Версии пакетов Pip: Python 3.8.18, torch 1.13.1, cuda 11.7

- Модель карты GPU: NVIDIA GeForce RTX 3090, NVIDIA A40

- Тренировки занимают много времени: для тренировки 10 000 шагов требуется около 1-2 часов.

Он может обучаться даже без графической карты GPU, используя только центральный процессор. Ждите хороших новостей!

Адрес загрузки установочного пакета одним щелчком мыши

Облачный диск windows thunderbolt

Программа установки в один клик для Mac

Пароль для распаковки zip - jian27 или jian27.com

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...