Dolphin: распознавание азиатских языков и моделирование преобразования речи в текст для азиатских языков

Общее введение

Dolphin - это модель с открытым исходным кодом, разработанная DataoceanAI в сотрудничестве с Университетом Цинхуа и ориентированная на распознавание речи и языков Азии. Она поддерживает 40 языков из Восточной Азии, Южной Азии, Юго-Восточной Азии и Ближнего Востока, а также 22 китайских диалекта. Модель обучена на более чем 210 000 часах аудиоданных, объединяющих собственные и общедоступные наборы данных. Dolphin может преобразовывать речь в текст, а также определять части речи (VAD), сегментировать аудио и распознавать язык (LID). Он спроектирован просто, а код и некоторые модели находятся в свободном доступе на GitHub для разработчиков.

Список функций

- Поддерживает преобразование речи в текст на 40 азиатских языках и 22 китайских диалектах.

- Функция распознавания голосовой активности (VAD) позволяет находить речевые сегменты в аудиозаписях.

- Поддержка разделения аудио, разрезание длинного аудио на небольшие сегменты для обработки.

- Внедрите функцию идентификации языка (LID) для определения языка или диалекта аудиозаписи.

- Открытый исходный код и модели, позволяющие пользователям изменять и настраивать их.

- Есть две модели - базовая и малая - для разных потребностей.

- Используйте двухуровневую систему маркировки, различающую языки и регионы (например.

<zh><CN>).

Использование помощи

Процесс установки и использования Dolphin прост и подходит для пользователей с базовыми навыками программирования. Ниже приведены подробные шаги.

Процесс установки

- Подготовка среды

Требуется Python 3.8 или выше, а также FFmpeg для обработки аудио.- Проверка Python: В терминале введите

python --version, подтверждая версию. - Python не устанавливается и может быть загружен с сайта python.org.

- Установите FFmpeg: выполните команду, соответствующую вашей системе:

- Ubuntu/Debian:

sudo apt update && sudo apt install ffmpeg - macOS:

brew install ffmpeg - Окна:

choco install ffmpeg

Неустановленные инструменты управления пакетами можно загрузить с сайта FFmpeg.

- Ubuntu/Debian:

- Проверка Python: В терминале введите

- Установка Dolphin

Есть два способа:- Установите с помощью pip

Введите его в терминал:pip install -U dataoceanai-dolphinЭто позволит установить последнюю стабильную версию.

- Установка из исходного кода

Чтобы использовать последнюю версию разработки, возьмите ее с GitHub:- Хранилище клонирования:

git clone https://github.com/DataoceanAI/Dolphin.git - Перейдите в каталог:

cd Dolphin - Установка:

pip install .

- Хранилище клонирования:

- Установите с помощью pip

- Скачать модели

Dolphin имеет 4 модели, в настоящее время для бесплатной загрузки доступны базовая (140М параметров) и малая (372М параметров).- через (щель) Обнимающееся лицо Получите файл модели.

- Сохраните по указанному пути, например

/data/models/dolphin/. - Базовая модель работает быстрее, а маленькая модель - точнее.

Использование

Поддерживаются операции командной строки и Python.

работа в командной строке

- Передача речи в текст

Подготовьте аудиофайл (например.audio.wav), введите:

dolphin audio.wav

Система автоматически загружает модель по умолчанию и выводит текст. Аудио должно быть в формате WAV и может быть преобразовано с помощью FFmpeg:

ffmpeg -i input.mp3 output.wav

- Определение моделей и путей

Используйте маленькую модель:

dolphin audio.wav --model small --model_dir /data/models/dolphin/

- Укажите язык и регион

Распознавание китайского языка с помощью двухслойных маркеров:

dolphin audio.wav --model small --model_dir /data/models/dolphin/ --lang_sym "zh" --region_sym "CN"

lang_symкод языка, например "zh" (китайский).region_symкод региона, например, "CN" (материковый Китай).

Полный список языков см. languages.md.

- Заполнить короткое аудио

Доступно, если продолжительность аудио составляет менее 30 секунд--padding_speech trueНачинка:

dolphin audio.wav --model small --model_dir /data/models/dolphin/ --lang_sym "zh" --region_sym "CN" --padding_speech true

Манипулирование кодом Python

- Загрузка аудио и моделей

Работает на языке Python:

import dolphin

waveform = dolphin.load_audio("audio.wav") # 加载音频

model = dolphin.load_model("small", "/data/models/dolphin/", "cuda") # 加载模型

"cuda"с GPU, без GPU измените на"cpu".

- Признание руководителей

Обрабатывает аудио и выводит его:result = model(waveform) # 转文本 print(result.text) # 显示结果 - Укажите язык и регион

Добавьте параметры:result = model(waveform, lang_sym="zh", region_sym="CN") print(result.text)

Функциональное управление

- Обнаружение голосовой активности (VAD)

Автоматически распознает сегменты речи и маркирует их, например, по времени:0.0-2.5s: 你好 3.0-4.5s: 今天天气很好 - Идентификация языка (LID)

Определите язык звука, например:dolphin audio.wav --model small --model_dir /data/models/dolphin/выход в виде

<zh>(китайский) или<ja>(японский). - двуязычная разметка

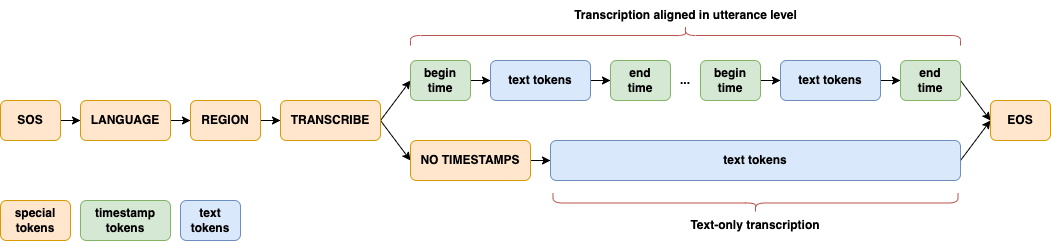

Различайте языки и регионы с помощью двухуровневой маркировки, например.<zh><CN>(на китайском языке),<zh><TW>(тайваньский мандарин) для развития навыков работы с азиатскими языками. - архитектура модели

Архитектура CTC-Attention с E-Branchformer для кодера и Transformer для декодера оптимизирована для азиатских языков.

сценарий применения

- материалы

Преобразует записи азиатских многоязычных конференций в текст, подходящий для международных или местных встреч. - изучение диалектов

Проанализировать фонологические особенности 22 китайских диалектов и получить данные для исследования. - Разработка интеллектуальных устройств

Интеграция в смарт-устройства для голосового управления на азиатских языках.

QA

- Какие языки поддерживаются?

Поддержка 40 азиатских языков и 22 диалектов китайского языка, см. languages.md. - Нужен графический процессор?

Не требуется. Процессор может работать, GPU (поддержка CUDA) работает быстрее. - В чем разница между базовой и маленькой моделями?

Базовая модель - малая (140 М параметров) с коэффициентом ошибок 33,31 TP3T; малая модель - большая (372 М параметров) с коэффициентом ошибок 25,21 TP3T.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...