DeepSeek выпускает унифицированные мультимодальные модели понимания и генеративные модели: от JanusFlow до Janus-Pro

JanusFlow Speed Reading

DeepSeek Команда выпустила еще одну новую модель, запустив рано утром 28-го числа инновационный мультимодальный фреймворк Janus-Pro, который представляет собой единую модель, способную решать задачи как мультимодального восприятия, так и генерации. Построенная на базе DeepSeek-LLM-1.5b-base/DeepSeek-LLM-7b-base, модель поддерживает ввод изображений 384 x 384 и использует специальный токенизатор для генерации изображений. Наиболее важной особенностью является разделение визуального кодирования на отдельные каналы при сохранении единого трансформатор архитектура для обработки.

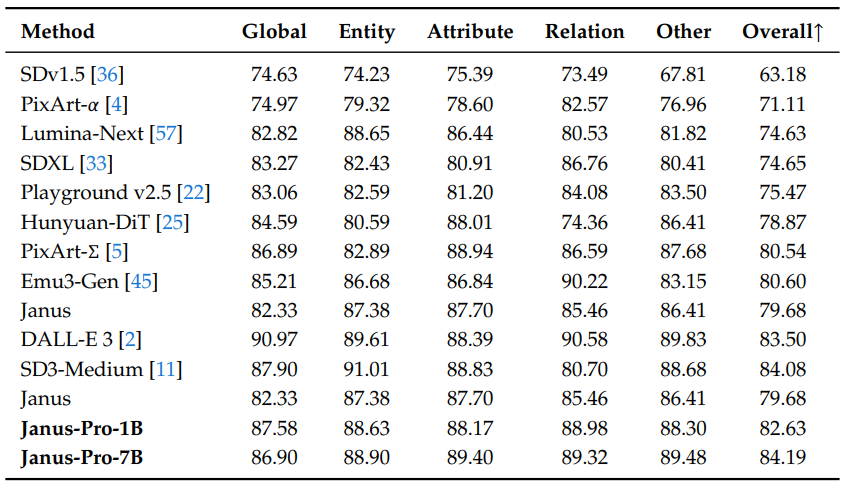

Этот инновационный дизайн не только решает проблему противоречивых ролей традиционных моделей в визуальных кодировщиках, но и делает всю систему более гибкой. На практике Janus-Pro превосходит предыдущие унифицированные модели, а в некоторых задачах даже конкурирует со специализированными моделями, основанными на задачах. Она обошла DALL-E 3 и Stable Diffusion от OpenAI в бенчмарках GenEval и DPG-Bench.

Модельный ряд Janus, начавшийся с модели JanusFlowВ рамках проекта "Удивительный мир", направленного на созданиеЕдиная структура для мультимодального понимания и генерацииОсновная идея заключается в объединении авторегрессионной модели языка (LLM) с моделью генерации ректифицированного потока. Основная идея заключается в объединении авторегрессионной модели языка (LLM) с моделью генерации ректифицированного потока, что позволяет достичь превосходного визуального понимания и высококачественной генерации изображений в рамках одной модели.Janus-Pro Являясь усовершенствованной версией Janus, модель Janus была дополнительно улучшена за счет всесторонней оптимизации стратегии обучения, объема данных и размерности модели и достигла значительного прогресса в нескольких эталонных тестах. В этой статье мы систематически рассматриваем эволюцию модели Janus от JanusFlow до Janus-Pro, уделяя особое внимание ее функциональности, характеристикам параметров и ключевым улучшениям.

1. JanusFlow: краеугольный камень унифицированной архитектуры

бумажный адрес:: https://arxiv.org/pdf/2411.07975

JanusFlow Основная инновация - этоМинималистская унифицированная архитектураОна ловко интегрирует модифицированную модель генерации потока в авторегрессионную систему LLM без необходимости внесения сложных изменений в структуру LLM. Основные особенности этой архитектуры включают:

- Исправлено формирование потокового изображения: JanusFlow использует модифицированную модель потока для генерации изображений, начиная с гауссовского шума, итеративно предсказывая векторы скорости для обновления представления скрытого пространства изображения и, в конечном счете, генерируя высококачественные изображения с помощью декодера. Этот подход позволяет избежать ограничений традиционных методов, в которых LLM действует только как условный генератор и не имеет возможности прямого генерирования.

- Отключаемый визуальный кодер: Чтобы оптимизировать производительность унифицированной модели, JanusFlow используетРазвязанный кодировщикСтратегия заключается в том, что для выполнения задачи понимания и задачи генерации используются отдельные визуальные кодеры, соответственно:

- Понимание кодирующих устройств (fenc): Использование предварительно обученных SigLIP-Large-Patch/16 модель, которая отвечает за извлечение семантических особенностей изображений для улучшения мультимодального понимания.

- Создайте кодер (genc) и декодер (gdec): обучение скретчу ConvNeXt модуль, предназначенный для решения задач генерации изображений с целью оптимизации качества генерации.

- Механизмы выравнивания репрезентаций: В процессе обучения унификации JanusFlow вводитвыравнивание характерамеханизм, который выравнивает промежуточные представления модулей генерации и понимания, тем самым повышая семантическую согласованность и последовательность в процессе генерации.

- Трехфазная стратегия обучения: Компания JanusFlow разработала подробную трехступенчатую программу обучения:

- Этап 1: случайная инициализация Адаптация компонентов - Линейный слой, генераторный кодер и декодер обучаются работе с предварительно обученными кодерами LLM и SigLIP в качестве инициализационного этапа для последующего обучения.

- Этап 2: Согласование предварительной подготовки - Обучите всю модель, за исключением визуального кодировщика, объединив мультимодальное понимание, генерацию изображений и обычные текстовые данные, чтобы изначально определить объединяющие возможности модели.

- Этап 3: Тонкая настройка мониторинга - Данные о точной настройке команд используются для дальнейшего обучения модели для улучшения реакции на команды пользователя и для размораживания параметров кодера SigLIP на этом этапе.

Характеристики параметров:

- Foundation LLM: Облегченная архитектура LLM с 1,3 Б параметров.

- Визуальный кодировщик: SigLIP-Large-Patch/16 (понимание), ConvNeXt (генерация кодеров и декодеров).

- Разрешение изображения: 384 × 384 пикселей.

Производительность: JanusFlow достигает значительной производительности в задачах генерации текста в изображение и мультимодального понимания, превосходя многие специализированные модели и доказывая эффективность своей унифицированной архитектуры.

2. Janus-Pro: полное обновление данных, моделей и стратегий

бумажный адрес:: https://github.com/deepseek-ai/Janus/blob/main/janus_pro_tech_report.pdf

Janus-Pro Являясь улучшенной версией Janus, JanusFlow был усовершенствован в трех основных областях:

- Оптимизированные стратегии обучения: Janus-Pro точно настраивает трехступенчатую стратегию обучения JanusFlow, направленную на устранение узких мест в эффективности и производительности обучения:

- Этап 1: Обучение расширенному набору данных ImageNet - Увеличение количества шагов обучения на наборе данных ImageNet позволяет модели более полно изучить зависимости между пикселями, улучшая базовые возможности генерации изображений.

- Этап 2: Сосредоточьтесь на обучении преобразованию данных из текста в изображения - На втором этапе обучения данные ImageNet удаляются и используется непосредственно обычный набор данных "текст-изображение", что позволяет модели более эффективно обучаться генерировать высококачественные изображения на основе плотных текстовых описаний.

- Этап 3: Масштабирование данных - На этапе контролируемой тонкой настройки соотношение данных мультимодального восприятия, обычного текста и данных "текст-изображение" было изменено (с 7:3:10 до 5:1:4), чтобы еще больше повысить эффективность мультимодального восприятия, обеспечив при этом возможность визуальной генерации.

- Расширенные учебные данные: Janus-Pro значительно увеличивает объем и разнообразие обучающих данных, чтобы улучшить способность к обобщению и качество генерации модели:

- Мультимодальное понимание данных: На этапе 2 предварительного обучения было добавлено около 90 миллионов новых образцов, охватывающих более широкий спектр данных о подписях к изображениям (например, YFCC), а также данные о таблицах, графиках и понимании документов (например, Docmatix). На третьем этапе тонкой настройки были добавлены DeepSeek-VL2 Набор данных, а также данные о понимании MEME, китайские диалоги и т.д., что значительно улучшает диалоговые возможности модели и ее многозадачность.

- Визуально созданные данные: Для улучшения эстетического качества и стабильности генерируемых изображений Janus-Pro вводит около 72 миллионов высококачественных синтетических эстетических данных и регулирует соотношение реальных и синтетических данных до 1:1. Эксперименты показывают, что добавление синтетических данных ускоряет сходимость модели и значительно улучшает эстетическое качество и стабильность генерируемых изображений.

- Увеличенный размер модели: Janus-Pro не только сохраняет параметрическую модель JanusFlow на 1,5 ББ, но и расширяет ее, включая 7B Параметрыи предоставляет Серия Janus-Pro в типоразмерах 1,5B и 7B.Экспериментальные результаты показывают, что крупномасштабные LLM могут значительно улучшить производительность модели и ускорить скорость сходимости. Экспериментальные результаты показывают, что крупномасштабные LLM могут значительно улучшить производительность модели и ускорить скорость сходимости, подтверждая масштабируемость архитектуры модели Janus.

Характеристики параметров:

- Размеры модели: Доступны модели размеров 1,5B и 7B.

- Архитектура: Следуйте архитектуре визуального кодера JanusFlow с раздельным управлением.

- Учебные данные: Значительно расширенные и оптимизированные учебные данные для мультимодального понимания и визуальной генерации.

- Разрешение изображения: Разрешение изображения, использовавшегося в экспериментах, оставалось на уровне 384 × 384 пикселей.

Производительность: Janus-Pro продемонстрировал эффективность обновления данных, моделей и стратегий, добившись значительного прироста производительности во всех бенчмарках, особенно в бенчмарке MMBench для мультимодального понимания и бенчмарках GenEval и DPG-Bench для генерации текста в изображения, которые превзошли JanusFlow и другие передовые унифицированные и специализированные модели.

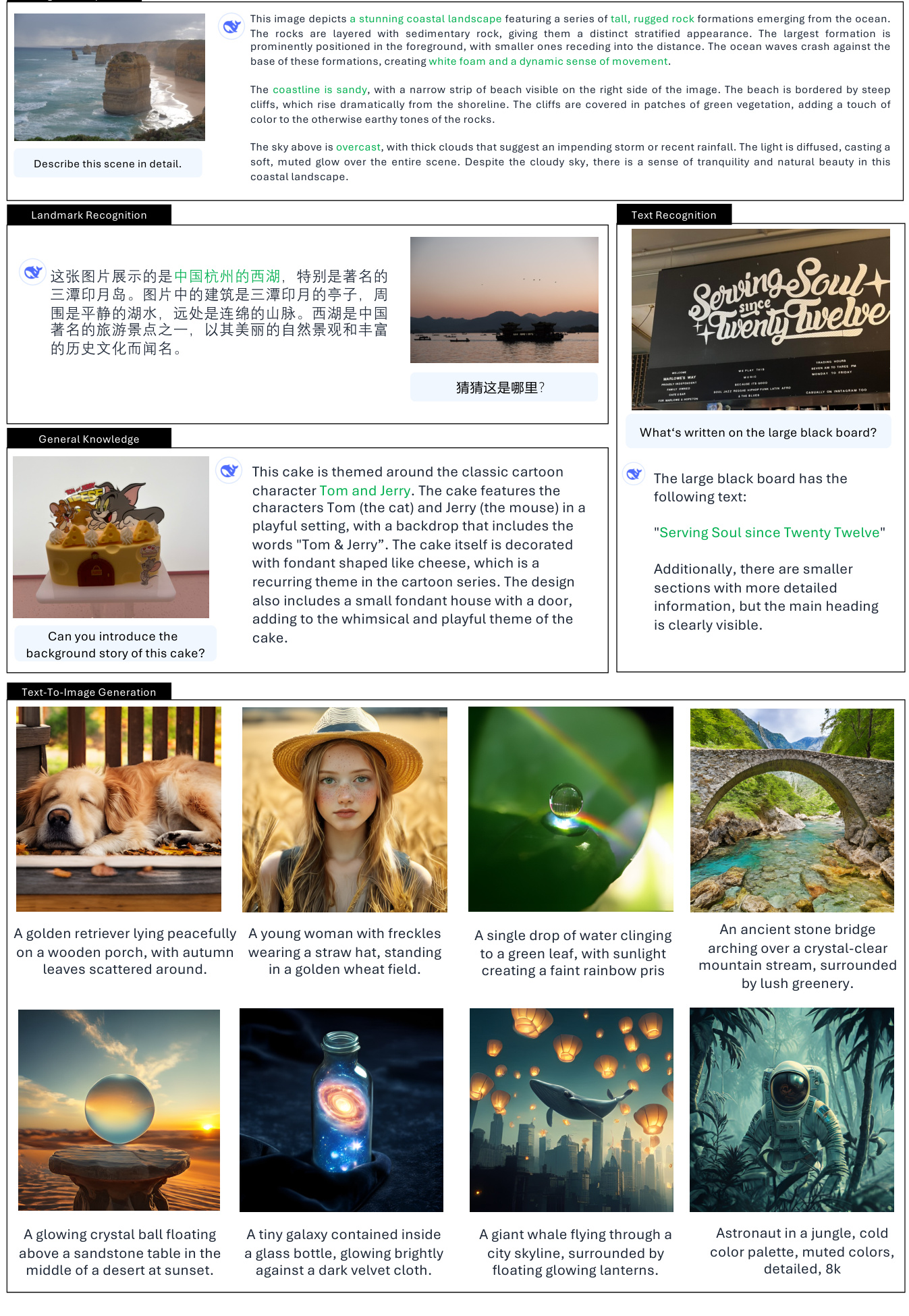

3.Реальные сценарии использования Janus

Функции визуального восприятия:

- Описание изображения/каптирование.

- Подробное описание сцены: позволяет генерировать подробные текстовые описания на основе содержимого изображения, включая элементы сцены, объекты, атмосферу окружающей среды и т. д. (Пример: описание трех бассейнов Западного озера, приморского пейзажа и т. д.) (Пример: описание трех бассейнов Западного озера, приморского пейзажа и т. д.)

- Графическое описание: Уметь понимать и описывать информацию на графиках и диаграммах, например, представлять данные и анализировать тенденции на гистограммах. (Пример: интерпретация гистограммы "Любимые фрукты детей")

- Распознавание/классификация объектов.

- Определять типы объектов на изображении: Уметь определять и перечислять категории объектов, которые появляются на изображении. (Пример: Определите тип фрукта на картинке)

- Подсчет объектов.

- Точный подсчет количества объектов на изображении: способность точно подсчитать количество определенных объектов на изображении. (Пример: подсчитать количество пингвинов на изображении)

- Знаменательное признание.

- Идентифицировать известные достопримечательности на изображениях: Уметь определять достопримечательности или места, которые появляются на изображении. (Пример: Определите три бассейна Западного озера).

- Распознавание текста/OCR.

- Распознавание текстового содержимого на изображениях: уметь распознавать текст на изображениях и извлекать текстовую информацию. (Пример: распознать надпись "Serving Soul since Twenty Twelve" на доске)

- Визуальные ответы на вопросы.

- Отвечать на вопросы, основываясь на содержании изображения: уметь понимать содержание изображения и давать разумный ответ, основываясь на вопросе пользователя. (Пример: спросите "Какой фрукт изображен на картинке?" в ответ на изображение).

- Визуальное мышление/интеграция знаний.

- Понимать значения и ассоциации, стоящие за изображениями: уметь рассуждать визуально на более глубоком уровне и контекстуализировать знания. (Примеры: объяснение юмора изображения собаки Моны Лизы, понимание тематического контекста мультфильма "Торт")

- Генерация кода (Python для черчения).

- Генерируйте код на основе команд пользователя: поймите требования пользователя к построению графиков и сгенерируйте Python-код в соответствии с ними. (Пример: генерирование кода Python для построения гистограммы)

Функция преобразования текста в изображение:

- Генерация изображений с помощью текста.

- Генерируйте изображения на основе текстовых описаний: можно генерировать семантически связанные изображения на основе текстовых подсказок, введенных пользователем.

- Создание творческих образов: способность понимать абстрактные и образные текстовые подсказки для создания творческих и художественных образов. (Примеры: летающий кит, корги из космической туманности и т.д.)

- Генерация стилизованных изображений: генерируйте изображения с определенными художественными стилями в соответствии с описанием стиля в текстовых подсказках. (Примеры: церковь в стиле эпохи Возрождения, горная деревня в стиле китайской живописи тушью и т. д.)

- Генерация простого текста на изображениях: возможность генерировать изображения с простыми текстовыми элементами. (Пример: надпись "Hello" на доске).

Примеры практических сценариев применения:

- Интеллектуальный помощник: выступает в роли мультимодального интеллектуального помощника, который понимает загруженные пользователем изображения и выполняет вопросы и ответы, описание, анализ и т. д.

- Создание контента: помощь создателям контента в быстром создании высококачественных изображений, таких как графика для социальных сетей, иллюстрации к статьям и многое другое.

- Образовательные приложения: используется для обучения распознаванию изображений, обучения интерпретации диаграмм и т.д., чтобы помочь студентам понять визуальную информацию.

- Информационный поиск: обеспечивает более богатые результаты поиска благодаря поиску изображений в сочетании с возможностями понимания и создания текста.

- Художественное творчество: Как творческий инструмент, он помогает художникам создавать изображения и исследовать новые формы визуального выражения.

Характеристики параметров и ограничения, о которых следует знать:

- Ограничения по разрешению изображения: Текущее обучение и тестирование модели в основном основано на изображениях с разрешением 384x384, что может иметь ограничения для сценариев, требующих более высокого разрешения.

- Тонкость детализации: несмотря на то, что изображение семантически насыщенно, возможно, еще есть возможность улучшить тонкость детализации из-за потери разрешения и реконструкции токенизатора зрения, например, небольшие участки лица могут быть недостаточно тонкими.

4. Резюме и перспективы

Семейство моделей Janus, от JanusFlow до Janus-Pro, демонстрирует потенциал для дальнейшего прорыва в области унифицированного мультимодального понимания и генерации. JanusFlow заложил основу для унифицированной архитектуры, а Janus-Pro достиг квантового скачка в производительности благодаря оптимизации стратегии обучения, масштабированию данных и увеличению размера модели. Успех Janus-Pro Успех Janus-Pro подтверждаетРасширения модели, основанные на данных, являются ключом к повышению производительности унифицированных моделейРазвитие семейства моделей Janus не только продвигает прогресс мультимодальных моделей, но и закладывает прочный фундамент для создания более универсальных и интеллектуальных систем ИИ.

Полный текст статьи "Janus-Pro: унифицированная мультимодальная модель понимания и генерации, поддерживаемая данными и расширениями модели

автор: Xiaokang Chen, Zhiyu Wu, Xingchao Liu, Zizheng Pan, Wen Liu, Zhenda Xie, Xingkai Yu, Chong Ruan

страница проекта: https://github.com/deepseek-ai/Janus

рефераты

В этой работе мы представляем Janus-Pro, улучшенную версию предыдущей модели Janus. В частности, Janus-Pro включает в себя (1) оптимизированную стратегию обучения, (2) расширенные обучающие данные и (3) масштабирование до больших размеров модели. Благодаря этим усовершенствованиям Janus-Pro значительно улучшает мультимодальное понимание и возможности следования командам для изображений, созданных текстом, а также повышает стабильность изображений, созданных текстом. Мы надеемся, что эта работа послужит стимулом для дальнейших исследований в этой области. Код и модель находятся в открытом доступе.

1. Введение

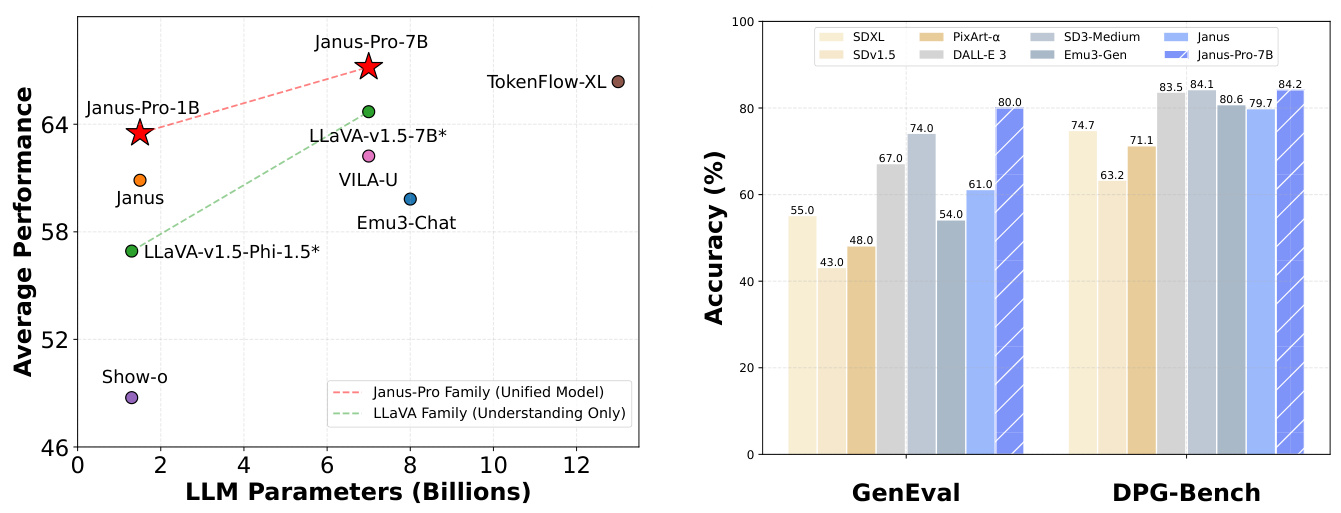

(a) Средние показатели выполнения четырех мультимодальных эталонов понимания. (b) Выполнение инструкции "текст-генератор-изображение" после выполнения контрольного задания.

Рисунок 1 | Результаты мультимодального понимания и визуальной генерации для Janus-Pro. Для мультимодального понимания мы усреднили точность POPE, MME-Perception, GQA и MMMU. Оценка MME-Perception была разделена на 20 для масштабирования в диапазоне [0, 100]. Для визуальной генерации мы оценили производительность бенчмарков GenEval и DPG-Bench, выполняющих команды. В целом, Janus-Pro превосходит предыдущие современные унифицированные мультимодальные модели, а также некоторые модели, ориентированные на конкретные задачи. Наилучшие результаты были получены при просмотре на экране.

1. простая фотография оранжевого мандарина 2. чистая доска с зеленой поверхностью, на которой белым мелом четко и ясно написано слово "Hello" 3. крупный план подсолнуха, символизирующего процветание, с зелеными стеблями и листьями, распустившимися лепестками и пчелой, сидящей на нем и сверкающей в лучах солнца.

Рисунок 2 | Сравнение изображений, сгенерированных с помощью Janus-Pro и его предшественника Janus. Janus-Pro обеспечивает более последовательный вывод коротких подсказок, более высокое визуальное качество, богатую детализацию и возможность генерировать простой текст. Разрешение изображения составляет 384x384, и его лучше всего просматривать на экране.

В последнее время достигнут значительный прогресс в объединении мультимодального понимания и генеративных моделей [30, 40, 45, 46, 48, 50, 54, 55]. Было показано, что эти подходы улучшают соблюдение инструкций в задачах визуального генерирования, одновременно уменьшая избыточность моделей. Большинство из этих подходов используют один и тот же визуальный кодер для обработки входных данных для задач мультимодального понимания и генерации. Это, как правило, приводит к низкой эффективности мультимодального понимания из-за различий в представлениях, необходимых для двух задач. Для решения этой проблемы Янус [46] предложил раздельное визуальное кодирование, которое снимает конфликт между задачами мультимодального понимания и генерации, обеспечивая отличную производительность в обеих задачах.

Как новаторская модель, Janus была проверена на шкале параметров 1B. Однако из-за ограниченности обучающих данных и относительно небольшого объема модели она имеет ряд недостатков, таких как низкая производительность при генерации изображений с короткими подсказками и непостоянное качество генерируемых текстом изображений. В этой статье мы представляем Janus-Pro, усовершенствованную версию Janus, которая улучшает три аспекта: стратегию обучения, данные и размер модели. Семейство Janus-Pro состоит из двух размеров моделей: 1B и 7B, демонстрируя масштабируемость подхода визуального кодирования и декодирования.

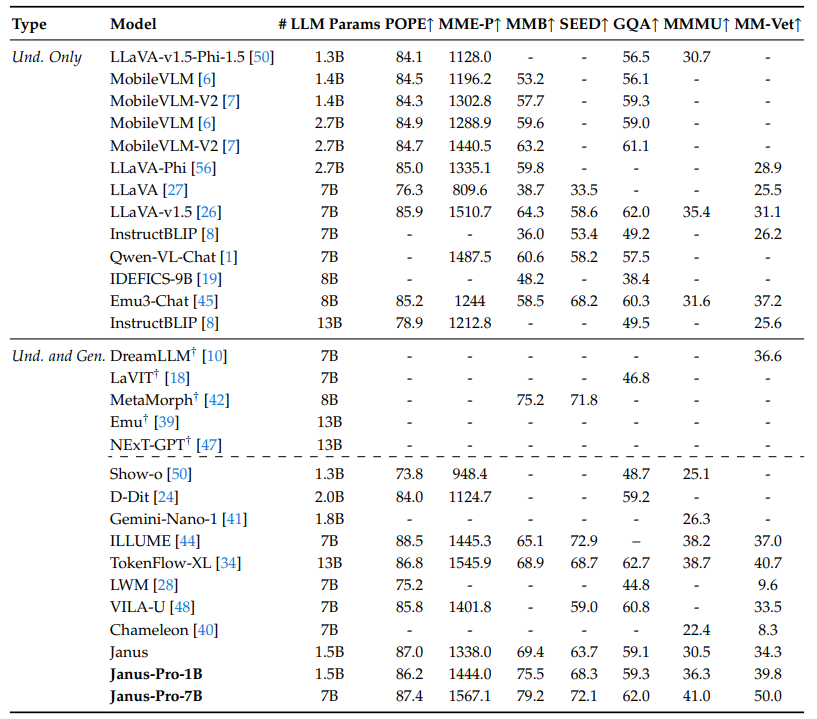

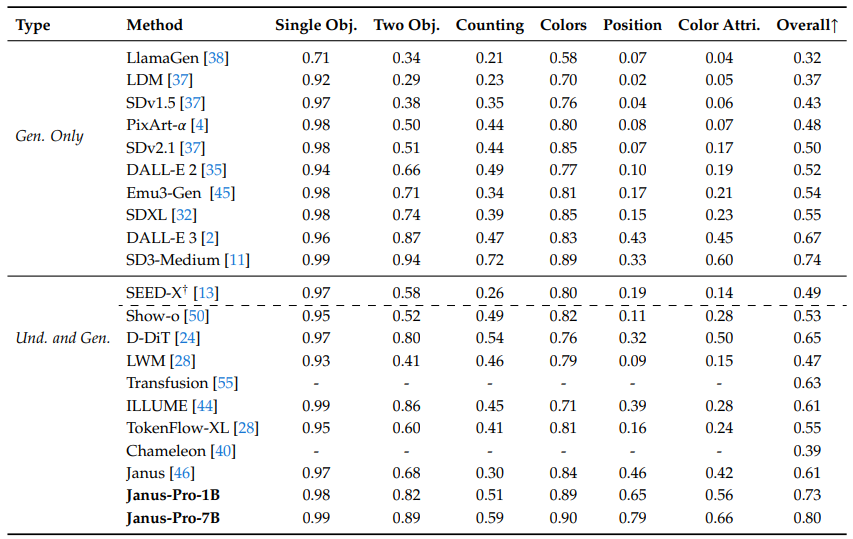

Мы оценили Janus-Pro в нескольких бенчмарках, и результаты показали превосходное мультимодальное понимание и значительно улучшенную производительность при выполнении текстовых инструкций по работе с изображениями. В частности, Janus-Pro-7B набрал 79,2 балла в эталоне мультимодального понимания MMBench [29], превзойдя предыдущие современные унифицированные мультимодальные модели, такие как Janus [46] (69,4), TokenFlow [34] (68,9) и MetaMorph [42] (75,2). Кроме того, Janus-Pro-7B набирает 0,80 балла в директиве "текст-генерация-изображений" по результатам лидерборда GenEval [14], опережая Janus [46] (0,61), DALL-E 3 (0,67) и Stable Diffusion 3 Medium [11] (0,74).

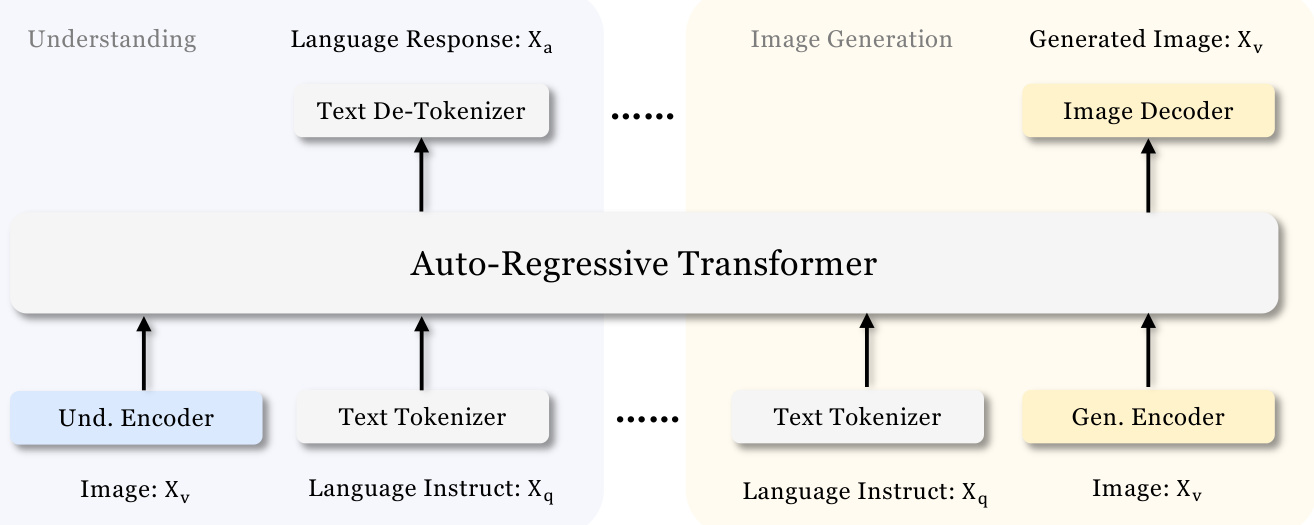

Рисунок 3 | Архитектура Janus-Pro. Мы разделяем визуальное кодирование для мультимодального понимания и визуальной генерации. "Und. Encoder" и "Gen. Encoder" - это сокращения от "Understanding Encoder" и "Generation Encoder" соответственно. "Und. Encoder" и "Gen. Encoder" - это сокращения от "Understanding Encoder" и "Generation Encoder" соответственно. Лучше всего смотреть на экране.

2. Методология

2.1.

Архитектура Janus-Pro показана на рисунке 3 и аналогична архитектуре Janus [46]. Основной принцип проектирования общей архитектуры - разделение визуального кодирования для мультимодального понимания и генерации. Мы применяем независимые методы кодирования для преобразования исходных данных в признаки, которые затем обрабатываются единым авторегрессионным трансформатором. Для мультимодального понимания мы используем кодировщик SigLIP [53] для извлечения высокоразмерных семантических признаков из изображений. Эти признаки распространяются из двумерной сетки в одномерную последовательность, и эти признаки изображения отображаются на входное пространство LLM с помощью адаптера понимания. Для задачи визуальной генерации мы используем VQ-теггер из [38] для преобразования изображений в дискретные идентификаторы. После сглаживания последовательностей идентификаторов в одномерные мы используем генеративный адаптер для отображения вкраплений кодовой книги, соответствующих каждому идентификатору, во входное пространство LLM. Затем мы объединяем эти последовательности признаков, чтобы сформировать мультимодальную последовательность признаков, которая впоследствии поступает в LLM для обработки. В дополнение к встроенному заголовку предсказания в LLM, мы используем случайно инициализированный заголовок предсказания для предсказания изображений в задачах визуальной генерации. Вся модель построена на основе авторегрессии.

2.2 Оптимизированные стратегии обучения

В предыдущей версии Janus использовался трехэтапный процесс обучения. На первом этапе обучались адаптеры и головки изображения. На втором этапе происходило равномерное предварительное обучение, в ходе которого все компоненты, кроме кодера понимания и кодера генерации, обновляли свои параметры. Третья фаза - контролируемая тонкая настройка, которая основывается на второй фазе путем дальнейшего раскрытия параметров кодера понимания в процессе обучения. В этой стратегии обучения есть некоторые проблемы. На втором этапе Janus разделил обучение способности преобразования текста в изображение на две части, следуя PixArt [4]. Первая часть обучалась на данных ImageNet [9], используя названия категорий изображений в качестве подсказок для генерируемых текстом изображений, с целью моделирования пиксельных зависимостей. Вторая часть обучалась на данных о изображениях, сгенерированных обычным текстом. При реализации 66,67% шагов обучения текстовым изображениям на втором этапе были отведены первой части. Однако в ходе дальнейших экспериментов мы обнаружили, что эта стратегия является неоптимальной и приводит к значительной вычислительной неэффективности.

Для решения этой проблемы были внесены два изменения.

- Более длительное обучение на первом этапе: Мы добавили этап обучения на первом этапе, который позволяет провести полное обучение на наборе данных ImageNet. Наши результаты показывают, что даже при фиксированных параметрах LLM модель может эффективно моделировать зависимости между пикселями и генерировать осмысленные изображения на основе названий категорий.

- Фаза II целенаправленного обучения: На втором этапе мы отказались от данных ImageNet и использовали непосредственно текстовые данные о изображениях, чтобы обучить модель генерировать изображения на основе плотных описаний. Этот переработанный подход позволяет на втором этапе более эффективно использовать данные о текстовых изображениях, что повышает эффективность обучения и общую производительность.

Мы также скорректировали соотношение данных в разных типах наборов данных на третьем этапе процесса тонкой настройки под наблюдением, изменив соотношение мультимодальных данных, данных, содержащих только текст, и данных, генерируемых текстом изображений, с 7:3:10 до 5:1:4. Немного уменьшив соотношение данных, генерируемых текстом изображений, мы заметили, что эта корректировка позволила нам добиться улучшения качества мультимодального восприятия, сохранив при этом сильные возможности визуальной генерации.

2.3 Расширения данных

Мы расширяем обучающие данные, используемые Janus для мультимодального понимания и создания видений.

- мультимодальное понимание: Для данных второго этапа предварительного обучения мы используем DeepSeekVL2 [49] и добавляем около 90 миллионов образцов. Они включают в себя наборы данных для создания подписей к изображениям (например, YFCC [31]), а также данные для понимания таблиц, графиков и документов (например, Docmatix [20]). На третьем этапе контролируемой тонкой настройки данных мы также добавили дополнительные наборы данных из DeepSeek-VL2, такие как данные о понимании MEME, данные о китайских диалогах и наборы, предназначенные для расширения возможностей диалога. Эти дополнения значительно расширяют возможности модели, повышая ее способность решать разнообразные задачи и улучшая общее впечатление от диалога.

- визуальная продукция: Мы заметили, что реальные данные, использовавшиеся в предыдущей версии Janus, были недостаточно качественными и содержали значительный шум, что обычно приводило к нестабильности генерируемых текстом изображений и эстетически плохому результату. В Janus-Pro мы включили около 72 миллионов синтетических образцов эстетических данных, чтобы довести соотношение реальных и синтетических данных до 1:1 на едином этапе предварительного обучения. Подсказки для этих синтетических образцов данных находятся в открытом доступе, например, в [43]. Эксперименты показали, что при обучении на синтетических данных модель сходится быстрее и выдает не только более стабильные изображения, сгенерированные текстом, но и значительно более высокое эстетическое качество.

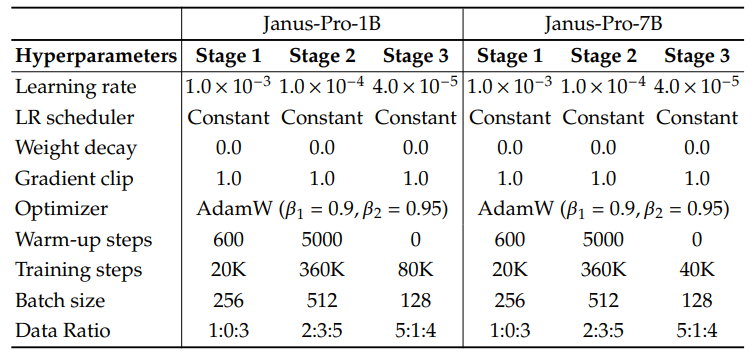

2.4 Расширения модели

В предыдущей версии Janus была проверена эффективность использования 1,5B LLM для развязки визуального кодирования. В Janus-Pro мы расширили модель до 7B, а гиперпараметры 1.5B и 7B LLM приведены в таблице 1. Мы наблюдали значительное увеличение скорости сходимости мультимодального понимания и потери визуальной генерации при использовании больших LLM по сравнению с меньшими моделями. Этот вывод еще раз подтверждает надежную масштабируемость данного подхода.

Таблица 1 | Конфигурация архитектуры Janus-Pro. Мы перечислили гиперпараметры архитектуры.

| Янус-Про-1В | Janus-Pro-7B | |

| Объем словарного запаса | 100K | 100K |

| Размер вставки | 2048 | 4096 |

| контекстное окно | 4096 | 4096 |

| устойчивость внимания | 16 | 32 |

| этаж | 24 | 30 |

Таблица 2 Подробные гиперпараметры для обучения Janus-Pro. Соотношение данных означает соотношение мультимодальных данных о понимании, текстовых данных и визуально сгенерированных данных.

3. Эксперименты

3.1 Детали реализации

В наших экспериментах мы использовали DeepSeek-LLM (1.5B и 7B) [3] в качестве базовой языковой модели с максимальной поддерживаемой длиной последовательности 4096. Для визуального кодера, используемого в задаче понимания, мы выбрали SigLIP-Large-Patch16-384 [53]. Генерирующий кодер имеет кодовую книгу размером 16 384 и понижает выборку изображения 16 раз. Адаптер понимания и адаптер генерации представляют собой двухслойные MLP. Подробные гиперпараметры для каждого этапа приведены в таблице 2. Размер всех изображений был изменен до 384x384 пикселей. Для мультимодальных данных понимания мы изменили размер длинной стороны изображения до 384 и заполнили короткую сторону цветом фона (RGB: 127, 127, 127), чтобы достичь 384. Для данных визуальной генерации короткая сторона была изменена до 384, а длинная сторона обрезана до 384. Мы используем упаковку последовательности в процессе обучения для повышения эффективности обучения. Мы смешиваем все типы данных в соответствии с заданными соотношениями за один шаг обучения. Наш Янус обучен и оценен с помощью HAI-LLM [15], легкого и эффективного фреймворка распределенного обучения, построенного на PyTorch. Весь процесс обучения занял примерно 7/14 дней на 16/32-узловом кластере, оснащенном 8 графическими процессорами Nvidia A100 (40 ГБ) для 1,5B/7B моделей.

3.2 Оценка настроек

Мультимодальное понимание: Для оценки мультимодального восприятия мы оценили нашу модель на широко признанных визуально-вербальных эталонах, основанных на изображениях, включая GQA [17], POPE [23], MME [12], SEED [21], MMB [29], MM-Vet [51] и MMMU [52].

Таблица 3 | Сравнение с современными методами в бенчмаркинге мультимодального понимания. "Und." и "Gen." означают "Понимание" и "Поколение" соответственно. Модели, использующие внешние предварительно обученные диффузионные модели, отмечены знаком †.

Визуальная генерация: Для оценки возможностей визуальной генерации мы использовали GenEval [14] и DPG-Bench [16].GenEval - это сложный эталон генерации изображений в текст, разработанный для отражения всех генеративных возможностей модели визуальной генерации через детальный анализ комбинаторных возможностей на уровне экземпляра.DPG-Bench (Dense Prompted Graph Benchmark) - это обширный набор данных, содержащий 1065 длинных, плотных подсказок в комплексном наборе данных, предназначенном для оценки сложных возможностей семантического выравнивания моделей преобразования текста в изображение.

3.3 Сравнение с современными достижениями

Мультимодальная производительность понимания: В таблице 3 мы сравниваем предложенный подход с современными унифицированными моделями и моделями, предназначенными только для понимания. Это можно объяснить развязкой мультимодального понимания и генерируемого визуального кодирования, что снимает конфликт между этими двумя задачами. Janus-Pro сохраняет высокую конкурентоспособность по сравнению с гораздо более крупными моделями. Например, Janus-Pro-7B превосходит TokenFlow-XL (13B) во всех бенчмарках, кроме GQA.

Таблица 4 Оценка генерации текста в изображение в бенчмарке GenEval. "Und." и "Gen." означают "Понимание" и "Генерация" соответственно. Модели, использующие внешние предварительно обученные диффузионные модели, отмечены знаком †.

Таблица 5 производительность на DPG-Bench. За исключением Janus и Janus-Pro, все методы в этой таблице зависят от модели, используемой для генерации задачи.

Визуальное представление поколения: Мы сообщаем о производительности визуальной генерации в GenEval и DPG-Bench. Как показано в таблице 4, наш Janus-Pro-7B получил общую точность 80% на GenEval, что превосходит все другие унифицированные или поддерживающие только генерацию методы, например, Transfusion [55] (63%), SD3-Medium (74%) и DALL-E 3 (67%). Это говорит о том, что наш метод обладает лучшей способностью следовать инструкциям. Как показано в таблице 5, Janus-Pro получил 84,19 балла в DPG-Bench, опередив все остальные методы. Это говорит о том, что Janus-Pro хорошо выполняет плотные инструкции для генерации текста в изображение.

3.4 Качественные результаты

Результаты мультимодального восприятия представлены на рис. 4. Janus-Pro демонстрирует впечатляющие результаты при обработке информации из разных контекстов, демонстрируя свою мощь. В нижней части рис. 4 показаны результаты генерации изображений, созданных на основе текста. Изображения, созданные Janus-Pro-7B, очень реалистичны и содержат большое количество деталей, несмотря на то, что разрешение составляет всего $384\times384$. Для воображаемых и творческих сценариев Janus-Pro-7B точно улавливает семантическую информацию в подсказках и генерирует осмысленные и последовательные изображения.

Рисунок 4 | Качественные результаты мультимодального понимания и возможности визуальной генерации. Модель - Janus-Pro-7B, а визуально сгенерированное изображение имеет разрешение $384\times384$. лучше всего просматривать на экране.

4. Заключение

В этой статье мы улучшаем Janus с точки зрения стратегии обучения, данных и размера модели. Эти усовершенствования приводят к значительному улучшению мультимодального понимания и генерации текста по команде. Однако Janus-Pro все еще имеет некоторые ограничения. Для мультимодального понимания разрешение входного сигнала ограничено $384\times384$, что сказывается на производительности в таких тонких задачах, как OCR. Для изображений, созданных с помощью текста, низкое разрешение в сочетании с потерями при реконструкции, вносимыми визуальным тегером, приводит к тому, что изображения получаются семантически насыщенными, но при этом недостаточно детализированными. Например, небольшие участки лица, занимающие ограниченное пространство изображения, могут казаться недостаточно детализированными. Увеличение разрешения изображения может решить эти проблемы.

библиография

[1] J. Bai, S. Bai, S. Yang, S. Wang, S. Tan, P. Wang, J. Lin, C. Zhou, and J. Zhou. qwen-vl: a cutting-edge large-scale visual language model with versatility. arXiv preprint arXiv:2308.12966, 2023.[2] J. Betker, G. Goh, L. Jing, T. Brooks, J. Wang, L. Li, L. Ouyang, J. Zhuang, J. Lee, Y. Guo, et al. Улучшение генерации изображений с помощью лучших надписей. Компьютерные науки. https://cdn.openai.com/papers/dall-e-3.pdf, 2(3):8, 2023.

[3] X. Bi, D. Chen, G. Chen, S. Chen, D. Dai, C. Deng, H. Ding, K. Dong, Q. Du, Z. Fu, et al. DeepSeek LLM: расширение языковых моделей с открытым исходным кодом с помощью долговременности. arXiv preprint arXiv:2401.02954, 2024.

[4] J. Chen, J. Yu, C. Ge, L. Yao, E. Xie, Y. Wu, Z. Wang, J. Kwok, P. Luo, H. Lu, et al. PixArtℎ: быстрое обучающее диффузионное преобразование для синтеза фотореалистичных изображений с генерацией текста. arXiv preprint arXiv:2310.00426, 2023.

[5] J. Chen, C. Ge, E. Xie, Y. Wu, L. Yao, X. Ren, Z. Wang, P. Luo, H. Lu, and Z. Li. PixArt-Sigma: слабо-сильное обучение диффузионного трансформатора для генерации изображений с 4K-текстом. arXiv preprint arXiv:2403.04692, 2024.

[6] X. Chu, L. Qiao, X. Lin, S. Xu, Y. Yang, Y. Hu, F. Wei, X. Zhang, B. Zhang, X. Wei, et al. Mobilevlm: быстрый, воспроизводимый и мощный визуальный языковой помощник для мобильных устройств. arXiv preprint arXiv:2312.16886, 2023.

[7] X. Chu, L. Qiao, X. Zhang, S. Xu, F. Wei, Y. Yang, X. Sun, Y. Hu, X. Lin, B. Zhang, et al. Mobilevlm v2: более быстрая и мощная основа для визуального моделирования языка. arXiv preprint arXiv:2402.03766, 2024.

[8] W. Dai, J. Li, D. Li, A. M. H. Tiong, J. Zhao, W. Wang, B. Li, P. Fung, and S. Hoi. Instructblip: towards the generalised visual language model with command fine-tuning, 2023.

[9] J. Deng, W. Dong, R. Socher, L.-J. Li, K. Li, and L. Fei-Fei. Imagenet: крупномасштабная иерархическая база данных изображений. Труды конференции 2009 IEEE по компьютерному зрению и распознаванию образов, стр. 248-255. Институт инженеров по электротехнике и электронике, 2009.

[10] R. Dong, C. Han, Y. Peng, Z. Qi, Z. Ge, J. Yang, L. Zhao, J. Sun, H. Zhou, H. Wei, et al. Dreamllm: мультимодальное совместное понимание и создание. arXiv preprint arXiv:2309.11499, 2023.

[11] П. Эссер, С. Кулал, А. Блаттманн, Р. Энтезари, Дж. Мллер, Х. Саини, Ю. Леви, Д. Лоренц, А. Зауэр, Ф. Бозель, Д. Поделл, Т. Докхорн, З. Инглиш, К. Лейси А. Гудвин, Ю. Марек и Р. Ромбах. потоковое преобразование с коррекцией масштаба для синтеза изображений высокого разрешения, 2024. URL https://arxiv.org/abs/2403.03206.

[12] C. Fu, P. Chen, Y. Shen, Y. Qin, M. Zhang, X. Lin, J. Yang, X. Zheng, K. Li, X. Sun, et al. MME: комплексный эталон оценки для мультимодальных больших языковых моделей. arXiv preprint arXiv:2306.13394, 2023.

[13] Y. Ge, S. Zhao, J. Zhu, Y. Ge, K. Yi, L. Song, C. Li, X. Ding, and Y. Shan. SEED-X: мультимодальная модель с унифицированным пониманием и генерацией мультигранулярности. arXiv preprint arXiv:2404.14396, 2024.

[14] Д. Гош, Х. Хаджиширзи и Л. Шмидт. GenEval: объектно-ориентированная структура для оценки выравнивания изображений, сгенерированных текстом. Advances in Neural Information Processing Systems, 36, 2024.

[15] High-flyer. HAI-LLM: эффективный и легкий инструмент для обучения большим моделям, 2023 г. URL https://www.high-flyer.cn/en/blog/hai-llm.

[16] X. Hu, R. Wang, Y. Fang, B. Fu, P. Cheng, and G. Yu. ELLA: Equipping diffusion models for enhanced semantic alignment. arXiv preprint arXiv:2403.05135, 2024.

[17] D. A. Hudson and C. D. Manning. gqa: a new dataset for real-world visual reasoning and combinatorial quizing. В материалах конференции IEEE/CVF по компьютерному зрению и распознаванию образов, страницы 6700-6709, 2019.

[18] Y. Jin, K. Xu, L. Chen, C. Liao, J. Tan, B. Chen, C. Lei, A. Liu, C. Song, X. Lei, et al. Динамическая дискретная визуальная токенизация для визуального предварительного обучения на унифицированном языке. arXiv preprint arXiv:2309.04669, 2023.

[19] H. Laurenon, D. van Strien, S. Bekman, L. Tronchon, L. Saulnier, T. Wang, S. Karamcheti, A. Singh, G. Pistilli, Y. Jernite, and et al. Введение в IDEFICS: открытая модель для воспроизведения самых современных визуальных языковых моделей, 2023 г. URL https://huggingface.co/blog/id efics.

[20] Х. Лоренон, А. Марафиоти, В. Сань и Л. Троншон. Построение и лучшее понимание визуальных языковых моделей: выводы и будущие направления, 2024.

[21] B. Li, R. Wang, G. Wang, Y. Ge, Y. Ge, and Y. Shan. SEED-Bench: benchmarking multimodal LLMs using generative understanding. arXiv preprint arXiv:2307.16125, 2023.

[22] Д. Ли, А. Камко, Э. Ахгари, А. Сабет, Л. Сюй и С. Доши. Игровая площадка v2.5: Трехточечная проницательность для повышения эстетического качества генерируемых текстом изображений. arXiv preprint arXiv:2402.17245, 2024.

[23] Y. Li, Y. Du, K. Zhou, J. Wang, W. X. Zhao, and J.-R. Wen. Evaluating object illusions in large-scale visual language models. arXiv preprint arXiv:2305.10355, 2023.

[24] Z. Li, H. Li, Y. Shi, A. B. Farimani, Y. Kluger, L. Yang, and P. Wang. double diffusion for unified image generation and understanding. arXiv preprint arXiv:2501.00289, 2024.

[25] Z. Li, J. Zhang, Q. Lin, J. Xiong, Y. Long, X. Deng, Y. Zhang, X. Liu, M. Huang, Z. Xiao, et al. Hunyuan-DiT: мощный мультиразрешающий диффузионный трансформатор с тонким пониманием китайского языка. arXiv preprint arXiv:2405.08748, 2024.

[26] H. Liu, C. Li, Y. Li, and Y. J. Lee. Improved fine-tuning baselines for visual commands. В материалах конференции IEEE/CVF по компьютерному зрению и распознаванию образов, стр. 26296-26306, 2024.

[27] H. Liu, C. Li, Q. Wu, and Y. J. Lee. visual command fine-tuning. Advances in Neural Information Processing Systems, 36, 2024.

[28] Х. Лю, В. Ян, М. Захария и П. Аббел. модель мира на видео и языках миллионной длины с использованием кольцевого внимания. arXiv препринт arXiv:2402.08268, 2024.

[29] Y. Liu, H. Duan, Y. Zhang, B. Li, S. Zhang, W. Zhao, Y. Yuan, J. Wang, C. He, Z. Liu, et al. MMBench: является ли ваша мультимодальная модель универсальной? arXiv preprint arXiv:2307.06281, 2023.

[30] Y. Ma, X. Liu, X. Chen, W. Liu, C. Wu, Z. Wu, Z. Pan, Z. Xie, H. Zhang, X. yu, L. Zhao, Y. Wang, J. Liu, and C. Ruan. Janusflow: reconciling autoregressive and corrective flows for unified multimodal understanding and generation, 2024.

[31] mehdidc. yfcc-huggingface. https://huggingface.co/datasets/mehdidc/yfcc15 m, 2024.

[32] D. Podell, Z. English, K. Lacey, A. Blattmann, T. Dockhorn, J. Mller, J. Penna, and R. Rombach. sdxl: improving potential diffusion models for high-resolution image synthesis. arXiv preprint arXiv:2307.01952,. 2023.

[33] D. Podell, Z. English, K. Lacey, A. Blattmann, T. Dockhorn, J. Mller, J. Penna, and R. Rombach. sdxl: improving potential diffusion models for high resolution image synthesis. 2024.

[34] L. Qu, H. Zhang, Y. Liu, X. Wang, Y. Jiang, Y. Gao, H. Ye, D. K. Du, Z. Yuan, and X. Wu. Tokenflow: unified image tagger for multimodal understanding and generation. arXiv preprint arXiv:2412.03069, 2024.

[35] А. Рамеш, П. Дхаривал, А. Никол, К. Чу и М. Чен. иерархическая генерация изображений с текстовыми условиями с использованием латентных значений CLIP. arXiv препринт arXiv:2204.06125, 1(2):3, 2022.

[36] Р. Ромбах, А. Блаттманн, Д. Лоренц, П. Эссер и Б. Оммер. Синтез изображений высокого разрешения с использованием модели скрытой диффузии. 2022.

[37] Р. Ромбах, А. Блаттманн, Д. Лоренц, П. Эссер и Б. Оммер. Синтез изображений высокого разрешения с использованием моделей скрытой диффузии. В материалах конференции IEEE/CVF по компьютерному зрению и распознаванию образов, страницы 10684-10695, 2022.

[38] П. Сунь, Й. Цзян, С. Чен, С. Чжан, Б. Пенг, П. Луо и З. Юань. Авторегрессионные модели, обыгрывающие диффузию: LLama для масштабируемой генерации изображений. arXiv preprint arXiv:2406.06525, 2024.

[39] Q. Sun, Q. Yu, Y. Cui, F. Zhang, X. Zhang, Y. Wang, H. Gao, J. Liu, T. Huang, and X. Wang. multimodal generative preraining. arXiv preprint arXiv:2307.05222, 2023.

[40] C. Team. Chameleon: A basic model for early fusion of mixed modes. arXiv preprint arXiv:2405.09818, 2024.

[41] Г. Команд, Р. Анил, С. Боржо, Ю. Ву, Ж.-Б. Алайрак, Ж. Ю, Р. Сорикут, Ж. Шалквик, А. М. Дай, А. Хаут и др. Близнецы: семейство способных мультимодальных моделей. arXiv preprint arXiv:2312.11805, 2023.

[42] S. Tong, D. Fan, J. Zhu, Y. Xiong, X. Chen, K. Sinha, M. Rabbat, Y. LeCun, S. Xie, and Z. Liu. Metamorph: multimodal understanding and generation through instruction fine-tuning. arXiv preprint arXiv:2412.14164,. 2024.

[43] Vivym. Середина путешествия Набор данных Prompt. https://huggingface.co/datasets/vivym/midjourney-prompts, 2023. Дата посещения: [вставьте дату посещения, например, 2023-10-15].

[44] C. Wang, G. Lu, J. Yang, R. Huang, J. Han, L. Hou, W. Zhang, and H. Xu. Illume: illuminating your LLMs to see, draw, and self-enhance. arXiv preprint arXiv:2412.06673, 2024.

[45] X. Wang, X. Zhang, Z. Luo, Q. Sun, Y. Cui, J. Wang, F. Zhang, Y. Wang, Z. Li, Q. Yu, et al. Emu3: предсказание следующего тега - это все, что вам нужно. arXiv preprint arXiv:2409.18869, 2024.

[46] C. Wu, X. Chen, Z. Wu, Y. Ma, X. Liu, Z. Pan, W. Liu, Z. Xie, X. Yu, C. Ruan, et al. Janus: развязка визуального кодирования для унифицированного мультимодального понимания и генерации. arXiv preprint arXiv:2410.13848, 2024.

[47] S. Wu, H. Fei, L. Qu, W. Ji, and T.-S. Chua. next-gpt: any-to-any multimodal LLM. arXiv preprint arXiv:2309.05519, 2023.

[48] Y. Wu, Z. Zhang, J. Chen, H. Tang, D. Li, Y. Fang, L. Zhu, E. Xie, H. Yin, L. Yi, et al. VILA-U: основополагающая модель для интеграции визуального понимания и генерации. arXiv preprint arXiv:2409.04429, 2024.

[49] Z. Wu, X. Chen, Z. Pan, X. Liu, W. Liu, D. Dai, H. Gao, Y. Ma, C. Wu, B. Wang, et al. DeepSeek-VL2: гибридная экспертная модель визуального языка для расширенного мультимодального понимания. arXiv preprint arXiv:2412.10302, 2024.

[50] J. Xie, W. Mao, Z. Bai, D. J. Zhang, W. Wang, K. Q. Lin, Y. Gu, Z. Chen, Z. Yang, and M. Z. Shou. show-o: a single converter for unified multimodal understanding and generation. arXiv preprint arXiv:2408.12528,. 2024.

[51] W. Yu, Z. Yang, L. Li, J. Wang, K. Lin, Z. Liu, X. Wang, and L. Wang. MM-Vet: оценка интегрирующей способности больших мультимодальных моделей. arXiv preprint arXiv:2308.02490, 2023.

[52] X. Yue, Y. Ni, K. Zhang, T. Zheng, R. Liu, G. Zhang, S. Stevens, D. Jiang, W. Ren, Y. Sun, et al. MMMU: крупномасштабный мультидисциплинарный мультимодальный эталон понимания и вывода для экспертного AGI. в Трудах конференции IEEE/CVF по компьютерному зрению и распознаванию образов, стр. 9556-9567, 2024.

[53] X. Zhai, B. Mustafa, A. Kolesnikov, and L. Beyer. сигмоидальные потери для предварительного обучения языковых изображений. В материалах Международной конференции по компьютерному зрению IEEE/CVF, страницы 11975-11986, 2023.

[54] C. Zhao, Y. Song, W. Wang, H. Feng, E. Ding, Y. Sun, X. Xiao, and J. Wang. Monoformer: единый преобразователь для диффузии и авторегрессии. arXiv preprint arXiv:2409.16280, 2024.

[55] К. Чжоу, Л. Ю, А. Бабу, К. Тирумала, М. Ясунага, Л. Шамис, Дж. Кан, X. Ма, Л. Зеттлмойер и О. Леви. Переливание: предсказание следующего помеченного и рассеянного изображения с помощью мультимодальной модели. arXiv Preprint. arXiv:2408.11039, 2024.

[56] Y. Zhu, M. Zhu, N. Liu, Z. Ou, X. Mou, and J. Tang. lLAVA-Phi: Efficient multimodal assistant with small language models. arXiv preprint arXiv:2401.02330, 2024.[57] L. Zhuo, R. Du, H. Xiao, Y. Li, D. Liu, R. Huang, W. Liu, L. Zhao, F.-Y. Wang, Z. Ma, et al. Lumina-Next: делаем Lumina-T2X мощнее и быстрее с помощью Next-DiT. arXiv preprint arXiv:2406.18583, 2024.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...