DeepSeek Debate: лидерство Китая по стоимости, реальные затраты на обучение и влияние закрытых моделей на прибыль

Ключевые слова: скачки цен на h100, ценообразование с учетом субсидий, экспортный контроль, ОМС

Рассказ о компании DeepSeek захватил весь мир

DeepSeek Взять мир штурмом. На протяжении последней недели DeepSeek был единственной темой, о которой хотели поговорить все в мире. В настоящее время у DeepSeek гораздо больше ежедневного трафика, чем у Claude, Perplexity или даже Gemini.

Но для тех, кто внимательно следит за этой сферой, это не совсем "новая" новость. Мы говорим о DeepSeek уже несколько месяцев (каждая ссылка - пример). Компания не нова, но шумиха - да, и SemiAnalysis уже давно утверждает, что DeepSeek очень талантлива, а широкой американской общественности это безразлично. Когда мир наконец обратил на это внимание, он сделал это в условиях бешеной шумихи, которая не отражала реальности.

Мы хотели бы подчеркнуть, что это заявление изменилось по сравнению с прошлым месяцем, когда были нарушены законы масштабирования и мы развеяли заблуждение о том, что алгоритмы теперь улучшаются слишком быстро, что в некотором смысле также плохо для Nvidia и графических процессоров.

Предыстория: 11 декабря 2024 года Законы масштабирования - архитектура O1 Pro, инфраструктура обучения выводам, Orion и Клод 3.5 Опус "Неудачи"

Сейчас все говорят о том, что DeepSeek настолько эффективен, что нам не нужно больше вычислений, и теперь существует огромный избыток мощностей во всем из-за изменения моделей. Парадокс Джевонса также чрезмерно преувеличен, но Джевонс ближе к реальности, и эти модели вызвали спрос, который ощутимо повлиял на цены H100 и H200.

DeepSeek и High-Flyer

High-Flyer - это китайский хедж-фонд, который рано начал использовать искусственный интеллект в своих торговых алгоритмах. Они рано осознали потенциал ИИ за пределами финансовой сферы и поняли, что такое масштабирование. В результате они увеличили поставки графических процессоров. После экспериментов с моделями, использующими кластеры из тысяч графических процессоров, High Flyer инвестировала в 10 000 графических процессоров A100 в 2021 году * до введения каких-либо ограничений на экспорт. * Это принесло свои плоды. По мере совершенствования High-Flyer поняла, что настало время выделить компанию DeepSeek в мае 2023 года с целью более целенаправленного развития возможностей ИИ. High-Flyer самостоятельно финансировала компанию, поскольку в то время интерес к ИИ со стороны внешних инвесторов был невелик, а отсутствие бизнес-модели было главной проблемой. Сегодня High-Flyer и DeepSeek часто обмениваются ресурсами, как человеческими, так и вычислительными.

Сейчас DeepSeek превратилась в серьезное совместное предприятие, далекое от "побочного бизнеса", о котором говорят многие СМИ. Мы считаем, что их инвестиции в GPU превышают 500 миллионов долларов, даже с учетом экспортного контроля.

Источник: SemiAnalysis, Lennart Heim.

Ситуация с графическим процессором

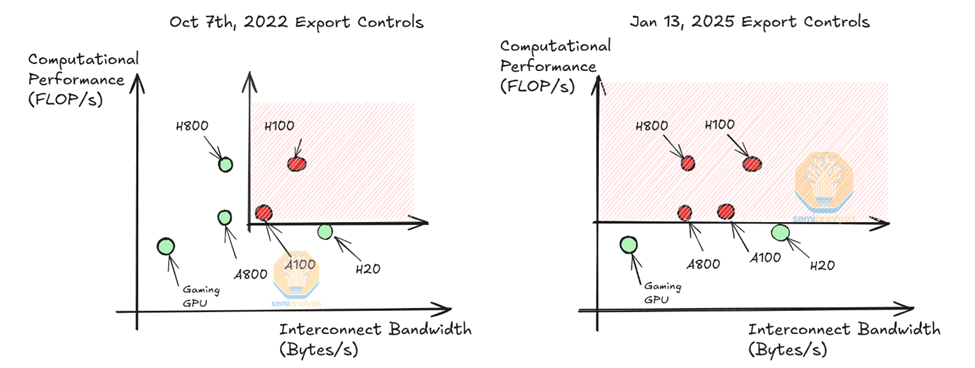

Мы думаем, что им пригодится около 50 000. Бункер GPUЭто не то же самое, что 50 000 H100, как утверждают некоторые люди. Nvidia выпускает разные модели H100 для соответствия различным нормам (H800, H20), и в настоящее время только H20 доступна для поставщиков моделей в Китае. Обратите внимание, что H800 обладает той же вычислительной мощностью, что и H100, но имеет меньшую пропускную способность сети.

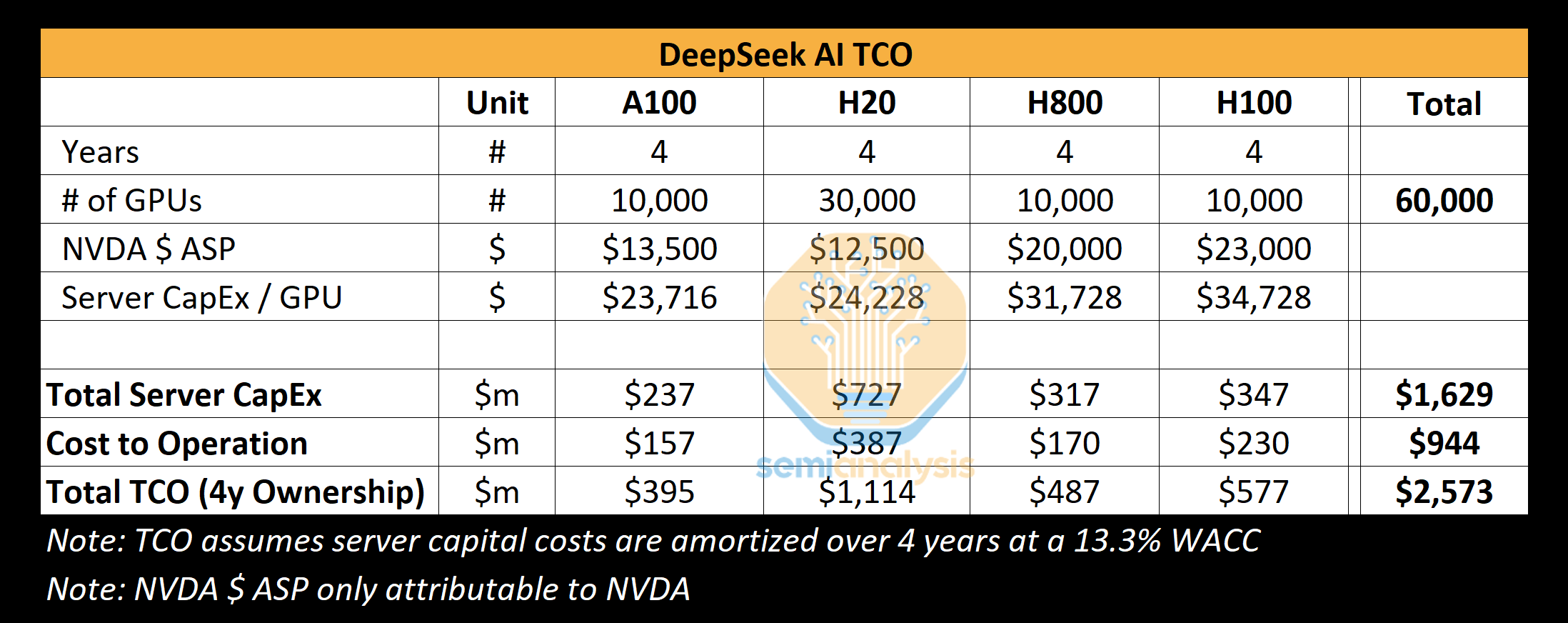

Мы считаем, что DeepSeek может использовать около 10 000 H800 и около 10 000 H100. Кроме того, они заказали больше H20, а Nvidia за последние 9 месяцев произвела более 1 миллиона китайских GPU. Эти GPU используются совместно High-Flyer и DeepSeek, и в некоторой степени распределены по географическому принципу. Они используются для торговли, выводов и обучения. Они используются для торговли, выводов, обучения и исследований. Для более конкретного и подробного анализа см. нашу модель ускорителя.

Источник: SemiAnalysis

Наш анализ показывает, что общий CAPEX сервера DeepSeek составляет около 1,6 миллиарда долларов, а расходы на эксплуатацию таких кластеров достигают 944 миллионов долларов. Аналогично, все лаборатории ИИ и гипермасштабируемые кластеры имеют больше GPU для различных задач, включая исследования и обучение, чем они используют для одного тренировочного цикла, поскольку объединение ресурсов является сложной задачей. x.AI - это уникальная лаборатория ИИ, в которой все GPU находятся в одном месте.

DeepSeek специализируется на поиске талантов из Китая, независимо от предыдущей квалификации, уделяя особое внимание компетентности и любознательности. Компания регулярно проводит мероприятия по подбору персонала в ведущих университетах, таких как Пекинский и Чжэцзянский, которые окончили многие из ее сотрудников. Должности не всегда заранее определены, и рекрутерам предоставляется гибкость: в объявлениях о вакансиях даже предлагается доступ к более чем 10 000 графических процессоров без ограничений по использованию. Они чрезвычайно конкурентоспособны и, как сообщается, предлагают перспективным кандидатам зарплату свыше 1,3 миллиона долларов, что намного выше, чем у крупных китайских технологических компаний и лабораторий искусственного интеллекта, таких как Moonshot. В компании работает около 150 сотрудников, но она быстро растет.

История показывает, что небольшой, хорошо финансируемый и целенаправленный стартап часто может расширить границы возможного. DeepSeek не имеет бюрократии Google и, поскольку они финансируются самостоятельно, может быстро продвигать идеи. Однако, как и Google, DeepSeek (по большей части) управляет собственным центром обработки данных и не полагается на внешние стороны или провайдеров. Это открывает больше пространства для экспериментов и позволяет им внедрять инновации по всему стеку.

Мы считаем их лучшей лабораторией "открытого веса" на сегодняшний день, опередив Meta's Llama, Mistral и других.

Стоимость и производительность DeepSeek

На этой неделе цены и эффективность DeepSeek вызвали ажиотаж, главным заголовком которого стала информация о стоимости обучения DeepSeek V3 в 6 миллионов долларов. Это неверно. Это похоже на то, как если бы вы указали на определенную часть спецификации товара и приписали ее ко всей стоимости. Затраты на предварительное обучение составляют очень малую часть от общей стоимости.

Расходы на обучение

Мы считаем, что цифры предварительного обучения далеки от реальных затрат на модель. Мы считаем, что за всю историю компании на аппаратное обеспечение было потрачено гораздо больше, чем 500 миллионов долларов. Чтобы разработать новые архитектурные инновации, приходится тратить значительные средства на тестирование новых идей, новых архитектурных идей и абляцию в процессе разработки модели. Разработка многоголового латентного внимания, ключевой инновации DeepSeek, заняла несколько месяцев и стоила всей команде человеческих ресурсов и времени GPU.

Стоимость в 6 миллионов долларов, указанная в статье, относится только к стоимости GPU для предварительного обучения, что составляет лишь часть общей стоимости модели. Для сравнения, обучение Claude 3.5 Sonnet обошлось в десятки миллионов долларов, и если бы это было все, что нужно Anthropic, они бы не собирали миллиарды долларов от Google и десятки миллиардов от Amazon. Это связано с тем, что им приходится экспериментировать, придумывать новые архитектуры, собирать и очищать данные, платить сотрудникам и т. д.

Как же DeepSeek удалось собрать такой большой кластер? Ключевым фактором является отставание в экспортном контроле, о котором мы поговорим в разделе "Экспорт" ниже.

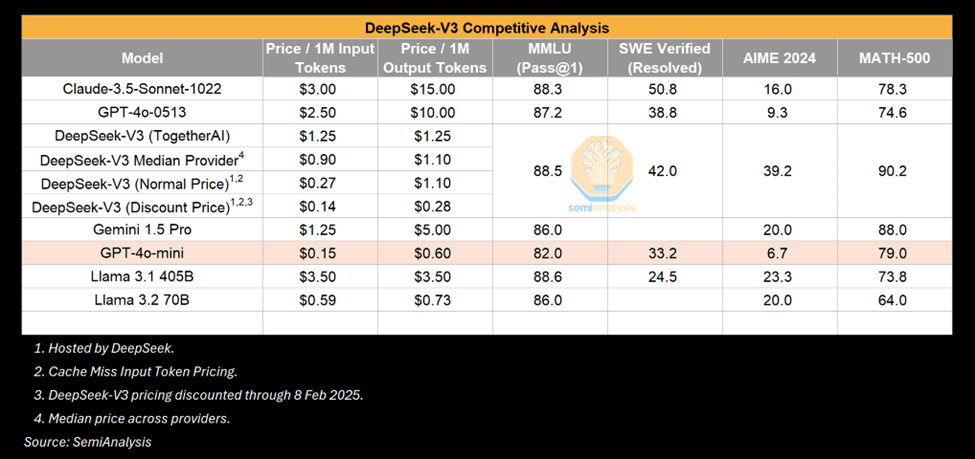

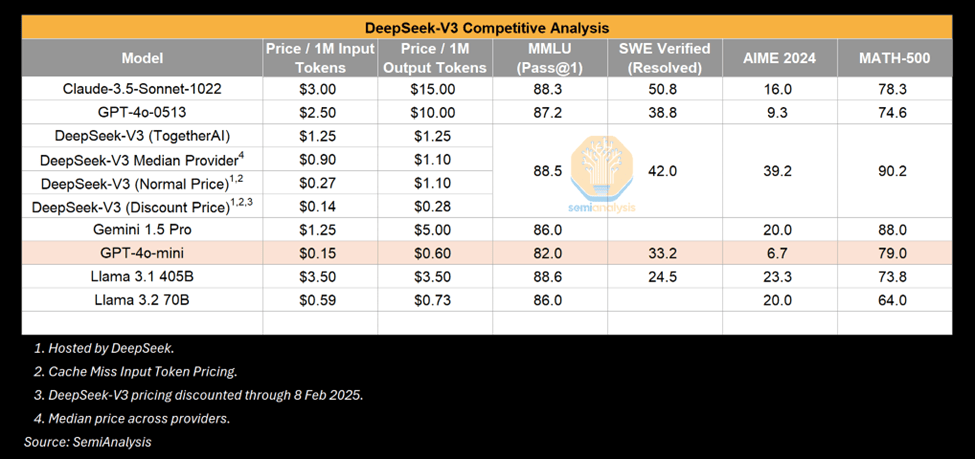

Ликвидация разрыва - V3 Performance

V3, несомненно, впечатляющая модель, но стоит подчеркнуть, что В отличие от того, что впечатляет.. Многие сравнивали V3 с GPT-4o и подчеркивали, что V3 превосходит 4o по производительности. Это правда, но GPT-4o находится на Май 2024 г.Выпущено.ИИ развивается стремительно, и май 2024 года - это еще одна эпоха с точки зрения совершенствования алгоритмов. Более того, мы не удивляемся тому, что через определенное время сопоставимая или большая мощность достигается меньшим количеством вычислений. Обвал стоимости вычислений - признак совершенствования ИИ.

Источник: SemiAnalysis

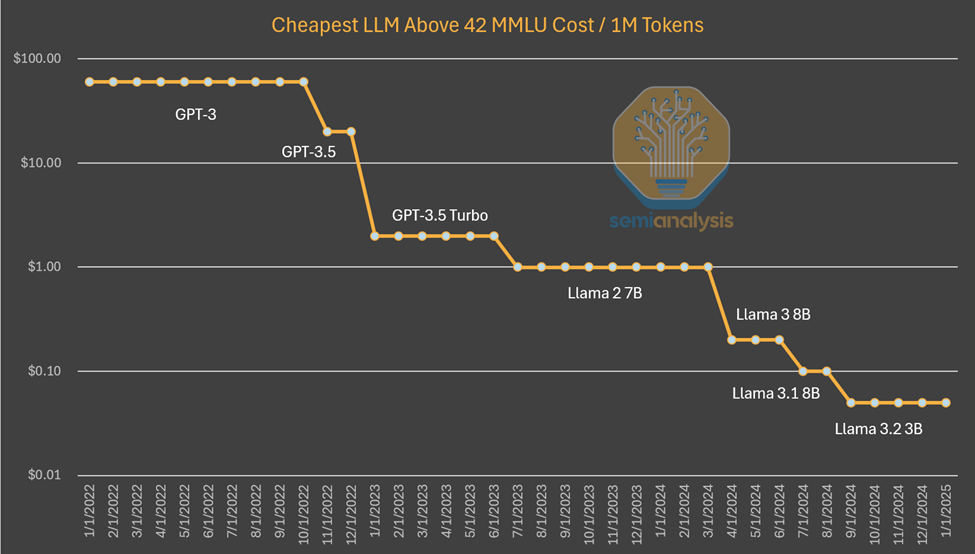

Один из примеров - небольшие модели, которые можно запускать на ноутбуках, имеют производительность, сопоставимую с GPT-3, для обучения которой требуется суперкомпьютер, а для выводов - несколько графических процессоров. Другими словами, алгоритмические усовершенствования позволяют сократить количество вычислений для обучения и рассуждений о моделях с теми же возможностями, и эта схема работает снова и снова. На этот раз мир обратил внимание, потому что это произошло из сино лаборатории. Но в том, что маленькие модели становятся лучше, нет ничего нового.

Источники: SemiAnalysis, Artificialanalysis.ai, Энакин.ai, a16z

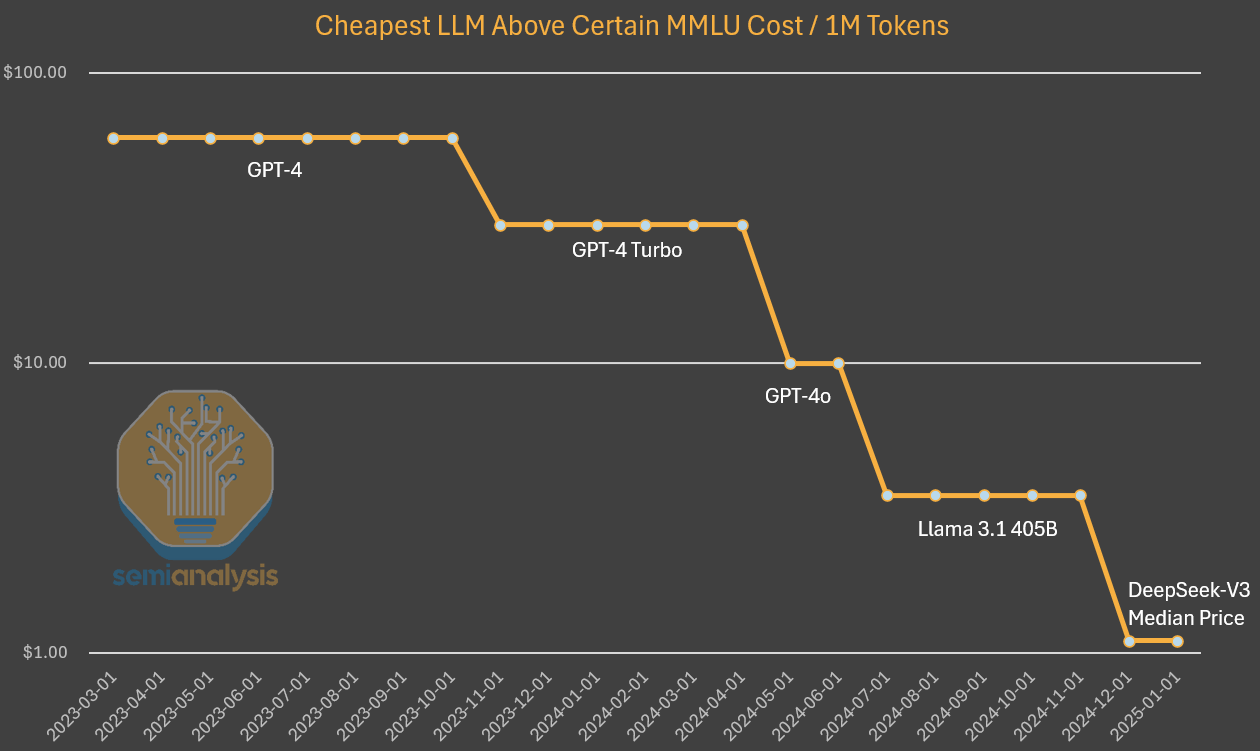

Пока что мы наблюдаем такую картину: лаборатории ИИ тратят больше абсолютных долларов, чтобы получить подробнее Интеллект Anthropic. Алгоритмический прогресс оценивается в 4 раза в год, то есть с каждым годом для достижения тех же возможностей требуется в 4 раза меньше вычислений. Дарио, генеральный директор Anthropic, считает, что алгоритмический прогресс идет еще быстрее, обеспечивая 10-кратное улучшение. В случае с ценообразованием на качественные выводы GPT-3 стоимость снизилась в 1200 раз.

При исследовании затрат на GPT-4 мы видим аналогичное снижение затрат, хотя и на более раннем этапе кривой. Хотя уменьшение разницы в стоимости с течением времени можно объяснить тем, что мощность больше не поддерживается постоянной, как на графике выше. В данном случае мы видим, что усовершенствование и оптимизация алгоритмов привели к 10-кратному снижению затрат и 10-кратному увеличению производительности.

Источники: SemiAnalysis, OpenAI, Вместе.ai

Если говорить начистоту, то DeepSeek уникальна тем, что добилась такого уровня стоимости и возможностей. Они уникальны тем, что выпускают открытые весы, но предыдущие Мистраль DeepSeek достигла такого уровня стоимости, но не удивляйтесь, если к концу года стоимость снизится еще в 5 раз.

Сравнима ли производительность R1 с производительностью o1?

С другой стороны, R1 удалось достичь результатов, сравнимых с o1, который был анонсирован только в сентябре. Как DeepSeek удалось так быстро наверстать упущенное?

Ответ заключается в том, что вывод - это новая парадигма с более быстрыми итерациями и легко достижимыми целями, где небольшой объем вычислений может дать значительный выигрыш по сравнению с предыдущими парадигмами. Как описано в нашем отчете "Законы масштабирования", предыдущие парадигмы основывались на предварительном обучении, которое становится все более дорогим и затрудняет достижение надежных результатов.

Новая парадигма сосредоточена на расширении возможностей вывода с помощью генерации синтетических данных и обучения с подкреплением в процессе посттренинга существующих моделей, что позволяет добиться более быстрых результатов по низкой цене. Более низкий барьер для входа в систему в сочетании с простыми оптимизациями означает, что DeepSeek может повторить подход o1 быстрее, чем обычно. По мере того как участники будут выяснять, как увеличить масштабы в этой новой парадигме, мы ожидаем, что временной разрыв в возможностях сопоставления будет увеличиваться.

Обратите внимание, что документ R1 Не упоминается вычислений. Это не случайно - для генерации синтетических данных, используемых для посттренинга R1, требуется много вычислений. И это без учета обучения с подкреплением. r1 - очень хорошая модель, мы это не оспариваем, и столь быстрое достижение преимущества в выводах объективно впечатляет. Тот факт, что DeepSeek - китайская разработка и догнала ее с меньшими ресурсами, впечатляет еще больше.

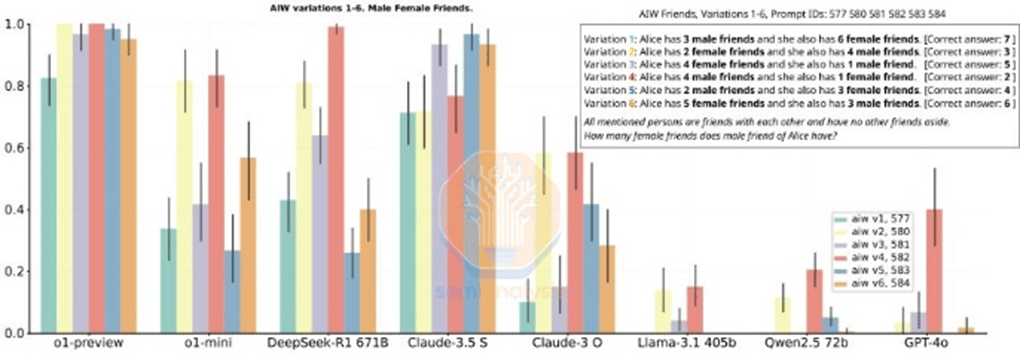

Но некоторые из эталонов, о которых упоминает R1, также введение в заблуждение. Сравнивать R1 с o1 сложно, потому что R1 специально не упоминает бенчмарки, в которых она не лидирует. Несмотря на то, что R1 превосходит по производительности вывода, он не является явным победителем во всех метриках, и во многих случаях он хуже, чем o1.

Источник: (Еще одна) история о взлете и падении. DeepSeek R1

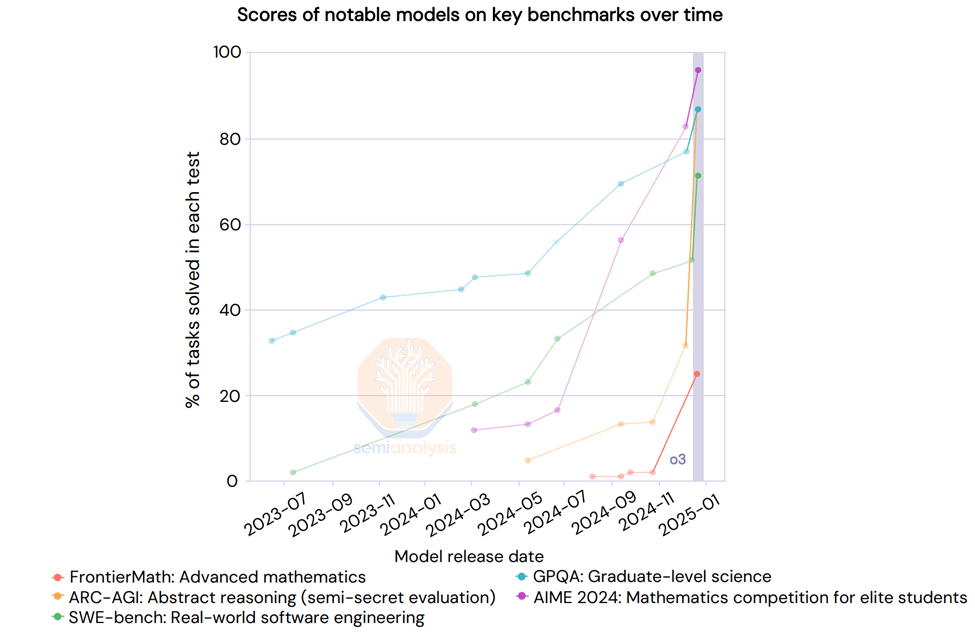

Мы еще не упомянули o3. o3 значительно превосходит по возможностям R1 и o1. Более того, OpenAI недавно поделился результатами для o3, где бенчмарк Scaling был вертикальным. "Глубокое обучение натолкнулось на стену", но в другом смысле.

Источник: AI Action Summit

Модель выводов Google так же хороша, как и R1

В то время как вокруг R1 поднялась бешеная шумиха, месяц назад американская компания с капиталом в 2,5 триллиона долларов выпустила более дешевую модель вывода: Google's Близнецы Flash 2.0 Thinking. модель есть и доступна через API Намного дешевле, чем R1.даже если контекстная длина модели больше.

Flash 2.0 Thinking выигрывает у R1 в заявленных бенчмарках, хотя бенчмарки не говорят всей истории. Google выпустила только 3 бенчмарка, поэтому картина неполная. Тем не менее, мы считаем, что модель Google надежна и может конкурировать с R1 по многим параметрам, но не подвержена шумихе. Это может быть связано с отсутствием стратегии выхода Google на рынок и плохим пользовательским опытом, но R1 также стал сюрпризом в Китае.

Источник: SemiAnalysis

Разумеется, все это не умаляет достоинств DeepSeek, чья структура как быстрорастущего, хорошо финансируемого, умного и сфокусированного стартапа такова, что он выигрывает в плане выпуска моделей выводов. Мета и других гигантов по причине, достойной похвалы.

Технические достижения

DeepSeek взломала код и открыла инновации, которые еще не реализованы ведущими лабораториями. Мы ожидаем, что любые улучшения, выпущенные DeepSeek, будут практически сразу же воспроизведены западными лабораториями.

В чем заключаются эти улучшения? Большинство архитектурных достижений относится именно к V3, которая также является базовой моделью для R1. Давайте опишем эти новшества подробнее.

Обучение (до и после обучения)

DeepSeek V3 использует преимущества беспрецедентного масштаба нескольких Токен Прогнозирование (MTP) - это модули, добавляющие внимание, которые предсказывают несколько следующих токенов вместо одного токена. Это улучшает производительность модели во время обучения и может быть отменено во время вывода. Это пример алгоритмической инновации, которая позволяет повысить производительность при меньших вычислительных затратах.

Есть и другие оговорки, например, точность FP8 при обучении, но ведущие лаборатории США уже давно проводят обучение по FP8.

DeepSeek v3 также является гибридной экспертной моделью, которая представляет собой большую модель, состоящую из множества других более мелких экспертов, специализирующихся на различных вещах, своего рода эмерджентное поведение. Одна из проблем, с которой сталкивается модель MoE, заключается в том, как определить, какой Token отправляется к какой субмодели или "эксперту". В DeepSeek реализована "закрытая сеть", которая сбалансированно направляет Token к нужному эксперту, не влияя на производительность модели. Это означает, что маршрутизация очень эффективна, и каждый токен изменяет лишь несколько параметров во время обучения относительно общего размера модели. Это повышает эффективность обучения и снижает стоимость выводов.

Несмотря на опасения, что повышение эффективности гибридных экспертов (MoE) может привести к сокращению инвестиций, Дарио отмечает, что экономическая эффективность более мощных моделей ИИ настолько велика, что любая экономия быстро реинвестируется в создание более крупных моделей. Повышение эффективности MoE не сокращает общие инвестиции, а скорее ускоряет усилия по масштабированию ИИ. Эти компании фокусируются на масштабировании моделей для большего количества вычислений и повышении их эффективности с помощью алгоритмов.

В случае с R1 ей помогло наличие сильной базовой модели (v3), отчасти благодаря обучению с подкреплением (RL). Отчасти это связано с обучением с подкреплением (RL), которое имеет два основных направления: форматирование (для обеспечения связного вывода) и полезность и безвредность (для обеспечения полезности модели). В процессе тонкой настройки модели на синтетическом наборе данных появляется способность к рассуждению. Это.Как описано в нашей статье Законы масштабированияИменно это и произошло с o1. Обратите внимание, что в статье R1 нет упоминания о вычислениях, потому что упоминание о том, сколько вычислений было использовано, указывает на то, что у них было больше GPU, чем подразумевается в описании. RL такого масштаба требует много вычислений, особенно для создания синтетических данных.

Кроме того, некоторые данные, используемые DeepSeek, судя по всему, получены из моделей OpenAI, что, как нам кажется, повлияет на стратегию извлечения информации из результатов. Это уже запрещено в TOS, но если смотреть в будущее, то новой тенденцией может стать форма KYC (Know Your Customer) для блокировки извлечений.

Если говорить об извлечении, то, пожалуй, самой интересной частью документа R1 является возможность тонкой настройки неинферентных мини-моделей, используя выходы инферентных моделей для их преобразования в инферентные модели. Управление набором данных содержит в общей сложности 800 000 образцов, и теперь любой желающий может создавать свои собственные наборы данных, используя выходы CoT в R1, и строить модели вывода с помощью этих выходов. Вероятно, мы увидим больше небольших моделей, демонстрирующих возможности вывода, что повысит производительность небольших моделей.

Многоуровневое внимание (MLA)

MLA - это ключевое нововведение, которое привело к значительному снижению стоимости выводов в DeepSeek. Причина в том, что по сравнению со стандартным вниманием MLA уменьшает объем KV-кэширования, необходимого для каждого запроса, примерно на 93.3%Кэш KV - это Трансформатор Механизм памяти в модели для хранения данных, представляющих контекст диалога, что позволяет сократить ненужные вычисления.

Как уже говорилось в нашей статье "Законы масштабирования", кэш KV растет по мере увеличения контекста диалога и создает значительный лимит памяти. Значительное уменьшение объема KV-кэша, необходимого для каждого запроса, уменьшило бы количество аппаратного обеспечения, требуемого для каждого запроса, тем самым снизив затраты. Однако мы считаем, что DeepSeek предлагает вывод по себестоимости, чтобы завоевать долю рынка, не зарабатывая при этом денег. Google Gemini Flash 2 Thinking все еще дешевле, и Google вряд ли будет предлагать его по себестоимости. MLA, в частности, привлекла внимание многих ведущих лабораторий США. MLA используется в DeepSeek V2, выпуск которого намечен на май 2024 года. Эффективность работы DeepSeek с H20 по сравнению с H100 также выше благодаря более высокой пропускной способности и емкости памяти H20. Компания также объявила о партнерстве с Huawei, но пока работы над вычислениями Ascend очень мало.

Наиболее интересными для нас являются последствия, в частности, влияние на маржу и то, что это означает для экосистемы в целом. Ниже мы рассмотрим будущую структуру цен в индустрии ИИ и подробно расскажем, почему мы считаем, что DeepSeek субсидирует цены, и почему мы видим первые признаки вступления в силу парадокса Джевонса. Мы комментируем последствия для экспортного контроля, возможную реакцию CCP по мере роста доминирующего положения DeepSeek и многое другое.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...