DeepSeek поджигает Олламу, безопасно ли ваше локальное развертывание? Опасайтесь "украденной" арифметики!

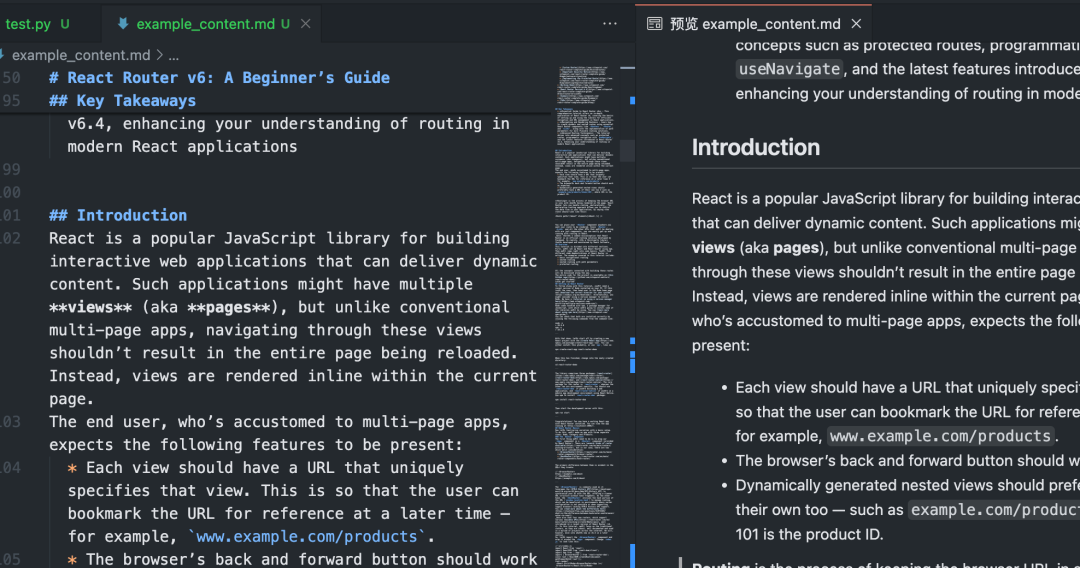

В последние годы технология моделирования больших языков (LLM) развивается беспрецедентными темпами и постепенно проникает в различные отрасли. В то же время растет и спрос на локальное развертывание LLM. ollama, как удобный инструмент локального развертывания больших моделей, хорошо известна своей простотой в использовании и способностью DeepSeek и другие продвинутые модели предпочитают разработчики и любители технологий.

Однако в погоне за технологическим удобством часто упускаются из виду риски безопасности. Некоторые пользователи развертывают локально Оллама После обслуживания порт службы Ollama может быть открыт для доступа в Интернет из-за неправильной конфигурации или слабой осведомленности о безопасности, что закладывает основу для потенциальных рисков безопасности. В этой статье мы проанализируем этот риск безопасности от начала и до конца и предложим соответствующие превентивные меры.

1. Удобство и потенциальные угрозы безопасности Ollama

Появление Ollama снизило барьеры для локального развертывания и использования больших языковых моделей, позволив пользователям легко запускать высокопроизводительные модели, такие как DeepSeek, на своих компьютерах или серверах. Это удобство привлекло большое количество пользователей, но оно же породило проблему, которую нельзя игнорировать:Сервис Ollama в его стандартной конфигурации может быть подвержен риску несанкционированного доступа из Интернета.

В частности, если пользователь развертывает службу Ollama, не выполнив необходимых настроек безопасности, таких как ограничение адресов прослушивания или настройка правил брандмауэра, то порт 11434, на котором Ollama прослушивает службу по умолчанию, может быть открыт для публики. Это означает, что любой пользователь Интернета может получить доступ к вашей службе Ollama по сети иБесплатное использование вычислительных ресурсов может привести даже к более серьезным проблемам с безопасностью.

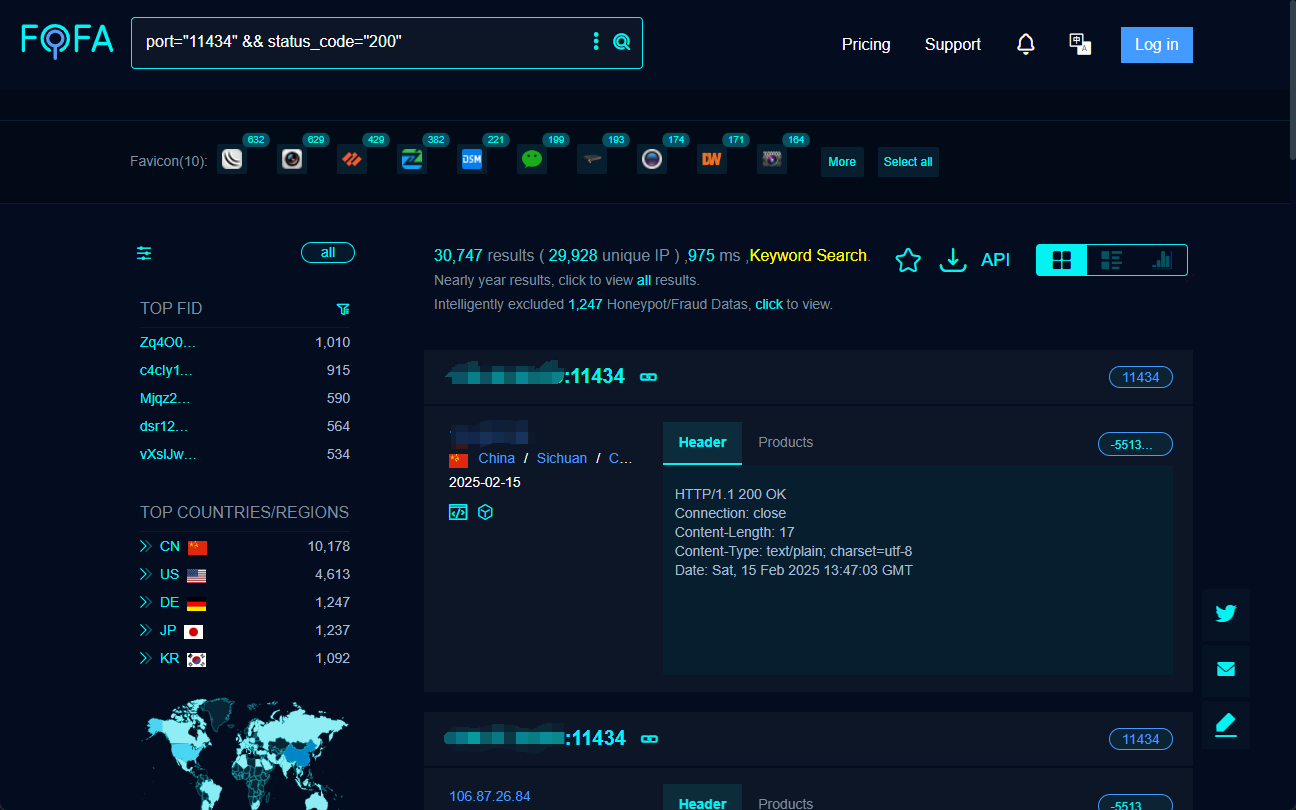

2. Как найти открытые услуги Ollama в Интернете? -- Поисковая система FOFA

Чтобы понять, в какой степени услуги Ollama представлены в Интернете и каков спектр потенциальных рисков, нам понадобится помощь поисковой системы киберпространства.FOFA Это мощный инструмент, который помогает нам быстро находить и находить публично открытые веб-сервисы по всему миру.

Тщательно составляя поисковые запросы FOFA, мы можем эффективно находить узлы, которые открывают порты служб Ollama для выхода в Интернет. Например, следующий поисковый запрос FOFA может быть использован для поиска целей с открытым портом 11434 и кодом состояния 200:

port="11434" && status_code="200"

Выполнив вышеуказанный поиск, FOFA составляет список квалифицированных целевых IP-адресов, на которых, вероятно, работают открытые для публики сервисы Ollama.

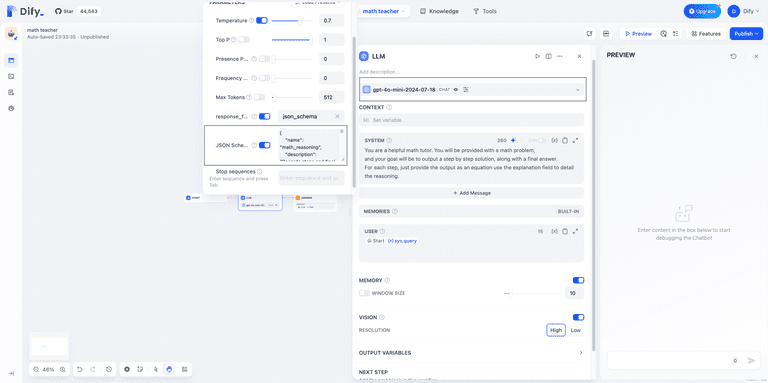

3. Как подключить и "завести" открытый сервис Ollama? -- ChatBox и Cherry Studio

После того как открытый интерфейс сервиса Ollama был найден с помощью FOFA, следующим шагом будет подключение и взаимодействие с ним с помощью инструментов на стороне клиента.ChatBox ответить пением Студия "Вишня это два широко используемых клиентских AI-программных обеспечения, оба из которых поддерживают подключение к сервису Ollama с помощью вызовов моделей и диалогов.

3.1 Использование ChatBox для подключения к службе Open Ollama

ChatBox Подключение к сервису Open Ollama, известному своей простотой и удобством использования, осуществляется очень просто:

- Загрузите и установите клиент ChatBox.

- Настройте адрес API: существовать ChatBox В настройках установите для адреса API IP-адрес и порт целевого сервера, например

http://目标IP:11434/. - Выберите модель и начните диалог: После завершения настройки вы можете выбрать модель и начать диалог с удаленным сервисом Ollama.

3.2 Подключение к сервису Open Ollama с помощью Cherry Studio

Студия "Вишня Он является более полным и поддерживает расширенные возможности, такие как управление базой знаний в дополнение к функциям диалога. Подключение осуществляется следующим образом:

- Загрузите и установите клиент Cherry Studio.

- Настройте интерфейс Ollama: существовать Студия "Вишня В разделе "Настройки" → "Службы модели" → "Ollama" установите адрес API

http://目标IP:11434. - Добавьте и проверьте модель: Добавьте целевую модель на странице управления моделями, например "deepseek-r1:1.5b", протестируйте соединение и после успеха можете использовать его.

С помощью таких клиентов, как ChatBox или Cherry Studio, пользователи могут легко подключаться к сервисам Ollama, представленным в Интернете, иСвободное несанкционированное использование чужих вычислительных ресурсов и возможностей моделирования.

Получив случайный адрес, попробуйте использовать веб-плагин, который поддерживает чтение моделей Ollama. Помощник страницы Диалог в центре:

4. Риски безопасности за "бесплатным обедом": кража электроэнергии, утечка данных и юридические подводные камни

За кажущимся "бесплатным обедом" скрывается множество рисков безопасности и потенциальных юридических проблем:

- Арифметическая кража (нецелевое использование ресурсов). Самый непосредственный риск заключается в том, что вычислительные мощности GPU поставщика услуг Ollama используются другими без компенсации, что приводит к напрасной трате ресурсов и снижению производительности. Злоумышленники могут использовать автоматизированные скрипты для массового сканирования и подключения к открытым сервисам Ollama, превращая их GPU в "потогонные фабрики" для обучения вредоносных моделей.

- Нарушение данных. Если конфиденциальные данные хранятся или обрабатываются в сервисе Ollama, существует риск утечки этих данных в открытой сетевой среде. Журналы диалогов пользователей, данные обучения и т. д. могут передаваться по незашифрованным каналам и быть злонамеренно прослушанными или украденными.

- Модели для продажи. Незашифрованные файлы моделей легко скачиваются и копируются, и если в услугах Ollama используются большие модели коммерчески ценных отраслей, существует риск, что модели могут быть украдены и проданы, что приведет к значительным финансовым потерям.

- Вторжение в систему. Сам сервис Ollama может иметь уязвимость в безопасности, которая, если ее использует хакер, может привести к удаленному выполнению кода, что позволит злоумышленнику получить полный контроль над сервером жертвы, превратив егопревратиться вЧасть ботнета, используемого для проведения масштабных кибератак.

- Юридические риски. Несанкционированный доступ и использование чужих сервисов Ollama или даже их злонамеренное использование могут нарушить соответствующие законы и правила и повлечь за собой юридическую ответственность.

5. безопаснее ли китайские пользователи? -- Динамический IP не является абсолютным барьером

Утверждается, что "китайские пользователи относительно защищены от этого риска "белой шкуры" из-за низкого уровня независимого владения ИС". Эта точка зрения несколько односторонняя.

Правда, среди китайских пользователей домашнего широкополосного доступа к Интернету динамические IP-адреса используются чаще, чем в западных странах, что в определенной степени снижает риск заражения. Неопределенность динамических IP затрудняет злоумышленникам отслеживание и определение местонахождения конкретных пользователей с течением времени.

Но это ни в коем случае не означает, что китайские пользователи могут быть спокойны. Во-первых, в китайском интернет-пространстве по-прежнему существует большое количество серверов Ollama, в том числе с фиксированными IP-адресами. Во-вторых, даже динамические IP-адреса могут оставаться неизменными в течение определенного периода времени, и злоумышленник все еще может осуществить атаку в период, когда IP-адрес не был изменен. Что еще более важно.Безопасность не может зависеть от "удачи" или "естественных барьеров", она должна основываться на проактивных мерах безопасности.

6. Местные рекомендации по безопасности службы Ollama: как не стать "бройлером"

Чтобы защитить локально развернутые службы Ollama от неправомерного использования другими лицами, пользователям необходимо принимать активные и эффективные меры безопасности. Ниже приведены некоторые рекомендации для начинающих пользователей:

6.1 Ограничение адресов прослушивания службы Ollama

Измените адрес прослушивания службы Ollama со стандартного 0.0.0.0 измениться 127.0.0.1Все в порядке.Заставляет службу Ollama прослушивать запросы только с локального компьютера и запрещает прямой доступ из внешних сетей. Выполните следующие действия:

- Найдите файл конфигурации: Конфигурационные файлы Ollama обычно находятся в папке

/etc/ollama/config.conf.. Откройте файл (или создайте его, если он не существует), найдите или добавьте строкуbind_addressЭлемент конфигурации. - Измените адрес привязки: главнокомандующий (военный)

bind_addressустанавливается на значение127.0.0.1и обеспечить, чтобыportустановленный на11434. Пример полной конфигурации показан ниже:bind_address = 127.0.0.1 port = 11434 - Сохраните и перезапустите службу: После сохранения файла конфигурации выполните команду

sudo systemctl restart ollamaчтобы конфигурация вступила в силу, перезапустите службу Ollama.

6.2 Настройка правил брандмауэра

Настроив правила брандмауэра, вы можетеТочный контроль над диапазоном IP-адресов и портов, разрешенных для доступа к сервису Ollama. Например, вы можете разрешить доступ к порту 11434 только IP-адресам вашей локальной сети и заблокировать все запросы на доступ из публичной сети. Ниже описана настройка брандмауэра в средах Windows и Linux соответственно:

Этапы настройки среды Windows:

- Включите брандмауэр Advanced Security Windows Defender: В "Панели управления" найдите "Система и безопасность", нажмите "Брандмауэр Windows Defender", а затем выберите "Дополнительные параметры". Дополнительные параметры".

- Создайте новое входящее правило: В разделе "Входящие правила" нажмите "Новое правило...", выберите тип правила "Порт" и нажмите "Далее". Далее".

- Укажите порт и протокол: Протокол выбран как "TCP", а конкретный локальный порт установлен на

11434Нажмите "Далее". - Выберите операцию: Выберите "Разрешить подключение" и нажмите "Далее".

- Настройте область действия (необязательно): Вы можете настроить области действия правил по своему усмотрению, но обычно просто сохраняйте параметры по умолчанию и нажмите кнопку Далее.

- Укажите имя и описание: Присвойте правилу легко узнаваемое имя (например, "Ограничение портов службы Ollama"), добавьте описание (необязательно) и нажмите "Готово", чтобы завершить создание правила.

Среда Linux (например, брандмауэр ufw) Этапы настройки:

- Включите брандмауэр ufw: Если ufw еще не включен, выполните следующие действия в терминале

sudo ufw enableчтобы включить брандмауэр. - Разрешить доступ к локальной сети: осуществлять

sudo ufw allow from 192.168.1.0/24 to any port 11434команда, которая позволяет192.168.1.0/24IP-адрес сегмента локальной сети получает доступ к порту 11434. Пожалуйста, измените диапазон IP-адресов в соответствии с реальным сегментом локальной сети. - Запретить доступ другим (необязательно): Если политика по умолчанию разрешает весь внешний доступ, вы можете выполнить команду

sudo ufw deny 11434команда, запрещающая доступ к порту 11434 для IP-адресов из всех других источников. - Просмотр состояния брандмауэра: осуществлять

sudo ufw status verboseчтобы проверить состояние правила брандмауэра и убедиться, что конфигурация вступила в силу.

6.3 Включение аутентификации и управления доступом

В тех случаях, когда вам необходимо предоставить услуги Ollama извне, убедитесь, чтоВключение механизмов аутентификации. для предотвращения несанкционированного доступа. Ниже перечислены некоторые распространенные методы аутентификации:

- Базовая аутентификация HTTP: Базовая аутентификация HTTP может быть настроена через веб-сервер, например Apache или Nginx. Этот метод прост и удобен в использовании, но его безопасность относительно низкая, что подходит для сценариев, не требующих высокой безопасности. После настройки базовой аутентификации пользователям необходимо указывать имя пользователя и пароль при доступе к сервисам Ollama.

- Ключ API: Добавьте механизм проверки API-ключа во фронтенд сервиса Ollama. Когда клиент запрашивает сервис Ollama, ему необходимо включить предопределенный ключ API в заголовок запроса или параметры запроса. Серверная сторона проверяет валидность ключа, и обрабатываются только запросы с правильным ключом. Такой подход более безопасен, чем базовая аутентификация, и легко интегрируется в приложения.

- Более продвинутые механизмы авторизации аутентификации, такие как OAuth 2.0: Для сценариев с повышенными требованиями к безопасности можно использовать более сложные системы аутентификации и авторизации, такие как OAuth 2.0. OAuth 2.0 обеспечивает совершенный процесс авторизации и аутентификации, поддерживает несколько режимов авторизации и позволяет достичь тонкого контроля доступа. Однако настройка и интеграция OAuth 2.0 относительно сложна и требует определенных усилий по разработке.

Выбор метода аутентификации должен основываться на сочетании таких факторов, как сценарии применения, требования к безопасности и стоимость технической реализации сервиса Ollama.

6.4 Использование обратного прокси-сервера

Используя обратный прокси-сервер (например, Nginx), вы можетеДействует как внешний интерфейс для службы Ollama, скрывая реальный IP-адрес и порт службы Ollama и обеспечивая дополнительные функции безопасности.Например:

- Скройте внутренний сервер: Обратный прокси-сервер служит "фасадом" для службы Ollama. Внешние пользователи видят только IP-адрес обратного прокси-сервера и не могут напрямую получить доступ к реальному серверу, на котором расположена служба Ollama, что повышает безопасность.

- Балансировка нагрузки: Если служба Ollama развернута на нескольких серверах, обратный прокси-сервер может реализовать балансировку нагрузки, чтобы распределить пользовательские запросы по разным серверам, повышая доступность и производительность службы.

- Шифрование SSL/TLS: Обратные прокси-серверы могут быть настроены на использование сертификатов SSL/TLS для обеспечения доступа с шифрованием HTTPS и защиты безопасности передачи данных.

- Брандмауэр веб-приложений (WAF): Некоторые обратные прокси-серверы интегрируют функциональность WAF для обнаружения и защиты от распространенных веб-атак, таких как SQL-инъекции, межсайтовые скриптовые атаки (XSS) и т. д., что еще больше повышает безопасность сервиса Ollama.

- Контроль доступа: Обратные прокси-серверы могут быть настроены на более гибкие политики контроля доступа, например, контроль доступа на основе IP-адреса, идентификации пользователя и содержимого запроса.

7. Заключение: осведомленность о безопасности и ответственность в действии

Популярность локально развернутых инструментов больших моделей, таких как Ollama, способствовала развитию технологических инноваций и приложений, но также поставила новые проблемы в области кибербезопасности. Сервис Ollama, представленный в Интернете как "бесплатный для использования", может показаться заманчивым, но он несет в себе скрытые риски. Такое поведение может не только нарушать законы, правила и киберэтику, но и представлять угрозу для вашей и чужой кибербезопасности.

Для развертывателей услуг Ollama повышение осведомленности о безопасности и принятие необходимых мер безопасности - это ответственность за защиту собственных вычислительных ресурсов и сохранность данных, а также за поддержание здорового сетевого окружения. Не превращайте свои серверы в "арифметические бройлеры" и даже не становитесь соучастниками кибератак из-за минутной небрежности.

Наслаждаясь дивидендами технологий, каждый пользователь Интернета должен всегда быть бдительным, иметь правильное представление о сетевой безопасности и работать вместе над созданием безопасной, надежной и устойчивой экосистемы приложений ИИ.

Снова предупреждение о риске: пожалуйста, немедленно проверьте и закалите свой сервис Ollama! Безопасность - это не мелочь!

Популярность модели DeepSeek и инструмента Ollama, несомненно, свидетельствует о развитии технологий искусственного интеллекта. Однако безопасность всегда остается краеугольным камнем технологического прогресса, который нельзя игнорировать. Пожалуйста, пользователи OllamaНемедленно пересмотрите конфигурацию локального развертывания, оцените потенциальные риски безопасности и примите необходимые меры по укреплению. Еще не поздно исправить ситуацию.

Для тех, кто еще не установил Ollama или только собирается ее развернуть, не забудьте такжеПолностью осознайте риски безопасности при локальном развертывании инструментов больших моделей, взвешенно оцените собственные технические возможности и уровень защиты, и используйте их надлежащим образом, исходя из соображений обеспечения безопасности. Помните, что за кибербезопасность отвечают все, а предотвратить ее до того, как она случится, - лучшая стратегия.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...