Масштабное применение технологии кэширования жестких дисков в API DeepSeek: ключевой шаг в цивилизации больших моделей

-- Обсуждение глубинной логики ценовых войн API больших моделей, оптимизации пользовательского опыта и включения технологий.

Image credit: Официальная документация DeepSeek

В то время как конкуренция в области создания больших моделей искусственного интеллекта обостряется, компания DeepSeek недавно объявила о том, что ее API-сервис инновационно используетТехнология кэширования жесткого дискаКорректировка цен DeepSeek просто шокирует - цена на часть кэш-хитов напрямую снижается до одной десятой от прежней цены, что в очередной раз освежает нижнюю границу цен в индустрии. Как сторонний обозреватель, давно интересующийся технологией больших моделей и тенденциями в отрасли, я считаю, что шаг DeepSeek - это не только революция в стоимости, вызванная технологическими инновациями, но и глубокая оптимизация пользовательского опыта API больших моделей, а также важный шаг к ускоренному распространению технологии больших моделей.

Технологические инновации: тонкости кэширования жестких дисков и скачки производительности

DeepSeek прекрасно понимает, что проблемы высокой стоимости и задержек уже давно сдерживают широкое распространение API больших моделей, а повсеместное контекстное дублирование пользовательских запросов - один из ключевых факторов, способствующих возникновению этих проблем. Например, в многораундовых диалогах историю предыдущего диалога приходится вводить заново в каждом раунде; в задачах обработки длинных текстов Prompt часто содержит повторяющиеся ссылки. Повторяющиеся вычисления Токен Это приводит к пустой арифметике и увеличивает время ожидания.

Чтобы решить эту проблему, DeepSeek креативно внедряет технологию контекстного кэширования на жестких дисках. Основной принцип заключается в интеллектуальном кэшировании контекстного контента, который, по прогнозам, будет повторно использоваться в будущем, например истории диалогов, системных пресетов, примеров Few-shot и т. д., в распределенный массив жестких дисков. Когда пользователь инициирует новый API-запрос, система автоматически определяет, совпадает ли префиксная часть входных данных с кэшированным контентом (обратите внимание: префикс должен быть идентичным, чтобы попасть в кэш). Если совпадает, система считывает дубликат непосредственно из высокоскоростного кэша жесткого диска без пересчета, оптимизируя задержку и стоимость.

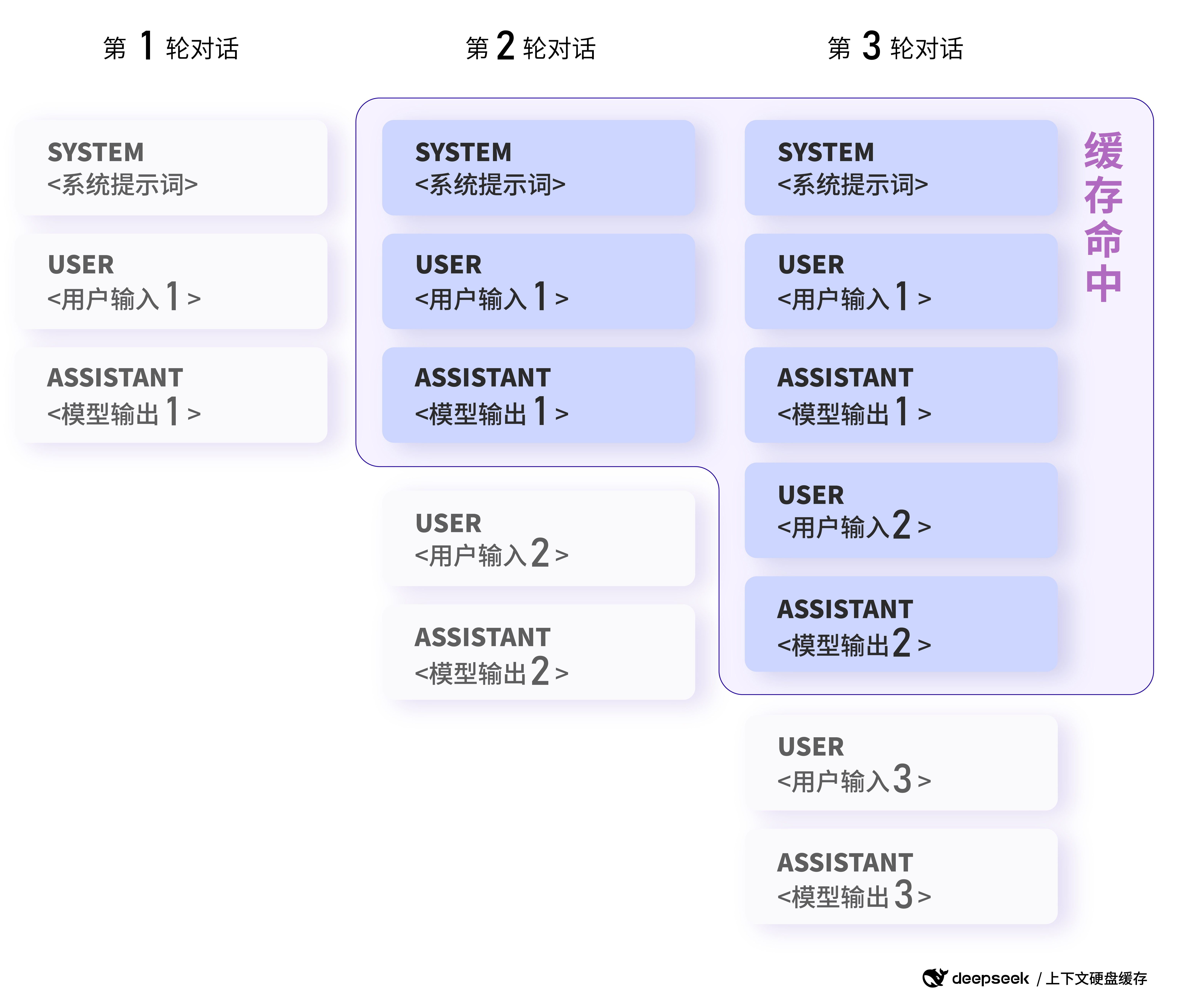

Чтобы лучше понять, как работает кэширование, давайте рассмотрим несколько примеров DeepSeek Предоставлен официальный пример:

Пример 1: сценарий многораундового диалога

Основная особенность: последующие раунды диалога автоматически используют контекстный кэш предыдущего раунда.

В многораундовых диалогах, где пользователи обычно задают последовательные вопросы по одной теме, кэширование на жестком диске DeepSeek позволяет эффективно повторно использовать контекст диалога. Например, в следующем сценарии диалога:

Первая просьба:

messages: [

{"role": "system", "content": "你是一位乐于助人的助手"},

{"role": "user", "content": "中国的首都是哪里?"}

]

Вторая просьба:

messages: [

{"role": "system", "content": "你是一位乐于助人的助手"},

{"role": "user", "content": "中国的首都是哪里?"},

{"role": "assistant", "content": "中国的首都是北京。"},

{"role": "user", "content": "美国的首都是哪里?"}

]

Image credit: Официальная документация DeepSeek

Пример попадания в кэш в сценарии многораундового диалога: последующие раунды диалога автоматически попадают в контекстный кэш предыдущего раунда.

При втором запросе, поскольку префиксная часть (системное сообщение + первое сообщение пользователя) точно такая же, как и при первом запросе, эта часть попадет в кэш без повторного вычисления, что сокращает время ожидания и стоимость.

Согласно официальным данным DeepSeek, в экстремальных сценариях с 128 тыс. входов и большим количеством повторений измеренная задержка первого маркера снизилась с 13 секунд до 500 миллисекунд, что является потрясающим улучшением производительности. Даже в неэкстремальных сценариях она может эффективно снизить задержку и улучшить пользовательский опыт.

Более того, служба кэширования жестких дисков DeepSeek полностью автоматизирована и не зависит от пользователя. Вы можете наслаждаться преимуществами кэширования по производительности и цене, не внося никаких изменений в код или интерфейс API. Новая функция prompt_cache_hit_tokens (хиты кэша) в поле usage, возвращаемом API, позволяет пользователям видеть количество полученных хитов кэша. жетоны (количество маркеров) и prompt_cache_miss_tokens (количество пропущенных маркеров) для мониторинга попаданий в кэш в реальном времени, чтобы лучше оценить и оптимизировать производительность кэширования.

DeepSeek способен занять лидирующие позиции в масштабном применении технологии кэширования на жестком диске, что неотделимо от передовой архитектуры модели. Структура MLA (Multi-head Latent Attention), предложенная DeepSeek V2, значительно уменьшает размер контекстного KV Cache, гарантируя при этом производительность модели, что позволяет хранить KV Cache на недорогом жестком диске, закладывая основу для укоренения технологии кэширования на жестком диске на рынке. Это позволяет хранить KV Cache на недорогом жестком диске, закладывая основу для технологии кэширования на жестком диске.

понимания DeepSeek-R1 Хит кэша API в сравнении с ценой:Использование API DeepSeek-R1 Часто задаваемые вопросы

Сценарии применения: от длинных текстовых вопросов и ответов до анализа кода - границы применения можно расширять бесконечно!

Сценарии применения технологии кэширования на жестком диске очень широки, и практически любое крупное модельное приложение с контекстным вводом может извлечь из нее пользу. В оригинальной статье перечислены следующие типичные сценарии и приведены более конкретные примеры:

- Ассистент викторины с длинными предустановленными словами-подсказками:

- Основная функция: фиксированные системные подсказки можно кэшировать, что снижает стоимость одного запроса.

- Пример:

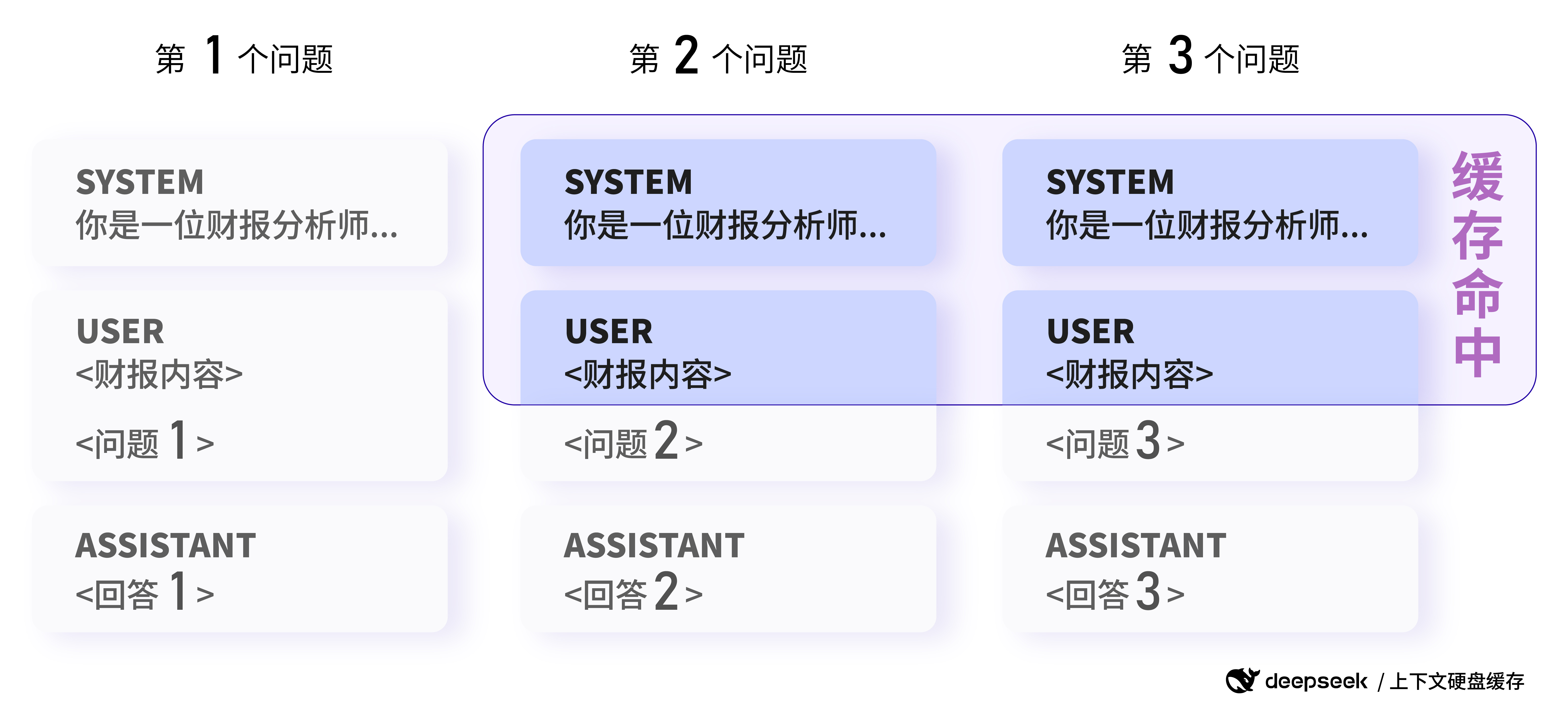

Пример 2: Сценарий вопросов и ответов с длинным текстом

Основная особенность: несколько анализов одного и того же документа могут попасть в кэш.

Пользователи должны анализировать один и тот же отчет о прибылях и задавать разные вопросы:

Первая просьба:

messages: [

{"role": "system", "content": "你是一位资深的财报分析师..."},

{"role": "user", "content": "<财报内容>\n\n请总结一下这份财报的关键信息。"}

]

Вторая просьба:

messages: [

{"role": "system", "content": "你是一位资深的财报分析师..."},

{"role": "user", "content": "<财报内容>\n\n请分析一下这份财报的盈利情况。"}

]

Во втором запросе, поскольку часть в системном и пользовательском сообщении имеет тот же префикс, что и в первом запросе, эта часть может быть помещена в кэш для экономии вычислительных ресурсов.

- Ролевые игры с несколькими раундами диалога:

- Основные особенности: высокая степень повторного использования истории диалогов и значительное кэширование.

- (Пример 1 был показан подробно)

- Анализ данных для коллекций фиксированных текстов:

- Основные возможности: несколько анализов и тестов по одному и тому же документу с высоким уровнем повторения префиксов.

- Например, несколько анализов и сессий вопросов и ответов по одному и тому же финансовому отчету или юридическому документу. (Пример 2 был подробно рассмотрен)

- Инструменты для анализа кода и устранения неполадок на уровне репозитория кода:

- Основная особенность: Задачи анализа кода часто связаны с большим количеством контекста, и кэширование может быть эффективным средством снижения затрат.

- Обучение с помощью нескольких выстрелов:

- Основная особенность: примеры Few-shot с префиксом Prompt могут кэшироваться, что снижает затраты на многократные вызовы Few-shot.

- Пример:

Пример 3: Сценарий обучения несколькими выстрелами

Основная особенность: один и тот же пример Few-shot можно кэшировать как префикс.

Пользователи используют Few-shot learning для повышения эффективности модели при проведении викторины на знание истории:

Первая просьба:

messages: [

{"role": "system", "content": "你是一位历史学专家,用户将提供一系列问题,你的回答应当简明扼要,并以`Answer:`开头"},

{"role": "user", "content": "请问秦始皇统一六国是在哪一年?"},

{"role": "assistant", "content": "Answer:公元前221年"},

{"role": "user", "content": "请问汉朝的建立者是谁?"},

{"role": "assistant", "content": "Answer:刘邦"},

{"role": "user", "content": "请问唐朝最后一任皇帝是谁"},

{"role": "assistant", "content": "Answer:李柷"},

{"role": "user", "content": "请问明朝的开国皇帝是谁?"},

{"role": "assistant", "content": "Answer:朱元璋"},

{"role": "user", "content": "请问清朝的开国皇帝是谁?"}

]

Вторая просьба:

messages: [

{"role": "system", "content": "你是一位历史学专家,用户将提供一系列问题,你的回答应当简明扼要,并以`Answer:`开头"},

{"role": "user", "content": "请问秦始皇统一六国是在哪一年?"},

{"role": "assistant", "content": "Answer:公元前221年"},

{"role": "user", "content": "请问汉朝的建立者是谁?"},

{"role": "assistant", "content": "Answer:刘邦"},

{"role": "user", "content": "请问唐朝最后一任皇帝是谁"},

{"role": "assistant", "content": "Answer:李柷"},

{"role": "user", "content": "请问明朝的开国皇帝是谁?"},

{"role": "assistant", "content": "Answer:朱元璋"},

{"role": "user", "content": "请问商朝是什么时候灭亡的"},

]

При втором запросе, поскольку в качестве префикса используется один и тот же пример из 4 снимков, эта часть может быть использована в кэше, и только последний вопрос должен быть пересчитан, что значительно снижает стоимость обучения по методу "несколько снимков".

Image credit: Официальная документация DeepSeek

Пример попадания в кэш в сценарии анализа данных: запросы с одинаковым префиксом могут попасть в кэш (примечание: изображение здесь соответствует оригинальному примеру анализа данных и больше сосредоточено на понятии дублирования префикса; сценарий примера Few-shot может быть интерпретирован таким же образом).

Эти сценарии - лишь верхушка айсберга. Применение технологии кэширования на жестких дисках открывает простор для фантазии при использовании API-интерфейсов для больших моделей с длинным контекстом. Например, мы сможем создавать более мощные инструменты для создания длинных текстов, решать более сложные наукоемкие задачи и разрабатывать более глубокие и запоминающиеся приложения разговорного ИИ.

Ссылка: Вдохновленный Клод

Преимущество в стоимости: цены снижаются на порядки, что благоприятно сказывается на экологии большой модели.

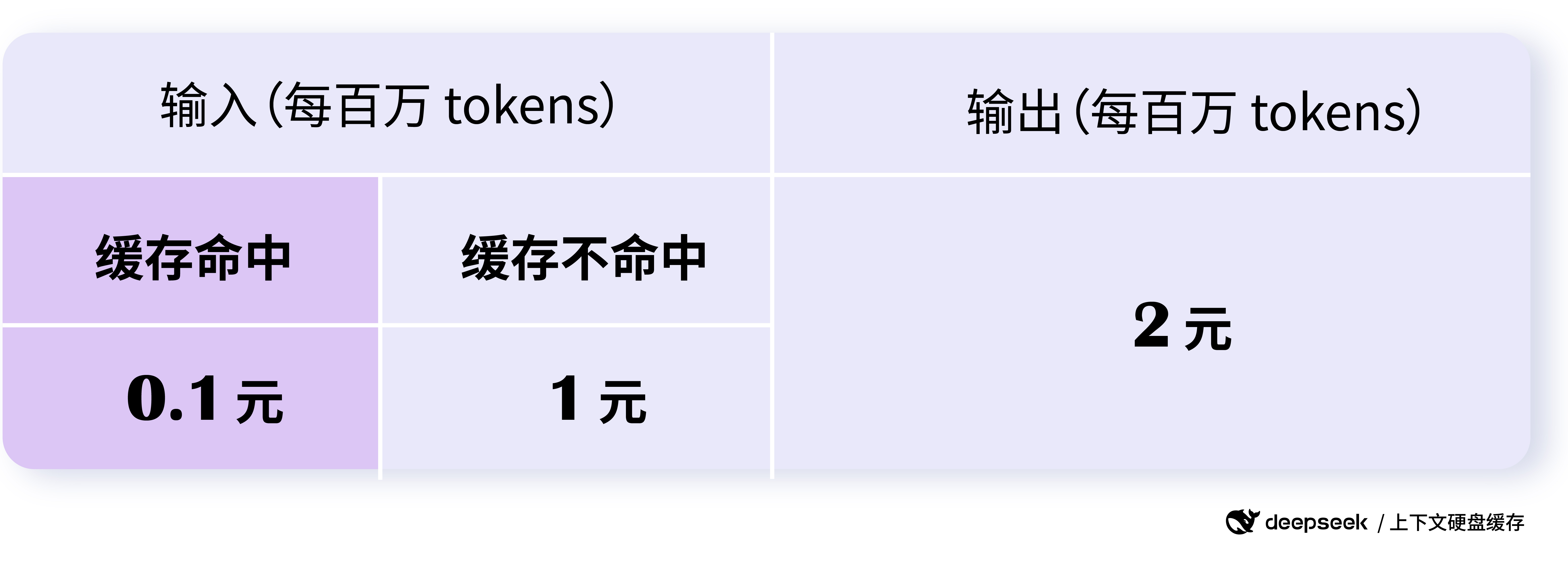

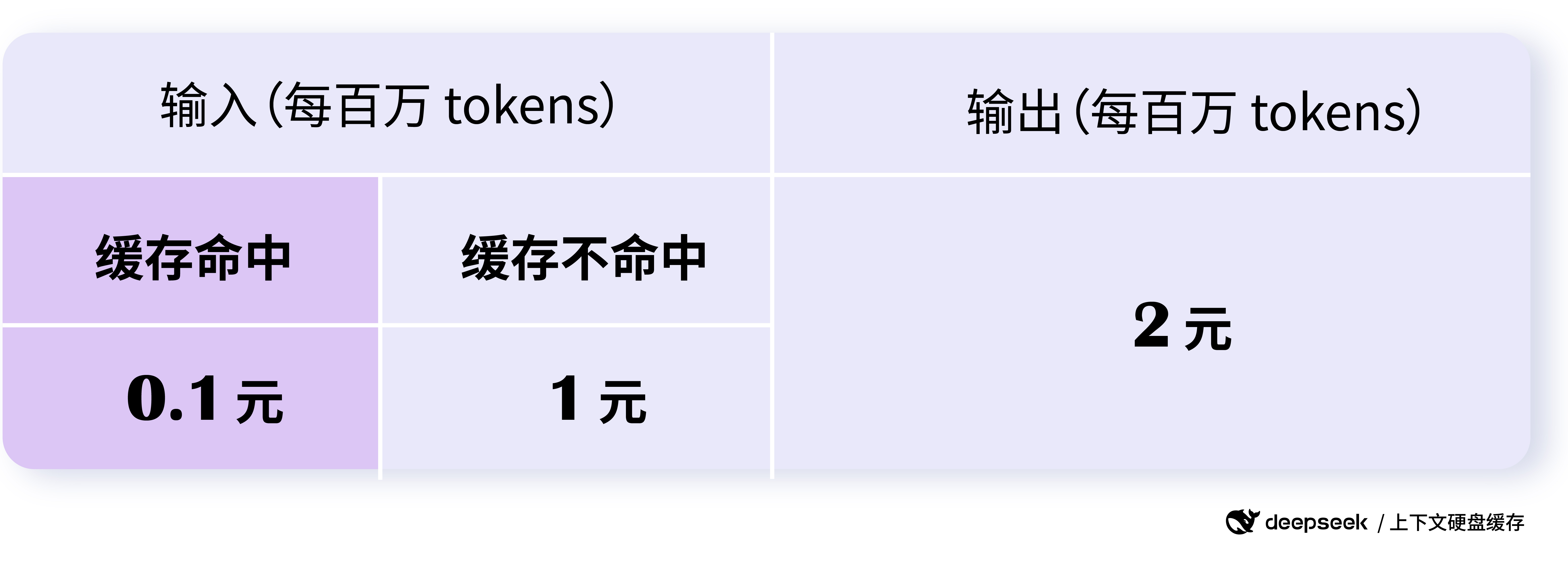

Корректировка цен на API DeepSeek "эпическая": часть API, связанная с попаданием в кэш, будет стоить 0,10 доллара за миллион токенов, а часть, связанная с промахом, - 1 доллар за миллион токенов. Цена за попадание в кэш составляет всего 0,1 доллара за миллион токенов, а за промах - 1 доллар за миллион токенов, что на порядок ниже прежней цены за попадание в кэш.

Согласно официальным данным DeepSeek, он позволяет сэкономить до 90%, и даже без оптимизации пользователи могут сэкономить более 50%. Это преимущество по стоимости имеет большое значение для снижения порога применения больших моделей и ускорения их популярности.

Что еще более интересно, так это ценовая стратегия DeepSeek. Цены на просмотры и пропуски кэша распределены таким образом, чтобы стимулировать пользователей использовать кэш как можно больше, оптимизировать дизайн Prompt и увеличить процент попаданий в кэш, тем самым еще больше снижая стоимость. При этом ни за сам кэш-сервис, ни за место для хранения кэша не взимается дополнительная плата, что очень удобно для пользователей.

Image credit: Официальная документация DeepSeek

Стоимость API DeepSeek была значительно снижена, и теперь стоимость посещений кэша составляет всего 0,1 доллара за миллион токенов.

Значительное снижение цен на API DeepSeek, несомненно, ускорит эволюцию ценовой войны больших моделей. Однако, в отличие от предыдущей простой ценовой конкуренции, снижение цен DeepSeek - это рациональное снижение цен, основанное на технологических инновациях и оптимизации затрат, что является более устойчивым и ориентированным на отрасль. Эта здоровая ценовая конкуренция в конечном итоге принесет пользу всей экосистеме больших моделей, так что больше разработчиков и предприятий смогут пользоваться передовыми технологиями больших моделей по более низкой цене.

Неограниченная потоковая передача и параллелизм, безопасное и надежное кэширование.

Помимо производительности и ценовых преимуществ, стабильность и безопасность DeepSeek API также заслуживают доверия. Сервис DeepSeek API рассчитан на пропускную способность 1 триллион токенов в день, с неограниченным потоком и параллельностью для всех пользователей, что обеспечивает качество обслуживания в условиях высокой нагрузки.

DeepSeek также уделил особое внимание безопасности данных. Кэш каждого пользователя отделен и логически изолирован друг от друга, что обеспечивает безопасность и конфиденциальность пользовательских данных. Кэш, который не использовался в течение длительного времени, автоматически очищается (обычно через несколько часов - несколько дней) и не хранится в течение длительного времени, а также не используется в других целях, что еще больше снижает потенциальные риски безопасности.

Следует отметить, что система кэширования использует 64 жетона в качестве единицы хранения, и все, что меньше 64 жетонов, не будет кэшировано. Кроме того, система кэширования работает по принципу "best effort" и не гарантирует 100% попаданий в кэш. Кроме того, построение кэша занимает несколько секунд, но для сценариев с длинным контекстом это вполне приемлемо.

Обновление модели и перспективы на будущее

Стоит отметить, что вместе с запуском технологии кэширования жестких дисков компания DeepSeek также объявила об обновлении модели deepseek-chat до DeepSeek-V3, а модели deepseek-reasoner - до новой модели DeepSeek-R1. Новые модели предлагают улучшенную производительность и возможности при значительно более низкой цене, что еще больше повышает конкурентоспособность API DeepSeek.

Согласно официальной информации о ценах, API DeepSeek-V3 (deepseek-chat) пользуется скидкой до 24:00 8 февраля 2025 года, при этом его цена составляет всего $0,1/млн токенов за кэшированные хиты, $1/млн токенов за пропущенные входы и $2/млн токенов за выходы. API DeepSeek-R1 (deepseek-reasoner) позиционируется как модель вывода с длиной цепочки мыслей 32К и максимальной длиной выхода 8К, при этом цена входа (кэшированные хиты) составляет $1/млн токенов. API DeepSeek-R1 (deepseek-reasoner) позиционируется как модель умозаключений с длиной цепочки мыслей 32К и максимальной длиной выхода 8К, с ценой входа (кэшированные хиты) $1/миллион токенов, $4/миллион токенов за пропущенные входы и $16/миллион токенов за выходы (все токены для цепочки мыслей и конечного ответа). и все токены окончательного ответа).

Серия инновационных инициатив DeepSeek демонстрирует постоянные инвестиции в технологии и философию ориентации на пользователя. У нас есть все основания полагать, что благодаря DeepSeek и другим инновационным силам технология больших моделей ускорит свое становление, станет более инклюзивной и принесет более масштабные изменения во все отрасли.

заключительные замечания

Инновационное использование технологии кэширования на жестком диске и значительное снижение цены API DeepSeek является знаковым прорывом. Он не только решает давние проблемы стоимости и задержек в API больших моделей, но и приносит пользователям более качественные и инклюзивные услуги больших моделей благодаря технологическим инновациям. Шаг DeepSeek может пересмотреть схему конкуренции API больших моделей, ускорить популярность и применение технологий искусственного интеллекта и, в конечном итоге, построить более процветающую, открытую и инклюзивную экосистему больших моделей.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...