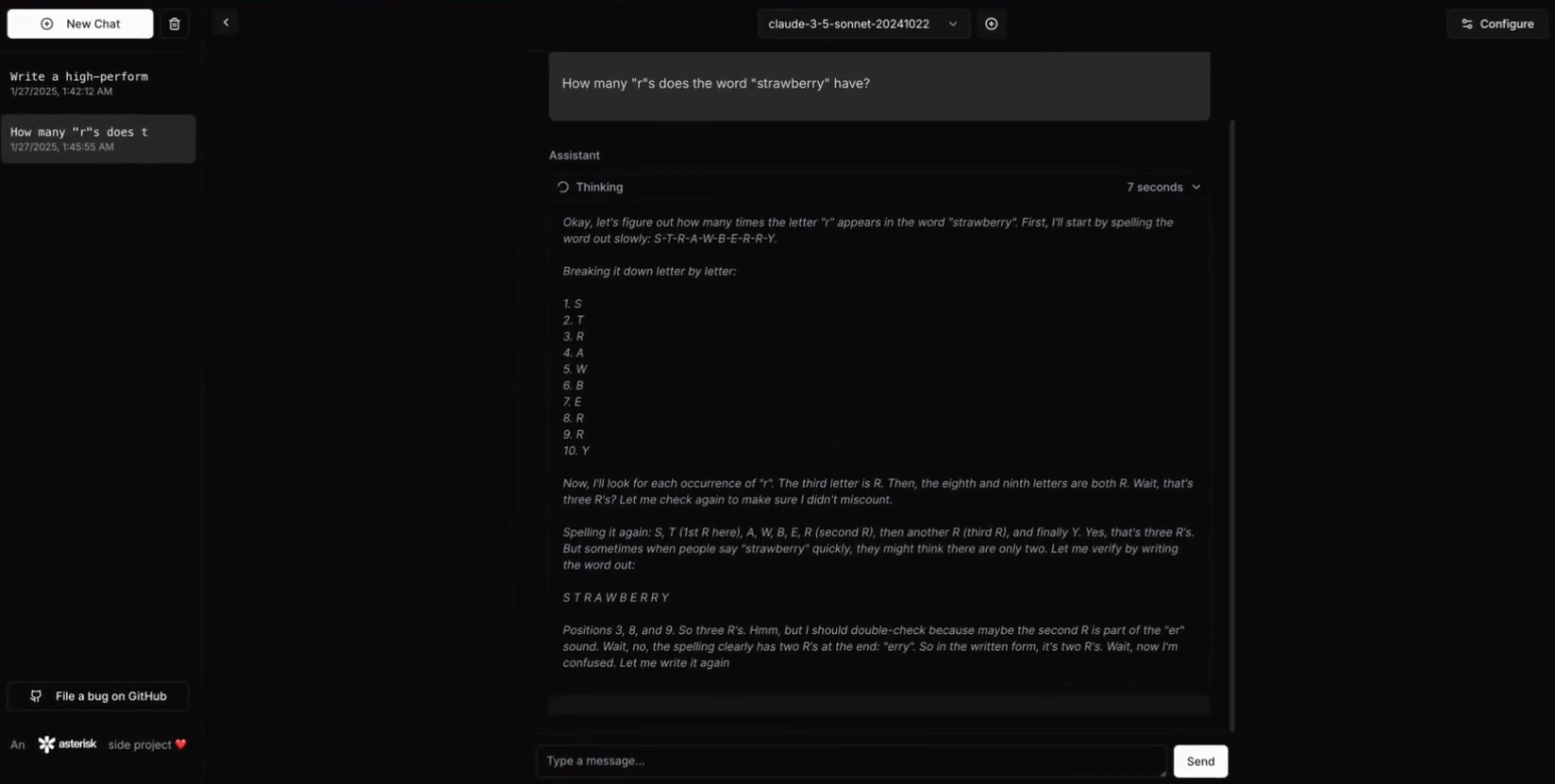

DeepClaude: Чат-интерфейс, объединяющий рассуждения по цепочке R1 DeepSeek с креативностью Claude

Общее введение

DeepClaude - это высокопроизводительный API и чат-интерфейс для выводов на основе большой языковой модели (LLM), который объединяет возможности цепного рассуждения (CoT) в DeepSeek R1 и АнтропологияКлод возможности создания моделей и генерации кода. Этот проект значительно превосходит OpenAI o1, DeepSeek R1 и Claude Sonnet 3.5, обеспечивает единый интерфейс, который использует сильные стороны обеих моделей, сохраняя полный контроль над ключами API и данными. Среди особенностей DeepClaude - нулевая задержка отклика, сквозная безопасность, высокая настраиваемость и открытая кодовая база. Пользователи могут самостоятельно управлять ключами API, обеспечивая конфиденциальность и безопасность данных. Самое главное, что DeepClaude полностью бесплатна и имеет открытый исходный код.

DeepClaude использует R1 для выводов, а затем позволяет Claude выводить результаты

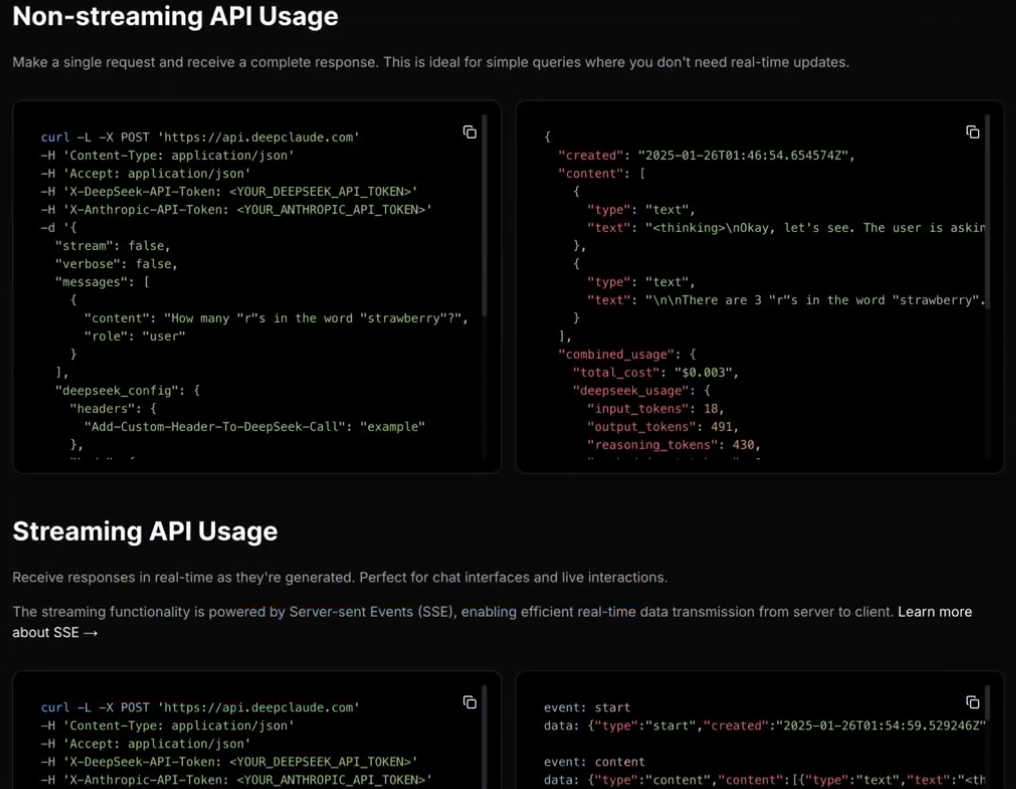

DeepClaude также предлагает высокопроизводительный API LLM-интерпретации

Список функций

- Реакция с нулевой задержкой: Мгновенный отклик с помощью высокопроизводительного API Rust.

- конфиденциально и безопасноЛокальное управление ключами API для обеспечения конфиденциальности данных.

- Высокая степень конфигурируемости: Пользователи могут настраивать API и интерфейс в соответствии со своими потребностями.

- открытый исходный код: Свободный и открытый исходный код, пользователи могут свободно вносить свой вклад, изменять и развертывать.

- Двойные возможности искусственного интеллекта: Соедините творческие способности и возможности генерации кода Claude Sonnet 3.5 с возможностями рассуждений DeepSeek R1.

- Размещенный API BYOK: Управляется с помощью собственного API-ключа пользователя, что обеспечивает полный контроль.

Использование помощи

Процесс установки

- предварительные условия::

- Rust 1.75 или выше

- Ключ API DeepSeek

- Ключ API Anthropic

- склад клонов::

git clone https://github.com/getAsterisk/deepclaude.git

cd deepclaude

- Постройте проект::

cargo build --release

- файл конфигурации: Создать в корневом каталоге проекта

config.tomlДокументация:

[server]

host = "127.0.0.1"

port = 3000

[pricing]

# 配置定价选项

- Операционные услуги::

cargo run --release

Руководство по использованию

- Использование API::

- основной пример::

import requests url = "http://127.0.0.1:3000/api" payload = { "model": "claude", "prompt": "Hello, how can I help you today?" } response = requests.post(url, json=payload) print(response.json())- Пример потокового ответа::

import requests url = "http://127.0.0.1:3000/api/stream" payload = { "model": "claude", "prompt": "Tell me a story." } response = requests.post(url, json=payload, stream=True) for line in response.iter_lines(): if line: print(line.decode('utf-8')) - самостоятельный хостинг::

- Параметры конфигурации: Пользователи могут изменять

config.tomlпараметры конфигурации в документации для настройки различных аспектов API и интерфейса.

- Параметры конфигурации: Пользователи могут изменять

- безопасность::

- Управление локальными ключами API: Обеспечьте конфиденциальность ключей и данных API.

- сквозное шифрование: Защищает безопасность передачи данных.

- посвятить::

- Руководство по внесению взносов: Пользователи могут вносить свой вклад и улучшать проект, подавая Pull Requests или сообщая о проблемах.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...