Полнокровный дистилляционный набор данных DeepSeek-R1 на китайской основе, поддерживает китайский дистилляционный набор данных SFT R1

Общее введение

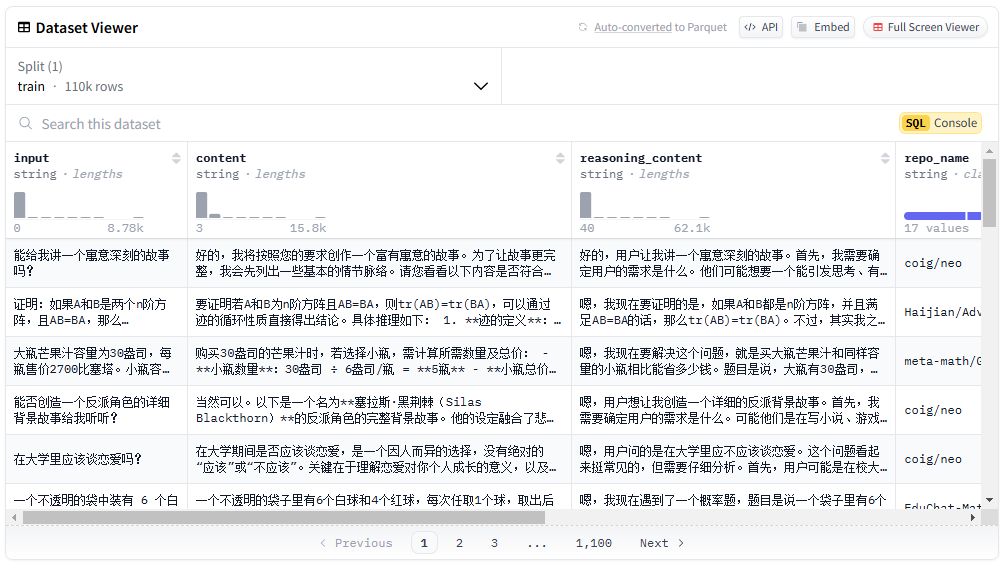

Китайский набор данных DeepSeek-R1 - это китайский набор данных с открытым исходным кодом, содержащий 110 тысяч единиц данных, предназначенных для поддержки исследований в области машинного обучения и обработки естественного языка. Набор данных выпущен командой Liu Cong NLP, и он содержит не только математические данные, но и большое количество общих типов данных, таких как логические рассуждения, Xiaohongshu, Zhihu и так далее. Процесс дистилляции набора данных осуществляется в строгом соответствии с деталями, предоставленными официальным представителем DeepSeek-R1, чтобы обеспечить высокое качество и разнообразие данных. Пользователи могут бесплатно загрузить и использовать набор данных на платформах Hugging Face и ModelScope.

Список функций

- Различные типы данных: Содержит математику, логические рассуждения, общие типы данных и т.д.

- Высококачественные данные: Дистиллировано в строгом соответствии с официальными данными, предоставленными DeepSeek-R1.

- свободный и открытый исходный код: Пользователи могут загрузить его бесплатно на платформах Hugging Face и ModelScope.

- Поддержка нескольких приложений: Применимо к широкому спектру областей исследований, таких как машинное обучение и обработка естественного языка.

- Подробное распределение данных: Обеспечивает подробную категоризацию данных и количественную информацию.

Использование помощи

Процесс установки

- Посетите платформы Hugging Face или ModelScope.

- Поиск "Chinese-DeepSeek-R1-Distill-data-110k".

- Нажмите на ссылку для скачивания и выберите подходящий формат для загрузки.

Использование

- Загрузка наборов данных: в среде Python

datasetsБиблиотека загружает набор данных.

from datasets import load_dataset

dataset = load_dataset("Congliu/Chinese-DeepSeek-R1-Distill-data-110k")

- Просмотр данных: Использование

datasetОбъекты просматривают основную информацию и образцы набора данных.

print(dataset)

print(dataset['train'][0])

- Предварительная обработка данных: Предварительная обработка данных в соответствии с потребностями исследования, например, разбивка на слова и удаление дубликатов.

from transformers import BertTokenizer

tokenizer = BertTokenizer.from_pretrained('bert-base-chinese')

tokenized_data = dataset.map(lambda x: tokenizer(x['text'], padding='max_length', truncation=True))

- обучение модели: Обучение модели с использованием предварительно обработанных данных.

from transformers import BertForSequenceClassification, Trainer, TrainingArguments

model = BertForSequenceClassification.from_pretrained('bert-base-chinese')

training_args = TrainingArguments(output_dir='./results', num_train_epochs=3, per_device_train_batch_size=16)

trainer = Trainer(model=model, args=training_args, train_dataset=tokenized_data['train'])

trainer.train()

Основные функции Процедура работы

- Математическая обработка данных: Для математических данных добавьте подсказку "Пожалуйста, рассуждайте шаг за шагом и поместите окончательный ответ в \boxed {}".

def add_math_prompt(example):

example['text'] = "请一步步推理,并把最终答案放到 \\boxed {}。" + example['text']

return example

math_data = dataset.filter(lambda x: x['category'] == 'math').map(add_math_prompt)

- Логические рассуждения Обработка данных: Специальная обработка данных логических рассуждений для обеспечения логичности и последовательности данных.

def process_logic_data(example):

# 自定义逻辑处理代码

return example

logic_data = dataset.filter(lambda x: x['category'] == 'logic').map(process_logic_data)© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...