Момент Шиншиллы и момент o3: эволюция закона масштаба для больших языковых моделей

Быстрое прочтение статьи

В этой статье представлен всесторонний и глубокий взгляд на прошлое и настоящее закона масштабирования больших языковых моделей (LLM) и будущее направление исследований в области ИИ. Благодаря четкой логике и обилию примеров автор Камерон Р. Вулф ведет читателей от базовых концепций к передовым исследованиям, представляя широкую картину области ИИ. Ниже приводится резюме и комментарии к основному содержанию статьи и точкам зрения автора:

1. Возникновение и развитие закона масштаба: от ГПТ до Чинчиллы

- В начале статьи авторы утверждают, что закон масштаба является главной движущей силой разработки больших языковых моделей. Введя базовую концепцию закона мощности, авторы объясняют, как потери при тестировании большой языковой модели уменьшаются по мере увеличения параметров модели, размера набора данных и объема вычислений.

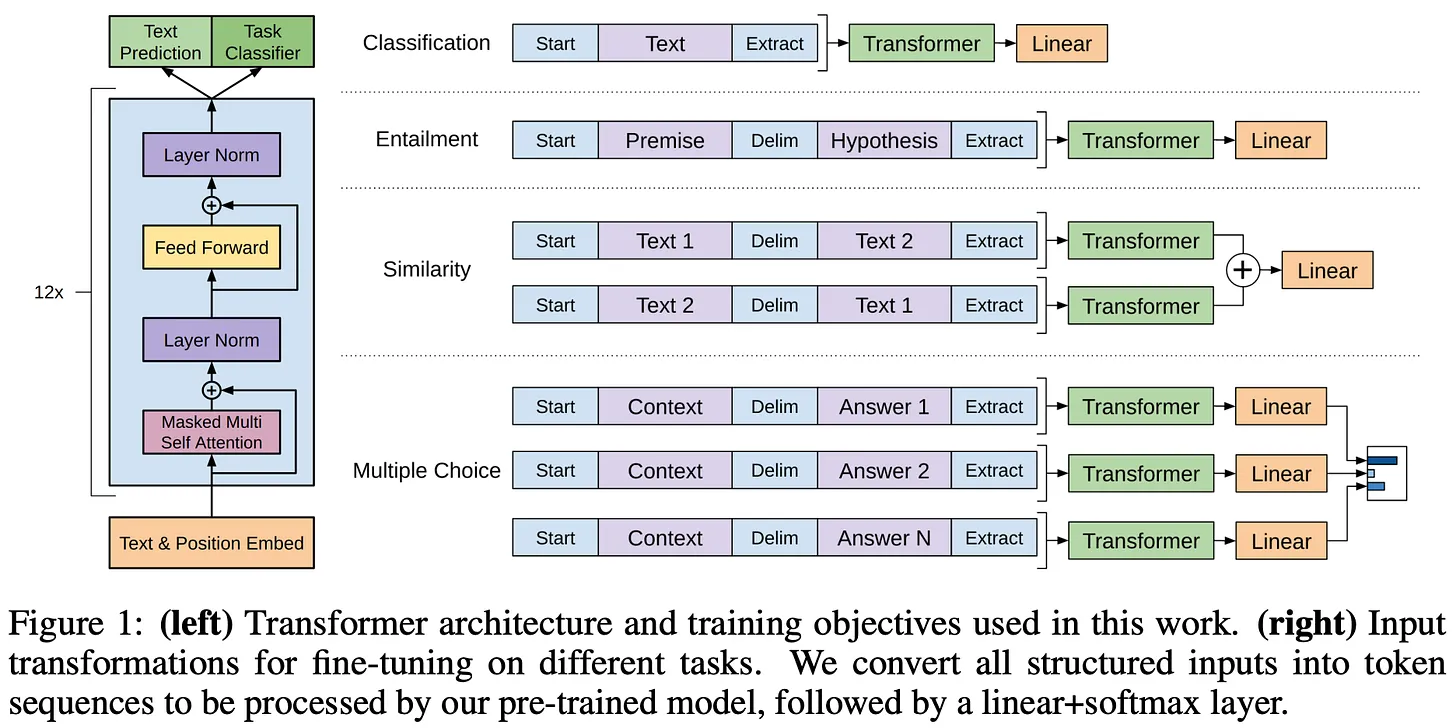

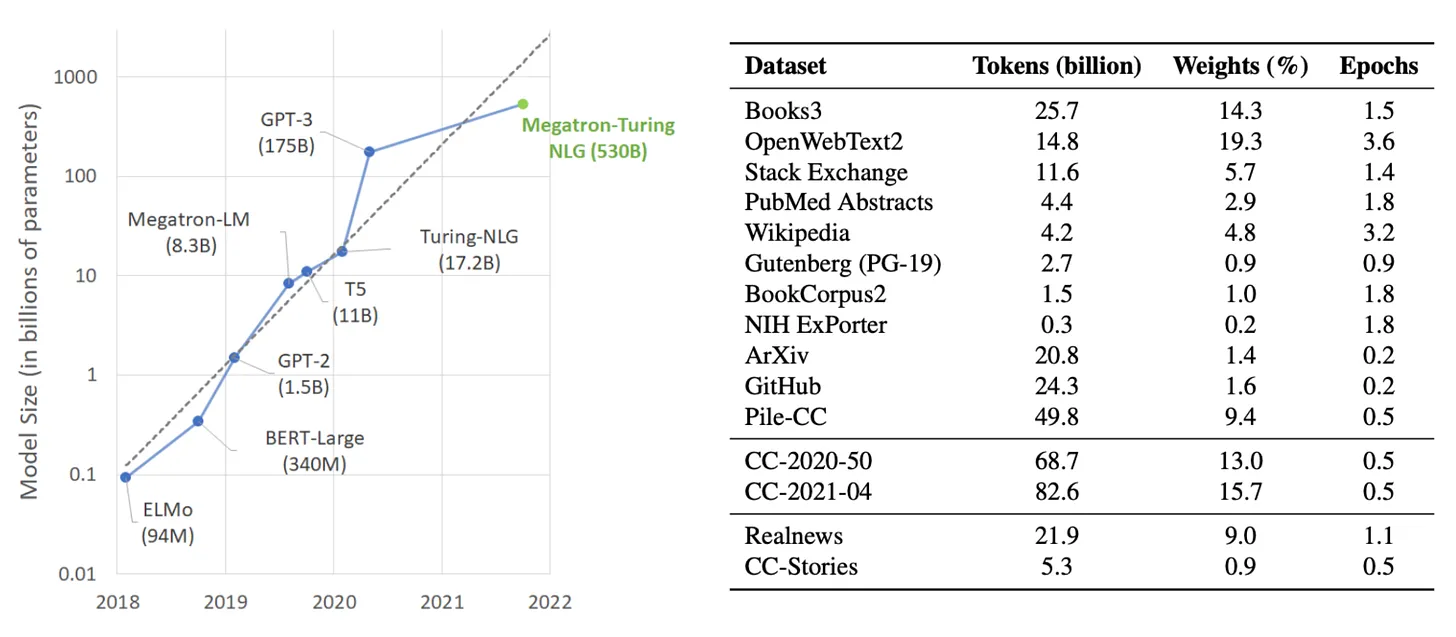

- Авторы рассматривают эволюцию семейства моделей GPT и наглядно демонстрируют применение законов масштаба на практике. Начиная с ранних GPT и GPT-2, эпохального GPT-3 и загадочного GPT-4, OpenAI всегда придерживался стратегии "делать чудеса из больших усилий" и постоянно обновлял верхний предел возможностей больших языковых моделей. В статье подробно описываются ключевые инновации, экспериментальные установки и производительность каждой модели, и отмечается, что появление GPT-3 знаменует собой переход от специализированной модели к базовой модели общего назначения большой языковой модели и открывает новую эру исследований ИИ.

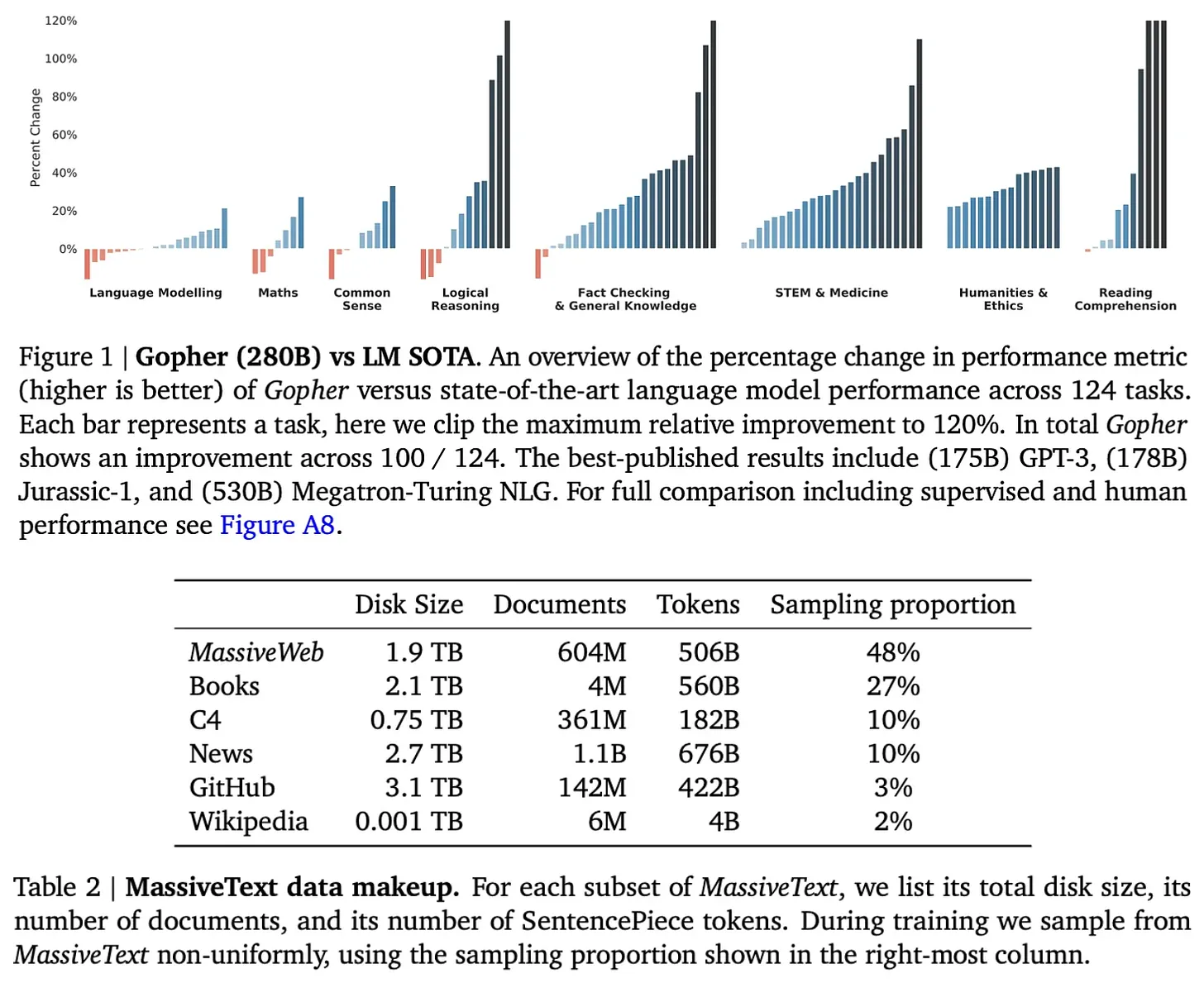

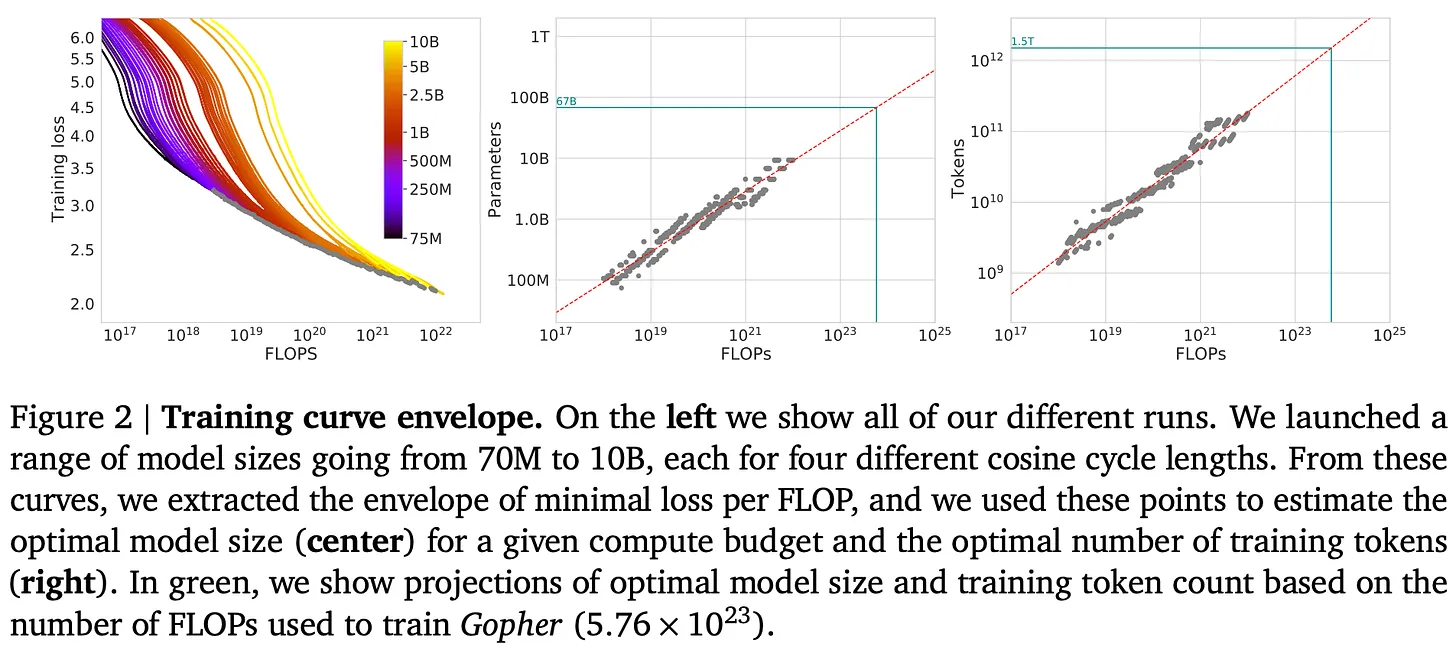

- Авторы не слепо отстаивают принцип "больше - значит лучше", а рационально анализируют закон "вычислительно оптимального" размера, предложенный моделью Чинчилла. Исследования DeepMind показали, что предыдущие модели, как правило, были "недообучены", то есть размер набора данных был слишком мал по сравнению с размером модели. Успех модели Чинчиллы продемонстрировал, что соответствующее увеличение размера набора данных может быть более эффективным, чем увеличение размера модели при том же вычислительном бюджете. Этот вывод оказал глубокое влияние на обучение последующих больших языковых моделей.

Комментарий: Авторы подробно рассказывают о законе масштаба, приводя как теоретические объяснения, так и подтверждающие примеры, чтобы даже неспециалисты могли понять его основные идеи. Рассматривая эволюцию серии моделей GPT, авторы связывают абстрактный закон масштаба с разработкой конкретных моделей, что повышает читабельность и убедительность статьи. Анализ модели Chinchilla демонстрирует дискурсивный дух автора, который не слепо отстаивает масштаб, а наводит читателей на размышления о том, как эффективнее использовать вычислительные ресурсы.

2. "Кончина" закона размера: вопросы и размышления

- Вторая часть статьи посвящена недавней постановке вопроса о законе масштаба в ИИ. Авторы приводят несколько сообщений в СМИ, которые говорят о том, что индустрия начинает задумываться о том, не достиг ли закон масштаба своего потолка, поскольку темпы совершенствования моделей замедляются. В то же время авторы ссылаются на инсайдеров отрасли, таких как Дарио Амодей и Сэм Альтман, которые утверждают обратное, говоря о том, что масштаб по-прежнему является важной движущей силой прогресса ИИ.

- Авторы отмечают, что "замедление" закона масштаба было в определенной степени ожидаемым. Закон масштаба сам по себе предсказывает, что с увеличением масштаба сложность повышения производительности растет экспоненциально. Кроме того, авторы подчеркивают важность определения понятия "производительность". Уменьшение потерь при тестировании не обязательно означает увеличение возможностей Большой языковой модели, а отраслевые ожидания от Большой языковой модели сильно различаются.

- "Узкие места в данных" - одна из проблем, на которой сосредоточены авторы. Модель Chinchilla и последующие исследования подчеркнули важность объема данных, но ограниченная доступность высококачественных данных в Интернете может стать узким местом для дальнейшего развития моделей больших языков.

Комментарий: Этот раздел демонстрирует критическое мышление автора и его глубокое понимание отрасли. Вместо того чтобы избегать споров, авторы объективно излагают мнения различных сторон и анализируют возможные причины "замедления масштаба" с технической точки зрения. Особое внимание автор уделяет "узким местам в данных", которые являются не только реальной проблемой для разработки больших языковых моделей, но и направлением для будущих исследований.

3. Будущее исследований в области ИИ: за пределами предварительного обучения

- В заключительной части статьи рассматриваются будущие направления исследований в области ИИ с акцентом на большие языковые модели системы/агенты и модели вывода.

- Авторы утверждают, что даже если рост размера предварительно обученных моделей станет узким местом, мы все равно сможем улучшить возможности ИИ, создавая сложные системы из больших языковых моделей. В статье описываются две основные стратегии декомпозиции и связывания задач, а в качестве примера разбиения сложных задач на подзадачи используются аннотации к книгам, с которыми отлично справляются большие языковые модели.

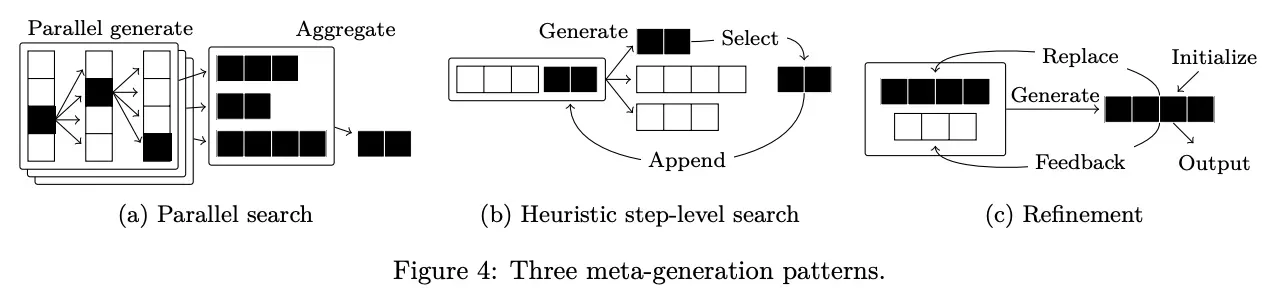

- Авторы также обсуждают перспективы применения Больших языковых моделей в разработке продуктов, отмечая, что создание действительно полезных продуктов на основе Больших языковых моделей - важное направление современных исследований в области ИИ. В частности, в статье освещается концепция агента, которая расширяет сценарии применения больших языковых моделей, предоставляя им возможность использовать инструменты. Однако авторы также указывают на проблемы надежности при создании сложных больших систем языкового моделирования и представляют направления исследований для повышения надежности системы за счет улучшения алгоритмов метагенерации.

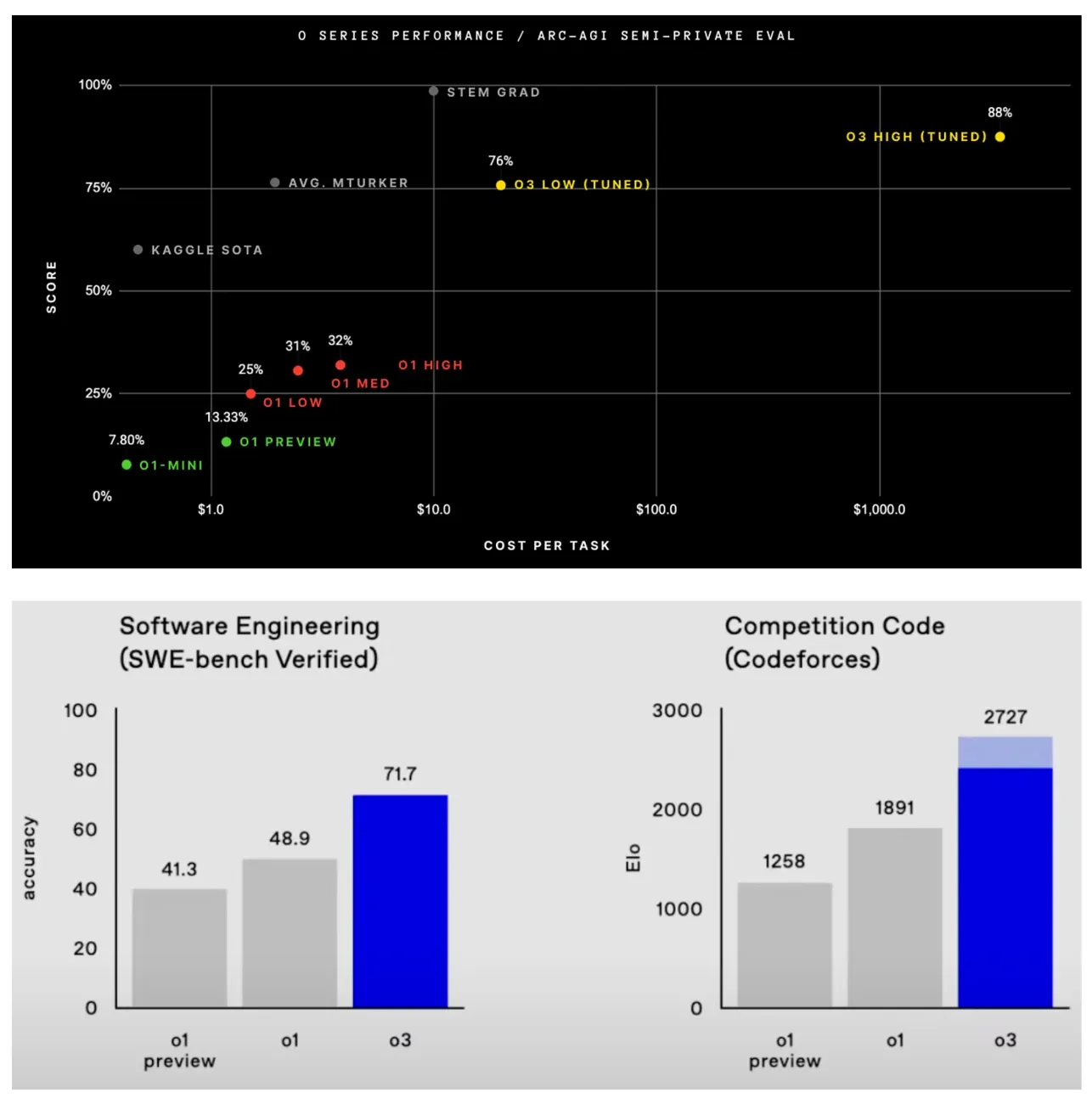

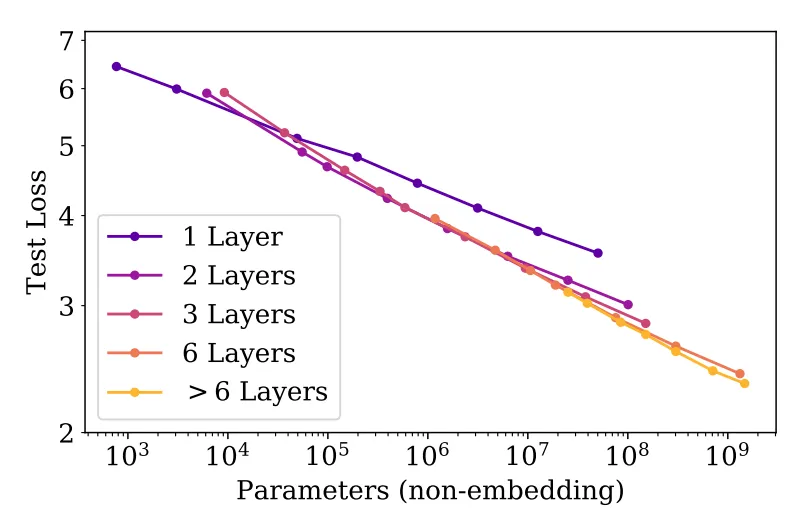

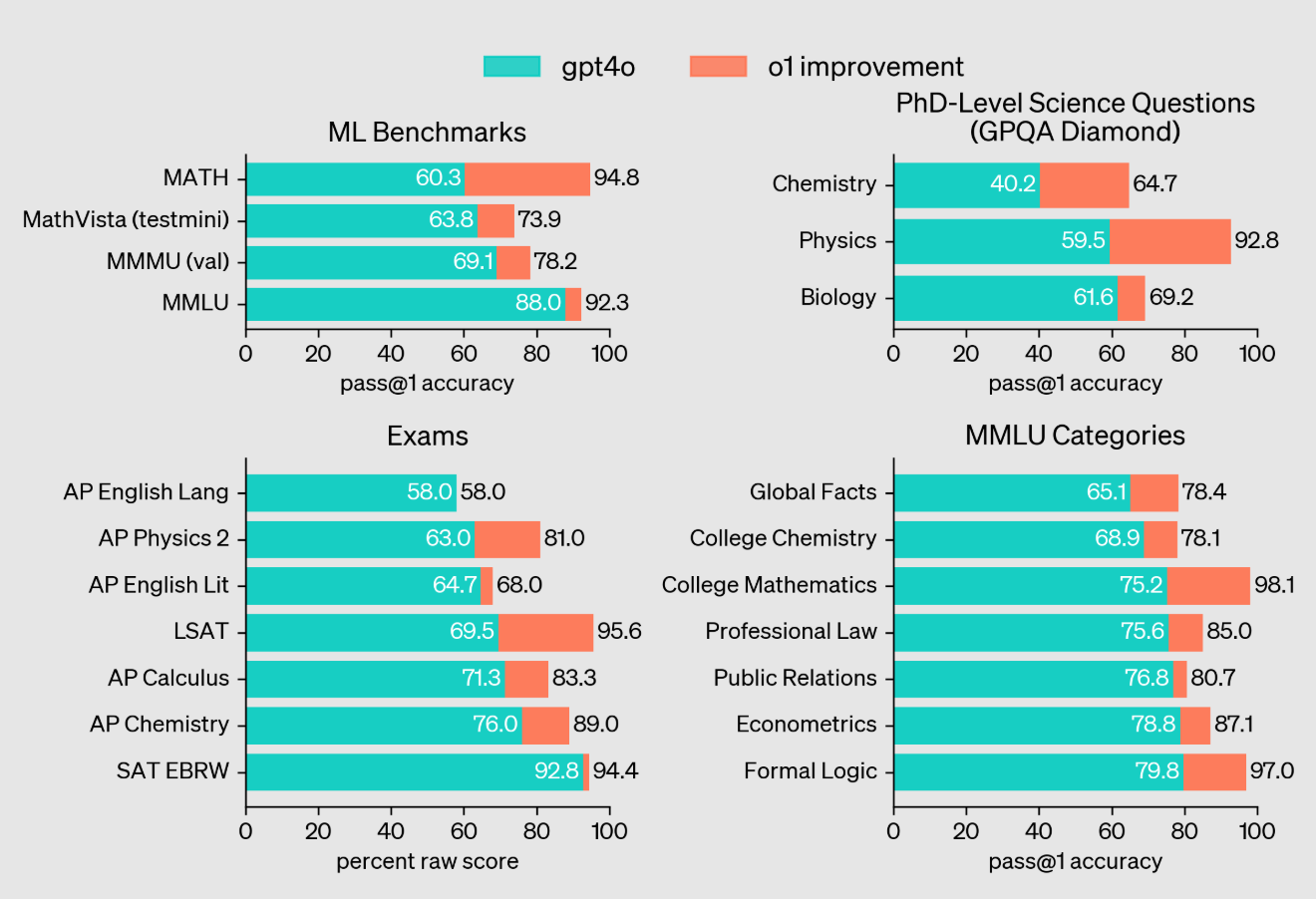

- Что касается моделей вывода, то авторы представляют модели OpenAI o1 и o3, которые показали впечатляющие результаты в сложных задачах вывода. Модель o3, в частности, превзошла человеческий уровень в нескольких сложных бенчмарках и даже превзошла предсказания Теренса Тао для некоторых задач. Авторы отмечают, что успех моделей o1 и o3 показывает, что помимо масштабирования предварительного обучения, вывод моделей может быть значительно улучшен путем увеличения вычислительных входов во время вывода, что является новой парадигмой масштабирования.

Комментарий: Этот раздел очень перспективен, а введение авторов в системы/агенты и модели вывода для моделирования большого языка открывает перед читателями новые горизонты. Акцент авторов на построении продуктов Большой языковой модели имеет большое практическое значение не только для академических исследований, но и для применения технологий ИИ на практике. Введение моделей o1 и o3 обнадеживает, поскольку они демонстрируют большой потенциал ИИ для решения сложных задач рассуждения и указывают новые направления для будущих исследований ИИ.

Подведите итоги и поразмышляйте:

Статья Кэмерона Р. Вулфа - превосходная работа, сочетающая в себе широту и глубину, не только дающая систематический обзор развития закона масштаба для больших языковых моделей, но и проницательный взгляд на будущее исследований в области ИИ. Точка зрения автора объективна и рациональна, он подтверждает важную роль закона масштаба, но при этом указывает на его ограничения и проблемы. Логика статьи ясна и хорошо аргументирована, так что даже читатели, не знакомые с областью ИИ, смогут извлечь из нее пользу.

Примечательные моменты:

- Подробное объяснение: Автор умеет объяснить сложные концепции простым и понятным языком, например, ввести законы мощности, законы масштаба и декомпозицию задач.

- Подкреплено богатыми примерами: В статье приводится большое количество моделей и экспериментальных результатов, таких как серия GPT, Chinchilla, Gopher, o1, o3 и т. д., чтобы сделать абстрактные теории осязаемыми и соотносимыми.

- Всесторонний обзор литературы: В статье приводится большое количество ссылок на классические работы и результаты последних исследований в области моделирования больших языков, что позволяет читателям получить ресурсы для углубленного изучения.

- Открытое мышление: Авторы не дают окончательного ответа на вопрос о будущем закона масштаба, а скорее наталкивают читателя на самостоятельные размышления, например "Что мы будем масштабировать дальше?". Этот вопрос вдохновит еще больше исследователей на изучение границ ИИ.

Эта статья заслуживает того, чтобы ее внимательно прочитали все, кто следит за развитием ИИ. Она не только подводит итог прошлому, но и проливает свет на будущее. Ценность статьи заключается не только в ее содержании, но и в ее духе, стимулирующем мышление и ведущем к инновациям. Я верю, что в будущих исследованиях ИИ мы увидим больше прорывов, подобных o3, а масштабные идеи продолжат стимулировать прогресс технологий ИИ в новых формах.

Название:Законы масштаба для больших языковых моделей: от GPT-3 до o3.

Оригинальный текст:https://cameronrwolfe.substack.com/p/llm-scaling-laws

Узнайте о современном состоянии масштабного моделирования языка и будущем исследований в области ИИ...

(Источники [1, 7, 10, 21])

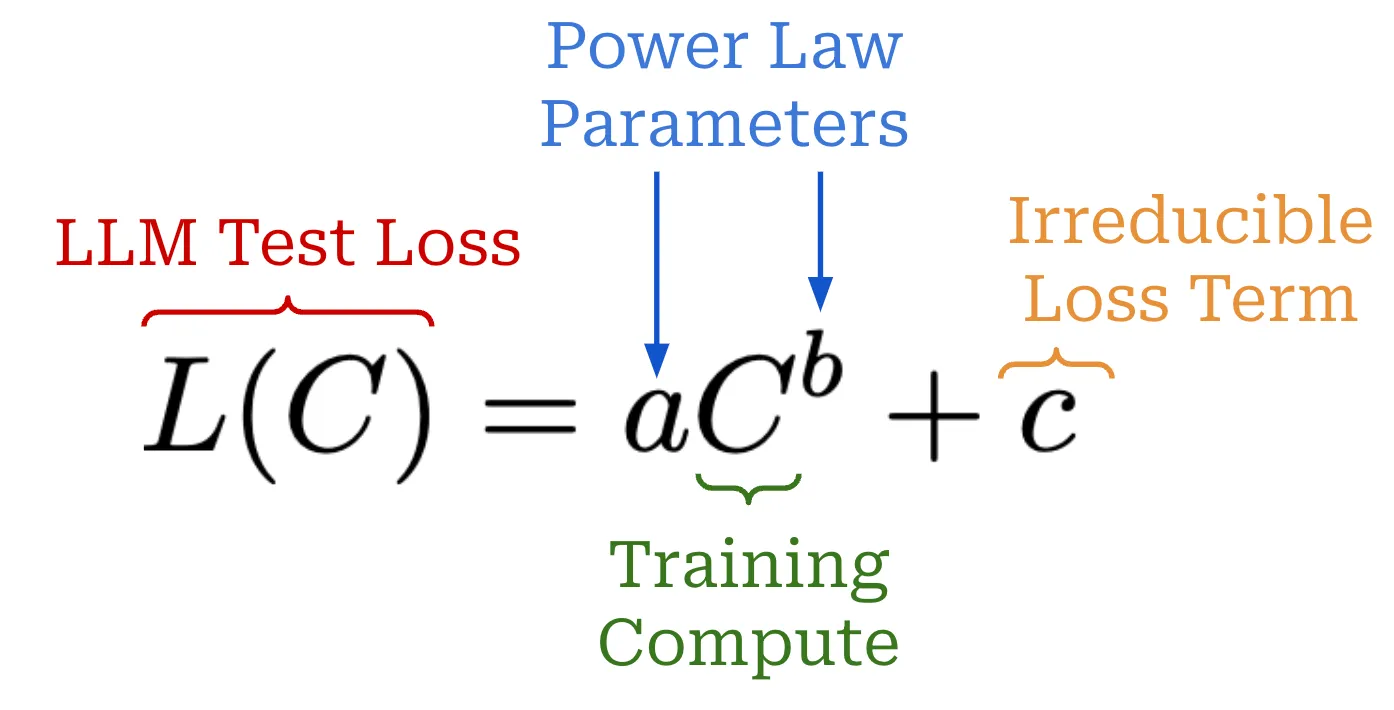

Самые последние достижения в области исследований искусственного интеллекта -В частности, Большая языковая модель (LLM)- Все зависит от масштаба. Если мы обучаем большие модели на большем количестве данных, мы получаем лучшие результаты. Эта взаимосвязь может быть более точно определена с помощью закона масштаба, который представляет собой уравнение, описывающее, как потери при тестировании большой языковой модели уменьшаются при увеличении некоторой значимой величины (например, объема обучающих вычислений). Закон масштаба помогает нам предсказать результаты более крупных и дорогостоящих тренировок, что дает нам необходимую уверенность для продолжения инвестиций в масштабирование.

"Если у вас есть большой набор данных и вы обучаете очень большую нейронную сеть, успех гарантирован!" - Илья Суцкевер

На протяжении многих лет закон масштаба был предсказуемой северной звездой для исследований в области ИИ. Фактически, успех ранних передовых лабораторий, таких как OpenAI, даже приписывали их приверженности закону масштаба. Однако недавно закон масштаба был поставлен под сомнение1 сообщениями о том, что ведущие исследовательские лаборатории работают над созданием следующего поколения лучших моделей больших языков. Эти заявления могут заставить нас отнестись к ним скептически:Возникнет ли узкое место при масштабировании? Если да, то есть ли другие пути решения?

В этом обзоре мы ответим на эти вопросы с самого начала, начиная с подробного объяснения Законов масштабирования модели Большого языка и сопутствующих исследований. Концепция закона масштаба проста, но в обществе существует множество заблуждений, связанных с масштабированием.Наука, лежащая в основе этого исследования, на самом деле очень специфичнаЗакон масштаба. Используя это детальное понимание масштабирования, мы обсудим последние тенденции в исследованиях в области моделирования большого языка, а также факторы, которые привели к "срыву" закона масштаба. Наконец, мы используем эту информацию, чтобы составить более четкое представление о будущем исследований в области ИИ, сосредоточившись на нескольких ключевых идеях.Включая шкалу--Эти идеи могут и дальше двигать прогресс.

Основные концепции масштабирования для больших языковых моделей

Чтобы понять, как масштабируются большие языковые модели, нам сначала нужно составить общее представление о законах масштабирования. Мы построим это понимание с нуля, начав с концепции законов мощности. Затем мы изучим, как законы мощности применялись при исследовании больших языковых моделей, чтобы вывести законы масштабирования, которые мы используем сегодня.

Что такое закон мощности?

Законы мощности - это фундаментальная концепция масштабирования больших языковых моделей. Вкратце, закон мощности просто описывает связь между двумя величинами. В случае большой языковой модели первая величина - это тестовые потери большой языковой модели.или другие соответствующие показатели производительности (например, точность выполнения задания [7])- Другое дело, что мы пытаемся масштабировать определенные параметры, например количество параметров модели. Например, при исследовании свойств масштабирования большой языковой модели мы можем увидеть следующее утверждение.

"При наличии достаточного количества обучающих данных масштаб потерь при проверке должен быть приближенно гладкой функцией силового закона от размера модели". - Источник [4]

Такое утверждение говорит нам о том, что существует измеримая связь между тестовыми потерями модели и общим количеством параметров модели. Изменение одной из этих величин приведет к инвариантному изменению относительного масштаба другой. Другими словами, из этой зависимости мы знаем, что увеличение общего числа параметров модели - этоПри соблюдении других условий (например, наличии достаточного количества обучающих данных)-приведет к снижению потерь при тестировании на предсказуемую величину.

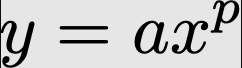

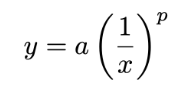

Формула закона мощности. Основной закон мощности выражается следующим уравнением.

Здесь изучаются две величины x ответить пением yно (не) a ответить пением p это константа, которая описывает связь между этими величинами. Если мы построим график этой функции по закону мощности2 , то получим рисунок ниже. Мы приводим графики в нормальной и логарифмической шкале, поскольку в большинстве работ, посвященных изучению масштабирования больших языковых моделей, используется логарифмическая шкала.

График фундаментального степенного закона между x и y

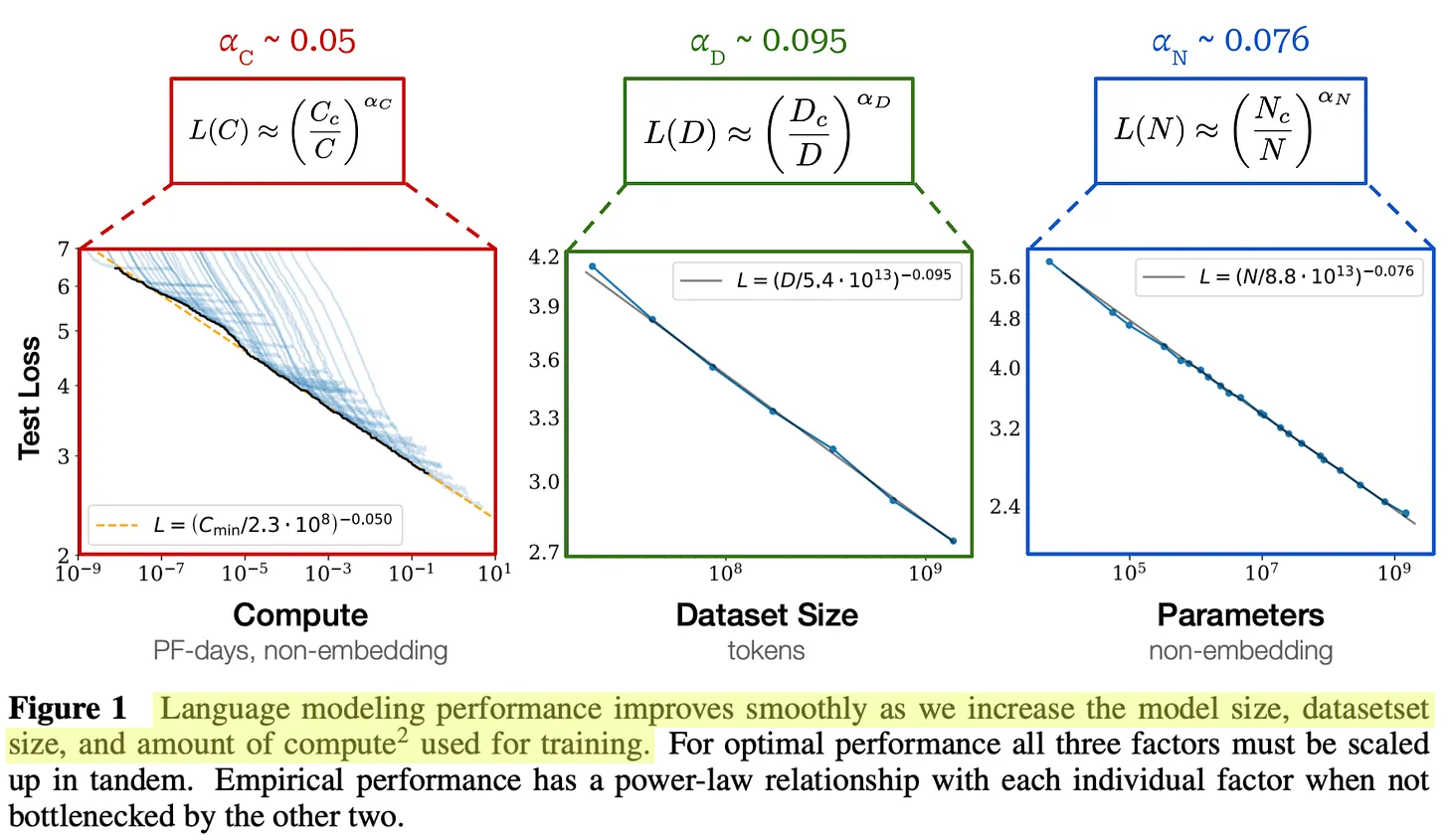

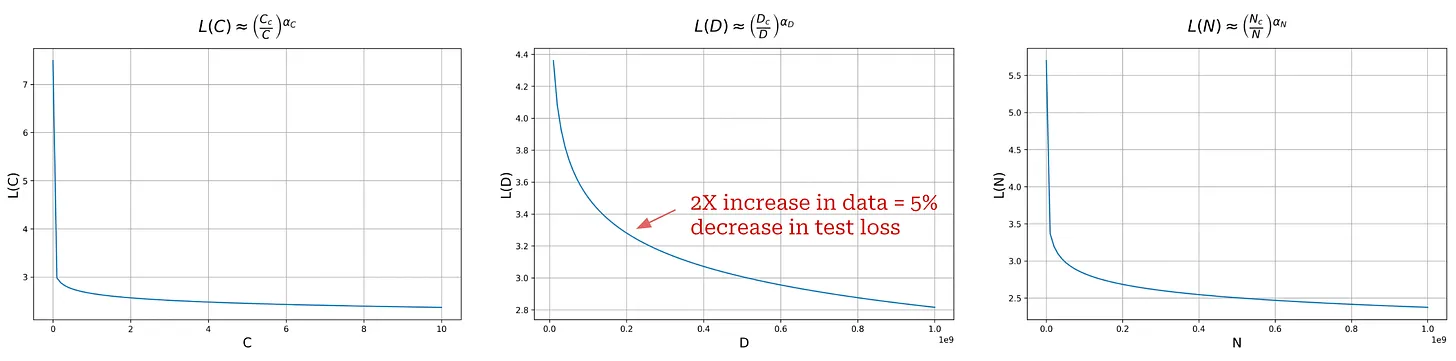

Однако диаграммы, предоставляемые для масштабирования Большой языковой модели, не похожи на диаграммы, показанные выше.Обычно они перевернуты.Смотрите пример ниже.

(Источник [1])

Уравнение для обратного степенного закона почти такое же, как и уравнение для стандартного степенного закона, но нас интересует p Используйте отрицательные экспоненты. Если сделать экспоненту степенного закона отрицательной, то график перевернется с ног на голову; см. пример ниже.

График обратного степенного закона между x и y

При построении графика в логарифмическом масштабе этот обратный закон мощности дает линейную зависимость, которая характеризует законы размера большинства больших языковых моделей. Почти в каждой работе, о которой пойдет речь в этом обзоре, будут построены такие графики, чтобы исследовать, как масштабирование различных факторов (например, размера, вычислений, данных и т. д.) влияет на производительность большой языковой модели. Теперь давайте рассмотрим законы мощности на примере одной из первых работ, посвященных их изучению в контексте масштабирования больших языковых моделей [1].

Масштабные законы для нейролингвистического моделирования [1]

На заре языкового моделирования мы не понимали, как масштаб влияет на производительность. Моделирование языка было многообещающей областью исследований, но текущее поколение моделей того времени (например, оригинальный GPT) имело ограниченную мощность. Мы еще не открыли для себя возможности более крупных моделей, и путь к созданию лучших языковых моделей был неясен.Имеет ли значение форма модели (т. е. количество слоев и размер)? Помогает ли увеличение размера модели улучшить ее работу? Сколько данных необходимо для обучения этих больших моделей?

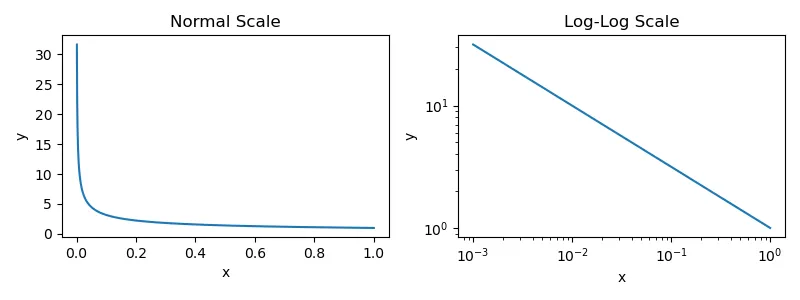

"По мере увеличения размера модели, объема набора данных и количества вычислений, используемых для обучения, потери растут по степенному закону, причем некоторые из этих тенденций охватывают более семи порядков величины". - Источник [1]

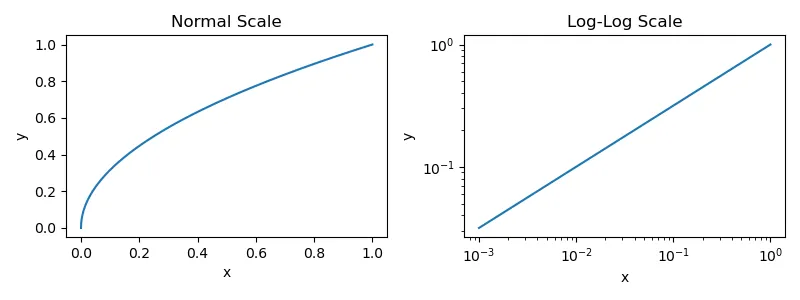

В работе [1] авторы поставили перед собой цель проанализировать несколько факторов, по...Примеры включают размер модели, форму модели, размер набора данных, вычисления для обучения и размер партии.- на производительность модели, чтобы ответить на эти вопросы. Из этого анализа мы узнали, что производительность большой языковой модели плавно улучшается по мере увеличения количества

- Количество параметров модели.

- Размер набора данных.

- Объем вычислений, используемых для обучения.

Более конкретно.Когда производительность не зависит от двух других факторов, между каждым из них и потерями при тестировании большой языковой модели наблюдается зависимость по закону мощности.

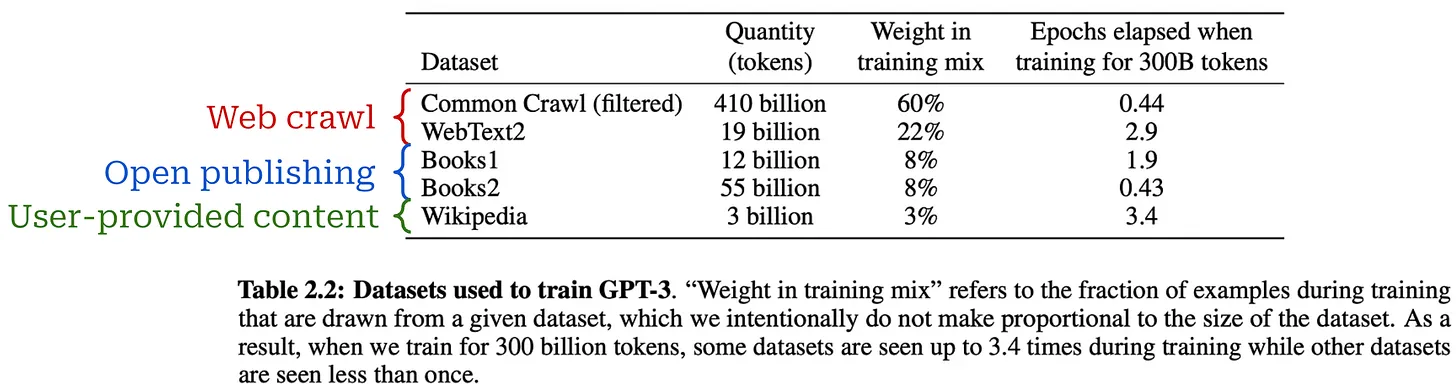

Экспериментальная установка.Для подгонки силовых законов авторы предварительно обучили большие языковые модели на подмножестве корпуса WebText2 с размером до 1,5 млрд параметров и содержанием от 22 до 23 млрд лексем. Все модели использовали 1024 Токен с фиксированной длиной контекста и стандартными потерями на предсказание следующего токена (кросс-энтропия) для обучения. Те же потери измеряются на зарезервированном тестовом наборе и используются в качестве основной метрики эффективности.Это значение соответствует стандартным настройкам предварительного обучения для большинства больших языковых моделей..

(Источник [1])

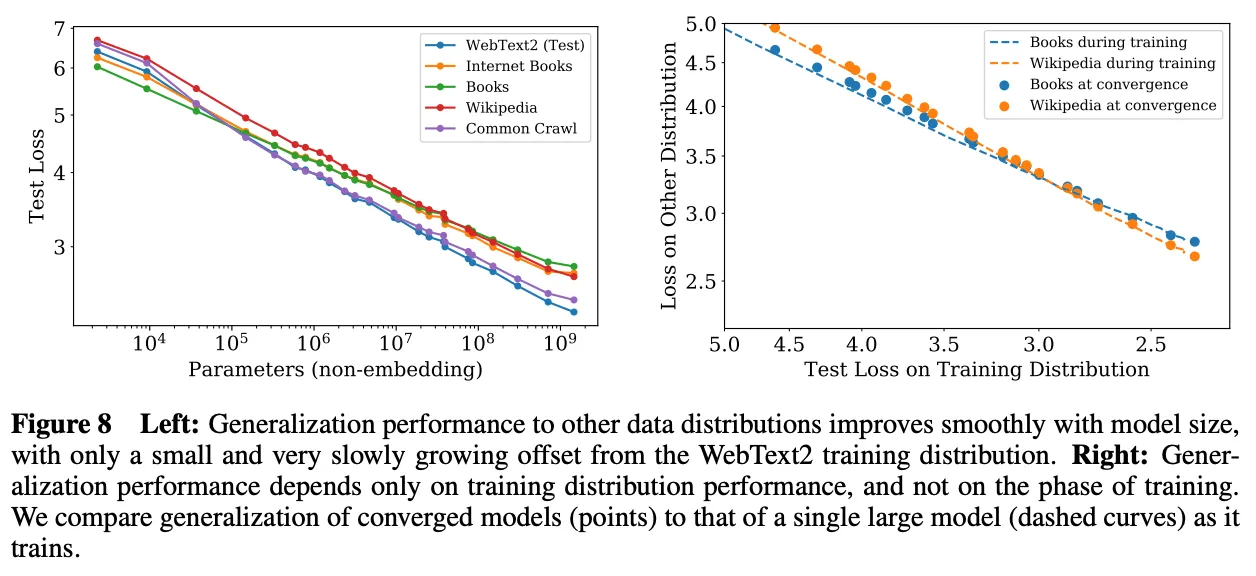

Модели больших языков Законы силы масштаба.Производительность большой языковой модели, обученной в [1] -С точки зрения потерь при тестировании WebText2- доказали, что они постоянно улучшаются с увеличением количества параметров, данных и вычислений3 . Эти тенденции охватывают восемь порядков величины в вычислениях, шесть порядков величины в размере модели и два порядка величины в размере набора данных. Точные зависимости закона мощности и уравнения, подгоняемые под каждую зависимость, представлены на рисунке выше. Каждое из этих уравнений очень похоже на уравнения обратного степенного закона, с которыми мы уже сталкивались. Однако мы установили a = 1 и добавьте внутри скобок дополнительную константу умножения, равную 4.

(Источник [1])

Эти законы мощности действуют только в том случае, если обучение не осложнено другими факторами. Таким образом, все три компонента -Размер модели, данные и расчеты-Для достижения оптимальной производительности все они должны быть расширены одновременно. Если мы будем расширять любой из этих компонентов по отдельности, мы достигнем точки убывающей отдачи.

О чем говорит закон мощности?Хотя графики закона мощности, приведенные в [1], выглядят многообещающе, следует отметить, что эти графики построены с использованием логарифмической шкалы. Если мы построим обычные графики (т. е. без логарифмической шкалы), то получим следующий рисунок, на котором видно, что форма закона мощности напоминает экспоненциальный спад.

Графики закона мощности без логарифмической шкалы

Учитывая, что в Интернете много говорят о масштабировании и AGI, такой вывод кажется контринтуитивным. Во многих случаях нам внушают, что качество больших языковых моделей растет экспоненциально с логарифмическим ростом вычислений, но это не так. На самом делеУлучшение качества больших языковых моделей становится все более сложным по мере увеличения масштаба.

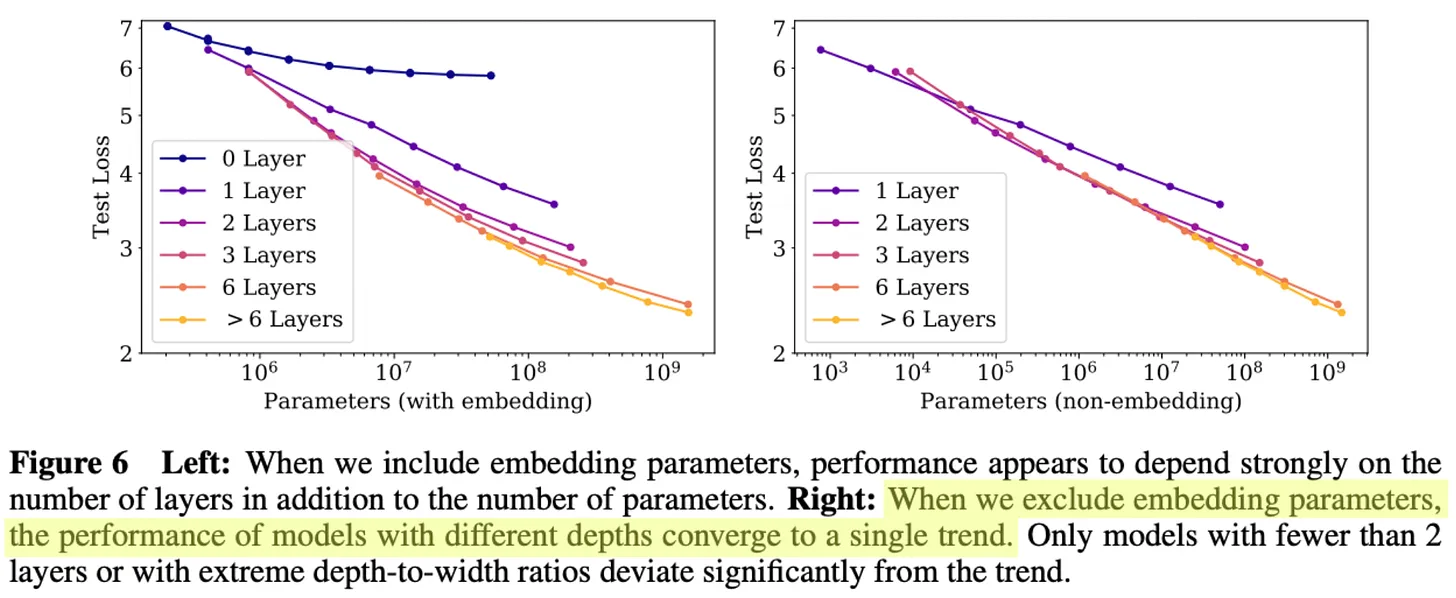

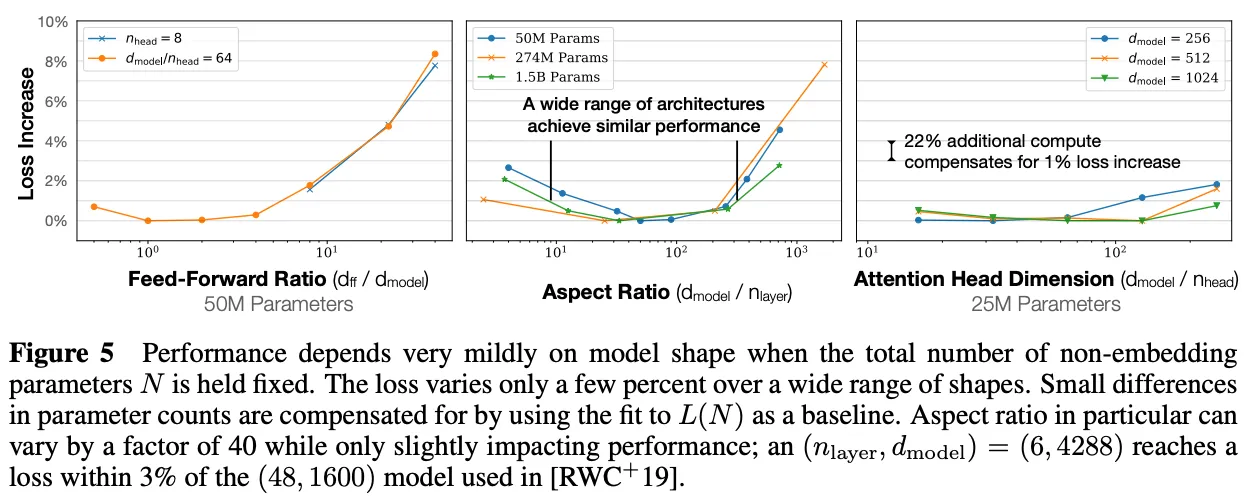

(Источник [1])

Другие полезные находки.В дополнение к закону мощности, наблюдаемому в [1], мы убедились, что другие рассматриваемые факторы, такие как форма модели или архитектурные настройки, оказывают незначительное влияние на производительность модели; см. выше. Безусловно, масштаб является самым большим фактором, способствующим созданию лучших моделей для больших языков.Увеличение количества данных, вычислений и параметров модели приводит к плавному росту производительности большой языковой модели.

"Большие модели имеют значительно более высокую эффективность выборки, поэтому оптимальное с точки зрения вычислительной эффективности обучение предполагает обучение очень больших моделей на относительно скромных объемах данных и остановку значительно раньше сходимости". - Источник [1]

Интересно, что эмпирический анализ, проведенный в [1], показывает, что большие языковые модели имеют более высокую эффективность выборки, то есть они используют меньше данных для достижения того же уровня потерь при тестировании по сравнению с моделями меньшего размера. По этой причинеПредварительное обучение большой языковой модели до сходимости является (возможно) неоптимальным.. Вместо этого мы можем обучать большие модели на меньшем количестве данных и останавливать процесс обучения до сходимости. Этот подход оптимален с точки зрения количества используемых вычислений при обучении, но он не учитывает затраты на вывод. На самом деле, мы обычно обучаем меньшие модели на большем количестве данных, потому что меньшие модели менее затратны для размещения.

Авторы также подробно проанализировали связь между размером модели и объемом данных, используемых для предварительного обучения, и обнаружили, что размер набора данных не должен увеличиваться так же быстро, как размер модели.Увеличение размера модели примерно в 8 раз требует увеличения объема обучающих данных примерно в 5 раз, чтобы избежать перебора.

(Источник [1])

"Эти результаты показывают, что производительность языкового моделирования плавно и предсказуемо улучшается, когда мы соответствующим образом масштабируем размер модели, данные и вычисления. Мы ожидаем, что более крупные языковые модели будут работать лучше, чем текущие модели, и иметь более высокую эффективность выборки". - Источник [1]

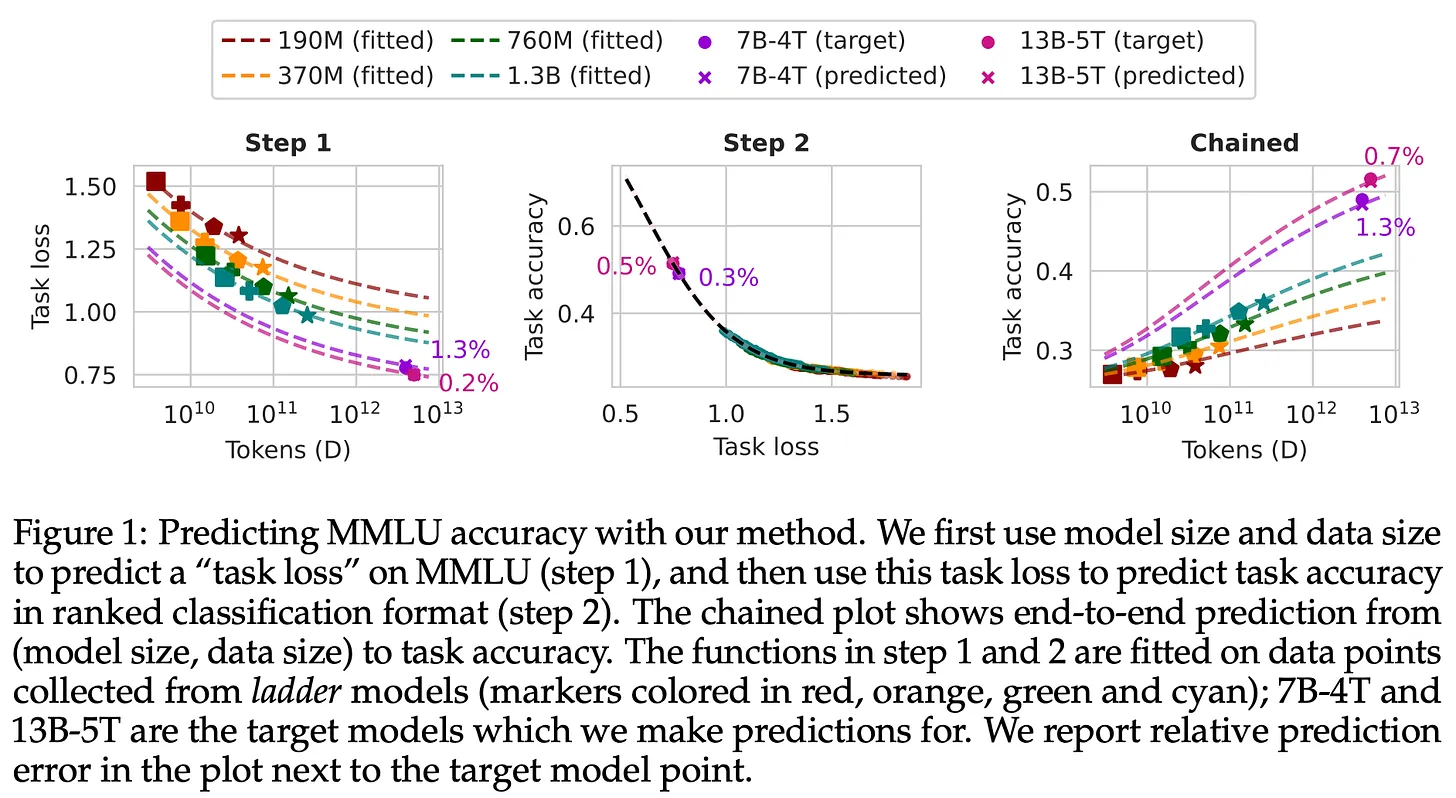

Практическое применение закона размера

Тот факт, что крупномасштабное предварительное обучение так полезно, ставит нас перед небольшой дилеммой. Наилучшие результаты можно получить, обучая большие модели на больших объемах данных. Однако такое обучение очень дорого иЭто означает, что они также берут на себя большой риск.Что, если мы потратим 10 миллионов долларов на обучение модели, которая не оправдает наших ожиданий? Что, если мы потратим 10 миллионов долларов на обучение модели, которая не оправдает наших ожиданий? Учитывая стоимость предварительного обучения, мы не можем выполнить какую-либо настройку для конкретной модели, и мы должны быть уверены, что модели, которые мы обучаем, работают хорошо. Нам нужно разработать стратегию настройки этих моделей и прогнозирования их эффективности, не тратя при этом слишком много денег.

(Источник [11])

- Обучите несколько небольших моделей, используя различные настройки обучения.

- Подгоните закон масштаба под производительность небольших моделей.

- Вывод о производительности больших моделей с помощью закона размера.

Конечно, у этого подхода есть свои ограничения. Предсказать производительность больших моделей на основе маленьких сложно и может быть неточным. Модели могут вести себя по-разному в зависимости от размера. Однако были предложены различные методы, позволяющие сделать это более осуществимым, и в настоящее время для этой цели широко используются законы масштаба. Возможность использовать законы масштаба для прогнозирования работы более крупных моделей дает нам больше уверенности (и спокойствия) как исследователям. Кроме того, закон масштаба дает простой способ обосновать инвестиции в исследования ИИ.

Расширение масштаба и эпоха предварительной подготовки

"Именно это является движущей силой всех тех достижений, которые мы наблюдаем сегодня, - мега-нейронные сети, обученные на огромных массивах данных". - Илья Суцкевер

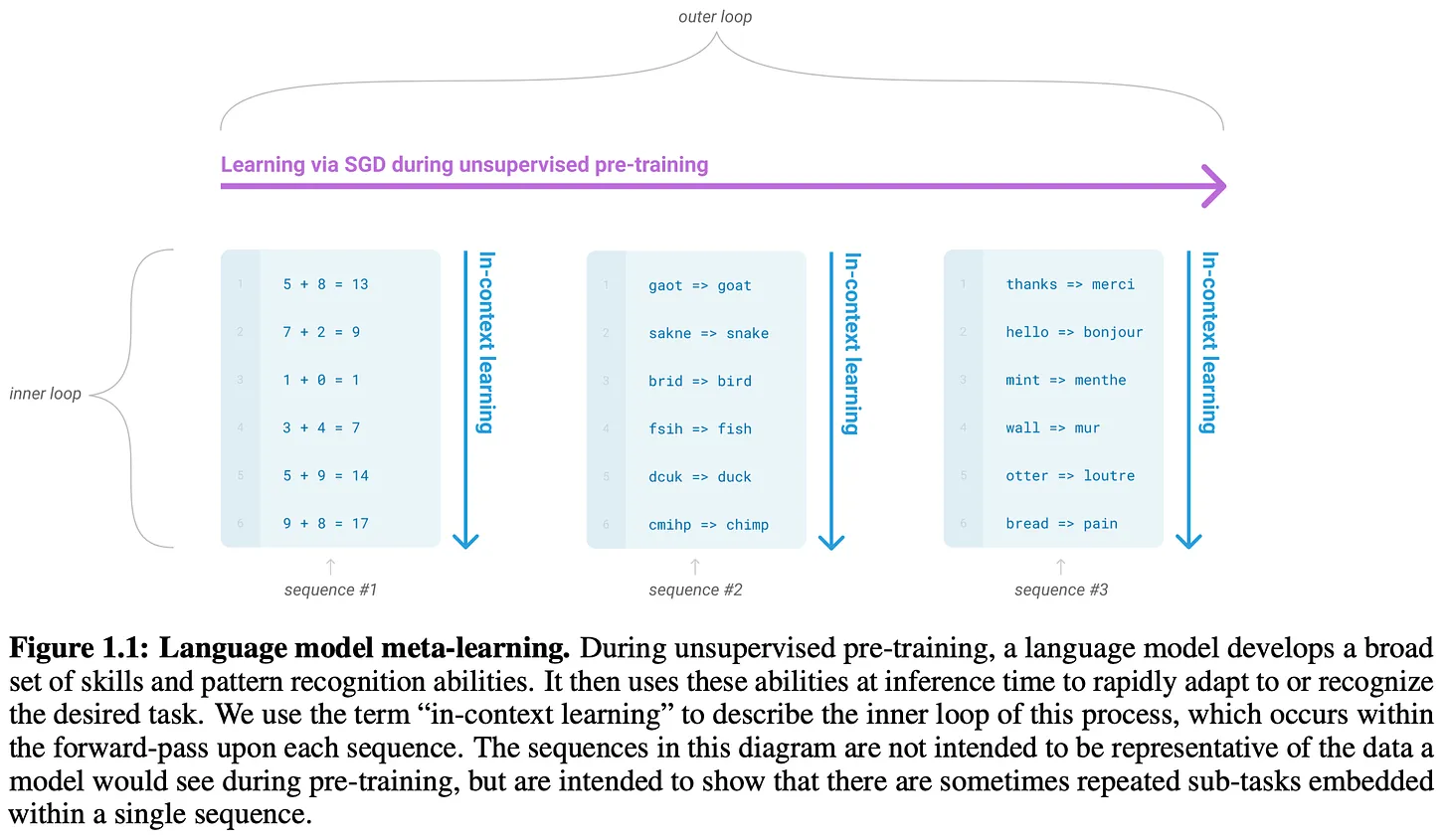

Открытие закона масштаба послужило катализатором многих последних достижений в изучении больших языковых моделей. Чтобы получить лучшие результаты, нам просто необходимо обучать модели на больших (и лучших!) наборах данных для обучения все более крупных моделей. Эта стратегия была использована для создания нескольких моделей семейства GPT, а также большинства известных моделей, созданных командами за пределами OpenAI. Здесь мы более подробно рассмотрим прогресс в исследовании масштабирования - вИлья Суцкевер недавно назвал его "эпохой предтренинга". 5.

Серия GPT: GPT [2], GPT-2 [3], GPT-3 [4] и GPT-4 [5].

Большие языковые модели Наиболее известным и заметным применением законов масштаба является создание семейства моделей GPT от OpenAI. Мы сосредоточимся в первую очередь на ранних открытых моделях этой серии -До GPT-3-Потому что:

- Детали этих моделей распространяются более открыто.

- Более поздние модели использовали достижения в исследованиях после обучения, а также расширили процесс предварительного обучения.

Мы также представим некоторые известные результаты масштабирования, например, модели из GPT-4.

(Источник [2])

- Самостоятельное предварительное обучение на плоском тексте очень эффективно.

- Для предварительного обучения важно использовать длинные, непрерывные отрезки текста.

- Предварительно обученные таким образом, отдельные модели могут быть точно настроены для решения множества различных задач с самой высокой точностью6 .

В целом, GPT не является особенно примечательной моделью, но она заложила важную основу для последующих работ (например, Transformer, работающий только с декодером, и предварительное обучение с самоконтролем), которые исследовали подобные модели в более широком масштабе.

(Источник [3])

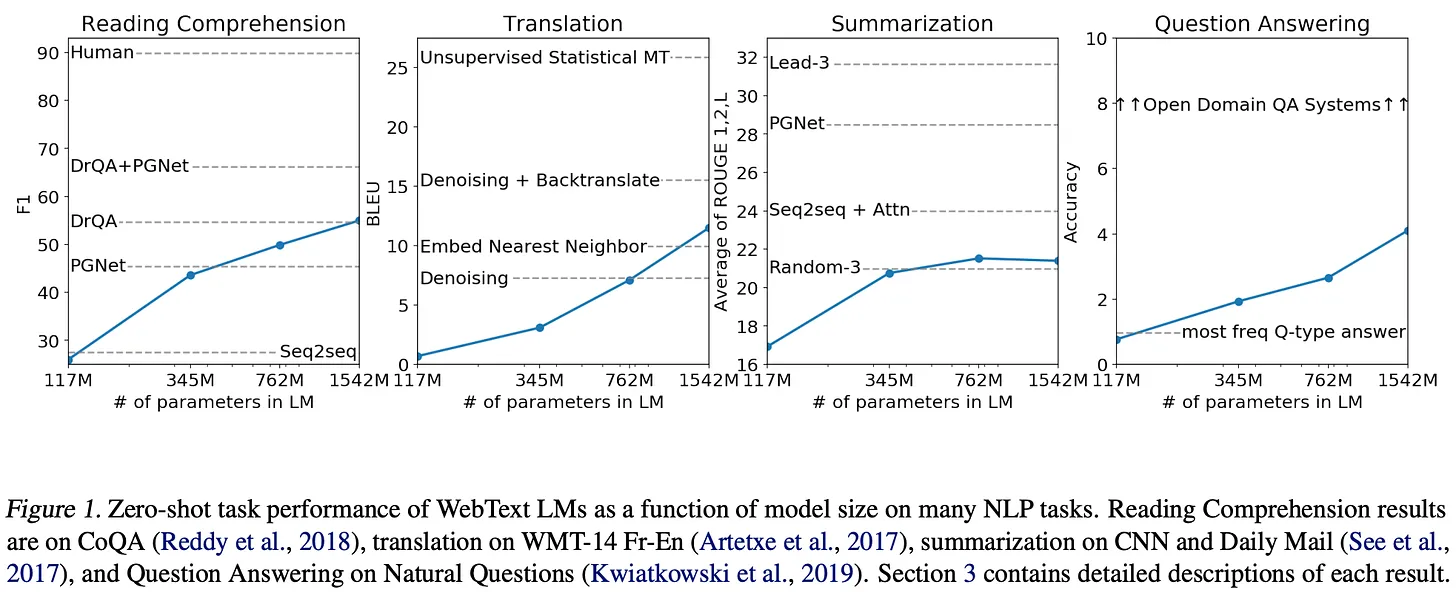

- Эти модели были предварительно обучены на WebText, который i) гораздо больше, чем BooksCorpus, и ii) Создается путем захвата данных из Интернета.

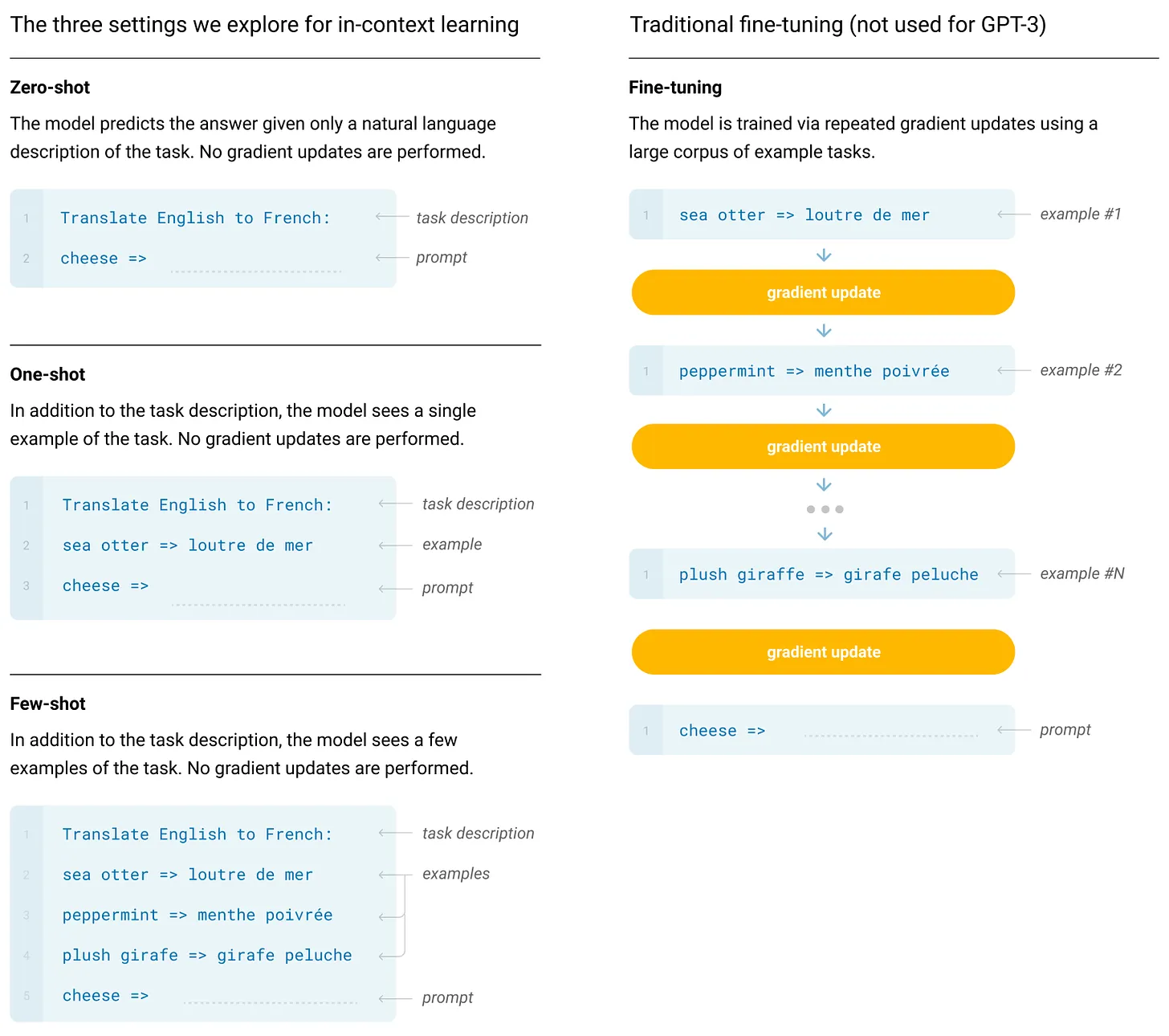

- Эти модели не настраиваются для решения последующих задач. Вместо этого мы решаем задачу, выполняя вывод с нулевой выборкой7 с помощью предварительно обученных моделей.

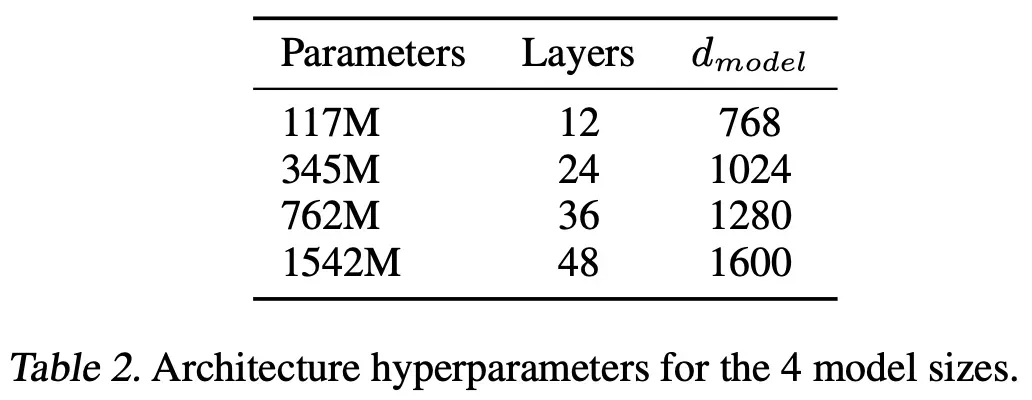

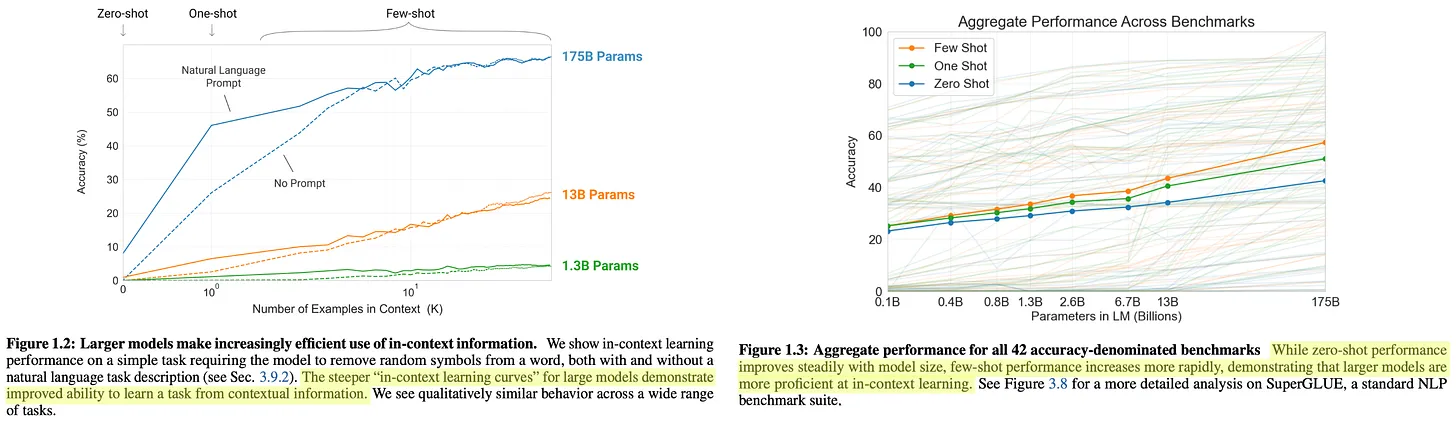

Модели GPT-2 не достигают современной производительности в большинстве бенчмарков8 , но их производительность последовательно улучшается с увеличением размера модели.Расширение числа параметров модели дает очевидные преимуществаСмотрите ниже.

(Источник [3])

"Языковые модели с достаточным потенциалом начнут учиться делать выводы и выполнять задачи, продемонстрированные в последовательностях естественного языка, чтобы лучше предсказывать их, независимо от способа их получения". - Источник [3]

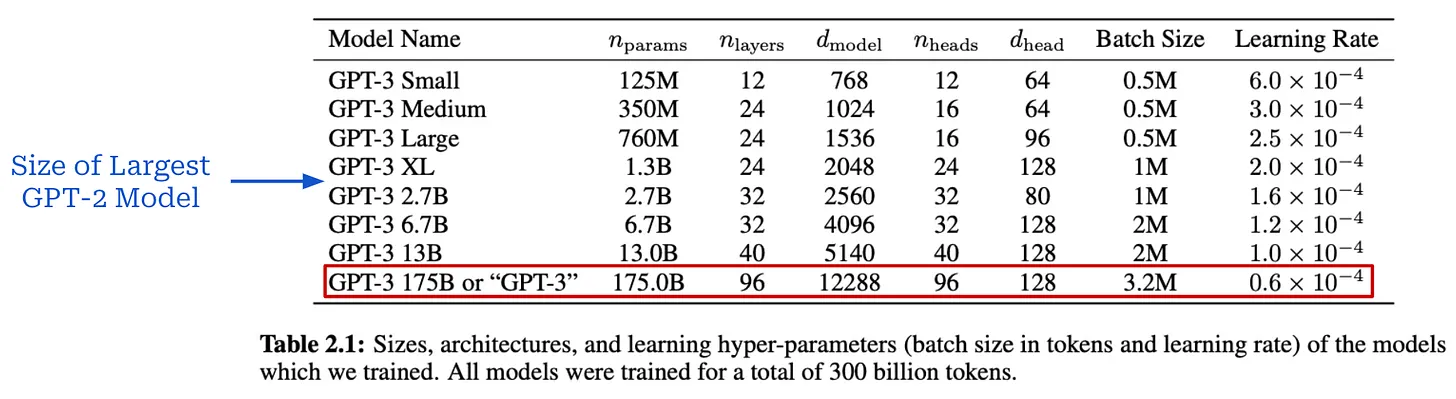

ГПТ-3 [4] стал переломным моментом в исследованиях ИИ, наглядно продемонстрировавшим преимущества крупномасштабного предварительного обучения большой языковой модели. Имея более 175 миллиардов параметров, эта модель более чем в 100 раз превосходит самую большую модель GPT-2; см. ниже.

(Источник [4])

(Источник [4])

(Источник [4])

(Источник [4])

(Источник [4])

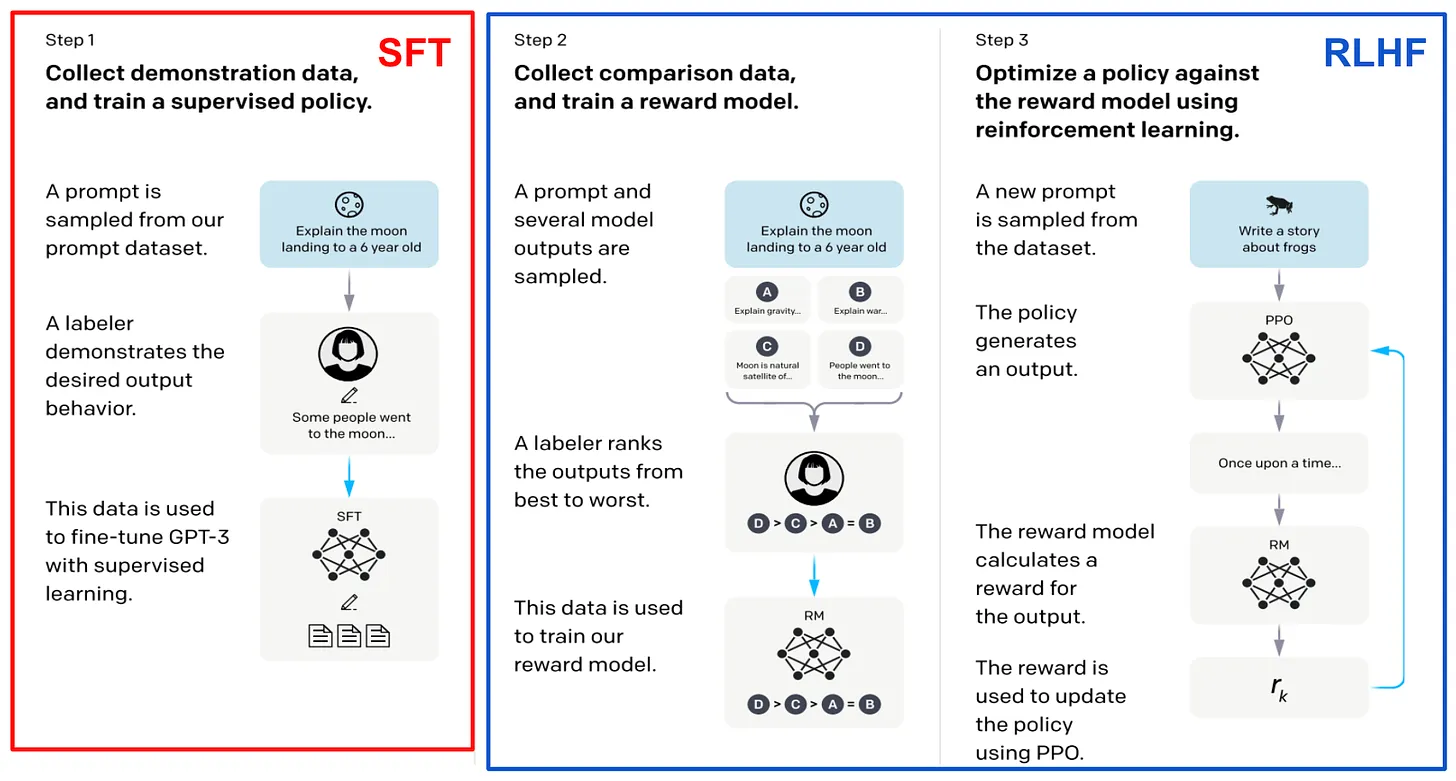

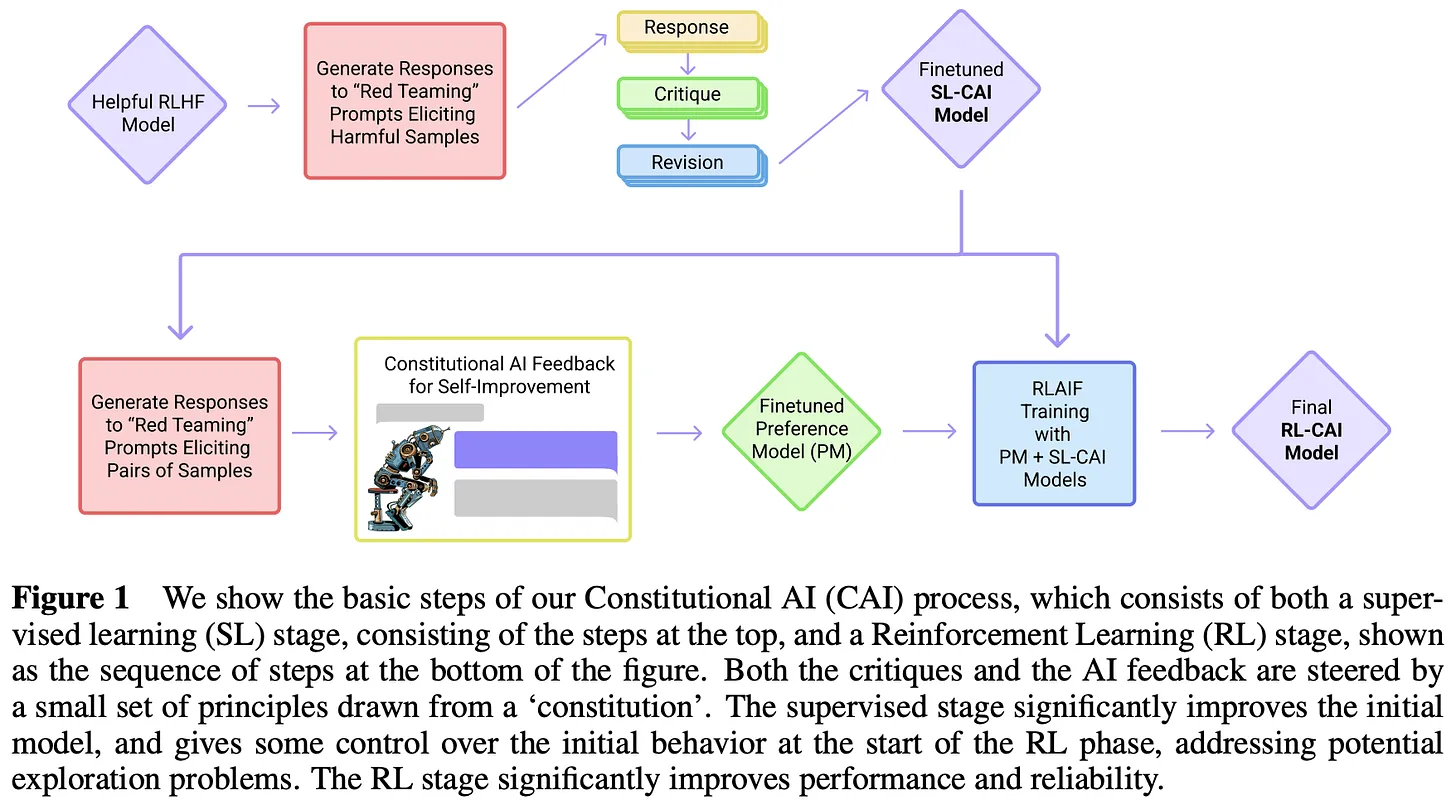

После GPT-3. Впечатляющая производительность GPT-3 вызвала большой интерес к изучению больших языковых моделей, сфокусированный в основном на крупномасштабном предварительном обучении. Следующие несколько моделей, выпущенных OpenAI, - этоInstructGPT [8], ChatGPT и GPT-4 [5]-Использование комбинации крупномасштабного предварительного обучения и новых методов пост-обучения (т.е. контролируемой тонкой настройки и обучения с подкреплением на основе человеческой обратной связи) позволило значительно повысить качество больших языковых моделей. Эти модели настолько впечатляют, что даже вызвали всплеск общественного интереса к исследованиям в области ИИ.

"GPT-4 - это модель на основе трансформатора, предварительно обученная предсказывать следующий токен в документе. Процесс выравнивания после обучения улучшает метрику факториальности и соответствие желаемому поведению". - Источник [5]

В этот момент OpenAI стала раскрывать меньше подробностей о своих исследованиях. Вместо этого новые модели стали появляться только через их API, что не позволило общественности понять, как эти модели создавались. К счастью, некоторые полезные сведения можно почерпнуть из материалов, которые OpenAI все же публикует. Например, InstructGPT [8]-.ChatGPT предшественники-- В сопутствующей статье подробно описана стратегия посттренировочного обучения модели; см. ниже. Учитывая, что в этом документе также говорится, что GPT-3 является базовой моделью для InstructGPT, можно сделать вывод, что улучшение производительности модели в значительной степени не зависит от расширенного процесса предварительного обучения.

(Источник [8])

- GPT-4 создан на основе трансформера.

- Модель предварительно обучена на основе предсказания следующего токена.

- Использование открытых и лицензированных данных третьих сторон.

- Модель настраивается с помощью обучения с усилением на основе отзывов людей.

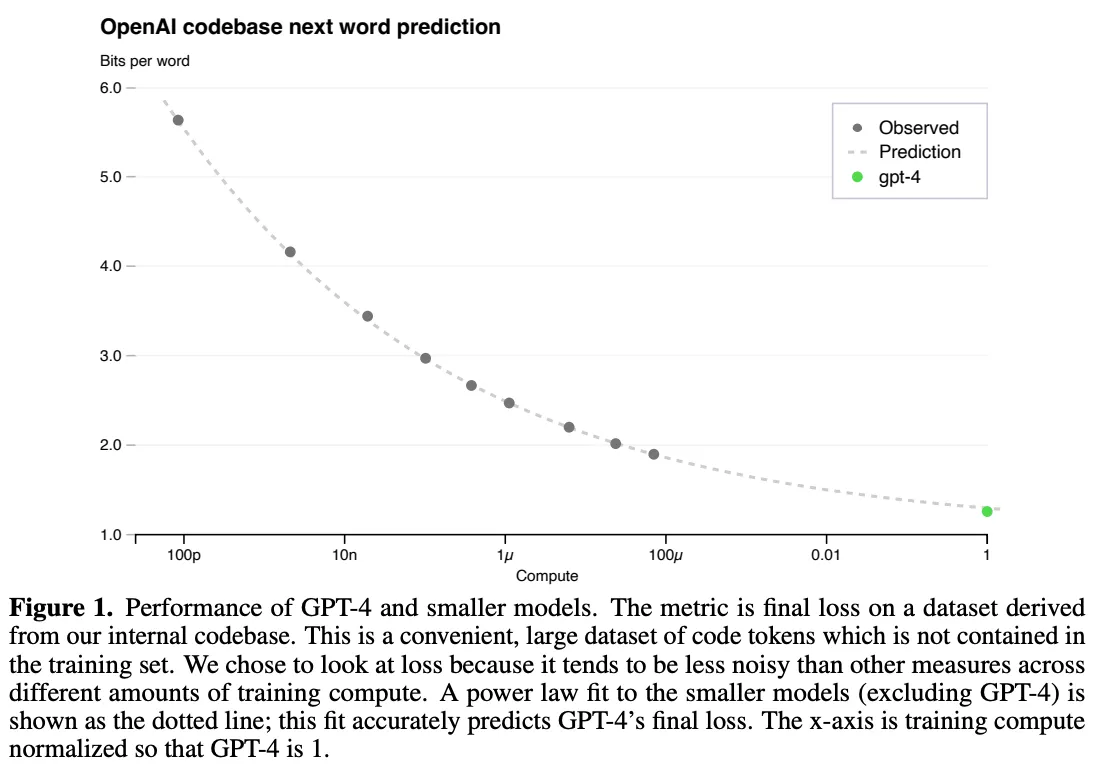

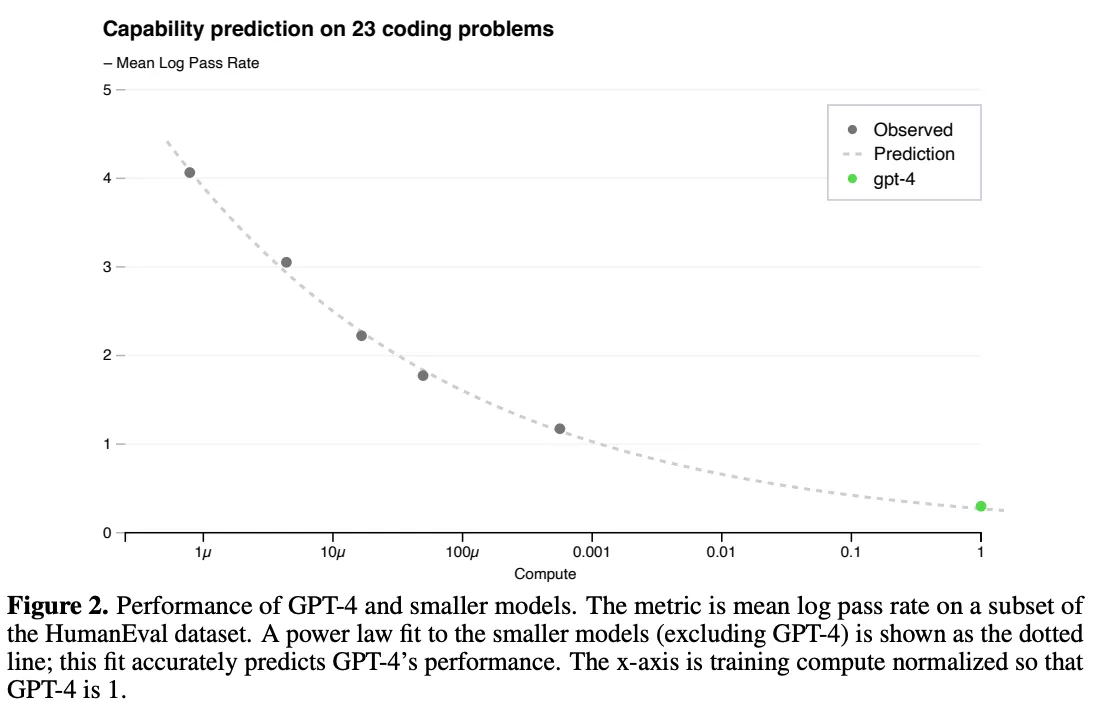

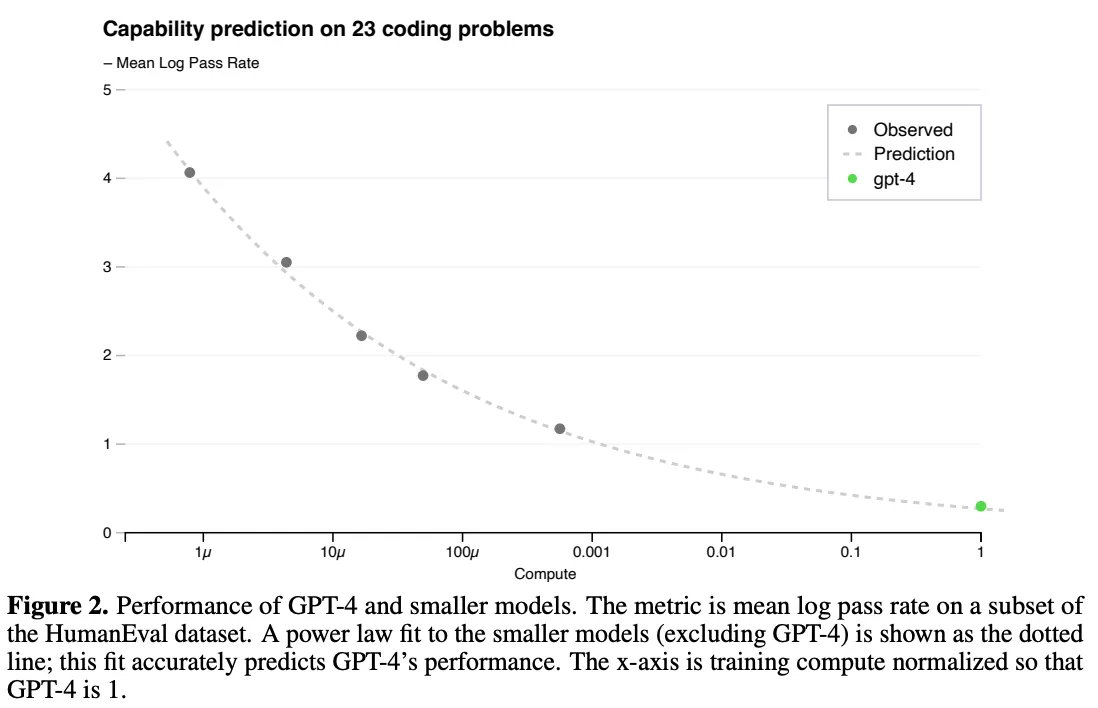

Тем не менее, важность масштабирования очень четко прослеживается в этом техническом отчете. Авторы отмечают, что ключевой задачей в этой работе является разработка масштабируемой обучающей архитектуры, которая предсказуемо работает в разных масштабах, позволяя экстраполировать результаты небольших прогонов и тем самым обеспечивая уверенность для более крупных (и гораздо более дорогих!) тренировочных упражнений с уверенностью.

"Итоговые потери правильно обученной большой языковой модели ...... можно аппроксимировать степенным законом объема вычислений, использованных для обучения модели". - Источник [5]

Масштабная предварительная подготовка стоит очень дорого, поэтому у нас обычно есть только один шанс сделать все правильно.Нет места для внесения корректировок в зависимости от модели. Закон размера играет ключевую роль в этом процессе. Мы можем обучить модель, используя в 1 000-10 000 раз меньше вычислений, и использовать результаты этих тренировок для подгонки законов мощности. Затем эти законы мощности можно использовать для предсказания производительности более крупных моделей. В частности, в [8] мы видели, что производительность GPT-4 была предсказана с помощью законов мощности, которые измеряют связь между потерями при вычислениях и потерями при тестировании; см. ниже.

GPT-4 Формула закона масштаба для обучения (Источник [5])

(Источник [5])

(Источник [5])

Шиншилла. Обучение вычислительно оптимальных больших языковых моделей [5]

(Источник [9])

(Источник [10])

(Источник [10])

"Объем данных для обучения, который, как ожидается, потребуется, значительно превышает объем данных, используемых в настоящее время для обучения больших моделей". - Источник [6]

Шиншилла.Анализ, приведенный в [6], подчеркивает важность размера данных.Для достижения оптимальной производительности большие модели необходимо обучать на большем количестве данныхЧтобы проверить этот вывод, авторы обучили большую языковую модель с 70 миллиардами параметров под названием Chinchilla. Чтобы проверить этот вывод, авторы обучили большую языковую модель с 70 миллиардами параметров под названием Chinchilla. По сравнению с предыдущими моделями, Chinchilla меньше по размеру, но имеет больший набор данных для предварительного обучения -Всего 1,4 триллиона учебных жетоновChinchilla использует те же данные и стратегию оценки, что и Gopher [10]. Хотя Chinchilla в четыре раза меньше Gopher, она постоянно превосходит более крупные модели; см. ниже.

(Источник [6])

Кончина" закона масштаба

Закон масштаба недавно стал горячей (и противоречивой) темой в исследованиях ИИ. Как мы видели в этом обзоре, масштаб во многом определял улучшения в ИИ в эпоху, предшествующую обучению. Однако по мере того как темпы выпуска и совершенствования моделей замедляются во второй половине 2024 года11 , мы начинаем наблюдать повсеместное сомнение в масштабировании моделей, что, по-видимому, указывает на то, что исследования ИИ - этоВ частности, закон масштаба-Можно удариться о стену.

- По данным Reuters, OpenAI меняет свою продуктовую стратегию из-за проблем с масштабированием текущего подхода.

- В информации говорится, что совершенствование модели GPT начинает замедляться.

- Bloomberg рассказывает о трудностях, с которыми сталкиваются несколько передовых лабораторий, пытаясь создать более мощный ИИ.

- TechCrunch пишет, что масштаб начинает приносить убывающую прибыль.

- Журнал Time Magazine опубликовал статью, посвященную различным факторам, из-за которых исследования в области ИИ замедляются.

- Илья Суцкевер на конференции NeurIPS'24 сказал: "Предварительное обучение, каким мы его знаем, закончится "*.

В то же время многие эксперты придерживаются противоположного мнения. Например, (Антропология Генеральный директор компании заявил, что масштабирование *"вероятно, ...... будет продолжаться".А Сэм Олтман продолжает проповедовать.фраза "Здесь нет стен "*. В этом разделе мы добавим больше красок в эту дискуссию, предоставив обоснованное объяснение текущего состояния шкалы и различных проблем, которые могут существовать.

Сокращение масштабов: что это значит? Почему это происходит?

"Оба утверждения, вероятно, верны: на техническом уровне масштабирование все еще работает. Для пользователей темпы улучшения замедляются". - Натан Ламберт

Затем ......Замедляется ли увеличение масштаба? Ответ на этот вопрос сложен и во многом зависит от нашего точного определения понятия "замедление". Пока что наиболее правдоподобный ответ на этот вопрос заключается в том, что оба ответа верны. По этой причине мы не будем пытаться ответить на этот вопрос. Вместо этого мы углубимся в то, что говорят на эту тему, чтобы составить более глубокое представление о текущем (и будущем) состоянии масштабирования больших языковых моделей.

О чем говорит нам закон масштаба?Для начала нам необходимо рассмотреть техническое определение закона размера. Закон размера определяет зависимость между вычислениями при обучении (или размером модели/набора данных) и потерями при тестировании большой языковой модели в соответствии с законом мощности. Тем не менееПрирода этих отношений часто понимается неправильно. Идея получения экспоненциального прироста производительности при логарифмическом росте вычислений - это миф. Закон масштаба больше похож на экспоненциальный спад, что означает, что со временем нам придется работать больше, чтобы получить дальнейший прирост производительности; см. ниже.

(Источник [5])

"Практики обычно используют эталонную точность в качестве косвенного показателя качества модели, а не потери на наборе оценок недоумения". - Источник [7]

Определите производительность.Как измерить, насколько совершенствуется Большая языковая модель? С точки зрения закона масштаба, производительность большой языковой модели обычно измеряется тестовыми потерями модели во время предварительного обучения, но влияние более низких тестовых потерь на возможности большой языковой модели неясно.Приведет ли снижение потерь к повышению точности при решении последующих задач? Приведет ли снижение потерь к появлению новых возможностей для Большой языковой модели? Существует несоответствие между тем, что говорит нам закон масштаба, и тем, что нас на самом деле волнует:

- Закон размера говорит нам о том, что увеличение размера предварительной подготовки плавно уменьшает потери при тестировании больших языковых моделей.

- Наша задача - получить "лучшую" модель большого языка.

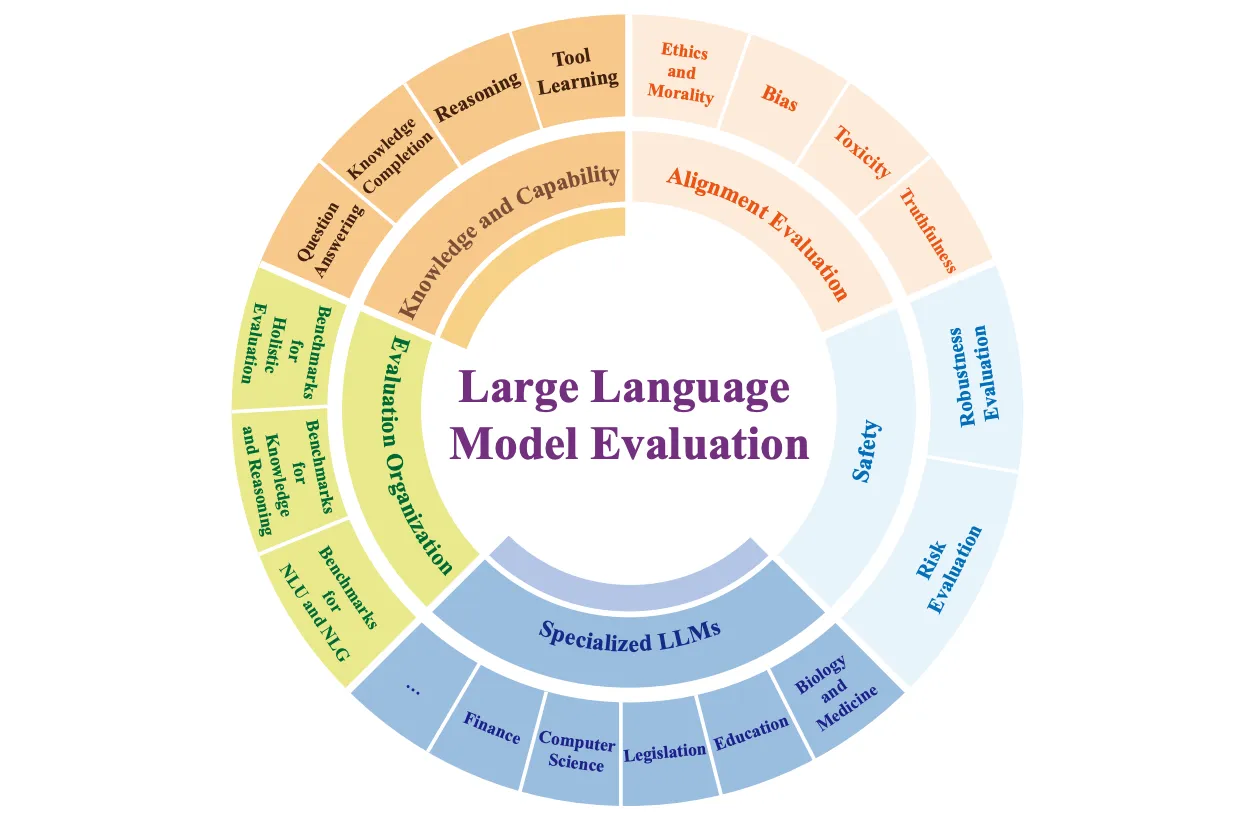

В зависимости от того, кто вы и что вы ожидаете от новой системы искусственного интеллекта...и методы, которые вы использовали для оценки этих новых систем-будут очень разными. Обычные пользователи ИИ, как правило, сосредоточены на чат-приложениях общего назначения, в то время как практиков часто волнует производительность больших языковых моделей в задачах, связанных с последующей обработкой информации. Напротив, исследователи в ведущих передовых лабораториях, похоже, возлагают большие (и очень специфические) надежды на системы ИИ; например, на написание докторских диссертаций или решение сложных математических задач. Учитывая широкий спектр возможностей, которые сложно оценить, существует множество способов оценить производительность больших языковых моделей; см. ниже.

(Источник [15])

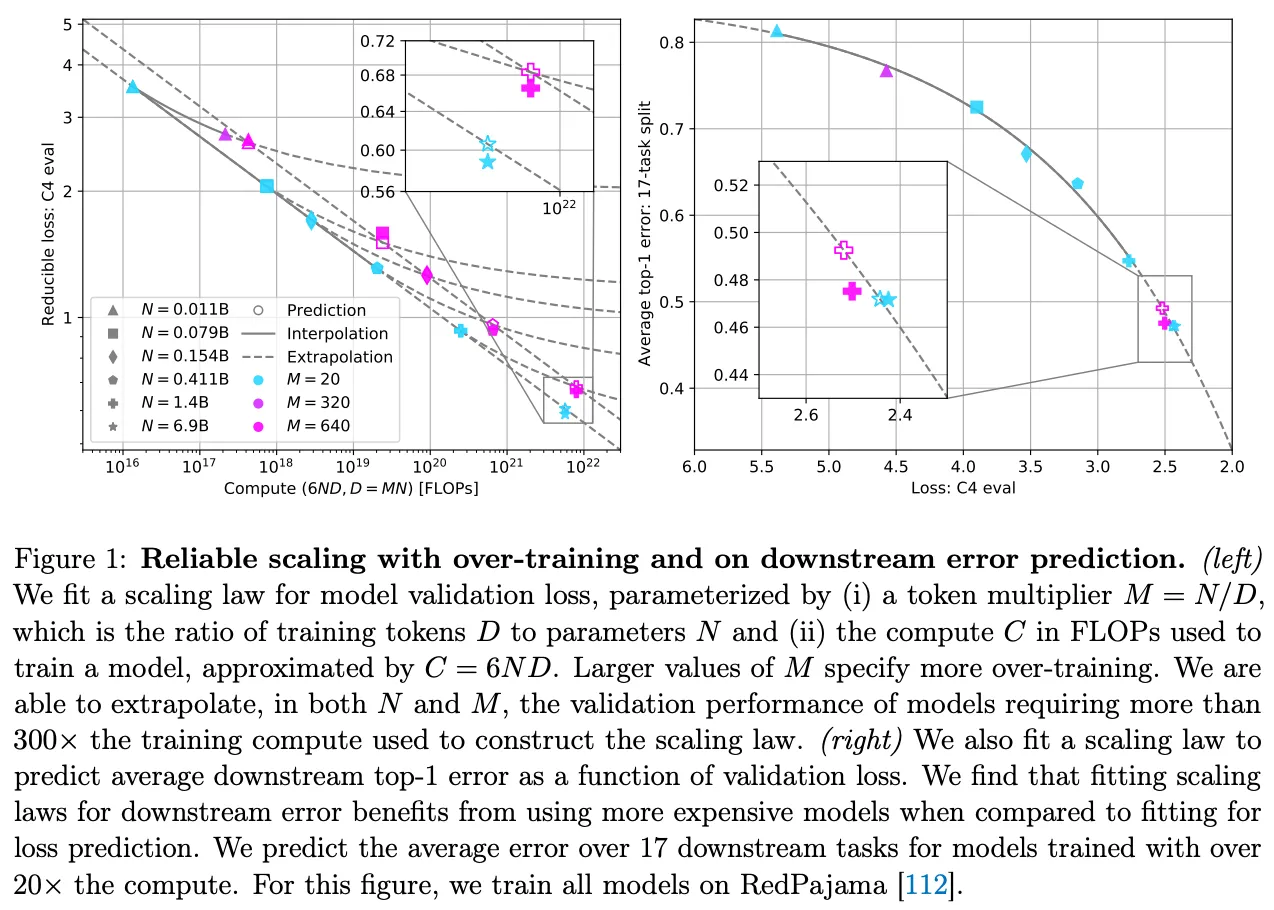

Гибель данных.Чтобы увеличить масштаб предварительного обучения больших языковых моделей, мы должны увеличить размер как модели, так и набора данных. Ранние исследования [1], по-видимому, предполагают, что объем данных менее важен, чем размер модели, но в работе Чинчиллы [6] мы видим, что размер набора данных не менее важен. Кроме того, последние работы показывают, что большинство исследователей предпочитают "переобучать" свои модели.или предварительно обучить их на наборах данных, размер которых превышает оптимальность Чинчиллы-для экономии затрат на вывод [7].

"Исследования по масштабированию часто сосредоточены на вычислении оптимальных механизмов обучения ...... Поскольку большие модели требуют больших затрат на рассуждения, в настоящее время распространена практика переобучения маленьких моделей". - Источник [7]

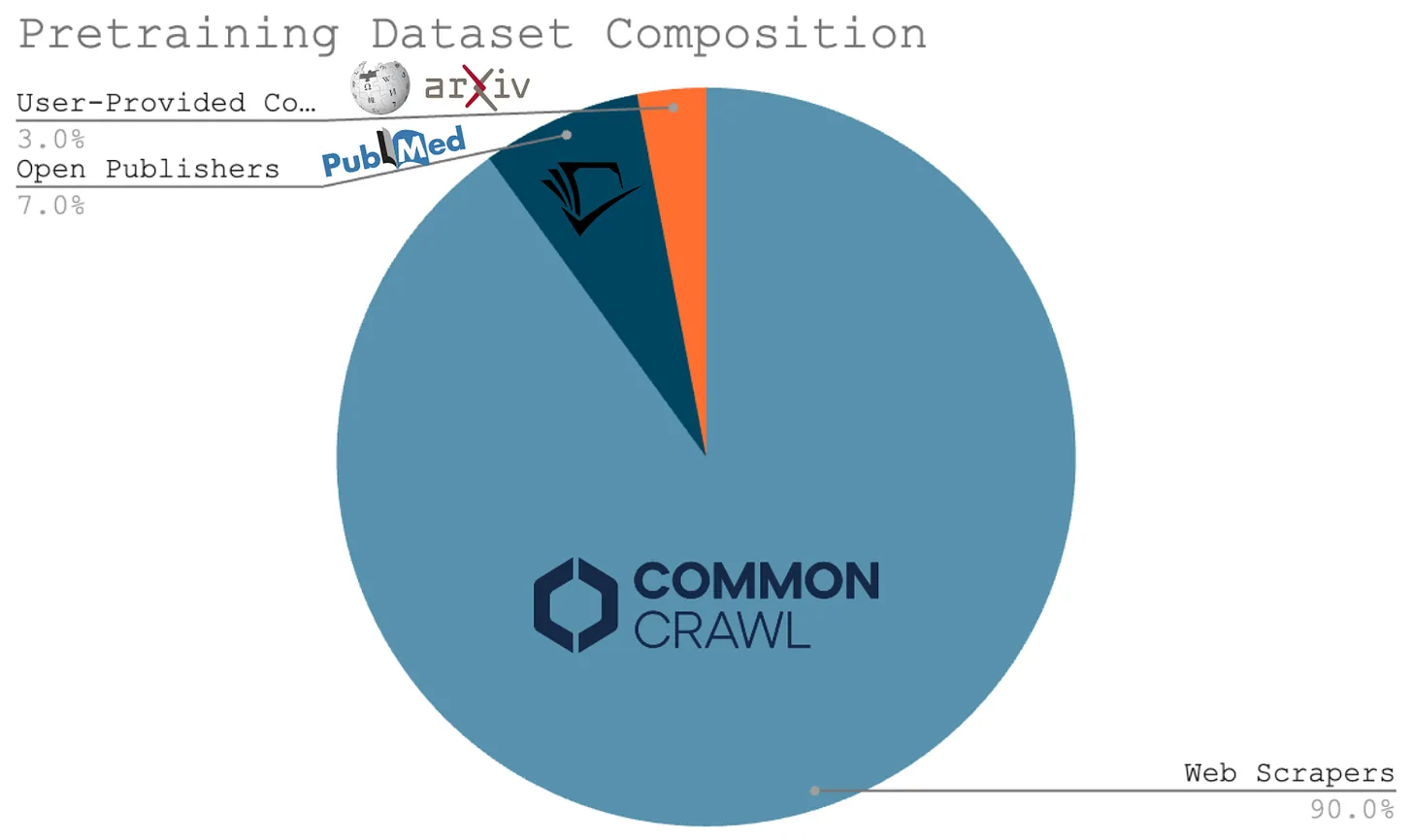

Все эти исследования приводят нас к одному простому выводу -Расширение возможностей предварительной подготовки больших языковых моделей потребует от нас создания больших наборов данных для предварительной подготовкиЭтот факт является одним из основных критических замечаний по поводу закона масштаба для больших языковых моделей. Этот факт является одним из основных критических замечаний по поводу закона масштаба для больших языковых моделей. Многие исследователи утверждают, что может не хватить данных, чтобы продолжать масштабировать процесс предварительного обучения. В качестве примера можно привести тот факт, что подавляющее большинство данных для предварительного обучения, использованных для текущей Большой языковой модели, было получено путем просмотра веб-страниц; см. ниже. Учитывая, что у нас есть только один Интернет, найти совершенно новые источники масштабных и высококачественных данных для предварительного обучения может быть непросто.

Даже Илья Суцкевер недавно приводил этот аргумент, утверждая, что i) Компьютерные технологии развиваются стремительно, но ii) Объем данных не увеличивается из-за того, что мы полагаемся на веб-ползание. В результате он утверждает, что мы не можем продолжать расширять процесс предварительного обучения вечно. Предварительное обучение в том виде, в котором мы его знаем, закончится, и мы должны найти новые пути для развития исследований ИИ. Другими словами."Мы достигли пика данных"..

Предтренировочная шкала нового поколения

Масштабирование в конечном итоге приведет к снижению отдачи, и аргументы против дальнейшего масштабирования, ориентированные на данные, являются разумными и убедительными. Тем не менее, существует несколько направлений исследований, которые могут улучшить процесс предварительного обучения.

Синтетические данные.Чтобы увеличить масштаб процесса предварительного обучения на несколько порядков, нам может понадобиться использовать синтетические данные. Несмотря на опасения, что чрезмерное использование синтетических данных может привести к проблемам с разнообразием [14], мы видим, что большие языковые модели все чаще...И, похоже, это удалось.-использование синтетических данных [12]. Кроме того, курсовое обучение [13] и стратегии непрерывного предварительного обучения привели к различным значимым улучшениям за счет корректировки данных предварительного обучения; например, изменения состава данных или добавления данных обучения в конце предварительного обучения.

(Источник [7])

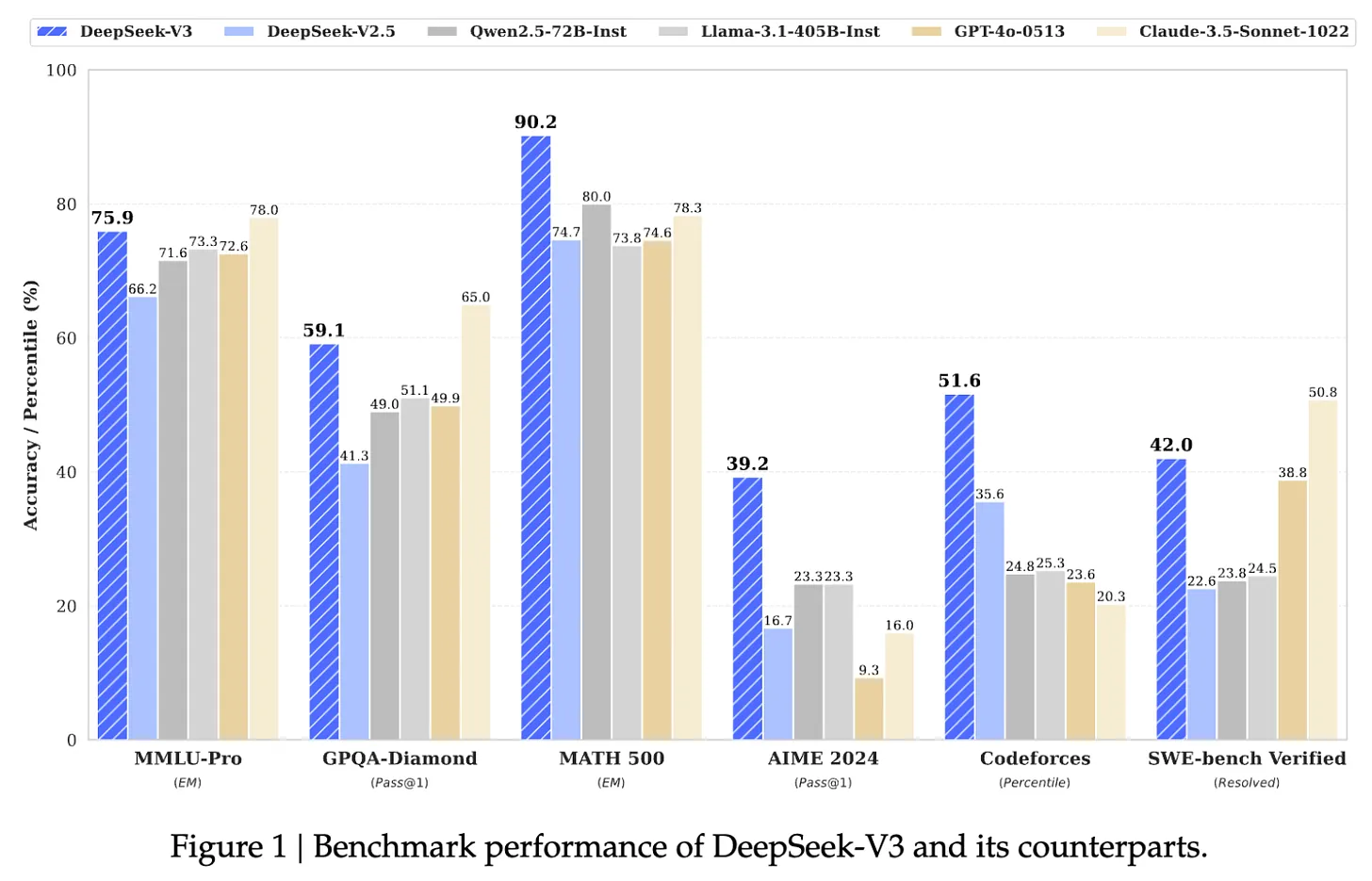

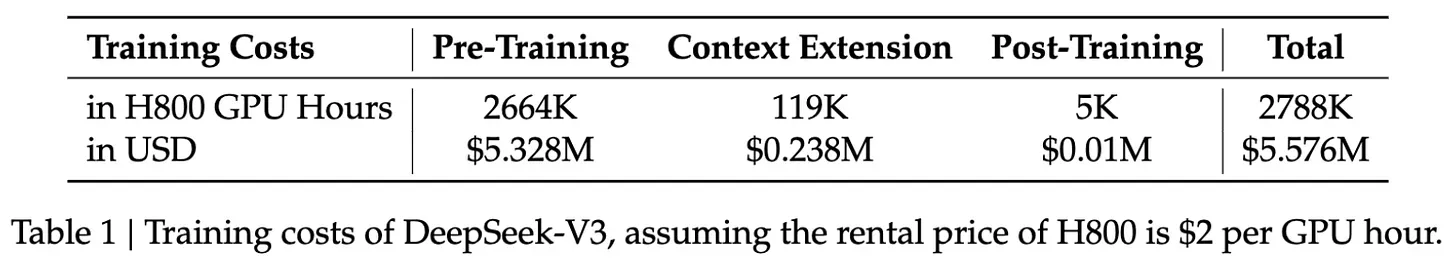

DeepSeek-v3.Несмотря на недавние споры, мы продолжаем видеть полурегулярные достижения в расширении процесса предварительного обучения больших языковых моделей. Например, недавний выпуск DeepSeek-v3 [18] - этоПараметр 671 миллиард12 (MoE) модель. Помимо того, что модель имеет открытый исходный код, она была предварительно обучена на 14,8 триллионах текстов Token и превзошла GPT-4o и Claude-3.5-Sonnet; результаты работы модели см. на рисунке ниже, а лицензию - здесь. Для сравнения, модель LLaMA-3 была обучена на более чем 15 триллионах необработанных текстовых данных; более подробную информацию см. здесь.

(Источник [18])

- Оптимизированная архитектура MoE из DeepSeek-v2.

- Новая стратегия без потерь для балансировки нагрузки MoE.

- Многоточечное предсказание целей обучения.

- Уточнение возможностей рассуждения на основе длинных моделей мыслительных цепочек (т.е. аналогично OpenAI's o1).

Модель также подверглась посттренинговому обучению, включая контролируемую тонкую настройку и обучение с подкреплением на основе обратной связи от людей, чтобы привести ее в соответствие с предпочтениями человека.

"Мы обучили DeepSeek-V3 на 14,8 триллиона высококачественных и разнообразных токенов. Процесс предварительного обучения был очень стабильным. Мы не испытали никаких неустранимых скачков потерь или необходимости откатываться назад в процессе обучения". - Источник [8]

Однако главным ключом к впечатляющей производительности DeepSeek-v3 является шкала предварительного обучения -Это большая модель, обученная на столь же большом наборе данных.DeepSeek-v3 имеет удивительно стабильный процесс предварительного обучения и соответствует стандарту большой языковой модели по очень низкой цене! Обучение такой большой модели затруднено по разным причинам (например, из-за сбоев GPU и скачков потерь). DeepSeek-v3 имеет удивительно стабильный процесс предварительного обучения и обучается по разумной цене в соответствии со стандартом большой языковой модели; см. ниже.Эти результаты свидетельствуют о том, что крупные операции перед тренировкой со временем становятся более управляемыми и эффективными..

(Источник [18])

- Более крупные вычислительные кластеры13.

- Больше (и лучше) аппаратного обеспечения.

- Много энергии.

- новые алгоритмы (например, для более масштабного распределенного обучения).

Подготовка моделей нового поколения - это не просто вопрос обеспечения финансирования для большего количества графических процессоров, это многопрофильный инженерный подвиг. Такая сложная работа требует времени. Для справки, GPT-4 был выпущен в марте 2023 года, почти через три года после выхода GPT-3.В частности, 33 месяца. Вполне можно ожидать, что за аналогичные сроки (если не за более длительные) удастся добиться еще 10-100-кратного увеличения масштаба.

"На каждый порядок роста масштаба необходимо находить свои инновации". - Эге Эрдил (Epoch AI)

Будущее исследований в области искусственного интеллекта

Теперь, когда мы глубже понимаем, как обстоят дела с предварительным обучением в масштабе, давайте предположим (чисто для целей этой дискуссии), что исследования в области предварительного обучения внезапно упрутся в стену. Даже если возможности моделей в ближайшем будущем не улучшатся, существует ряд способов, с помощью которых исследования в области ИИ могут продолжать быстро развиваться. Мы уже обсуждали некоторые из этих тем (например, синтетические данные). В этом разделе мы сосредоточимся на двух популярных в настоящее время темах:

- Система/агент больших языковых моделей.

- Модели рассуждений.

Создание полезной системы моделирования большого языка

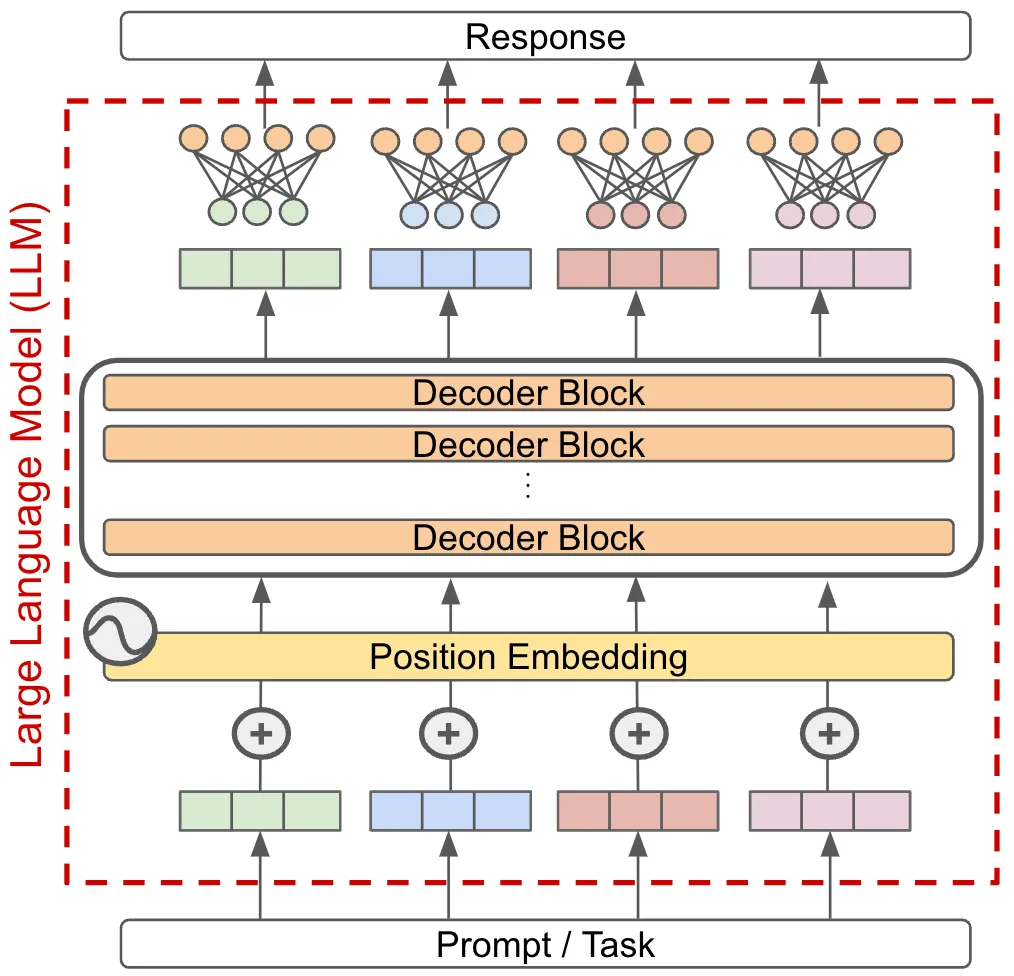

Большинство современных приложений на основе Больших Языковых Моделей работают в парадигме одной модели. Другими словами, мы решаем задачу, передавая ее одной модели Большого языка и непосредственно используя выход модели в качестве ответа на эту задачу; см. ниже.

Если бы мы хотели улучшить такую систему (то есть решать более сложные задачи с большей точностью), мы могли бы просто улучшить возможности базовой модели, но такой подход предполагает создание более мощных моделей. Вместо этого мы можем выйти за рамки одномодельной парадигмы, построив систему на основе крупноязычной модели, которая объединяет в себе несколько крупноязычных моделей.или другой компонент-- решать сложные задачи.

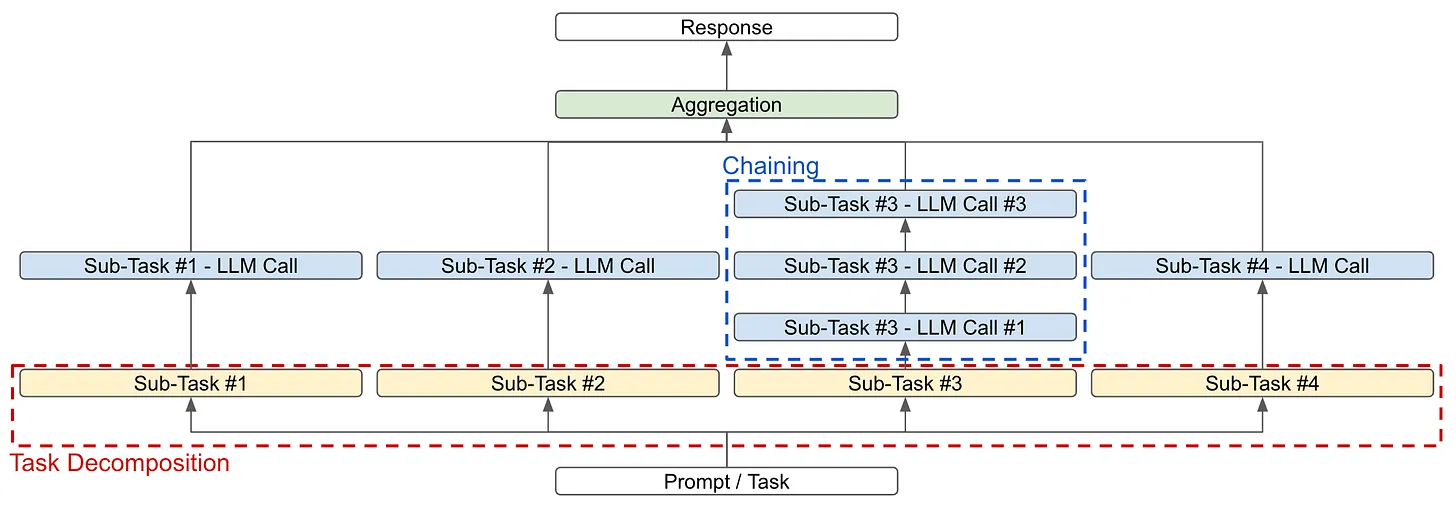

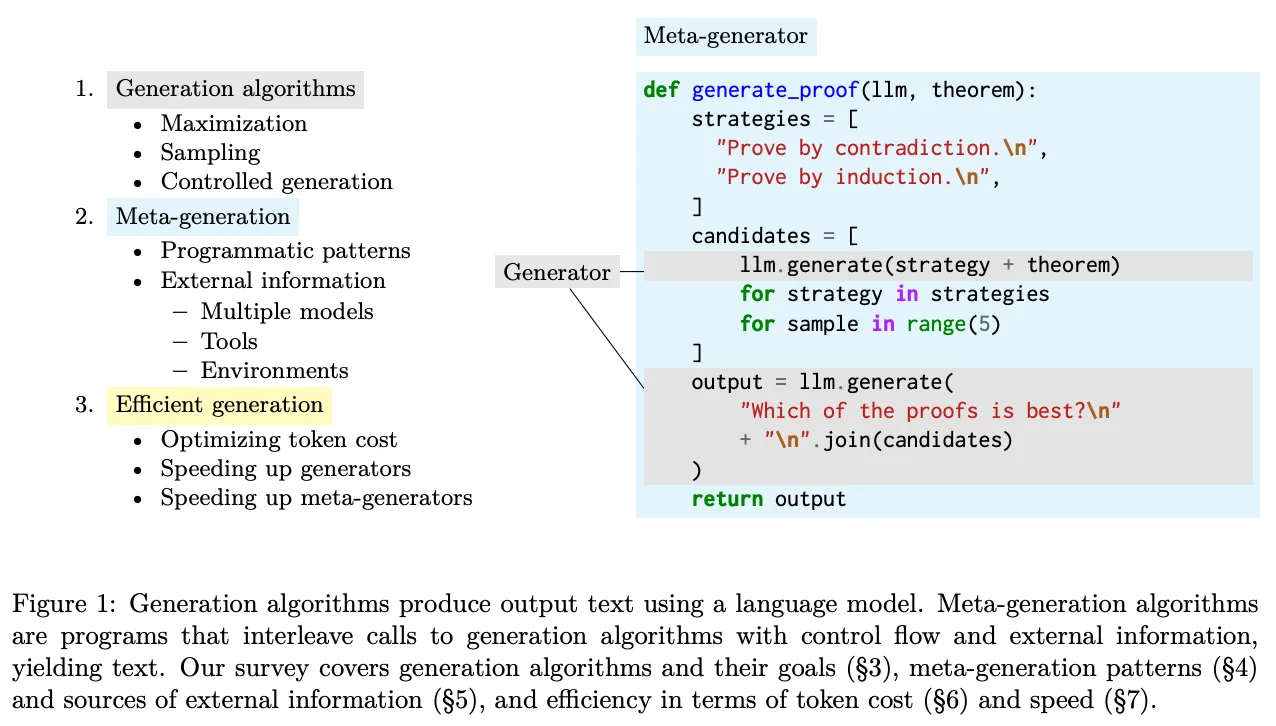

Основы системы моделирования больших языков. Цель системы Big Language Model - разложить сложные задачи на более мелкие части, которые могут быть легче решены с помощью Big Language Model или других модулей. Для достижения этой цели можно использовать две основные стратегии (как показано на рисунке выше):

- Разбивка задач: Разбейте саму задачу на более мелкие подзадачи, которые можно решать по отдельности, а затем объединить14 , чтобы получить окончательный ответ.

- ссылка (на веб-сайте): Решайте задачи или подзадачи, делая несколько последовательных обращений к большой языковой модели, а не один вызов.

Эти стратегии можно использовать по отдельности или в тандеме. Например, предположим, что мы хотим создать систему для краткого изложения книг. Для этого мы можем разбить задачу на части, сначала обобщив каждую главу книги. Отсюда мы можем:

- Резюмируйте задачу, разбив ее на более мелкие фрагменты текста (т.е. аналогично рекурсивной/иерархической декомпозиции).

- Свяжите несколько вызовов LM между собой; например, пусть один LM извлечет все важные факты или информацию из главы, а другой LM создаст резюме главы на основе этих ключевых фактов.

Затем мы можем объединить эти результаты, заставив Большую языковую модель суммировать связанные между собой краткие описания глав, чтобы составить краткое изложение всего романа. Тот факт, что большинство сложных задач можно разложить на простые части, которые легко решить, делает такие системы моделирования большого языка очень мощными. При более глубокой декомпозиции и связывании эти системы могут стать очень сложными, что делает их интересной (и влиятельной) областью исследований в области прикладного ИИ.

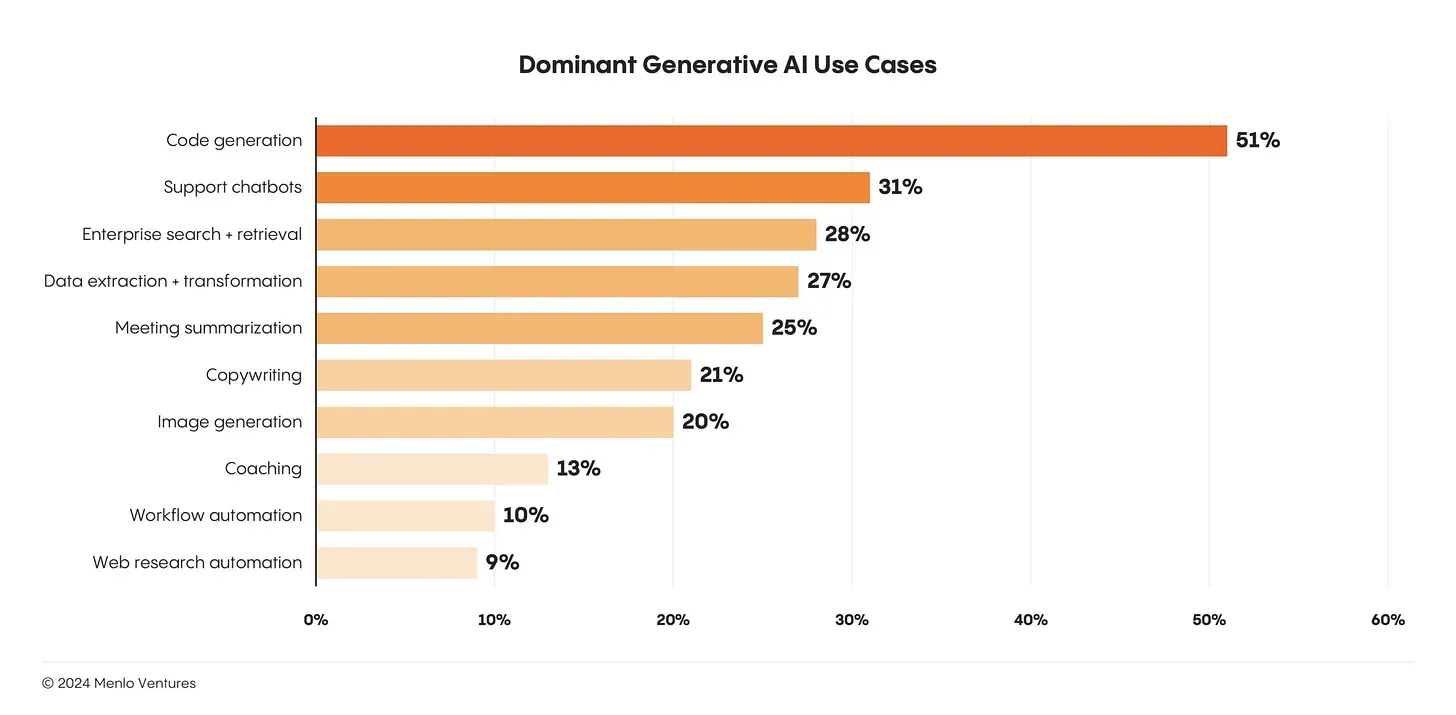

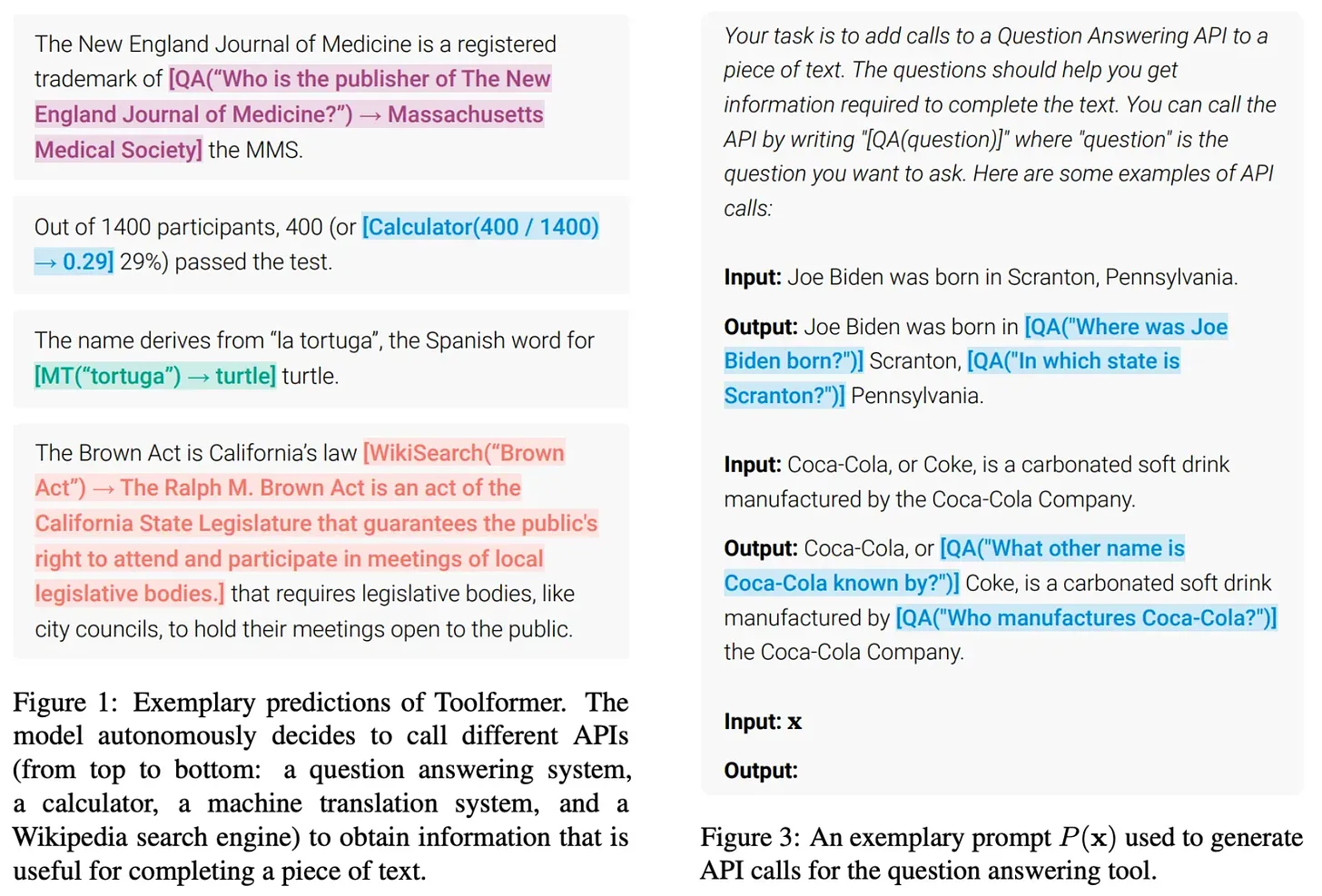

Создание продуктов на основе Большой языковой модели.Несмотря на успех и популярность Большой языковой модели, количество реальных (и широко распространенных) примеров использования Большой языковой модели все еще очень мало. На сегодняшний день самыми крупными случаями использования Большой языковой модели являются генерация кода и чаты, которые являются относительно очевидными приложениями Большой языковой модели15 ; см. ниже.

Учитывая, что областей применения моделирования больших языков так много.Просто создание более полезных продуктов на основе больших языковых моделей - важная область исследований в области прикладного ИИ.. Очень мощные модели уже доступны нам, но использовать их для создания продуктов, достойных применения, - совершенно другая проблема. Для решения этой проблемы необходимо научиться создавать надежные и мощные системы моделирования больших языков.

(Источник [19])

прочностьявляется одним из самых больших препятствий на пути создания более мощных Больших языковых моделей/агентных систем. Предположим, у нас есть система Большой языковой модели, которая делает десять различных обращений к Большой языковой модели. Более того, предположим, что вероятность успеха каждого обращения к Большой языковой модели составляет 95%, и все обращения должны быть успешными, чтобы сгенерировать правильный конечный результат. Хотя отдельные компоненты системы достаточно точны, ноОднако коэффициент успешности всей системы составляет всего 60%!

(Источник [20])

(Источник [20])

Модели рассуждений и новые парадигмы масштабирования

Распространенной критикой первых больших языковых моделей было то, что они просто запоминали данные и не обладали достаточной способностью к рассуждениям. Однако за последние несколько лет утверждение о том, что большие языковые модели не способны рассуждать, было в значительной степени опровергнуто. Из последних исследований мы знаем, что эти модели, возможно, всегда обладали врожденной способностью рассуждать, но для того, чтобы вызвать эту способность, необходимо было использовать правильные подсказки или методы обучения.

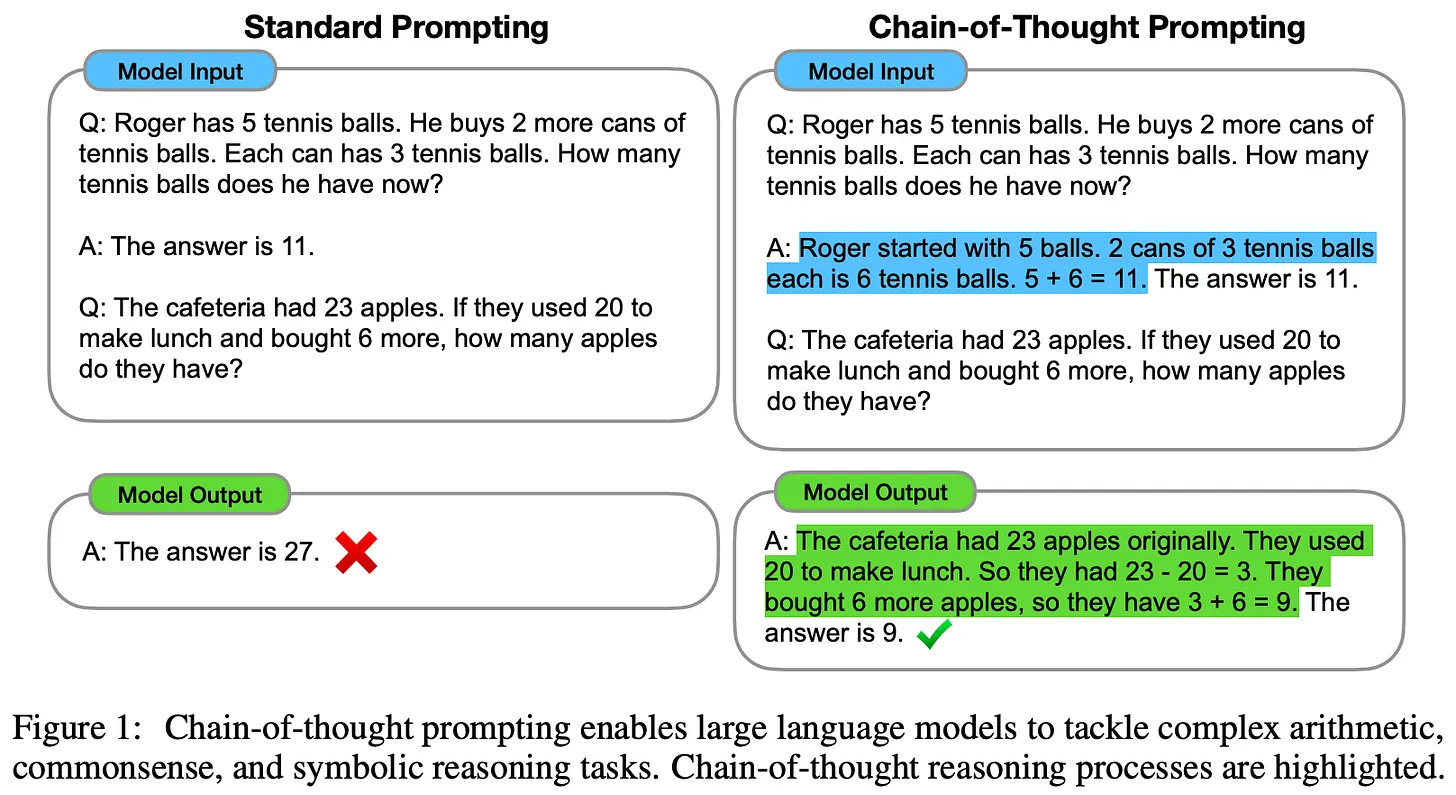

Советы по цепочке мыслей (CoT) [22] был одним из первых методов, продемонстрировавших возможности вывода на основе большой языковой модели. Метод прост и основан на подсказках. Мы просто просим Большую языковую модель дать объяснение своему ответу, прежде чем генерировать сам ответ; подробнее см. здесь. Рассудочная способность Большой языковой модели значительно повышается, когда она генерирует обоснование, описывающее пошаговый процесс, использованный для получения ответа. Кроме того, такие объяснения понятны человеку и могут сделать вывод модели более интерпретируемым!

(Источник [22])

- Большие языковые модели класса - Модели оценки судей обычно служат основой для выставления оценок до генерации окончательных результатов оценки [23, 24].

- Для обучения небольших/открытых больших языковых моделей составлению более качественных цепочек мыслей были предложены стратегии тонкой настройки под наблюдением и настройки инструкций [25, 26].

- Большие языковые модели часто просят проанализировать, прокомментировать или подтвердить собственные результаты, а затем изменить свои результаты на основе этой информации [12, 27].

Сложные рассуждения являются активной темой исследований и быстро развиваются. Новые алгоритмы обучения, которые учат большие языковые модели включать (пошаговую) проверку [28, 29] в процесс рассуждения, показали многообещающие результаты, и мы, вероятно, продолжим наблюдать улучшения по мере появления новых и лучших стратегий обучения.

Модель вывода o1 в OpenAI [21] знаменует собой значительный скачок вперед в возможностях рассуждений Большой языковой модели. o1 использует стратегии рассуждений, которые в значительной степени основаны на цепочках размышлений. Подобно тому, как люди думают, прежде чем ответить на вопрос, o1 требуется время, чтобы "подумать", прежде чем дать ответ. На самом деле "мышление", которое генерирует o1, - это просто длинная цепочка мыслей, которую модель использует для обдумывания проблемы, разбиения ее на более простые шаги, опробования различных подходов к решению проблемы и даже исправления собственных ошибок16 .

"OpenAI o1 - это новая крупномасштабная языковая модель, обученная выполнять сложные рассуждения с помощью обучения с подкреплением. o1 думает, прежде чем ответить - он может генерировать длинную внутреннюю цепочку мыслей, прежде чем ответить пользователю". - Источник [21]

Подробности точной стратегии обучения o1 не разглашаются. Однако мы знаем, что o1 учится рассуждать с помощью "крупномасштабного алгоритма обучения с подкреплением", который "очень эффективно использует данные" и фокусируется на улучшении способности модели генерировать полезные цепочки мыслей. Судя по публичным комментариям исследователей OpenAI и недавним заявлениям об o1, похоже, что модель была обучена с помощью чистого обучения с подкреплением, что противоречит предыдущим предположениям о том, что o1 могла использовать какую-то форму поиска деревьев в своих рассуждениях.

Сравнение GPT-4o и o1 в задачах, требующих большого количества умозаключений (Источник [21])

- Лучшие 89% в разделе Конкурентные задачи по программированию на Codeforces.

- Попадание в число 500 лучших студентов США в отборочных турах Американской математической олимпиады (AIME).

- Превосходит точность ответов аспирантов на вопросы по физике, биологии и химии (GPQA) на уровне аспирантов.

(Источник [22])

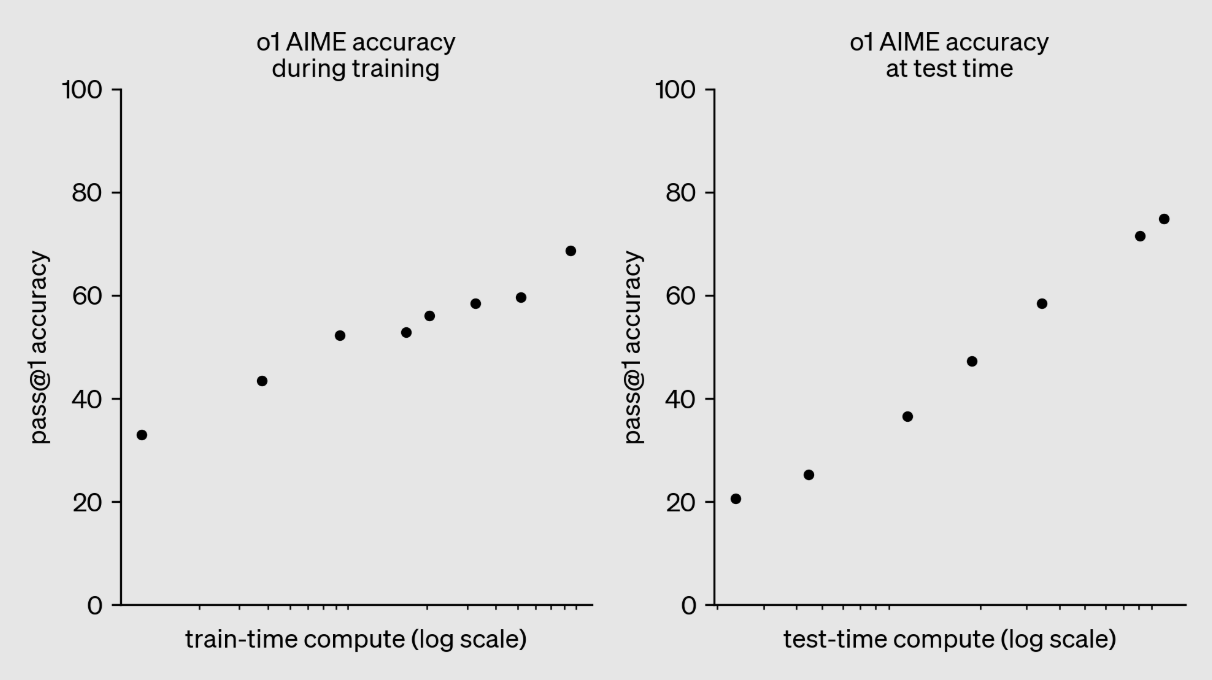

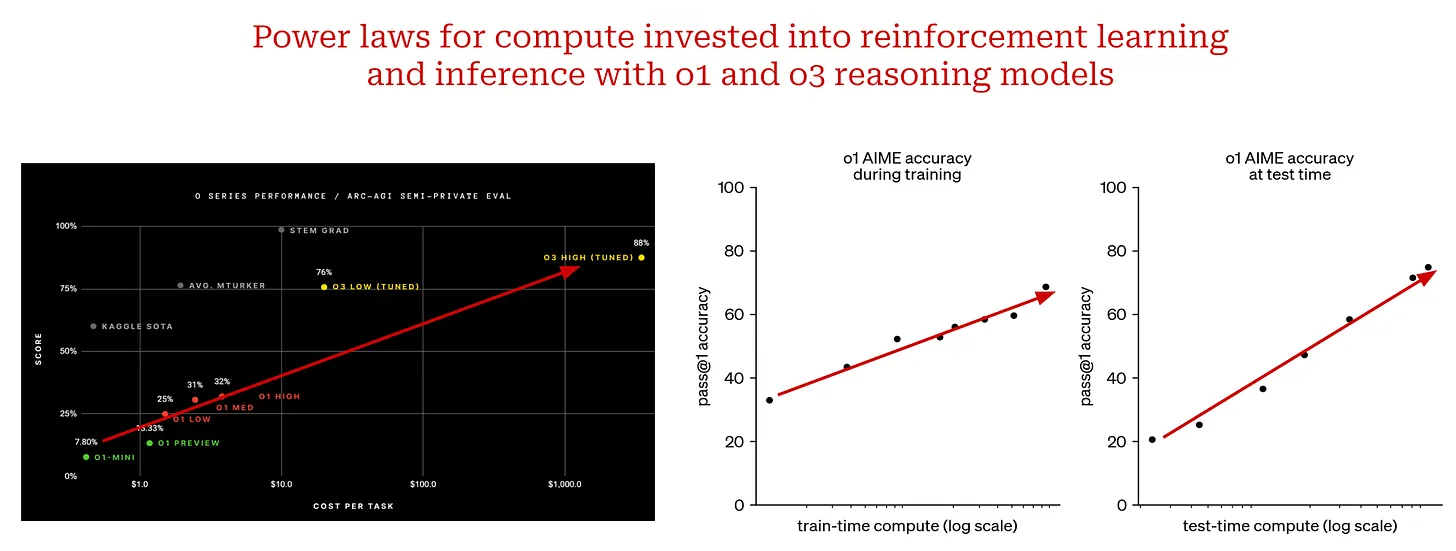

"Мы обнаружили, что производительность o1 продолжает улучшаться при увеличении количества обучения с подкреплением (вычисляется во время обучения) и увеличении времени на обдумывание (вычисляется во время тестирования)". - Источник [22]

Аналогично, на графике выше мы видим, что производительность o1 плавно улучшается по мере того, как мы вкладываем больше вычислений в обучение с помощью обучения с подкреплением. Именно такой подход использовался при создании модели вывода o3. Модель была оценена OpenAI в конце 2024 года, и очень мало подробностей об o3 было представлено общественности. Однако, учитывая, что модель была выпущена так быстро после o1 (то есть через три месяца), вполне вероятно, что o3 - это "увеличенная" версия o1, в которой больше вычислений вкладывается в обучение с подкреплением.

На момент написания статьи модель o3 еще не была выпущена, но результаты, достигнутые благодаря расширению o1, впечатляют (а в некоторых случаях и шокируют). Ниже перечислены наиболее заметные достижения o3:

- Набрал 87,5% в бенчмарке ARC-AGI, по сравнению с точностью GPT-4o в 5%. o3 стал первой моделью, которая превысила 85% производительности на уровне человека в ARC-AGI. Этот бенчмарк был назван "Северной звездой" AGI и остается непобежденным уже более пяти лет17 .

- Точность 71,7% на SWE-Bench Verified и оценка Эло 2727 на Codeforces ставят o3 в число 200 лучших программистов мира.

- с точностью 25,2% в бенчмарке FrontierMath от EpochAI.Улучшенная точность по сравнению с предыдущей версией 2.0%Теренс Тао назвал этот эталон "чрезвычайно сложным" и, скорее всего, неразрешимым для систем ИИ "по крайней мере в течение нескольких лет". Теренс Тао назвал этот эталон "чрезвычайно сложным" и, скорее всего, неразрешимым для систем искусственного интеллекта "по крайней мере, в течение нескольких лет".

Также была представлена облегченная версия o3 под названием o3-mini, которая работает очень хорошо и предлагает значительные улучшения в эффективности вычислений.

(Источник [21] и здесь)

- Время обучения (интенсивное обучение) Расчет.

- Вычисляйте, когда рассуждаете.

Масштабирование моделей в стиле o1 отличается от традиционного закона размера. Вместо того чтобы увеличивать процесс предварительного обучения, мы увеличиваем объем вычислений, затрачиваемых на пост-обучение и вывод.Это совершенно новая парадигма масштабирования.Пока что результаты, достигнутые благодаря расширению модели вывода, очень хороши. Такой вывод позволяет предположить, что существуют и другие возможности для расширения, помимо предварительного обучения. С появлением моделей вывода мы обнаружили следующую гору, на которую нам предстоит взобраться. Хотя она может иметь различные формы, ноМасштабы будут и дальше определять прогресс в исследованиях ИИ.

заключительные замечания

Теперь мы имеем более четкое представление о законах масштаба, их влиянии на большие языковые модели и будущем направлении исследований в области ИИ. Как мы выяснили, существует множество факторов, способствующих недавней критике законов масштаба:

- Естественное затухание закона масштаба.

- Ожидания от компетентности в области моделирования больших языков значительно различались.

- Задержки при проведении масштабных междисциплинарных инженерных работ.

Это законные вопросы, которыеНо ни один из них не указывает на то, что масштабирование все еще не работает так, как ожидалось. Инвестиции в крупномасштабное предварительное обучение будут (и должны) продолжаться, но со временем улучшать его будет все сложнее. В результате другие направления развития (например, агенты и умозаключения) станут более важными. Однако основная идея масштабирования будет продолжать играть огромную роль, пока мы инвестируем в эти новые области исследований. Вопрос не в том, будем ли мы продолжать масштабироваться или нет.Главный вопрос в том, что мы будем делать дальше..

библиография

[1] Каплан, Джаред и др. "Законы масштабирования для нейронных моделей языка". Препринт arXiv:2001.08361 (2020).[2] Рэдфорд, Алек. "Улучшение понимания языка с помощью генеративного предварительного обучения" (2018).[3] Рэдфорд, Алек и др. "Языковые модели - это несамостоятельные многозадачные обучаемые". Блог OpenAI 1.8 (2019): 9.[4] Браун, Том и др. "Языковые модели - это малозаметные обучаемые". Достижения в области нейронных систем обработки информации 33 (2020): 1877-1901.[5] Ачиам, Джош и др. "Технический отчет Gpt-4". Препринт arXiv:2303.08774 (2023).[6] Хоффманн, Джордан и др. "Обучение вычислительно-оптимальных больших языковых моделей". Препринт arXiv:2203.15556 (2022).[7] Гадре, Самир Ицхак и др. "Языковые модели надежно масштабируются с переобучением и на последующих задачах". Препринт arXiv:2403.08540 (2024).[8] Ouyang, Long, et al. "Обучение языковых моделей следовать инструкциям с обратной связью от человека". Достижения в области нейронных систем обработки информации 35 (2022): 27730-27744.[9] Смит, Шейден и др. "Использование deepspeed и megatron для обучения megatron-turing nlg 530b, крупномасштабной генеративной модели языка". Препринт arXiv:2201.11990 (2022).[10] Rae, Jack W., et al. "Масштабирование языковых моделей: методы, анализ и выводы из обучения gopher". Препринт arXiv:2112.11446 (2021).[11] Bhagia, Akshita, et al. "Establishing Task Scaling Laws through Compute-Efficient Model Ladders." Препринт arXiv:2412.04403 (2024).[12] Бай, Юнтао и др. "Конституционный ай: безвредность по отзывам ай". Препринт arXiv:2212.08073 (2022).[13] Блейкни. Коди.и др. "Искрятся ли ваши данные радостью? Повышение производительности за счет увеличения выборки доменов в конце обучения". Препринт arXiv:2406.03476 (2024).[14] Chen, Hao, et al. "О разнообразии синтетических данных и их влиянии на обучение больших языковых моделей". Препринт arXiv:2410.15226 (2024).[15] Guo, Zishan, et al. "Оценка больших языковых моделей: всеобъемлющий обзор". Препринт arXiv:2310.19736 (2023).[16] Xu, Zifei, et al. "Scaling laws for post-training quantized large language models". Препринт arXiv:2410.12119 (2024).[17] Xiong, Yizhe, et al. "Temporal scaling law for large language models." Препринт arXiv:2404.17785 (2024).[18] DeepSeek-AI et al. "DeepSeek-v3 Technical Report". https://github.com/deepseek-ai/DeepSeek-V3/blob/main/DeepSeek_V3.pdf (2024).[19] Schick, Timo, et al. "Toolformer: языковые модели могут научить себя использовать инструменты." arXiv preprint arXiv:2302.04761 (2023).[20] Welleck, Sean, et al. "From decoding to meta-generation: reference-time algorithms for large language models." Препринт arXiv:2406.16838 (2024).[21] OpenAI и др. "Учимся рассуждать с помощью LLM". https://openai.com/index/learning-to-reason-with-llms/ (2024).[22] Wei, Jason, et al. "Chain-of-thought prompting elicits reasoning in large language models." Достижения в области нейронных систем обработки информации 35 (2022): 24824-24837.[23] Liu, Yang, et al. "G-eval: оценка Nlg с помощью gpt-4 с лучшим выравниванием по человеку". Препринт arXiv:2303.16634 (2023).[24] Kim, Seungone, et al. "Prometheus: Inducing fine-grained evaluation capability in language models." Двенадцатая международная конференция по изучению репрезентаций . 2023.[25] Хо, Намгю, Лаура Шмид и Се-Юн Юн. "Большие языковые модели - учителя рассуждений". Препринт arXiv:2212.10071 (2022).[26] Kim, Seungone, et al. "The cot collection: improving zero-shot and few-shot learning of language models through chain-of-thought fine-tuning". Препринт arXiv:2305.14045 (2023).[27] Венг, Иксуань и др. "Большие языковые модели - лучшие рассуждения с самопроверкой". Препринт arXiv:2212.09561 (2022).[28] Лайтман, Хантер и др. "Проверяем шаг за шагом". Препринт arXiv:2305.20050 (2023).[29] Zhang, Lunjun, et al. "Generative verifiers: reward modeling as next-token prediction". Препринт arXiv:2408.15240 (2024).1 Два основных отчета - от The Information и Reuters.

2 Мы создали чертеж, используя следующие настройки:a = 1(математика) родp = 0.5мир 0 < x < 1.

3 Расчеты определены в [1] как 6NBSкоторый N количество параметров модели, которыеB размер партии, используемой во время обучения.S общее количество шагов обучения.

4 Эта дополнительная мультипликативная константа не меняет поведения степенного закона. Чтобы понять, почему это так, мы должны понять определение масштабной инвариантности. Поскольку законы мощности инвариантны к масштабу, основные характеристики закона мощности остаются неизменными, даже если мы увеличиваем или уменьшаем его масштаб на некоторый коэффициент. Наблюдаемое поведение одинаково при любом масштабе!

5 Это описание взято из премии "Испытание временем", которую Илья получил за эту работу на выставке NeurIPS'24.

6 Хотя сейчас это может показаться очевидным, не стоит забывать, что в то время для большинства задач НЛП (например, резюмирование и вопросы и ответы) существовали исследовательские области, посвященные им! Каждая из этих задач имела соответствующие архитектуры, специализированные для выполнения этой задачи, а GPT представлял собой единую общую модель, которая могла превзойти большинство этих архитектур в ряде различных задач.

7 Это значит, что мы просто описываем каждую задачу в подсказках большой языковой модели и используем одну и ту же модель для решения разных задач - вМежду заданиями меняются только подсказки.

8 Этого следовало ожидать, так как эти модели используют вывод с нулевой выборкой и не подвергаются тонкой настройке на каких-либо последующих задачах.

9 Под "эмерджентными" способностями мы понимаем навыки, которые становятся доступными для больших языковых моделей только после достижения ими определенного размера (например, достаточно большой модели).

10 Здесь мы определяем "вычислительный оптимум" как обучающую установку, которая дает наилучшую производительность (в смысле потери теста) при фиксированных вычислительных затратах на обучение.

11 Например, Anthropic постоянно откладывает свой выход. Клод 3.5 Opus, Google выпустила только флеш-версию Gemini-2, а OpenAI выпустила GPT-4o только в 2024 году (до выхода o1 и o3 в декабре), который, вероятно, не намного более способен, чем GPT-4.

12 В процессе вывода одного токена активно всего 37 миллиардов параметров.

13 Например, компания xAI недавно построила новый центр обработки данных в Мемфисе со 100 000 графических процессоров NVIDIA, а руководство Anthropic намерено увеличить расходы на вычисления в 100 раз в течение следующих нескольких лет.

14 Шаг агрегирования может быть реализован различными способами. Например, мы можем агрегировать ответы вручную (например, через соединение), используя большую языковую модель или что-то среднее!

15 Это не потому, что эти задачи просты. И генерация кода, и общение в чате - непростые задачи, но они являются (возможно) достаточно очевидными приложениями Большой языковой модели.

16OpenAI решила скрыть эти длинные цепочки размышлений от пользователей o1. Аргументом в пользу такого выбора является то, что эти основы дают представление о мыслительных процессах модели, которые могут быть использованы для отладки или мониторинга модели. Однако моделям следует позволить выражать свои чистые мысли без каких-либо фильтров безопасности, необходимых для вывода модели на пользователя.

17 В настоящее время ARC-AGI остается технически непобежденной, поскольку o3 превышает вычислительные требования для бенчмарков. Тем не менее, модель достигает точности 75,7% при более низких вычислительных настройках.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...