CAG: метод генерации с расширенным кэшем, который в 40 раз быстрее, чем RAG

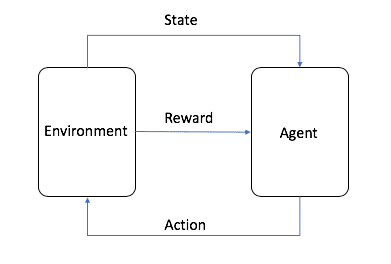

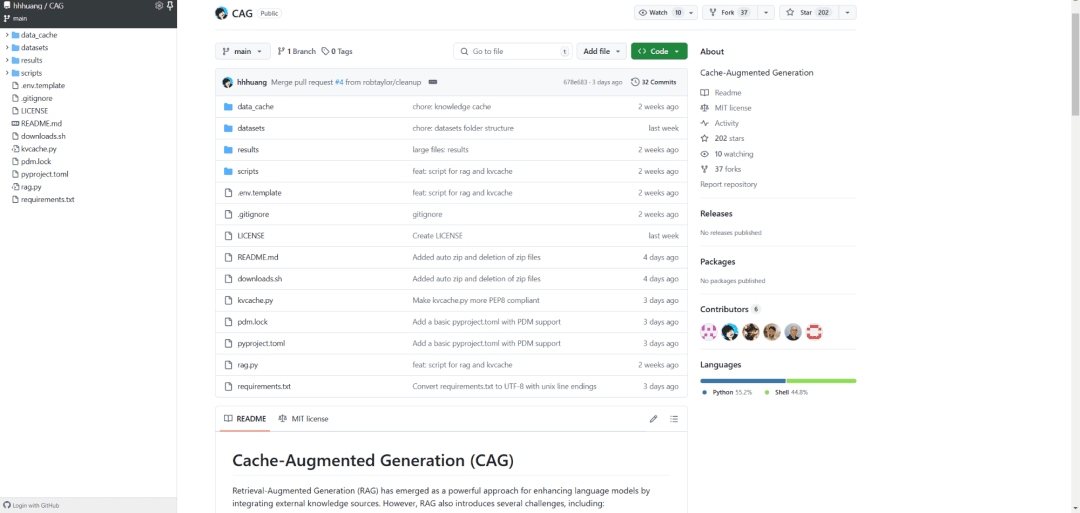

CAG (Cache Augmented Generation), которая в 40 раз быстрее, чем RAG (Retrieval Augmented Generation), революционизирует получение знаний: вместо того чтобы получать внешние данные в реальном времени, все знания предварительно загружаются в контекст модели. Это все равно что сжать огромную библиотеку в портативный набор инструментов, который можно пролистать, когда он нужен, а реализация CAG элегантна:

- Документ сначала проходит предварительную обработку, чтобы убедиться, что он вписывается в контекстное окно LLM.

- Обработанное содержимое затем кодируется в кэш Key-Value.

- Наконец, этот кэш хранится в памяти или на жестком диске, чтобы его можно было вызвать в любой момент.

Результаты убедительны: на эталонных наборах данных, таких как HotPotQA и SQuAD, CAG не только в 40 раз быстрее, но и значительно точнее и согласованнее. Это объясняется его способностью захватывать контекст глобально, без проблем, связанных с ошибками поиска или неполнотой данных.

С точки зрения практического применения эта технология перспективна в таких областях, как медицинская диагностика, финансовый анализ и обслуживание клиентов. Она позволяет системам искусственного интеллекта поддерживать высокую производительность, избегая при этом бремени обслуживания сложных архитектур.

В конечном итоге инновационность CAG заключается в том, что она превращает "бери и работай" в "носи с собой", что не только повышает эффективность, но и открывает новые возможности для внедрения ИИ. Это может стать стандартом для следующего поколения архитектур ИИ.

Ссылки:

[1] https://github.com/hhhuang/CAG

[2] https://arxiv.org/abs/2412.15605

[3] Длинноконтекстные LLM испытывают трудности с длинноконтекстным обучением: https://arxiv.org/pdf/2404.02060v2

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...