К сожалению, технический отчет Kimi k1.5, выпущенный вместе с DeepSeek-R1, улучшает длинный контекст и мультимодальный вывод.

Технический отчет Kimi k1.5 Быстрое чтение

1. Мощные мультимодальные рассуждения:

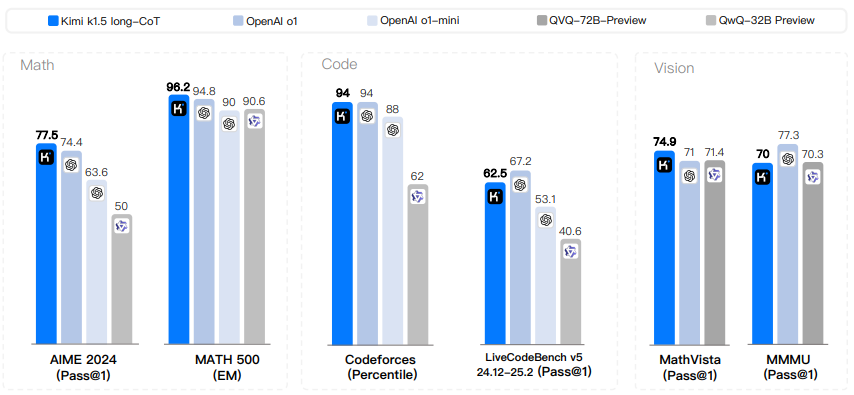

Кими Модель k1.5 достигает передовых результатов в области умозаключений в различных бенчмарках и модальностях, включая математические, кодовые, текстовые и визуальные задачи умозаключения.

Он не только работает с обычным текстом, но и понимает комбинации изображений и текста, обеспечивая истинное мультимодальное мышление.

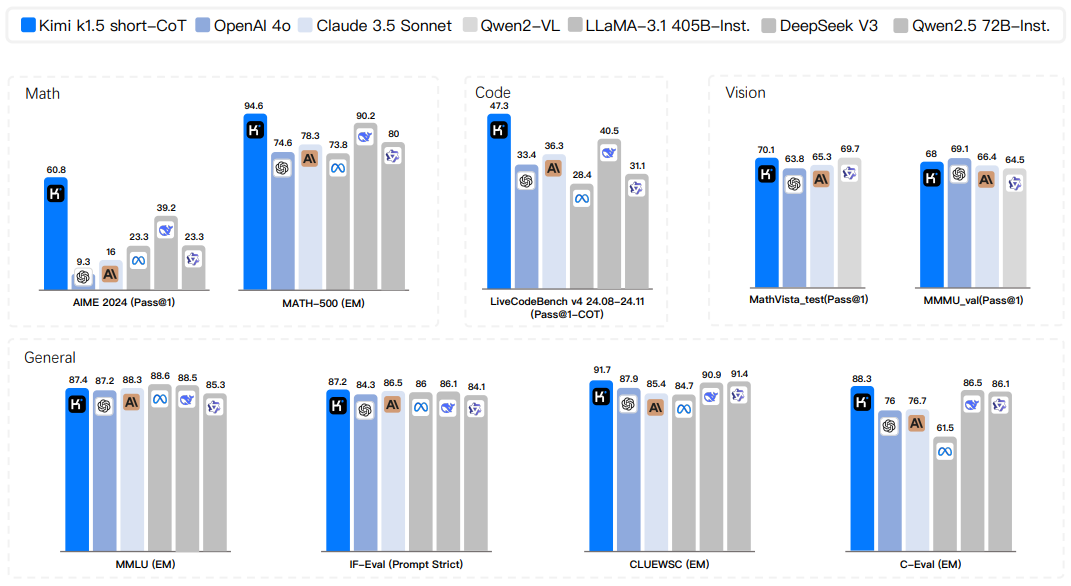

Как версия с длинным и коротким CoT, так и версия с коротким CoT демонстрируют высокую производительность.

Лидерство было достигнуто в таких наборах данных, как AIME, MATH 500, Codeforces и других.

Он также демонстрирует высокие результаты в визуальных бенчмарках, таких как MathVista.

2. Прорывы в длительном контекстном обучении RL:

При расширении контекстного окна до 128k производительность модели продолжает улучшаться, подтверждая, что длина контекста является ключевым параметром для масштабирования обучения с подкреплением.

- Техника частичного разворачивания используется для значительного повышения эффективности обучения длинных контекстных RL, что позволяет обучать более длинные и сложные процессы вывода.

- Показано, что длинные контексты имеют решающее значение для решения сложных задач.

3. Действительные методы long2short:

- Предложен эффективный метод long2short, позволяющий использовать знания моделей с длинным контекстом для повышения производительности моделей с коротким контекстом и улучшения Токен Эффективность.

- Повышение производительности коротких моделей достигается с помощью таких методов, как объединение моделей, выборка кратчайших отклонений и DPO, и является более эффективным, чем прямое обучение коротких моделей.

Показано, что производительность коротких моделей может быть улучшена за счет переноса предыдущих знаний о мышлении в длинные модели CoT.

4. Оптимизированная схема обучения RL:

Предлагаются усовершенствованные методы оптимизации политики, позволяющие добиться надежной работы без использования сложных технологий.

Для повышения эффективности и результативности обучения RL рассматриваются различные стратегии выборки, штрафы за длину и оптимизация рецептов данных.

Эффективность предложенной методологии и методики обучения была проверена с помощью исследований абляции.

5. детальный процесс обучения и разработка системы:

- Обнародован подробный рецепт обучения для Kimi k1.5, включающий этапы предварительной подготовки, тонкой настройки и интенсивного обучения.

- Представлены гибридные стратегии развертывания для оптимизации использования ресурсов во время обучения и вывода.

- Подробно описывается конвейер обработки данных и механизмы контроля качества, обеспечивающие качество обучающих данных.

- Разработал песочницу безопасного кода для выполнения и оценки сгенерированного кода.

6. Исследование размера модели и длины контекста:

Исследовалось влияние размера модели и длины контекста на производительность, и было обнаружено, что большие модели работают лучше, но маленькие модели, использующие более длинные контексты, могут приближаться или даже соответствовать производительности больших моделей, демонстрируя улучшение производительности модели за счет обучения RL.

рефераты

Было показано, что предварительное обучение языковой модели с использованием предсказания следующего токена эффективно масштабируется вычислительно, но ограничено объемом доступных обучающих данных. Расширенное обучение с подкреплением (RL) открывает новое измерение для непрерывного совершенствования ИИ, обещая масштабировать обучающие данные для больших языковых моделей (LLM) путем обучения с целью поиска вознаграждений. Однако ранее опубликованные работы не дали конкурентоспособных результатов. В свете этого мы рассказываем о практике обучения Kimi k1.5, нашей последней мультимодальной LLM, обученной с помощью RL, включая методы обучения RL, формулировку мультимодальных данных и оптимизацию инфраструктуры. Расширение длинного контекста и улучшенные методы оптимизации политики являются ключевыми элементами нашего подхода, который устанавливает простую и эффективную структуру RL, не полагаясь на более сложные методы, такие как поиск по дереву Монте-Карло, функции ценности и модели вознаграждения процесса. Примечательно, что наша система достигает передовых результатов в различных бенчмарках и модальностях - например, 77.5 на AIME, 96.2 на MATH 500, 94-й процентиль на Codeforces, MathVista. 74,9 на MathVista, что соответствует показателям OpenAI 01. Кроме того, мы представляем эффективные методы long2short, которые используют методы long CoT для улучшения модели short-CoT, что позволяет получить самые современные результаты вывода по short-CoT - например, 60.8 на AIME, 94.6 на MATH500, 47.9 на 47,3 на LiveCodeBench, что значительно превосходит существующие модели короткого КоТ, такие как GPT-40 и Клод Sonnet 3.5 (до +550%).

Рисунок 1: Результаты Kimi k1.5 long-CoT.

Рисунок 2: Результаты короткого коагулятора Kimi k1.5.

1 Введение

Предварительное обучение языковых моделей с использованием предсказания следующего токена было исследовано в контексте леммы расширения, где масштабирование параметров модели и объема данных приводит к постоянному улучшению интеллекта. (Kaplan et al. 2020; Hoffmann et al. 2022) Однако этот подход ограничен количеством доступных высококачественных обучающих данных. (Villalobos et al. 2024; Muennighoff et al. 2023) В этом отчете мы представляем рецепт обучения для Kimi k1.5, нашего последнего мультимодального LLM, обученного с помощью обучения с подкреплением (RL). Цель состоит в том, чтобы исследовать возможное новое измерение непрерывного расширения. Используя RL с LLM, модель учится исследовать вознаграждения и поэтому не ограничена существующими статичными наборами данных.

Существует несколько ключевых элементов, касающихся разработки и обучения k1.5.

- длинное контекстное расширение: Мы расширили контекстное окно RL до 128k и наблюдали постоянное улучшение производительности при увеличении длины контекста. Ключевая идея нашего подхода заключается в использовании частичного разворачивания для повышения эффективности обучения - то есть, чтобы избежать затрат на регенерацию новой траектории с нуля путем повторного использования большой части предыдущей траектории для выборки новой траектории. Наши наблюдения показывают, что длина контекста является ключевым измерением для непрерывного масштабирования RL в LLM.

- Улучшенная оптимизация стратегии: Мы выводим формулировку RL с помощью long-CoT и используем вариант зеркального спуска онлайн для надежной оптимизации стратегии. Алгоритм улучшается благодаря нашей эффективной стратегии выборки, штрафу за длину и оптимизации формулировки данных.

- Упрощенная структура: Сочетание длинных расширений контекста и улучшенных методов оптимизации политики создает упрощенный RL-фреймворк для обучения с помощью LLM. Поскольку мы можем увеличивать длину контекста, выученная CoT проявляет свойства планирования, отражения и коррекции. Увеличение длины контекста увеличивает количество шагов поиска. В результате мы показываем, что надежная производительность может быть достигнута без использования более сложных методов (например, древовидного поиска Монте-Карло, функций стоимости и моделей вознаграждения процесса).

- мультимодальныйНаша модель обучена совместно на текстовых и визуальных данных, что дает ей возможность рассуждать совместно о двух модальностях.

Кроме того, мы предлагаем эффективный подход long2short, который использует методы long-CoT для улучшения моделей short-CoT. В частности, наш подход заключается в применении штрафа за длину с активацией long-CoT и объединением моделей.

Наша версия long-CoT достигает современных результатов в различных бенчмарках и модальностях - например, 77.5 на AIME, 96.2 на MATH 500, 94-й процентиль на Codeforces, 74.9 на MathVista, что соответствует OpenAI 01. 74,9 на MathVista, что соответствует OpenAI 01. Наша модель также достигла самых современных результатов в вычислении коротких кодов - например, 60,8 на AIME, 94,6 на MATH500 и 47,3 на LiveCodeBench - что значительно превосходит существующие модели коротких кодов, такие как GPT-40 и Claude Sonnet 3.5 (до +550%). Результаты представлены на рисунках 1 и 2.

2 Метод: обучение с подкреплением с использованием LLM

Разработка Kimi k1.5 состояла из нескольких этапов: предварительное обучение, тонкая настройка под наблюдением Ванилы (SFT), тонкая настройка под наблюдением Long-CoT и обучение с подкреплением (RL). В данном отчете основное внимание уделяется RL, начиная с обзора управления набором подсказок RL (раздел 2.1) и тонкой настройки с длительным контролем CoT (раздел 2.2), за которым следует углубленное обсуждение стратегий обучения RL в разделе 2.3. Более подробную информацию о предварительном обучении и тонкой настройке под наблюдением Ванилы можно найти в разделе 2.5.

2.1 Управление набором реплик RL

В ходе предварительных экспериментов мы обнаружили, что качество и разнообразие наборов подсказок RL играют решающую роль в обеспечении эффективности обучения с подкреплением. Тщательно построенные наборы подсказок не только направляют модель к надежному выводу, но и снижают риск атак на вознаграждение и чрезмерной подгонки поверхностных паттернов. В частности, три ключевых свойства определяют высококачественные наборы подсказок RL:

- Диверсифицированное покрытиеСоветы должны охватывать различные дисциплины, такие как STEM, кодирование и общие рассуждения, чтобы повысить адаптивность модели и обеспечить ее широкую применимость в различных областях.

- Сбалансированная сложность:: Наборы подсказок должны включать равномерно распределенные легкие, средние и трудные задачи, чтобы способствовать постепенному обучению и предотвратить чрезмерную привязку к определенным уровням сложности.

- Точная оценка:: Советы должны обеспечивать объективную и надежную оценку валидатором, чтобы гарантировать, что производительность модели оценивается на основе здравых рассуждений, а не поверхностных шаблонов или случайных догадок.

Чтобы добиться разнообразного охвата набора подсказок, мы используем автоматические фильтры для отбора вопросов, требующих развернутых рассуждений и простых для оценки. Наш набор данных включает вопросы из различных областей, таких как STEM, конкурсы и общие задачи на рассуждение, и содержит как обычные текстовые данные, так и данные викторины с изображениями. Кроме того, мы разработали систему маркировки для классификации подсказок по областям и дисциплинам, чтобы обеспечить сбалансированное представление различных тематических областей (M. Li et al. 2023; W. Liu et al. 2023).

Мы использовали подход, основанный на модели, который использует собственную способность модели адаптивно оценивать сложность каждой подсказки. В частности, для каждой подсказки модель SFT генерирует десять ответов, используя относительно высокую температуру выборки. Затем рассчитывается коэффициент прохождения и используется в качестве косвенного показателя сложности подсказки - чем ниже коэффициент прохождения, тем выше сложность. Такой подход позволяет привести оценку сложности в соответствие с внутренними возможностями модели, что делает его очень эффективным при обучении RL. Используя этот подход, мы можем предварительно отсеять большинство тривиальных случаев и легко исследовать различные стратегии выборки в процессе обучения RL.

Чтобы избежать потенциальных атак на вознаграждение (Everitt et al. 2021; Pan et al. 2022), нам необходимо убедиться, что мы можем точно проверить процесс рассуждения и окончательный ответ для каждой подсказки. Эмпирические наблюдения показали, что некоторые сложные задачи на рассуждение могут иметь относительно простые и легко угадываемые ответы, что приводит к ошибочному прямому подтверждению - когда модель приходит к правильному ответу через неправильный процесс рассуждения. Чтобы решить эту проблему, мы исключили вопросы, склонные к подобным ошибкам, такие как вопросы с множественным выбором, истина/ложь и вопросы, основанные на доказательствах. Кроме того, для общих задач типа "вопрос-ответ" мы предлагаем простой, но эффективный метод выявления и удаления легко атакуемых подсказок. В частности, мы побуждаем модель угадывать возможные ответы без каких-либо шагов по выводу CoT. Если модель угадывает правильный ответ за N попыток, подсказка считается слишком легкой для атаки и удаляется. Мы обнаружили, что при задании N = 8 удаляется большинство легко атакуемых подсказок. Разработка более сложных моделей проверки остается открытым направлением для будущих исследований.

2.2 Тонкая настройка под наблюдением Long-CoT

С помощью улучшенного набора подсказок RL мы используем инженерию подсказок для создания небольшого, но высококачественного набора данных для разминки с длинным CoT, содержащего точно проверенные пути умозаключений для текстовых и графических входов. Этот подход похож на выборку отклонений (RS), но фокусируется на генерации длинных путей умозаключений CoT с помощью инженерии подсказок. Полученный набор данных для разминки призван отразить ключевые когнитивные процессы, необходимые для рассуждений гуманоидов, такие как планирование (когда модель систематически намечает шаги, предшествующие выполнению); оценка (которая включает критическую оценку промежуточных шагов); размышление (которое позволяет модели пересмотреть и улучшить свой подход); и исследование (которое поощряет рассмотрение альтернативных решений). Выполняя облегченный SFT на этом разогревочном наборе данных, мы можем эффективно направлять модель на усвоение этих стратегий вывода. В результате модель long-CoT, прошедшая тонкую настройку, демонстрирует улучшенную способность генерировать более подробные и логически последовательные ответы, что повышает ее производительность в различных задачах умозаключения.

2.3 Расширенное обучение

2.3.1 Постановка проблемы

Получив обучающий набор данных D = {(xi, yi)}^n_i=1, которая содержит вопрос xi и соответствующий истинный ответ yi, наша цель - обучить модель стратегии πθ точному решению тестовой задачи. В сложном контексте рассуждений сопоставление проблемы x с решением y - непростая задача. Чтобы решить эту проблему, подход "цепочки мышления" (CoT) предлагает использовать серию промежуточных шагов z = (z1, z2, ... , zm) для соединения x и y, где каждый zi - это последовательность лексем, которая может служить важным промежуточным шагом в решении задачи (J. Wei et al., 2022). При решении задачи x разум авторегрессионной выборки zt ~ πθ(-|x, z1, ... , zt-1), а затем выборка окончательного ответа y ~ πθ(-|x, z1,... , zm). Мы используем y, z ~ πθ для обозначения этого процесса выборки. Заметим, что и мысли, и окончательные ответы выбираются как лингвистические последовательности.

Чтобы еще больше расширить возможности модели в области умозаключений, мы используем алгоритмы планирования для изучения различных мыслительных процессов, чтобы генерировать улучшенные CoT при рассуждениях (Yao et al. 2024; Y. Wu et al. 2024; Snell et al. 2024). Главная идея этих подходов заключается в явном построении деревьев мыслительного поиска, руководствуясь оценками значений. Это позволяет модели исследовать различные продолжения мыслительного процесса или возвращаться назад, чтобы исследовать новые направления, когда она натыкается на тупик. Более подробно, пусть T - это дерево поиска, где каждый узел представляет частичное решение s = (x, z1:|s|). Здесь s состоит из задачи x и последовательности мыслей z1:|s| = (z1, ... , z|s|), которые ведут к узлу, где |s| обозначает количество мыслей в последовательности. Алгоритм планирования использует модель критики v для обеспечения обратной связи v(x, z1:|s|), которая помогает оценить текущий прогресс в решении задачи и выявить любые ошибки в существующем частичном решении. Отметим, что обратная связь может быть представлена либо дискриминантными оценками, либо лингвистическими последовательностями (L. Zhang et al. 2024). Руководствуясь обратной связью от всех s ∈ T , алгоритм планирования расширяет дерево поиска, выбирая узлы, которые с наибольшей вероятностью будут расширены. Вышеописанный процесс повторяется итеративно до тех пор, пока не будет получено полное решение.

Мы также можем подойти к алгоритмам планирования с алгоритмической точки зрения. Учитывая прошлую историю поиска, доступную на t-й итерации (s1, v(s1), ... , st-1, v(st-1)), алгоритм планирования A итеративно определяет следующее направление поиска A(st|s1, v(s1), ... , st-1, v(st-1)) и обеспечивает обратную связь с текущим ходом поиска A(v(st)|s1, v(s1), ... , st). , st) для обеспечения обратной связи. Поскольку и обдумывание, и обратная связь могут рассматриваться как промежуточные шаги рассуждения, и поскольку эти компоненты могут быть представлены в виде лингвистических последовательностей токенов, мы используем z вместо s и v для упрощения представления. Таким образом, мы рассматриваем алгоритм планирования как действующий непосредственно на последовательность шагов умозаключения A(-|z1, z2, ...). ) как отображение последовательности шагов умозаключений A(-|z1, z2, ...). В этой схеме вся информация, хранящаяся в дереве поиска, используемом алгоритмом планирования, раскладывается на полный контекст, предоставляемый алгоритму. Это открывает интересную перспективу для создания высококачественных CoT: вместо того чтобы явно строить дерево поиска и реализовывать алгоритм планирования, мы можем обучить модель для аппроксимации этого процесса. Здесь объем мышления (т. е. лингвистический токен) аналогичен вычислительному бюджету, традиционно выделяемому алгоритмам планирования. Последние достижения в области длинных контекстных окон способствуют плавному масштабированию на этапах обучения и тестирования. Если это возможно, такой подход позволяет модели выполнять неявный поиск непосредственно в пространстве заключений с помощью авторегрессионных предсказаний. В результате модель не только учится решать набор обучающих задач, но и развивает способность эффективно решать отдельные задачи, тем самым улучшая обобщение на неизвестные тестовые задачи.

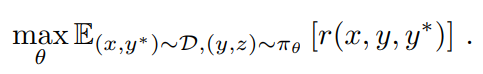

Поэтому мы рассматриваем модели обучения для генерации CoT, используя обучение с подкреплением (RL) (OpenAI 2024). Пусть r - модель вознаграждения, которая определяет правильность ответа y, предложенного на заданный вопрос x, на основе истинного ответа y*, присваивая значение r(x, y, y*) ∈ {0, 1}. Для проверяемых задач вознаграждение напрямую определяется заранее заданными критериями или правилами. Например, в задачах на кодирование мы оцениваем, прошел ли ответ тестовый пример. Для вопросов с истинными ответами в свободной форме мы обучаем модель вознаграждения r(x, y, y*), чтобы предсказать, соответствует ли ответ истинному ответу. Учитывая вопрос x, модель πθ генерирует CoT и окончательный ответ посредством процесса выборки z ~ πθ(-|x), y ~ πθ(-|x, z). Качество сгенерированного CoT зависит от того, может ли он давать правильные окончательные ответы. В целом, мы рассматриваем следующие цели для оптимизации стратегии

Расширяя обучение RL, мы стремимся обучить модель, которая использует преимущества как простого CoT на основе подсказок, так и CoT с расширенным планированием. Модель по-прежнему авторегрессивно сэмплирует лингвистические последовательности во время вывода, что позволяет избежать сложного распараллеливания, требуемого продвинутыми алгоритмами планирования во время развертывания. Однако ключевое отличие от простых подходов, основанных на подсказках, заключается в том, что модель должна не просто следовать ряду шагов умозаключения. Вместо этого она должна научиться ключевым навыкам планирования, включая выявление ошибок, откат назад и улучшение решения, используя весь набор исследованных мыслей в качестве контекстуальной информации.

2.3.2 Оптимизация стратегии

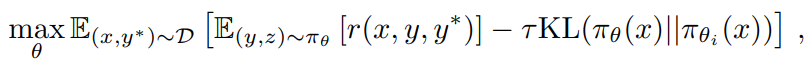

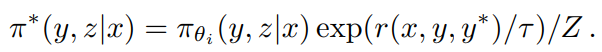

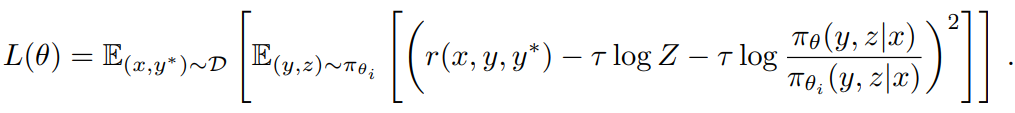

В качестве алгоритма обучения мы используем вариант зеркального спуска онлайн-стратегии (Abbasi-Yadkori et al. 2019; Mei et al. 2019; Tomar et al. 2020). Алгоритм выполняется итеративно. На i-й итерации мы используем текущую модель πθi в качестве эталонной модели и оптимизируем следующую задачу оптимизации политики регуляризации относительной энтропии.

где τ > 0 - параметр, управляющий степенью регуляризации. Эта задача имеет решение в замкнутой форме

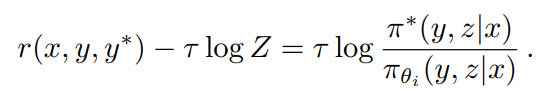

где Z = Σy',z' πθi (y', z'|x) exp(r(x, y', y*)/τ) - коэффициент нормализации. Взяв логарифм обеих сторон, мы получим, что для любого (y, z) выполняются следующие ограничения, что позволяет нам использовать данные автономной политики при оптимизации

Это привело к следующим потерям при замене

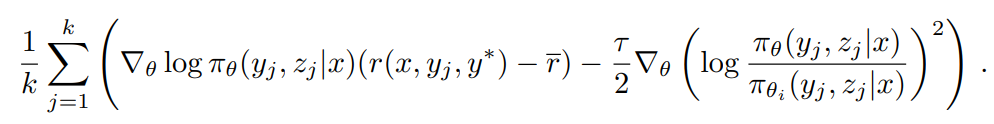

Для аппроксимации τ log Z мы используем выборки (y1, z1), ... , (yk, zk) ~ πθ: τ log Z ≈ log 1/k Σ^k_j=1 exp(r(x, yj, y*)/τ). Мы также обнаружили, что использование эмпирического среднего значения вознаграждения за выборку τ = mean(r(x, y1, y*), ... , r(x, yk, y*)) дает достоверные практические результаты. Это разумно, поскольку с ростом τ → ∞ τ log Z приближается к ожидаемому вознаграждению при πθi . Наконец, мы выводим наш алгоритм обучения, используя градиент потерь на подстановку. Для каждой задачи x выбирается k ответов с использованием эталонной политики πθi , и градиент определяется следующим образом

Для тех, кто знаком с методами градиента стратегии, этот градиент похож на градиент стратегии из (2), в котором в качестве базовой линии используется среднее значение выборочных вознаграждений (Kool et al. 2019; Ahmadian et al. 2024). Основное отличие заключается в том, что ответ сэмплируется из πθi, а не из онлайн-стратегии, и применяется регуляризация l2. Таким образом, мы можем рассматривать это как естественное расширение обычного градиентного алгоритма онлайн-регуляризованной политики на случай автономной политики (Nachum et al. 2017). Мы выбираем партию задач из D и обновляем параметр до θi+1 , который впоследствии используется в качестве эталонной политики для следующей итерации. Мы также перезагружаем оптимизатор в начале каждой итерации, поскольку каждая итерация рассматривает другую оптимизационную задачу из-за изменения эталонной стратегии.

Мы исключили сеть ценностей из системы обучения, которая также использовалась в предыдущем исследовании (Ahmadian et al. 2024). Хотя этот выбор дизайна значительно повышает эффективность обучения, мы также предполагаем, что традиционное использование функций ценности для распределения кредитов в классической RL может не подходить для нашего контекста. Рассмотрим ситуацию, когда модель генерирует частичный CoT (z1, z2, ... , zt) и имеет два потенциальных следующих шага вывода: zt+1 и z't+1. Предположим, что zt+1 приводит непосредственно к правильному ответу, а z't+1 содержит некоторые ошибки. Если бы функция ценности оракула была доступна, она бы показала, что zt+1 сохраняет более высокую ценность, чем z't+1. Согласно стандартным принципам распределения кредитов, выбор z't+1 был бы наказан, поскольку он имеет отрицательное преимущество по сравнению с текущей стратегией. Однако изучение z't+1 ценно для обучения модели генерировать длинные CoT. Используя обоснование окончательного ответа, полученного из длинного CoT, в качестве сигнала вознаграждения, модель может учиться на модели проб и ошибок, принимая z't+1 до тех пор, пока она успешно восстанавливается и приходит к правильному ответу. Главный вывод, который можно сделать из этого примера, заключается в том, что мы должны поощрять модель исследовать различные пути рассуждений, чтобы повысить ее способность решать сложные проблемы. Такой исследовательский подход позволяет накопить большой опыт, который способствует развитию важнейших навыков планирования. Вместо того чтобы повышать точность решения учебных задач до максимального уровня, наша главная цель - вооружить модель эффективными стратегиями решения проблем, что в конечном итоге улучшит ее работу на тестовых задачах.

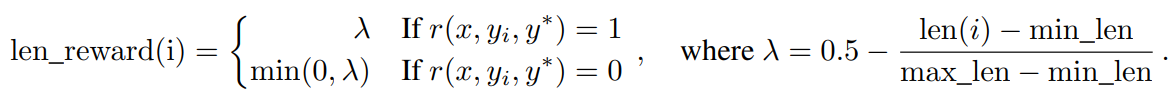

2.3.3 Штрафы за длину

Мы наблюдаем феномен чрезмерной задумчивости, когда длина ответа модели значительно увеличивается в процессе обучения RL. Хотя это приводит к улучшению производительности, слишком длинные процессы рассуждений требуют больших затрат во время обучения и вывода, а люди обычно не любят излишних размышлений. Для решения этой проблемы мы вводим бонус длины, чтобы ограничить быстрый рост длины токена и тем самым повысить эффективность модели. Учитывая k выборочных ответов (y1, z1) для задачи x, ... , (yk, zk) и истинный ответ y*, пусть len(i) - это длина (yi, zi), min_len = min_i len(i) и max_len = max_i len(i). Если max_len = min_len, мы устанавливаем бонус длины равным нулю для всех ответов, поскольку они имеют одинаковую длину. В противном случае бонус длины определяется следующим образом

По сути, мы поощряем более короткие ответы и наказываем более длинные ответы в правильных ответах, в то же время явно наказывая более длинные ответы в неправильных ответах. Эта награда, основанная на длине и параметрах веса, затем добавляется к исходной награде.

В наших предварительных экспериментах штраф за длину может замедлить начальный этап обучения. Чтобы смягчить эту проблему, мы предлагаем постепенно увеличивать штраф за длину на начальном этапе обучения. В частности, мы оптимизируем стандартную стратегию без штрафа за длину, а затем применяем постоянный штраф за длину в течение оставшейся части обучения.

2.3.4 Стратегия отбора проб

Хотя сам алгоритм RL обладает относительно хорошими свойствами выборки (более трудные задачи дают большие градиенты), эффективность его обучения ограничена. Поэтому некоторые хорошо определенные априорные методы выборки могут дать больший прирост производительности. Мы используем несколько сигналов для дальнейшего улучшения стратегии выборки. Во-первых, обучающие данные RL, которые мы собираем, естественно, имеют различные метки сложности. Например, конкурсные задачи по математике сложнее, чем задачи по математике в начальной школе. Во-вторых, поскольку в процессе обучения RL одни и те же задачи выбираются несколько раз, мы можем отслеживать процент успешного решения каждой задачи как индикатор сложности. Мы предлагаем два метода выборки, чтобы использовать эти предварительные знания для повышения эффективности обучения.

Выборка курсов Сначала мы обучаемся на более простых задачах, а затем постепенно переходим к более сложным. Поскольку исходная RL-модель имеет ограниченную производительность, трата ограниченного вычислительного бюджета на решение очень сложных задач обычно дает мало правильных образцов, что приводит к снижению эффективности обучения. В то же время собираемые нами данные естественным образом содержат метки оценки и сложности, что делает выборку на основе сложности интуитивно понятным и эффективным способом повышения эффективности обучения.

приоритетный отбор проб В дополнение к выборке курса мы используем стратегию приоритетной выборки, чтобы сосредоточиться на проблемах с плохой производительностью модели. Мы отслеживаем коэффициент успешности si для каждой задачи i и выбираем задачи пропорционально 1/si, так что задачи с более низким коэффициентом успешности получают более высокую вероятность выборки. Это позволит направить усилия модели на самые слабые участки, что ускорит обучение и повысит общую производительность.

2.3.5 Более подробная информация о рецептах обучения

Генерация тестовых примеров для кодирования Поскольку для многих проблем кодирования в Интернете не существует тестовых примеров, мы разработали способ автоматической генерации тестовых примеров, которые можно использовать в качестве бонуса для обучения моделей с помощью RL. Наше внимание сосредоточено в основном на проблемах, которые не требуют специальных экспертов. Мы также предполагаем наличие реальных ответов на эти вопросы, чтобы использовать их для генерации более качественных тестовых примеров.

Мы расширяем наш подход с помощью широко известной библиотеки генерации тестовых примеров CYaRon¹. Мы используем нашу базу Kimi k1.5 для генерации тестовых примеров на основе формулировок задач. Инструкции по использованию CYaRon и описания задач служат в качестве входных данных для генератора. Для каждой проблемы мы сначала генерируем 50 тестовых примеров и случайным образом выбираем 10 реальных ответов для каждого тестового случая. Мы прогоняем тестовые примеры с полученными ответами. Тестовый пример считается правильным, если по крайней мере 10 из 7 представленных ответов совпадают. После этого раунда фильтрации мы получаем отобранный набор тестовых примеров. Если по крайней мере 10 из 9 представленных ответов проходят набор отобранных тестовых примеров, вопрос и связанные с ним отобранные тестовые примеры добавляются в наш обучающий набор.

По статистике, из выборки в 1 000 вопросов онлайн-конкурса примерно 614 вопросов не требовали специального судьи. Мы разработали 463 генератора тестовых примеров, которые выдали не менее 40 корректных тестовых примеров, в результате чего наш обучающий набор содержит 323 задачи.

Моделирование вознаграждения за занятия математикой Одна из проблем при оценке математических решений заключается в том, что один и тот же базовый ответ может быть записан в разных формах. Например, a² - 4 и (a + 2)(a - 2) могут быть правильными решениями. Мы использовали два подхода для повышения точности оценки модели вознаграждения:

- Классический RM: Вдохновляясь подходом InstructGPT (Ouyang et al. 2022), мы реализовали модель вознаграждения, основанную на ценности заголовка, и собрали около 800 000 точек данных для точной настройки. В конечном итоге модель принимает на вход "вопрос", "ссылку" и "ответ" и выдает скаляр, указывающий, является ли ответ правильным или нет.

- Chain of Thought RM: Недавние исследования (Ankner et al. 2024; McAleese et al. 2024) показали, что модели вознаграждения, дополненные рассуждениями по цепочке мышления (CoT), могут значительно превзойти классические подходы, особенно в задачах, требующих тонких критериев правильности (например, в математике). Поэтому для точной настройки модели Kimi мы собрали аналогичный по размеру набор данных из примерно 800 000 примеров с метками CoT. Основанный на тех же исходных данных, что и классический RM, подход "цепочки размышлений" явно генерирует пошаговые процессы вывода в формате JSON, а затем выдает окончательное суждение о правильности, что приводит к более надежному и интерпретируемому сигналу вознаграждения.

При ручной проверке точность классического РМ составила около 84,4, а точность РМ с цепочкой мыслей достигла 98,5. Во время обучения RL мы использовали РМ с цепочкой мыслей, чтобы обеспечить более корректную обратную связь.

Визуальные данные Чтобы улучшить возможности модели по выводу реальных изображений и добиться более эффективного согласования между визуальными данными и большими языковыми моделями (LLM), наши данные Visual Reinforcement Learning (Vision RL) взяты из трех различных категорий: реальные данные, синтетические данные визуального вывода и текстовые рендеринговые данные.

- Данные реального мира охватывают широкий спектр научных задач на всех уровнях обучения, требующих понимания графиков и рассуждений; задачи на угадывание локализации, требующие визуального восприятия и рассуждений; а также аналитические задачи, предполагающие понимание сложных диаграмм. Эти наборы данных улучшают способность модели выполнять визуальные рассуждения в реальных сценариях.

- Синтетические данные визуального мышления генерируются человеком и включают в себя изображения и сцены, созданные программами, разработанными для улучшения определенных навыков визуального мышления, таких как понимание пространственных отношений, геометрических моделей и взаимодействия объектов. Эти синтетические наборы данных обеспечивают контролируемую среду для тестирования способностей модели к визуальному рассуждению и предоставляют бесконечное количество обучающих примеров.

- Текстовые данные создаются путем преобразования текстового контента в визуальный формат, что позволяет модели сохранять согласованность при обработке текстовых запросов в различных модальностях. Преобразуя текстовые документы, фрагменты кода и структурированные данные в изображения, мы гарантируем, что модель будет выдавать последовательный ответ независимо от того, является ли входной текст обычным или преобразованным в изображение (например, скриншот или фотография). Это также помогает повысить способность модели обрабатывать изображения с большим объемом текста.

Каждый тип данных важен для создания комплексной модели визуального языка, способной эффективно управлять различными реальными приложениями и обеспечивать стабильную производительность в разных режимах ввода.

2.4 Long2short: сжатие контекста для моделей Short-CoT

Хотя модель long-CoT достигает высокой производительности, она потребляет больше тестового времени Token, чем стандартная модель short-CoT LLM. Однако априорные знания о мышлении в модели long-CoT могут быть перенесены в модель short-CoT для повышения производительности даже при ограниченном бюджете тестового времени Token. Мы предлагаем несколько подходов к решению этой проблемы long2short, включая объединение моделей (Yang et al., 2024), выборку кратчайших отклонений, DPO (Rafailov et al., 2024) и long2short RL. Подробное описание этих подходов приведено ниже:

Объединение моделей Оказалось, что объединение моделей помогает сохранить способность к обобщению. Мы также обнаружили, что при объединении длинных и коротких моделей Token повышается эффективность Token. Этот подход позволяет объединить длинные модели CoT с более короткими моделями, чтобы получить новые модели без обучения. В частности, мы объединяем две модели путем простого усреднения их весов.

Минимальный отбор проб Мы заметили, что наша модель генерирует ответы разной длины для одной и той же задачи. Исходя из этого, мы разработали метод выборки кратчайшего отклонения. Этот метод выбирает одну и ту же задачу n раз (в наших экспериментах n = 8) и отбирает самый короткий правильный ответ для контролируемой тонкой настройки.

DPO Подобно выборке кратчайших отказов, мы используем модель Long CoT для создания нескольких образцов ответов. Самое короткое правильное решение выбирается в качестве положительного образца, а более длинные ответы рассматриваются как отрицательные образцы, включая более длинный неправильный ответ и более длинный правильный ответ (в 1,5 раза длиннее, чем выбранный положительный образец). Эти положительные и отрицательные пары составляют парные данные предпочтений, используемые для обучения DPO.

Long2short RL После стандартного этапа обучения RL мы выбираем модель, обеспечивающую наилучший баланс между производительностью и эффективностью использования токенов, в качестве базовой модели и проводим отдельный этап обучения long2short RL. На втором этапе мы применяем штраф за длину, введенный в разделе 2.3.3, и значительно уменьшаем максимальную длину развертки, чтобы дополнительно наказать ответы, которые длиннее, чем требуется, но могут быть правильными.

2.5 Другие подробности обучения

2.5.1 Предварительное обучение

Базовая модель Kimi k1.5 обучена на разнообразном высококачественном мультимодальном корпусе. Лингвистические данные охватывают пять областей: английский, китайский, код, математические рассуждения и знания. Мультимодальные данные, включая субтитры, чередование изображений и текстов, OCR, знания и наборы данных QA, позволяют нашей модели приобрести визуальную лингвистическую компетенцию. Строгий контроль качества обеспечивает релевантность, разнообразие и сбалансированность всего набора данных для предварительного обучения. Предварительное обучение проводилось в три этапа: (1) визуально-лингвистическое предварительное обучение, в ходе которого была заложена прочная лингвистическая основа, а затем постепенная мультимодальная интеграция; (2) период охлаждения, в ходе которого использовались отобранные и синтетические данные для консолидации возможностей, особенно для задач вывода и знаний; и (3) длительная контекстная активация, в ходе которой обработка последовательности была расширена до 131 072 токенов. Более подробную информацию см. в Приложении B.

2.5.2 Тонкая настройка ванильного супервизора

Мы создали корпус ванильных SFT, охватывающий широкий спектр областей. Для задач, не связанных с рассуждениями, включая вопросы и ответы, письмо и обработку текста, мы изначально создали начальный набор данных путем ручного аннотирования. Этот набор данных используется для обучения посевных моделей. Затем мы собираем различные подсказки и используем посевную модель для создания нескольких ответов на каждую подсказку. Затем аннотатор ранжирует эти ответы и улучшает ответ, получивший наивысший рейтинг, для создания окончательной версии. Для задач рассуждения, таких как математические задачи и задачи кодирования, где проверка на основе моделирования правил и вознаграждений является более точной и эффективной, чем ручное суждение, мы расширяем набор данных SFT с помощью выборки отказов.

Наш ванильный набор данных SFT содержит около 1 миллиона текстовых примеров. В частности, 500 000 примеров для общих вопросов и ответов, 200 000 для кодирования, 200 000 для математики и науки, 5 000 для творческого письма и 20 000 для длинных контекстных задач, таких как подведение итогов, проверка документов, перевод и письмо. Кроме того, мы создали 1 миллион визуальных примеров текста, охватывающих различные категории, включая интерпретацию диаграмм, OCR, диалоги на основе изображений, визуальное кодирование, визуальные рассуждения и математические/научные задачи с наглядными пособиями.

Сначала мы обучаем модель в течение 1 эпохи при длине последовательности 32k Token, а затем обучаем ее в течение 1 эпохи при длине последовательности 128k Token. На первом этапе (32k) скорость обучения снижается с 2 × 10-5 до 2 × 10-6 , а затем снова увеличивается до 1 × 10-5 на втором этапе (128k), после чего окончательно снижается до 1 × 10-6 . Чтобы повысить эффективность обучения, мы упаковали несколько обучающих примеров в каждую обучающую последовательность.

2.6 Инфраструктура RL

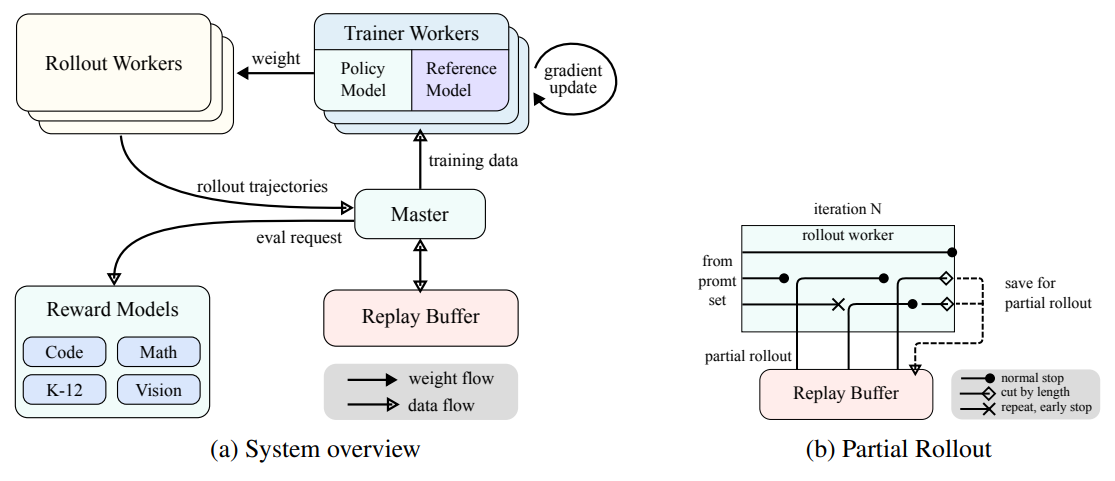

Рисунок 3: Крупномасштабная система обучения с подкреплением для LLM

(a) Обзор системы

(b) Частичное развертывание

2.6.1 Крупномасштабная система обучения с подкреплением для LLM

В области ИИ обучение с подкреплением (RL) стало ключевым методом обучения для больших языковых моделей (LLM) (Ouyang et al. 2022) (Jaech et al. 2024), черпая вдохновение из успеха в освоении сложных игр, таких как го, Starcraft II и Dota 2, с помощью таких систем, как AlphaGo (Silver et al. 2017), AlphaStar (Vinyals et al. 2019) и OpenAI Dota Five (Berner et al. 2019), а также другие системы. Следуя этой традиции, система Kimi k1.5 использует итеративно синхронизированный RL-фреймворк, который тщательно разработан для улучшения вывода модели путем постоянного обучения и адаптации. Ключевым нововведением в этой системе является внедрение техники частичного разворачивания, которая предназначена для оптимизации обработки сложных траекторий вывода.

Как показано на рис. 3а, система обучения RL работает по принципу итерационной синхронизации, где каждая итерация состоит из фазы развертывания и фазы обучения. Во время фазы развертывания рабочий, координируемый центральным главным сервером, генерирует траектории развертывания, взаимодействуя с моделью для создания последовательности реакций на различные входные данные. Эти траектории затем сохраняются в буфере воспроизведения, что обеспечивает разнообразный и непредвзятый набор обучающих данных за счет прерывания временной корреляции. На последующих этапах обучения учебная книга обращается к этому опыту для обновления весов модели. Этот циклический процесс позволяет модели постоянно учиться на своих операциях и со временем корректировать свою стратегию для повышения производительности.

Центральный мастер-сервер выполняет роль центрального командного пункта, управляя потоком данных и связью между рабочими процессами развертывания, рабочими процессами обучения, оценкой с помощью моделей вознаграждения и буферами воспроизведения. Он обеспечивает согласованную работу системы, балансирует нагрузку и способствует эффективной обработке данных.

Тренировочный процесс обращается к этим траекториям разворота, либо завершенным за одну итерацию, либо разделенным на несколько итераций, чтобы вычислить градиентные обновления, которые улучшают параметры модели и повышают ее производительность. Этот процесс контролируется моделью вознаграждения, которая оценивает качество выходных данных модели и обеспечивает необходимую обратную связь для управления процессом обучения. Оценка модели вознаграждения имеет решающее значение для определения эффективности стратегии модели и направления модели к оптимальной производительности.

Кроме того, система включает в себя сервис выполнения кода, который специально разработан для решения проблем, связанных с кодом, и является неотъемлемой частью модели вознаграждения. Этот сервис оценивает результаты работы модели в реальных сценариях кодирования, обеспечивая тесную связь обучения модели с реальными задачами программирования. Проверяя решение модели на реальном выполнении кода, этот цикл обратной связи необходим для улучшения стратегии модели и повышения ее эффективности в задачах, связанных с кодом.

2.6.2 Частичное развертывание для РЛ с длинным CoT

Одна из основных идей нашей работы заключается в расширении обучения RL в длинном контексте. Частичное выкатывание - это ключевая техника, которая эффективно решает проблему работы с длинными характеристиками CoT путем управления выкатыванием как для длинных, так и для коротких траекторий. Эта техника устанавливает фиксированный бюджет выходных лексем, который ограничивает длину каждой траектории выкатывания. Если траектория превышает лимит жетонов на этапе выкатывания, незавершенная часть сохраняется в буфере воспроизведения и продолжается на следующей итерации. Это гарантирует, что ни одна длинная траектория не будет монополизировать ресурсы системы. Кроме того, поскольку рабочие процессы развертывания выполняются асинхронно, пока одни рабочие процессы обрабатывают длинные траектории, другие могут независимо обрабатывать новые, более короткие задачи развертывания. Асинхронная работа повышает эффективность вычислений, обеспечивая активный вклад всех рабочих процессов разворачивания в процесс обучения, тем самым оптимизируя общую производительность системы.

Как показано на рисунке 3b, система частичного развертывания работает путем декомпозиции длинных ответов на фрагменты в течение итераций (от итерации n-m до итерации n). Буфер воспроизведения выступает в качестве центрального механизма хранения этих фрагментов ответа, где в режиме онлайн необходимо вычислять только текущую итерацию (итерация n). Предыдущие сегменты (итерации от n-m до n-1) могут быть эффективно повторно использованы из буфера, что устраняет необходимость в повторном развертывании. Такой сегментированный подход значительно снижает вычислительные затраты: вместо того чтобы развертывать весь ответ сразу, система обрабатывает и сохраняет сегменты постепенно, что позволяет генерировать более длинные ответы при сохранении быстрого времени итерации. Во время обучения определенные сегменты могут быть исключены из расчета потерь для дальнейшей оптимизации процесса обучения, что делает систему в целом эффективной и масштабируемой.

Реализация частичного развертывания также обеспечивает обнаружение дубликатов. Система выявляет дублирующие последовательности в генерируемом контенте и прерывает их на ранней стадии, сокращая таким образом ненужные вычисления при сохранении качества выходных данных. Обнаруженным дубликатам могут быть назначены дополнительные штрафы, что позволяет эффективно предотвратить генерацию избыточного контента в наборе реплик.

2.6.3 Гибридное развертывание обучения и рассуждений

Процесс обучения RL состоит из следующих этапов:

Рисунок 4: Схема гибридного развертывания

- этап обучения: Во-первых, Мегатрон (Shoeybi et al. 2020) и vLLM (Kwon et al. 2023) выполняются в отдельных контейнерах, инкапсулированных процессами shim, называемыми движками контрольных точек (раздел 2.6.3). megatron начинает процесс обучения. После завершения обучения Megatron выгружает память GPU и готовится к передаче текущих весов в vLLM.

- этап вывода: После выгрузки Megatron vLLM запускается с весами виртуальной модели и обновляет их последними весами, переданными из Megatron через Mooncake (Qin et al. 2024). После завершения развертывания механизм контрольной точки останавливает все процессы vLLM.

- Последующий этап обучения: Как только память, выделенная vLLM, будет освобождена, Мегатрон выгрузит ее и начнет новый раунд обучения.

Мы столкнулись с проблемой одновременной поддержки всех перечисленных ниже функций в рамках существующей работы.

- Сложные параллельные стратегии: Megatron может иметь другую стратегию параллелизма, чем vLLM. Обучающие веса, распределенные по нескольким узлам в Megatron, может быть трудно разделить с vLLM.

- Минимизация незадействованных ресурсов GPU: В случае онлайн-политики RL последние работы (например, SGLang (L. Zheng et al. 2024) и VLLM) могут резервировать некоторые GPU во время обучения, что, в свою очередь, может привести к простаиванию графических процессоров для обучения.

- Динамическая масштабируемость: В некоторых случаях значительного ускорения можно добиться, увеличив количество узлов вывода при неизменном процессе обучения. Наша система может эффективно использовать необходимое количество свободных узлов GPU.

Как показано на рисунке 4, мы реализовали этот гибридный фреймворк развертывания поверх Megatron и vLLM (раздел 2.6.3), в результате чего фаза перехода от обучения к рассуждениям заняла менее минуты, а обратная фаза - около 10 секунд.

Стратегия гибридного развертывания Мы предлагаем гибридную стратегию развертывания для задач обучения и вывода, которая использует контейнеры Kubernetes Sidecar для совместного использования всех доступных GPU, чтобы объединить обе рабочие нагрузки в одной капсуле. Основными преимуществами этой стратегии являются:

- Это способствует эффективному распределению и управлению ресурсами и предотвращает простаивание обучающих узлов в ожидании узлов вывода (когда они развернуты на разных узлах).

- Используя различные изображения для развертывания, обучение и вывод можно проводить независимо друг от друга для повышения эффективности.

- Архитектура не ограничивается vLLM, и другие фреймворки могут быть легко интегрированы.

контрольно-пропускной пункт Механизм контрольных точек отвечает за управление жизненным циклом процесса vLLM, предоставляя HTTP API, которые запускают различные операции над vLLM. Для обеспечения общей согласованности и надежности мы используем глобальную систему метаданных, управляемую сервисом etcd, для трансляции операций и состояния.

Когда vLLM деинсталлируется, бывает сложно полностью освободить память GPU, в основном из-за графиков CUDA, буферов NCCL и драйверов NVIDIA. Чтобы минимизировать модификации vLLM, мы завершаем и перезапускаем его по мере необходимости для повышения эффективности использования GPU и отказоустойчивости.

Обходной путь в Megatron преобразует принадлежащие контрольные точки в формат Hugging Face в общей памяти. Это преобразование также учитывает параллелизм конвейеров и экспертный параллелизм, так что в этих контрольных точках сохраняется только тензорный параллелизм. Затем контрольные точки в общей памяти фрагментируются и регистрируются в глобальной системе метаданных. Мы используем Mooncake для передачи контрольных точек между одноранговыми узлами через RDMA. Для загрузки файла весов и выполнения тензорно-параллельного преобразования требуются некоторые модификации vLLM.

Мы разработали "песочницу" как безопасную среду для выполнения представленного пользователем кода, оптимизированную для выполнения кода и бенчмаркинга кода. Благодаря динамическому переключению образов контейнеров песочница поддерживает различные сценарии использования с помощью MultiPL-E (Cassano, Gouwar, D. Nguyen, S. Nguyen, et al. 2023), DMOJ Judge Server², Lean, Jupyter Notebook и других образов.

Для RL в задачах кодирования Sandbox обеспечивает надежность суждений по тренировочным данным, предоставляя последовательный и повторяемый механизм оценки. Система обратной связи поддерживает многоступенчатые оценки, такие как обратная связь при выполнении кода и редактирование на уровне репозитория, сохраняя при этом единый контекст для обеспечения справедливого и беспристрастного сравнения эталонов на разных языках программирования.

Мы развернули сервис на Kubernetes для масштабируемости и эластичности, открыв его через конечную точку HTTP для внешней интеграции. Такие функции Kubernetes, как автоматический перезапуск и скользящие обновления, обеспечивают доступность и отказоустойчивость.

Для оптимизации производительности и поддержки сред RL мы интегрировали несколько технологий в наши сервисы выполнения кода, чтобы повысить эффективность, скорость и надежность. К ним относятся:

- Использование Crun: Мы используем crun в качестве среды выполнения контейнеров вместо Docker, что значительно сокращает время запуска контейнеров.

- Повторное использование группы Cgroup: Мы предварительно создаем cgroups для использования контейнерами, что очень важно в высококонкурентных сценариях, где создание и уничтожение cgroups для каждого контейнера может стать узким местом.

- Оптимизация использования диска: Высокоскоростное пространство хранения фиксированного размера обеспечивается за счет использования оверлейной файловой системы, смонтированной как tmpfs, для контроля записи на диск. Такой подход благоприятствует временным рабочим нагрузкам.

Эти оптимизации повышают эффективность RL при выполнении кода, обеспечивая тем самым стабильно надежную среду для оценки сгенерированного RL кода, что необходимо для итеративного обучения и улучшения модели.

3 эксперимента

3.1 Оценка

Поскольку k1.5 является мультимодальной моделью, мы провели комплексную оценку различных режимов на различных эталонных тестах. Подробную схему оценки можно найти в Приложении C. Наши эталонные тесты состоят из следующих трех основных категорий:

- Сравнительный анализ текстов: MMLU (Hendrycks et al., 2020), IF-Eval (J. Zhou et al., 2023), CLUEWSC (L. Xu et al., 2020), C-EVAL (Y. Huang et al., 2023).

- Бенчмаркинг рассуждений: HumanEval-Mul, LiveCodeBench (Jain et al. 2024), Codeforces, AIME 2024, MATH-500 (Lightman et al. 2023)

- Визуальный бенчмаркинг: MMMU (Yue, Ni, et al. 2024), MATH-Vision (K. Wang et al. 2024), MathVista (Lu et al. 2023).

3.2 Основные результаты

Модель K1.5 long-CoT Производительность модели Kimi k1.5 long-CoT показана в таблице 2. Способность модели к долгосрочным выводам значительно повышается благодаря точной настройке под надзором Long-CoT (описанной в разделе 2.2) и совместному обучению с визуальным текстом (рассмотренному в разделе 2.3). Вычислительные расширения в тестовое время еще больше повышают ее производительность, позволяя модели достигать передовых результатов в различных модальностях. Наша оценка показывает значительное улучшение способности модели рассуждать, понимать и синтезировать информацию в расширенных контекстах, что представляет собой прогресс в возможностях мультимодального ИИ.

K1.5 модель короткого КоТ Производительность модели Kimi k1.5 short-CoT показана в таблице 3. Эта модель объединяет в себе различные методы, включая традиционную контролируемую тонкую настройку (рассмотренную в разделе 2.5.2), обучение с подкреплением (рассмотренное в разделе 2.3) и уточнение от длинного к короткому (описанное в разделе 2.4). Результаты показывают, что модель k1.5 short-CoT обеспечивает конкурентоспособную или превосходящую производительность в ряде задач по сравнению с ведущими моделями с открытым исходным кодом и проприетарными моделями. В их число входят текстовые, визуальные и логические задачи, причем значительные преимущества наблюдаются в понимании естественного языка, математике, кодировании и логических рассуждениях.

Таблица 2: Производительность Kimi k1.5 long-CoT и флагманских моделей с открытым исходным кодом и проприетарных моделей.

Таблица 3: Производительность Kimi k1.5 short-CoT и флагманских моделей с открытым исходным кодом и собственной разработки. Производительность модели VLM была получена с помощью бенчмаркинга OpenCompass (https://opencompass.org.cn/).

3.3 Расширение длинного контекста

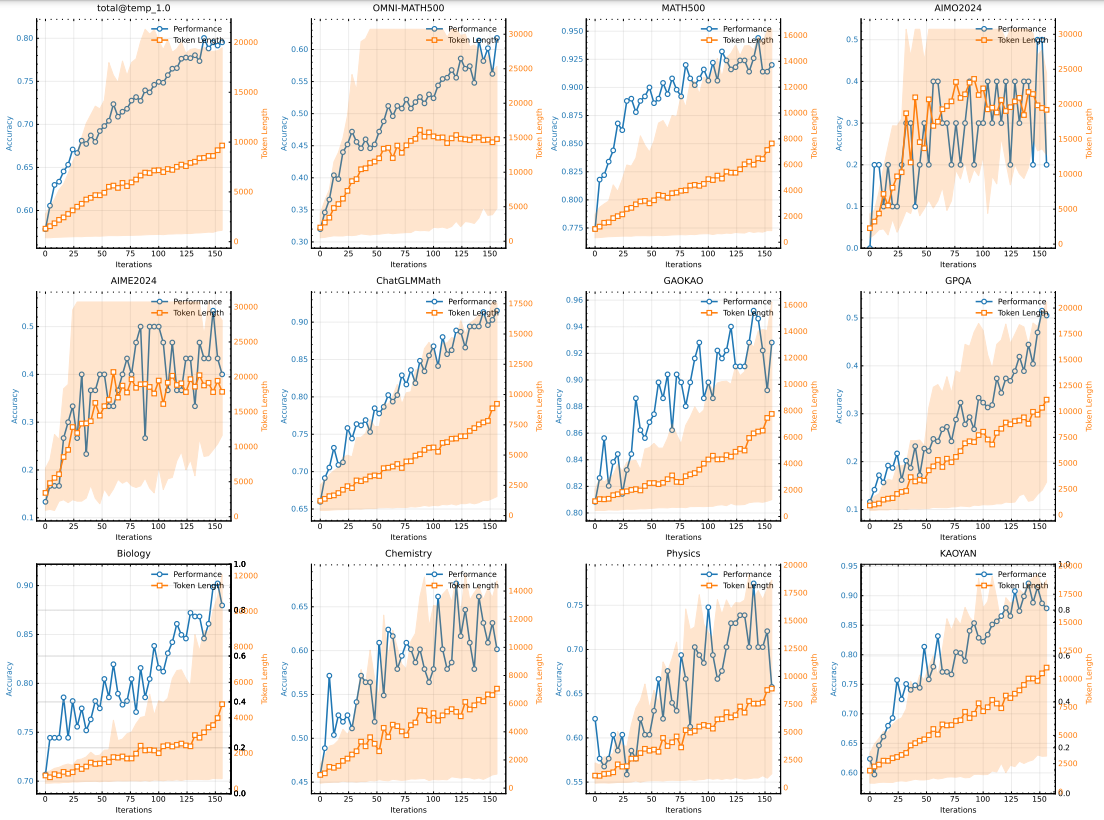

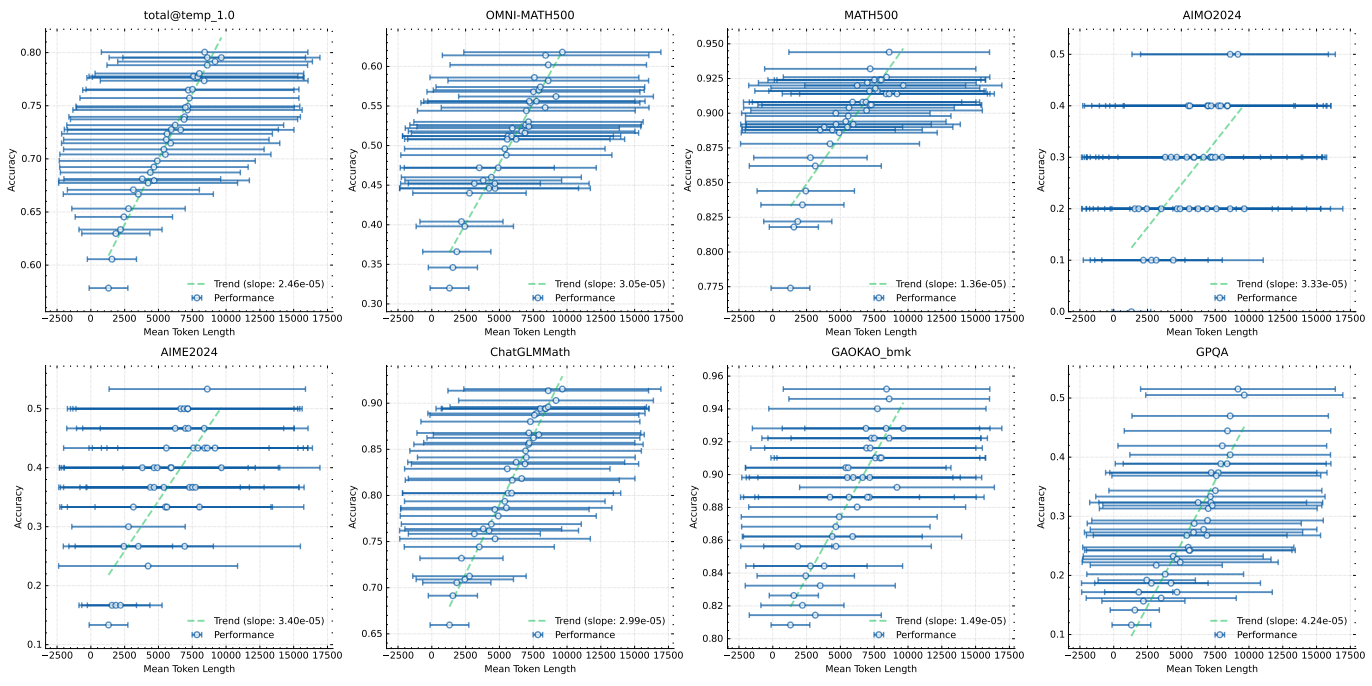

Мы используем модель среднего размера, чтобы исследовать расширенные свойства RL с LLM. На рисунке 5 показана эволюция точности обучения и длины ответа в течение итераций обучения для небольшого варианта модели, обученной на наборе математических подсказок. По мере обучения наблюдается одновременное увеличение длины ответа и точности выполнения. Примечательно, что длина ответа увеличивается быстрее для более сложных эталонных тестов, что говорит о том, что модель учится генерировать более подробные решения для сложных задач. На рисунке 6 показана сильная корреляция между длиной выходного контекста модели и ее способностью решать задачи. В последнем запуске k1.5 мы увеличили длину контекста до 128k и наблюдаем постоянное улучшение результатов в тестах с жесткими выводами.

Рисунок 5: Изменение точности и продолжительности обучения при увеличении числа итераций обучения. Обратите внимание, что приведенные выше оценки получены на основе внутренней модели long-cot, которая имеет гораздо меньший размер модели, чем модель k1.5 long-CoT. Заштрихованная область обозначает 95-й процентиль длины ответа.

3.4 Long2short

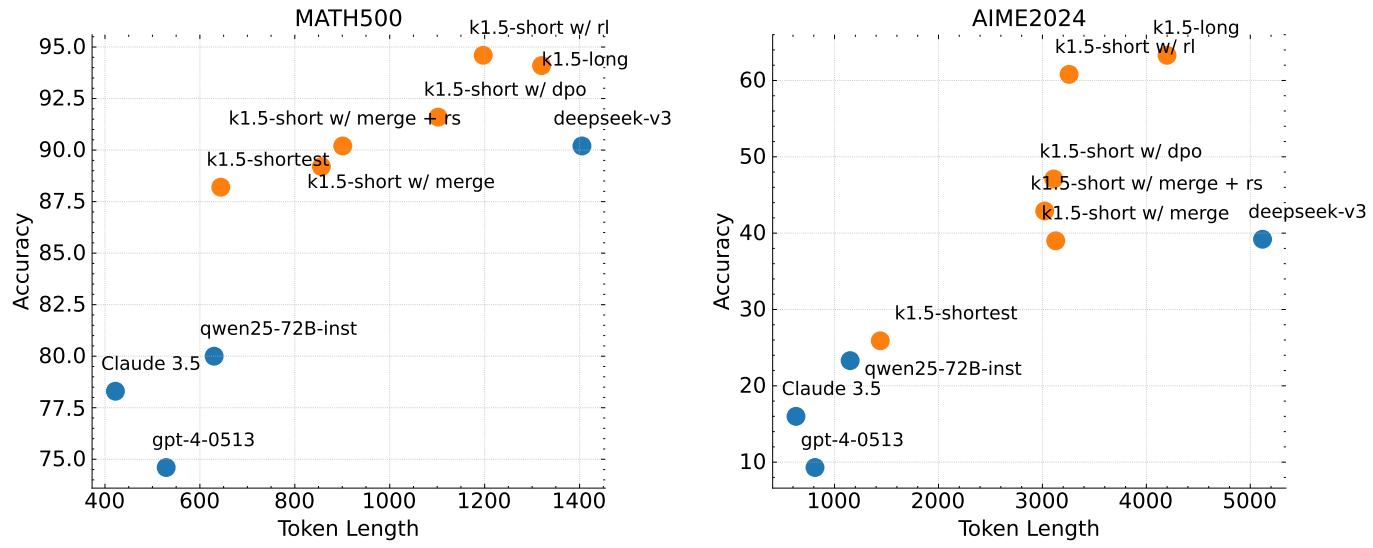

Мы сравниваем предложенный алгоритм long2short RL с методами DPO, выборки кратчайших отклонений и слияния моделей, представленными в разделе 2.4, уделяя особое внимание эффективности Token для задачи long2short (X. Chen et al., 2024), и в частности тому, как сделать так, чтобы полученные модели long-cot приносили пользу моделям short. На рис. 7 k1.5-long обозначает модель long-cot, которую мы выбираем для обучения long2short. k1.5-short w/ rl обозначает короткую модель, полученную с помощью обучения long2short RL. k1.5-short w/ dpo обозначает короткую модель, которая улучшает эффективность Token с помощью обучения DPO. k1.5-short w/ merge обозначает слияние моделей. k1.5-short w/ merge обозначает слияние моделей. k1.5-short w/ merge обозначает слияние моделей. k1.5-short w/ merge обозначает слияние моделей. k1.5-short w/ merge обозначает слияние моделей. short w/ merge обозначает модель после слияния моделей, а k1.5-short w/ merge + rs - короткую модель, полученную путем применения выборки кратчайших отклонений к объединенной модели. k1.5-shortest обозначает самую короткую модель, полученную в ходе обучения long2short. Как показано на рис. 7, предложенный алгоритм long2short RL демонстрирует самую высокую эффективность Token по сравнению с другими методами, такими как DPO и объединение моделей. Стоит отметить, что все модели семейства k1.5 (отмечены оранжевым цветом) демонстрируют лучшую эффективность Token по сравнению с другими моделями (отмечены синим цветом). Например, k1.5-short w/ rl достигает оценки Pass@1 60,8 на AIME2024 (в среднем за 8 прогонов), используя при этом в среднем 3 272 токена. k1.5-shortest также достигает оценки Pass@1 88,2 на MATH500, потребляя при этом примерно такое же количество токенов, как и другие короткие модели. модели.

Рисунок 6: Производительность модели улучшается с увеличением длины ответа

Рисунок 7: Производительность Long2Short. Все семейства k1.5 демонстрируют лучшую эффективность Token по сравнению с другими моделями.

3.5 Исследования абляции

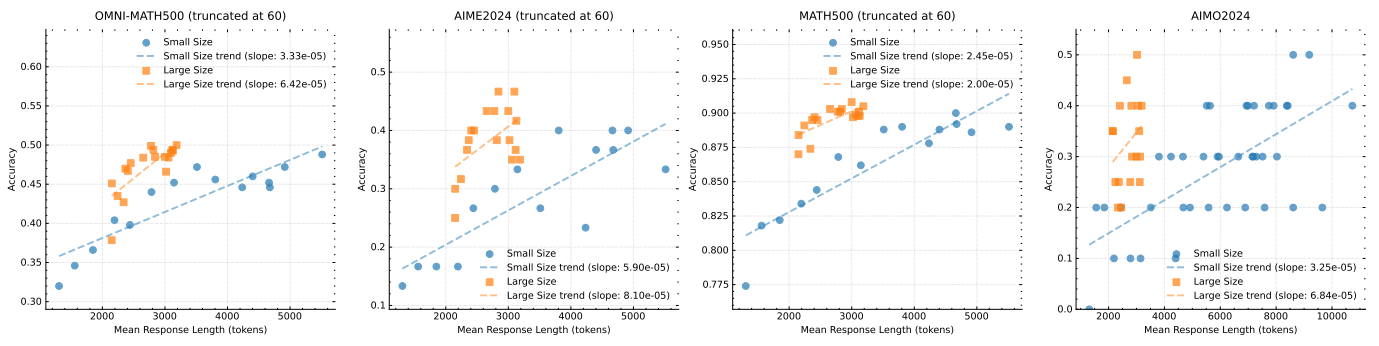

Расширение размера модели и длины контекста Наш основной вклад заключается в применении RL для повышения способности моделей генерировать расширенные CoT и, таким образом, улучшать их вывод. Естественно возникает вопрос: как это сопоставимо с простым увеличением размера модели? Чтобы продемонстрировать эффективность нашего подхода, мы обучили две модели разного размера на одном и том же наборе данных и записали результаты оценки и среднюю длину выводов на всех контрольных точках во время обучения RL. Эти результаты показаны на рис. 8. Стоит отметить, что хотя большая модель изначально превосходит меньшую, меньшая модель может достичь сопоставимой производительности, используя более длинный CoT, оптимизированный RL. Однако большие модели обычно демонстрируют лучшую эффективность Token, чем маленькие. Это также говорит о том, что если целью является достижение наилучшей возможной производительности, то увеличение длины контекста больших моделей имеет более высокую верхнюю границу и является более эффективным с точки зрения Token. Однако обучение меньших моделей с большей длиной контекста может быть приемлемым решением, если вычисления закладываются в бюджет на момент тестирования.

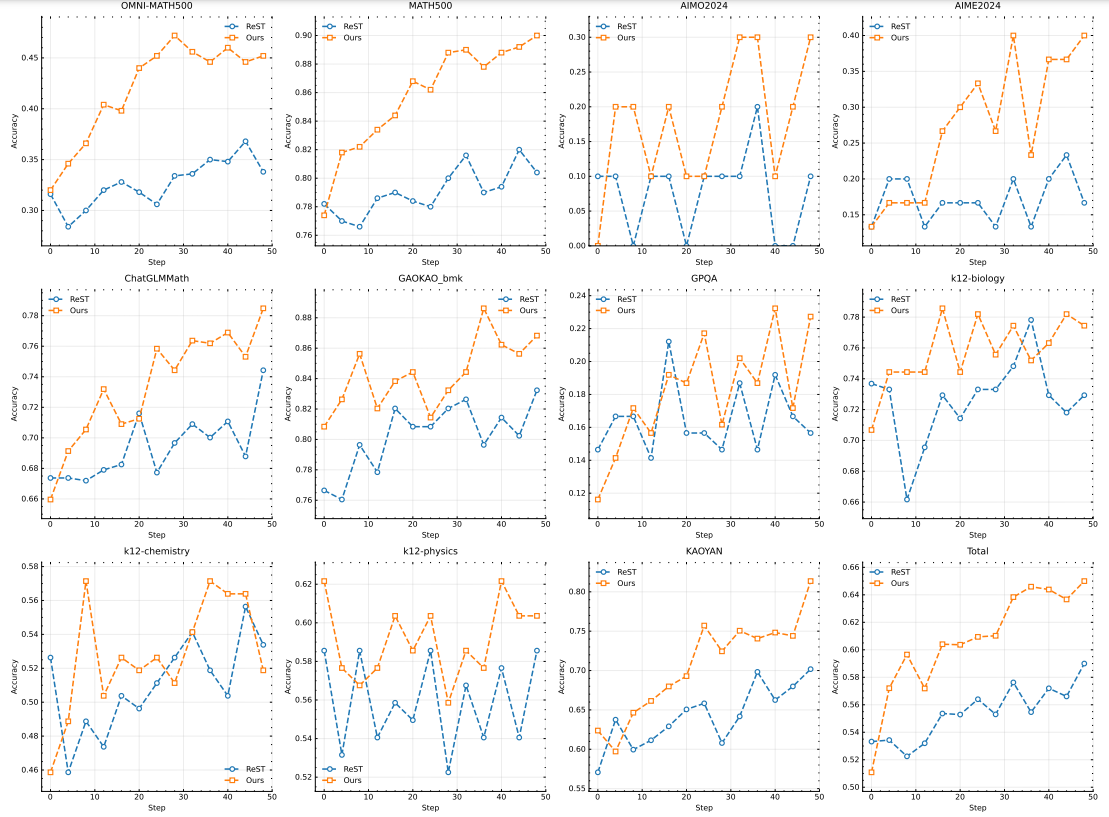

Эффект от использования отрицательных градиентов Мы исследуем эффективность использования ReST (Gulcehre et al., 2023) в качестве алгоритма оптимизации политики в нашей системе. Основное отличие ReST от других методов на основе RL, включая наш, заключается в том, что ReST итеративно улучшает модель путем подгонки лучшего ответа, отобранного из текущей модели, без применения отрицательного градиента для наказания неправильных ответов. Как показано на рис. 10, наш метод демонстрирует более высокую сложность выборки по сравнению с ReST, что говорит о том, что включение отрицательных градиентов значительно повышает эффективность модели при генерации длинных CoT. Наш подход не только улучшает качество выводов, но и оптимизирует процесс обучения, что приводит к надежной работе при использовании меньшего количества обучающих образцов. Этот вывод позволяет предположить, что выбор алгоритма оптимизации стратегии имеет решающее значение в наших условиях, поскольку в других областях разрыв в производительности между ReST и другими методами на основе RL не так сильно выражен, как в (Gulcehre et al. 2023). Таким образом, наши результаты подчеркивают важность выбора подходящей стратегии оптимизации для максимизации эффективности генерации длинных CoT.

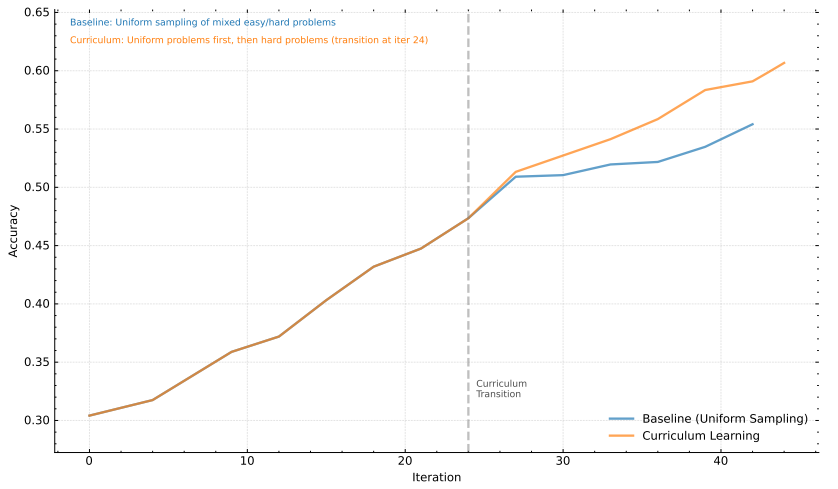

стратегия отбора проб Далее мы демонстрируем эффективность стратегии выборки курсов, представленной в разделе 2.3.4. Наш обучающий набор данных D содержит задачи разного уровня сложности. Используя наш подход к выборке курса, мы сначала используем D для разминки, а затем обучаем модель, фокусируясь только на трудных задачах. Этот метод сравнивается с базовым методом, который использует равномерную стратегию выборки без какой-либо настройки курса. Как показано на рис. 9, наши результаты наглядно демонстрируют, что предложенный подход к выборке курса значительно повышает производительность. Это улучшение можно объяснить тем, что метод постепенно ставит перед моделью сложные задачи, позволяя ей лучше понимать и справляться со сложными проблемами. Направляя усилия по обучению на решение более сложных задач после первоначального обобщения, модель может лучше укрепить свои способности к рассуждению и решению проблем.

Рисунок 8: Зависимость производительности модели от длины ответа для разных размеров модели

Рисунок 9: Анализ подхода к обучению в рамках курса к производительности модели.

4 Заключение

Мы представляем рецепт обучения и дизайн системы для k1.5, нашего последнего мультимодального LLM, обученного с помощью RL. Один из ключевых выводов, который мы сделали из практики, заключается в том, что масштабирование длины контекста имеет решающее значение для непрерывного совершенствования LLM. Мы используем оптимизированные алгоритмы обучения и оптимизацию инфраструктуры, такую как частичное развертывание, чтобы добиться эффективного обучения RL с длинным контекстом. Дальнейшее повышение эффективности и масштабируемости обучения РЛ с длинным контекстом остается важным направлением дальнейшей работы.

Рисунок 10: Сравнение оптимизации политики с помощью ReST.

Другой наш вклад заключается в объединении нескольких методов для улучшения оптимизации политики. В частности, мы сформулировали РЛ с длинным CoT, используя LLM, и вывели варианты зеркального спуска в режиме онлайн для надежной оптимизации. Мы также экспериментировали со стратегиями выборки, штрафами за длину и оптимальной формулировкой данных для достижения надежной работы RL.

Мы показываем, что даже без использования более сложных методов (например, древовидного поиска Монте-Карло, функций ценности и моделей вознаграждения процессов) можно добиться высокой производительности с помощью длинных контекстных расширений и улучшенной оптимизации политики. В будущем было бы также интересно исследовать, как улучшить распределение кредитов и уменьшить чрезмерную задумчивость без ущерба для исследовательских возможностей модели.

Мы также отметили потенциал методов long2short. Эти методы в значительной степени улучшают производительность модели short-CoT. Более того, методы long2short могут быть объединены с long-CoT RL итерационным способом для дальнейшего повышения эффективности Token и получения наилучшей производительности для заданного бюджета длины контекста.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие посты

Нет комментариев...