Bonsai: трехзначная взвешенная языковая модель, подходящая для работы с устройствами на границе

Общее введение

Bonsai - это языковая модель с открытым исходным кодом, разработанная deepgrove-ai, с размером параметров 500 миллионов, использующая тернарные веса. Она основана на архитектуре Llama и Мистраль Классификатор построен на основе линейного слоя, адаптированного для поддержки трехзначных весов. Для обучения модели использовались наборы данных DCLM-Pro и Fineweb-Edu общим объемом менее 5 миллиардов лексем. Несмотря на небольшой объем обучающих данных, Bonsai демонстрирует хорошие результаты и является одной из первых легких трехзначных моделей, достигших конкурентоспособного уровня. Пользователи могут вызывать ее через библиотеку Huggingface Transformers. Код проекта находится в открытом доступе на GitHub для разработчиков, изучающих эффективные модели ИИ.

Список функций

- Легкий вес и эффективная работа: Используется метод трехзначного взвешивания, а сама модель является небольшой, быстрой и подходит для устройств с низким ресурсом.

- создание естественного языка: Поддержка создания беглого текста, который можно использовать для диалога, вопросов и ответов и других заданий.

- открытый доступ: Полный код доступен на GitHub, что позволяет пользователям загружать, изменять и оптимизировать его.

- Совместимость с обнимающимся лицом: Бесшовная интеграция в библиотеку Transformers для легкой загрузки и развертывания.

- отличная производительность: Производительность, сопоставимая с аналогичными моделями при небольшом объеме обучающих данных.

Использование помощи

Процесс установки

Чтобы использовать Bonsai, необходимо сначала настроить среду выполнения. Ниже приведены подробные шаги:

- Проверка окружения Python

Убедитесь, что на вашем компьютере установлен Python 3.8 или выше. Введите в терминале:

python --version

Если у вас нет этой программы, вы можете загрузить ее с сайта Python.

- Установка библиотеки трансформеров

Bonsai опирается на библиотеку Transformers от Huggingface. Запустите ее в терминале:

pip install transformers

После установки используйте pip show transformers Подтвердите версию.

- Скачать модели бонсай

Модели размещены на сайте Huggingface. Рекомендуется загружать их автоматически с помощью кода (см. ниже), или их можно загрузить вручную. - Установите дополнительные зависимости

Если требуется тонкая настройка или ускорение, установитеtorchответить пениемdatasets::

pip install torch datasets

Как использовать

Бонсай вызывается с помощью скрипта Python. Вот основные шаги:

Загрузочные модели и разделители

Выполните следующий код в Python:

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("deepgrove/Bonsai", trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained("deepgrove/Bonsai", trust_remote_code=True)

Создать текст

Введите текст и получите результаты:

text = "中国的首都是哪里?"

inputs = tokenizer(text, return_tensors="pt")

outputs = model.generate(**inputs, max_length=100)

result = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(result)

Вывод может быть таким: "Столица Китая - Пекин". .

Параметры настройки

Параметры генерации могут быть изменены, например:

outputs = model.generate(**inputs, max_length=50, temperature=0.7)

max_length: Установите длину выходного сигнала.temperature: Управляет случайностью вывода, чем меньше значение, тем стабильнее.

Функциональное управление

эффективная работа

Благодаря трехзначному взвешиванию Bonsai хорошо работает с 16-битной точностью. При наличии графического процессора он может быть ускорен автоматически:

import torch

print(torch.cuda.is_available()) # 返回 True 表示 GPU 可用

GPU значительно увеличит производительность, но процессор будет работать просто отлично.

Оценка производительности

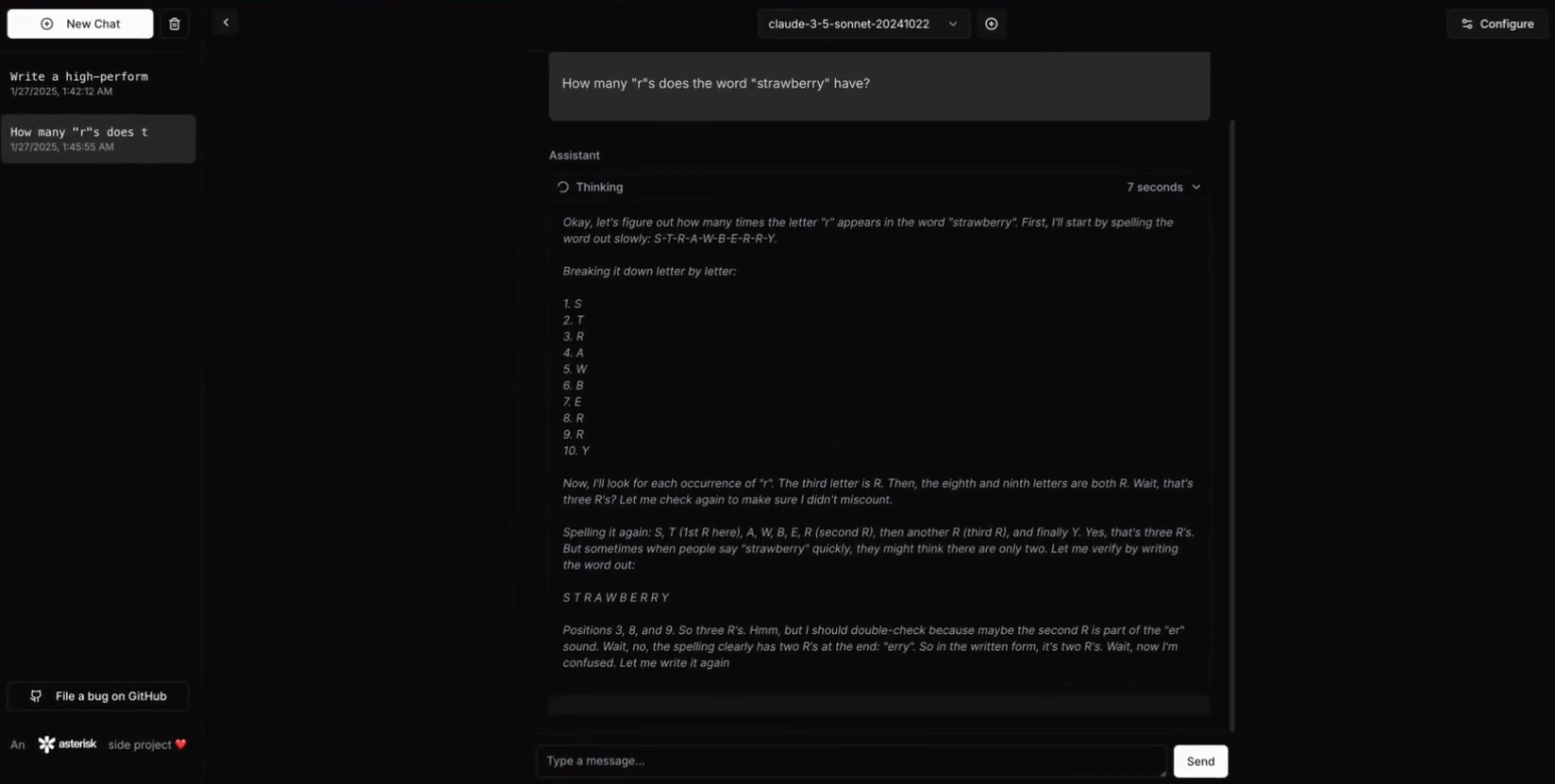

Bonsai демонстрирует отличные результаты в нескольких бенчмарках. Вот официальные данные:

| моделирование | ARC-c | ARC-e | HS. | OBQA | PiQA | Вино. | MMLU | средний балл |

|---|---|---|---|---|---|---|---|---|

| MobiLlama 0.5B | 26.62 | 46.68 | 51.66 | 30.00 | 71.65 | 54.50 | 28.61 | 44.25 |

| Квен 2 0.5B | 28.84 | 50.29 | 49.12 | 33.00 | 69.26 | 56.99 | 31.78 | 45.61 |

| MobileLLM 600M | 29.01 | 56.65 | 55.35 | 34.00 | 71.65 | 59.75 | 31.40 | 48.13 |

| Квен 2.5 0.5B | 32.25 | 58.29 | 52.18 | 35.40 | 69.91 | 56.12 | 33.40 | 48.22 |

| Бонсай | 33.36 | 57.95 | 48.04 | 34.00 | 70.24 | 54.85 | 30.28 | 46.96 |

| Эти тесты, включающие ARC, OBQA, MMLU и другие, показывают, что Bonsai входит в число лучших легких моделей. |

Тонкая настройка модели

Bonsai не настраивается для задач генерации общего назначения. Он может быть доработан, если его нужно оптимизировать для конкретных задач (например, викторины):

- Подготовьте данные: используйте текстовый файл или

datasetsЗагрузка библиотеки. - Параметры конфигурации: с

TrainingArgumentsУстановка. - Модели обучения:

from transformers import Trainer, TrainingArguments

training_args = TrainingArguments(

output_dir="./bonsai_finetuned",

num_train_epochs=3,

per_device_train_batch_size=4

)

trainer = Trainer(model=model, args=training_args, train_dataset=your_dataset)

trainer.train()

Подробнее см. Документация по обнимающимся лицам.

предостережение

- Пределы точности: В настоящее время поддерживаются операции только с 16-битной точностью, и команда разрабатывает поддержку смешанной точности.

- Необязательный тюнинг: Модель по умолчанию не подходит для непосредственного использования в сложных командных задачах и нуждается в тонкой настройке.

- требования к оборудованию: Обычные процессоры могут запустить его, GPU не требуется, но рекомендуется.

сценарий применения

- Учебные пособия

Бонсай может ответить на такие базовые вопросы, как "Какая столица Франции?". . Ответы генерируются быстро после ввода текста и подходят для обучения. - Приложения для краевых устройств

Модель легкая и подходит для установки на мобильные телефоны или встроенные устройства для локализованной обработки языка. - Моделирование исследований

Исследователи могут использовать его для проверки потенциала методов взвешивания трех значений и изучения эффективного дизайна моделей ИИ.

QA

- В чем заключаются основные преимущества Bonsai?

Он использует метод трехзначных весов для достижения легкого веса и высокой эффективности, с меньшим количеством обучающих данных, но высокой производительностью, подходящей для сценариев с ограниченными ресурсами. - Нужен графический процессор?

Для его запуска не требуется процессор, но GPU ускорит его. - Можно ли использовать его непосредственно для диалога?

Модель по умолчанию не требует настройки, поэтому перед использованием ее для конкретной задачи рекомендуется провести тонкую настройку.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...