Auto-Deep-Research: многоагентное взаимодействие для выполнения запросов к литературе и создания исследовательских отчетов

Общее введение

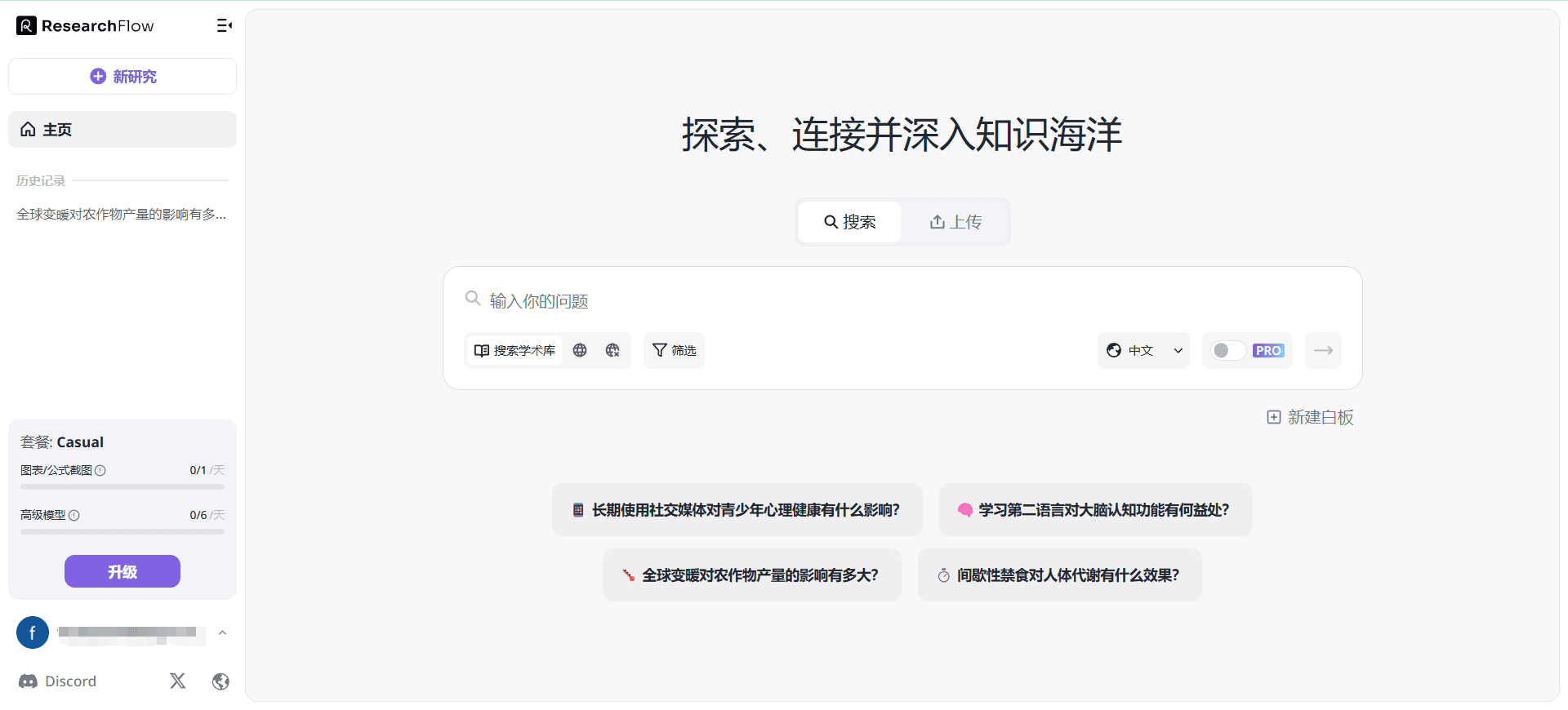

Auto-Deep-Research - это инструмент искусственного интеллекта с открытым исходным кодом, разработанный Лабораторией интеллектуальных данных Гонконгского университета (HKUDS), чтобы помочь пользователям автоматизировать задачи глубокого исследования. Он построен на базе фреймворка AutoAgent и поддерживает различные большие языковые модели (LLM), такие как OpenAI, Anthropic, Deepseek и Grok и т. д., способные обрабатывать сложные взаимодействия с файловыми данными и веб-поиск. В отличие от дорогостоящих инструментов, требующих подписки, таких как OpenAI's Deep Research, Auto-Deep-Research полностью бесплатен, и для его использования пользователям достаточно предоставить свой ключ LLM API. Известный своей высокой производительностью и гибкостью, инструмент показал отличные результаты в бенчмарках GAIA и подходит для исследователей, разработчиков и пользователей, которым нужно эффективное решение для исследований.

Список функций

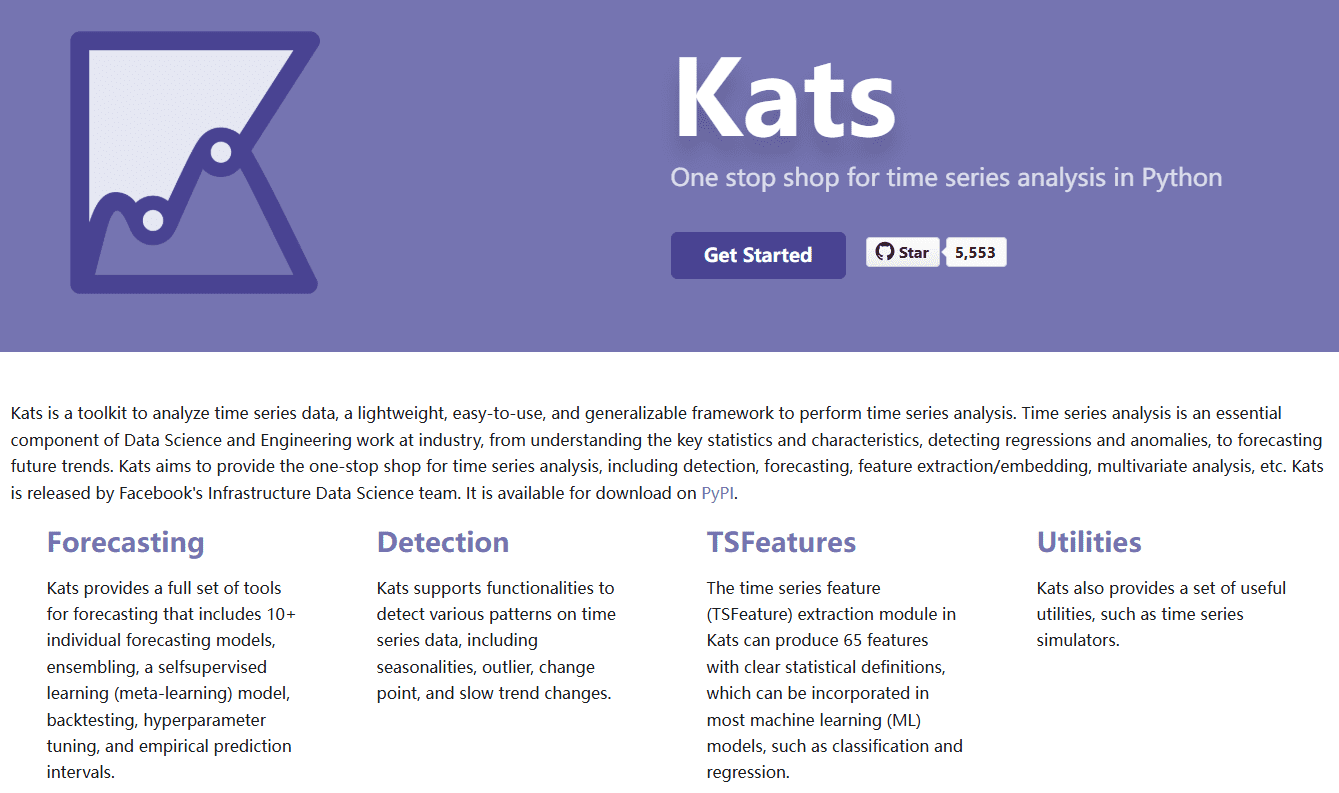

- Автоматизированные углубленные исследования: Автоматический поиск и сопоставление необходимой информации для создания подробных отчетов на основе тем, введенных пользователем.

- Поддержка нескольких моделей: Совместимость с различными крупными языковыми моделями, пользователи могут выбрать подходящую модель в соответствии со своими потребностями.

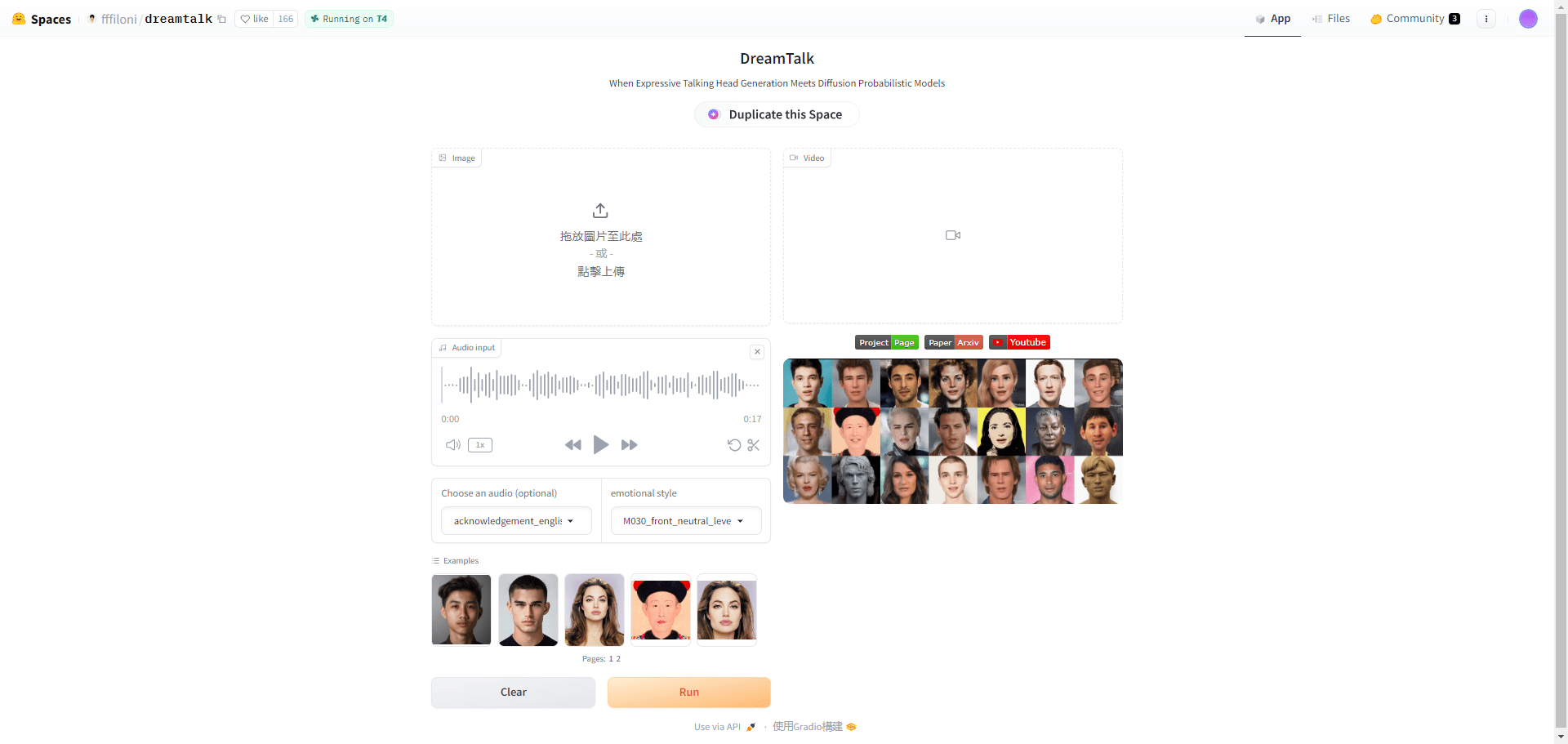

- Взаимодействие с файловыми данными: Поддержка загрузки и обработки изображений, PDF-файлов, текстовых файлов и т. д. для расширения источников данных для исследований.

- запуск одним нажатием: Нет необходимости в сложной настройке, введите простые команды, чтобы быстро приступить к работе.

- Возможность веб-поиска: Объедините веб-ресурсы и данные социальных сетей (например, Platform X), чтобы получить более полную информацию.

- С открытым исходным кодом и бесплатно: Предоставляется полный исходный код, чтобы пользователи могли настроить функциональность или развернуть в локальной среде.

Использование помощи

Процесс установки

Установка Auto-Deep-Research проста и интуитивно понятна и в значительной степени опирается на среды Python и Docker. Ниже приведены подробные шаги:

1. Подготовка окружающей среды

- Установка Python: Убедитесь, что в вашей системе установлен Python 3.10 или более поздней версии. Рекомендуемый

condaСоздайте виртуальную среду:conda create -n auto_deep_research python=3.10 conda activate auto_deep_research

- Установка Docker: Поскольку инструмент использует контейнерную среду выполнения Docker, пожалуйста, сначала скачайте и установите Docker Desktop, не нужно извлекать образы вручную, инструмент сделает это автоматически.

2. Загрузка исходного кода

- Клонируйте репозиторий GitHub локально:

git clone https://github.com/HKUDS/Auto-Deep-Research.git cd Auto-Deep-Research

3. Установка зависимостей

- Установите необходимые пакеты Python, выполнив следующую команду в каталоге проекта:

pip install -e .

4. Настройте ключ API

- В корневом каталоге проекта скопируйте файл шаблона и отредактируйте его:

cp .env.template .env - Откройте в текстовом редакторе

.envфайла, заполните API-ключ LLM, как требуется, например:OPENAI_API_KEY=your_openai_key DEEPSEEK_API_KEY=your_deepseek_key XAI_API_KEY=your_xai_keyПримечание: Не все ключи являются обязательными, просто настройте модель ключа, который вы планируете использовать.

5. инструменты для запуска

- Введите следующую команду, чтобы запустить Auto-Deep-Research:

auto deep-research - Необязательные конфигурации параметров, например, указание имени контейнера или модели:

auto deep-research --container_name myresearch --COMPLETION_MODEL grok

Основные функции

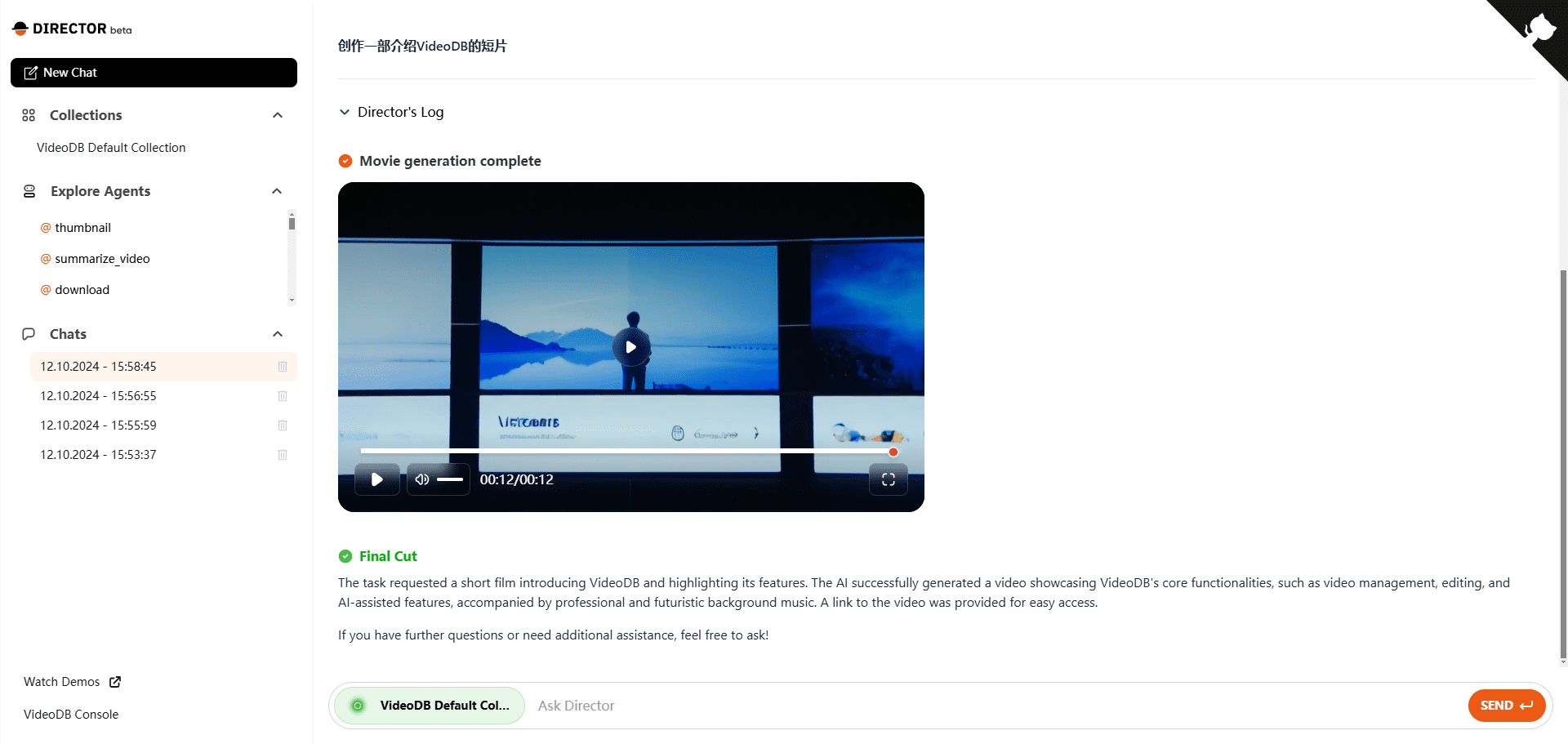

Автоматизированные углубленные исследования

- Укажите тему исследования: При запуске инструмент предлагает выбрать тему исследования, например "Искусственный интеллект в здравоохранении".

- автовыполнение: Инструмент анализирует релевантную информацию с помощью веб-поиска и встроенных моделей без вмешательства пользователя.

- Создание отчетов: По окончании работы результаты будут выведены на терминал в формате Markdown или сохранены в виде файла с исходным текстом и подробным анализом.

Взаимодействие с файловыми данными

- Загрузка файлов: Укажите путь к файлу в командной строке, например:

auto deep-research --file_path ./my_paper.pdf - Обработка данных: Инструмент анализирует PDF-файл, изображение или текст и включает их в исследование.

- комбинированный анализ: Данные загруженных файлов интегрированы с результатами веб-поиска для получения более полных выводов.

Выбор большой языковой модели

- Просмотр моделей поддержки: Поддержка OpenAI, Grok, Deepseek и т.д. Названия конкретных моделей см. в документации LiteLLM.

- Определение моделей: Добавьте параметры к команде запуска, например:

auto deep-research --COMPLETION_MODEL deepseek - эксплуатационное испытание: Настройте выбор для оптимизации работы с учетом производительности модели и отзывчивости API.

Основные функции

Запуск одним касанием

- Вместо того чтобы вручную настраивать образ Docker или сложные параметры, просто запустите

auto deep-researchИнструмент автоматически подберет необходимое окружение и запустит его. - Если требуется настройка, это можно сделать с помощью

--container_nameПараметрические именованные контейнеры для удобства управления несколькими экземплярами.

Веб-поиск и интеграция с социальными сетями

- В инструмент встроена функция веб-поиска, которая автоматически просматривает веб-контент. Если вы хотите включить данные с платформы X, вы можете указать ключевые слова в теме исследования, и инструмент попытается найти соответствующие сообщения.

- Например: введите "последние тенденции в исследованиях ИИ", и в результатах могут появиться ссылки на обсуждения и технологические блоги пользователей X.

предостережение

- Безопасность ключей API: Не ставьте

.envФайл загружается в публичное хранилище, чтобы избежать раскрытия ключа. - сетевое окружение: Убедитесь, что Docker и сетевые соединения работают правильно, так как это может повлиять на извлечение образа или функциональность поиска.

- оптимизация производительности: Если локальное оборудование ограничено, рекомендуется использовать облачный LLM, чтобы избежать запуска больших моделей, вызывающих задержки.

Выполнив эти действия, пользователи смогут легко начать работу с Auto-Deep-Research - инструментом, который обеспечивает эффективную поддержку как академических исследований, так и технических изысканий.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...