Audio-Reasoner: крупномасштабная языковая модель, поддерживающая глубокие аудио рассуждения

Общее введение

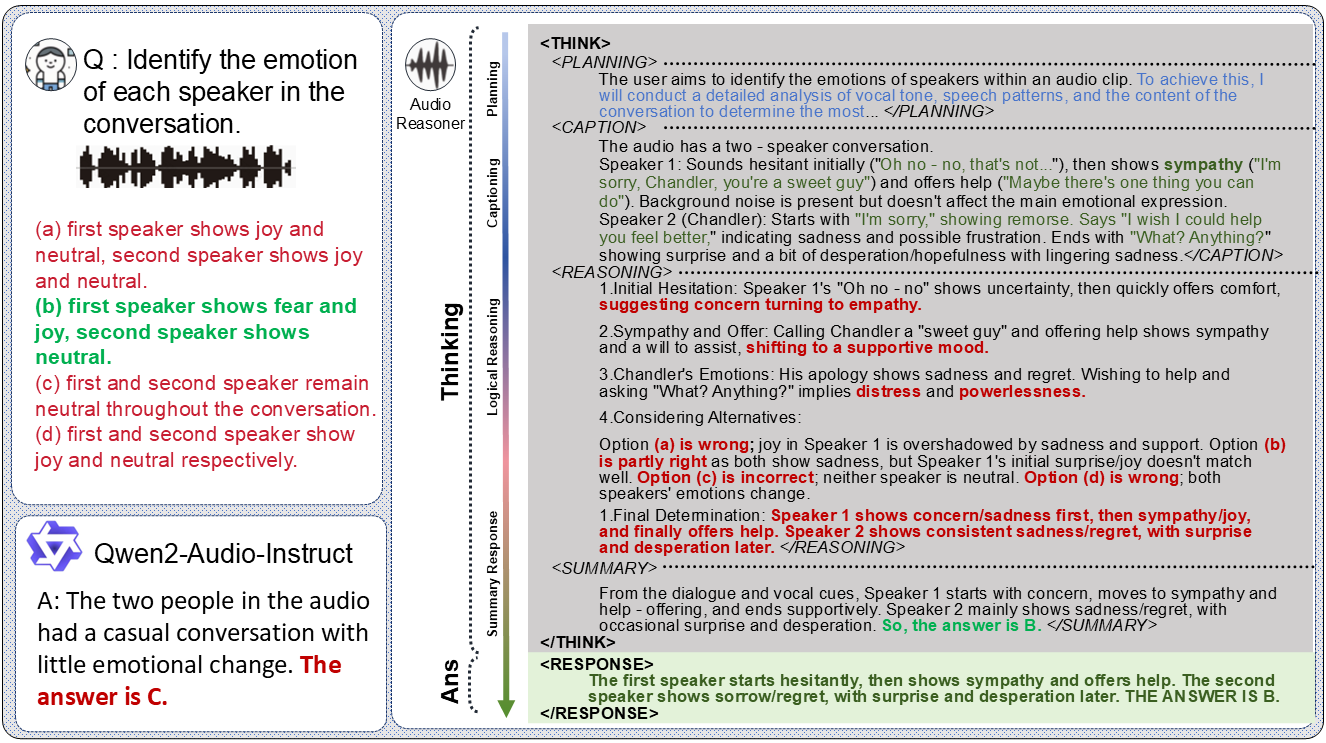

Audio-Reasoner - это проект с открытым исходным кодом, разработанный командой Университета Цинхуа и размещенный на GitHub. Он направлен на создание крупномасштабных языковых моделей, поддерживающих глубокие рассуждения в аудио. Модель основана на Qwen2-Audio-Instruct, которая обеспечивает сложные рассуждения и мультимодальное понимание аудиоконтента за счет внедрения структурированной технологии Chain-of-Thought (CoT). Проект включает модель Audio-Reasoner-7B и готовящийся набор данных CoTA (с 1,2 млн высококачественных образцов), который позволил добиться опережающего повышения производительности на 25,42% и 14,57% в бенчмарках MMAU-mini и AIR-Bench-Chat, соответственно.Audio-Reasoner Audio-Reasoner - идеальный инструмент для исследователей и разработчиков, поскольку он поддерживает обработку звука, музыки, голоса и других типов аудио, и подходит для аудиоанализа и сценариев понимания контента.

Список функций

- Глубокое осмысление аудио: Анализ аудиозаписей и создание подробных рассуждений и результатов с использованием структурированного цепного мышления.

- Мультимодальная поддержка задач: Объединение аудио- и текстовых данных для кросс-модальных задач понимания и рассуждения.

- Многократная обработка звука: Поддерживает распознавание и анализ нескольких типов аудио, таких как голос, музыка, речь и т.д.

- Высокопроизводительные предварительно обученные модели: Предоставляет модель Audio-Reasoner-7B, которая превосходит другие модели в нескольких эталонных тестах.

- Набор данных CoTA: Содержит 1,2 миллиона образцов для поддержки обучения структурированным выводам и расширения возможностей моделей.

- Код рассуждения и демонстрация: Предоставляет полный код выводов и демонстрационные примеры для тестирования и разработки.

- программа с открытым исходным кодом:: В будущем процесс синтеза данных и обучающий код будут открыты, чтобы облегчить сотрудничество с сообществом.

Использование помощи

Процесс установки

Установка Audio-Reasoner требует настройки среды Python и загрузки весов модели. Ниже приведены подробные шаги, которые позволят пользователям успешно завершить сборку:

1. Клонирование репозитория GitHub

Начните с локального клонирования проекта Audio-Reasoner. Откройте терминал и выполните следующую команду:

git clone https://github.com/xzf-thu/Audio-Reasoner.git

cd Audio-Reasoner

Это позволит загрузить файлы проекта локально в каталог проекта.

2. Создание и активация виртуальной среды

Чтобы избежать конфликтов зависимостей, рекомендуется создать отдельное окружение Python с помощью Conda:

conda create -n Audio-Reasoner python=3.10

conda activate Audio-Reasoner

Эта команда создает и активирует среду на базе Python 3.10 под названием "Audio-Reasoner".

3. Установка пакетов зависимостей

Проект предусматривает requirements.txt файл, содержащий необходимые зависимости. Установка выполняется следующим образом:

pip install -r requirements.txt

pip install transformers==4.48.0

Внимание:transformers Версия 4.48.0 должна быть установлена для обеспечения стабильной работы модели. Сначала установите другие зависимости, а затем укажите transformers версии, чтобы избежать конфликтов.

4. Загрузка весов модели

Модель Audio-Reasoner-7B была опубликована на HuggingFace, ее нужно скачать и настроить путь вручную:

- интервью HuggingFace Audio-Reasoner-7BЗагрузите файл модели.

- Вставьте загруженный путь контрольной точки в код в

last_model_checkpointпеременные, например:

last_model_checkpoint = "/path/to/Audio-Reasoner-7B"

Как использовать

После установки пользователь может запускать Audio-Reasoner через код для решения аудиозадач. Ниже приводится подробное руководство по эксплуатации:

Быстрый старт: запустите код примера

Проект содержит пример быстрого запуска, который поможет пользователям протестировать функциональность модели:

- Подготовка аудиофайлов

По умолчанию он использует собственныйassets/test.wavфайл, или вы можете заменить его своим собственным аудио в формате WAV. Убедитесь, что путь указан правильно. - Аудиодорожки и проблемы редактирования кода

показать (билет)inference.pyИли просто используйте следующий код для установки аудиодорожки и задавайте вопросы:audiopath = "assets/test.wav" prompt = "这段音频的节奏感和拍子是怎样的?" audioreasoner_gen(audiopath, prompt) - программа бега

Выполните его в терминале:conda activate Audio-Reasoner cd Audio-Reasoner python inference.pyМодель выводит структурированные результаты выводов, включая

<THINK>(планировать, описывать, рассуждать, обобщать) и<RESPONSE>(Окончательный ответ).

Основная функциональность: Audio Deep Reasoning

В основе Audio-Reasoner лежит аудиорассуждение, основанное на цепном мышлении, и вот как это работает:

- Входной звук и проблемы

- пользоваться

audioreasoner_genфункцию, передавая путь к аудио и конкретный вопрос. Пример:audiopath = "your_audio.wav" prompt = "音频中是否有鸟叫声?" audioreasoner_gen(audiopath, prompt)

- пользоваться

- Просмотр результатов вывода

Модель возвращает детальные процессы рассуждений, например:<THINK> <PLANNING>: 检查音频中的声音特征,识别是否有鸟叫声。 <CAPTION>: 音频包含自然环境音,可能有风声和动物叫声。 <REASONING>: 分析高频声音特征,与鸟类叫声模式匹配。 <SUMMARY>: 音频中可能存在鸟叫声。 </THINK> <RESPONSE>: 是的,音频中有鸟叫声。 - Настройка выходных параметров (опция)

Если требуется более длинный или гибкий ответ, его можно изменитьRequestConfigПараметры:request_config = RequestConfig(max_tokens=4096, temperature=0.5, stream=True)

Локальное тестирование заданных образцов

В проект встроены тестовые аудиозаписи и вопросы для быстрой проверки:

conda activate Audio-Reasoner

cd Audio-Reasoner

python inference.py

После запуска терминал отобразит описание assets/test.wav Результаты анализов подходят для первого опыта.

Особенность: Мультимодальное понимание

Audio-Reasoner поддерживает совместный анализ аудио и текста. Пример:

prompt = "这段音乐的情绪是否与‘悲伤’描述相符?"

audioreasoner_gen("sad_music.wav", prompt)

Модель объединяет особенности звука и семантику текста для вывода результатов.

Меры предосторожности и часто задаваемые вопросы

- аудиоформат: Рекомендуемый формат WAV, частота дискретизации 16 кГц, моно.

- медленно движущийся: Если он работает медленно, проверьте, включен ли GPU (требуется PyTorch для CUDA).

- Модель не отвечает: Убедитесь, что путь к модели правильный и что зависимости полностью установлены.

- Конфликт зависимостей: Если установка не удалась, попробуйте создать новое окружение и установить зависимости в строгом порядке.

Расширенное использование

- Пользовательская логика рассуждений:: Модификации

systemСлова-подсказки для корректировки стиля рассуждений модели. - пакетный файл:: Воля

max_batch_sizeУстановите большее значение (например, 128), чтобы поддерживать одновременное прослушивание нескольких звуков. - Объединение с набором данных CoTA: Будущие наборы данных CoTA могут быть использованы для дальнейшего обучения или тонкой настройки модели, когда они будут выпущены.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...