Snowflake выпускает многоязычную векторную модель Arctic Embed 2.0 для высококачественного поиска на китайском языке

Компания Snowflake рада сообщить о выпуске Arctic Embed L 2.0 ответить пением Arctic Embed M 2.0 которая является следующей итерацией нашей передовой модели встраивания, теперь может поддерживать многоязычный поиск. Несмотря на то, что наши предыдущие версии были хорошо приняты клиентами, партнерами и сообществом разработчиков открытого кода и получили миллионы загрузок, мы получали один запрос: можете ли вы сделать эту модель многоязычной? Arctic Embed 2.0 опирается на прочный фундамент наших предыдущих версий, добавляя многоязычную поддержку без ущерба для англоязычной производительности или масштабируемости, чтобы удовлетворить потребности более широкого сообщества пользователей. сообщества, которое охватывает широкий спектр языков и приложений.

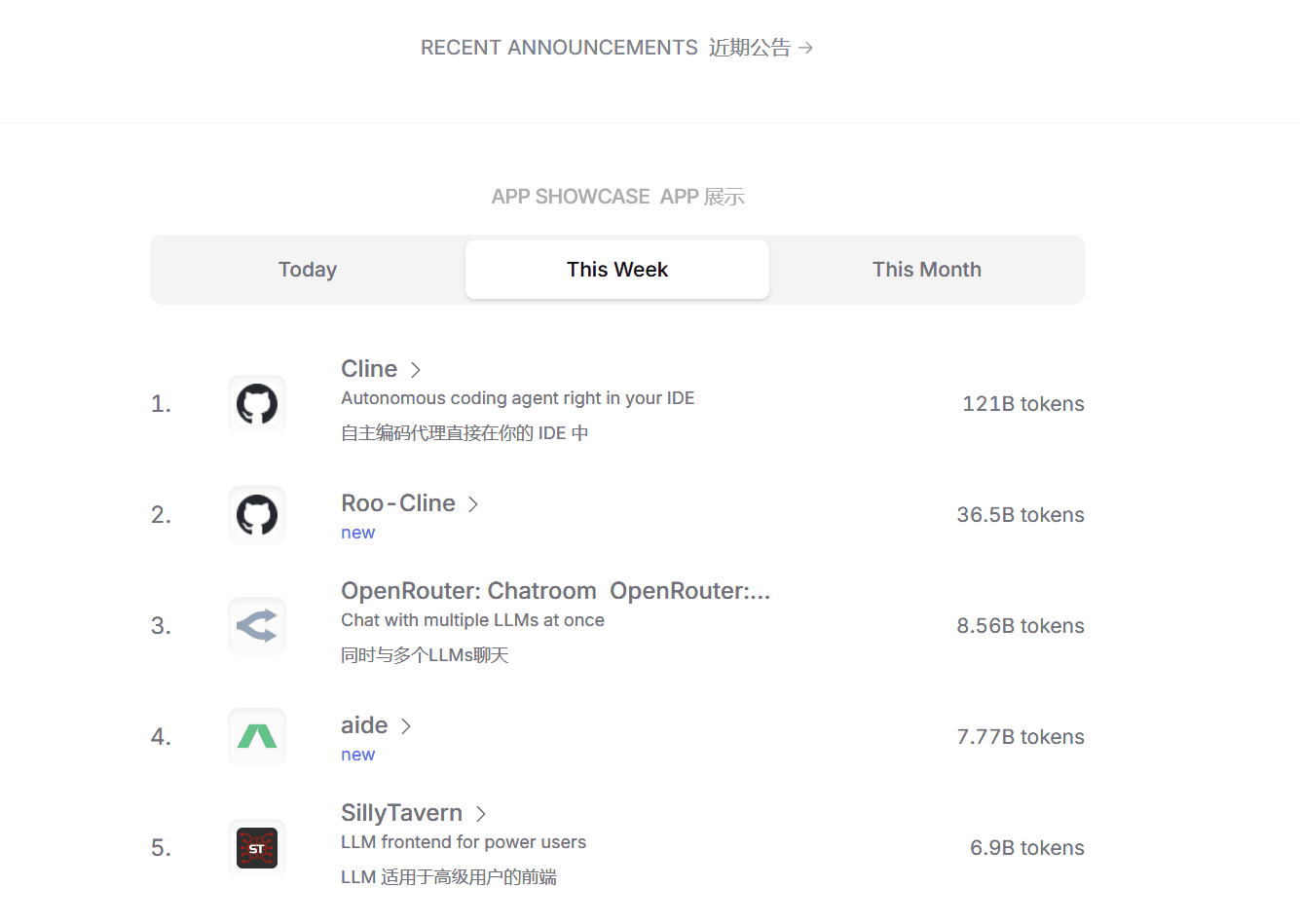

Рис. 1. Производительность однонаправленного объемного поиска многоязычной модели встраивания с открытым исходным кодом и менее чем 1 миллиардом параметров. Оценки: MTEB Поиск и среднее значение nDCG@10 на подмножестве CLEF (ELRA, 2006) (охватывающем английский, французский, испанский, итальянский и немецкий языки).

Многоязычие без компромиссов

В этом выпуске Arctic Embed 2.0 мы выпускаем два доступных варианта: средний вариант, сфокусированный на эффективности выводов, который построен на базе Alibaba ГТД-многоязычный В дополнение к этому, с 305 миллионами параметров (из которых 113 миллионов - не вложенные), еще один большой вариант фокусируется на качестве поиска и построен на Facebook's XMLR-Large с 568 миллионами параметров (из которых 303 миллиона - не вложенные) поверх варианта с длинным контекстом. Оба размера поддерживают до 8 192 Токен длина контекста. При создании Arctic Embed 2.0 мы осознали проблему, с которой сталкиваются многие существующие многоязычные модели: оптимизация для нескольких языков часто приводит к снижению качества поиска на английском языке. Это привело к тому, что многие модели в этой области имеют два варианта для каждой версии: англоязычный и многоязычный. Модели Arctic Embed 2.0 отличаются от других. Они обеспечивают высочайшую производительность на неанглийских языках, таких как немецкий, испанский и французский, и при этом превосходят своих предшественников, использующих только английский язык, в поиске на английском. Arctic Embed M 1.5.

Тщательно балансируя между необходимостью многоязычия и стремлением Snowflake к совершенству в области англоязычного поиска, мы создали Arctic Embed 2.0 как универсальную рабочую лошадку для широкого спектра глобальных задач. В данном документе все качественные оценки относятся к средним показателям NDCG@10 по всем задачам, если не указано иное.

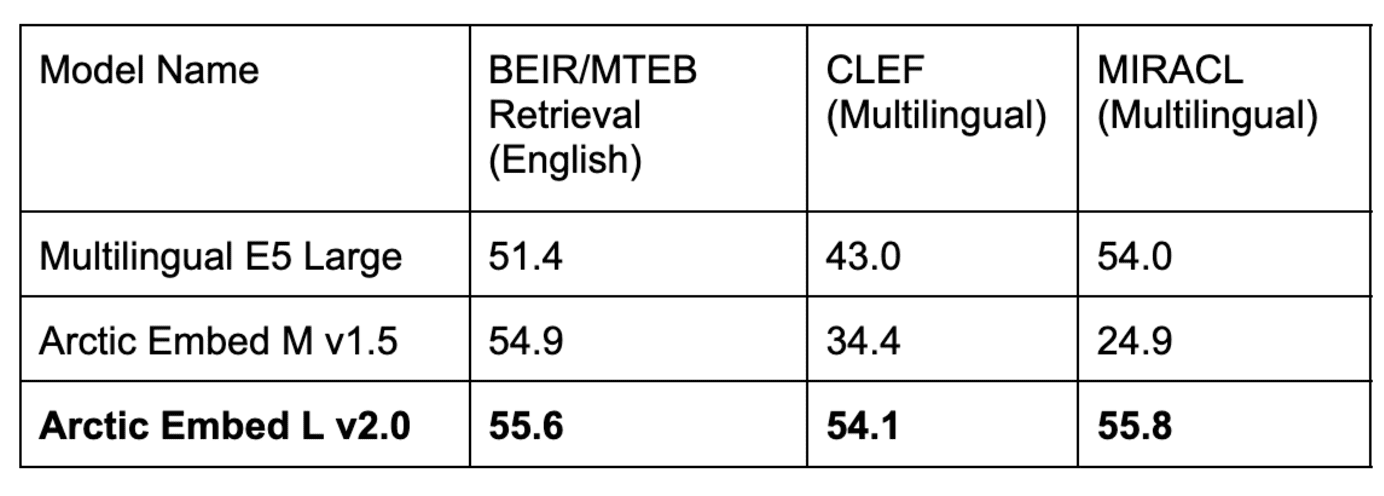

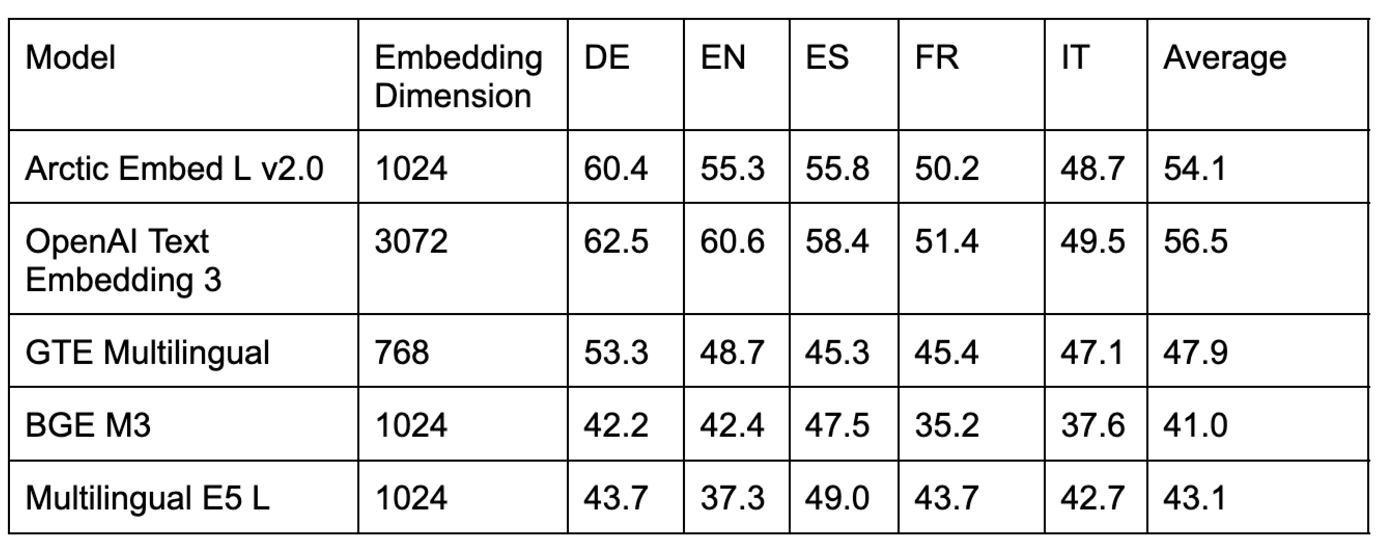

Таблица 1. Наша модель Arctic Embed L v2.0 достигла высоких результатов в популярном английском бенчмарке MTEB Retrieval, а также высокого качества поиска в нескольких многоязычных бенчмарках. Предыдущие итерации Arctic Embed хорошо работали на английском, но плохо на многоязычном, в то время как популярные многоязычные модели с открытым исходным кодом снизили свои показатели на английском. Производительность на английском языке снизилась. Все оценки моделей и наборов данных отражают среднее значение NDCG@10. Оценки CLEF и MIRACL отражают среднее значение для немецкого (DE), английского (EN), испанского (ES), французского (FR) и итальянского (IT) языков.

Разнообразный и мощный набор функций Arctic Embed 2.0

- Пропускная способность и эффективность корпоративного класса: Модель Arctic Embed 2.0 создана для нужд крупных предприятий. Даже наша "большая" модель имеет параметры менее миллиарда и обеспечивает быстрое, высокопроизводительное встраивание. По результатам внутреннего тестирования, она легко обрабатывает более 100 документов в секунду (в среднем) на графических процессорах NVIDIA A10 и достигает менее 10 миллисекунд задержки при встраивании запросов, что позволяет развертывать ее в реальных условиях на доступном оборудовании.

- Бескомпромиссное качество поиска на английском и неанглийском языках: Несмотря на компактные размеры, обе модели Arctic Embed 2.0 получили впечатляющие оценки NDCG@10 на различных англоязычных и неанглоязычных эталонных наборах данных, продемонстрировав способность к обобщению даже для языков, не включенных в обучающее решение. Эти впечатляющие результаты делают Arctic Embed L 2.0 лидером среди передовых моделей поиска.

- Масштабируемый поиск с помощью обучения представлений "Матрешка" (MRL): Arctic Embed версии 2.0 включает в себя ту же самую функциональность MRL, которая была представлена в Arctic Embed 1.5, позволяя пользователям сократить расходы и оптимизировать размер при выполнении поиска в больших наборах данных. Благодаря двум размерам модели, пользователи могут выполнять высококачественный поиск, используя всего 128 байт на вектор (в 96 раз меньше, чем несжатый эмбеддинг популярной модели OpenAI text-embedding-3-large ^1^). Как и Arctic Embed 1.5, модель Arctic Embed 2.0 в сжатом состоянии также превосходит несколько аналогов с поддержкой MRL, при этом качество значительно снижается, а результаты в бенчмарках выше.

- По-настоящему открытый исходный код: Модель Arctic Embed 2.0 выпускается под щедрой лицензией Apache 2.0.

Гибкость с открытым исходным кодом и надежность корпоративного класса

Как и их предшественники, модели Arctic Embed 2.0 выпускаются под щедрой лицензией Apache 2.0, что позволяет организациям изменять, внедрять и расширять их на основе привычных лицензий. Эти модели работают "из коробки", поддерживают приложения различных вертикалей благодаря надежному многоязыковому встраиванию и обладают хорошими возможностями обобщения.

Клеман Деланг (Clément Delangue), генеральный директор Hugging Face, сказал: "Многоязычные модели встраивания очень важны для того, чтобы люди со всего мира, а не только англоговорящие, могли стать создателями ИИ. Выпуская эти современные модели с открытым исходным кодом на Hugging Face, Snowflake делает огромный вклад в развитие ИИ и всего мира".

На самом деле, среди вариантов с открытым исходным кодом семейство Arctic Embed 2.0 заслуживает особого внимания благодаря своим обобщающим способностям в многоязычных поисковых тестах. Благодаря лицензированию Набор тестов Cross-Language Evaluation Forum (CLEF) 2000-2003 гг.Наша команда смогла измерить качество внедоменного поиска различных моделей с открытым исходным кодом и обнаружила неблагоприятную тенденцию в отношении внутридоменного поиска. МИРАКЛ низкие показатели по сравнению с результатами, полученными на оценочном наборе. Мы предполагаем, что некоторые из ранних разработчиков моделей с открытым исходным кодом могли непреднамеренно перенастроить свои учебные сценарии для улучшения производительности MIRACL в ущерб улучшению производительности MIRACL, и, таким образом, могли чрезмерно подогнать учебные данные MIRACL. Следите за предстоящим техническим отчетом о том, как проходило обучение модели Arctic Embed 2.0 и что мы узнали в процессе обучения.

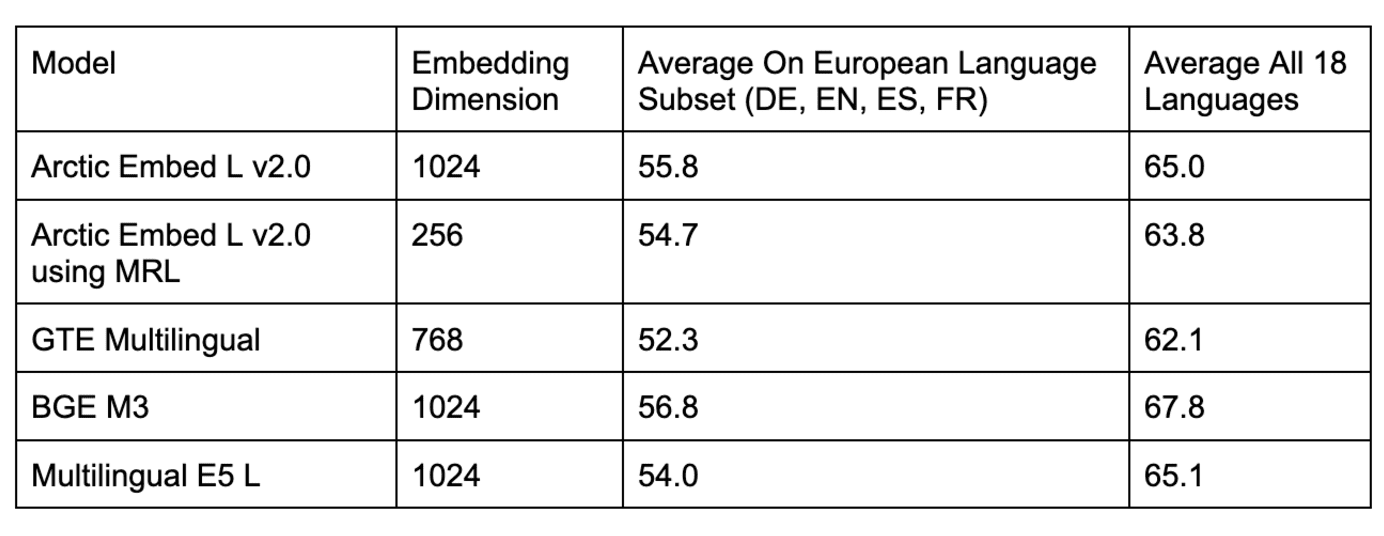

Таблица 2. Сравнение моделей многоязычного поиска на нескольких наборах данных из внедоменного бенчмарка CLEF.

Таблица 3. Сравнение нескольких открытых моделей многоязычного поиска в бенчмарке MIRACL.

Как показано в таблицах 2 и 3, несколько популярных моделей с открытым исходным кодом для внутридоменной оценки MIRACL сравниваются с Arctic Embed L 2.0 сопоставимы, но плохо работают во внедоменных оценках CLEF. Мы также провели бенчмаркинг популярных закрытых моделей (например, модели OpenAI text-embedding-3-large) и обнаружили, что Arctic L 2.0 работает наравне с ведущими собственными моделями.

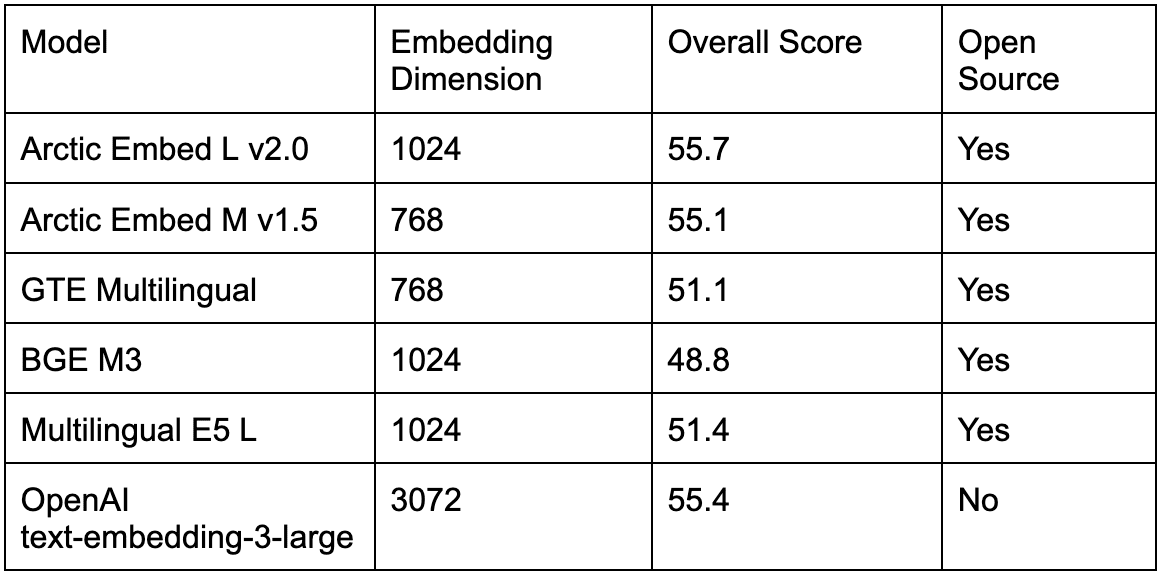

Как показано в таблице 4, существующие многоязычные модели с открытым исходным кодом также лучше справляются с популярным эталонным тестом MTEB Retrieval на английском языке, чем Arctic Embed L 2.0 и даже хуже, заставляя пользователей, желающих поддерживать несколько языков, выбирать между более низким качеством поиска на английском языке и повышенной операционной сложностью использования второй модели для поиска только на английском языке. С выходом Arctic Embed 2.0 специалисты могут перейти на единую модель с открытым исходным кодом, не жертвуя качеством поиска на английском языке.

Таблица 4. Сравнение нескольких лучших моделей многоязычного поиска с открытым и закрытым исходным кодом в бенчмарке MTEB Retrieval.

Сжатие и эффективность без компромиссов

Компания Snowflake продолжает уделять первостепенное внимание эффективности и масштабированию при разработке встраиваемых моделей. С помощью Arctic Embed L 2.0Это позволяет сжимать качественные характеристики больших моделей в компактные вкрапления, требующие всего 128 байт памяти на вектор. Это позволяет предоставлять поисковые услуги для миллионов документов при низких затратах на низкопроизводительном оборудовании. Мы также достигли эффективности в пропускной способности встраивания, сжав впечатляющее качество поиска Arctic Embed 2.0 в 100 миллионов и 300 миллионов не вложенных параметров для двух размеров (среднего и большого) соответственно - лишь небольшое увеличение по сравнению с нашей ранней версией, предназначенной только для английского языка.

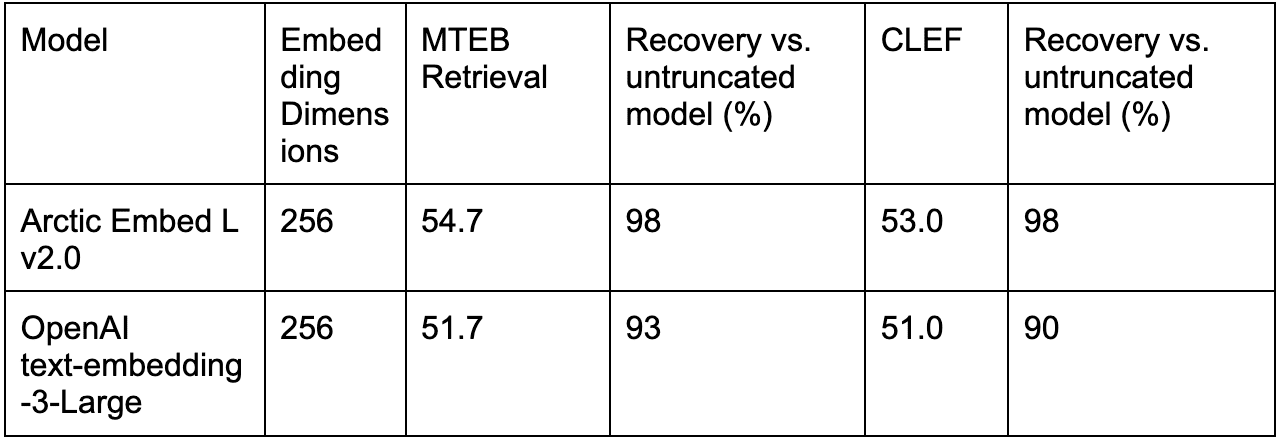

Действительно, механизмы, ориентированные на масштабирование, являются Arctic Embed L 2.0 Там, где он действительно блистает, он достигает лучшего качества при сжатии по сравнению с другими моделями, обученными MRL (например, OpenAI's text-embedding-3-large).

В таблице 5. сравнивается производительность OpenAI по встраиванию текста 3-large с усеченным встраиванием с помощью Arctic Embed L 2.0 только для английского (MTEB Retrieval) и многоязычного (CLEF) языков.

Заключение: Новый стандарт для многоязычного эффективного поиска

С Arctic Embed 2.0 компания Snowflake установила новый стандарт для многоязычных и эффективных моделей встраивания. Кроме того, мы не только повысили качество встраивания текста, но и сделали его доступным для всех желающих. Если ваша цель - расширить охват многоязычных пользователей, сократить расходы на хранение или внедрить документы на доступное оборудование, Arctic Embed 2.0 предоставляет возможности и гибкость для удовлетворения ваших потребностей.

В наших ближайших технических отчетах мы более подробно рассмотрим инновации, лежащие в основе Arctic Embed 2.0. А пока мы приглашаем вас начать внедрение с помощью Snowflake уже сегодня.

^1^ В данном расчете используется формат float32 для несжатой базовой линии, т.е. 3 072 числа по 32 бита каждое, итого 98 304 бита на вектор, что ровно в 96 раз больше, чем 1 024 бита на вектор (эквивалентно 128 байтам на вектор), используемых при хранении 256-мерных векторов, усеченных MRL в модели Arctic Embed 2.0, в формате int4.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...