AppAgent: автоматизированное управление смартфоном с помощью мультимодального интеллекта

Общее введение

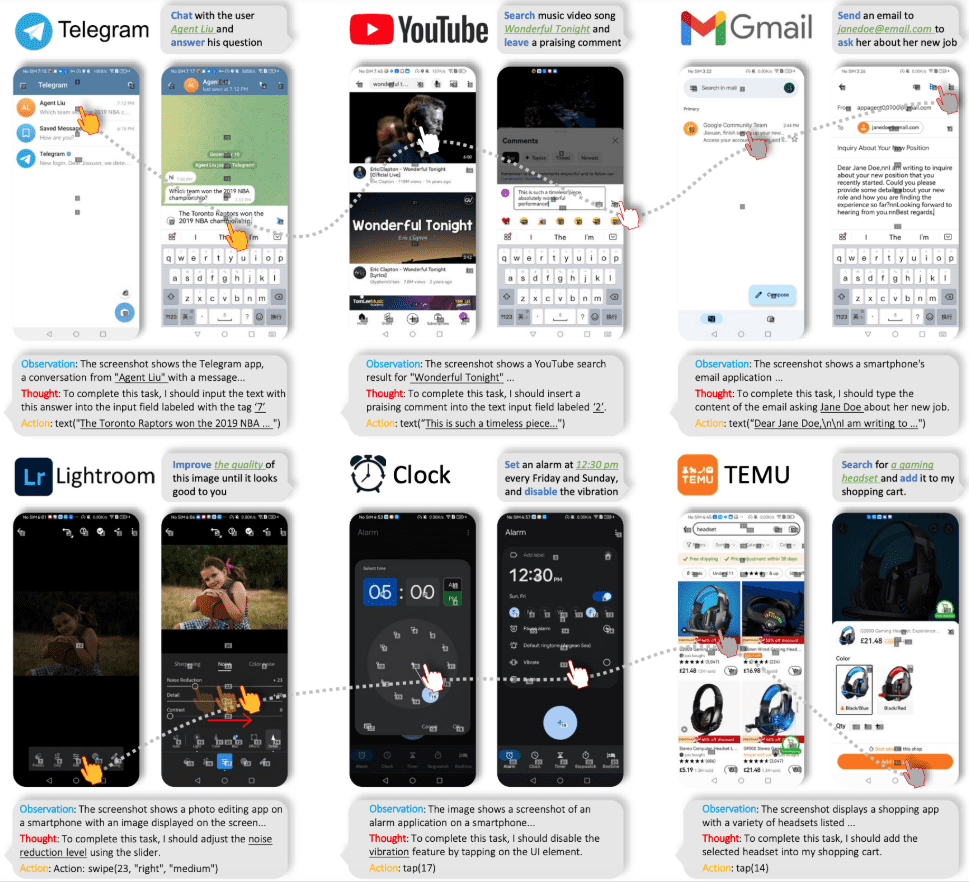

AppAgent - это мультимодальный агент, основанный на большой языковой модели (LLM) и предназначенный для работы с приложениями для смартфонов. Фреймворк расширяет свою применимость к различным приложениям благодаря упрощенному пространству манипуляций, которое имитирует человеческие взаимодействия, такие как касания и смахивания, что устраняет необходимость в системном внутреннем доступе. AppAgent учится использовать новые приложения, автономно изучая или наблюдая за демонстрациями людей, и генерирует базу знаний для выполнения сложных задач.

Компания Tencent выпустила AppAgent - мультимодальное интеллектуальное устройство, которое может управлять интерфейсом мобильного телефона напрямую, распознавая текущий интерфейс мобильного телефона и команды пользователя, и управлять мобильным телефоном, как настоящий пользователь! Например, он может управлять программами для редактирования фотографий, открывать картографические приложения для навигации, совершать покупки и так далее.

Домашняя страница проекта: https://appagent-official.github.io

Ссылка на статью: https://arxiv.org/abs/2312.13771

автореферат диссертации

Благодаря последним достижениям в области больших языковых моделей (LLM), были созданы интеллектуальные умные тела, способные выполнять сложные задачи. В этой статье мы представляем новую мультимодальную структуру для интеллектуальных тел на основе больших языковых моделей, предназначенную для манипулирования приложениями для смартфонов. Наш фреймворк позволяет "умным телам" манипулировать приложениями для смартфонов через упрощенное пространство манипуляций, так, чтобы это было похоже на то, как если бы человек выполнял операции нажатия и пролистывания. Этот инновационный подход позволяет обойти необходимость прямого доступа к внутренним компонентам системы, что делает ее пригодной для широкого спектра различных приложений. В основе функциональности нашего интеллект-тела лежит инновационный подход к обучению. Интеллектуальное тело учится ориентироваться и использовать новые приложения путем самостоятельного изучения или наблюдения за демонстрацией работы человека. В процессе он создает базу знаний, на которую опирается при выполнении сложных задач в различных приложениях. Чтобы продемонстрировать полезность нашего интеллекта, мы тщательно протестировали его на 50 задачах в 10 различных приложениях, включая социальные сети, электронную почту, карты, покупки и сложные инструменты для редактирования изображений. Результаты тестирования показали, что наш интеллект эффективно справляется с широким спектром сложных задач.

Список функций

- самостоятельное исследованиеАгенты могут автономно исследовать приложения, записывать интерактивные элементы и генерировать документацию.

- Демонстрационное обучение людей: Агент изучает задачу, наблюдая за демонстрацией человека, и генерирует соответствующую документацию.

- выполнение мандата: На этапе развертывания агент выполняет сложные задачи на основе сгенерированных документов.

- Мультимодальные входы: Поддерживает как текстовые, так и визуальные входы, используя модели GPT-4V или Qwen-VL-Max.

- Обработка CAPTCHA: Можно пройти аутентификацию с помощью CAPTCHA.

- Распознавание элементов пользовательского интерфейса: Используйте наложения сетки для размещения немаркированных элементов пользовательского интерфейса.

Использование помощи

Установка и настройка

- Загрузка и установка: Загрузите файлы проекта со страницы GitHub и установите необходимые зависимости.

- файл конфигурации: Измените корневой каталог

config.yamlфайл для настройки ключа API для модели GPT-4V или Qwen-VL-Max. - подключённое устройство: Подключите устройство Android с помощью USB и включите отладку по USB в "Параметрах разработчика".

Модель самоисследования

- начать исследование: Беги

learn.pyвыберите режим автономной разведки, введите название приложения и описание задачи. - Запись взаимодействий: Агент автоматически исследует приложение, регистрирует элементы взаимодействия и создает документацию.

Режим демонстрации человека

- Демонстрация стартапа: Беги

learn.pyфайл, выберите режим Human Demo Mode и введите название приложения и описание задачи. - Исполнительная демонстрация: Следуйте подсказкам, и агент запишет все взаимодействия и создаст документацию.

выполнение мандата

- Приступайте к выполнению заданий: Беги

run.pyфайл, введите имя приложения и описание задачи, а также выберите соответствующую библиотеку документов. - работать: Агент будет выполнять задания по выполнению сложных операций на основе документации.

Подробная процедура работы

- Скачать проект: Посетите страницу GitHub, загрузите файлы проекта и распакуйте их.

- Установка зависимостей: Запуск в терминале

pip install -r requirements.txtУстановите все зависимости. - модель конфигурации: Изменить по мере необходимости

config.yamlфайл для настройки ключа API для модели GPT-4V или Qwen-VL-Max. - подключённое устройство: Подключите устройство Android с помощью USB и включите на нем режим отладки USB.

- Инициируйте исследование или демонстрацию: Беги

learn.pyфайл, выберите режим автономной разведки или демонстрации человека, введите название приложения и описание задачи. - Создание документации: Агент будет записывать все взаимодействия и генерировать документацию для последующего выполнения задач.

- работать: Беги

run.pyдокумента, введите имя приложения и описание задачи, выберите соответствующую библиотеку документов, и агент выполнит задачу на основе документа.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...