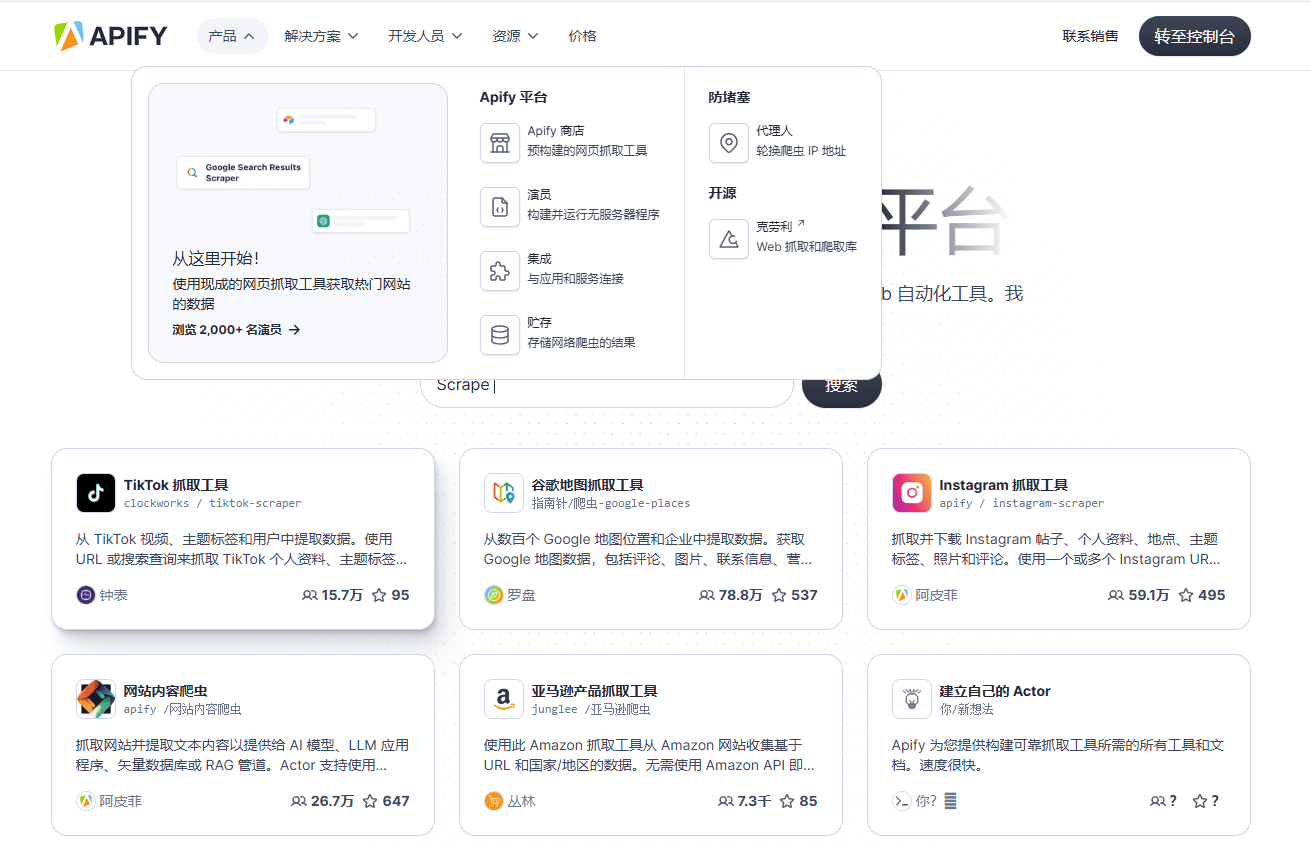

Apify: полнофункциональная платформа для сбора и извлечения данных, автоматизация сбора данных, создание собственных краулеров, интеграция различных API.

Общее введение

Apify - это полнофункциональная платформа для сбора и извлечения данных, которая предоставляет множество инструментов и сервисов для автоматизации сбора данных с любого веб-сайта. Apify поддерживает множество языков программирования и фреймворков, а также предоставляет богатые возможности API и интеграции для различных видов сбора данных и автоматизации.

Самый мощный инструмент для сбора данных, который можно быстро интегрировать в основные рабочие процессы и быстро создать базу знаний.

Список функций

- веб-гусеница: Ползание по любым веб-страницам с помощью Chrome с поддержкой рекурсивного ползания и списков URL.

- извлечение данных: Извлечение структурированных данных из веб-страниц с поддержкой форматов JSON, XML, CSV и других.

- Гусеница на заказ: Создание и публикация пользовательских инструментов извлечения данных, называемых Actors.

- Интеграция API: Интеграция с широким спектром сторонних сервисов и инструментов, таких как Zapier, Google Sheets, Slack и др.

- Профессиональные услуги: Предоставляем индивидуальные решения для веб-краулинга, разработанные и реализованные командой профессионалов.

- инструмент с открытым исходным кодом: Поддержка широкого спектра инструментов и библиотек с открытым исходным кодом, таких как Puppeteer, Playwright, Selenium и другие.

- обработка данных: Обеспечивает очистку данных, преобразование форматов и другие функции для поддержки крупномасштабной обработки данных.

- Мониторинг и планирование: Мониторинг задач захвата в режиме реального времени, поддержка планирования по времени и автоматизации.

Использование помощи

Установка и использование

- Регистрация и вход: Посетите официальный сайт Apify, зарегистрируйте учетную запись и войдите в систему.

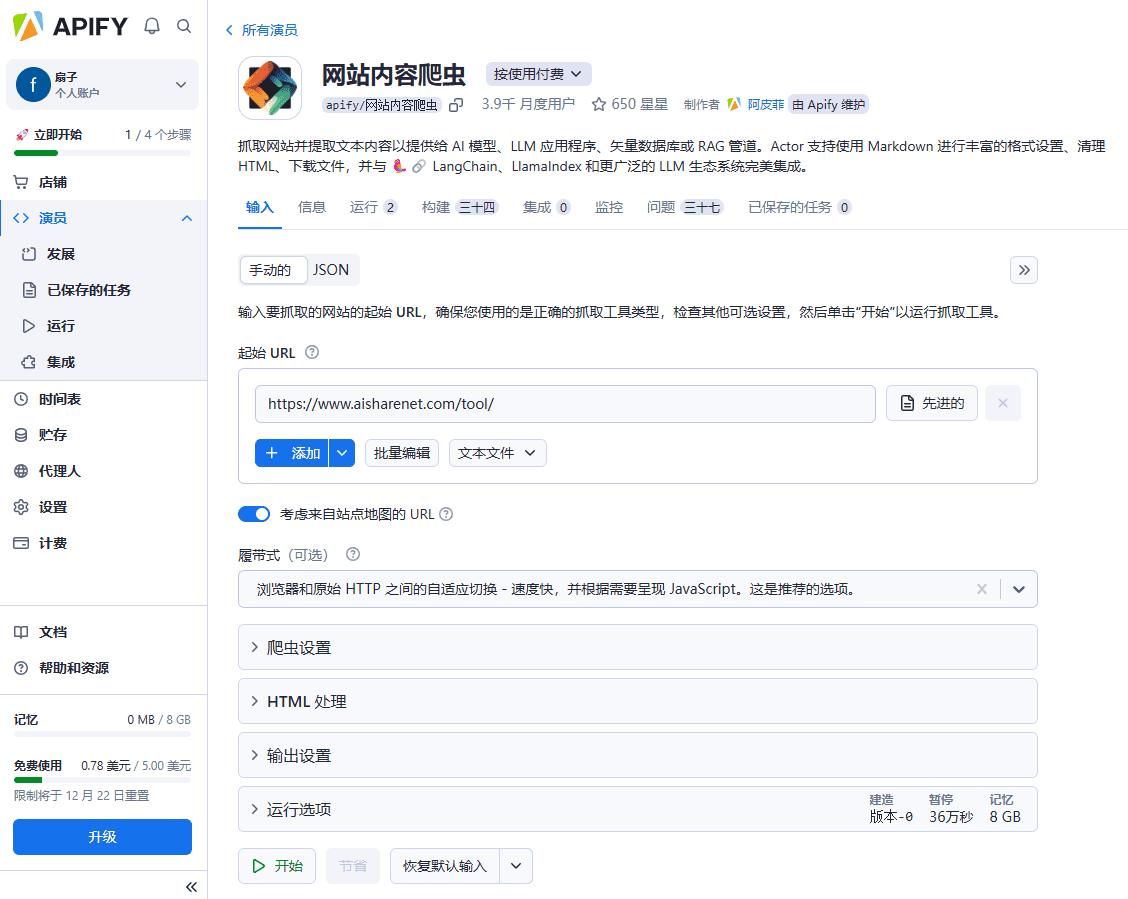

- Инструменты выбора: Найдите в магазине Apify Store готовые инструменты для краулинга и выберите подходящий.

- Настройте задачу захвата::

- Введите URL-адрес: На странице конфигурации инструмента введите URL-адрес веб-страницы, которая будет просматриваться.

- Настройка правил кроулинга: Настройте необходимые правила для ползания, например, рекурсивное ползание, поля извлечения данных и т. д.

- Выполнение заданий: Нажмите кнопку "Выполнить", чтобы запустить задачу захвата и просмотреть ход выполнения и результаты в режиме реального времени.

- Экспорт данныхПосле завершения захвата данные можно экспортировать в JSON, XML, CSV и другие форматы, загрузить локально или импортировать непосредственно в другие системы.

- Создание пользовательских краулеров::

- Создание актера: Создайте новый Actor на платформе Apify, чтобы написать пользовательскую логику для сбора и извлечения данных.

- Тестирование и отладка: Используйте инструменты разработки и отладки, предоставляемые Apify, чтобы проверить логику ползания и исправить ошибки.

- Опубликовать и запустить: Опубликуйте актера в Apify Store, установите задания по времени или запускайте их вручную.

- Интеграция API::

- Получить ключ API: Получите ключ API в настройках вашей учетной записи для вызова API Apify.

- Вызов API: Интегрируйте Apify API в собственные приложения для автоматизации извлечения и обработки данных, используя примеры кода, приведенные в документации по API.

- Профессиональные услуги::

- Свяжитесь с командой Apify: Если требуется индивидуальное решение, вы можете обратиться в отдел профессиональных услуг Apify, чтобы предоставить описание требований.

- Реализация проекта: Команда Apify разработает и внедрит индивидуальное решение для краулинга на основе требований, чтобы обеспечить точность и эффективность извлечения данных.

Подробный порядок работы функций

- веб-гусеница::

- Выбор инструмента для захвата: Выберите инструмент "Веб-скребок" в магазине Apify.

- Настройте задачу захвата: Введите URL-адрес веб-страницы, которую нужно просмотреть, и задайте правила рекурсивного просмотра и извлечения данных.

- Запуск задачи захвата: Нажмите кнопку "Выполнить", чтобы просмотреть ход и результаты захвата в режиме реального времени.

- Экспорт данных: После завершения захвата экспортируйте данные в нужный формат.

- извлечение данных::

- Выберите инструмент извлечения данных: Выберите подходящий инструмент для извлечения данных из магазина Apify Store, например "Google Maps Scraper".

- Настройка задач извлечения: Введите URL-адрес веб-страницы, из которой нужно извлечь данные, и задайте поля и правила извлечения данных.

- Запустите задачу извлечения: Нажмите кнопку "Выполнить", чтобы просмотреть ход и результаты извлечения в режиме реального времени.

- Экспорт данных: После завершения извлечения экспортируйте данные в нужный формат.

- Гусеница на заказ::

- Создание актера: Создайте новый Actor на платформе Apify, чтобы написать пользовательскую логику для сбора и извлечения данных.

- Тестирование и отладка: Используйте инструменты разработки и отладки, предоставляемые Apify, чтобы проверить логику ползания и исправить ошибки.

- Опубликовать и запустить: Опубликуйте актера в Apify Store, установите задания по времени или запускайте их вручную.

- Интеграция API::

- Получить ключ API: Получите ключ API в настройках вашей учетной записи для вызова API Apify.

- Вызов API: Интегрируйте Apify API в собственные приложения для автоматизации извлечения и обработки данных, используя примеры кода, приведенные в документации по API.

- Профессиональные услуги::

- Свяжитесь с командой Apify: Если требуется индивидуальное решение, вы можете обратиться в отдел профессиональных услуг Apify, чтобы предоставить описание требований.

- Реализация проекта: Команда Apify разработает и внедрит индивидуальное решение для краулинга на основе требований, чтобы обеспечить точность и эффективность извлечения данных.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...