AI full-stack инструмент с открытым исходным кодом! Возьмите с собой Ollama+Qwen2.5-Code runbolt.new, один клик для создания сайта!

В последнее время очень популярны инструменты для программирования с использованием искусственного интеллекта: Cursor, V0, Bolt.new и совсем недавно Windsurf.

В этом посте мы начнем с рассказа о решении с открытым исходным кодом - Bolt.new, которое принесло доход в размере 4 миллионов долларов всего за четыре недели с момента запуска продукта.

Непосредственно на сайтеОграничения скорости доступа внутри страныиКвота бесплатных токенов ограничена.

Как запустить его на местном уровне, чтобы больше людей могли им пользоваться, и ускорить внедрение ИИ в жизнь - вот задача Monkey.

Сегодняшняя акция.Проводит вас через большую модель, развернутую с помощью местной Олламы, управляя болтом.newПрограммист искусственного интеллекта, который понял, что Токен Свобода.

1. Знакомство с Bolt.new

Bolt.new Это SaaS-платформа для кодирования ИИ с базовыми LLM-интеллектами, объединенная с технологией WebContainers, которая позволяет кодировать и выполнять коды в браузере, с такими преимуществами, как:

- Одновременная поддержка front-end и back-end разработки.;

- Визуализация структуры папок проекта.;

- Самостоятельная среда с автоматической установкой зависимостей (например, Vite, Next.js и т. д.).;

- Запуск сервера Node.js от развертывания до производства

БолтЦель .new - сделать разработку веб-приложений более доступной для широкого круга людей, чтобы даже новички в программировании могли реализовать свои идеи с помощью простого естественного языка.

Проект был официально открыт: https://github.com/stackblitz/bolt.new.

Однако официальный открытый исходный код bolt.new имеет ограниченную поддержку моделей, и многие наши отечественные партнеры не могут вызвать зарубежный LLM API.

В обществе есть бог. bolt.new-any-llmМестная поддержка доступна. Оллама Посмотрите на эту модель в действии ниже.

2. Локальное развертывание Qwen2.5-Code

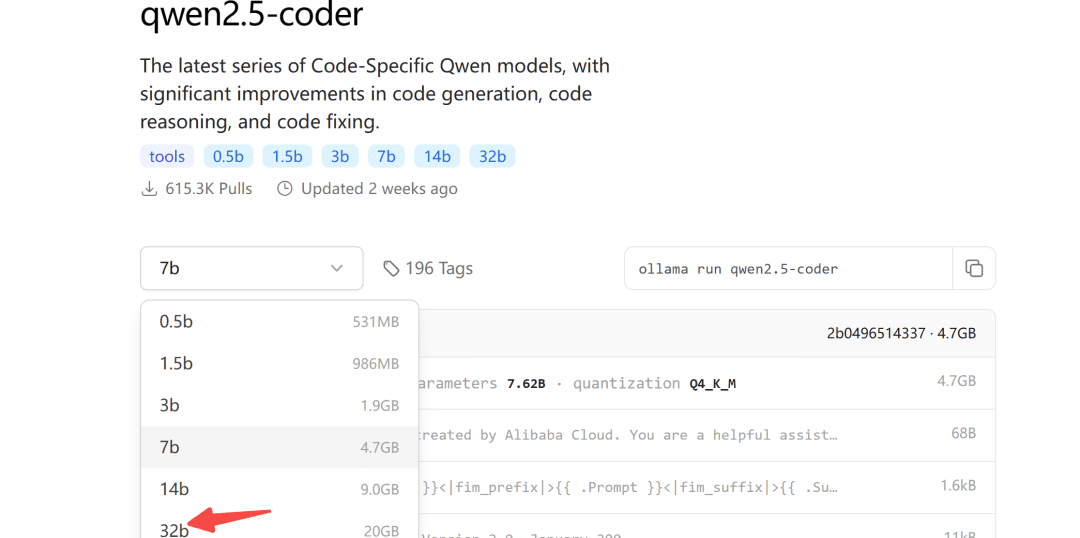

Некоторое время назад компания Ali выложила в открытый доступ серию моделей Qwen2.5-Coder, среди которых модель 32B показала лучшие результаты в более чем десяти бенчмарках.

Она заслуживает звания самой мощной в мире модели с открытым исходным кодом, превосходящей по ряду ключевых возможностей даже GPT-4o.

Репозиторий моделей Ollama также доступен для qwen2.5-coder:

Ollama - это удобный для гаджетов инструмент для развертывания больших моделей.

2.1 Загрузка модели

Что касается размера загружаемой модели, вы можете выбрать его в соответствии с вашей собственной видеопамятью, для модели 32B гарантируется не менее 24 Гб видеопамяти.

Ниже мы продемонстрируем это на примере модели 7b:

ollama pull qwen2.5-coder

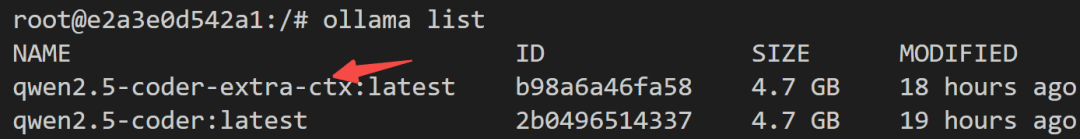

2.2 Модификации модели

Поскольку максимальный выход Ollama по умолчанию составляет 4096 лексем, этого явно недостаточно для задач генерации кода.

Для этого необходимо изменить параметры модели, чтобы увеличить количество контекстных Token.

Сначала создайте новый файл Modelfile и заполните его:

FROM qwen2.5-coder

PARAMETER num_ctx 32768

Затем начинается преобразование модели:

ollama create -f Modelfile qwen2.5-coder-extra-ctx

После успешного преобразования снова просмотрите список моделей:

2.3 Модельные прогоны

Наконец, проверьте на стороне сервера, можно ли успешно вызвать модель:

def test_ollama():

url = 'http://localhost:3002/api/chat'

data = {

"model": "qwen2.5-coder-extra-ctx",

"messages": [

{ "role": "user", "content": '你好'}

],

"stream": False

}

response = requests.post(url, json=data)

if response.status_code == 200:

text = response.json()['message']['content']

print(text)

else:

print(f'{response.status_code},失败')

Если все в порядке, вы можете вызвать его в bolt.new.

3. Bolt.new работает локально

3.1 Локальное развертывание

шаг1: Загрузите bolt.new-any-llm, который поддерживает локальные модели:

git clone https://github.com/coleam00/bolt.new-any-llm

шаг2: Сделайте копию переменных окружения:

cp .env.example .env

шаг3: Измените переменную окружения наOLLAMA_API_BASE_URLЗамените его своим собственным:

# You only need this environment variable set if you want to use oLLAMA models

# EXAMPLE http://localhost:11434

OLLAMA_API_BASE_URL=http://localhost:3002

шаг4: Установка зависимостей (при локальной установке узла)

sudo npm install -g pnpm # pnpm需要全局安装

pnpm install

шаг5: управление одним нажатием кнопки

pnpm run dev

Следующий вывод свидетельствует об успешном запуске:

➜ Local: http://localhost:5173/

➜ Network: use --host to expose

➜ press h + enter to show help

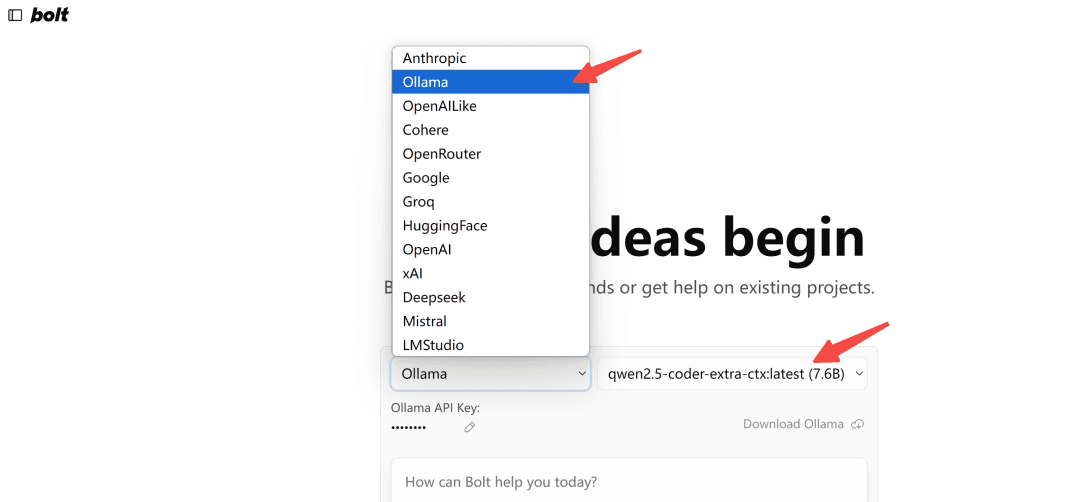

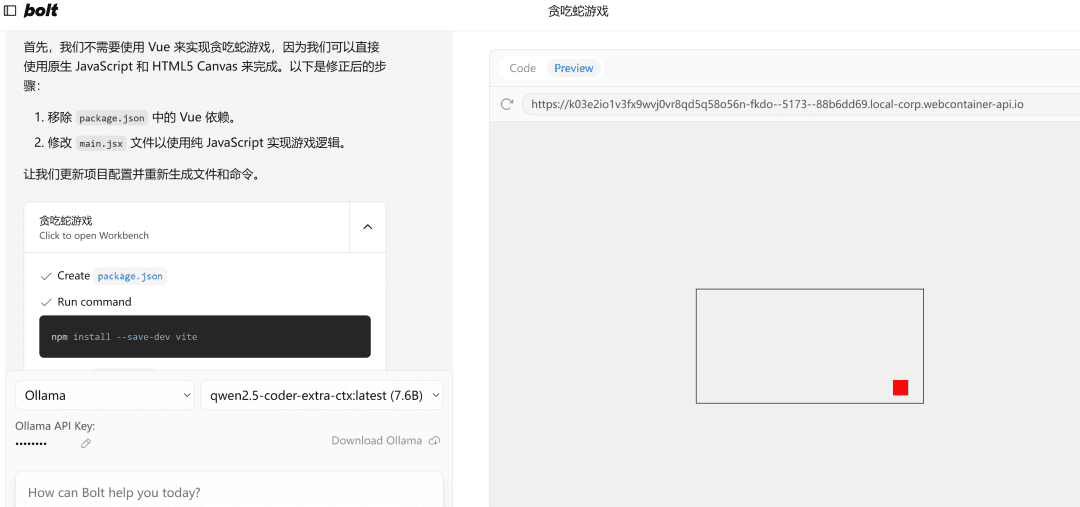

3.2 Демонстрация эффектов

Открыть в браузереhttp://localhost:5173/Выбрана модель типа Ollama:

Примечание: При первой загрузке, если модель не отображается в Ollama, обновите ее несколько раз, чтобы посмотреть, как она выглядит.

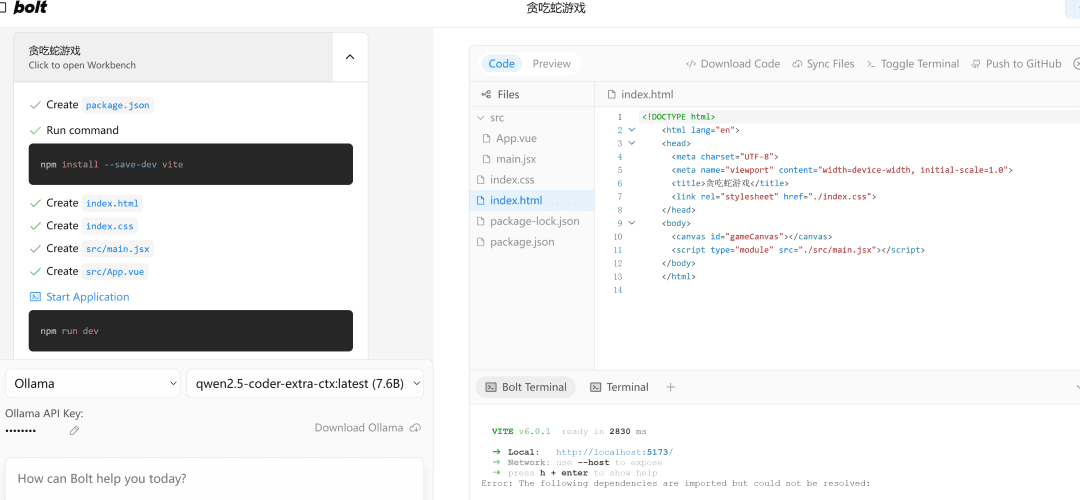

Давайте проверим это на практике.

写一个网页端贪吃蛇游戏

Слева.流程执行область, а справа -代码编辑область, под которой находится终端Область. Пишите код, устанавливайте зависимости и выполняйте команды терминала - AI сделает все это за вас!

Если он столкнулся с ошибкой, просто выдайте ошибку, выполните его снова, и если все в порядке, правая частьPreviewСтраница успешно откроется.

Примечание: Поскольку в примере используется маленькая 7b модель, при необходимости вы можете попробовать использовать 32b модель, эффект будет значительно лучше.

написать в конце

В этой статье рассказывается о локальном развертывании модели qwen2.5-code и успешном использовании инструмента программирования ИИ bolt.new.

Использовать его для разработки фронтенд-проекта все еще довольно мощно, конечно, если использовать его хорошо, знать некоторые базовые концепции фронтенда и бэкенда, будет вдвое эффективнее.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...

![[转]从零拆解一款火爆的浏览器自动化智能体,4步学会设计自主决策Agent](https://aisharenet.com/wp-content/uploads/2025/01/e0a98a1365d61a3.png)