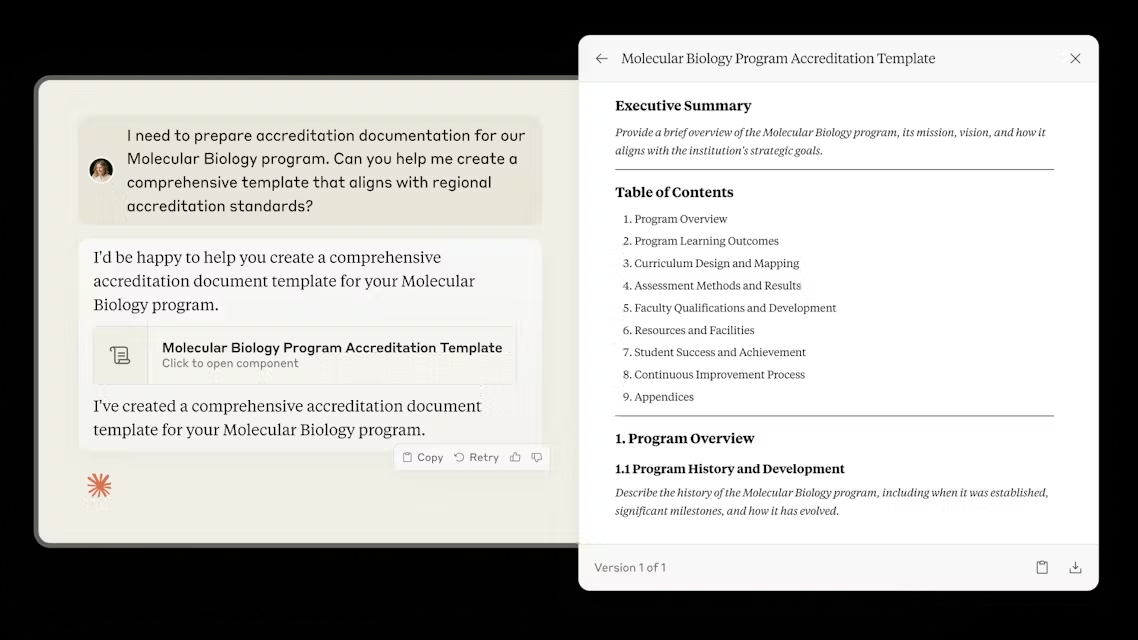

Дебаты о производительности памяти искусственного интеллекта: бенчмарки Zep Mem0 под сомнением

Недавний анонс в области искусственного интеллекта Body Memory вызвал большой интерес в отрасли.Компания Mem0 публикует исследовательские отчетыКомпания утверждает, что ее продукты достигают лучших в отрасли уровней (SOTA) в технологии AI Smart Body Memory и превосходят ее по ряду показателей, включая Zep Однако это утверждение было быстро оспорено командой Zep. Однако это утверждение было быстро оспорено командой Zep, которая отметила, что при правильной реализации ее продукт действительно превзошел выбранный Mem0 эталон LoCoMo примерно на 241TP3 Т. Эта существенная разница заставила глубже задуматься о справедливости эталона, строгости экспериментальной схемы и надежности окончательных выводов.

В условиях жесткой конкуренции в области искусственного интеллекта получение сертификата SOTA (State-of-the-Art) значит очень много для любой компании. Это не только означает технологическое лидерство, но и привлекает инвестиции, таланты и внимание рынка. Поэтому любые заявления о SOTA, особенно выводы, сделанные на основе бенчмаркинга, должны быть тщательно проанализированы.

Утверждение Zep: результаты тестов LoCoMo изменились при правильной реализации

В своем ответе команда Zep отметила, что когда эксперимент LoCoMo был настроен в соответствии с лучшими практиками ее продукта, результаты сильно отличались от отчета Mem0.

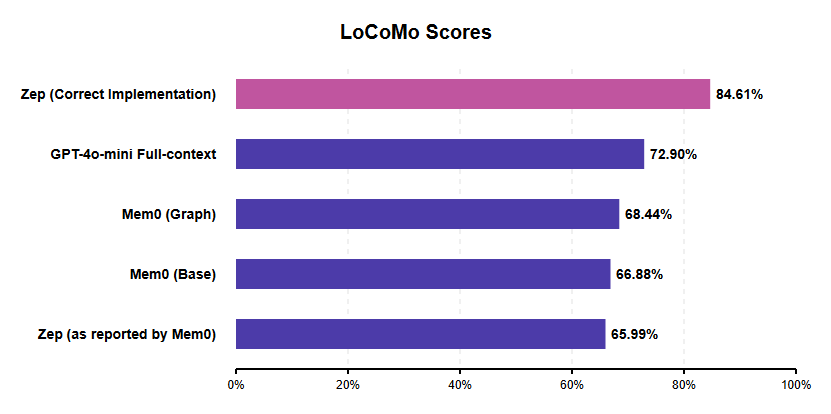

Все оценки взяты из отчетов Mem0, за исключением обсуждаемого здесь "Zep (Correct)".

Согласно опубликованной оценке компании Zep, J-score ее продукта достигает 84.61%По сравнению с оптимальной конфигурацией Mem0 (график Mem0), составляющей около 68,41 TP3T, она достигает примерно 23.6% относительного прироста производительности. Это контрастирует с результатом Зепа 65,99%, полученным в статье Mem0, который, по мнению Зепа, скорее всего, является прямым результатом ошибки в реализации, о чем будет сказано ниже.

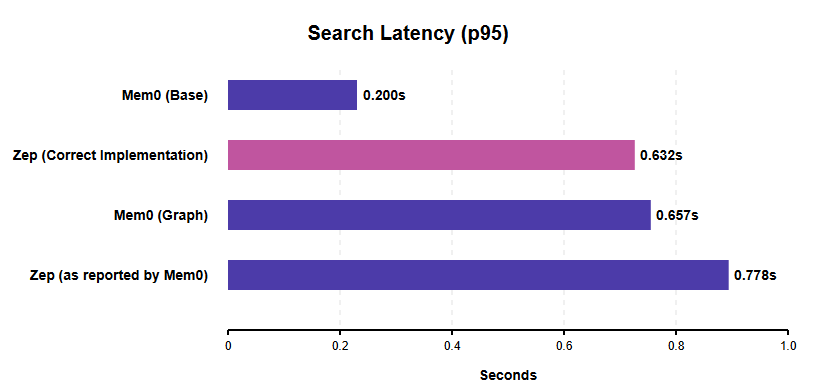

Что касается **задержки поиска (p95 search latency)**, Zep отмечает, что когда его система правильно настроена для одновременного поиска, p95 search latency составляет 0,632 секунды. Это лучше, чем 0,778 секунды, указанные Zep в отчете Mem0 (которые, по мнению Zep, завышены из-за реализации последовательного поиска), и немного быстрее, чем задержка поиска графов в Mem0 (0,657 секунды).

Все оценки взяты из отчетов Mem0, за исключением обсуждаемого здесь "Zep (Correct)".

Стоит отметить, что базовая конфигурация Mem0 (Mem0 Base) демонстрирует меньшую задержку поиска (0,200 секунды). Однако это не совсем эквивалентное сравнение, поскольку Mem0 Base использует более простое векторное хранилище/кэш, не обладающее реляционными возможностями базы данных графов, а также имеет самый низкий показатель точности среди всех вариантов Mem0. Эффективный одновременный поиск Zep демонстрирует высокую производительность для ИИ-интеллектов производственного уровня, которым требуются более сложные структуры памяти и важна оперативность, и Zep объясняет, что данные о задержках были измерены в среде AWS us-west-2 с настройкой NAT для передачи данных.

Ограничения бенчмаркинга LoCoMo вызывают вопросы

Решение Mem0 выбрать LoCoMo в качестве эталона для своего исследования было тщательно проанализировано компанией Zep, которая выявила ряд фундаментальных недостатков эталона как на уровне разработки, так и на уровне исполнения. Разработка и проведение комплексного и непредвзятого бенчмарка - сложная задача, требующая глубокой экспертизы, достаточных ресурсов и глубокого понимания внутренних механизмов тестируемой системы.

Основные проблемы LoCoMo, выявленные командой Zep, включают:

- Недостаточная длина и сложность диалога: Средняя длина диалога в LoCoMo колеблется от 16 000 до 26 000. Жетоны Между. Хотя это может показаться длинным, для современных LLM это обычно в пределах возможностей их контекстного окна. Такая длительность не дает реальной нагрузки на возможности извлечения информации из долговременной памяти. В качестве убедительного доказательства, собственные результаты Mem0 показывают, что ее система не справляется даже с простым "полным контекстом" (т.е. когда весь диалог поступает непосредственно в LLM). J-score для базовой линии полного контекста составляет около 731 TP3T, в то время как лучший результат Mem0 - около 681 TP3T. Если простое предоставление всего текста дает лучшие результаты, чем профессиональная система памяти, то бенчмарк не может адекватно исследовать объем памяти в реальном взаимодействии ИИ и интеллекта.

- Невозможность проверить критические функции памяти: В бенчмарке отсутствует проблема "обновления знаний", для тестирования которой он был создан. Обновление памяти при изменении информации с течением времени (например, когда пользователь меняет работу) - критически важная функция для памяти ИИ.

- Вопросы качества данных: Сам набор данных страдает от нескольких недостатков качества:

- Категория недоступностиКатегория 5 не могла быть использована из-за отсутствия стандартизированного ответа, что вынудило Mem0 и Zep исключить эту категорию из своих оценок.

- мультимодальная ошибка: Некоторые вопросы касались изображений, но необходимая информация отсутствовала в описаниях изображений, сгенерированных моделью BLIP в процессе создания набора данных.

- Неправильное указание ораторов: В некоторых вопросах поведение или высказывания неверно приписываются не тому собеседнику.

- Отсутствие ясности в определении проблемы: Некоторые вопросы неоднозначны и могут иметь более одного потенциально правильного ответа (например, спросить человека, когда он ходит в поход, когда он может быть там и в июле, и в августе).

Учитывая эти ошибки и несоответствия, надежность LoCoMo как авторитетного показателя производительности памяти интеллектов ИИ вызывает сомнения. К сожалению, LoCoMo - не единичный случай. Другие эталоны, такие как HotPotQA, подвергались критике за использование учебных данных LLM (например, Википедии), чрезмерное упрощение вопросов и фактические ошибки. Это подчеркивает постоянную проблему проведения надежных бенчмарков в области ИИ.

Mem0 Критика методологии оценки Zep

Помимо споров вокруг самого бенчмарка LoCoMo, сравнение Zep в статье Mem0, по мнению Zep, основано на несовершенной реализации и поэтому не может точно отразить истинные возможности Zep:

- Неправильная модель пользователяMem0 использует структуру пользовательского графа, предназначенную для взаимодействия одного пользователя с помощником, но распределяет роли пользователей между диалогами.обе участвующие стороныУчастники. Это, скорее всего, запутает внутреннюю логику Zep, заставив его воспринимать диалог как диалог одного пользователя, постоянно переключающего личность между сообщениями.

- Неправильная обработка временных меток: Временные метки передаются путем добавления их в конец сообщения, а не с помощью специфического для Zep поля created_at. Такой нестандартный подход мешает возможностям Zep по определению времени.

- Последовательный и параллельный поиск: Операция поиска выполняется последовательно, а не параллельно, что искусственно увеличивает задержку поиска Zep, о которой сообщает Mem0.

Компания Zep утверждает, что эти ошибки при внедрении в корне неверно истолковали принцип работы Zep и неизбежно привели к низким показателям, о которых говорится в документе Mem0.

Промышленность призывает к улучшению бенчмаркинга: почему Zep отдает предпочтение LongMemEval

Споры, вызванные появлением LoCoMo, усилили потребность индустрии в более надежных и актуальных бенчмарках, и команда Zep выразила предпочтение таким бенчмаркам, как LongMemEval Это критерий оценки, поскольку он компенсирует недостатки LoCoMo в нескольких отношениях:

- Длина и трудности: содержит значительно более длинные диалоги (в среднем 115k Tokens), которые действительно проверяют контекстуальные границы.

- Временные рассуждения и изменение состояния: В явном виде проверяет понимание времени и способность справляться с изменениями в информации (обновление знаний).

- масса (в физике): Планируется и разрабатывается вручную с целью обеспечения высокого качества.

- Актуальность для компании: Больше соответствует сложности и требованиям реальных корпоративных приложений.

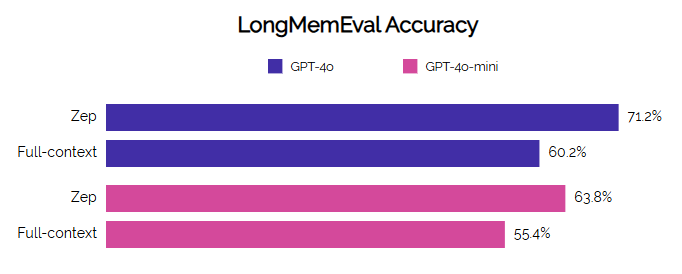

Как сообщается, Zep продемонстрировал высокую производительность в LongMemEval, добившись значительного улучшения точности и времени ожидания по сравнению с базовым уровнем, особенно в сложных задачах, таких как синтез нескольких сессий и временной вывод.

Бенчмаркинг - сложное занятие, а оценка продуктов конкурентов требует еще большего усердия и опыта, чтобы обеспечить справедливость и точность сравнений. Из подробного опровержения, представленного Zep, следует, что заявленные Mem0 показатели SOTA основаны на некачественном бенчмарке (LoCoMo) и некачественной реализации системы конкурента (Zep).

При корректной оценке по одному и тому же эталону Zep значительно превосходит Mem0 по точности и демонстрирует высокую конкурентоспособность по задержке поиска, особенно при сравнении реализаций на основе графов. Это различие подчеркивает критическую важность тщательного эксперимента и глубокого понимания оцениваемой системы, чтобы сделать достоверные выводы.

В будущем область ИИ отчаянно нуждается в более качественных и репрезентативных бенчмарках. Наблюдатели отрасли также призывают команды Mem0 оценивать свои продукты в более сложных и релевантных бенчмарках, таких как LongMemEval, где Zep уже опубликовала свои результаты, чтобы провести более значимые боковые сравнения возможностей долговременной памяти ИИ-интеллектов. Речь идет не только о репутации отдельных продуктов, но и о правильном направлении технологического прогресса для всей индустрии в целом.

Ссылка:ZEP: архитектура темпорального графа знаний для интеллектуальной памяти тела

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...