Топ-5 платформ для выводов ИИ, которые используют полнокровную версию DeepSeek-R1 бесплатно

Из-за чрезмерного трафика и кибератаки сайт и приложение DeepSeek не работали несколько дней, а API не работает.

Ранее мы уже рассказывали о методе локального развертывания DeepSeek-R1 (см.Локальное развертывание DeepSeek-R1), но средний пользователь ограничен аппаратной конфигурацией, которая не позволяет запустить даже модель 70b, не говоря уже о полноценной модели 671b.

К счастью, все основные платформы имеют доступ к DeepSeek-R1, так что вы можете попробовать его в качестве плоской замены.

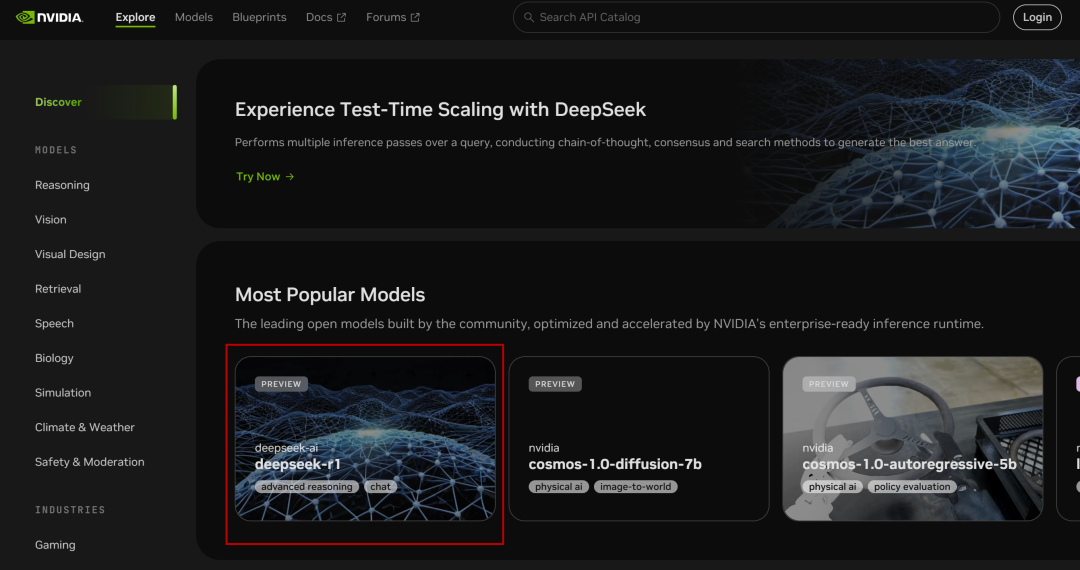

I. Микросервисы NVIDIA NIM

NVIDIA Build: интегрируйте несколько моделей ИИ и испытайте их бесплатно

Сайт: https://build.nvidia.com/deepseek-ai/deepseek-r1

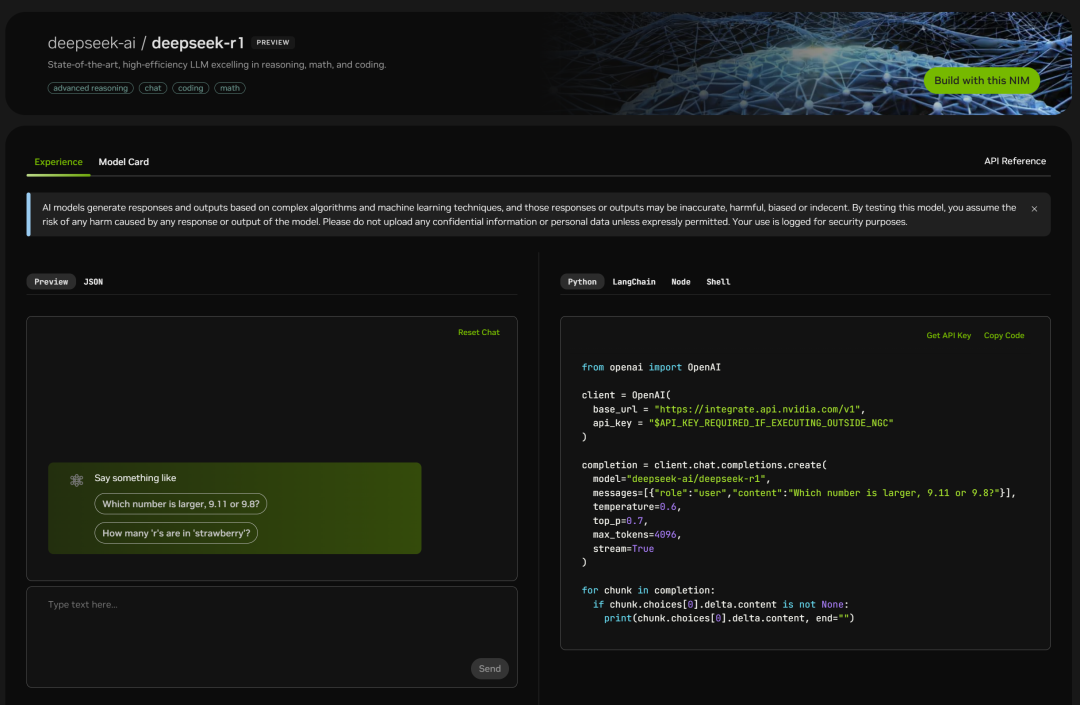

NVIDIA развернула параметр полного объема 671B из DeepSeek-R1 Модели, веб-версия просты в использовании, и вы можете видеть окно чата, когда нажимаете на него:

Также справа указана страница с кодом:

Просто проверьте его:

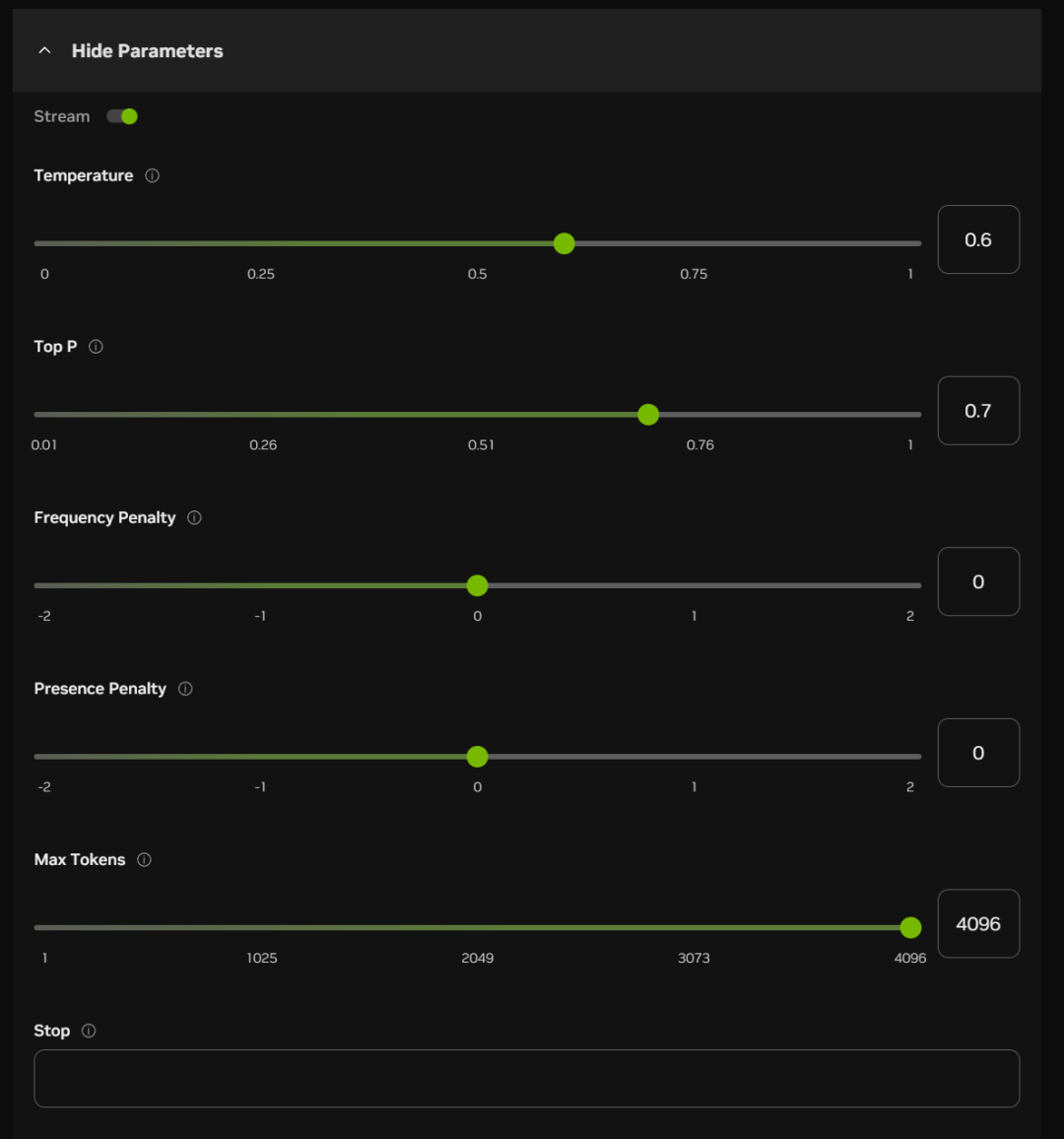

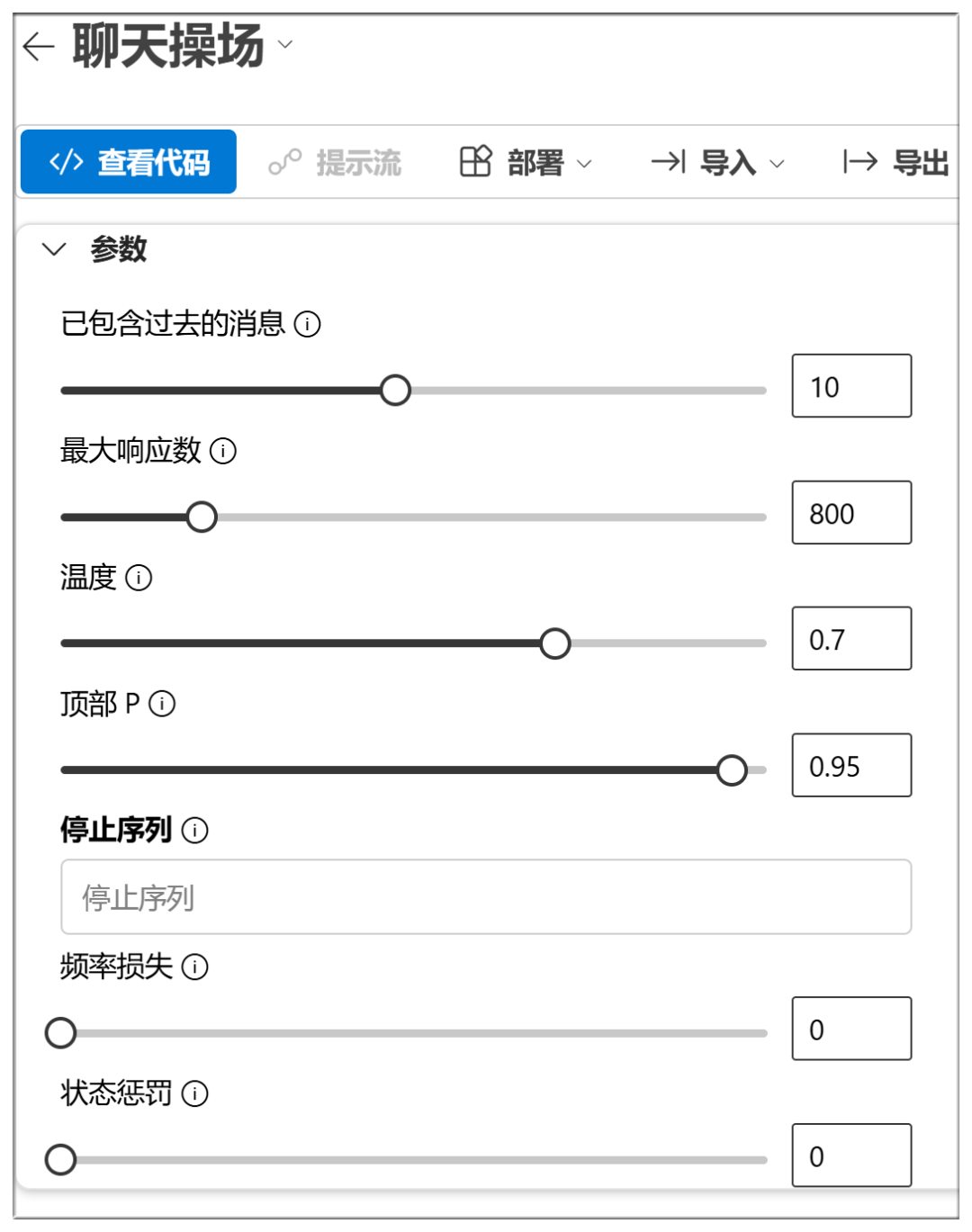

Под окном чата вы также можете включить некоторые параметры (в большинстве случаев они могут быть установлены по умолчанию):

Ниже перечислены примерные значения и функции этих опций:

Температура:

Чем выше значение, тем более случайным будет результат и тем более креативные ответы могут быть получены

Верхняя часть P (ядерная выборка):

Более высокие значения сохраняют больше токенов вероятностного качества и генерируют большее разнообразие

Штраф за частоту:

Более высокие значения в большей степени наказывают высокочастотные слова и уменьшают многословие или повторы

Штраф за присутствие:

Чем выше значение, тем более склонна модель пробовать новые слова

Максимальное количество жетонов:

Чем больше значение, тем больше потенциальная длина ответа

Остановитесь:

Остановка вывода при генерации определенных символов или последовательностей, чтобы предотвратить слишком долгую генерацию или исчерпание тем.

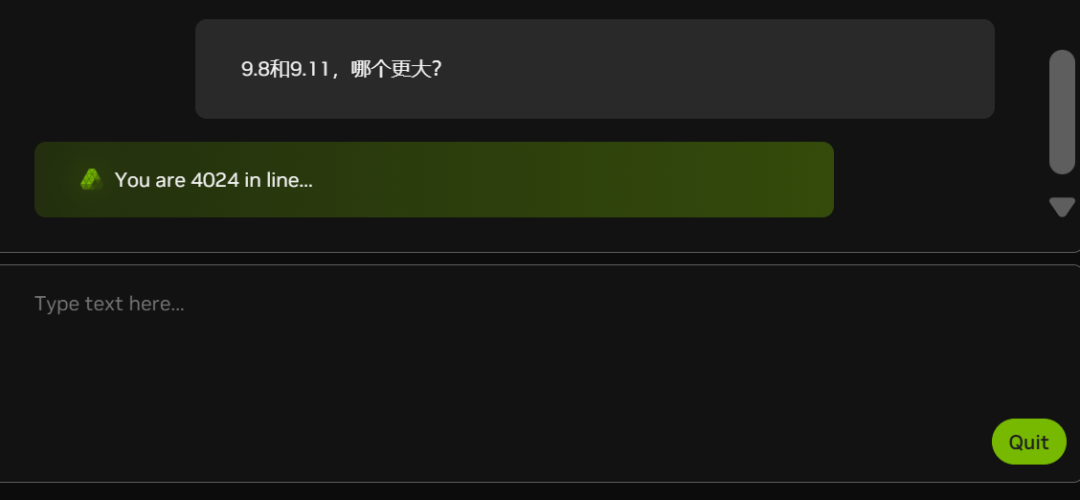

В настоящее время из-за растущего числа "белых джонов" (посмотрите на количество людей в очереди на графике ниже) NIM в некоторых случаях отстает:

Неужели NVIDIA тоже не хватает видеокарт?

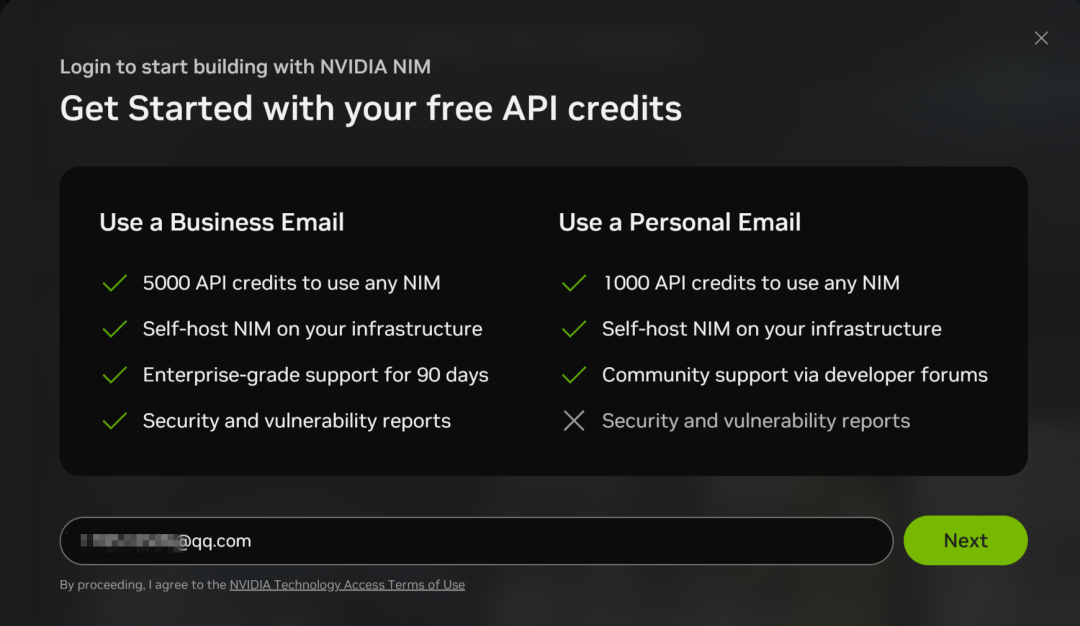

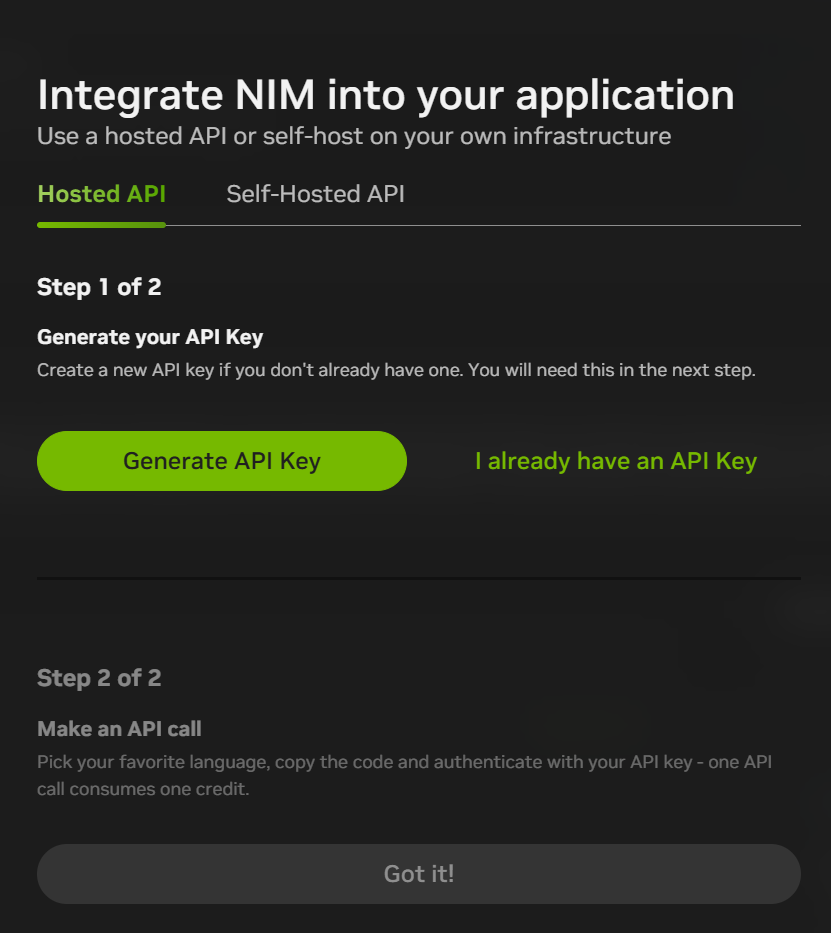

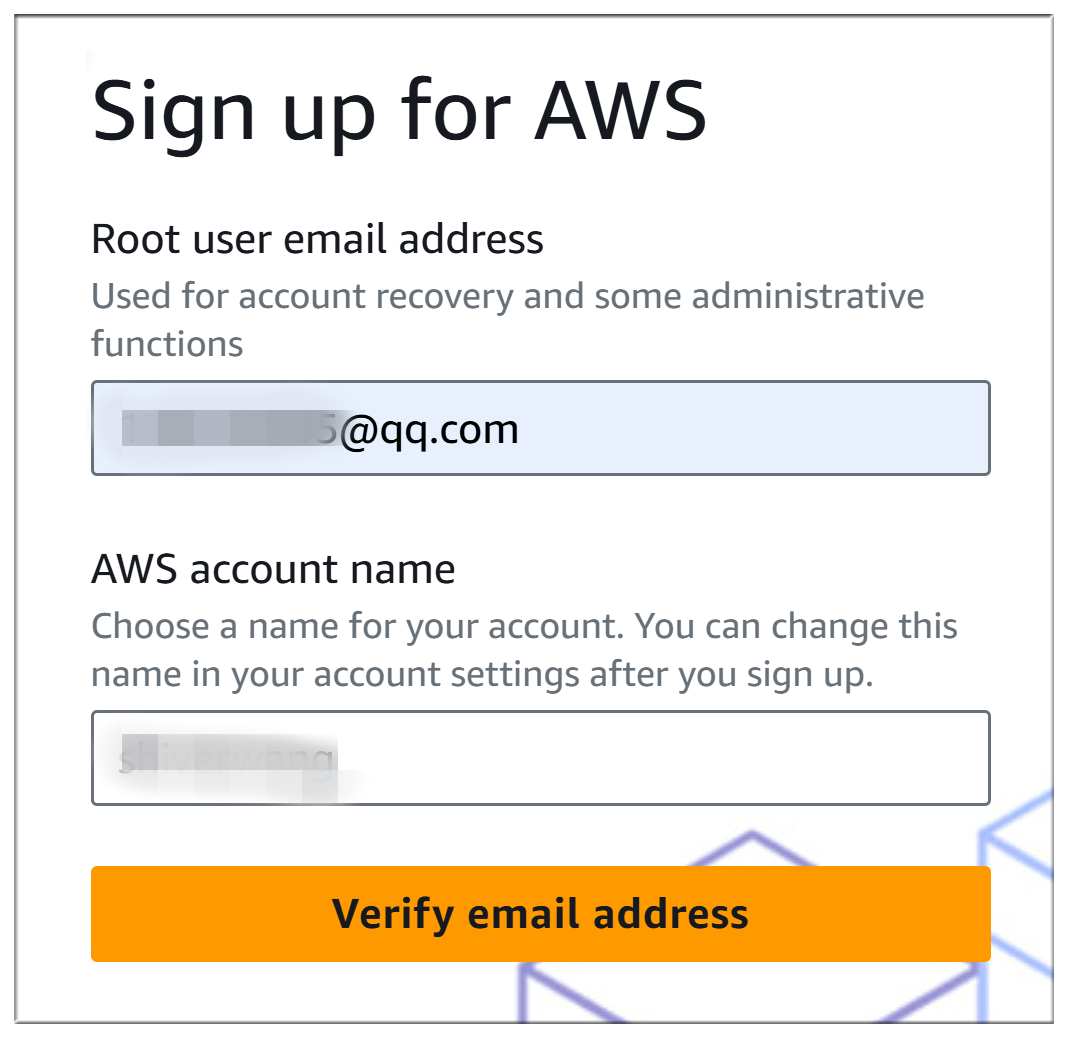

Микросервисы NIM также поддерживают API-вызовы к DeepSeek-R1, но для этого необходимо зарегистрировать учетную запись, указав адрес электронной почты:

Процесс регистрации относительно прост и требует только проверки электронной почты:

После регистрации вы можете нажать кнопку "Build with this NIM" в правом верхнем углу интерфейса чата, чтобы сгенерировать API KEY. В настоящее время за регистрацию вы получаете 1 000 очков (1 000 взаимодействий), так что вы можете использовать их все, а затем зарегистрироваться снова с новым адресом электронной почты.

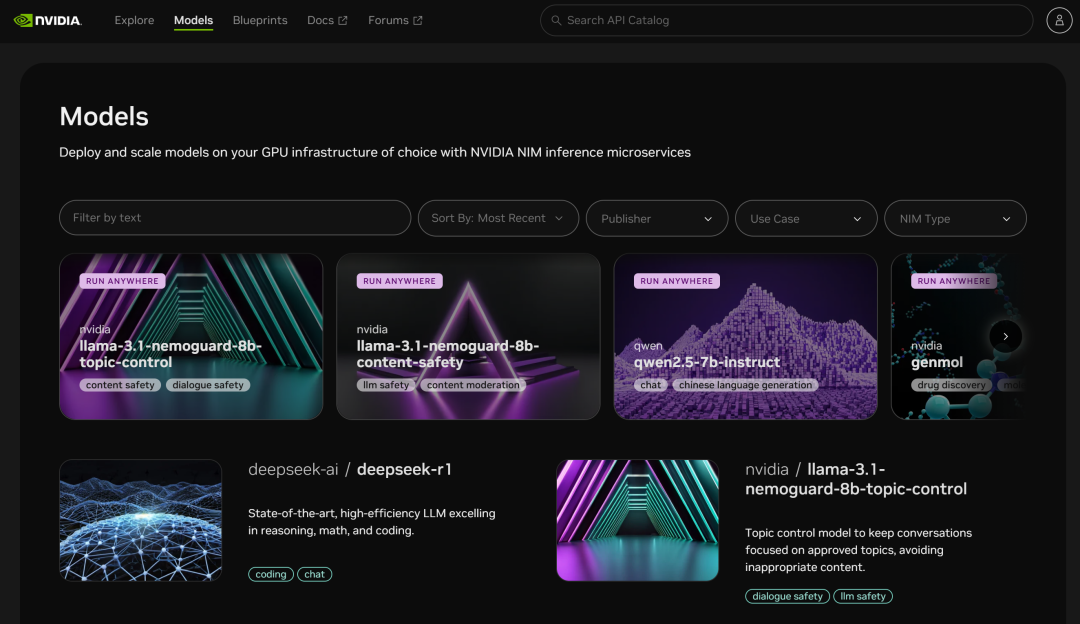

Платформа микросервисов NIM также предоставляет доступ ко многим другим моделям:

II. Microsoft Azure

Веб-сайт:

https://ai.azure.com

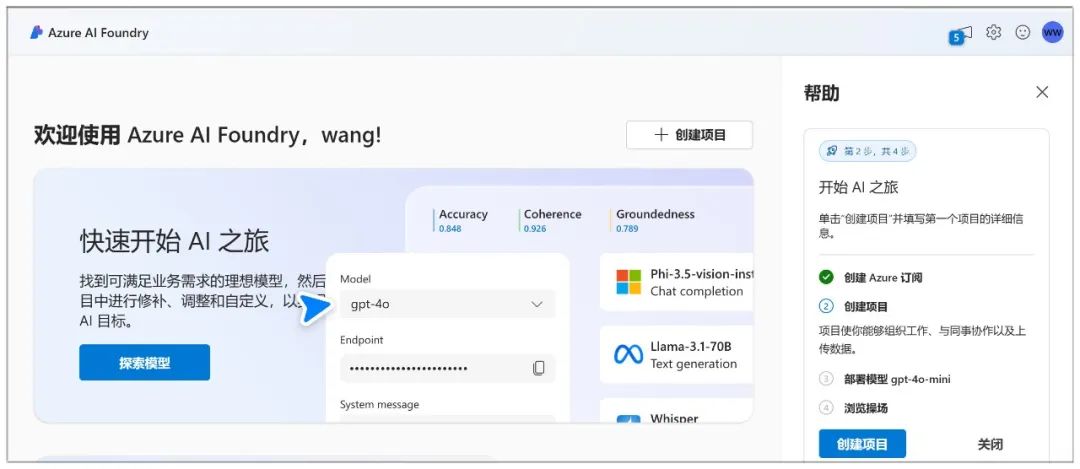

Microsoft Azure позволяет создать чат-бот и взаимодействовать с моделью через чат-площадку.

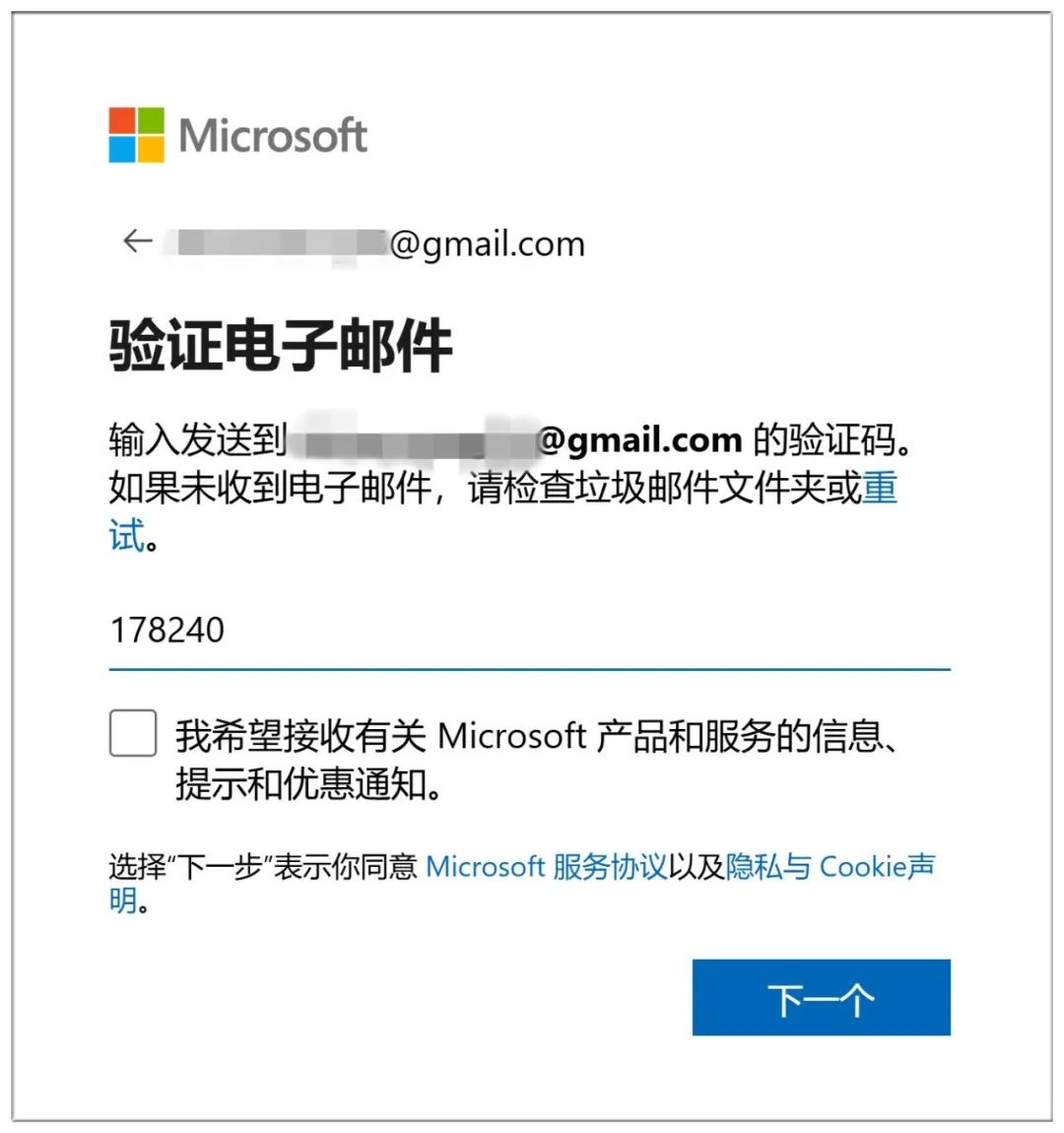

Регистрация в Azure сопряжена со многими трудностями: сначала вам нужно создать учетную запись Microsoft (просто войдите в нее, если она у вас уже есть):

Для создания учетной записи также требуется проверка электронной почты:

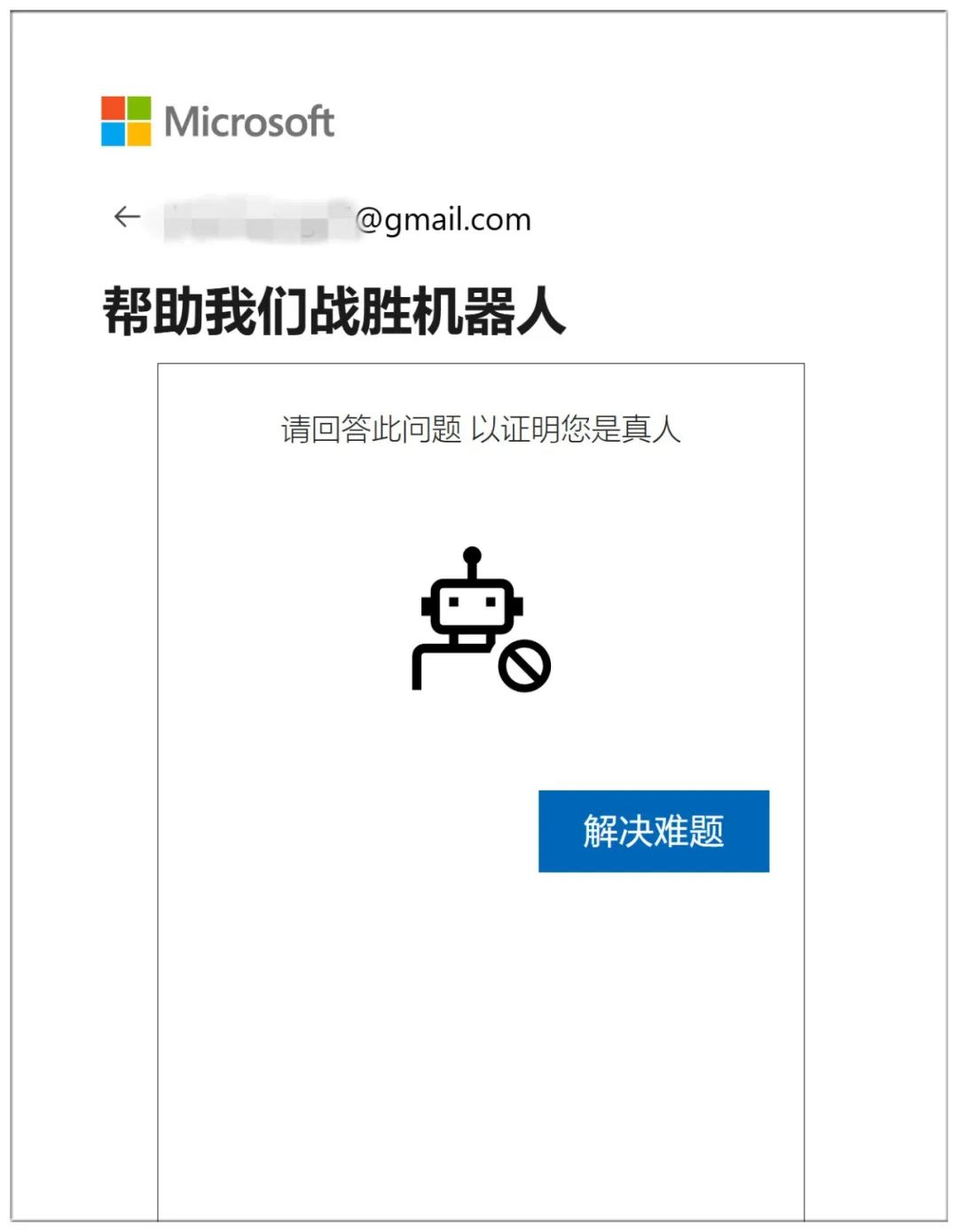

В завершение докажите, что вы человек, ответив на 10 последовательных вопросов о неземном мире:

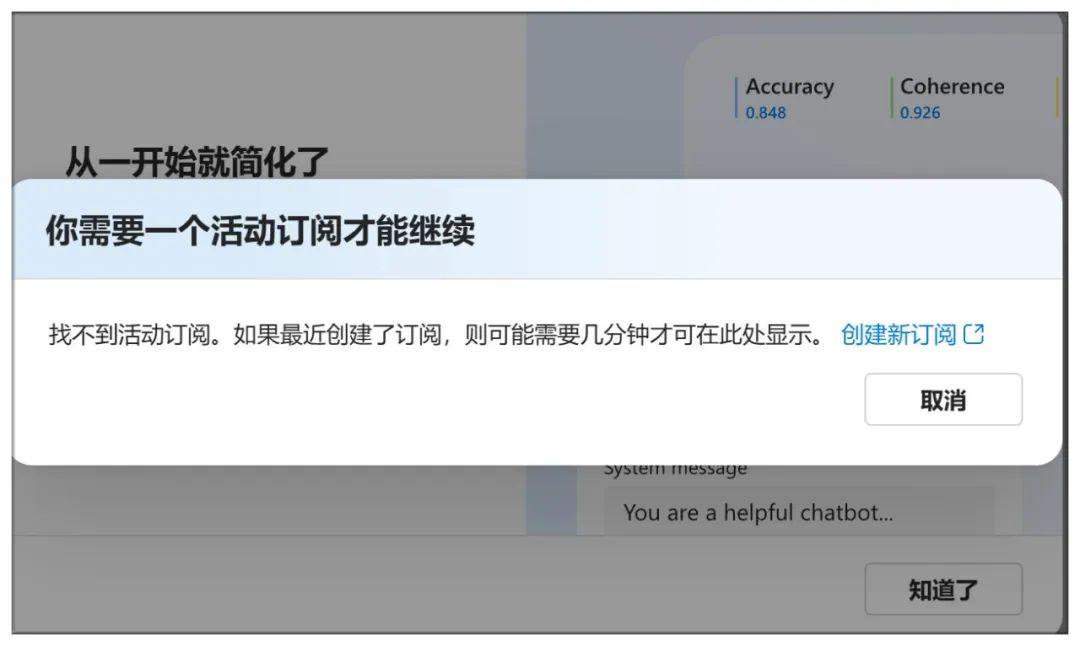

Мало просто попасть сюда, нужно еще и создать подписку:

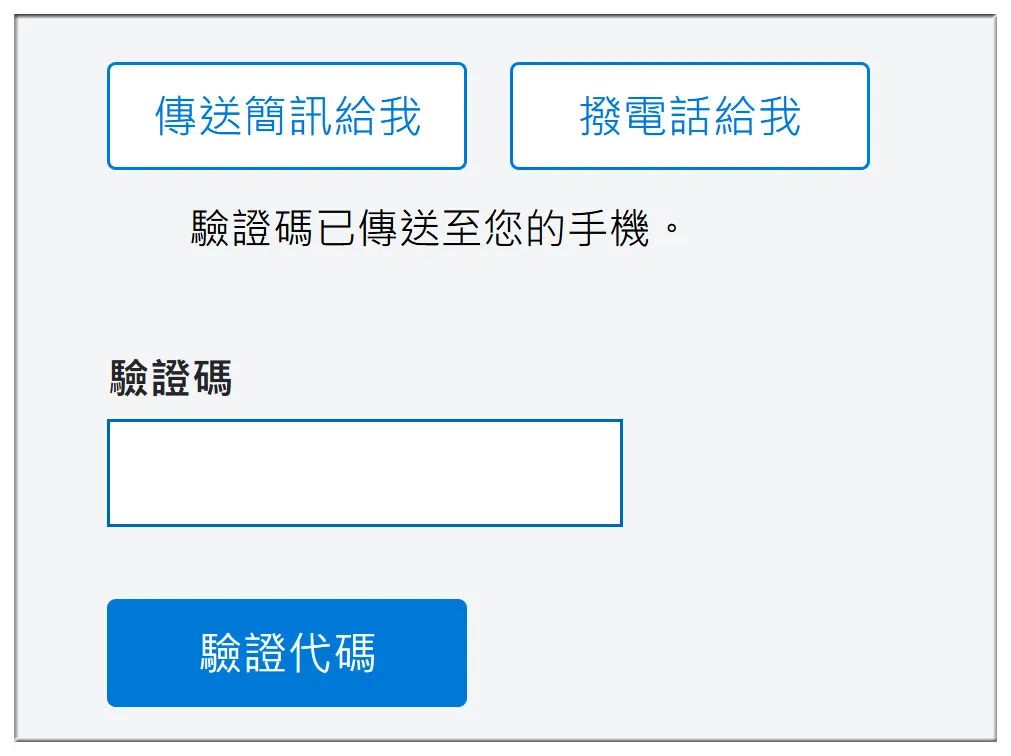

Проверьте номер мобильного телефона, а также номер банковского счета и другую информацию:

Далее выберите "Без технической поддержки":

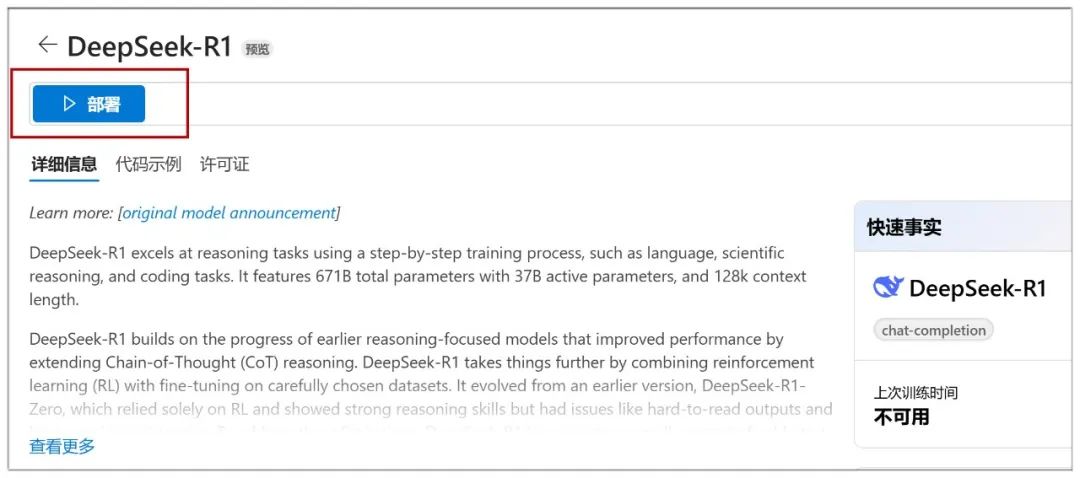

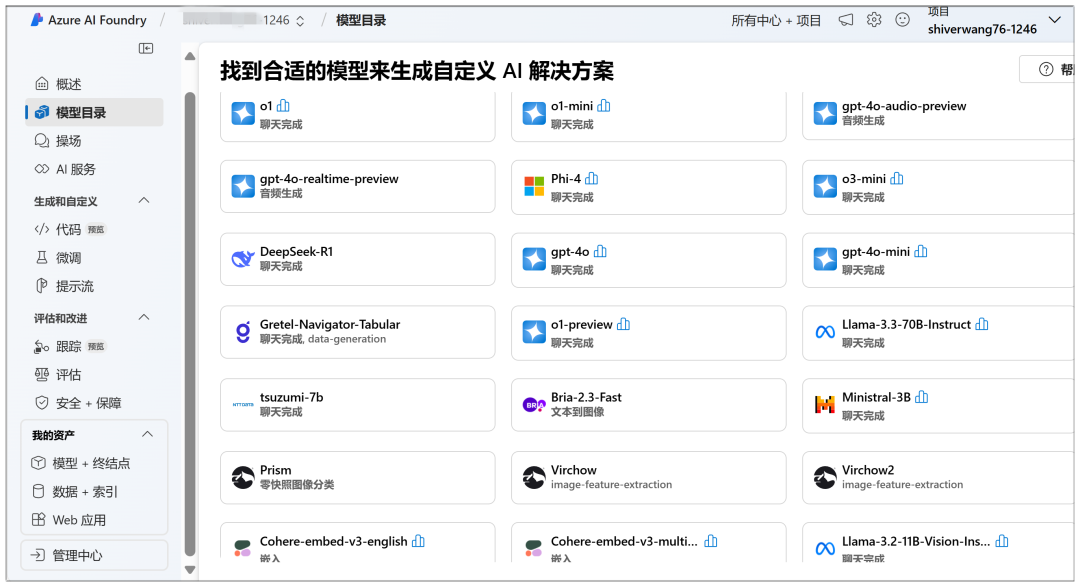

Здесь вы можете начать развертывание облака, в "Каталоге моделей" вы можете увидеть модель DeepSeek-R1 на видном месте:

После этого нажмите кнопку "Развернуть" на следующей странице:

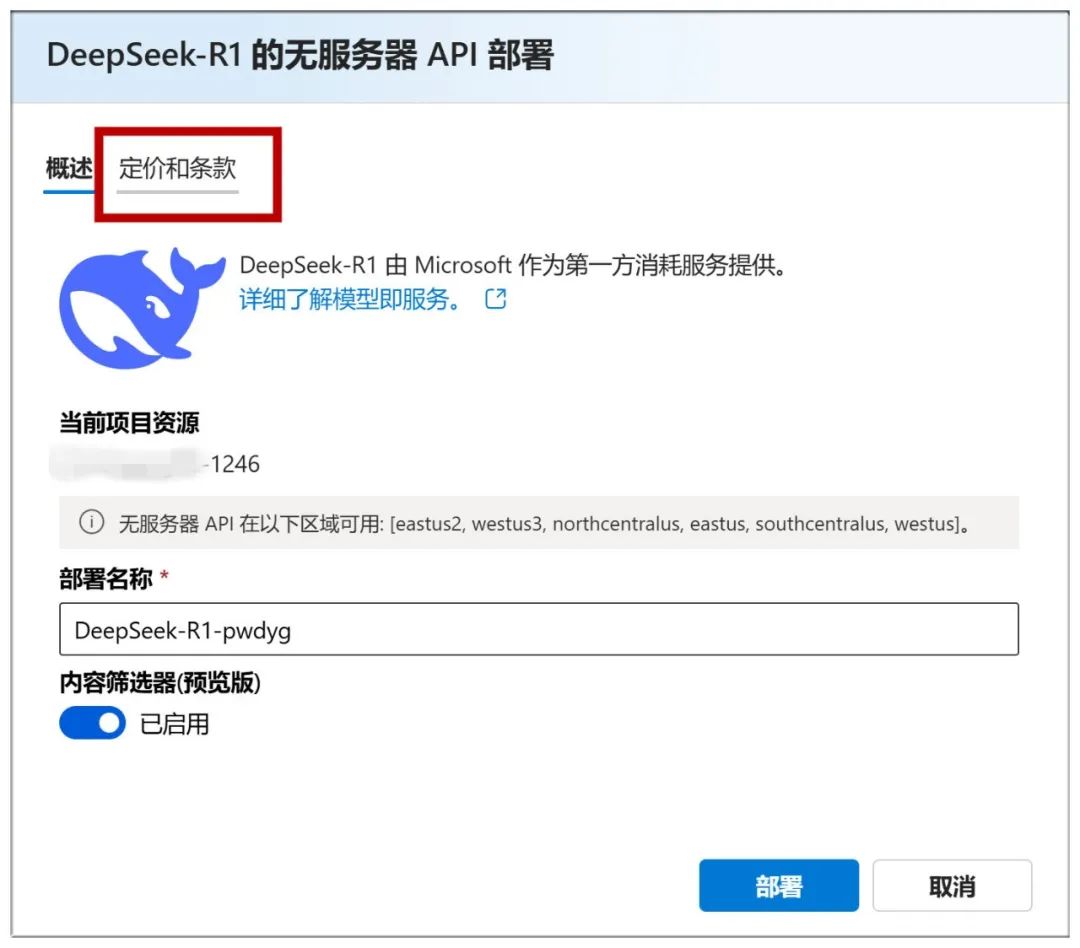

Далее необходимо выбрать "Создать новый проект":

Затем задайте все по умолчанию и нажмите "Далее":

Затем нажмите кнопку "Создать":

Создание его на этой странице начинается, и вам нужно подождать некоторое время:

Когда вы закончите, вы попадете на эту страницу, где можно нажать кнопку "Развернуть", чтобы перейти к следующему шагу:

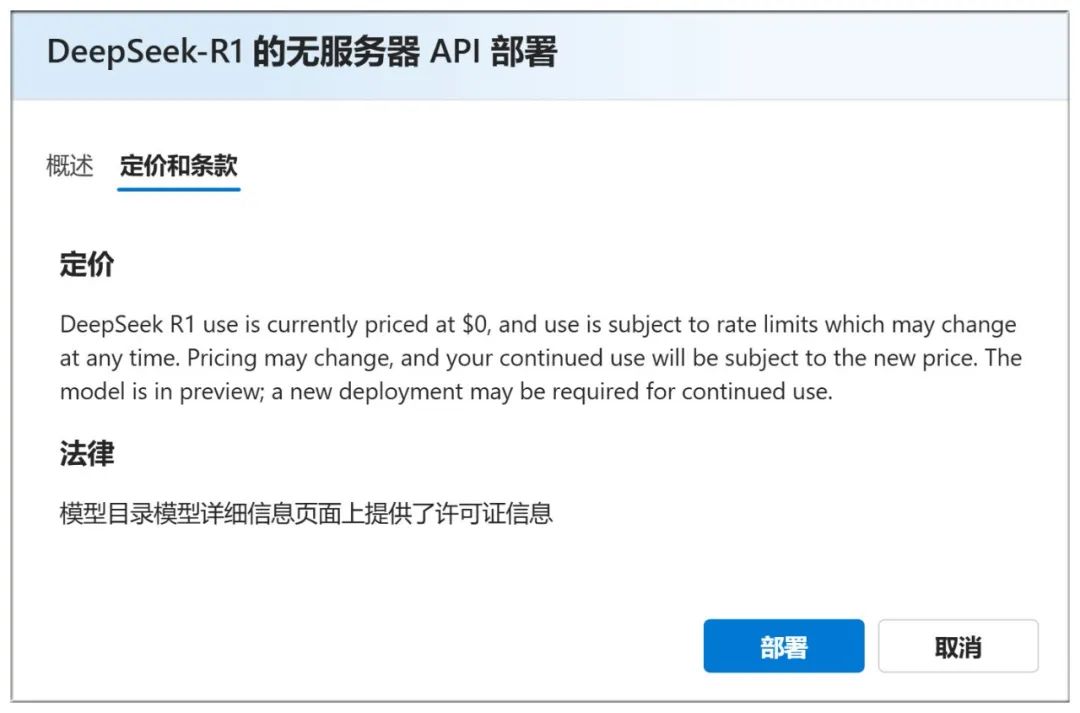

Вы также можете проверить "Цены и условия" выше, чтобы убедиться, что он бесплатен для использования:

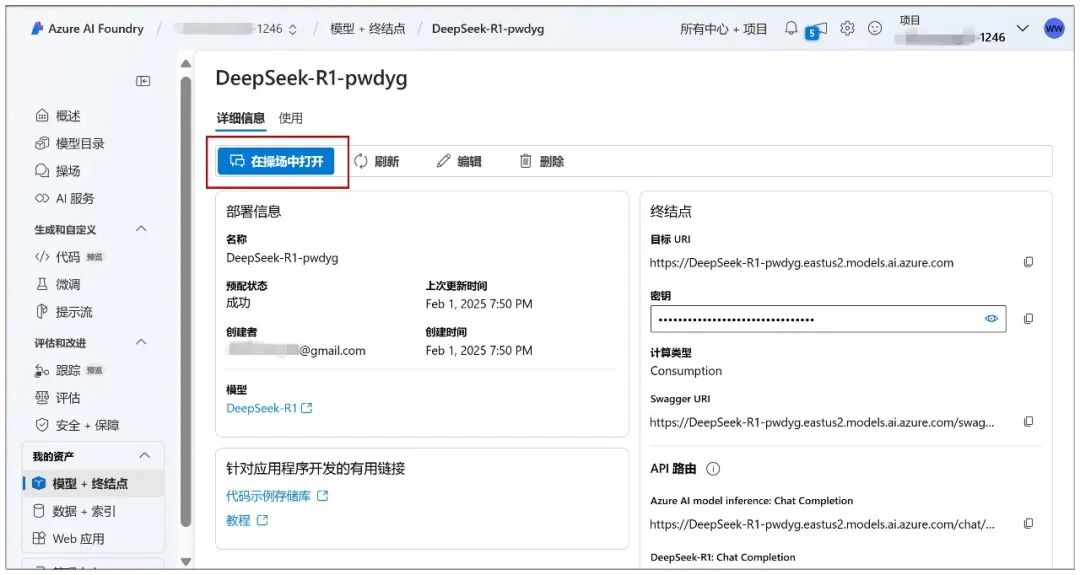

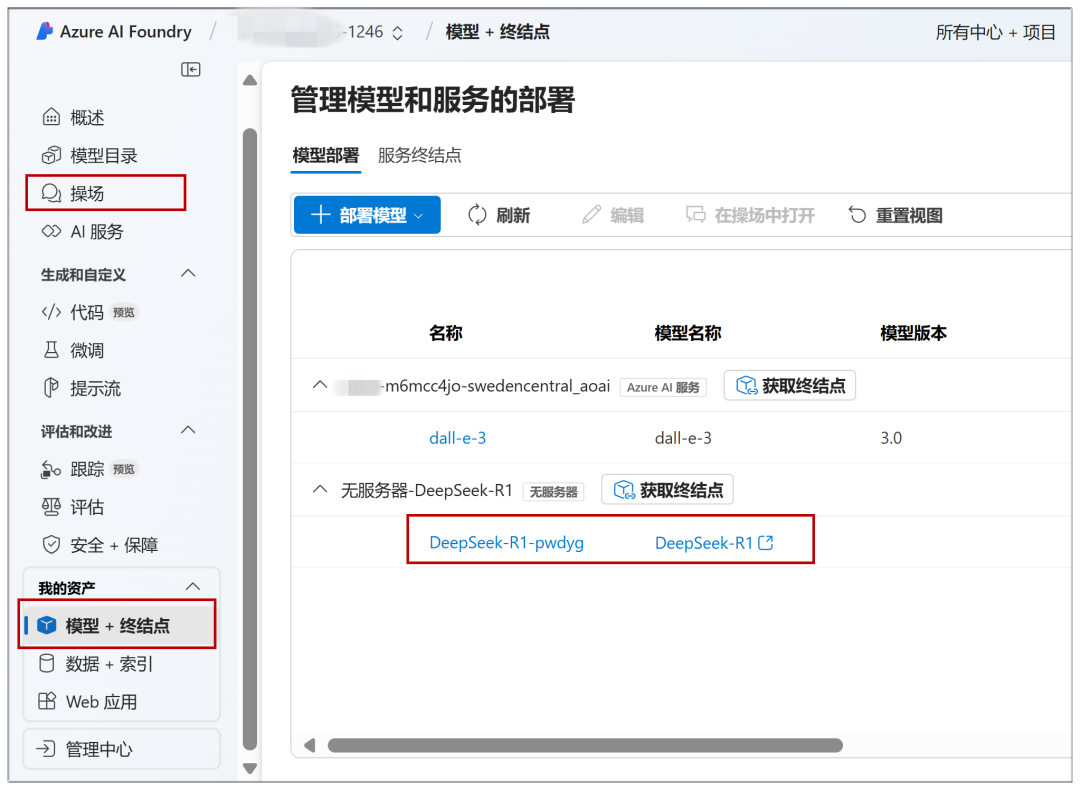

Перейдите на эту страницу, нажав на "Развертывание", и нажмите на "Открыть в Playground":

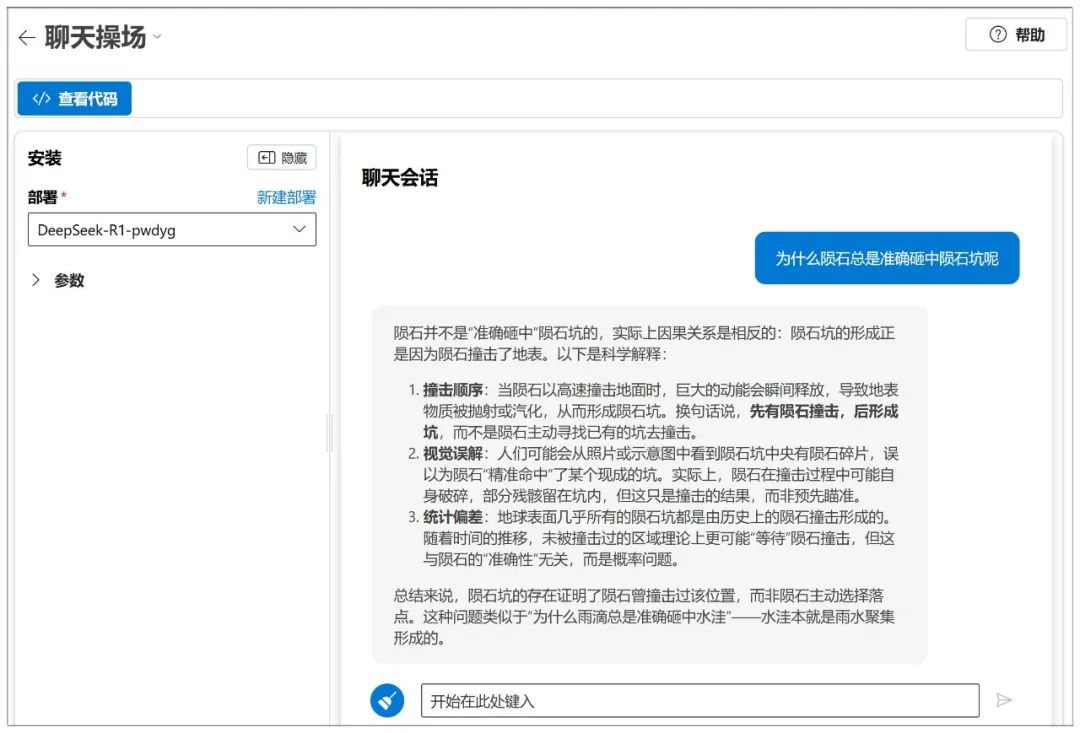

Тогда можно начинать диалог:

В Azure также доступна настройка параметров, подобная NIM:

В качестве платформы можно использовать множество моделей:

К уже развернутым моделям можно быстро получить доступ в будущем через "Playground" или "Model + Endpoint" в левом меню:

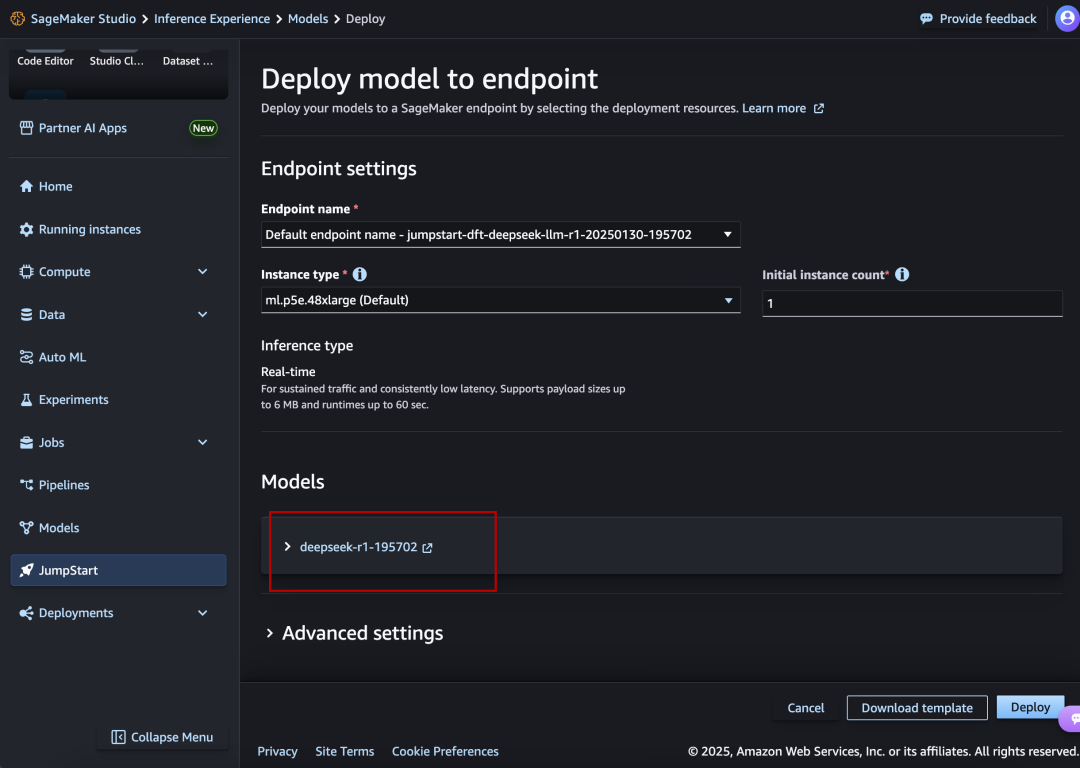

III. Amazon AWS

Веб-сайт:

https://aws.amazon.com/cn/blogs/aws/deepseek-r1-models-now-available-on-aws

DeepSeek-R1 также находится на видном месте и выстроен в ряд.

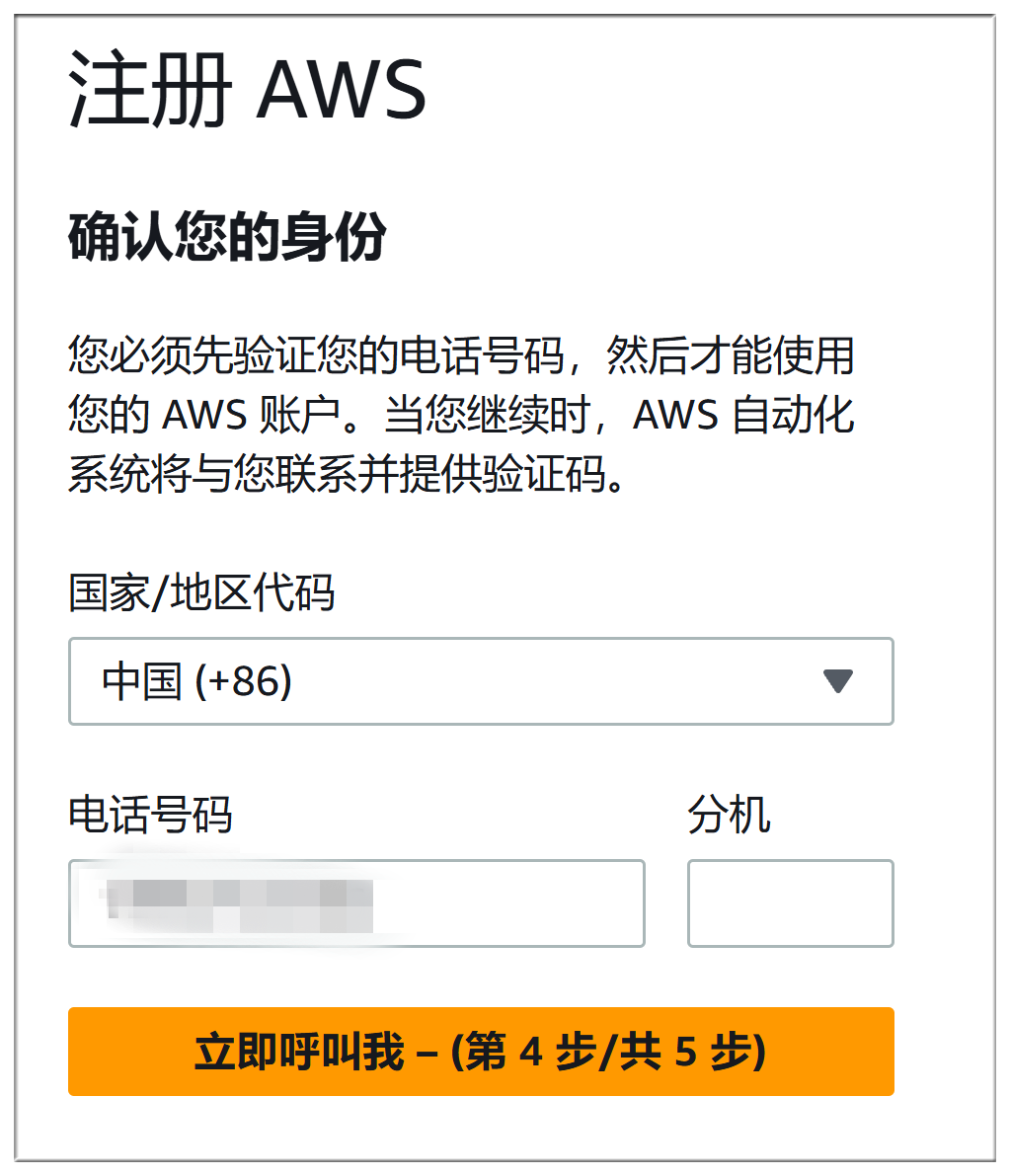

Процесс регистрации Amazon AWS и Microsoft Azure почти такой же хлопотный, в обоих случаях нужно заполнить способ оплаты, а также верификацию телефона + голосовую верификацию, здесь подробно описывать не буду:

Процесс развертывания во многом совпадает с процессом развертывания Microsoft Azure:

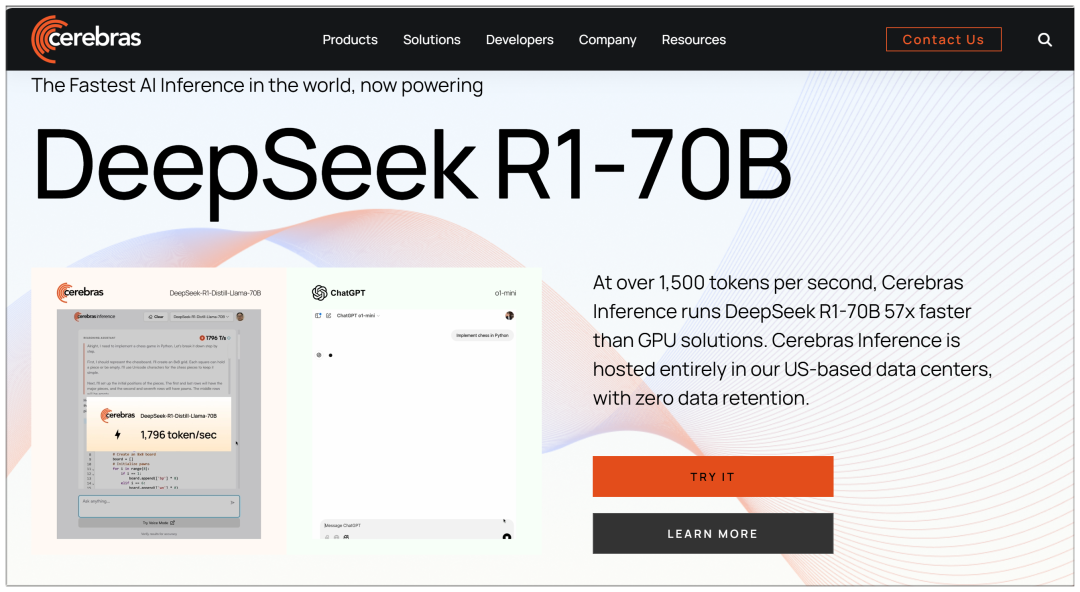

IV. Церебры

Cerebras: самая быстрая в мире платформа для высокопроизводительных вычислений и выводов на основе ИИ, доступная уже сегодня

Сайт: https://cerebras.ai

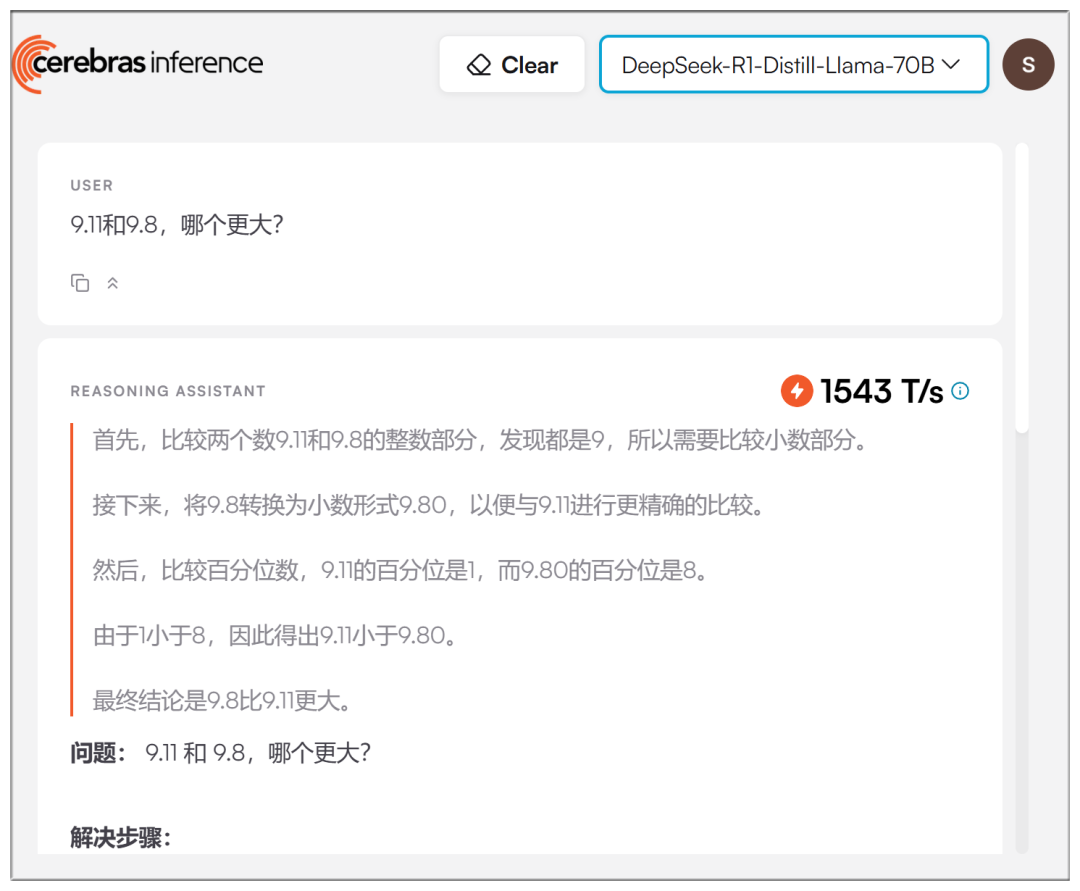

В отличие от нескольких крупных платформ, Cerebras использует модель 70b, утверждая, что она "в 57 раз быстрее решений на GPU":

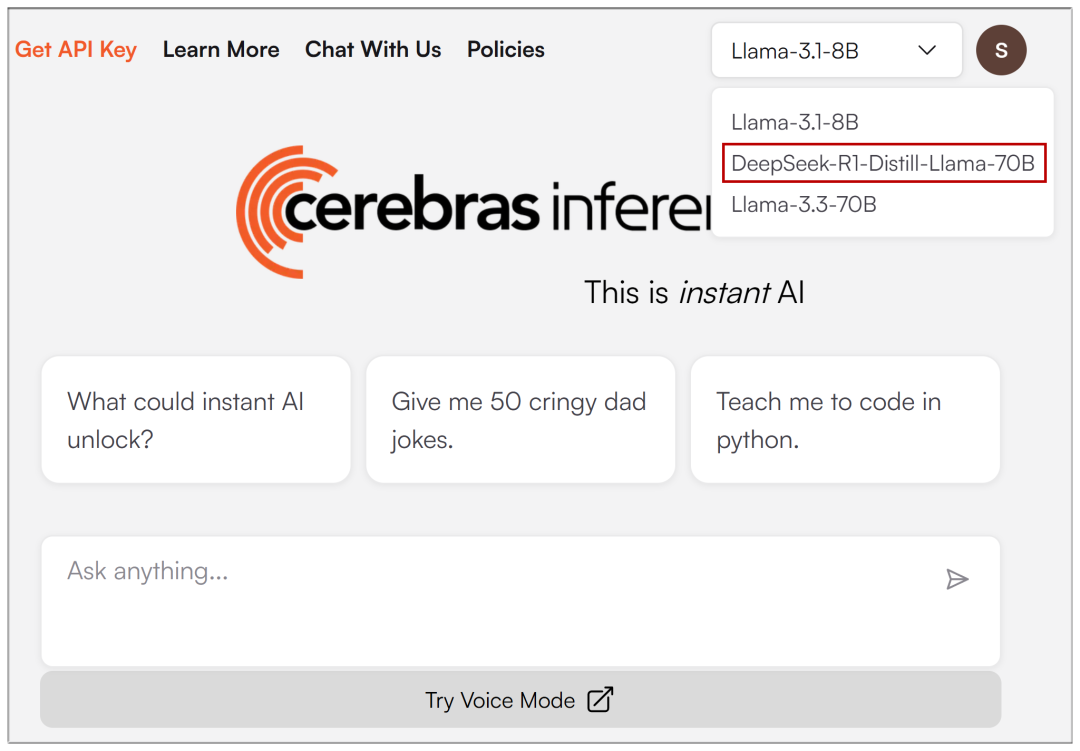

После ввода регистрационного адреса электронной почты в выпадающем меню вверху можно выбрать DeepSeek-R1:

Реальные скорости действительно выше, хотя и не настолько, как заявлено:

В. Грок

Groq: поставщик решений для ускорения вывода больших моделей ИИ, высокоскоростной бесплатный интерфейс больших моделей

Сайт: https://groq.com/groqcloud-makes-deepseek-r1-distill-llama-70b-available

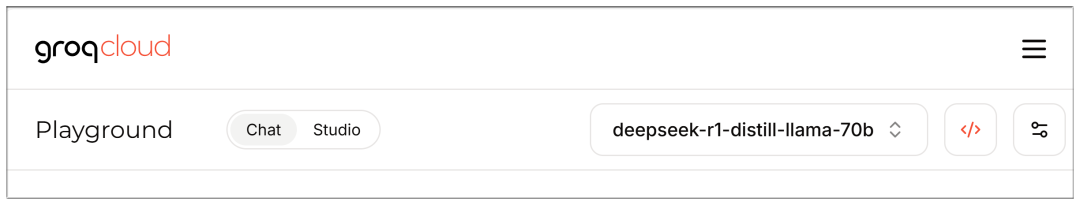

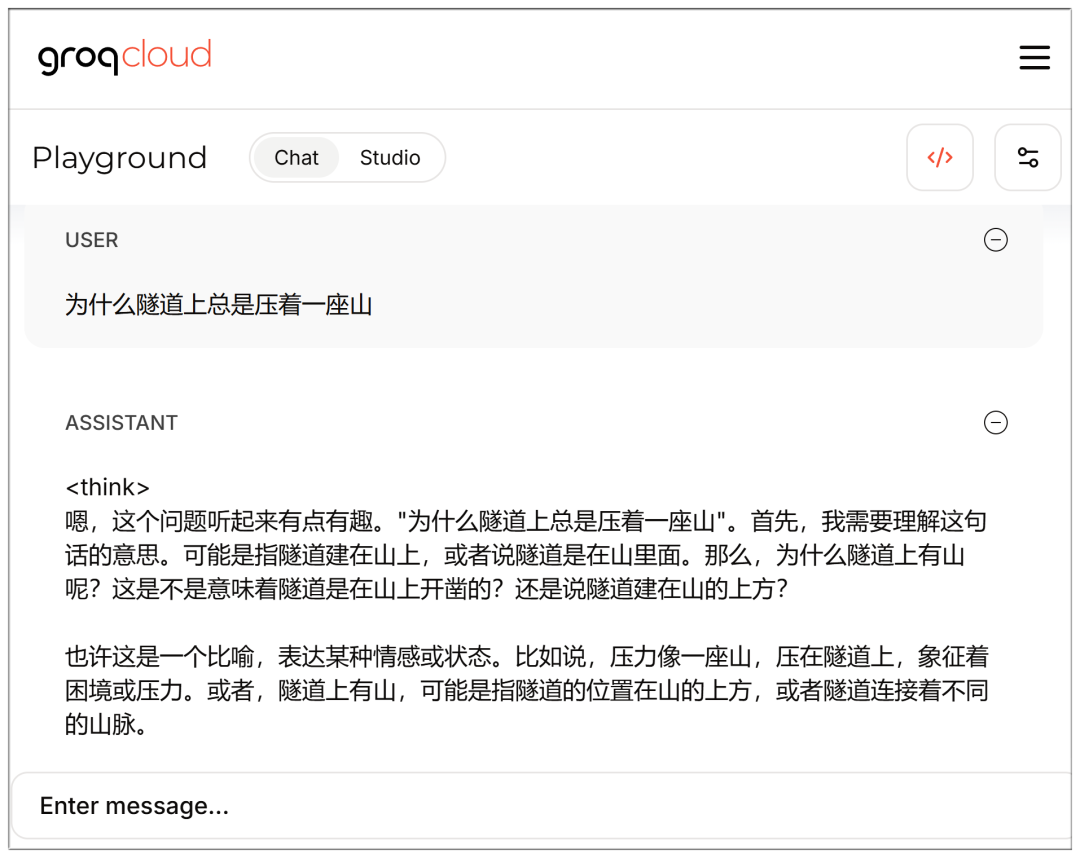

Модели также доступны для выбора после регистрации и ввода электронной почты:

Он тоже быстрый, но, опять же, 70b кажется немного более отсталым, чем Cerebras?

Обратите внимание, что доступ к интерфейсу чата можно получить непосредственно при входе в систему:

https://console.groq.com/playground?model=deepseek-r1-distill-llama-70b

Полный список DeepSeek V3 и R1:

AMD

Графические процессоры AMD Instinct™ обеспечивают работу DeepSeek-V3: революционная разработка ИИ на SGLang (AMD Instinct™ GPUs Power DeepSeek-V3: революционная разработка ИИ с помощью SGLang)

NVIDIA

Модель карты DeepSeek-R1 NVIDIA (Карта модели DeepSeek-R1 NVIDIA)

Microsoft Azure

Запуск DeepSeek-R1 на одной виртуальной машине NDv5 MI300X (Запуск DeepSeek-R1 на одной виртуальной машине NDv5 MI300X)

Baseten

https://www.baseten.co/library/deepseek-v3/

Новита ИИ

Novita AI использует SGLang под управлением DeepSeek-V3 для OpenRouter (Novita AI использует SGLang для запуска DeepSeek-V3 для OpenRouter)

ByteDance Volcengine

Полноразмерная модель DeepSeek приземлилась на Volcano Engine!

DataCrunch

Развертывание DeepSeek-R1 671B на 8x NVIDIA H200 с SGLang (Развертывание DeepSeek-R1 671B на 8x NVIDIA H200 с использованием SGLang)

Гиперболический

https://x.com/zjasper666/status/1872657228676895185

Vultr

Как развернуть Deepseek V3 Large Language Model (LLM) с помощью SGLang (Как развернуть систему с помощью SGLang) Deepseek V3 Моделирование большого языка (LLM))

RunPod

Что нового в использовании бессерверного LLM в RunPod в 2025 году? (Какие новые возможности использует Serverless LLM в RunPod в 2025 году?)

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...